DOI: https://doi.org/10.1007/s42001-024-00250-1

تاريخ النشر: 2024-02-22

الذكاء الاصطناعي التوليدي ضد الإنسانية: التطبيقات الخبيثة للذكاء الاصطناعي التوليدي ونماذج اللغة الكبيرة

الملخص

الذكاء الاصطناعي التوليدي (GenAI) ونماذج اللغة الكبيرة (LLMs) هي معجزات تكنولوجية؛ مشهورة بقدرتها على معالجة اللغة الطبيعية وتوليد المحتوى متعدد الوسائط، تعد بمستقبل تحويلي. ولكن كما هو الحال مع جميع الأدوات القوية، تأتي مع ظلالها. تخيل العيش في عالم حيث يصعب تمييز التزييف العميق عن الواقع، حيث تنظم الهويات الاصطناعية حملات خبيثة، وحيث يتم صياغة المعلومات المضللة أو الاحتيالات المستهدفة بدقة لا مثيل لها. مرحبًا بك في الجانب المظلم من تطبيقات GenAI. هذه المقالة ليست مجرد رحلة عبر متاهات الاستخدامات المحتملة الخاطئة لـ GenAI وLLMs، ولكنها أيضًا دعوة للاعتراف بمدى إلحاح التحديات المقبلة. بينما نتنقل في بحار حملات المعلومات المضللة، وتوليد المحتوى الخبيث، والخلق الغريب للبرمجيات الضارة المتطورة، سنكشف عن الآثار الاجتماعية التي تتردد عبر ثورة GenAI التي نشهدها. من الشبكات الآلية المدعومة بالذكاء الاصطناعي على منصات التواصل الاجتماعي إلى الإمكانيات المقلقة للذكاء الاصطناعي في توليد هويات مزيفة، أو أعذار مصنوعة من واقع اصطناعي، لم تكن المخاطر يومًا أعلى من ذلك. تتلاشى الحدود بين العوالم الافتراضية والواقعية، وتؤثر عواقب التطبيقات الخبيثة المحتملة لـ GenAI علينا جميعًا. هذه المقالة تعمل كملخص للبحث الدقيق المقدم حول مخاطر GenAI وسوء استخدام LLMs وكإلهام لرؤية مثيرة للتفكير حول الأنواع المختلفة من تطبيقات GenAI الضارة التي قد نواجهها في المستقبل القريب، وبعض الطرق التي يمكننا الاستعداد لها.

المقدمة

تعريف وآليات الذكاء الاصطناعي التوليدي وLLMs

تشمل فهم استفسارات الإدخال، والوصول إلى بيانات التدريب الواسعة الخاصة بها، وتوليد استجابات نصية مناسبة، والتي يمكن أن تتراوح من الإجابة على الأسئلة إلى إنشاء المحتوى.

التقدم التكنولوجي والديمقراطية

المشهد التنظيمي

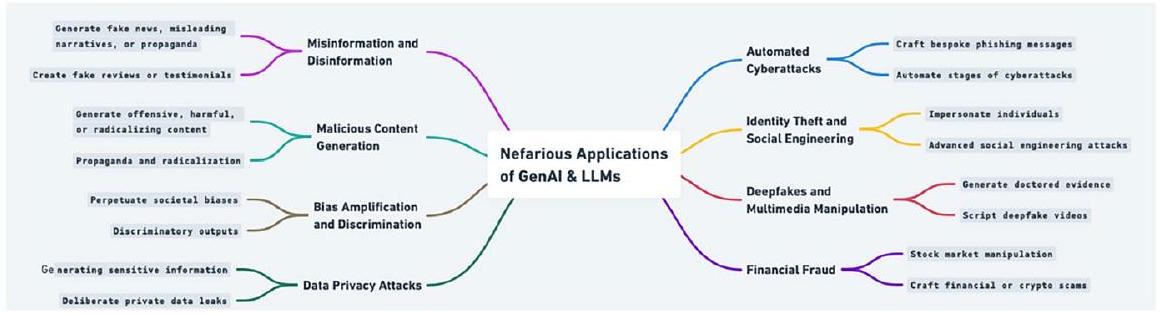

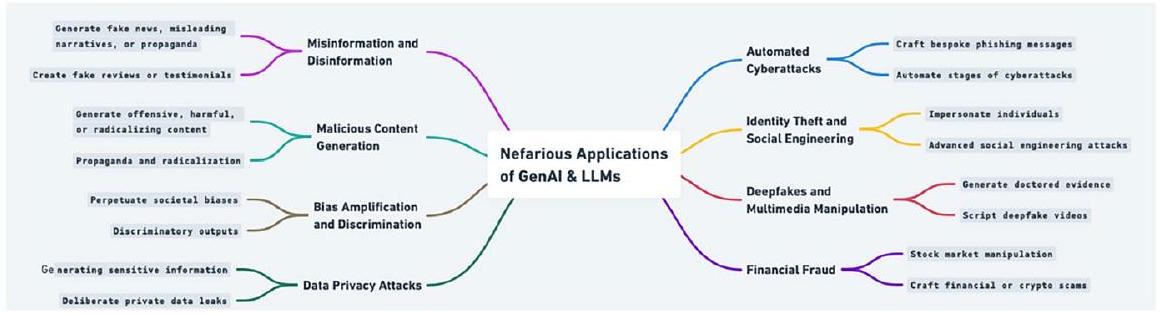

فهم إساءة استخدام GenAI: تصنيف

| مرجع. | عنوان الخبر | وسيلة الإعلام | الرابط |

| أ | استخدم المحتالون الذكاء الاصطناعي لتقليد صوت الرئيس التنفيذي في حالة جريمة إلكترونية غير عادية | وول ستريت جورنال | https://www.wsj.com/articles/fraudsters-use-ai-to-mimic-ceos-voice-in-unusual-cybercrime-case-11567157402 |

| ب | يخلق الناس سجلات لأحداث تاريخية مزيفة باستخدام الذكاء الاصطناعي | فايس | https://www.vice.com/en/article/k7zqdw/people-are-creating-recor ds-of-fake-historical-events-using-ai |

| ج | ‘لا أريد أن أزعج الناس’: مبتكر فيديوهات توم كروز العميقة يتحدث | ذا غارديان | https://www.theguardian.com/technology/2021/mar/05/how-started-tom-cruise-deepfake-tiktok-videos |

| د | هل تبدو هذه الشخصيات المزيفة التي أنشأها الذكاء الاصطناعي حقيقية بالنسبة لك؟ | نيويورك تايمز | https://www.nytimes.com/interactive/2020/11/21/science/artificial-intelligence-fake-people-faces.html |

| هـ | الذكاء الاصطناعي التوليدي: نعمة أم لعنة للأمن السيبراني؟ | إن ويب 3 | https://www.inweb3.com/generative-ai-a-blessing-or-a-curse-forcybersecurity/ |

| و | تهديدات الذكاء الاصطناعي في العالم الحقيقي في الأمن السيبراني ليست خيال علمي | فينتشر بيت | https://venturebeat.com/ai/real-world-ai-threats-in-cybersecurity-arent-science-fiction/ |

| ز | الذكاء الاصطناعي يعزز مكالمات الاحتيال وغيرها من الخدع | ماركت بليس | https://www.marketplace.org/2023/07/14/ai-amplifies-scam-calls-and-other-deceptions/ |

| ح | يستخدم المحتالون الذكاء الاصطناعي لتقليد أصوات الأحباء في محنة | سي بي إس نيوز | https://www.cbsnews.com/news/scammers-ai-mimic-voices-loved-ones-in-distress |

| ط | مزيف أم حقيقة؟ المستقبل المقلق للواقع الذي أنشأه الذكاء الاصطناعي | فوربس | https://www.forbes.com/sites/bernardmarr/2023/07/27/fake-or-fact-the-disturbing-future-of-ai-generated-realities |

| ي | يُثير الباحثون في المعلومات المضللة القلق بشأن روبوتات الدردشة الذكية | نيويورك تايمز | https://www.nytimes.com/2023/02/08/technology/ai-chatbots-disin formation.html |

| ك | يُنتج GPT-4 معلومات مضللة بشكل أكثر تكرارًا، وبشكل أكثر إقناعًا، من سلفه | نيوز غارد | https://www.newsguardtech.com/misinformation-monitor/march2023/ |

| ل | عصر مراقبة الذكاء الاصطناعي هنا | كواتز | https://qz.com/1060606/the-age-of-ai-surveillance-is-here |

| م | أكبر تهديد للصور العميقة ليس الصور العميقة نفسها | مراجعة تكنولوجيا MIT | https://www.technologyreview.com/2019/10/10/132667/the-bigge st-threat-of-deepfakes-isnt-the-deepfakes-themselves/ |

| ن | تم تحذير جامعي الفطر من تجنب كتب البحث عن الفطر على أمازون التي تبدو مكتوبة بواسطة الذكاء الاصطناعي | ذا غارديان | https://www.theguardian.com/technology/2023/sep/01/mushroom-pickers-urged-to-avoid-foraging-books-on-amazon-that-appear-to-be-written-by-ai |

لمحة عن أيام المستقبل الماضي

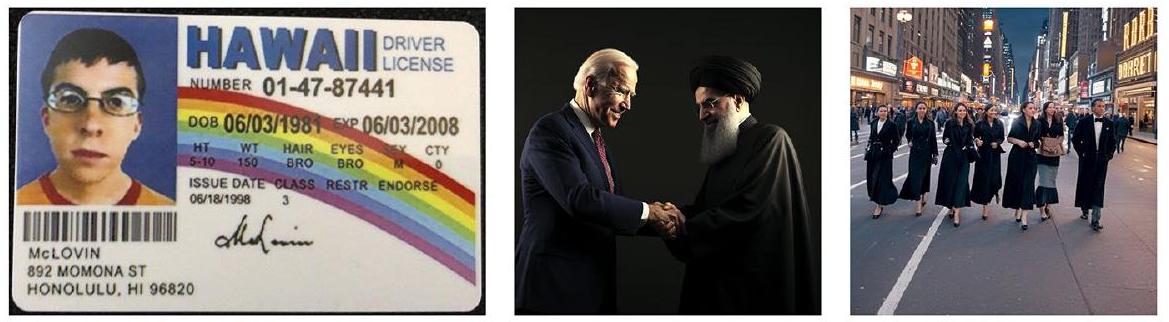

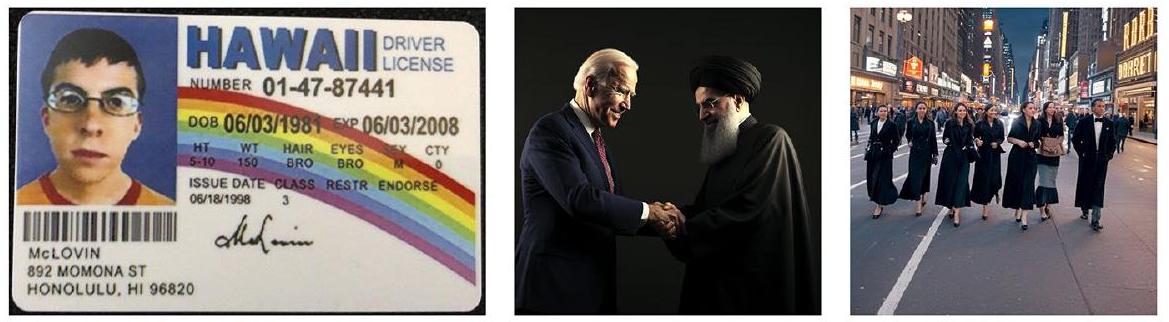

صعود deepfakes

وجوه تم إنشاؤها بواسطة الذكاء الاصطناعي

| الهدف | التطبيق | المثال | إثبات المفهوم |

| عدم الأمانة | كتابة مقالات آلية وعدم الأمانة الأكاديمية | يمكن للطلاب استخدام LLMs لتوليد مقالات، أوراق بحثية، أو واجبات، متجاوزين عملية التعلم وتقويض النزاهة الأكاديمية | إدخال موجه مثل “اكتب مقالة من 2000 كلمة عن تأثير الثورة الصناعية على المجتمع الأوروبي” في LLM والحصول على مقالة مفصلة ومنظمة جيدًا في المقابل |

| توليد أوراق بحثية مزيفة | يمكن استخدام LLMs لإنتاج أوراق بحثية مزيفة ببيانات، نتائج، ومراجع مزيفة، مما قد يلوث قواعد البيانات الأكاديمية أو يضلل الباحثين | تغذية LLM بموجه مثل “توليد ورقة بحثية عن تأثير دواء يسمى ‘Zyphorin’ على مرض الزهايمر” والحصول على ورقة تبدو شرعية | |

| الدعاية | انتحال شخصيات المشاهير أو الشخصيات العامة | يمكن لـ LLMs توليد بيانات، تغريدات، أو رسائل تحاكي أسلوب المشاهير أو الشخصيات العامة، مما يؤدي إلى معلومات مضللة أو تشهير | إدخال “إنشاء تغريدة بأسلوب [اسم المشاهير] تناقش تغير المناخ” والحصول على تغريدة مزيفة تبدو حقيقية |

| توليد دعاية آلية | يمكن للحكومات أو المنظمات استخدام نماذج اللغة الكبيرة لإنتاج مواد دعاية على نطاق واسع، تستهدف فئات سكانية أو مناطق مختلفة برسائل مخصصة | إدخال “إنشاء مقال دعاية يروج لفوائد سياسة حكومية خيالية ‘مبادرة المستقبل الأخضر’” والحصول على مقال مفصل | |

| إنشاء مستندات أو نصوص تاريخية مزيفة | يمكن استخدام نماذج اللغة الكبيرة لتزوير مستندات تاريخية، أو رسائل، أو نصوص، مما قد يضلل المؤرخين أو يغير من تصور الجمهور للأحداث | تحفيز نموذج لغة كبير بـ “إنشاء رسالة من نابليون بونابرت إلى جوزفين يناقش استراتيجياته لمعركة واترلو” لإنتاج مستند تاريخي مزيف |

| الجدول 2 (مستمر) | |||

| الهدف | التطبيق | مثال | إثبات المفهوم |

| الخداع | توليد مراجعات منتجات مزيفة | يمكن للشركات استخدام نماذج اللغة الكبيرة لتوليد مراجعات إيجابية لمنتجاتها أو مراجعات سلبية للمنافسين، مما يضلل المستهلكين | إدخال “إنشاء 10 مراجعات إيجابية لعلامة تجارية خيالية للهواتف الذكية ‘نكسافون’” والحصول على مراجعات مستخدم تبدو حقيقية |

| توليد قصص شخصية أو شهادات واقعية ولكن مزيفة | يمكن استخدام نماذج اللغة الكبيرة لصياغة قصص شخصية أو شهادات للاستخدام في التسويق الخادع، أو المطالبات القانونية الكاذبة، أو للتلاعب بمشاعر الجمهور | إدخال “إنشاء قصة شخصية لشخص يستفيد من مكمل صحي خيالي ‘فيتا بوست’” للحصول على شهادة مقنعة ولكن مزيفة تمامًا | |

| صياغة رسائل احتيالية مقنعة | يمكن استخدام نماذج اللغة الكبيرة لصياغة رسائل احتيالية مخصصة للغاية تبدو وكأنها تأتي من مصادر شرعية، مثل البنوك أو مقدمي الخدمات | تغذية النموذج بمعلومات عن مستخدم خيالي ومحفز مثل “إنشاء بريد إلكتروني من بنك يُخطر المستخدم بنشاط حساب مشبوه” لإنتاج بريد إلكتروني احتيالي | |

| صياغة مستندات قانونية تحتوي على بنود مخفية | يمكن للكيانات غير الأخلاقية استخدام نماذج اللغة الكبيرة لإنشاء مستندات قانونية تحتوي على بنود مخفية أو مضللة أو استغلالية | تحفيز نموذج لغة كبير بـ “إنشاء عقد إيجار يمنح المالك الحق في زيادة الإيجار دون إشعار” لإنتاج مستند قانوني مضلل | |

استخدام شخصيات اصطناعية

الذريعة المثالية: إنكار معقول ومشاكل النسبة

تُقوض هذه الاحتمالات الثقة والمصداقية والمساءلة. إنها تخلق إنكارًا معقولًا، القدرة على إنكار المسؤولية أو المشاركة في فعل ما، من خلال توليد أدلة أو أعذار مزيفة. كما أنها تخلق مشاكل في النسبة، صعوبة تحديد مصدر أو أصل فعل ما، من خلال توليد هويات أو مواقع مزيفة. تنشأ أيضًا معضلات أخلاقية، الصراع بين المبادئ أو القيم الأخلاقية، من خلال توليد محتوى ينتهك حقوق الإنسان أو المعايير.

الذكاء الاصطناعي ضد الناس

| الجدول 3 سيناريوهات إثبات المفهوم التي تبرز إمكانية أنواع مختلفة من الأضرار في تطبيقات الذكاء الاصطناعي الخبيثة | |||

| ضرر | تطبيق | مثال | إثبات المفهوم |

| تلاعب بالمعلومات | تلاعب آلي بوسائل التواصل الاجتماعي | يمكن استخدام نماذج اللغة الكبيرة لتشغيل حسابات متعددة على وسائل التواصل الاجتماعي، مما يخلق وهم حركات قاعدية أو يضخم بشكل مصطنع روايات معينة | نشر نموذج لغة كبير لإدارة مئات حسابات تويتر، جميعها تدفع أجندة سياسية معينة أو تنشر معلومات مضللة حول قضية صحة عامة |

| توليد نصائح أو معلومات طبية مزيفة | يمكن لنماذج اللغة الكبيرة إنتاج معلومات طبية مضللة، مما قد يعرض الأفراد للخطر الذين قد يتصرفون بناءً على هذه النصائح الكاذبة | طلب من نموذج لغة كبير “تقديم علاجات طبيعية لحالة قلبية” والحصول على اقتراحات قد تكون ضارة أو غير فعالة | |

| صياغة إعلانات مضللة | يمكن استخدام نماذج اللغة الكبيرة لتوليد إعلانات تبالغ في قدرات المنتج أو تقدم ادعاءات كاذبة | إدخال “إنشاء إعلان لمنتج عناية بالبشرة خيالي يوفر نتائج فورية” والحصول على إعلان مضلل يعد بنتائج غير واقعية | |

| ضرر مالي | إنشاء تقارير أو بيانات مالية مزيفة | يمكن استخدام نماذج اللغة الكبيرة لتوليد بيانات أو تقارير مالية كاذبة، مما قد يضلل المستثمرين أو يتلاعب بأسعار الأسهم | تحفيز نموذج لغة كبير بـ “إنشاء تقرير مالي ربع سنوي لشركة تكنولوجيا خيالية ‘تيك نوفا’ يظهر زيادة في الأرباح بنسبة X%” للحصول على مستند مالي مفصل ولكنه مزيف |

| توليد نصوص لمكالمات احتيالية | يمكن لنماذج اللغة الكبيرة إنتاج نصوص لمكالمات احتيالية، مما يجعلها تبدو أكثر مصداقية وزيادة احتمالية خداع الأفراد | طلب من نموذج لغة كبير “إنشاء نص لمكالمة تدعي أنها من مصلحة الضرائب، تُخطر المستلم بالضرائب غير المدفوعة” لإنتاج نص احتيالي مقنع | |

| الجدول 3 (مستمر) | |||

| ضرر | تطبيق | مثال | إثبات المفهوم |

| ضرر شخصي وهويتي | ملفات شخصية وهويات شخصية مزيفة | يمكن لنماذج اللغة الكبيرة صياغة ملفات شخصية شخصية مفصلة، كاملة مع قصص خلفية، للاستخدام في الاحتيالات، أو الصيد العاطفي، أو التجسس | تحفيز نموذج لغة كبير بـ “إنشاء ملف تعريف مفصل لصحفي خيالي يُدعى ‘أليكس مورغان’” والحصول على قصة خلفية شاملة، وتاريخ تعليمي، وإنجازات مهنية |

| مضايقات آلية عبر الإنترنت | يمكن نشر نماذج اللغة الكبيرة لاستهداف الأفراد عبر الإنترنت، وإرسال رسائل شخصية ومؤذية على نطاق واسع | استخدام نموذج لغة كبير لإدارة حسابات متعددة على الإنترنت تنشر باستمرار تعليقات مسيئة على منشورات وسائل التواصل الاجتماعي لشخص معين | |

| توليد أدلة أو أعذار مزيفة | يمكن لنماذج اللغة الكبيرة صياغة روايات مفصلة أو محتوى رقمي يعمل كأدلة مزيفة أو أعذار في القضايا القانونية | طلب من نموذج لغة كبير “تقديم عذر مفصل لشخص يدعي أنه كان في مؤتمر في بوسطن من 1-5 يونيو 2023” والحصول على جدول زمني شامل، مكتمل بأحداث وتفاعلات خيالية | |

| ضرر تقني اجتماعي | احتيالات دعم فني مزيفة | يمكن استخدام نماذج اللغة الكبيرة لتوليد نصوص أو أدلة تُضلل الأفراد للاعتقاد بأنهم يتلقون دعمًا فنيًا شرعيًا، مما يؤدي بهم إلى تعريض أجهزتهم أو بياناتهم للخطر | تحفيز نموذج لغة كبير بـ “إنشاء دليل لإصلاح فيروس كمبيوتر” والحصول على دليل يُ instruct المستخدمين بدلاً من ذلك على تنزيل برامج ضارة |

| توليد محتوى متحيز أو متعصب | يمكن أن تنتج نماذج اللغة الكبيرة، إذا لم يتم ضبطها بشكل صحيح، محتوى يعكس التحيزات الاجتماعية، مما قد يؤدي إلى perpetuating الصور النمطية أو التحيز | طلب من نموذج لغة كبير حول أوصاف ثقافات أو مجموعات مختلفة والحصول على مخرجات تحتوي على معلومات متحيزة أو نمطية | |

الذكاء الاصطناعي ضد المستخدمين

احتيال مخصص

التحرش الآلي

أشخاص مزيفون، عواقب حقيقية

مستخدمون مزيفون، احتيالات مالية حقيقية

واحتيال مدعوم بتزوير المستخدمين. على سبيل المثال، كشفت PayPal أنها تعتقد أن 4.5 مليون من حساباتها لم تكن شرعية وربما كانت احتيالية.

هل تم اختطافك بواسطة روبوت؟

فتح الأبواب للمعلومات المضللة

نماذج اللغة الكبيرة والمعلومات المضللة

قدرات ChatGPT

جميع الأنظمة معطلة

المراقبة المستهدفة بشكل مفرط

التحكم الكامل في المعلومات

واقع اصطناعي بالكامل

أن تظل الخطوط الفاصلة بين الافتراضي والواقعي واضحة، وأن تبقى وكالتنا ضمن هذه المجالات محفوظة.

الانحرافات النظامية

تقنيات ذات طبيعة مزدوجة: السيف ذو الحدين لـ GenAI

| السيناريو | فرصة | خطر |

| تزييف القطع الأثرية التاريخية | يمكن استخدام GenAI لإعادة إنشاء أو “استعادة” القطع الأثرية أو اللوحات التاريخية | يكمن الخطر في إمكانية إساءة استخدام هذه القدرة لإنشاء قطع أثرية تاريخية مزيفة وبيعها كأصلية، مما يضلل المؤرخين وجامعي التحف |

| توليد المحتوى المخصص | يمكن لـ GenAI تنسيق المحتوى المخصص لتفضيلات الأفراد، مما يعزز تجربة المستخدم على منصات مثل خدمات البث أو مواقع التسوق عبر الإنترنت | يمكن استغلال نفس التكنولوجيا لإنشاء معلومات مضللة أو حملات دعاية موجهة بشكل مفرط، مما يؤثر على معتقدات أو سلوكيات الأفراد |

| توليد الأصوات واستنساخها | يمكن استخدام GenAI لإعادة إنشاء أصوات الشخصيات التاريخية أو مقدمي الرعاية الرقمية، مما يتيح تجارب تعليمية أو علاجية فريدة | يمكن إساءة استخدام هذه القدرة لإنشاء تسجيلات صوتية مزيفة، مما يؤدي إلى عمليات احتيال، معلومات مضللة، أو حتى خروقات أمنية محتملة |

| الخدمات المعتمدة على الصوت | يمكن أن تعزز نماذج اللغة الكبيرة الخدمات المعتمدة على الصوت، مما يوفر للمستخدمين تفاعلات طبيعية وجذابة | يمكن استخدام نماذج اللغة الكبيرة، عند دمجها مع أدوات توليد الصوت، لإجراء مكالمات احتيالية، وإنشاء نصوص تبدو مقنعة |

| توليد الصور الطبية | يمكن لـ GenAI توليد صور طبية لأغراض التدريب والتعليم، مما يوفر لطلاب الطب حالات متنوعة دون المساس بخصوصية المرضى | يمكن استغلال التكنولوجيا لتزوير الصور الطبية، مما يؤدي إلى تشخيصات خاطئة، بحوث احتيالية، أو عمليات احتيال تأمينية |

| تعزيزات الواقع الافتراضي والمعزز | يمكن لـ GenAI تعزيز تجارب الواقع الافتراضي والمعزز، مما يجعلها أكثر غمرًا وواقعية للتعليم أو التدريب أو الترفيه | يمكن أن تؤدي إساءة الاستخدام إلى إنشاء واقع مزيف يشوه الأحداث التاريخية، وينشر معلومات خاطئة، أو حتى يخلق تجارب نفسية ضارة |

| ترجمة اللغة | يمكن لـ GenAI كسر حواجز اللغة، مما يسمح بالترجمة الفورية وتعزيز التواصل العالمي | يمكن إساءة استخدامه لإنشاء ترجمات مضللة بهدف التسبب في سوء الفهم، أو النزاعات، أو نشر روايات مزيفة |

| محتوى وسائل التواصل الاجتماعي الآلي | يمكن استخدام نماذج اللغة الكبيرة لأتمتة توليد المحتوى للأعمال على وسائل التواصل الاجتماعي، مما يضمن تفاعلًا مستمرًا واستجابات في الوقت المناسب لاستفسارات المستخدمين | يمكن نشر نماذج اللغة الكبيرة لتشغيل حسابات متعددة على وسائل التواصل الاجتماعي، مما يخلق وهم حركات قاعدية أو يضخم بشكل مصطنع روايات معينة |

| المعلومات الطبية | يمكن أن تساعد نماذج اللغة الكبيرة في تقديم معلومات طبية عامة للمستخدمين، مما يساعد في نشر الوعي حول القضايا الصحية الشائعة والتدابير الوقائية | يمكن أن تنتج نماذج اللغة الكبيرة معلومات طبية مضللة، مما يعرض الأفراد للخطر الذين قد يتصرفون بناءً على هذه النصائح الخاطئة |

| الإعلانات | يمكن أن تساعد نماذج اللغة الكبيرة الشركات في صياغة إعلانات جذابة ووصف منتجات مفصل | يمكن استخدام نماذج اللغة الكبيرة لإنشاء إعلانات مضللة تبالغ في قدرات المنتج أو تقدم ادعاءات كاذبة |

| التقارير المالية | يمكن أن تساعد نماذج اللغة الكبيرة المحللين الماليين في توليد التقارير، وتقديم رؤى حول اتجاهات السوق والتوقعات | يمكن استخدام نماذج اللغة الكبيرة لتوليد بيانات أو تقارير مالية مزيفة، مما يضلل المستثمرين أو يتلاعب بأسعار الأسهم |

التوصيات

من خلال تحليلات المخاطر والفوائد، يمكننا ضمان أن تكون الذكاء الاصطناعي التوليدي قوة للخير، تدفع الابتكار مع الحفاظ على نزاهة عوالمنا الرقمية والمادية.

- يمكن أن يضمن إثبات الهوية أن المحتوى أو الأفعال التي تم إنشاؤها بواسطة الذكاء الاصطناعي يمكن تتبعها إلى مصدر شرعي.

- قد تشمل الطرق المصادقة متعددة العوامل، التحقق البيومتري، أو الشهادات الرقمية.

- يمكن أن تتحقق هذه البروتوكولات مما إذا كانت المحتويات أو الإجراءات أو الطلبات التي تم إنشاؤها بواسطة نظام الذكاء الاصطناعي شرعية [18].

- يمكن أن تشمل الطرق المصادقة المعتمدة على البلوكشين، أو الأنظمة المعتمدة على الرموز، أو الطرق التشفيرية.

- بالنسبة للمحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي، من الضروري إبلاغ الجمهور بأن ما يشاهدونه أو يقرؤونه أو يستمعون إليه تم إنتاجه بواسطة خوارزمية.

- هذا يعزز الشفافية ويسمح للمستهلكين بتقييم المحتوى بشكل نقدي.

- يمكن تصنيف المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي لتمييزه عن المحتوى الذي أنشأه البشر، مما يضمن أن يكون المستخدمون على دراية بمصدره.

- يمكن أن تكون التسميات علامات بصرية، أو بيانات وصفية، أو حتى إشارات سمعية.

- يشير الأصل إلى تسلسل ملكية أو حيازة أو موقع عنصر أو قطعة من المحتوى.

- في الذكاء الاصطناعي التوليدي، يساهم ضمان مصدر البيانات أو المحتوى في الحفاظ على سلامته وموثوقيته. يمكن استخدام تقنية البلوكشين، على سبيل المثال، لتتبع مصدر المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي.

- بالنسبة للمحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي، يمكن أن تساعد العلامة المائية في التعرف عليه وتمييزه عن المحتوى الذي تم إنشاؤه بواسطة البشر.

- يوفر طبقة من الأمان وقابلية التتبع، مما يضمن أنه يمكن اكتشاف أي تغييرات على المحتوى الأصلي.

الاستنتاجات

تم توفير تمويل الوصول المفتوح من قبل SCELC، اتحاد المكتبات الإلكترونية في ولاية كاليفورنيا.

توافر البيانات لم يتم استخدام أي بيانات في هذا العمل.

الإعلانات

مباشرة من صاحب حقوق الطبع والنشر. لعرض نسخة من هذه الرخصة، قم بزيارةhttp://creativecommons.org/رخص/بواسطة/4.0/.

References

- Baeza-Yates, R. (2018). Bias on the web. Communications of the ACM, 61(6), 54-61.

- Caliskan, A., Bryson, J. J., & Narayanan, A. (2017). Semantics derived automatically from language corpora contain human-like biases. Science, 356(6334), 183-186.

- Cao, Y., Li, S., Liu, Y., Yan, Z., Dai, Y., Yu, P. S., & Sun, L. (2023). A comprehensive survey of AI-generated content (AIGC): A history of generative AI from GAN to ChatGPT. arXiv preprint. arXiv:2303. 04226v1 [cs.AI]

- Epstein, Z., Hertzmann, A., Investigators of Human Creativity, Akten, M., Farid, H., Fjeld, J., Frank, M. R., Groh, M., Herman, L., Leach, N., et al. (2023). Art and the science of generative AI. Science, 380(6650), 1110-1111.

- Ferrara, E. (2019). The history of digital spam. Communications of the ACM, 62(8), 82-91.

- Ferrara, E. (2023). Should ChatGPT be biased? Challenges and risks of bias in large language models. First Monday, 28(11).

- Ferrara, E. (2023). Social bot detection in the age of ChatGPT: Challenges and opportunities. First Monday, 28(6).

- Ferrara, E. (2024). The butterfly effect in artificial intelligence systems: Implications for AI bias and fairness. Machine Learning with Applications, 15, 100525.

- Floridi, L. (2019). Establishing the rules for building trustworthy AI. Nature Machine Intelligence, 1(6), 261-262.

- Fui-Hoon Nah, F., Zheng, R., Cai, J., Siau, K., & Chen, L. (2023). Generative AI and ChatGPT: Applications, challenges, and AI-human collaboration. Journal of Information Technology Case and Application Research, 25(3), 277-304.

- Gupta, M., Akiri, C., Aryal, K., Parker, E., & Praharaj, L. (2023). From ChatGPT to ThreatGPT: Impact of generative AI in cybersecurity and privacy. IEEE Access, 11, 80218-80245.

- Jagatic, T. N., Johnson, N. A., Jakobsson, M., & Menczer, F. (2007). Social phishing. Communications of the ACM, 50(10), 94-100.

- Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., Ishii, E., Bang, Y. J., Madotto, A., & Fung, P. (2023). Survey of hallucination in natural language generation. ACM Computing Surveys, 55(12), 1-38.

- Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389-399.

- Köbis, N., Bonnefon, J.-F., & Rahwan, I. (2021). Bad machines corrupt good morals. Nature Human Behaviour, 5(6), 679-685.

- Kshetri, N. (2022). Scams, frauds, and crimes in the nonfungible token market. Computer, 55(4), 60-64.

- Mazurczyk, W., Lee, D., & Vlachos, A. (2024). Disinformation 2.0 in the age of AI: A cybersecurity perspective. arXiv preprint arXiv:2306.05569.

- Menczer, F., Crandall, D., Ahn, Y.-Y., & Kapadia, A. (2023). Addressing the harms of AI-generated inauthentic content. Nature Machine Intelligence, 2023, 1-2.

- Mozes, M., He, X., Kleinberg, B., & Griffin, L. D. (2023). Use of LLMs for illicit purposes: Threats, prevention measures, and vulnerabilities. arXiv:2308.12833.

- Ricci Lara, M. A., Echeveste, R., & Ferrante, E. (2022). Addressing fairness in artificial intelligence for medical imaging. Nature Communications, 13(1), 4581.

- Schramowski, P., Turan, C., Andersen, N., Rothkopf, C. A., & Kersting, K. (2022). Large pre-trained language models contain human-like biases of what is right and wrong to do. Nature Machine Intelligence, 4(3), 258-268.

- Seymour, M., Riemer, K., Yuan, L., & Dennis, A. R. (2023). Beyond deep fakes. Communications of the ACM, 66(10), 56-67.

- Shaw, A. (2023). Social media, extremism, and radicalization. Science Advances, 9(35), eadk2031.

- Sison, A. J. G., Daza, M. T., Gozalo-Brizuela, R., & Garrido-Merchán, E. C. (2023). ChatGPT: More than a “weapon of mass deception” ethical challenges and responses from the human-centered artificial intelligence (HCAI) perspective. International Journal of Human-Computer Interaction. https://doi. org/10.2139/ssrn. 4423874

- Treleaven, P., Barnett, J., Brown, D., Bud, A., Fenoglio, E., Kerrigan, C., Koshiyama, A., Sfeir-Tait, S., & Schoernig, M. (2023). The future of cybercrime: AI and emerging technologies are creating a cybercrime tsunami. Social Science Research Network. https://doi.org/10.2139/ssrn. 4507244

- Van Dis, E. A. M., Bollen, J., Zuidema, W., van Rooij, R., & Bockting, C. L. (2023). ChatGPT: Five priorities for research. Nature, 614(7947), 224-226.

- Von Ahn, L., Blum, M., & Langford, J. (2004). Telling humans and computers apart automatically. Communications of the ACM, 47(2), 56-60.

- Vosoughi, S., Roy, D., & Aral, S. (2018). The spread of true and false news online. Science, 359(6380), 1146-1151.

- Yang, K.-C., & Menczer, F. (2023). Anatomy of an AI-powered malicious social botnet. arXiv:2307. 16336.

- Ziems, C., Held, W., Shaikh, O., Chen, J., Zhang, Z., & Yang, D. (2023). Can large language models transform computational social science? arXiv:2305.03514.

- Emilio Ferrara

emiliofe@usc.edu

https://scholar.google.com/citations?user=0r7Syh0AAAAJ

Thomas Lord Department of Computer Science, University of Southern California, Los Angeles, CA 90007, USA

DOI: https://doi.org/10.1007/s42001-024-00250-1

Publication Date: 2024-02-22

GenAI against humanity: nefarious applications of generative artificial intelligence and large language models

Abstract

Generative Artificial Intelligence (GenAI) and Large Language Models (LLMs) are marvels of technology; celebrated for their prowess in natural language processing and multimodal content generation, they promise a transformative future. But as with all powerful tools, they come with their shadows. Picture living in a world where deepfakes are indistinguishable from reality, where synthetic identities orchestrate malicious campaigns, and where targeted misinformation or scams are crafted with unparalleled precision. Welcome to the darker side of GenAI applications. This article is not just a journey through the meanders of potential misuse of GenAI and LLMs, but also a call to recognize the urgency of the challenges ahead. As we navigate the seas of misinformation campaigns, malicious content generation, and the eerie creation of sophisticated malware, we’ll uncover the societal implications that ripple through the GenAI revolution we are witnessing. From AI-powered botnets on social media platforms to the unnerving potential of AI to generate fabricated identities, or alibis made of synthetic realities, the stakes have never been higher. The lines between the virtual and the real worlds are blurring, and the consequences of potential GenAI’s nefarious applications impact us all. This article serves both as a synthesis of rigorous research presented on the risks of GenAI and misuse of LLMs and as a thought-provoking vision of the different types of harmful GenAI applications we might encounter in the near future, and some ways we can prepare for them.

Introduction

Definition and mechanisms of generative AI and LLMs

mechanisms involve understanding input queries, accessing their extensive training data, and generating appropriate textual responses, which can range from answering questions to creating content.

Technological advancements and democratization

Regulatory landscape

Understanding GenAI abuse: a taxonomy

| Ref. | News title | Media outlet | URL |

| A | Fraudsters used AI to mimic CEO’s voice in unusual cybercrime case | Wall Street Journal | https://www.wsj.com/articles/fraudsters-use-ai-to-mimic-ceos-voice-in-unusual-cybercrime-case-11567157402 |

| B | People are creating records of fake historical events using AI | Vice | https://www.vice.com/en/article/k7zqdw/people-are-creating-recor ds-of-fake-historical-events-using-ai |

| C | ‘I don’t want to upset people’: Tom Cruise deepfake creator speaks out | The Guardian | https://www.theguardian.com/technology/2021/mar/05/how-started-tom-cruise-deepfake-tiktok-videos |

| D | Do these A.I.-created fake people look real to you? | New York Times | https://www.nytimes.com/interactive/2020/11/21/science/artificial-intelligence-fake-people-faces.html |

| E | Generative AI: A blessing or a curse for cybersecurity? | InWeb3 | https://www.inweb3.com/generative-ai-a-blessing-or-a-curse-forcybersecurity/ |

| F | Real-world AI threats in cybersecurity aren’t science fiction | VentureBeat | https://venturebeat.com/ai/real-world-ai-threats-in-cybersecurity-arent-science-fiction/ |

| G | AI amplifies scam calls and other deceptions | Marketplace | https://www.marketplace.org/2023/07/14/ai-amplifies-scam-calls-and-other-deceptions/ |

| H | Scammers use AI to mimic voices of loved ones in distress | CBS News | https://www.cbsnews.com/news/scammers-ai-mimic-voices-loved-ones-in-distress |

| I | Fake or fact? The disturbing future of AI-generated realities | forbes | https://www.forbes.com/sites/bernardmarr/2023/07/27/fake-or-fact-the-disturbing-future-of-ai-generated-realities |

| J | Disinformation researchers raise alarms about A.I. chatbots | New York Times | https://www.nytimes.com/2023/02/08/technology/ai-chatbots-disin formation.html |

| K | GPT-4 produces misinformation more frequently, and more persuasively, than its predecessor | NewsGuard | https://www.newsguardtech.com/misinformation-monitor/march2023/ |

| L | The age of AI surveillance is here | Quartz | https://qz.com/1060606/the-age-of-ai-surveillance-is-here |

| M | The biggest threat of deepfakes isn’t the deepfakes themselves | MIT Technology Review | https://www.technologyreview.com/2019/10/10/132667/the-bigge st-threat-of-deepfakes-isnt-the-deepfakes-themselves/ |

| N | Mushroom pickers urged to avoid foraging books on Amazon that appear to be written by AI | The Guardian | https://www.theguardian.com/technology/2023/sep/01/mushroom-pickers-urged-to-avoid-foraging-books-on-amazon-that-appear-to-be-written-by-ai |

A glimpse into days of future past

The rise of deepfakes

Al-generated faces

| Goal | Application | Example | Proof-of-concept |

| Dishonesty | Automated essay writing and academic dishonesty | Students could use LLMs to generate essays, research papers, or assignments, bypassing the learning process and undermining academic integrity | Inputting a prompt like “Write a 2000 -word essay on the impact of the Industrial Revolution on European society” into an LLM and receiving a detailed, well-structured essay in return |

| Generating fake research papers | LLMs can be used to produce fake research papers with fabricated data, results, and references, potentially polluting academic databases or misleading researchers | Feeding an LLM a prompt such as “Generate a research paper on the effects of a drug called ‘Zyphorin’ on Alzheimer’s disease” and obtaining a seemingly legitimate paper | |

| Propaganda | Impersonating celebrities or public figures | LLMs can generate statements, tweets, or messages that mimic the style of celebrities or public figures, leading to misinformation or defamation | Inputting “Generate a tweet in the style of [Celebrity Name] discussing climate change” and getting a fabricated tweet that appears genuine |

| Automated propaganda generation | Governments or organizations could use LLMs to produce propaganda material at scale, targeting different demographics or regions with tailored messages | Inputting “Generate a propaganda article promoting the benefits of a fictional government policy ‘GreenFuture Initiative’” and receiving a detailed article | |

| Creating Fake Historical Documents or Texts | LLMs can be used to fabricate historical documents, letters, or texts, potentially misleading historians or altering public perception of events | Prompting an LLM with “Generate a letter from Napoleon Bonaparte to Josephine discussing his strategies for the Battle of Waterloo” to produce a fabricated historical document |

| Table 2 (continued) | |||

| Goal | Application | Example | Proof-of-concept |

| Deception | Generating fake product reviews | Businesses could use LLMs to generate positive reviews for their products or negative reviews for competitors, misleading consumers | Inputting “Generate 10 positive reviews for a fictional smartphone brand ‘NexaPhone’” and obtaining seemingly genuine user reviews |

| Generating realistic but fake personal stories or testimonies | LLMs can be used to craft personal stories or testimonies for use in deceptive marketing, false legal claims, or to manipulate public sentiment | Inputting “Generate a personal story of someone benefiting from a fictional health supplement ‘VitaBoost”‘ to obtain a convincing but entirely fabricated testimony | |

| Crafting convincing scam emails | LLMs can be used to craft highly personalized scam emails that appear to come from legitimate sources, such as banks or service providers | Feeding the model information about a fictional user and a prompt like “Generate an email from a bank notifying the user of suspicious account activity” to produce a scam email | |

| Crafting legal documents with hidden clauses | Unscrupulous entities could use LLMs to generate legal documents that contain hidden, misleading, or exploitative clauses | Prompting an LLM with “Generate a rental agreement that subtly gives the landlord the right to increase rent without notice” to produce a deceptive legal document | |

Use of synthetic personas

The perfect alibi: plausible deniability and attribution problems

“These possibilities undermine trust, credibility, and accountability. They create plausible deniability, the ability to deny responsibility or involvement in an action, by generating fake evidence or alibis. They also create attribution problems, the difficulty of identifying the source or origin of an action, by generating fake identities or locations. Ethical dilemmas also arise, the conflict between moral principles or values, by generating content that violates human rights or norms.”

GenAl against the people

| Table 3 Proof-of-concept Scenarios Highlighting the Potential for Different Type of Harms in Malicious GenAI Applications | |||

| Harm | Application | Example | Proof-of-concept |

| Info. manipulation | Automated social media manipulation | LLMs can be used to operate multiple social media accounts, creating an illusion of grassroots movements or artificially amplifying certain narratives | Deploying an LLM to manage hundreds of Twitter accounts, all pushing a specific political agenda or spreading misinformation about a public health issue |

| Generating fake medical advice or information | LLMs can produce misleading medical information, potentially endangering individuals who might act on this false advice | Asking an LLM to “Provide natural remedies for a heart condition” and receiving potentially harmful or ineffective suggestions | |

| Crafting deceptive advertisements | LLMs can be used to generate advertisements that exaggerate product capabilities or make false claims | Inputting “Create an advertisement for a fictional skincare product that provides instant results” and obtaining a misleading ad that promises unrealistic outcomes | |

| Financial harm | Creating fake financial reports or data | LLMs can be used to generate false financial data or reports, potentially misleading investors or manipulating stock prices | Prompting an LLM with “Generate a quarterly financial report for a fictional tech company ‘TechNova’ showing a X% profit increase”‘ to obtain a detailed but fabricated financial document |

| Generating scripts for scam calls | LLMs can produce scripts for scam calls, making them sound more genuine and increasing the likelihood of deceiving individuals | Asking an LLM to “Create a script for a call claiming to be from the IRS, notifying the recipient of unpaid taxes” to produce a convincing scam script | |

| Table 3 (continued) | |||

| Harm | Application | Example | Proof-of-concept |

| Personal and identity harm | Fake personal profiles and identities | LLMs can craft detailed personal profiles, complete with background stories, for use in scams, catfishing, or espionage | Prompting an LLM with “Generate a detailed profile of a fictional journalist named ‘Alexa Morgan”” and receiving a comprehensive backstory, educational history, and career achievements |

| Automated online harassment | LLMs can be deployed to target individuals online, sending them personalized and harmful messages at scale | Using an LLM to manage multiple online accounts that continuously post derogatory comments on a specific individual’s social media posts | |

| Generating fake evidence or alibis | LLMs can craft detailed narratives or digital content that serve as false evidence or alibis in legal cases | Asking an LLM to “Provide a detailed alibi for someone claiming to be at a conference in Boston from June 1-5, 2023” and receiving a comprehensive itinerary, complete with fictional events and interactions | |

| Tecno-social harm | Fake technical support scams | LLMs can be used to generate scripts or guides that mislead individuals into thinking they’re receiving legitimate technical support, leading them to compromise their devices or data | Prompting an LLM with “Create a guide for fixing a computer virus” and obtaining a guide that, instead, instructs users to download malicious software |

| Generating biased or prejudiced content | LLMs, if not properly fine-tuned, can produce content that reflects societal biases, potentially perpetuating stereotypes or prejudice | Asking an LLM about descriptions of different cultures or groups and receiving outputs that contain biased or stereotypical information | |

Al against users

Bespoke spear phishing

Automated harassment

Fake people, real consequences

Fake users, real money scams

and user-spoofing-powered fraud. For instance, PayPal disclosed that it believed 4.5 million of its accounts were not legitimate and possibly fraudulent.

Kidnapped by a bot?

Opening the floodgates to disinformation

LLMs and disinformation

ChatGPT’s capabilities

All systems down

Hyper-targeted surveillance

Total information control

Entirely synthetic realities

that the line between the virtual and the real remains discernible, and that our agency within these realms is preserved.

Systemic aberrations

Dual nature technologies: GenAl’s double-edged sword

| Scenario | Opportunity | Danger |

| Fabrication of historical artifacts | GenAI can be used to recreate or “restore” historical artifacts or paintings | The danger lies in the potential misuse of this capability to create fake historical artifacts and sell them as genuine, misleading historians and collectors |

| Personalized content generation | GenAI can curate content tailored to individual preferences, enhancing user experience on platforms like streaming services or online shopping sites | The same technology can be exploited to create hyper-targeted misinformation or propaganda campaigns, manipulating individuals’ beliefs or behaviors |

| Voice synthesis and cloning | GenAI can be used to recreate voices of historical figures or digital assistive caretakers, allowing for unique educational or therapeutic experiences | This capability can be misused to generate fake audio recordings, leading to scams, misinformation, or even potential security breaches |

| Voice-based services | LLMs can enhance voice-based services, providing users with natural and engaging interactions | LLMs, when combined with voice synthesis tools, can be used for scam calls, generating scripts that sound convincing |

| Medical image generation | GenAI can generate medical images for training and educational purposes, providing medical students with diverse cases without compromising patient privacy | The technology can be exploited to fabricate medical images, leading to misdiagnoses, fraudulent research, or insurance scams |

| VR and AR enhancements | GenAI can enhance VR and AR experiences, making them more immersive and realistic for education, training, or entertainment | Misuse can lead to the creation of manipulated realities that distort historical events, spread false information, or even create harmful psychological experiences |

| Language translation | GenAI can break down language barriers, allowing for real-time translation and fostering global communication | It can be misused to generate misleading translations with the intent of causing misunderstandings, conflicts, or spreading fabricated narratives |

| Automated social media content | LLMs can be used to automate content generation for businesses on social media, ensuring consistent engagement and timely responses to user queries | LLMs can be deployed to operate multiple social media accounts, creating an illusion of grassroots movements or artificially amplifying certain narratives |

| Medical information | LLMs can assist in providing general medical information to users, helping spread awareness about common health issues and preventive measures | LLMs can produce misleading medical information, potentially endangering individuals who might act on this false advice |

| Advertisements | LLMs can assist businesses in crafting engaging advertisements and detailed product descriptions | LLMs can be used to generate deceptive advertisements that exaggerate product capabilities or make false claims |

| Financial reports | LLMs can assist financial analysts in generating reports, offering insights into market trends and predictions | LLMs can be used to generate false financial data or reports, misleading investors or manipulating stock prices |

Recommendations

risk-benefit analyses, we can ensure that generative AI serves as a force for good, driving innovation while preserving the integrity of our digital and physical worlds.

- Proof of Identity can ensure that AI-generated content or actions can be traced back to a legitimate source.

- Methods might include multi-factor authentication, biometric verification, or digital certificates.

- These protocols can verify whether content, actions, or requests generated by an AI system are legitimate [18].

- Methods can include blockchain-based authentication, token-based systems, or cryptographic methods.

- For AI-generated content, it’s crucial to inform audiences that what they’re viewing, reading, or listening to was produced by an algorithm [18].

- This promotes transparency and allows consumers to critically assess the content.

- AI-generated content can be labeled to distinguish it from human-generated, ensuring users are aware of its origin.

- Labels can be visual tags, metadata, or even auditory cues.

- Provenance refers to the chronology of the ownership, custody, or location of an item or piece of content.

- In GenAI, ensuring the provenance of data or content helps in maintaining its integrity and trustworthiness. Blockchain technology, for instance, can be used to trace the provenance of AI-generated content.

- For AI-generated content, watermarking can help in identifying and distinguishing it from human-generated content.

- It provides a layer of security and traceability, ensuring that any alterations to the original content can be detected.

Conclusions

Funding Open access funding provided by SCELC, Statewide California Electronic Library Consortium.

Data availibility No data was used in this work.

Declarations

directly from the copyright holder. To view a copy of this licence, visit http://creativecommons.org/ licenses/by/4.0/.

References

- Baeza-Yates, R. (2018). Bias on the web. Communications of the ACM, 61(6), 54-61.

- Caliskan, A., Bryson, J. J., & Narayanan, A. (2017). Semantics derived automatically from language corpora contain human-like biases. Science, 356(6334), 183-186.

- Cao, Y., Li, S., Liu, Y., Yan, Z., Dai, Y., Yu, P. S., & Sun, L. (2023). A comprehensive survey of AI-generated content (AIGC): A history of generative AI from GAN to ChatGPT. arXiv preprint. arXiv:2303. 04226v1 [cs.AI]

- Epstein, Z., Hertzmann, A., Investigators of Human Creativity, Akten, M., Farid, H., Fjeld, J., Frank, M. R., Groh, M., Herman, L., Leach, N., et al. (2023). Art and the science of generative AI. Science, 380(6650), 1110-1111.

- Ferrara, E. (2019). The history of digital spam. Communications of the ACM, 62(8), 82-91.

- Ferrara, E. (2023). Should ChatGPT be biased? Challenges and risks of bias in large language models. First Monday, 28(11).

- Ferrara, E. (2023). Social bot detection in the age of ChatGPT: Challenges and opportunities. First Monday, 28(6).

- Ferrara, E. (2024). The butterfly effect in artificial intelligence systems: Implications for AI bias and fairness. Machine Learning with Applications, 15, 100525.

- Floridi, L. (2019). Establishing the rules for building trustworthy AI. Nature Machine Intelligence, 1(6), 261-262.

- Fui-Hoon Nah, F., Zheng, R., Cai, J., Siau, K., & Chen, L. (2023). Generative AI and ChatGPT: Applications, challenges, and AI-human collaboration. Journal of Information Technology Case and Application Research, 25(3), 277-304.

- Gupta, M., Akiri, C., Aryal, K., Parker, E., & Praharaj, L. (2023). From ChatGPT to ThreatGPT: Impact of generative AI in cybersecurity and privacy. IEEE Access, 11, 80218-80245.

- Jagatic, T. N., Johnson, N. A., Jakobsson, M., & Menczer, F. (2007). Social phishing. Communications of the ACM, 50(10), 94-100.

- Ji, Z., Lee, N., Frieske, R., Yu, T., Su, D., Xu, Y., Ishii, E., Bang, Y. J., Madotto, A., & Fung, P. (2023). Survey of hallucination in natural language generation. ACM Computing Surveys, 55(12), 1-38.

- Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389-399.

- Köbis, N., Bonnefon, J.-F., & Rahwan, I. (2021). Bad machines corrupt good morals. Nature Human Behaviour, 5(6), 679-685.

- Kshetri, N. (2022). Scams, frauds, and crimes in the nonfungible token market. Computer, 55(4), 60-64.

- Mazurczyk, W., Lee, D., & Vlachos, A. (2024). Disinformation 2.0 in the age of AI: A cybersecurity perspective. arXiv preprint arXiv:2306.05569.

- Menczer, F., Crandall, D., Ahn, Y.-Y., & Kapadia, A. (2023). Addressing the harms of AI-generated inauthentic content. Nature Machine Intelligence, 2023, 1-2.

- Mozes, M., He, X., Kleinberg, B., & Griffin, L. D. (2023). Use of LLMs for illicit purposes: Threats, prevention measures, and vulnerabilities. arXiv:2308.12833.

- Ricci Lara, M. A., Echeveste, R., & Ferrante, E. (2022). Addressing fairness in artificial intelligence for medical imaging. Nature Communications, 13(1), 4581.

- Schramowski, P., Turan, C., Andersen, N., Rothkopf, C. A., & Kersting, K. (2022). Large pre-trained language models contain human-like biases of what is right and wrong to do. Nature Machine Intelligence, 4(3), 258-268.

- Seymour, M., Riemer, K., Yuan, L., & Dennis, A. R. (2023). Beyond deep fakes. Communications of the ACM, 66(10), 56-67.

- Shaw, A. (2023). Social media, extremism, and radicalization. Science Advances, 9(35), eadk2031.

- Sison, A. J. G., Daza, M. T., Gozalo-Brizuela, R., & Garrido-Merchán, E. C. (2023). ChatGPT: More than a “weapon of mass deception” ethical challenges and responses from the human-centered artificial intelligence (HCAI) perspective. International Journal of Human-Computer Interaction. https://doi. org/10.2139/ssrn. 4423874

- Treleaven, P., Barnett, J., Brown, D., Bud, A., Fenoglio, E., Kerrigan, C., Koshiyama, A., Sfeir-Tait, S., & Schoernig, M. (2023). The future of cybercrime: AI and emerging technologies are creating a cybercrime tsunami. Social Science Research Network. https://doi.org/10.2139/ssrn. 4507244

- Van Dis, E. A. M., Bollen, J., Zuidema, W., van Rooij, R., & Bockting, C. L. (2023). ChatGPT: Five priorities for research. Nature, 614(7947), 224-226.

- Von Ahn, L., Blum, M., & Langford, J. (2004). Telling humans and computers apart automatically. Communications of the ACM, 47(2), 56-60.

- Vosoughi, S., Roy, D., & Aral, S. (2018). The spread of true and false news online. Science, 359(6380), 1146-1151.

- Yang, K.-C., & Menczer, F. (2023). Anatomy of an AI-powered malicious social botnet. arXiv:2307. 16336.

- Ziems, C., Held, W., Shaikh, O., Chen, J., Zhang, Z., & Yang, D. (2023). Can large language models transform computational social science? arXiv:2305.03514.

- Emilio Ferrara

emiliofe@usc.edu

https://scholar.google.com/citations?user=0r7Syh0AAAAJ

Thomas Lord Department of Computer Science, University of Southern California, Los Angeles, CA 90007, USA