DOI: https://doi.org/10.1038/s41598-025-92190-7

PMID: https://pubmed.ncbi.nlm.nih.gov/40069265

تاريخ النشر: 2025-03-11

تقارير علمية

مفتوح

توجيه تطوير الذكاء الاصطناعي العام: مسارات اجتماعية، تكنولوجية، أخلاقية، مستوحاة من الدماغ

الملخص

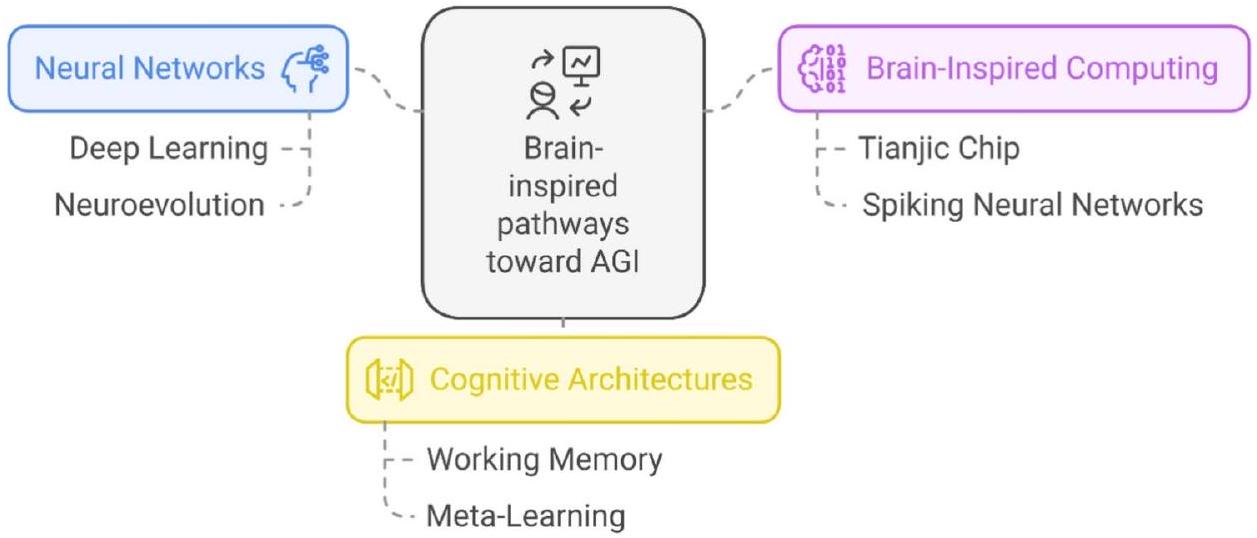

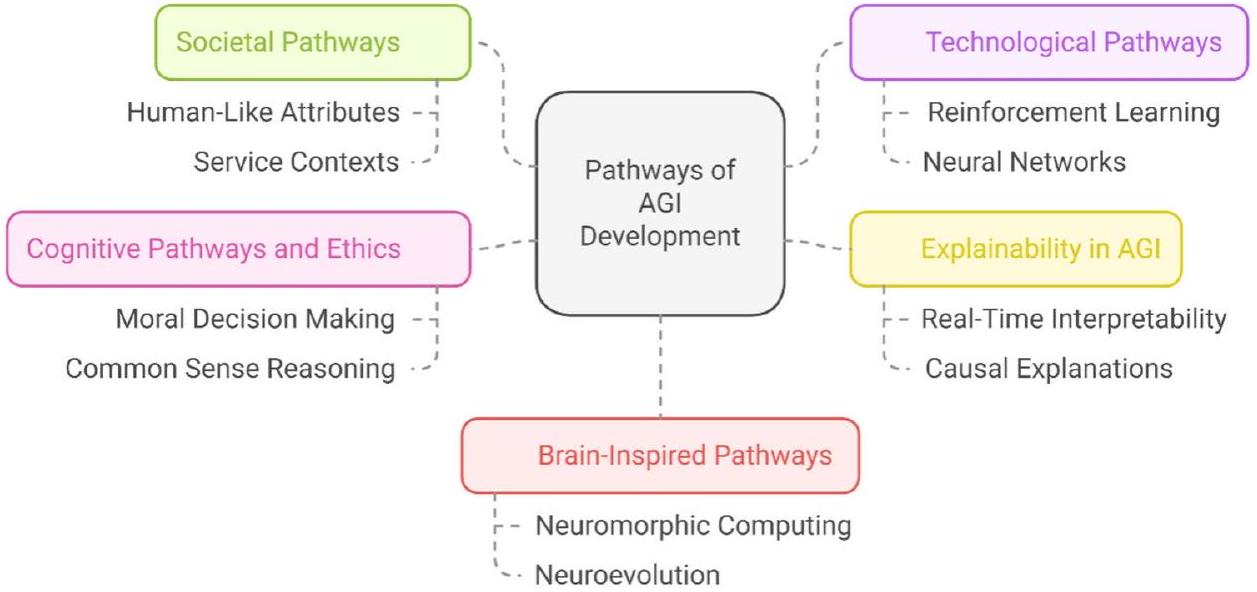

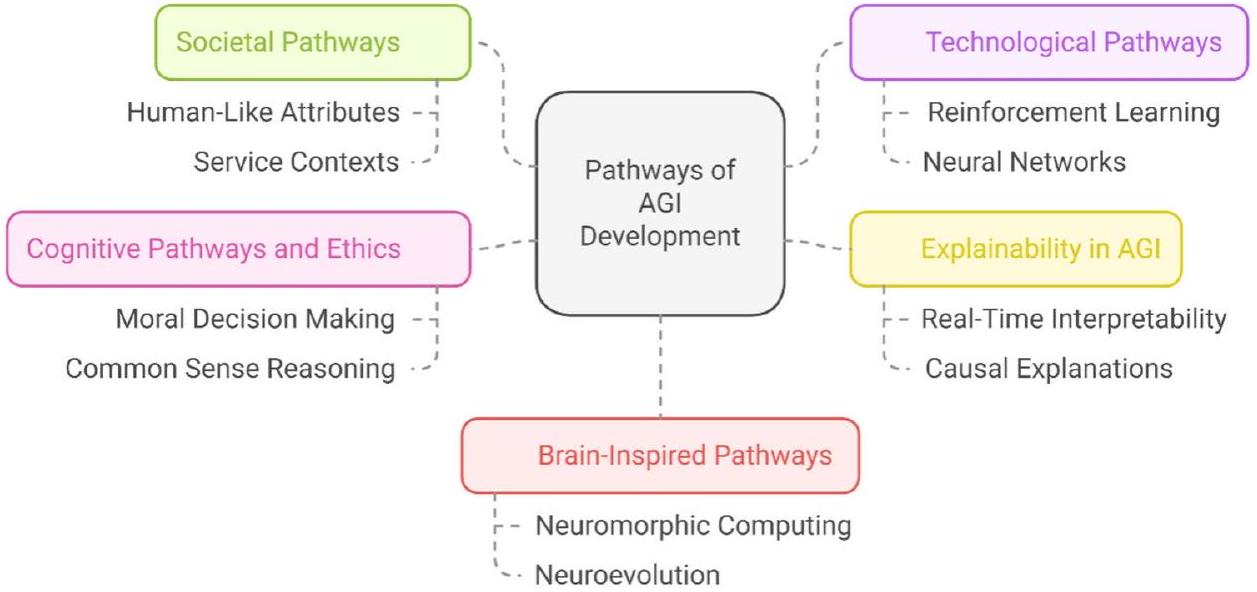

تدرس هذه الدراسة الضرورة الملحة لمواءمة تطوير الذكاء الاصطناعي العام (AGI) مع المسارات الاجتماعية والتكنولوجية والأخلاقية والمستوحاة من الدماغ لضمان دمجه المسؤول في الأنظمة البشرية. باستخدام إطار عمل PRISMA ونمذجة BERTopic، تحدد خمس مسارات رئيسية تشكل مسار AGI: (1) التكامل الاجتماعي، الذي يتناول التأثيرات الاجتماعية الأوسع لـ AGI، والتبني العام، واعتبارات السياسة؛ (2) التقدم التكنولوجي، الذي يستكشف التطبيقات الواقعية، وتحديات التنفيذ، وقابلية التوسع؛ (3) القابلية للتفسير، التي تعزز الشفافية والثقة وقابلية التفسير في اتخاذ قرارات AGI؛ (4) الاعتبارات المعرفية والأخلاقية، التي تربط بين الهياكل المتطورة لـ AGI والأطر الأخلاقية، والمساءلة، والعواقب الاجتماعية؛ و(5) الأنظمة المستوحاة من الدماغ، التي تستفيد من النماذج العصبية البشرية لتحسين كفاءة تعلم AGI، وقابليته للتكيف، وقدراته على التفكير. تقدم هذه الدراسة مساهمة فريدة من خلال الكشف المنهجي عن مواضيع AGI التي لم يتم استكشافها بشكل كافٍ، واقتراح إطار مفاهيمي يربط بين تقدم الذكاء الاصطناعي والتطبيقات العملية، ومعالجة التحديات التقنية والأخلاقية والاجتماعية المتعددة الأوجه لتطوير AGI. تدعو النتائج إلى التعاون بين التخصصات لسد الفجوات الحرجة في الشفافية، والحكم، والتوافق الاجتماعي، مع اقتراح استراتيجيات للوصول العادل، وتكيف القوى العاملة، والدمج المستدام. بالإضافة إلى ذلك، تسلط الدراسة الضوء على الحدود البحثية الناشئة، مثل واجهات الوعي AGI وأنظمة الذكاء الجماعي، مما يوفر مسارات جديدة لدمج AGI في التطبيقات الموجهة نحو الإنسان. من خلال تجميع الرؤى عبر التخصصات، تقدم هذه الدراسة خارطة طريق شاملة لتوجيه تطوير AGI بطرق توازن بين الابتكار التكنولوجي والمسؤوليات الأخلاقية والاجتماعية، مما يعزز التقدم الاجتماعي والرفاهية.

طرق وأساليب تمثيل المعرفة المتنوعة مثل الوعي والأخلاق والتفاعل الاجتماعي لمعالجة الفجوات في الهياكل الحالية وتعزيز قدرات الذكاء الاصطناعي العام. سالمون وآخرون.

- ما هي المسارات اللازمة لتمكين الذكاء الاصطناعي العام القابل للتوسع والتكيف والتفسير عبر بيئات متنوعة؟

- كيف يمكن تطوير أنظمة الذكاء العام الاصطناعي لتتوافق مع المبادئ الأخلاقية واحتياجات المجتمع والوصول العادل؟

- ما هي المسارات التي يمكن أن تضمن التعاون الفعال والثقة والشفافية بين البشر وأنظمة الذكاء الاصطناعي العام؟

- كيف يمكن للذكاء العام الاصطناعي أن يساهم في التقدم من خلال التكامل بين التخصصات؟

الخلفية المفاهيمية

- الذكاء الاصطناعي الضعيف (المعروف أيضًا بالذكاء الاصطناعي الضيق): يشمل هذا الأنظمة الذكية المصممة للتفوق في مهام محددة ومحددة جيدًا دون امتلاك قدرات معرفية عامة أو قدرات استدلال. غالبًا ما يكون الذكاء الاصطناعي الضعيف، الذي يركز على مهام معينة، فعالًا للغاية ضمن نطاقه ولكنه لا يمكنه التكيف أو تطبيق المعرفة خارج وظائفه المدربة. تشمل الأمثلة المساعدات الصوتية مثل سيري، وأدوات ترجمة اللغة، وخوارزميات التوصية، والأنظمة المتخصصة مثل AlphaGo.

. - الذكاء الاصطناعي بمستوى الإنسان: يصف هذا المفهوم الذكاء الاصطناعي الذي يتطابق مع القدرات المعرفية البشرية، مثل التفكير الطبيعي، وفهم المشاعر، واتخاذ القرارات المعقدة. على سبيل المثال، يمكن أن يحاكي الذكاء الاصطناعي بمستوى الإنسان الحدس البشري في مجالات مثل الدبلوماسية أو السرد الإبداعي، مما يظهر تساويًا سلوكيًا مع البشر.

. - الذكاء الاصطناعي الشبيه بالبشر: يركز هذا المفهوم على تقليد السلوكيات البشرية، مثل الكلام، تعبيرات الوجه، والاستجابات العاطفية. على عكس الذكاء الاصطناعي العام، يولي الذكاء الاصطناعي الشبيه بالبشر الأولوية للتفاعل والقابلية للتواصل على حساب التنوع المعرفي. تشمل الأمثلة أنظمة المحادثة مثل ChatGPT أو الروبوتات الشبيهة بالبشر مثل صوفيا، التي تحاكي المشاعر البشرية.

. - الذكاء الاصطناعي العام (AGI): يشير AGI إلى أنظمة الذكاء الاصطناعي التي يمكنها فهم والتعلم والتكيف لأداء أي مهمة فكرية يمكن أن يؤديها الإنسان. على عكس الذكاء الاصطناعي الضيق، يقوم AGI بتعميم التعلم عبر مجالات متعددة ويطبق التفكير على مشاكل جديدة وغير مألوفة. يمكن لنظام AGI حقيقي تشخيص الأمراض، وتأليف السيمفونيات، وتصميم أنظمة هندسية معقدة – كل ذلك دون برمجة محددة للمهام.

. - الذكاء الاصطناعي القوي: يشير الذكاء الاصطناعي القوي، الذي غالبًا ما يُعتبر مرادفًا للذكاء الاصطناعي العام، إلى نظام ذكاء اصطناعي يمتلك فهمًا حقيقيًا، ووعيًا، ووعيًا ذاتيًا. بينما يركز الذكاء الاصطناعي العام على الأداء الوظيفي، يتساءل الذكاء الاصطناعي القوي عما إذا كانت الآلات يمكن أن “تفكر” بطريقة تشبه البشر، مما يثير نقاشات فلسفية حول الوعي.

.

| نوع الذكاء الاصطناعي | تعريف | الخصائص الرئيسية | الاعتبارات الأخلاقية | أمثلة |

| الذكاء الاصطناعي الضعيف | تم تصميم أنظمة الذكاء الاصطناعي لأداء مهام محددة بكفاءة دون قدرات معرفية عامة. | محدد المهام وذو أهداف؛ قابلية التكيف محدودة خارج الوظائف المدربة | التحيزات في المخرجات، محدودية الشرح، والاعتماد على مجموعات بيانات تدريب قد تكون معيبة | أنظمة التعرف على الصور، ومحركات التوصية، والمساعدات الافتراضية مثل أليكسا أو مساعد جوجل |

| ذكاء اصطناعي بمستوى إنساني | أنظمة الذكاء الاصطناعي التي يمكن أن تنافس القدرات البشرية في المهام الفكرية والمعرفية | أداء قابل للمقارنة مع البشر؛ التفكير عبر مهام متنوعة | التحيزات في قرارات الذكاء الاصطناعي، استبدال الوظائف البشرية، والاحتمال المحتمل لتآكل الخصوصية | تم مناقشته في سيناريوهات اختبار تورينغ والذكاء الاصطناعي القادر على اللعب بمستوى بشري مثل ألفا غو |

| ذكاء اصطناعي شبيه بالبشر | تم تصميم أنظمة الذكاء الاصطناعي لمحاكاة السلوكيات المعرفية البشرية، والتفكير، ومهارات حل المشكلات. | استجابات وسلوكيات شبيهة بالبشر؛ التركيز على التقليد | تلاعب المستخدم، الشفافية في سلوك الذكاء الاصطناعي، والحفاظ على تفاعلات أخلاقية بين الإنسان والذكاء الاصطناعي | تشات جي بي تي، سيري، صوفيا الروبوت، والذكاء الاصطناعي المحادثي |

| الذكاء الاصطناعي العام (AGI) | أنظمة الذكاء الاصطناعي قادرة على أداء أي مهمة فكرية يمكن أن يقوم بها الإنسان، مع القدرة على التكيف عبر المجالات. | قدرات التعلم والاستدلال العامة؛ غير محددة المهمة | سوء الاستخدام، والسيطرة، والعواقب غير المقصودة تؤثر على المجتمع البشري، مما يتطلب أطرًا للحكم والسلامة | أنظمة افتراضية مثل OpenCog والمفاهيم التي تم استكشافها في أبحاث DeepMind حول الذكاء الاصطناعي العام |

| الذكاء الاصطناعي القوي | الذكاء الاصطناعي الذي يظهر فهمًا حقيقيًا، واستدلالًا، ووعيًا مشابهًا للبشر | القدرة على التفكير والفهم والتأمل الذاتي، وليس مجرد تنفيذ المهام | حقوق الآلات، الوكالة الأخلاقية، والمساءلة في عمليات اتخاذ القرار | لا توجد أمثلة من العالم الحقيقي حتى الآن؛ تم استكشافها في مناقشات الذكاء الاصطناعي الفلسفية (مثل “حجة الغرفة الصينية” لجون سيرل) |

| الذكاء الخارق الاصطناعي | ذكاء اصطناعي افتراضي يتجاوز الذكاء البشري في جميع المجالات، بما في ذلك اتخاذ القرار والإبداع | يتجاوز القدرات المعرفية البشرية؛ قادر على التحسين الذاتي السريع | فقدان السيطرة البشرية، توزيع غير متساوٍ للقوة، وتهديدات وجودية للبشرية | سيناريوهات نيك بوستروم في الذكاء الخارق؛ تصويرات مستقبلية في أفلام مثل “هي” أو “إكس ماشينا”. |

| نوع الذكاء الاصطناعي | الصناعات والمجالات | تطبيقات نموذجية |

| ذكاء اصطناعي بمستوى الإنسان | – خدمة العملاء: وكلاء الذكاء الاصطناعي الذين يحاكون التواصل البشري. – الألعاب: خصوم يشبهون البشر لتجربة لعب تكيفية. – التعليم: مدرسون فعالون مثل المعلمين البشريين. – التصنيع: روبوتات قادرة على اتخاذ قرارات المهام المعرفية. – الترفيه: أفلام، رسوم متحركة، أو إنشاء محتوى. | – معلمون مدعومون بالذكاء الاصطناعي يقدمون دعمًا مخصصًا. – شخصيات ألعاب مدفوعة بالذكاء الاصطناعي تتكيف ديناميكيًا مع المستخدمين. |

| ذكاء اصطناعي شبيه بالبشر | – التجزئة: مساعدين افتراضيين للعملاء يقدمون تفاعلات شبيهة بالبشر. – الرعاية الصحية: دعم الصحة النفسية عبر رفقاء الذكاء الاصطناعي. – الضيافة: روبوتات شبيهة بالبشر تساعد في رعاية العملاء. – التعليم: معلمون تفاعليون اجتماعيون للأطفال. – التسويق: اتصالات وحملات مخصصة بواسطة الذكاء الاصطناعي. | – روبوتات الذكاء الاصطناعي تساعد المرضى المسنين. مساعدين للتسوق الافتراضي يعززون تجربة العملاء |

| الذكاء الاصطناعي العام (AGI) | – الرعاية الصحية: التشخيص، العلاجات المخصصة، اتخاذ القرارات المتقدمة. – التعليم: أنظمة التعلم التكيفية. – المالية: نمذجة المخاطر الديناميكية، توقعات السوق. – الدفاع: المحاكاة الاستراتيجية. – البحث والتطوير: الاكتشاف العلمي والابتكار عبر التخصصات. | – أطباء مدعومون بالذكاء الاصطناعي قادرون على التشخيص الذاتي. – مساعدين بحثيين مدعومين بالذكاء الاصطناعي يكتشفون مواد أو أدوية جديدة. |

| الذكاء الاصطناعي القوي | – الفلسفة/الأخلاق: فهم الوعي والإدراك. – الرعاية الصحية: التفكير المعرفي للرعاية الشخصية. – القطاع القانوني: اتخاذ قرارات مستقلة في الحالات المعقدة. – الصناعات الإبداعية: الإبداع الفني أو الإبداع الحقيقي. – الروبوتات: روبوتات مستقلة بالكامل. | – أنظمة الذكاء الاصطناعي القادرة على التفكير الأخلاقي أو التعاطف. – قضاة ذكاء اصطناعي يتعاملون مع القضايا القانونية بنزاهة وأخلاق. |

| الذكاء الخارق الاصطناعي | – الدفاع والأمن: اتخاذ قرارات استراتيجية مستقلة تتجاوز القدرات البشرية. – المالية: تحسين الاقتصاد العالمي. – الطاقة: أنظمة تخصيص موارد عالية الكفاءة. – البحث العلمي: ميكانيكا الكم، نمذجة المناخ، أو استكشاف الفضاء العميق. – الحوكمة: صنع السياسات وحل المشكلات المدعوم بالذكاء الاصطناعي. | – نمذجة تغير المناخ تتجاوز دقة الإنسان بكثير.- أنظمة حوكمة مدعومة بالذكاء الاصطناعي محسّنة |

- الذكاء الاصطناعي الفائق (ASI): يشير ASI إلى أنظمة الذكاء الاصطناعي الافتراضية التي تتجاوز الذكاء البشري في كل جانب قابل للقياس، بما في ذلك الإبداع والتفكير الاستراتيجي وحل المشكلات. بينما يتطابق الذكاء الاصطناعي العام (AGI) مع القدرات البشرية، فإن ASI تحقق قدرات تتجاوز الفهم البشري، مما يثير أسئلة أخلاقية ووجودية هامة.

.

الأعمال ذات الصلة

الحجة التي تقول إن الآلات لا يمكن أن تمتلك مشاعر بسبب عدم وجود مشاعر، تقترح بدلاً من ذلك أن أنظمة الذكاء الاصطناعي العام يمكن أن تمتلك مشاعر من خلال قدرتها على الحكم، كما يتضح في مشاعر مثل الغضب. تريغيرو وآخرون.

| المؤلفون | تركيز البحث | فجوات البحث |

| Bécue وآخرون.

|

يستكشف الابتكار المدفوع بـ AGI من خلال توافق نضج الذكاء الاصطناعي، واستراتيجيات التصنيع، وقدرة الابتكار، مع التأكيد على دور AGI في اتخاذ القرار وحل المشكلات المعقدة في الصناعة 5.0 | توافق نضج الذكاء الاصطناعي مع مقاييس الابتكار |

| Yue و Shyu

|

يستفيد من AGI في إنشاء شبكات دمج الذكاء لإدارة الأزمات الاستباقية، مع دمج مبادئ تكامل البيانات متعددة المصادر، والوعي بالوضع، واتخاذ القرار | قابلية توسيع شبكات دمج الذكاء المدفوعة بـ AGI |

| Li وآخرون.

|

يستخدم مبادئ AGI مثل التعلم متعدد الوسائط، واستخراج المعرفة الخاصة بالمجال، وتحسين العمليات لمعالجة التحديات المعقدة في قطاع الطاقة الجيولوجية | المعرفة الخاصة بالمجال لتطبيق AGI |

|

|

يفحص تأثير AGI على إعادة تعريف الأدوار والمهارات المهنية، مع التركيز على التعاون بين AGI والبشر، والتفكير الأخلاقي، والقدرة على التكيف في بيئة معلومات مدفوعة بـ AGI | تكييف مجموعة المهارات لبيئات مدفوعة بـ AGI |

| Chiroma وآخرون.

|

يركز على التطبيقات المتعلقة بـ AGI في إنترنت الأشياء الطبية، بما في ذلك الذكاء الاصطناعي القابل للتفسير لاتخاذ القرارات الصحية، والتحليلات التنبؤية لأنظمة مراقبة الصحة في الوقت الحقيقي | معالجة الأمان والخصوصية في إنترنت الأشياء الطبية |

| McLean وآخرون.

|

يحلل المخاطر المتعلقة بـ AGI مثل عدم توافق الأهداف، واتخاذ القرار المستقل، والتهديدات الوجودية التي تشكلها AGI، مقترحًا أطر حوكمة للتخفيف من هذه المخاطر | نقص في مصطلحات وتعريفات AGI القياسية |

| Wang وآخرون.

|

يستعرض نماذج الرؤية الكبيرة المدفوعة بـ AGI وهندسة المطالبات البصرية، مع التأكيد على قدرة AGI على تكييف المطالبات لمهام بصرية قابلة للتعميم وواعية بالسياق | تصميم مطالبات بصرية فعالة لأنظمة AGI |

| Daase و Turowski

|

يقترح منهجيات متوافقة مع AGI للذكاء الاصطناعي القابل للتفسير، موصلًا بين العلوم السلوكية وعلوم التصميم لتطوير أنظمة AGI عامة الأغراض لمجتمع 5.0 | منهجيات موحدة للذكاء الاصطناعي القابل للتفسير |

| Yang وآخرون.

|

يحدد تحديات AGI في تحليل المخططات، مع التركيز على قدرة AGI على فهم الشكل، والطوبولوجيا، واسترجاع الصور المعتمد على المحتوى للتطبيقات التقنية | التقدم في تقنيات استرجاع المخططات المحددة |

| Krishnan وآخرون.

|

يستكشف دمج AGI مع التقنيات المزعزعة مثل إنترنت الأشياء والأنظمة المستقلة، مع التأكيد على دوره في أطر المدن الذكية القابلة للتكيف، والقابلة للتوسع، والمركزية حول الإنسان | تحديات التنفيذ للتقنيات المتداخلة |

| Krishnan وآخرون.

|

يستكشف مبادئ AGI مثل القدرة على التكيف والتفاعل متعدد الوكلاء لتحسين التقنيات المزعزعة في المدن الذكية، باستخدام نماذج تجريبية لتقييم تأثير AGI | تحقق من صحة الأطر لتقنيات AGI المزعزعة |

| Long و Cotner

|

يقترح إطارًا مفاهيميًا لتطوير AGI، مع التركيز على التعميم، والاستقلالية، والتكامل على مستوى النظام للتطبيقات متعددة المجالات | قابلية توسيع أنظمة AGI المستقلة |

| Everitt وآخرون.

|

يوفر مراجعة شاملة لتحديات سلامة AGI، مع معالجة توافق الأهداف، والتحكم في النظام، واستراتيجيات نشر الذكاء الاصطناعي الأخلاقي | الفجوات في استراتيجيات سلامة AGI الشاملة |

طرق

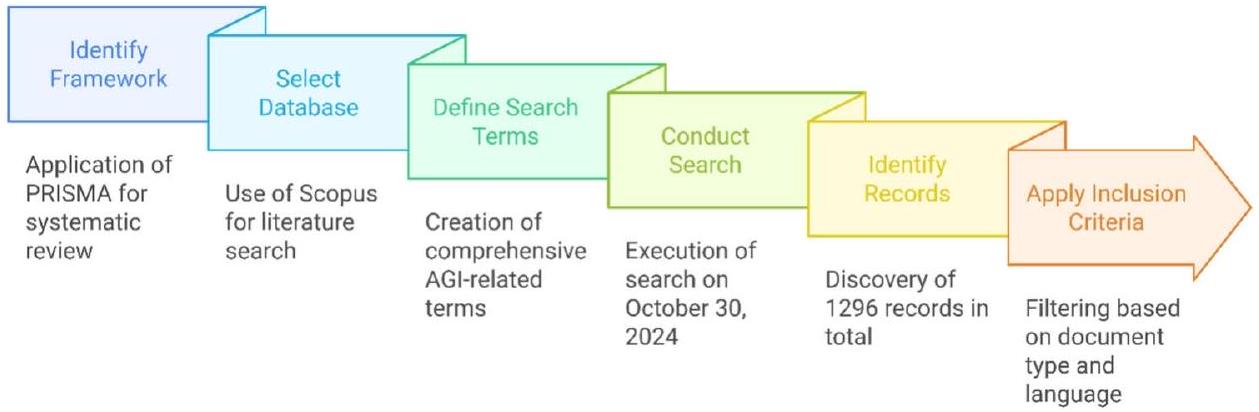

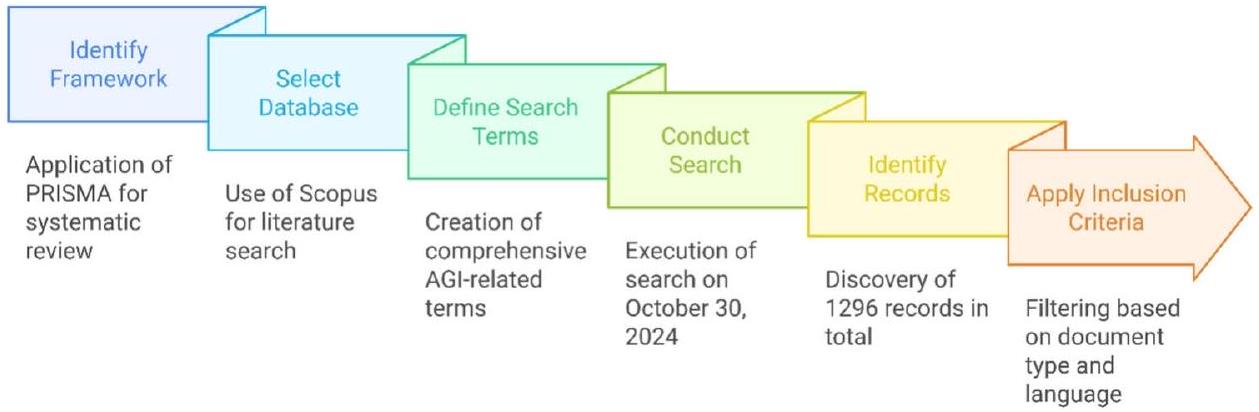

بروتوكول PRISMA

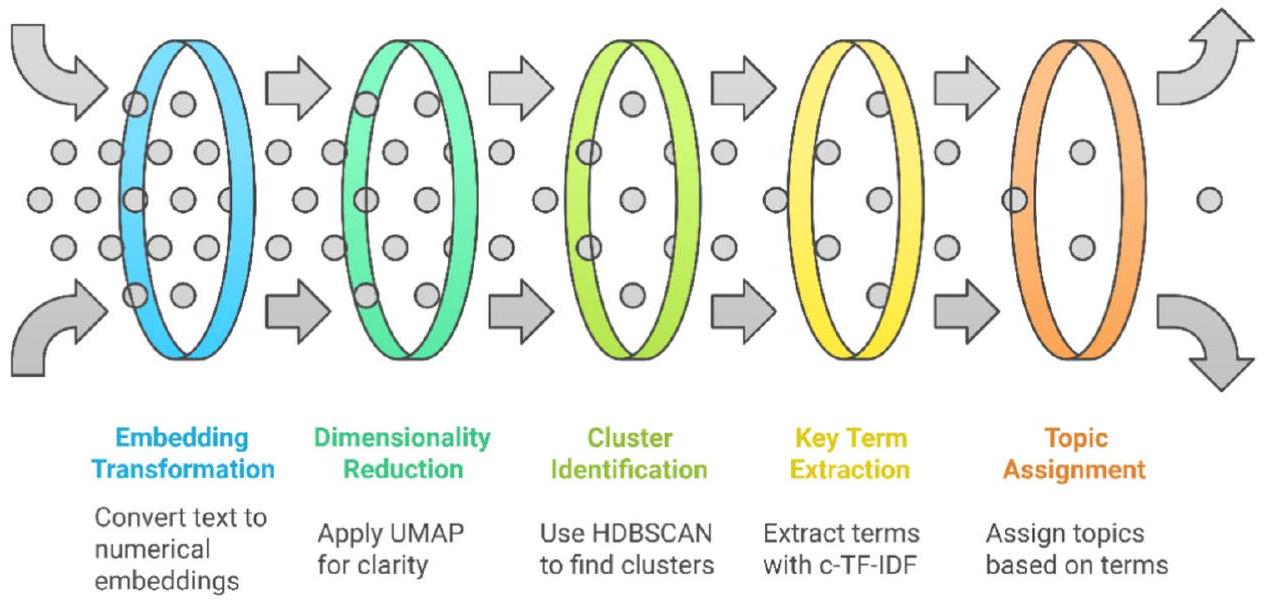

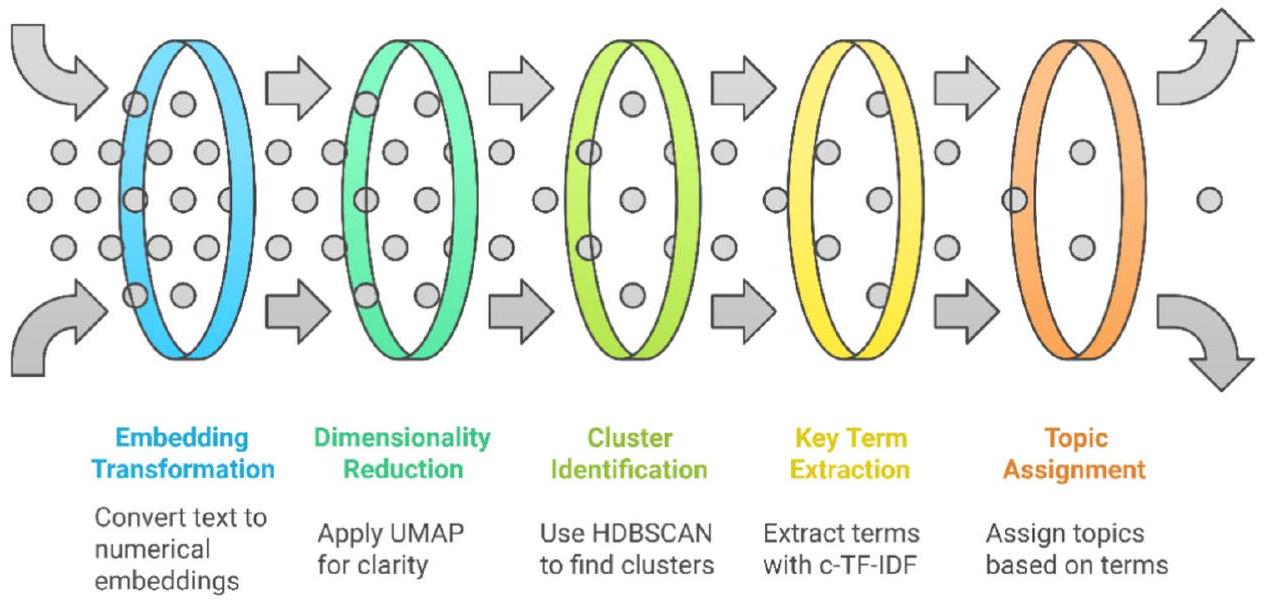

نمذجة BERTopic

| المسارات | النظريات/الأطر المذكورة | مفاهيم AGI المستخدمة | الكلمات الرئيسية |

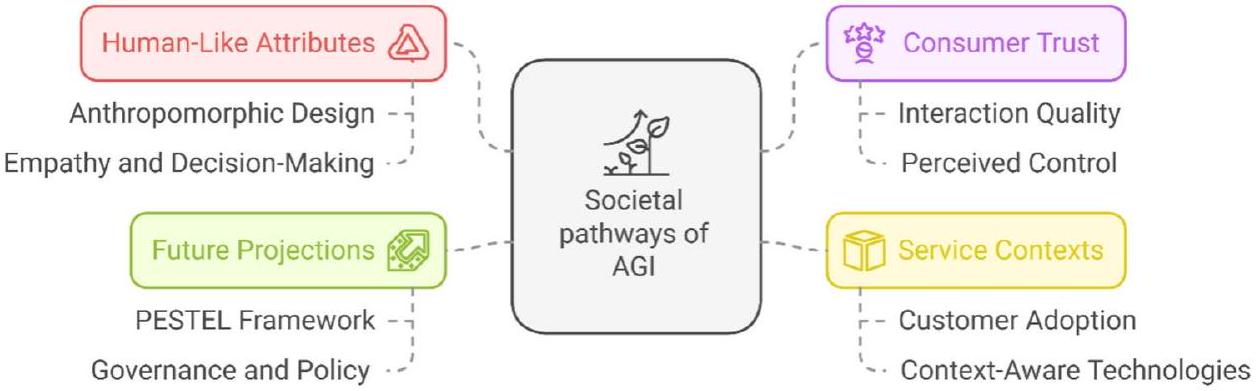

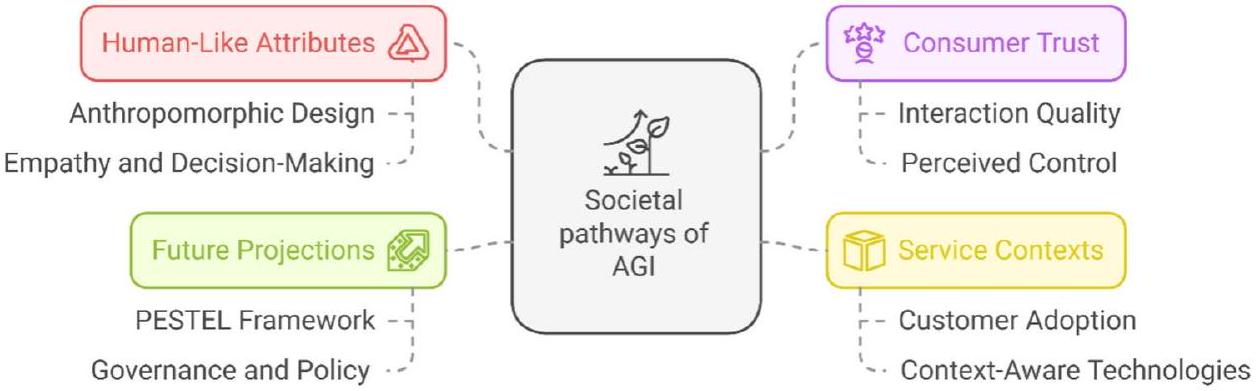

| المسارات الاجتماعية للذكاء الاصطناعي الشبيه بالبشر | الحواسيب كفاعلين اجتماعيين (CASA)، إطار عمل PESTEL | التعاطف، جودة التفاعل، التصميم الشبيه بالبشر | مستوى إنساني”، “ذكاء اصطناعي شبيه بالبشر”، “سلامة الذكاء الاصطناعي”، “اتخاذ القرار”، “تعلم الآلة”، “اختبار تورينج”، “تقدم”، “تغيير اجتماعي |

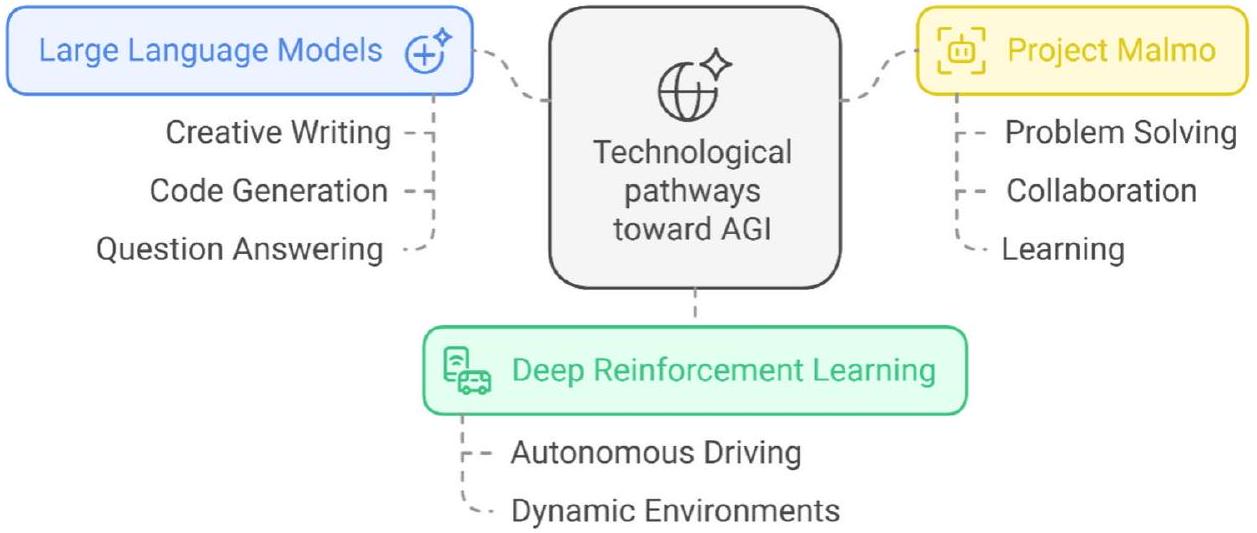

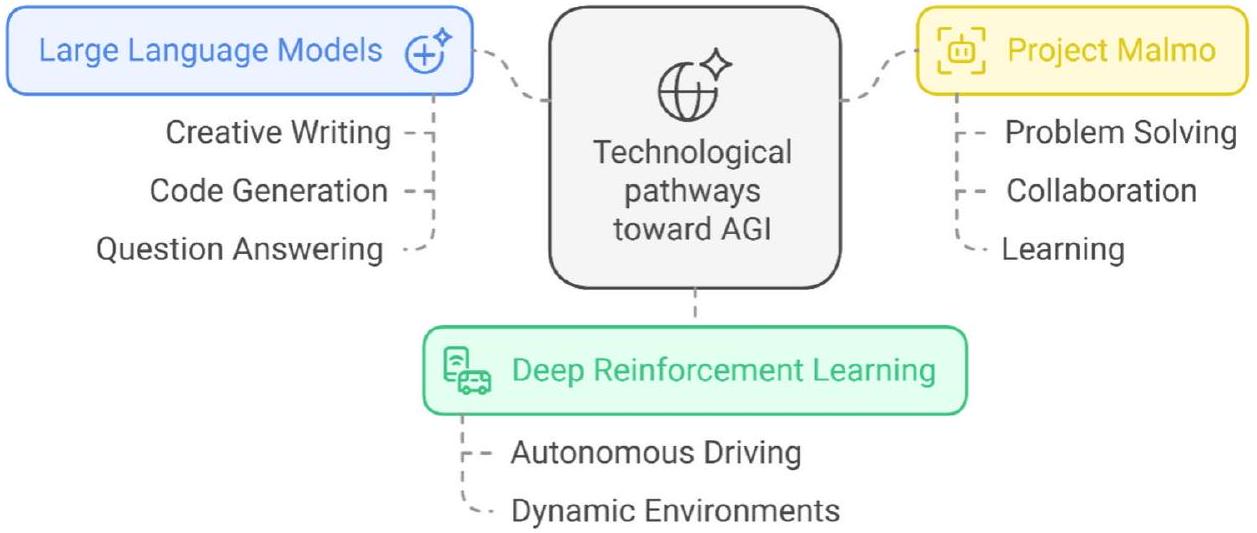

| المسارات التكنولوجية نحو AGI | الذكاء الاصطناعي القابل للتفسير (XAI)، فرضية تعظيم المكافآت، الذكاء الاصطناعي المنطقي | الشفافية، التعلم المعزز، مشاكل التمثيل | تطور”، “تقدمات”، “آثار العالم الحقيقي”، “الذكاء الاصطناعي العام”، “البيانات الضخمة”، “مستوى إنساني”، “اعتبارات أخلاقية”، “سياسة”، “حكم |

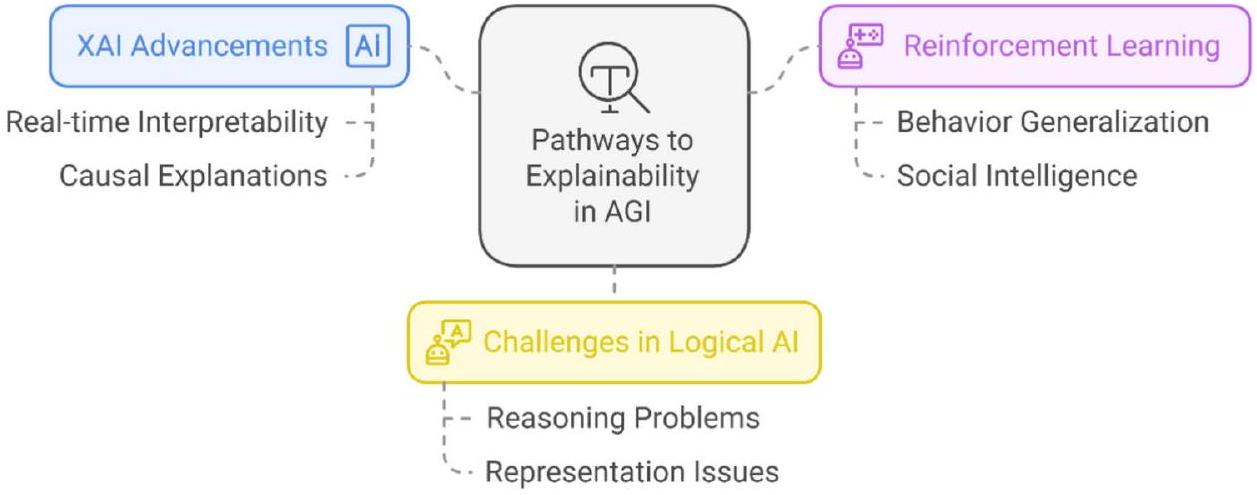

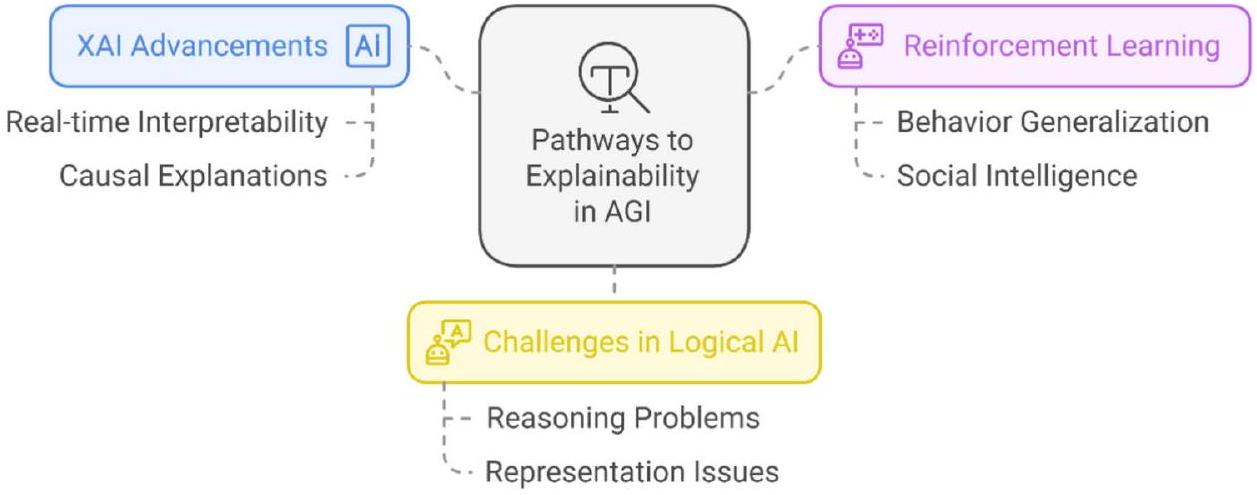

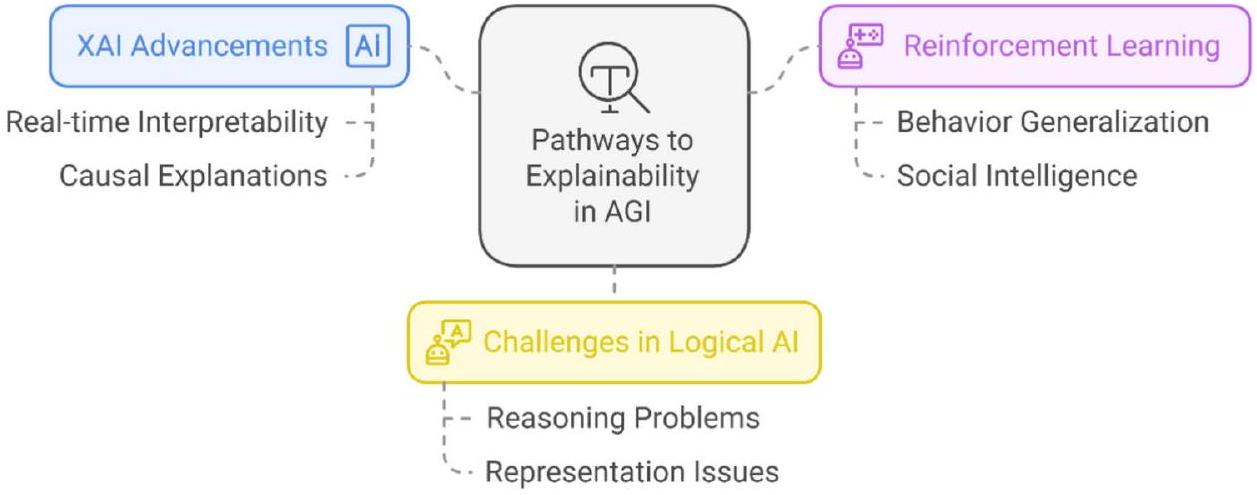

| المسارات نحو القابلية للتفسير في AGI | إطار التعلم المعزز، نمذجة موضوع LDA، منصات تجريب الذكاء الاصطناعي | حل المشكلات، الذكاء الاصطناعي المحدد للمهام | التعلم المعزز”، “تعلم الآلة”، “الذكاء الاصطناعي العام”، “معالجة اللغة الطبيعية”، “الجيل القادم”، “الابتكار”، “الاتجاهات |

| المسارات المعرفية والأخلاق في AGI | نموذج LIDA، نظرية مساحة العمل العالمية، نظرية اكتمال الذكاء الاصطناعي | اتخاذ القرار الأخلاقي، اختبار تورينج، الحواسيب العصبية | الهياكل المعرفية”، “وعي الآلة”، “الفطرة السليمة”، “الذكاء الاصطناعي القوي”، “اعتبارات أخلاقية”، “حكم”، “المستقبل |

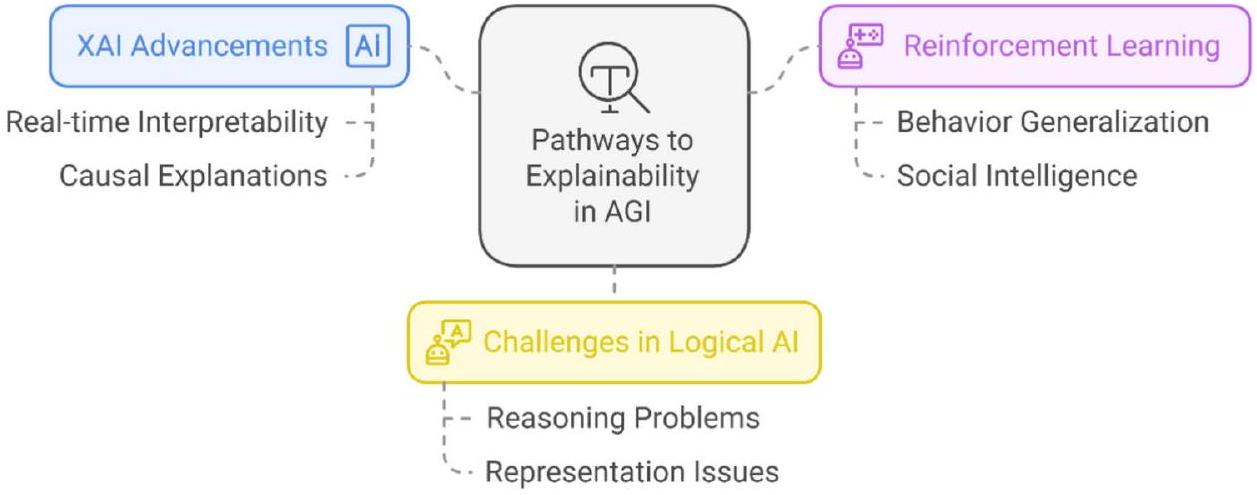

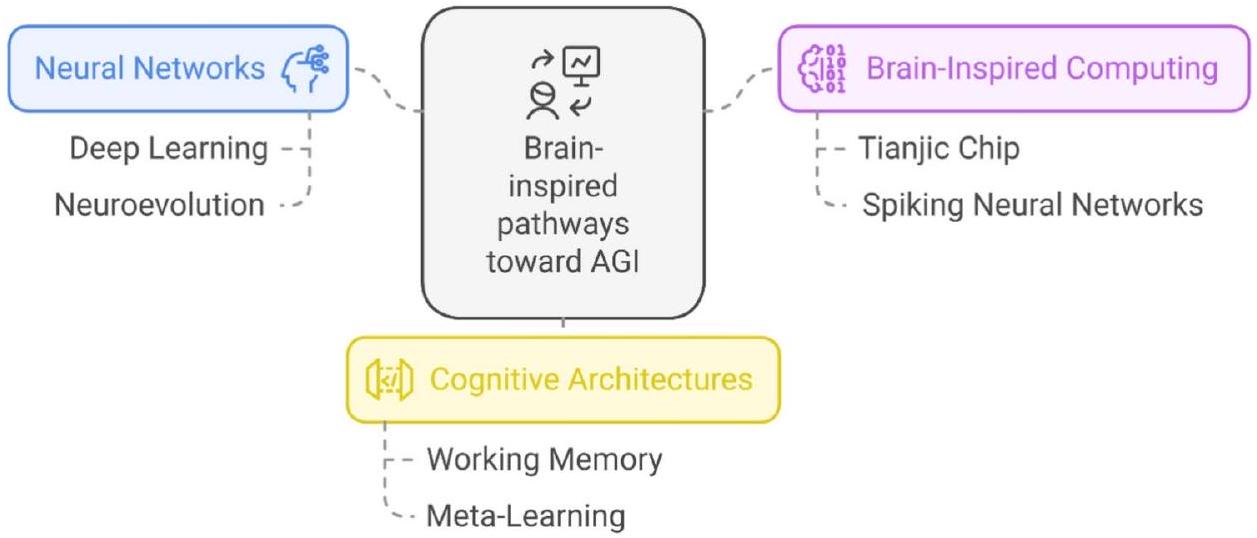

| المسارات المستوحاة من الدماغ نحو AGI | معمارية تيانجيك الهجينة، التطور العصبي، نظرية تعقيد العينة الإحصائية | المعالجة في الوقت الحقيقي، تحسين الشبكة، المعالجة عالية الأبعاد | الحوسبة العصبية”، “الذاكرة العاملة”، “الحوسبة المستوحاة من الدماغ”، “الأحدث”، “الاختراق”، “التوقعات”، “الجيل القادم |

النتائج

المسارات الاجتماعية للذكاء الاصطناعي العام

المسارات التكنولوجية نحو AGI

مسارات الشرح في الذكاء العام الاصطناعي

المسارات المعرفية والأخلاق في الذكاء العام الاصطناعي

في أنظمة الذكاء العام الاصطناعي لمعالجة المشكلات الأخلاقية. من خلال تقليد عمليات التفكير البشري، تسلط الدراسة الضوء على تقدم الذكاء العام الاصطناعي نحو اتخاذ قرارات واعية بالسياق، خاصة في البيئات الأخلاقية المعقدة. تعالج هذه الإطار الاعتبارات الأخلاقية والآثار المحتملة للحوكمة مع زيادة قدرة الوكلاء المستقلين. يبرز تطور الذكاء العام الاصطناعي نحو التفكير الأخلاقي الحاجة إلى سياسات تنظيمية لضمان التوافق مع القيم الاجتماعية.

المسارات المستوحاة من الدماغ نحو الذكاء العام الاصطناعي

نقاش

“المسارات التكنولوجية نحو الذكاء الاصطناعي العام” تربط بين تطوير الذكاء الاصطناعي العام، والتحديات العملية، والآثار الاجتماعية. تعالج أنظمة الذكاء الاصطناعي العام، المدفوعة بالتعلم العميق المعزز والأطر متعددة الوسائط، المهام الواقعية، مما يعزز التفكير الشبيه بالبشر للأنظمة المستقلة، والألعاب، والعمليات الإدراكية. ومع ذلك، فإن الاعتماد السريع، كما هو الحال مع ChatGPT، يثير تحديات اجتماعية مثل التحولات في التوظيف وفجوات السياسات

“المسارات نحو القابلية للتفسير في الذكاء الاصطناعي العام” تسلط الضوء على الحاجة الملحة لأنظمة الذكاء الاصطناعي العام الشفافة، والموثوقة، والمتوافقة أخلاقيًا. تعزز تقنيات مثل LIME وSHAP الشفافية، وهو أمر ضروري لبناء الثقة في مجالات حساسة مثل الرعاية الصحية

“المسارات الإدراكية والأخلاقية في الذكاء الاصطناعي العام” تفحص التفاعل بين التطور الإدراكي للذكاء الاصطناعي العام وتأثيره الاجتماعي. أطر مثل LIDA

“تسليط الضوء على المسارات المستوحاة من الدماغ نحو الذكاء العام الاصطناعي” يبرز دمج الأساليب المستوحاة من علوم الأعصاب والشبكات العصبية الاصطناعية لتقدم أبحاث الذكاء العام الاصطناعي. توفر الأجهزة العصبية الناشئة، مثل الشرائح الشبيهة بالدماغ والمنصات الهجينة، قدرات معرفية فعالة من حيث الطاقة وفي الوقت الحقيقي، وهي ضرورية لنشر الذكاء العام الاصطناعي في بيئات ديناميكية. يوسع هذا التقدم نطاق الحوسبة المستوحاة من الدماغ إلى تطبيقات جديدة، بما في ذلك الروبوتات وأنظمة التعلم التكيفية. تظهر المنصات الهجينة مثل شريحة تيانجيك

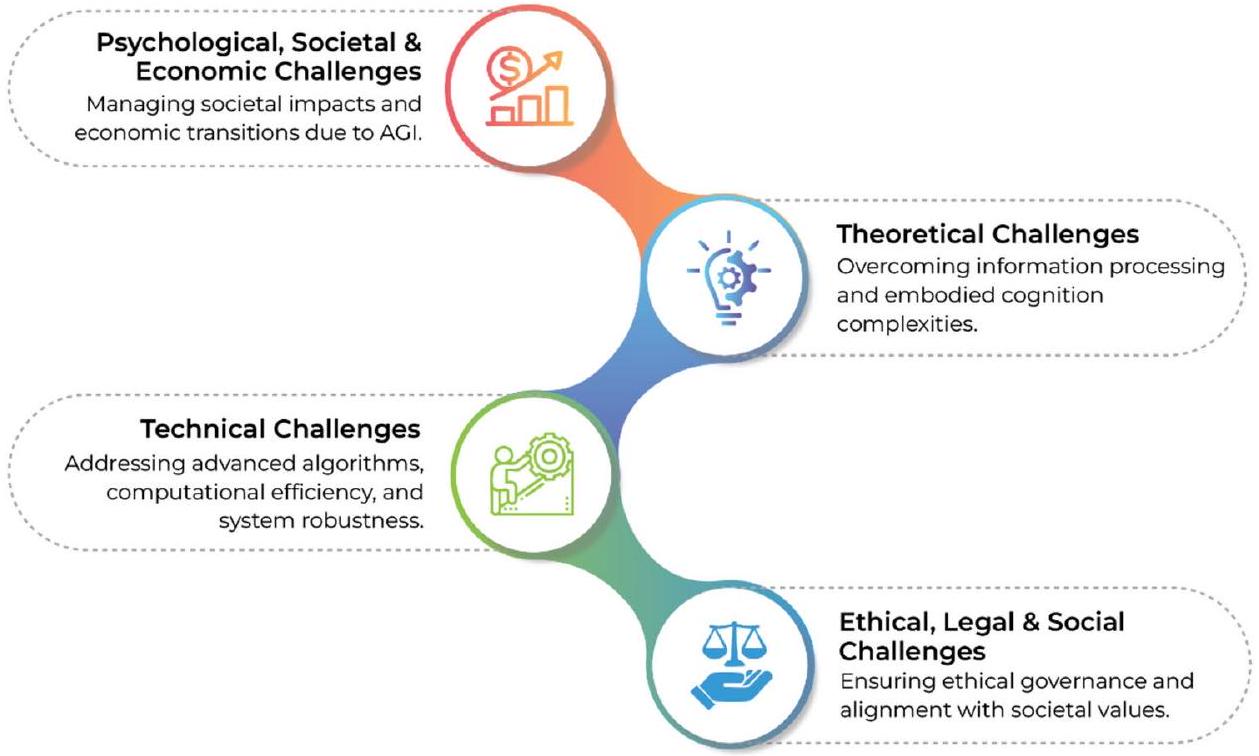

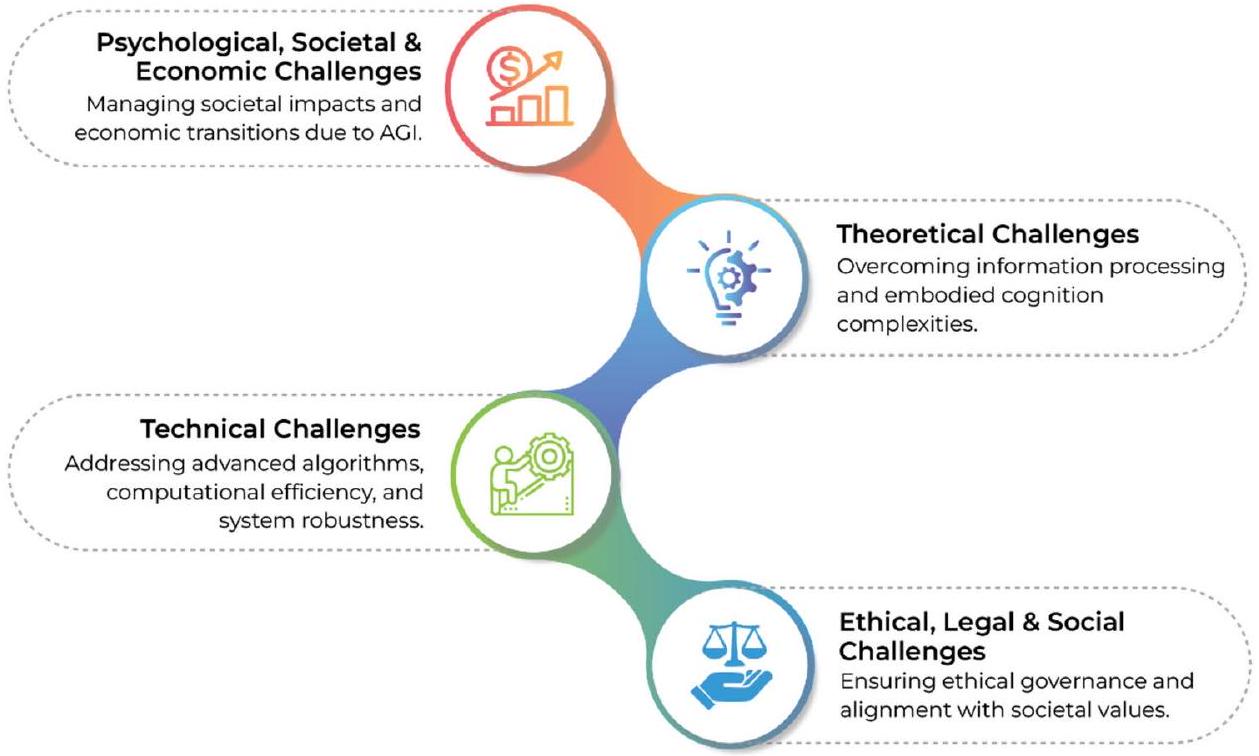

التحديات الرئيسية المحيطة بالذكاء العام الاصطناعي

التحديات الأخلاقية والقانونية والاجتماعية

الآثار

الآثار على النظرية

التفكير السليم. بالإضافة إلى ذلك، تستفيد هذه الأبحاث من أطر التعلم المعزز ونظريات التطور العصبي لاستكشاف المسارات التنموية لـ AGI. تعزز هذه النظريات من خلال تقديم هياكل مستوحاة من الدماغ وهجينة تجمع بين التفكير الرمزي وتعلم الشبكات العصبية، مما يعالج القيود في القابلية للتوسع والتعميم واتخاذ القرار الديناميكي في الأنظمة الحالية.

الآثار على الممارسة

الآثار على السياسة

يجب أن يفرض أيضًا العدالة في تدريب نماذج الذكاء الاصطناعي العام، مما يمنع التحيزات التي قد تضر بشكل غير متناسب بالمجموعات المهمشة في كل من التطبيقات التعليمية والرعاية الصحية.

القيود والاتجاهات المستقبلية

الموضوع السائد: الإرشادات الأخلاقية وحوكمة الذكاء الاصطناعي العام

موضوع الصعود: الذكاء العام الاصطناعي والذكاء الجماعي

الموضوع المتزايد: الذكاء الاصطناعي العام المستوحى من الدماغ

الموضوع الجديد: الذكاء الاصطناعي العام والوعي

الموضوع الجديد: الذكاء الاصطناعي العام في التعليم

الخاتمة

توفر البيانات

تاريخ الاستلام: 10 يناير 2025؛ تاريخ القبول: 25 فبراير 2025

تاريخ النشر على الإنترنت: 11 مارس 2025

References

- Fjelland, R. Why general artificial intelligence will not be realized. Hum. Soc. Sci. Commun. 7(1), 1-9 (2020).

- Yampolskiy, R. On the Differences between Human and Machine Intelligence. In AISafety@ IJCAI (2021).

- Hellström, T. & Bensch, S. Apocalypse now: no need for artificial general intelligence. AI Soc. 39(2), 811-813 (2024).

- Barrett, A. M. & Baum, S. D. A model of pathways to artificial superintelligence catastrophe for risk and decision analysis. J. Exp. Theor. Artif. Intell. 29(2), 397-414 (2017).

- Gill, K. S. Artificial super intelligence: beyond rhetoric. AI Soc. 31, 137-143 (2016).

- Pueyo, S. Growth, degrowth, and the challenge of artificial superintelligence. J. Clean. Prod. 197, 1731-1736 (2018).

- Saghiri, A. M., Vahidipour, S. M., Jabbarpour, M. R., Sookhak, M. & Forestiero, A. A survey of artificial intelligence challenges: Analyzing the definitions, relationships, and evolutions. Appl. Sci. 12(8), 4054 (2022).

- Ng, G. W. & Leung, W. C. Strong artificial intelligence and consciousness. J. Artif. Intell. Conscious. 7(01), 63-72(2020).

- Yampolskiy, R. V. Agi control theory. In Artificial General Intelligence: 14th International Conference, AGI 2021, Palo Alto, CA, USA, October 15-18, 2021, Proceedings 14 (pp. 316-326). Springer International Publishing (2022a).

- Yampolskiy, R. V. On the controllability of artificial intelligence: An analysis of limitations. J. Cyber Secur. Mob. 321-404 (2022b).

- Ramamoorthy, A. & Yampolskiy, R. Beyond mad? The race for artificial general intelligence. ITU J. 1(1), 77-84 (2018).

- Cao, L. Ai4tech: X-AI enabling X-Tech with human-like, generative, decentralized, humanoid and metaverse AI. Int. J. Data Sci. Anal. 18(3), 219-238 (2024).

- Goertzel, B. Artificial general intelligence and the future of humanity. The transhumanist reader: Classical and contemporary essays on the science, technology, and philosophy of the human future 128-137 (2013).

- Li, X., Zhao, L., Zhang, L., Wu, Z., Liu, Z., Jiang, H. & Shen, D. Artificial general intelligence for medical imaging analysis. IEEE Rev. Biomed. Eng. (2025).

- Rathi, S. Approaches to artificial general intelligence: An analysis (2022). arXiv preprint arXiv:2202.03153.

- Arora, A. & Arora, A. The promise of large language models in health care. The Lancet

. - Bikkasani, D. C. Navigating artificial general intelligence (AGI): Societal implications, ethical considerations, and governance strategies. AI Ethics 1-16 (2024).

- Li, J. X., Zhang, T., Zhu, Y. & Chen, Z. Artificial general intelligence for the upstream geoenergy industry: A review. Gas Sci. Eng. 205469 (2024).

- Nedungadi, P., Tang, K. Y. & Raman, R. The transformative power of generative artificial intelligence for achieving the sustainable development goal of quality education. Sustainability 16(22), 9779 (2024).

- Zhu, X., Chen, S., Liang, X., Jin, X. & Du, Z. Next-generation generalist energy artificial intelligence for navigating smart energy. Cell Rep. Phys. Sci. 5(9), 102192 (2024).

- Faroldi, F. L. Risk and artificial general intelligence. AI Soc. 1-9 (2024).

- Simon, C. J. Ethics and artificial general intelligence: technological prediction as a groundwork for guidelines. In 2019 IEEE International Symposium on Technology and Society (ISTAS) 1-6 (IEEE, 2019).

- Chouard, T. The Go files: AI computer wraps up 4-1 victory against human champion. Nat. News 20, 16 (2016).

- Morris, M. R., Sohl-Dickstein, J. N., Fiedel, N., Warkentin, T. B., Dafoe, A., Faust, A., Farabet, C. & Legg, S. Position: Levels of AGI for operationalizing progress on the path to AGI. In International Conference on Machine Learning (2023).

- Weinbaum, D. & Veitas, V. Open ended intelligence: The individuation of intelligent agents. J. Exp. Theor. Artif. Intell. 29(2), 371-396 (2017).

- Sublime, J. The AI race: Why current neural network-based architectures are a poor basis for artificial general intelligence. J. Artif. Intell. Res. 79, 41-67 (2024).

- Wickramasinghe, B., Saha, G. & Roy, K. Continual learning: A review of techniques, challenges and future directions. IEEE Trans. Artif. Intell. (2023).

- Fei, N. et al. Toward artificial general intelligence via a multimodal foundation model. Nat. Commun. 13(1), 3094 (2022).

- Kelley, D. & Atreides, K. AGI protocol for the ethical treatment of artificial general intelligence systems. Procedia Comput. Sci. 169, 501-506 (2020).

- McCormack, J. Autonomy, intention, Performativity: Navigating the AI divide. In Choreomata (pp. 240-257). Chapman and Hall/ CRC (2023).

- Khamassi, M., Nahon, M. & Chatila, R. Strong and weak alignment of large language models with human values. Sci. Rep. 14(1), 19399 (2024).

- McIntosh, T. R., Susnjak, T., Liu, T., Watters, P., Ng, A. & Halgamuge, M. N. A game-theoretic approach to containing artificial general intelligence: Insights from highly autonomous aggressive malware. IEEE Trans. Artif. Intell. (2024).

- Salmi, J. A democratic way of controlling artificial general intelligence. AI Soc. 38(4), 1785-1791 (2023).

- Bubeck, S., Chandrasekaran, V., Eldan, R., Gehrke, J., Horvitz, E., Kamar, E. & Zhang, Y. Sparks of artificial general intelligence: Early experiments with gpt-4 (2023). arXiv preprint arXiv:2303.12712.

- Faraboschi, P., Frachtenberg, E., Laplante, P., Milojicic, D. & Saracco, R. Artificial general intelligence: Humanity’s downturn or unlimited prosperity. Computer 56(10), 93-101 (2023).

- Wei, Y. Several important ethical issues concerning artificial general intelligence. Chin. Med. Ethics 37(1), 1-9 (2024).

- McLean, S. et al. The risks associated with artificial general intelligence: A systematic review. J. Exp. Theor. Artif. Intell. 35(5), 649-663 (2023).

- Shalaby, A. Digital sustainable growth model (DSGM): Achieving synergy between economy and technology to mitigate AGI risks and address Global debt challenges. J. Econ. Technol. (2024a).

- Croeser, S. & Eckersley, P. Theories of parenting and their application to artificial intelligence. In Proceedings of the 2019 AAAI/ ACM Conference on AI, Ethics, and Society (pp. 423-428) (2019).

- Lenharo, M. What should we do if AI becomes conscious? These scientists say it is time for a plan. Nature (2024). https://doi.org /10.1038/d41586-024-04023-8

- Shankar, V. Managing the twin faces of AI: A commentary on “Is AI changing the world for better or worse?”. J. Macromark. 44(4), 892-899 (2024).

- Wu, Y. Future of information professions: Adapting to the AGI era. Sci. Tech. Inf. Process. 51(3), 273-279 (2024).

- Sukhobokov, A., Belousov, E., Gromozdov, D., Zenger, A. & Popov, I. A universal knowledge model and cognitive architecture for prototyping AGI (2024). arXiv preprint arXiv:2401.06256.

- Salmon, P. M. et al. Managing the risks of artificial general intelligence: A human factors and ergonomics perspective. Hum. Fact. Ergon. Manuf. Serv. Ind. 33(5), 366-378 (2023).

- Bory, P., Natale, S. & Katzenbach, C. Strong and weak AI narratives: An analytical framework. AI Soc. 1-11 (2024).

- Gai, F. When artificial intelligence meets Daoism. In Intelligence and Wisdom: Artificial Intelligence Meets Chinese Philosophers 83-100 (2021).

- Menaga, D. & Saravanan, S. Application of artificial intelligence in the perspective of data mining. In Artificial Intelligence in Data Mining (pp. 133-154). Academic Press (2021).

- Adams, S., Arel, I., Bach, J., Coop, R., Furlan, R., Goertzel, B., Sowa, J. (2012). Mapping the landscape of human-level artificial general intelligence. AI Magazine 33(1), 25-42.

- Beerends, S. & Aydin, C. Negotiating the authenticity of AI: how the discourse on AI rejects human indeterminacy. AI Soc. 1-14 (2024).

- Besold, T. R. Human-level artificial intelligence must be a science. In Artificial General Intelligence: 6 th International Conference, AGI 2013, Beijing, China, July 31-August 3, 2013 Proceedings 6 (pp. 174-177). Springer Berlin Heidelberg (2013).

- Eth, D. The technological landscape affecting artificial general intelligence and the importance of nanoscale neural probes. Informatica 41(4) (2017).

- Nvs, B. & Saranya, P. L. Water pollutants monitoring based on Internet of Things. In Inorganic Pollutants in Water (pp. 371-397) (2020). Elsevier.

- Flowers, J. C. Strong and Weak AI: Deweyan Considerations. In AAAI spring symposium: Toward conscious AI systems (Vol. 2287, No. 7) (2019).

- Mitchell, M. Debates on the nature of artificial general intelligence. Science 383(6689), eado7069 (2024).

- Grech, V. & Scerri, M. Evil doctor, ethical android: Star Trek’s instantiation of conscience in subroutines. Early Hum. Dev. 145, 105018 (2020).

- Noller, J. Extended human agency: Towards a teleological account of AI. Hum. Soc. Sci. Commun. 11(1), 1-7 (2024).

- Nominacher, M. & Peletier, B. Artificial intelligence policies. The digital factory for knowledge: Production and validation of scientific results 71-76 (2018).

- Isaac, M., Akinola, O. M., & Hu, B. Predicting the trajectory of AI utilizing the Markov model of machine learning. In 2023 IEEE 3rd International Conference on Computer Communication and Artificial Intelligence (CCAI) (pp. 30-34). IEEE (2023).

- Stewart, W. The human biological advantage over AI. AI & Soc. 1-10 (2024).

- Vaidya, A. J. Can machines have emotions? AI Soc. 1-16 (2024).

- Triguero, I., Molina, D., Poyatos, J., Del Ser, J. & Herrera, F. General purpose artificial intelligence systems (GPAIS): Properties, definition, taxonomy, societal implications and responsible governance. Inf. Fus. 103, 102135 (2024).

- Bécue, A., Gama, J. & Brito, P. Q. AI’s effect on innovation capacity in the context of industry 5.0: A scoping review. Artif. Intell. Rev. 57(8), 215 (2024).

- Yue, Y. & Shyu, J. Z. A paradigm shift in crisis management: The nexus of AGI-driven intelligence fusion networks and blockchain trustworthiness. J. Conting. Crisis Manag. 32(1), e12541(2024).

- Chiroma, H., Hashem, I. A. T. & Maray, M. Bibliometric analysis for artificial intelligence in the internet of medical things: Mapping and performance analysis. Front. Artif. Intell. 7, 1347815 (2024).

- Wang, Z., Chen, J., Chen, J. & Chen, H. Identifying interdisciplinary topics and their evolution based on BERTopic. Scientometrics https://doi.org/10.1007/s11192-023-04776-5 (2023).

- Wang, J., Liu, Z., Zhao, L., Wu, Z., Ma, C., Yu, S. & Zhang, S. Review of large vision models and visual prompt engineering. MetaRadiol. 100047 (2023).

- Daase, C. & Turowski, K. Conducting design science research in society 5.0-Proposal of an explainable artificial intelligence research methodology. In International Conference on Design Science Research in Information Systems and Technology (pp. 250265). Springer, Cham (2023).

- Yang, L., Gong, M. & Asari, V. K. Diagram image retrieval and analysis: Challenges and opportunities. In Proceedings of the IEEE/ CVF Conference on Computer Vision and Pattern Recognition Workshops (pp. 180-181) (2020).

- Krishnan, B., Arumugam, S. & Maddulety, K. ‘Nested’disruptive technologies for smart cities: Effects and challenges. Int. J. Innov. Technol. Manag. 17(05), 2030003 (2020).

- Krishnan, B., Arumugam, S. & Maddulety, K. Impact of disruptive technologies on smart cities: challenges and benefits. In International Working Conference on Transfer and Diffusion of IT (pp. 197-208). Cham: Springer International Publishing (2020).

- Long, L. N. & Cotner, C. F. A review and proposed framework for artificial general intelligence. In 2019 IEEE Aerospace Conference (pp. 1-10). IEEE (2019).

- Everitt, T., Lea, G. & Hutter, M. AGI safety literature review (2018). arXiv preprint arXiv:1805.01109.

- Wang, P. & Goertzel, B. Introduction: Aspects of artificial general intelligence. In Advances in Artificial General Intelligence: Concepts, Architectures and Algorithms (pp. 1-16). IOS Press (2007).

- Yampolskiy, R. & Fox, J. Safety engineering for artificial general intelligence. Topoi 32, 217-226 (2013).

- Dushkin, R. V. & Stepankov, V. Y. Hybrid bionic cognitive architecture for artificial general intelligence agents. Procedia Comput. Sci. 190, 226-230 (2021).

- Nyalapelli, V. K., Gandhi, M., Bhargava, S., Dhanare, R. & Bothe, S. Review of progress in artificial general intelligence and human brain inspired cognitive architecture. In 2021 International Conference on Computer Communication and Informatics (ICCCI) (pp. 1-13). IEEE (2021).

- Page, M. J. et al. The PRISMA 2020 statement: an updated guideline for reporting systematic reviews. BMJ 372, n71. https://doi.o rg/10.1136/bmj.n71 (2021).

- Donthu, N., Kumar, S., Pandey, N., Pandey, N. & Mishra, A. Mapping the electronic word-of-mouth (eWOM) research: A systematic review and bibliometric analysis. J. Bus. Res. 135, 758-773 (2021).

- Comerio, N. & Strozzi, F. Tourism and its economic impact: A literature review using bibliometric tools. Tour. Econ. 25(1), 109-131 (2019).

- Raman, R., Gunasekar, S., Dávid, L. D. & Nedungadi, P. Aligning sustainable aviation fuel research with sustainable development goals: Trends and thematic analysis. Energy Rep. 12, 2642-2652 (2024).

- Raman, R., Gunasekar, S., Kaliyaperumal, D. & Nedungadi, P. Navigating the nexus of artificial intelligence and renewable energy for the advancement of sustainable development goals. Sustainability 16(21), 1-25 (2024).

- Egger, R. & Yu, J. A topic modeling comparison between lda, nmf, top2vec, and bertopic to demystify twitter posts. Front. Sociol. 7, 886498 (2022).

- Devlin, J., Chang, M. W., Lee, K. & Toutanova, K. BERT: Pre-training of deep bidirectional transformers for language understanding. NAACL HLT 2019-2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies-Proceedings of the Conference, 1(Mlm), 4171-4186 (2019).

- Grootendorst, M. BERTopic: Neural topic modeling with a class-based TFIDF procedure (2022). http://arxiv.org/abs/2203.05794

- Alamsyah, A. & Girawan, N. D. Improving clothing product quality and reducing waste based on consumer review using RoBERTa and BERTopic language model. Big Data Cogn. Comput. 7(4), 168 (2023).

- Raman, R. et al. Green and sustainable AI research: An integrated thematic and topic modeling analysis. J. Big Data 11(1), 55 (2024).

- Um, T. & Kim, N. A study on performance enhancement by integrating neural topic attention with transformer-based language model. Appl. Sci. 14(17), 7898 (2024).

- Gan, L., Yang, T., Huang, Y., Yang, B., Luo, Y. Y., Richard, L. W. C. & Guo, D. Experimental comparison of three topic modeling methods with LDA, Top2Vec and BERTopic. In International Symposium on Artificial Intelligence and Robotics (pp. 376-391). Singapore: Springer Nature Singapore (2023).

- Yi, J., Oh, Y. K. & Kim, J. M. Unveiling the drivers of satisfaction in mobile trading: Contextual mining of retail investor experience through BERTopic and generative AI. J. Retail. Consum. Serv. 82, 104066 (2025).

- Oh, Y. K., Yi, J. & Kim, J. What enhances or worsens the user-generated metaverse experience? An application of BERTopic to Roblox user eWOM. Internet Res. (2023).

- Kim, K., Kogler, D. F. & Maliphol, S. Identifying interdisciplinary emergence in the science of science: Combination of network analysis and BERTopic. Hum. Soc. Sci. Commun. 11(1), 1-15 (2024).

- Khodeir, N. & Elghannam, F. Efficient topic identification for urgent MOOC Forum posts using BERTopic and traditional topic modeling techniques. Educ. Inf. Technol. 1-27 (2024).

- McInnes, L., Healy, J. & Melville, J. UMAP: Uniform manifold approximation and projection for dimension reduction (2018).

- Douglas, T., Capra, L. & Musolesi, M. A computational linguistic approach to study border theory at scale. Proc. ACM Hum. Comput. Interact. 8(CSCW1), 1-23 (2024).

- Pelau, C., Dabija, D. C. & Ene, I. What makes an AI device human-like? The role of interaction quality, empathy and perceived psychological anthropomorphic characteristics in the acceptance of artificial intelligence in the service industry. Comput. Hum. Behav. 122, 106855 (2021).

- Yang, Y., Liu, Y., Lv, X., Ai, J. & Li, Y. Anthropomorphism and customers’ willingness to use artificial intelligence service agents. J. Hosp. Mark. Manag. 31(1), 1-23 (2022).

- Kaplan, A. & Haenlein, M. Rulers of the world, unite! The challenges and opportunities of artificial intelligence. Bus. Horizons 63(1), 37-50 (2020).

- Sallab, A. E., Abdou, M., Perot, E. & Yogamani, S. Deep reinforcement learning framework for autonomous driving (2017). arXiv preprint arXiv:1704.02532.

- Taecharungroj, V. “What can ChatGPT do?” Analyzing early reactions to the innovative AI chatbot on Twitter. Big Data Cogn. Comput. 7(1), 35 (2023).

- Hohenecker, P. & Lukasiewicz, T. Ontology reasoning with deep neural networks. J. Artif. Intell. Res. 68, 503-540 (2020).

- Došilović, F. K., Brčić, M. & Hlupić, N. Explainable artificial intelligence: A survey. In 2018 41st International convention on information and communication technology, electronics and microelectronics (MIPRO) (pp. 0210-0215). IEEE (2018).

- Silver, D., Singh, S., Precup, D. & Sutton, R. S. Reward is enough. Artif. Intell. 299, 103535 (2021).

- McCarthy, J. From here to human-level AI. Artif. Intell. 171(18), 1174-1182 (2007).

- Wallach, W., Franklin, S. & Allen, C. A conceptual and computational model of moral decision making in human and artificial agents. Top. Cogn. Sci. 2(3), 454-485 (2010).

- Franklin, S. Artificial Minds. MIT Press, p. 412 (1995).

- Yampolskiy, R. V. Turing test as a defining feature of AI-completeness. Artificial Intelligence, Evolutionary Computing and Metaheuristics: In the Footsteps of Alan Turing, 3-17 (2013).

- Arcas, B. A. Do large language models understand us?. Daedalus 151(2), 183-197 (2022).

- Pei, J. et al. Towards artificial general intelligence with hybrid Tianjic chip architecture. Nature 572(7767), 106-111 (2019).

- Stanley, K. O., Clune, J., Lehman, J. & Miikkulainen, R. Designing neural networks through neuroevolution. Nat. Mach. Intell. 1(1), 24-35 (2019).

- Sejnowski, T. J. The unreasonable effectiveness of deep learning in artificial intelligence. Proc. Natl. Acad. Sci. 117(48), 3003330038 (2020).

- Wang, J. & Pashmforoosh, R. A new framework for ethical artificial intelligence: Keeping HRD in the loop. Hum. Resour. Dev. Int. 27(3), 428-451 (2024).

- Boltuc, P. Human-AGI Gemeinschaft as a solution to the alignment problem. In International Conference on Artificial General Intelligence (pp. 33-42). Cham: Springer Nature Switzerland (2024).

- Naudé, W. & Dimitri, N. The race for an artificial general intelligence: Implications for public policy. AI Soc. 35, 367-379 (2020).

- Cichocki, A. & Kuleshov, A. P. Future trends for human-AI collaboration: A comprehensive taxonomy of AI/AGI using multiple intelligences and learning styles. Comput. Intell. Neurosci. 2021(1), 8893795 (2021).

- Lake, B. M., Ullman, T. D., Tenenbaum, J. B. & Gershman, S. J. Building machines that learn and think like people. Behav. Brain Sci. 40, e253 (2017).

- Shalaby, A. Classification for the digital and cognitive AI hazards: urgent call to establish automated safe standard for protecting young human minds. Digit. Econ. Sustain. Dev. 2(1), 17 (2024).

- Liu, C. Y. & Yin, B. Affective foundations in AI-human interactions: Insights from evolutionary continuity and interspecies communications. Comput. Hum. Behav. 161, 108406 (2024).

- Dong, Y., Hou, J., Zhang, N. & Zhang, M. Research on how human intelligence, consciousness, and cognitive computing affect the development of artificial intelligence. Complexity 2020(1), 1680845 (2020).

- Muggleton, S. Alan turing and the development of artificial intelligence. AI Commun. 27(1), 3-10 (2014).

- Liu, Y., Zheng, W. & Su, Y. Enhancing ethical governance of artificial intelligence through dynamic feedback mechanism. In International Conference on Information (pp. 105-121). Cham: Springer Nature Switzerland (2024).

- Qu, P. et al. Research on general-purpose brain-inspired computing systems. J. Comput. Sci. Technol. 39(1), 4-21 (2024).

- Nadji-Tehrani, M. & Eslami, A. A brain-inspired framework for evolutionary artificial general intelligence. IEEE Trans. Neural Netw. Learn. Syst. 31(12), 5257-5271 (2020).

- Huang, T. J. Imitating the brain with neurocomputer a “new” way towards artificial general intelligence. Int. J. Autom. Comput. 14(5), 520-531 (2017).

- Zhao, L. et al. When brain-inspired ai meets agi. Meta-Radiol. 1, 100005 (2023).

- Qadri, Y. A., Ahmad, K. & Kim, S. W. Artificial general intelligence for the detection of neurodegenerative disorders. Sensors 24(20), 6658 (2024).

- Kasabov, N. K. Neuroinformatics, neural networks and neurocomputers for brain-inspired computational intelligence. In 2023 IEEE 17th International Symposium on Applied Computational Intelligence and Informatics (SACI) (pp. 000013-000014). IEEE (2023).

- Stiefel, K. M. & Coggan, J. S. The energy challenges of artificial superintelligence. Front. Artif. Intell. 6, 1240653 (2023).

- Yang S. & Chen, B. Effective surrogate gradient learning with high-order information bottleneck for spike-based machine intelligence. IEEE Trans. Neural Netw. Learn. Syst. (2023).

- Yang, S. & Chen, B. SNIB: Improving spike-based machine learning using nonlinear information bottleneck. IEEE Trans. Syst. Man Cybern. Syst. 53, 7852 (2023).

- Walton, P. Artificial intelligence and the limitations of information. Information 9(12), 332 (2018).

- Ringel Raveh, A. & Tamir, B. From homo sapiens to robo sapiens: the evolution of intelligence. Information 10(1), 2 (2018).

- Chen, B. & Chen, J. China’s legal practices concerning challenges of artificial general intelligence. Laws 13(5), 60 (2024).

- Mamak, K. AGI crimes? The role of criminal law in mitigating existential risks posed by artificial general intelligence. AI Soc. 1-11 (2024).

- Jungherr, A. Artificial intelligence and democracy: A conceptual framework. Soc. Media+ Soc. 9(3), 20563051231186353 (2023).

- Guan, L. & Xu, L. The mechanism and governance system of the new generation of artificial intelligence from the perspective of general purpose technology. Xitong Gongcheng Lilun yu Shijian/Syst. Eng. Theory Pract. 44(1), 245-259 (2024).

- Pregowska, A. & Perkins, M. Artificial intelligence in medical education: Typologies and ethical approaches. Ethics Bioethics 14(1-2), 96-113 (2024).

- Bereska, L. & Gavves, E. Taming simulators: Challenges, pathways and vision for the alignment of large language models. In Proceedings of the AAAI Symposium Series (Vol. 1, No. 1, pp. 68-72) (2023).

- Chen, G., Zhang, Y. & Jiang, R. A novel artificial general intelligence security evaluation scheme based on an analytic hierarchy process model with a generic algorithm. Appl. Sci. 14(20), 9609 (2024).

- Sotala, K. & Yampolskiy, R. Risks of the journey to the singularity. Technol. Singular. Manag. J. 11-23 (2017).

- Mercier-Laurent, E. The future of AI or AI for the future. Unimagined Futures-ICT Opportunities and Challenges 20-37 (2020).

- Miller, J. D. Some economic incentives facing a business that might bring about a technological singularity. In Singularity hypotheses: A scientific and philosophical assessment (pp. 147-159). Berlin, Heidelberg: Springer Berlin Heidelberg (2013).

- Bramer, W. M., Rethlefsen, M. L., Kleijnen, J. & Franco, O. H. Optimal database combinations for literature searches in systematic reviews: A prospective exploratory study. Syst. Rev. 6, 1-12 (2017).

- Mishra, V. & Mishra, M. P. PRISMA for review of management literature-method, merits, and limitations-An academic review. Advancing Methodologies of Conducting Literature Review in Management Domain, 125-136 (2023).

- de Groot, M., Aliannejadi, M. & Haas, M. R. Experiments on generalizability of BERTopic on multi-domain short text (2022). arXiv preprint arXiv:2212.08459.

- Letrud, K. & Hernes, S. Affirmative citation bias in scientific myth debunking: A three-in-one case study. PLoS ONE 14(9), e0222213 (2019).

- McCain, K. W. Assessing obliteration by incorporation in a full-text database: JSTOR, Economics, and the concept of “bounded rationality”. Scientometrics 101, 1445-1459 (2014).

مساهمات المؤلفين

التمويل

الإعلانات

المصالح المتنافسة

الموافقة على النشر

معلومات إضافية

معلومات إعادة الطبع والتصاريح متاحة على www.nature.com/reprints.

ملاحظة الناشر تظل Springer Nature محايدة فيما يتعلق بالمطالبات القضائية في الخرائط المنشورة والانتماءات المؤسسية.

© المؤلفون 2025

مدرسة أمارا للأعمال، أمارا فيشوا فيديابيثام، أمارتيبوري، أمارتيبوري، كيرالا 690525، الهند. كلية العلوم السلوكية والاجتماعية والصحية، جامعة كليمسون، كليمسون، SC 29634، الولايات المتحدة الأمريكية. ³مركز أنظمة وشبكات الأمن السيبراني، أمارا فيشوا فيديابيثام، أمارتيبوري، أمارتيبوري، كيرالا 690525، الهند. قسم الميكروبيولوجيا والمناعة، جامعة ميامي، كلية ميلر للطب، ميامي، FL 33136، الولايات المتحدة الأمريكية. مدرسة أمارا للحوسبة، أمارا فيشوا فيديابيثام، أمارتيبوري، أمارتيبوري، كيرالا 690525، الهند. البريد الإلكتروني: raghu@amrita.edu

DOI: https://doi.org/10.1038/s41598-025-92190-7

PMID: https://pubmed.ncbi.nlm.nih.gov/40069265

Publication Date: 2025-03-11

scientific reports

OPEN

Navigating artificial general intelligence development: societal, technological, ethical, and braininspired pathways

Abstract

This study examines the imperative to align artificial general intelligence (AGI) development with societal, technological, ethical, and brain-inspired pathways to ensure its responsible integration into human systems. Using the PRISMA framework and BERTopic modeling, it identifies five key pathways shaping AGI’s trajectory: (1) societal integration, addressing AGI’s broader societal impacts, public adoption, and policy considerations; (2) technological advancement, exploring real-world applications, implementation challenges, and scalability; (3) explainability, enhancing transparency, trust, and interpretability in AGI decision-making; (4) cognitive and ethical considerations, linking AGI’s evolving architectures to ethical frameworks, accountability, and societal consequences; and (5) braininspired systems, leveraging human neural models to improve AGI’s learning efficiency, adaptability, and reasoning capabilities. This study makes a unique contribution by systematically uncovering underexplored AGI themes, proposing a conceptual framework that connects AI advancements to practical applications, and addressing the multifaceted technical, ethical, and societal challenges of AGI development. The findings call for interdisciplinary collaboration to bridge critical gaps in transparency, governance, and societal alignment while proposing strategies for equitable access, workforce adaptation, and sustainable integration. Additionally, the study highlights emerging research frontiers, such as AGI-consciousness interfaces and collective intelligence systems, offering new pathways to integrate AGI into human-centered applications. By synthesizing insights across disciplines, this study provides a comprehensive roadmap for guiding AGI development in ways that balance technological innovation with ethical and societal responsibilities, advancing societal progress and well-being.

diverse knowledge representation methods and modules such as consciousness, ethics, and social interaction to address gaps in existing architectures and advance AGI capabilities. Salmon et al.

- What pathways are needed to enable scalable, adaptable, and explainable AGI across diverse environments?

- How can AGI systems be developed to align with ethical principles, societal needs, and equitable access?

- What pathways can ensure effective collaboration, trust, and transparency between humans and AGI systems?

- How can AGI contribute to advancements through interdisciplinary integration?

Conceptual background

- Weak AI (also known as narrow AI): This encompasses AI systems designed to excel in specific, well-defined tasks without possessing general cognitive abilities or reasoning capabilities. Often, task-specific, weak AI is highly efficient within its scope but cannot adapt or apply knowledge beyond its trained functions. Examples include voice assistants such as Siri, language translation tools, recommendation algorithms, and specialized systems such as AlphaGo

. - Human-level AI: This concept describes AI that matches human cognitive abilities, such as natural reasoning, emotional understanding, and complex decision-making. For example, human-level AI could mimic human intuition in fields such as diplomacy or creative storytelling, exhibiting behavioral parity with humans

. - Human-like AI: This concept focuses on mimicking human behaviors, such as speech, facial expressions, and emotional responses. Unlike AGI, human-like AI prioritizes interaction and relatability over cognitive versatility. Examples include conversational systems such as ChatGPT or humanoid robots such as Sophia, which simulate human emotions

. - Artificial general intelligence (AGI): AGI refers to AI systems that can understand, learn, and adapt to perform any intellectual task a human can perform. Unlike narrow AI, AGI generalizes learning across multiple domains and applies reasoning to new, unfamiliar problems. A true AGI system could diagnose diseases, compose symphonies, and design complex engineering systems-all without task-specific programming

. - Strong AI: Strong AI, often synonymous with AGI, suggests an AI system that possesses actual understanding, consciousness, and self-awareness. While AGI focuses on functional performance, strong AI questions whether machines can “think” in a human-like way, raising philosophical debates about sentience

.

| Type of AI | Definition | Key characteristics | Ethical considerations | Examples |

| Weak AI | AI systems are designed to perform specific tasks efficiently without general cognitive abilities | Task-specific and goaloriented; Limited adaptability beyond trained functions | Biases in outputs, limited explainability, and reliance on potentially flawed training datasets | Image recognition systems, recommendation engines, and virtual assistants like Alexa or Google Assistant |

| Human-level AI | AI systems that can match human capabilities in intellectual and cognitive tasks | Comparable performance to humans; Reasoning across diverse tasks | Biases in AI decisions, the replacement of human jobs, and the potential erosion of privacy | Discussed in Turing Test scenarios and human-level game-playing AIs like AlphaGo |

| Human-like AI | AI systems are designed to mimic human cognitive behaviors, reasoning, and problem-solving skills | Human-like responses and behaviors; Focus on imitation | User manipulation, transparency in AI behavior, and maintaining ethical humanAI interactions | ChatGPT, Siri, Sophia the Robot, and conversational AIs |

| Artificial General Intelligence (AGI) | AI systems are capable of performing any intellectual task that a human can, with adaptability across domains | Generalized learning and reasoning abilities; Taskagnostic | Misuse, control, and unintended consequences impact human society, requiring frameworks for governance and safety | Hypothetical systems like OpenCog and concepts explored in DeepMind’s research on AGI |

| Strong AI | AI that exhibits true understanding, reasoning, and consciousness similar to human beings | Ability to think, understand, and self-reflect, Not just task execution | Machine rights, moral agency, and accountability in decision-making processes | No real-world examples yet; explored in philosophical AI debates (e.g., John Searle’s “Chinese Room Argument”) |

| Artificial Superintelligence | Hypothetical AI that surpasses human intelligence in all domains, including decision-making and creativity | Exceeds human cognitive abilities; Capable of rapid self-improvement | Loss of human control, unequal power distribution, and existential threats to humanity | Nick Bostrom’s scenarios in Superintelligence; futuristic portrayals in movies like “Her” or “Ex Machina.” |

| Type of AI | Industries and domains | Example applications |

| Human-level AI | – Customer Service: AI agents replicating human communication.- Gaming: Human-like opponents for adaptive gameplay.- Education: Tutors are as effective as human teachers.- Manufacturing: Robots capable of cognitive task decision-making.- Entertainment: Film, animation, or content creation | – AI-powered tutors providing personalized support.- AI-driven gaming characters that adapt dynamically to users |

| Human-like AI | – Retail: Virtual customer assistants providing human-like interactions.- Healthcare: Mental health support via AI companions.- Hospitality: Human-like robots assisting in customer care.- Education: Socially interactive tutors for children.- Marketing: Personalized AI communications and campaigns | – AI robots assisting elderly patients.Virtual shopping assistants enhancing customer experience |

| Artificial General Intelligence (AGI) | – Healthcare: Diagnosis, personalized treatments, advanced decision-making.- Education: Adaptive learning systems.- Finance: Dynamic risk modeling, market predictions.- Defense: Strategic simulations.- R&D: Scientific discovery and innovation across disciplines | – AI-driven doctors capable of autonomous diagnosis.- AI-powered research assistants discovering new materials or drugs |

| Strong AI | – Philosophy/Ethics: Understanding consciousness and cognition.- Healthcare: Cognitive reasoning for personalized care.- Legal Sector: Independent decision-making in complex cases.- Creative Industries: True artistic or creative generation.- Robotics: Fully autonomous robots | – AI systems capable of moral reasoning or empathy.- AI judges handling legal cases with fairness and ethics |

| Artificial Superintelligence | – Defense and Security: Strategic autonomous decision-making beyond human capabilities.- Finance: Global economic optimization.- Energy: Highly efficient resource allocation systems.- Scientific Research: Quantum mechanics, climate modeling, or deep space exploration.- Governance: AI-driven policymaking and problemsolving | – Climate-change modeling far beyond human accuracy.- Optimized, AI-led governance systems |

- Artificial superintelligence (ASI): ASI refers to hypothetical AI systems that surpass human intelligence in every measurable aspect, including creativity, strategic thinking, and problem solving. While AGI matches human abilities, ASI achieves capabilities beyond human comprehension, raising significant ethical and existential questions

.

Related work

the argument that machines cannot have emotions due to a lack of feelings, proposing instead that AGI systems could possess emotions through their capacity for judgment, as demonstrated in emotions such as anger. Triguero et al.

| Author(s) | Research focus | Research gaps |

| Bécue et al.

|

Explores AGI-driven innovation through the alignment of AI maturity, manufacturing strategies, and innovation capacity, emphasizing AGI’s role in decision-making and complex problem-solving in Industry 5.0 | Alignment of AI maturity with innovation metrics |

| Yue and Shyu

|

Leverages AGI in the creation of intelligence fusion networks for proactive crisis management, incorporating principles of multisourced data integration, situational awareness, and decision-making | Scalability of AGI-driven intelligence fusion networks |

| Li et al.

|

Utilizes AGI principles such as multimodal learning, domain-specific knowledge extraction, and operational optimization for addressing complex challenges in the geoenergy sector | Domain-specific knowledge for AGI application |

|

|

Examines AGI’s impact on redefining professional roles and skills, focusing on AGI-human collaboration, ethical reasoning, and adaptability in an AGI-driven information environment | Skillset adaptation for AGIdriven environments |

| Chiroma et al.

|

Focuses on AGI-related applications in IoMT, including explainable AI for healthcare decision-making, and predictive analytics for real-time health monitoring systems | Addressing security and privacy in IoMT |

| McLean et al.

|

Analyzes AGI-related risks such as goal misalignment, autonomous decision-making, and the existential threats posed by AGI, proposing governance frameworks to mitigate such risks | Lack of standard AGI terminology and definitions |

| Wang et al.

|

Reviews AGI-driven large vision models and visual prompt engineering, emphasizing AGI’s capability to adapt prompts for generalizable and context-aware visual tasks | Designing efficient visual prompts for AGI systems |

| Daase and Turowski

|

Proposes AGI-compatible methodologies for explainable AI, connecting behavioral and design sciences to develop general-purpose AGI systems for Society 5.0 | Unified methodologies for explainable AI |

| Yang et al.

|

Identifies AGI challenges in diagram analysis, focusing on AGI’s ability to understand shape, topology, and content-based image retrieval for technical applications | Advances in diagramspecific retrieval techniques |

| Krishnan et al.

|

Investigates AGI integration with disruptive technologies like IoT and autonomous systems, emphasizing its role in adaptive, scalable, and human-centered smart city frameworks | Implementation challenges for nested technologies |

| Krishnan et al.

|

Explores AGI principles such as adaptability and multiagent interaction for optimizing disruptive technologies in smart cities, using empirical models to assess AGI’s impact | Framework validation for disruptive AGI technologies |

| Long and Cotner

|

Proposes a conceptual framework for AGI development, focusing on generalization, autonomy, and system-level integration for multidomain applications | Scalability of autonomous AGI systems |

| Everitt et al.

|

Provides a comprehensive review of AGI safety challenges, addressing goal alignment, system control, and ethical AI deployment strategies | Gaps in comprehensive AGI safety strategies |

Methods

PRISMA protocol

BERTopic modeling

| Pathways | Theories/Frameworks mentioned | AGI concepts used | Keywords |

| Societal pathways of human-like AI | Computers as Social Actors (CASA), PESTEL Framework | Empathy, Interaction Quality, Anthropomorphic Design | “human level”, “human-like AI”, “AI safety”, “decision making”, “machine learning”, “Turing test”, “progression”, “social change” |

| Technological pathways toward AGI | Explainable AI (XAI), Reward Maximization Hypothesis, Logical AI | Transparency, Reinforcement Learning, Representation Problems | “evolution”, “advancements”, “real-world effects”, “artificial general intelligence”, “big data”, “human-level”, “ethical considerations”, “policy”, “governance” |

| Pathways to explainability in AGI | Reinforcement Learning Framework, LDA Topic Modeling, AI Experimentation Platforms | Problem Solving, Task-Specific AI | “reinforcement learning”, “machine learning”, “artificial general intelligence”, “natural language processing”, “next-generation”, “innovation”, “trends” |

| Cognitive pathways and ethics in AGI | LIDA Model, Global Workspace Theory, AICompleteness Theory | Moral Decision Making, Turing Test, Neurocomputers | “cognitive architectures”, “machine consciousness”, “common sense”, “strong AI”, “ethical considerations”, “governance”, “future” |

| Brain inspired pathways toward AGI | Hybrid Tianjic Architecture, Neuroevolution, Statistical Sample Complexity Theory | Real-time Processing, Network Optimization, High-Dimensional Processing | “neuromorphic computing”, “working memory”, “brain-inspired computing”, “cutting-edge”, “breakthrough”, “projections”, “nextgeneration” |

Results

Societal pathways of AGI

Technological pathways toward AGI

Pathways to explainability in AGI

Cognitive pathways and ethics in AGI

into AGI systems to address ethical problems. By mimicking human deliberation processes, the study highlights AGI’s advancements toward making context-aware decisions, particularly in morally complex environments. This framework addresses ethical considerations and potential governance implications as autonomous agents become increasingly capable. The evolution of the AGI toward moral reasoning underscores the need for regulatory policies to ensure alignment with societal values.

Brain-inspired pathways toward AGI

Discussion

“Technological pathways toward AGI” connect AGI’s development, practical challenges, and societal implications. AGI systems, driven by deep reinforcement learning and multimodal frameworks, address real-world tasks, advancing human-like reasoning for autonomous systems, games, and cognitive processes. However, rapid adoption, as seen with ChatGPT, raises societal challenges such as employment shifts and policy gaps

“Pathways to explainability in AGI” highlights the critical need for transparent, trustworthy, and ethically aligned AGI systems. Techniques such as LIME and SHAP enhance transparency, which is essential for trust in sensitive areas such as healthcare

“Cognitive pathways and ethics in AGI” examines the interplay between the cognitive development of AGI and its societal impact. Frameworks such as LIDA

“Brain inspired pathways toward AGI” highlights the integration of neuroscience-inspired and artificial neural network approaches to advance AGI research. Emerging neuromorphic hardware, such as brain-like chips and hybrid platforms, offer energy-efficient, real-time cognitive capabilities, which are essential for AGI’s deployment in dynamic environments. This advancement expands the scope of brain-inspired computing to new applications, including robotics and adaptive learning systems. Hybrid platforms such as the Tianjic chip

Key challenges surrounding AGI

Ethical, legal, and social challenges

Implications

Implications for theory

common-sense reasoning. Additionally, this research leverages reinforcement learning frameworks and theories of neuroevolution to explore the developmental pathways of AGI. It advances these theories by introducing brain-inspired and hybrid architectures that combine symbolic reasoning with neural network learning, thus addressing limitations in scalability, generalization, and dynamic decision-making in current systems.

Implications for practice

Implications for policy

should also mandate fairness in AGI model training, preventing biases that could disproportionately disadvantage marginalized groups in both educational and healthcare applications.

Limitations and future directions

Prevailing theme: ethical guidelines and governance of AGI

Rising theme: AGI and collective intelligence

Rising theme: Brain-inspired AGI

Novel theme: AGI and consciousness

Novel theme: AGI in education

Conclusion

Data availability

Received: 10 January 2025; Accepted: 25 February 2025

Published online: 11 March 2025

References

- Fjelland, R. Why general artificial intelligence will not be realized. Hum. Soc. Sci. Commun. 7(1), 1-9 (2020).

- Yampolskiy, R. On the Differences between Human and Machine Intelligence. In AISafety@ IJCAI (2021).

- Hellström, T. & Bensch, S. Apocalypse now: no need for artificial general intelligence. AI Soc. 39(2), 811-813 (2024).

- Barrett, A. M. & Baum, S. D. A model of pathways to artificial superintelligence catastrophe for risk and decision analysis. J. Exp. Theor. Artif. Intell. 29(2), 397-414 (2017).

- Gill, K. S. Artificial super intelligence: beyond rhetoric. AI Soc. 31, 137-143 (2016).

- Pueyo, S. Growth, degrowth, and the challenge of artificial superintelligence. J. Clean. Prod. 197, 1731-1736 (2018).

- Saghiri, A. M., Vahidipour, S. M., Jabbarpour, M. R., Sookhak, M. & Forestiero, A. A survey of artificial intelligence challenges: Analyzing the definitions, relationships, and evolutions. Appl. Sci. 12(8), 4054 (2022).

- Ng, G. W. & Leung, W. C. Strong artificial intelligence and consciousness. J. Artif. Intell. Conscious. 7(01), 63-72(2020).

- Yampolskiy, R. V. Agi control theory. In Artificial General Intelligence: 14th International Conference, AGI 2021, Palo Alto, CA, USA, October 15-18, 2021, Proceedings 14 (pp. 316-326). Springer International Publishing (2022a).

- Yampolskiy, R. V. On the controllability of artificial intelligence: An analysis of limitations. J. Cyber Secur. Mob. 321-404 (2022b).

- Ramamoorthy, A. & Yampolskiy, R. Beyond mad? The race for artificial general intelligence. ITU J. 1(1), 77-84 (2018).

- Cao, L. Ai4tech: X-AI enabling X-Tech with human-like, generative, decentralized, humanoid and metaverse AI. Int. J. Data Sci. Anal. 18(3), 219-238 (2024).

- Goertzel, B. Artificial general intelligence and the future of humanity. The transhumanist reader: Classical and contemporary essays on the science, technology, and philosophy of the human future 128-137 (2013).

- Li, X., Zhao, L., Zhang, L., Wu, Z., Liu, Z., Jiang, H. & Shen, D. Artificial general intelligence for medical imaging analysis. IEEE Rev. Biomed. Eng. (2025).

- Rathi, S. Approaches to artificial general intelligence: An analysis (2022). arXiv preprint arXiv:2202.03153.

- Arora, A. & Arora, A. The promise of large language models in health care. The Lancet

. - Bikkasani, D. C. Navigating artificial general intelligence (AGI): Societal implications, ethical considerations, and governance strategies. AI Ethics 1-16 (2024).

- Li, J. X., Zhang, T., Zhu, Y. & Chen, Z. Artificial general intelligence for the upstream geoenergy industry: A review. Gas Sci. Eng. 205469 (2024).

- Nedungadi, P., Tang, K. Y. & Raman, R. The transformative power of generative artificial intelligence for achieving the sustainable development goal of quality education. Sustainability 16(22), 9779 (2024).

- Zhu, X., Chen, S., Liang, X., Jin, X. & Du, Z. Next-generation generalist energy artificial intelligence for navigating smart energy. Cell Rep. Phys. Sci. 5(9), 102192 (2024).

- Faroldi, F. L. Risk and artificial general intelligence. AI Soc. 1-9 (2024).

- Simon, C. J. Ethics and artificial general intelligence: technological prediction as a groundwork for guidelines. In 2019 IEEE International Symposium on Technology and Society (ISTAS) 1-6 (IEEE, 2019).

- Chouard, T. The Go files: AI computer wraps up 4-1 victory against human champion. Nat. News 20, 16 (2016).

- Morris, M. R., Sohl-Dickstein, J. N., Fiedel, N., Warkentin, T. B., Dafoe, A., Faust, A., Farabet, C. & Legg, S. Position: Levels of AGI for operationalizing progress on the path to AGI. In International Conference on Machine Learning (2023).

- Weinbaum, D. & Veitas, V. Open ended intelligence: The individuation of intelligent agents. J. Exp. Theor. Artif. Intell. 29(2), 371-396 (2017).

- Sublime, J. The AI race: Why current neural network-based architectures are a poor basis for artificial general intelligence. J. Artif. Intell. Res. 79, 41-67 (2024).

- Wickramasinghe, B., Saha, G. & Roy, K. Continual learning: A review of techniques, challenges and future directions. IEEE Trans. Artif. Intell. (2023).

- Fei, N. et al. Toward artificial general intelligence via a multimodal foundation model. Nat. Commun. 13(1), 3094 (2022).

- Kelley, D. & Atreides, K. AGI protocol for the ethical treatment of artificial general intelligence systems. Procedia Comput. Sci. 169, 501-506 (2020).

- McCormack, J. Autonomy, intention, Performativity: Navigating the AI divide. In Choreomata (pp. 240-257). Chapman and Hall/ CRC (2023).

- Khamassi, M., Nahon, M. & Chatila, R. Strong and weak alignment of large language models with human values. Sci. Rep. 14(1), 19399 (2024).

- McIntosh, T. R., Susnjak, T., Liu, T., Watters, P., Ng, A. & Halgamuge, M. N. A game-theoretic approach to containing artificial general intelligence: Insights from highly autonomous aggressive malware. IEEE Trans. Artif. Intell. (2024).

- Salmi, J. A democratic way of controlling artificial general intelligence. AI Soc. 38(4), 1785-1791 (2023).

- Bubeck, S., Chandrasekaran, V., Eldan, R., Gehrke, J., Horvitz, E., Kamar, E. & Zhang, Y. Sparks of artificial general intelligence: Early experiments with gpt-4 (2023). arXiv preprint arXiv:2303.12712.

- Faraboschi, P., Frachtenberg, E., Laplante, P., Milojicic, D. & Saracco, R. Artificial general intelligence: Humanity’s downturn or unlimited prosperity. Computer 56(10), 93-101 (2023).

- Wei, Y. Several important ethical issues concerning artificial general intelligence. Chin. Med. Ethics 37(1), 1-9 (2024).

- McLean, S. et al. The risks associated with artificial general intelligence: A systematic review. J. Exp. Theor. Artif. Intell. 35(5), 649-663 (2023).

- Shalaby, A. Digital sustainable growth model (DSGM): Achieving synergy between economy and technology to mitigate AGI risks and address Global debt challenges. J. Econ. Technol. (2024a).

- Croeser, S. & Eckersley, P. Theories of parenting and their application to artificial intelligence. In Proceedings of the 2019 AAAI/ ACM Conference on AI, Ethics, and Society (pp. 423-428) (2019).

- Lenharo, M. What should we do if AI becomes conscious? These scientists say it is time for a plan. Nature (2024). https://doi.org /10.1038/d41586-024-04023-8

- Shankar, V. Managing the twin faces of AI: A commentary on “Is AI changing the world for better or worse?”. J. Macromark. 44(4), 892-899 (2024).

- Wu, Y. Future of information professions: Adapting to the AGI era. Sci. Tech. Inf. Process. 51(3), 273-279 (2024).

- Sukhobokov, A., Belousov, E., Gromozdov, D., Zenger, A. & Popov, I. A universal knowledge model and cognitive architecture for prototyping AGI (2024). arXiv preprint arXiv:2401.06256.

- Salmon, P. M. et al. Managing the risks of artificial general intelligence: A human factors and ergonomics perspective. Hum. Fact. Ergon. Manuf. Serv. Ind. 33(5), 366-378 (2023).

- Bory, P., Natale, S. & Katzenbach, C. Strong and weak AI narratives: An analytical framework. AI Soc. 1-11 (2024).

- Gai, F. When artificial intelligence meets Daoism. In Intelligence and Wisdom: Artificial Intelligence Meets Chinese Philosophers 83-100 (2021).

- Menaga, D. & Saravanan, S. Application of artificial intelligence in the perspective of data mining. In Artificial Intelligence in Data Mining (pp. 133-154). Academic Press (2021).

- Adams, S., Arel, I., Bach, J., Coop, R., Furlan, R., Goertzel, B., Sowa, J. (2012). Mapping the landscape of human-level artificial general intelligence. AI Magazine 33(1), 25-42.

- Beerends, S. & Aydin, C. Negotiating the authenticity of AI: how the discourse on AI rejects human indeterminacy. AI Soc. 1-14 (2024).

- Besold, T. R. Human-level artificial intelligence must be a science. In Artificial General Intelligence: 6 th International Conference, AGI 2013, Beijing, China, July 31-August 3, 2013 Proceedings 6 (pp. 174-177). Springer Berlin Heidelberg (2013).

- Eth, D. The technological landscape affecting artificial general intelligence and the importance of nanoscale neural probes. Informatica 41(4) (2017).

- Nvs, B. & Saranya, P. L. Water pollutants monitoring based on Internet of Things. In Inorganic Pollutants in Water (pp. 371-397) (2020). Elsevier.

- Flowers, J. C. Strong and Weak AI: Deweyan Considerations. In AAAI spring symposium: Toward conscious AI systems (Vol. 2287, No. 7) (2019).

- Mitchell, M. Debates on the nature of artificial general intelligence. Science 383(6689), eado7069 (2024).

- Grech, V. & Scerri, M. Evil doctor, ethical android: Star Trek’s instantiation of conscience in subroutines. Early Hum. Dev. 145, 105018 (2020).

- Noller, J. Extended human agency: Towards a teleological account of AI. Hum. Soc. Sci. Commun. 11(1), 1-7 (2024).

- Nominacher, M. & Peletier, B. Artificial intelligence policies. The digital factory for knowledge: Production and validation of scientific results 71-76 (2018).

- Isaac, M., Akinola, O. M., & Hu, B. Predicting the trajectory of AI utilizing the Markov model of machine learning. In 2023 IEEE 3rd International Conference on Computer Communication and Artificial Intelligence (CCAI) (pp. 30-34). IEEE (2023).

- Stewart, W. The human biological advantage over AI. AI & Soc. 1-10 (2024).

- Vaidya, A. J. Can machines have emotions? AI Soc. 1-16 (2024).

- Triguero, I., Molina, D., Poyatos, J., Del Ser, J. & Herrera, F. General purpose artificial intelligence systems (GPAIS): Properties, definition, taxonomy, societal implications and responsible governance. Inf. Fus. 103, 102135 (2024).

- Bécue, A., Gama, J. & Brito, P. Q. AI’s effect on innovation capacity in the context of industry 5.0: A scoping review. Artif. Intell. Rev. 57(8), 215 (2024).

- Yue, Y. & Shyu, J. Z. A paradigm shift in crisis management: The nexus of AGI-driven intelligence fusion networks and blockchain trustworthiness. J. Conting. Crisis Manag. 32(1), e12541(2024).

- Chiroma, H., Hashem, I. A. T. & Maray, M. Bibliometric analysis for artificial intelligence in the internet of medical things: Mapping and performance analysis. Front. Artif. Intell. 7, 1347815 (2024).

- Wang, Z., Chen, J., Chen, J. & Chen, H. Identifying interdisciplinary topics and their evolution based on BERTopic. Scientometrics https://doi.org/10.1007/s11192-023-04776-5 (2023).

- Wang, J., Liu, Z., Zhao, L., Wu, Z., Ma, C., Yu, S. & Zhang, S. Review of large vision models and visual prompt engineering. MetaRadiol. 100047 (2023).

- Daase, C. & Turowski, K. Conducting design science research in society 5.0-Proposal of an explainable artificial intelligence research methodology. In International Conference on Design Science Research in Information Systems and Technology (pp. 250265). Springer, Cham (2023).

- Yang, L., Gong, M. & Asari, V. K. Diagram image retrieval and analysis: Challenges and opportunities. In Proceedings of the IEEE/ CVF Conference on Computer Vision and Pattern Recognition Workshops (pp. 180-181) (2020).

- Krishnan, B., Arumugam, S. & Maddulety, K. ‘Nested’disruptive technologies for smart cities: Effects and challenges. Int. J. Innov. Technol. Manag. 17(05), 2030003 (2020).

- Krishnan, B., Arumugam, S. & Maddulety, K. Impact of disruptive technologies on smart cities: challenges and benefits. In International Working Conference on Transfer and Diffusion of IT (pp. 197-208). Cham: Springer International Publishing (2020).

- Long, L. N. & Cotner, C. F. A review and proposed framework for artificial general intelligence. In 2019 IEEE Aerospace Conference (pp. 1-10). IEEE (2019).

- Everitt, T., Lea, G. & Hutter, M. AGI safety literature review (2018). arXiv preprint arXiv:1805.01109.

- Wang, P. & Goertzel, B. Introduction: Aspects of artificial general intelligence. In Advances in Artificial General Intelligence: Concepts, Architectures and Algorithms (pp. 1-16). IOS Press (2007).

- Yampolskiy, R. & Fox, J. Safety engineering for artificial general intelligence. Topoi 32, 217-226 (2013).

- Dushkin, R. V. & Stepankov, V. Y. Hybrid bionic cognitive architecture for artificial general intelligence agents. Procedia Comput. Sci. 190, 226-230 (2021).

- Nyalapelli, V. K., Gandhi, M., Bhargava, S., Dhanare, R. & Bothe, S. Review of progress in artificial general intelligence and human brain inspired cognitive architecture. In 2021 International Conference on Computer Communication and Informatics (ICCCI) (pp. 1-13). IEEE (2021).

- Page, M. J. et al. The PRISMA 2020 statement: an updated guideline for reporting systematic reviews. BMJ 372, n71. https://doi.o rg/10.1136/bmj.n71 (2021).

- Donthu, N., Kumar, S., Pandey, N., Pandey, N. & Mishra, A. Mapping the electronic word-of-mouth (eWOM) research: A systematic review and bibliometric analysis. J. Bus. Res. 135, 758-773 (2021).

- Comerio, N. & Strozzi, F. Tourism and its economic impact: A literature review using bibliometric tools. Tour. Econ. 25(1), 109-131 (2019).

- Raman, R., Gunasekar, S., Dávid, L. D. & Nedungadi, P. Aligning sustainable aviation fuel research with sustainable development goals: Trends and thematic analysis. Energy Rep. 12, 2642-2652 (2024).

- Raman, R., Gunasekar, S., Kaliyaperumal, D. & Nedungadi, P. Navigating the nexus of artificial intelligence and renewable energy for the advancement of sustainable development goals. Sustainability 16(21), 1-25 (2024).

- Egger, R. & Yu, J. A topic modeling comparison between lda, nmf, top2vec, and bertopic to demystify twitter posts. Front. Sociol. 7, 886498 (2022).

- Devlin, J., Chang, M. W., Lee, K. & Toutanova, K. BERT: Pre-training of deep bidirectional transformers for language understanding. NAACL HLT 2019-2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies-Proceedings of the Conference, 1(Mlm), 4171-4186 (2019).

- Grootendorst, M. BERTopic: Neural topic modeling with a class-based TFIDF procedure (2022). http://arxiv.org/abs/2203.05794

- Alamsyah, A. & Girawan, N. D. Improving clothing product quality and reducing waste based on consumer review using RoBERTa and BERTopic language model. Big Data Cogn. Comput. 7(4), 168 (2023).

- Raman, R. et al. Green and sustainable AI research: An integrated thematic and topic modeling analysis. J. Big Data 11(1), 55 (2024).

- Um, T. & Kim, N. A study on performance enhancement by integrating neural topic attention with transformer-based language model. Appl. Sci. 14(17), 7898 (2024).

- Gan, L., Yang, T., Huang, Y., Yang, B., Luo, Y. Y., Richard, L. W. C. & Guo, D. Experimental comparison of three topic modeling methods with LDA, Top2Vec and BERTopic. In International Symposium on Artificial Intelligence and Robotics (pp. 376-391). Singapore: Springer Nature Singapore (2023).

- Yi, J., Oh, Y. K. & Kim, J. M. Unveiling the drivers of satisfaction in mobile trading: Contextual mining of retail investor experience through BERTopic and generative AI. J. Retail. Consum. Serv. 82, 104066 (2025).

- Oh, Y. K., Yi, J. & Kim, J. What enhances or worsens the user-generated metaverse experience? An application of BERTopic to Roblox user eWOM. Internet Res. (2023).

- Kim, K., Kogler, D. F. & Maliphol, S. Identifying interdisciplinary emergence in the science of science: Combination of network analysis and BERTopic. Hum. Soc. Sci. Commun. 11(1), 1-15 (2024).

- Khodeir, N. & Elghannam, F. Efficient topic identification for urgent MOOC Forum posts using BERTopic and traditional topic modeling techniques. Educ. Inf. Technol. 1-27 (2024).

- McInnes, L., Healy, J. & Melville, J. UMAP: Uniform manifold approximation and projection for dimension reduction (2018).

- Douglas, T., Capra, L. & Musolesi, M. A computational linguistic approach to study border theory at scale. Proc. ACM Hum. Comput. Interact. 8(CSCW1), 1-23 (2024).

- Pelau, C., Dabija, D. C. & Ene, I. What makes an AI device human-like? The role of interaction quality, empathy and perceived psychological anthropomorphic characteristics in the acceptance of artificial intelligence in the service industry. Comput. Hum. Behav. 122, 106855 (2021).

- Yang, Y., Liu, Y., Lv, X., Ai, J. & Li, Y. Anthropomorphism and customers’ willingness to use artificial intelligence service agents. J. Hosp. Mark. Manag. 31(1), 1-23 (2022).

- Kaplan, A. & Haenlein, M. Rulers of the world, unite! The challenges and opportunities of artificial intelligence. Bus. Horizons 63(1), 37-50 (2020).

- Sallab, A. E., Abdou, M., Perot, E. & Yogamani, S. Deep reinforcement learning framework for autonomous driving (2017). arXiv preprint arXiv:1704.02532.

- Taecharungroj, V. “What can ChatGPT do?” Analyzing early reactions to the innovative AI chatbot on Twitter. Big Data Cogn. Comput. 7(1), 35 (2023).

- Hohenecker, P. & Lukasiewicz, T. Ontology reasoning with deep neural networks. J. Artif. Intell. Res. 68, 503-540 (2020).

- Došilović, F. K., Brčić, M. & Hlupić, N. Explainable artificial intelligence: A survey. In 2018 41st International convention on information and communication technology, electronics and microelectronics (MIPRO) (pp. 0210-0215). IEEE (2018).

- Silver, D., Singh, S., Precup, D. & Sutton, R. S. Reward is enough. Artif. Intell. 299, 103535 (2021).

- McCarthy, J. From here to human-level AI. Artif. Intell. 171(18), 1174-1182 (2007).

- Wallach, W., Franklin, S. & Allen, C. A conceptual and computational model of moral decision making in human and artificial agents. Top. Cogn. Sci. 2(3), 454-485 (2010).

- Franklin, S. Artificial Minds. MIT Press, p. 412 (1995).

- Yampolskiy, R. V. Turing test as a defining feature of AI-completeness. Artificial Intelligence, Evolutionary Computing and Metaheuristics: In the Footsteps of Alan Turing, 3-17 (2013).

- Arcas, B. A. Do large language models understand us?. Daedalus 151(2), 183-197 (2022).