DOI: https://doi.org/10.1609/aaai.v38i20.30214

تاريخ النشر: 2024-03-24

مُسيء سلوك، مُستشار جيد: استكشاف دور نماذج اللغة الكبيرة في كشف الأخبار الزائفة

الملخص

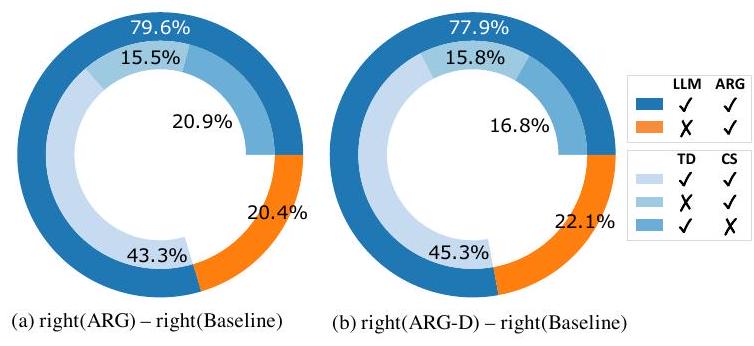

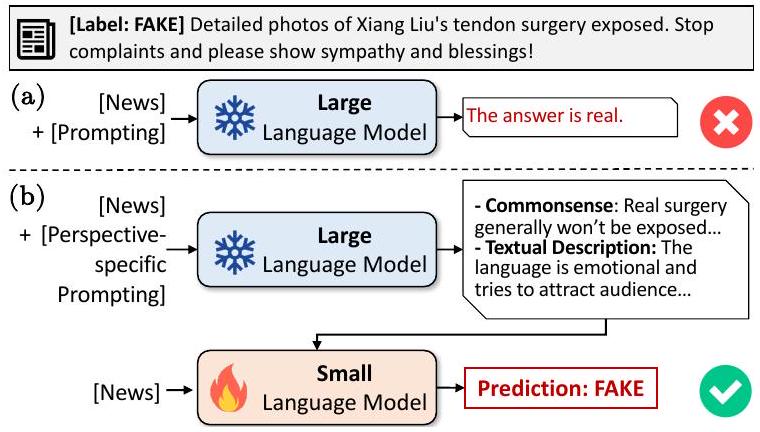

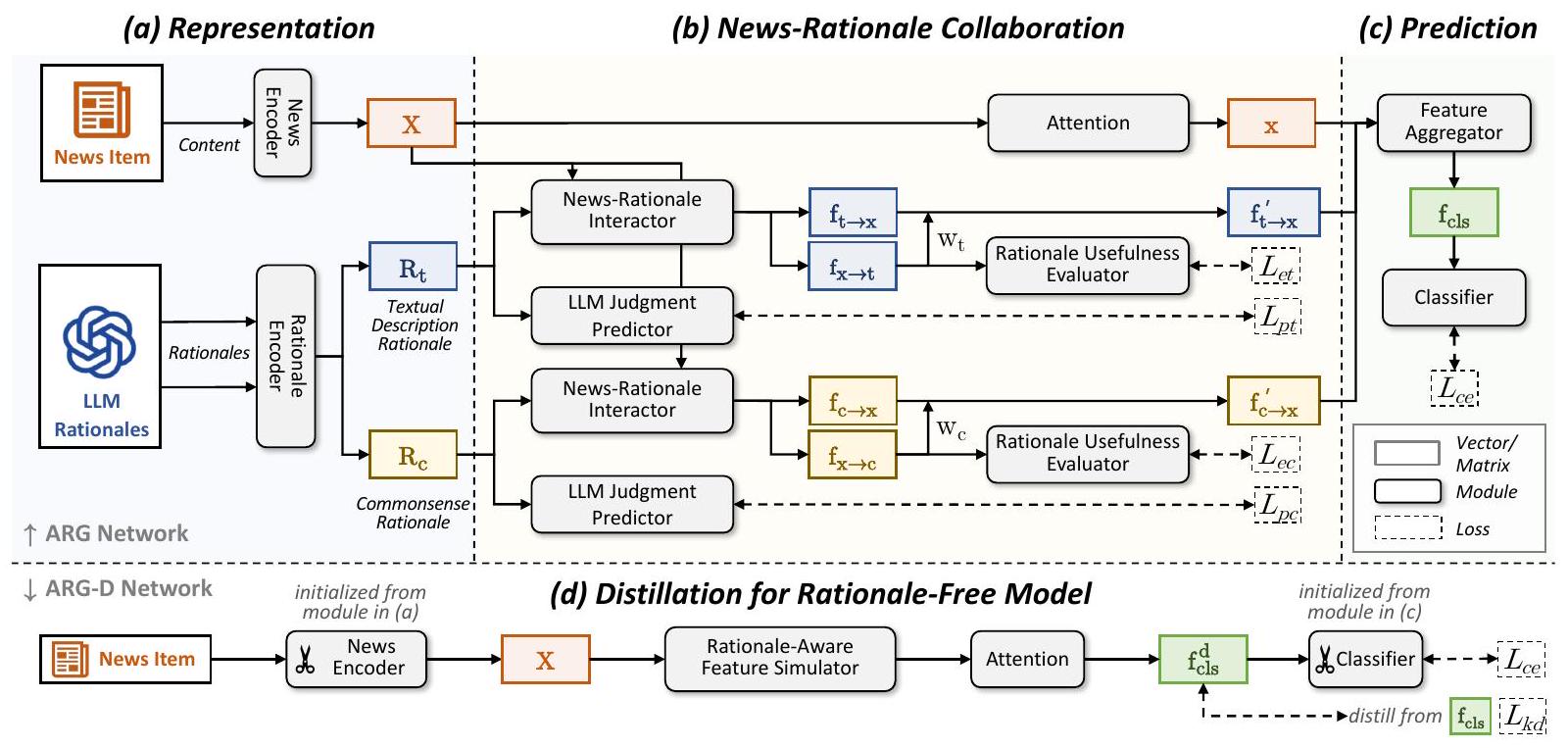

يتطلب اكتشاف الأخبار المزيفة حسًا دقيقًا لمجموعة متنوعة من الأدلة وفهمًا عميقًا للخلفية الواقعية، وهو ما لا يزال يمثل تحديًا للكاشفين المعتمدين على نماذج اللغة الصغيرة (SLMs) بسبب قيود المعرفة والقدرة. أظهرت التقدمات الأخيرة في نماذج اللغة الكبيرة (LLMs) أداءً ملحوظًا في مهام متنوعة، لكن ما إذا كانت وكيف يمكن أن تساعد LLMs في اكتشاف الأخبار المزيفة لا يزال غير مستكشف بشكل كافٍ. في هذه الورقة، نستكشف إمكانيات LLMs في اكتشاف الأخبار المزيفة. أولاً، نجري دراسة تجريبية ونجد أن LLM متطور مثل GPT 3.5 يمكنه عمومًا كشف الأخبار المزيفة وتقديم مبررات متعددة الزوايا مرغوبة ولكنه لا يزال أقل أداءً من SLM الأساسي، BERT المُعدل. تُعزى تحليلاتنا اللاحقة إلى هذه الفجوة إلى عدم قدرة LLM على اختيار ودمج المبررات بشكل صحيح للتوصل إلى استنتاج. بناءً على هذه النتائج، نقترح أن LLMs الحالية قد لا تحل محل SLMs المعدلة في اكتشاف الأخبار المزيفة ولكن يمكن أن تكون مستشارًا جيدًا لـ SLMs من خلال تقديم مبررات تعليمية متعددة الزوايا. لتجسيد هذا الاقتراح، نصمم شبكة توجيه مبررات تكيفية لاكتشاف الأخبار المزيفة (ARG)، حيث تكتسب SLMs بشكل انتقائي رؤى حول تحليل الأخبار من مبررات LLMs. نستخرج أيضًا نسخة خالية من المبررات من ARG من خلال التقطير، وهي ARGD، التي تخدم السيناريوهات الحساسة من حيث التكلفة دون استعلام LLMs. تُظهر التجارب على مجموعتين من البيانات الواقعية أن ARG و ARGD يتفوقان على ثلاثة أنواع من طرق الأساس، بما في ذلك المعتمدة على SLM، المعتمدة على LLM، ومجموعات من نماذج اللغة الصغيرة والكبيرة.

1 المقدمة

- هل يمكن أن تساعد LLMs في اكتشاف الأخبار المزيفة بمعرفتها الداخلية وقدرتها؟

- ما الحل الذي يجب أن نتبناه للحصول على أداء أفضل باستخدام LLMs؟

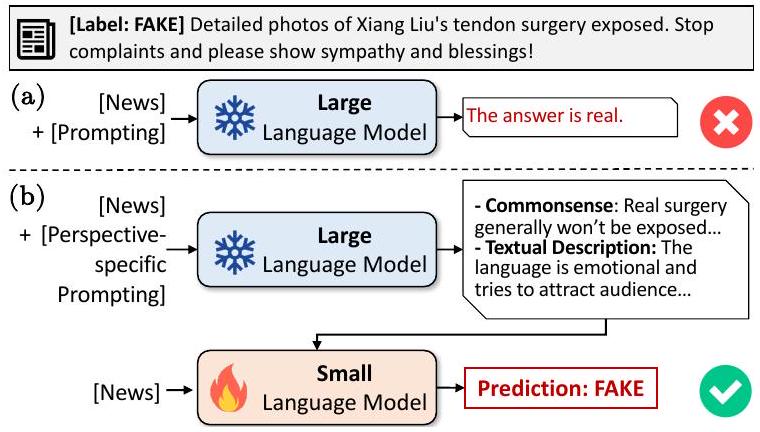

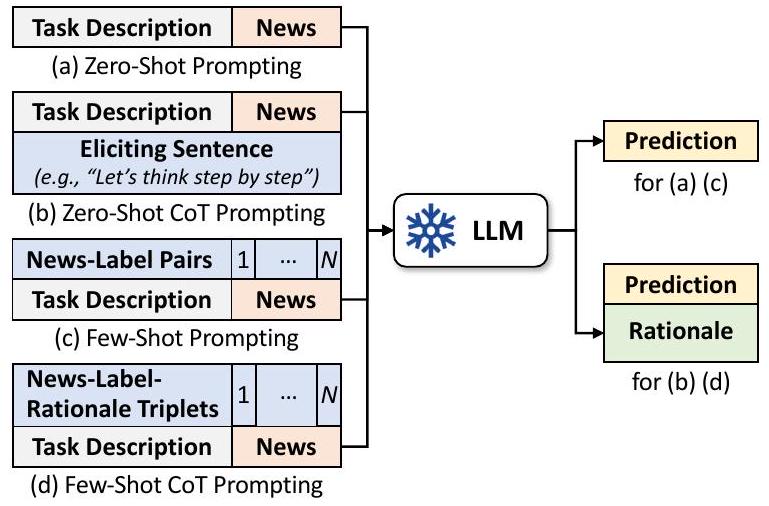

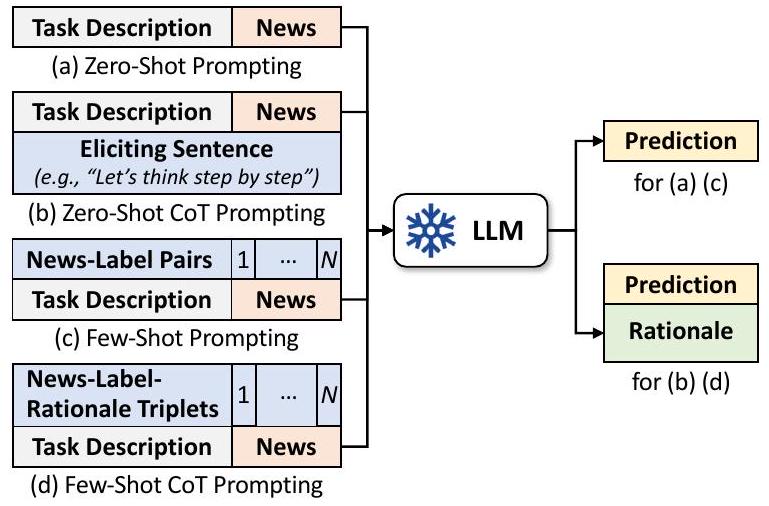

للإجابة على هذين السؤالين، نجري أولاً تحقيقًا عميقًا في الدور الفعال لـ LLMs في اكتشاف الأخبار المزيفة ونحاول تقديم حل عملي يتضمن LLM. على عكس الأعمال المعاصرة (بيلرين وآخرون، 2023؛ كارامانسيون، 2023) التي تطلب ببساطة من LLMs تقديم توقعات مع تعليمات المهمة، نجري دراسة تجريبية مفصلة لاستخراج إمكانيات LLMs. على وجه التحديد، نستخدم أربعة أساليب تحفيز نموذجية (تحفيز بدون عينة/تحفيز قليل العينة/تحفيز سلسلة الأفكار) لطلب من LLM إصدار أحكام حول صحة العناصر الإخبارية المعطاة (الشكل 1(أ)) ونجد أن حتى أفضل طريقة تعتمد على LLM لا تزال أقل أداءً من SLMs المعدلة الخاصة بالمهمة. ثم نقوم بتحليل المبررات التفسيرية التي تم إنشاؤها بواسطة LLM ونجد أن LLM يمكن أن تقدم مبررات معقولة ومعلوماتية من عدة زوايا. من خلال تحفيز LLM بعد ذلك بمطالب محددة للزوايا وأداء تجميعات قائمة على القواعد للأحكام، نجد أن المبررات تفيد بالفعل اكتشاف الأخبار المزيفة، وننسب الأداء غير المرضي إلى عدم قدرة LLM على اختيار ودمج المبررات بشكل صحيح.

|

|

الصينية | الإنجليزية | ||||

| تدريب | تقييم | اختبار | تدريب | تقييم | اختبار | |

| حقيقي | 2,331 | 1,172 | 1,137 | 2,878 | 1,030 | 1,024 |

| مزيف | 2,873 | 779 | 814 | 1,006 | 244 | 234 |

| الإجمالي | 5,204 | 1,951 | 1,951 | 3,884 | 1,274 | 1,258 |

استنادًا إلى هذه النتائج، نقترح أن LLM الحالي قد لا يكون بديلاً جيدًا لـ SLM المعدل جيدًا ولكنه يمكن أن يكون مستشارًا جيدًا من خلال تقديم مبررات تعليمية، كما هو موضح في الشكل 1(ب). لتجسيد اقتراحنا، نصمم شبكة توجيه مبررات تكيفية (ARG) لاكتشاف الأخبار المزيفة، والتي تربط بين نماذج اللغة الصغيرة والكبيرة من خلال حقن رؤى جديدة حول تحليل الأخبار من مبررات LLM الكبيرة إلى LMs الصغيرة. تستخرج ARG أيضًا ARG-D الخالية من المبررات عبر التقطير للسيناريوهات الحساسة من حيث التكلفة دون الحاجة لاستعلام LLMs. تُظهر التجارب على مجموعتين من البيانات الواقعية أن ARG و ARG-D يتفوقان على الطرق الحالية المعتمدة على SLM/LLM فقط ومجموعات الطرق. مساهماتنا هي كما يلي:

- تحقيق مفصل: نحقق في الدور الفعال لـ LLMs في اكتشاف الأخبار المزيفة ونجد أن LLM سيء في حكم الصحة ولكنه جيد في تحليل المحتويات؛

- حل مبتكر وعملي: نصمم شبكة ARG جديدة وإصدارها المقطر ARG-D التي تكمل نماذج اللغة الصغيرة والكبيرة من خلال اكتساب رؤى من مبررات LLM التي تم إنشاؤها لـ SLMs، والتي أظهرت تفوقًا بناءً على تجارب واسعة؛

- موارد مفيدة: نبني مجموعة مبررات من GPT-3.5 لاكتشاف الأخبار المزيفة بلغتين (الصينية والإنجليزية) وسنجعلها متاحة للجمهور لتسهيل المزيد من البحث.

2 هل LLM كاشف جيد؟

2.1 إعدادات التجربة

- يتم بناء التحفيز بدون أمثلة (Zero-Shot Prompting) من خلال تضمين وصف المهمة والأخبار المعطاة فقط. لجعل الاستجابة أكثر كفاءة وتقليل نسبة الرفض، نتبنى بشكل اختياري تقنية تمثيل الأدوار عند وصف مهمتنا (Liu et al., 2023b; Ramlochan, 2023).

- تحفيز سلسلة الأفكار بدون تدريب مسبق (كوجيما وآخرون، 2022) هو نهج بسيط ومباشر لتحفيز سلسلة الأفكار (CoT) لـ…

| نموذج | الاستخدام | صيني | الإنجليزية |

| جي بي تي-3.5- | عدم وجود أمثلة | 0.676 | 0.568 |

| زيرو شوت كوت | 0.677 | 0.666 | |

| قليل من اللقطات |

|

0.697 | |

| قليل من اللقطات – سلسلة من الأفكار | 0.681 |

|

|

| بيرت | التعديل الدقيق |

|

|

|

|

|

- التوجيه القليل (براون وآخرون، 2020) يوفر توجيهات محددة للمهام وعددًا من أمثلة تصنيف الأخبار كعرض. بعد الاختبارات الأولية لـ

- تحفيز سلسلة التفكير القليل (Wei et al., 2022b) لا يوفر فقط أمثلة على تسميات الأخبار، بل يظهر أيضًا خطوات التفكير مع المبررات المكتوبة سابقًا. هنا، نحصل على العروض المبررة المقدمة من المخرجات الصحيحة والمعقولة لتحفيز سلسلة التفكير بدون تدريب.

2.2 مقارنة بين النماذج اللغوية الصغيرة والكبيرة

| وجهة نظر | صيني | الإنجليزية | |||||

| دعامة | ماك إف 1 | دعامة | ماك إف 1 | ||||

| الوصف النصي | 65% | 0.706 | 71% | 0.653 | |||

|

|||||||

| الفطرة السليمة | 71% | 0.698 | 60٪ | 0.680 | |||

|

|||||||

| الواقعية | 17% | 0.629 | 24% | 0.626 | |||

|

|||||||

| آخرون | ٤٪ | 0.649 | ٨٪ | 0.704 | |||

2) النسخ القليلة من العينات تتفوق على النسخ التي لا تحتوي على عينات، مما يشير إلى أهمية عينات المهام. ومع ذلك، فإن تقديم عدة عينات يضيق الفجوة مع نموذج اللغة القائم على التعلم الذاتي ولكنه لا يؤدي إلى التفوق عليه.

3) يؤدي استخدام تقنية CoT إلى تحقيق مكاسب إضافية في الأداء بشكل عام، خاصة في إعداد عدم وجود أمثلة مسبقة على مجموعة البيانات الإنجليزية.

2.3 تحليل المبررات من نموذج اللغة الكبير

| نموذج | الاستخدام | صيني | الإنجليزية |

| جي بي تي-3.5-تيربو | زيرو شوت كوت | 0.677 | 0.666 |

| من منظور TD | 0.667 | 0.611 | |

| من منظور CS | 0.678 | 0.698 | |

| بيرت | التعديل الدقيق | 0.753 | 0.765 |

| مجموعة | التصويت بالأغلبية | 0.735 | 0.724 |

| تصويت أوراكل | 0.908 | 0.878 |

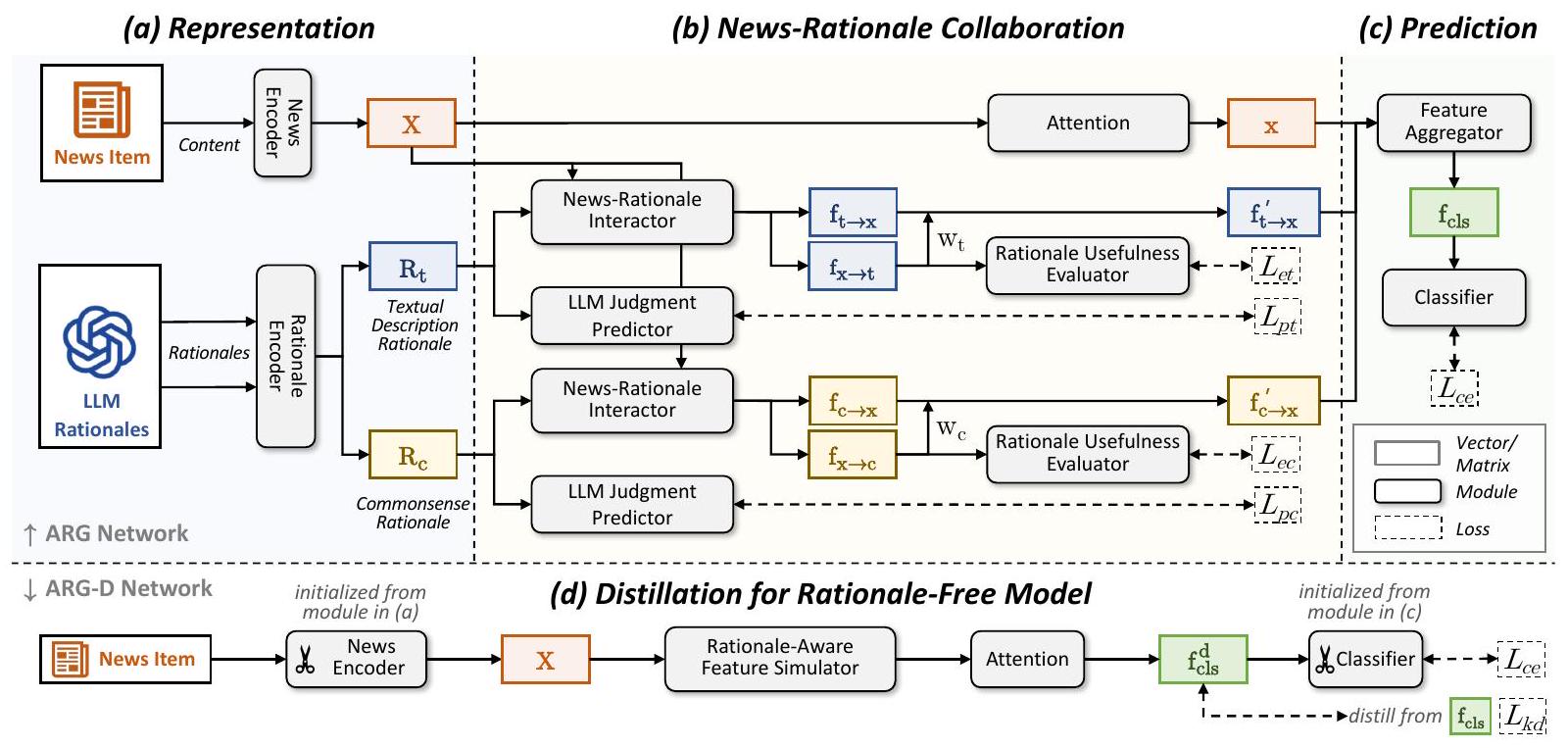

3 ARG: شبكة توجيه الأسباب التكيفية لاكتشاف الأخبار المزيفة

3.1 التمثيل

العروض. بالنسبة للخبر المعطى

3.2 التعاون في الأخبار والمبررات

3.2.1 تفاعل الأخبار-المنطق

3.2.2 توقع حكم LLM

3.2.3 تقييم فائدة الأساس المنطقي

3.3 التنبؤ

| نموذج | صيني | الإنجليزية | |||||||

| ماكF1 | حساب |

|

|

ماك إف 1 | حساب |

|

|

||

| G1: نموذج اللغة الكبير فقط GPT-3.5-turbo | 0.725 | 0.734 | 0.774 | 0.676 | 0.702 | 0.813 | 0.884 | 0.519 | |

| جي 2: فقط SLM | خط الأساس | 0.753 | 0.754 | 0.769 | 0.737 | 0.765 | 0.862 | 0.916 | 0.615 |

| إيان

|

0.754 | 0.756 | 0.773 | 0.736 | 0.763 | 0.864 | 0.918 | 0.608 | |

| ناشر-إيمو | 0.761 | 0.763 | 0.784 | 0.738 | 0.766 | 0.868 | 0.920 | 0.611 | |

| إن ديف | 0.765 | 0.766 | 0.779 | 0.751 | 0.768 | 0.865 | 0.918 | 0.618 | |

| G3: LLM+SLM | الخط الأساسي + المبررات | 0.767 | 0.769 | 0.787 | 0.748 | 0.777 | 0.870 | 0.921 | 0.633 |

| سوبر آي سي إل | 0.757 | 0.759 | 0.779 | 0.734 | 0.736 | 0.864 | 0.920 | 0.551 | |

| أرج | 0.784 | 0.786 | 0.804 | 0.764 | 0.790 |

|

0.926 | 0.653 | |

| (التحسن النسبي مقارنة بالخط الأساسي) |

|

||||||||

| بدون متنبئ حكم LLM | 0.773 | 0.774 | 0.789 | 0.756 |

|

0.880 | 0.928 | 0.645 | |

| مقيّم فائدة بدون مبرر |

|

0.783 | 0.801 | 0.761 | 0.782 | 0.873 | 0.923 | 0.641 | |

| بدون متنبئ ومقيم | 0.769 | 0.770 | 0.782 | 0.756 | 0.780 | 0.874 | 0.923 | 0.637 | |

| أرج-دي |

|

||||||||

3.4 التقطير لنموذج خالٍ من المبررات

4 التقييم

4.1 إعدادات التجربة

جي 2 (SLM فقط)

G3 (LLM+SLM): 1) الأساسيات + المبررات: يجمع الميزات من مشفر الأخبار ومشفر المبررات ويغذيها إلى MLP للتنبؤ. 2) SuperICL (شو وآخرون، 2023): يستغل SLM كإضافة لتعلم السياق في LLM من خلال حقن التنبؤ والثقة لكل عينة اختبار في الموجه.

4.2 مقارنة الأداء ودراسة الإلغاء

4.3 تحليل النتائج

4.4 تحليل التكلفة في الممارسة

5 الأعمال ذات الصلة

المحتوى المعطى، بما في ذلك النص (بريزبيلا، 2020) والصور (تشي وآخرون، 2021) وقد تتطلب مساعدة إضافية من قواعد المعرفة (بوبات وآخرون، 2018) وبيئات الأخبار (شينغ وآخرون، 2022). تحصل كلا المجموعتين من الطرق على تمثيل نصي من نماذج مدربة مسبقًا مثل BERT كقاعدة ولكن نادرًا ما تأخذ في الاعتبار إمكاناتها لاكتشاف الأخبار المزيفة. قمنا بإجراء استكشاف في هذه الورقة من خلال دمج LMs الكبيرة والصغيرة وحققنا تحسينًا جيدًا باستخدام المحتوى النصي فقط.

LLMs لفهم اللغة الطبيعية

6 الخاتمة والنقاش

الجيد للتعلم” من النماذج الأسوأ. نتوقع أن يتم توسيع حلنا ليشمل مهام أخرى وتعزيز استخدام LLMs بشكل أكثر فعالية وملاءمة من حيث التكلفة في المستقبل.

الشكر

References

تحليل حالة

في تقديم توقع دقيق، مما يتجاوز توقعاتنا. بعد إجراء تحليل مقارن، وجدنا أنه ضمن مجموعة التدريب، يؤدي استخدام عبارات مثل “أسلوب الكتابة المدمج” في أسباب الوصف النصي غالبًا إلى أحكام غير صحيحة. نفترض أنه مسترشدًا بالإشارات المقدمة من مقيم فائدة الأسباب، أدركت ARG هذا النمط وكانت قادرة على اتخاذ أحكام تتعارض مع الأسباب الخاطئة واختارت التوقع الصحيح. بينما في الحالة 5، لم تتمكن ARG من عكس الحكم الخاطئ كما في الحالة 4. نعتقد أن هذا بسبب عدم وجود نمط واضح مثل ذلك في الحالة 4. مقيدة بأداء فهم اللغة الطبيعية لنموذج BERT-base، كافحت ARG لالتقاط علاقات منطقية أكثر تعقيدًا.

أمثلة على التحفيز

الأخبار: واو! تم التقاط روبوت في روسيا بشكل بطولي وهو ينقذ فتاة صغيرة مرحة من أن تسحقها رف. انتشر هذا الفعل على الإنترنت، مما يظهر قوة الروبوت، مذهل!

سبب LLM (الوصف النصي): تستخدم هذه الرسالة لغة مبالغ فيها وعاطفية، دون تقديم مصادر أو أدلة موثوقة.

سبب LLM (الفطرة السليمة): بناءً على المعرفة والخبرة الشائعة، لم تصل الروبوتات بعد إلى مستوى يمكنها من التصرف بشكل مستقل وإنقاذ الأرواح البشرية.

توقع القاعدة: حقيقي توقع LLM TD: مزيف توقع LLM CS: مزيف توقع ARG: حقيقي

الحالة 2: توقعت القاعدة بشكل خاطئ، بينما توقعت ARG بشكل صحيح، وكان LLM باستخدام منظور الوصف النصي أيضًا صحيحًا.

الأخبار: #NingboRevelation# [صيادو نينغبو شيانغشان يصطادون سمكة غريبة، أطلق عليها لقب ‘باندا الماء’]#NingboFreshNews# حوالي الساعة 7:00 مساءً في 2 مارس، اصطادت السفينة ZXY02206، عند إحداثيات

سبب LLM (الوصف النصي): تستخدم هذه الرسالة لغة أكثر رسمية وتقدم تفاصيل محددة حول الوقت والمكان ونوع السمكة التي تم اصطيادها، بما في ذلك حجمها. كما تذكر أن المعلومات قد تم التحقق منها.

سبب LLM (الفطرة السليمة): بناءً على المعرفة والخبرة الشائعة، فإن سمكة الستurgeon الصينية هي نوع مهدد بالانقراض ونادر، مما يجعل من غير المحتمل أن يتم اصطيادها بشكل شائع من قبل صيادين عاديين.

توقع القاعدة: مزيف توقع LLM TD: حقيقي توقع LLM CS: مزيف توقع ARG: حقيقي

الحالة 3: توقعت القاعدة بشكل خاطئ، بينما توقعت ARG بشكل صحيح، وكان LLM باستخدام منظور الفطرة السليمة أيضًا صحيحًا.

الأخبار: بعد التعافي، يتنقل رئيس الوزراء البريطاني إلى العمل بالدراجة كل يوم، على الرغم من أنه يمتلك سيارة فولكس فاجن مستعملة. لا يُسمح له باستخدام سيارة رسمية للتنقل، ونظرًا لعدم وجود مكان ثابت لوقوف السيارات في مكتب رئيس الوزراء، يختار ركوب الدراجة. يتبعه حارسان في سيارة لكنهما غالبًا ما يتأخران بسبب الازدحام المروري.

سبب LLM (الوصف النصي): أسلوب هذه الرسالة مباشر وواضح، دون تزيين مفرط أو مبالغة. يبدو أن المحتوى الموصوف أيضًا واقعي وموثوق.

سبب LLM (الفطرة السليمة): بالنظر إلى طبيعة وظيفة رئيس الوزراء البريطاني واعتبارات الأمن، فإن الادعاء بأنه يتنقل إلى العمل بالدراجة كل يوم ليس موثوقًا جدًا.

توقع القاعدة: حقيقي توقع LLM TD: حقيقي توقع LLM CS: مزيف توقع ARG: مزيف

الجدول 6: حالات في مجموعة الاختبار حيث كانت واحدة على الأقل في القاعدة و LLM باستخدام التحفيز المحدد للمنظور قد توقعت بشكل صحيح. TD/CS تمثل الوصف النصي/منظور الفطرة السليمة، على التوالي. الأنماط في الأسباب تحتها خط والتوقعات الصحيحة بالخط العريض المائل.

Case 4: Both the Baseline and the LLM using perspective-specific prompting made incorrect predictions, while the

ARG did it correctly.

News: According to Russian media reports, recently, Japan entrusted US military transport planes stationed in Japan to

transport 2,000 test kits donated by our country to Japan. However, during the transportation process, the US suddenly

informed Japan that these test kits had been transported to the US mainland. A US Air Force official later explained that

due to a mistake, these materials were wrongly transported to the US mainland. The Japanese side does not accept the

explanation of the US military official! Do you think the actions of the US military were really due to a mistake?

LLM Rationale (Textual Description): The style of the message is quite compact, with language that is concise and clear.

There are no apparent grammatical or spelling errors, making it consistent with the style of news reporting.

LLM Rationale (Commonsense): Based on common experience and knowledge, it's not uncommon for mistakes to occur

during the transportation of goods. Therefore, it's more likely that the actions of the U.S. military were due to an error

rather than intentional.

Ground Truth: Fake

Baseline Pred.: Real LLM TD Pred.: Real LLM CS Pred.: Real ARG Pred.: Fake

الأخبار: #ShenzhenEpidemic# بدأت منطقة سونغغانغ في شنتشن فرض قيود على الدخول والخروج. يجب على الجميع الانتباه لارتداء الأقنعة بشكل صحيح! احموا أنفسكم! الوباء لم ينته بعد، يجب على الجميع أن يكونوا حذرين للغاية.

سبب LLM (الوصف النصي): تستخدم الرسالة هاشتاج “#ShenzhenEpidemic#”، والذي يتماشى مع الطريقة الشائعة للنشر على وسائل التواصل الاجتماعي. النغمة أيضًا رسمية جدًا، مما يعمل كتذكير للجميع باتخاذ تدابير وقائية ويعبر عن القلق والانتباه تجاه الوضع الوبائي.

سبب LLM (الفطرة السليمة): نظرًا للوضع العالمي الحالي بشأن الوباء، تقوم مناطق مختلفة بتنفيذ تدابير للسيطرة على انتشار الفيروس. لذلك، قد تتبنى شنتشن أيضًا تدابير تحكم مماثلة. بالإضافة إلى ذلك، تذكر الرسالة ارتداء الأقنعة وحماية النفس، وهو ما يتماشى مع التدابير الوقائية خلال الوباء.

Ground Truth: Fake

Baseline Pred.: Real LLM TD Pred.: Real LLM CS Pred.: Real ARG Pred.: Real

(1) التحفيز بدون طلقات

أ: 1

(2) التحفيز بدون طلقات باستخدام CoT

ج: دعنا نفكر خطوة بخطوة. أولاً، تذكر هذه الرسالة أن شيانغ ليو خضع لجراحة وتر، والتي يمكن التحقق منها من خلال قنوات أخرى. ثانياً، تشير الرسالة إلى الكشف عن صور مفصلة، والتي يمكن أيضاً التحقق منها من خلال البحث في التقارير ذات الصلة. أخيراً، تحث الرسالة الناس على إظهار التعاطف وتقديم البركات، وهو ما يتماشى مع الممارسات الشائعة. لذلك، يمكن اعتبار أن هذه الرسالة من المرجح أن تكون معلومات صحيحة، والرد هو 1. لذلك، الجواب (الأرقام العربية) هو 1

(3) Zero-Shot CoT مع تحفيز محدد للمنظور (وصف نصي)

ج: دعنا نفكر من منظور الوصف النصي. تستخدم هذه الرسالة لغة عاطفية لنقل التعاطف والبركات لشيانغ ليو، بينما تشير أيضاً إلى الكشف عن صور مفصلة للجراحة. بالنظر إلى أن مثل هذه الرسالة من المحتمل أن تجذب انتباه الجمهور وتفاعلهم، فمن المرجح أن تكون معلومات صحيحة. ارجع 1.

(4) Zero-Shot CoT مع تحفيز محدد للمنظور (الفطرة السليمة)

ج: دعنا نفكر من منظور الفطرة السليمة. بناءً على المعرفة والخبرة الشائعة، عادةً، لن يتم الكشف عن جراحة حقيقية، حيث أن هذا ينطوي على خصوصية المريض والتزامات السرية للمؤسسات الطبية. لذلك، من المرجح أن تكون هذه الرسالة غير صحيحة. ارجع 0.

(5) تحفيز قليل الطلقات

ج: 1

س: بالنظر إلى الرسالة التالية، توقع صحتها. إذا كانت أكثر احتمالاً أن تكون رسالة حقيقية، ارجع 1؛ وإلا، ارجع 0. يرجى الامتناع عن تقديم تقييمات غامضة مثل غير محدد: أخبار عاجلة: تبرئة تياني لي الناجحة! تم استلام أخبار للتو تفيد بأن مالك بار “rivuai160” في سانليتون قد تم احتجازه من قبل الشرطة. وقد بدأت السلطات تحقيقاً في الدعارة على البار. من المتوقع أن ينتقل تياني لي وخمسة آخرين من كونهم مدعى عليهم إلى شهود، وقد يتم الإفراج عنهم في أقرب وقت هذا الأسبوع!

ج: 0

س: بالنظر إلى الرسالة التالية، توقع صحتها. إذا كانت أكثر احتمالاً أن تكون رسالة حقيقية، ارجع 1؛ وإلا، ارجع 0. يرجى الامتناع عن تقديم تقييمات غامضة مثل غير محدد: تم الكشف عن صور مفصلة لجراحة وتر شيانغ ليو. توقف عن الشكاوى ويرجى إظهار التعاطف والبركات!

(6) تحفيز قليل الطلقات مع CoT

ج: دعنا نفكر خطوة بخطوة. أولاً، مصدر الرسالة هو رابط ويبو، ونحتاج إلى النظر في مصداقية هذا الرابط. ثانياً، يتعلق محتوى الرسالة بإنكار روسيا لنقل الأراضي إلى الصين، ونحتاج إلى تقييم ما إذا كان هذا يتماشى مع الواقع. أخيراً، يجب علينا التحقق مما إذا كانت الرسالة تتماشى مع التقارير من مصادر إعلامية موثوقة أخرى. بناءً على هذا التحليل، من المرجح أن تكون الرسالة معلومات صحيحة. وزارة الخارجية الروسية هي كيان رسمي، مما يمنح بعض المصداقية لإنكارهم. بالإضافة إلى ذلك، تتماشى الرسالة مع الإنكارات من حكومة هانشون، الصين، ووزارة الدفاع الحدودية الروسية. لذلك، ارجع 1. لذلك، الجواب (الرقم العربي) هو: 1.

س: بالنظر إلى الرسالة التالية، توقع صحتها. إذا كانت أكثر احتمالاً أن تكون رسالة حقيقية، ارجع 1؛ وإلا، ارجع 0. يرجى الامتناع عن تقديم تقييمات غامضة مثل غير محدد: أخبار عاجلة: تبرئة تياني لي الناجحة! تم استلام أخبار للتو تفيد بأن مالك بار “rivuai160” في سانليتون قد تم احتجازه من قبل الشرطة. وقد بدأت السلطات تحقيقاً في الدعارة على البار. من المتوقع أن ينتقل تياني لي وخمسة آخرين من كونهم مدعى عليهم إلى شهود، وقد يتم الإفراج عنهم في أقرب وقت هذا الأسبوع!

ج: دعنا نفكر خطوة بخطوة. أولاً، تدعي هذه الرسالة أن تبرئة تياني لي كانت ناجحة، لكنها لا تحدد القضية المعنية وتفتقر إلى أي دليل داعم. لذلك، هذه الجزء غير موثوق. ثانياً، تشير الرسالة إلى أن مالك بار “rivuai160” في سانليتون قد تم احتجازه من قبل الشرطة، وأن السلطات قد بدأت تحقيقاً في الدعارة على البار. قد يكون هذا الجزء صحيحاً، حيث أن التحقيقات الشرطية في المنشآت المشتبه في تورطها في الدعارة ليست غير شائعة. ومع ذلك، لا يمكننا التحقق من مصدر هذه الرسالة وموثوقيتها، لذا فهي ليست موثوقة تمامًا أيضًا. أخيراً، تشير الرسالة إلى أن تياني لي وخمسة آخرين من المتوقع أن ينتقلوا من كونهم مدعى عليهم إلى شهود وقد يتم الإفراج عنهم في أقرب وقت هذا الأسبوع. هذا الجزء أيضًا يفتقر إلى دليل محدد، مما يجعله غير موثوق. في الختام، فإن مصداقية هذه الرسالة منخفضة، ومن المرجح أن تكون غير صحيحة. لذلك، يجب أن تعود 0. وبالتالي، الجواب (الرقم العربي) هو: 0.

س: بالنظر إلى الرسالة التالية، توقع صحتها. إذا كانت أكثر احتمالاً أن تكون رسالة حقيقية، ارجع 1؛ وإلا، ارجع 0. يرجى الامتناع عن تقديم تقييمات غامضة مثل غير محدد: تم الكشف عن صور مفصلة لجراحة وتر شيانغ ليو. توقف عن الشكاوى ويرجى إظهار التعاطف والبركات!

أ: أولاً، تشير هذه الرسالة إلى أن شيانغ ليو خضع لعملية جراحية في الأوتار، وهو ما يمكن التحقق منه من خلال قنوات أخرى. ثانياً، تشير الرسالة إلى تعرض مفصل مفصل للصور، وهو ما يمكن التحقق منه أيضاً من خلال البحث في التقارير ذات الصلة. أخيراً، تحث الرسالة الناس على إظهار التعاطف وتقديم التمنيات، وهو ما يتماشى مع الممارسات الشائعة. لذلك، يمكن اعتبار أن هذه الرسالة من المرجح أن تكون معلومات صحيحة، والرد هو 1.

- *المؤلف المراسل.

- يُقبل على نطاق واسع أن BERT (ديفلين وآخرون، 2019) وعائلة GPT-3 (براون وآخرون، 2020) هما على التوالي صغير وكبير (تشاو وآخرون، 2023).

DOI: https://doi.org/10.1609/aaai.v38i20.30214

Publication Date: 2024-03-24

Bad Actor, Good Advisor: Exploring the Role of Large Language Models in Fake News Detection

Abstract

Detecting fake news requires both a delicate sense of diverse clues and a profound understanding of the real-world background, which remains challenging for detectors based on small language models (SLMs) due to their knowledge and capability limitations. Recent advances in large language models (LLMs) have shown remarkable performance in various tasks, but whether and how LLMs could help with fake news detection remains underexplored. In this paper, we investigate the potential of LLMs in fake news detection. First, we conduct an empirical study and find that a sophisticated LLM such as GPT 3.5 could generally expose fake news and provide desirable multi-perspective rationales but still underperforms the basic SLM, fine-tuned BERT. Our subsequent analysis attributes such a gap to the LLM’s inability to select and integrate rationales properly to conclude. Based on these findings, we propose that current LLMs may not substitute fine-tuned SLMs in fake news detection but can be a good advisor for SLMs by providing multi-perspective instructive rationales. To instantiate this proposal, we design an adaptive rationale guidance network for fake news detection (ARG), in which SLMs selectively acquire insights on news analysis from the LLMs’ rationales. We further derive a rationale-free version of ARG by distillation, namely ARGD, which services cost-sensitive scenarios without querying LLMs. Experiments on two realworld datasets demonstrate that ARG and ARGD outperform three types of baseline methods, including SLM-based, LLM-based, and combinations of small and large language models.

1 Introduction

- Can LLMs help detect fake news with their internal knowledge and capability?

- What solution should we adopt to obtain better performance using LLMs?

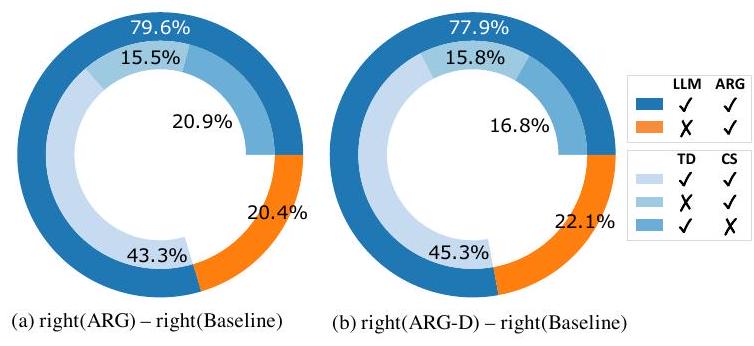

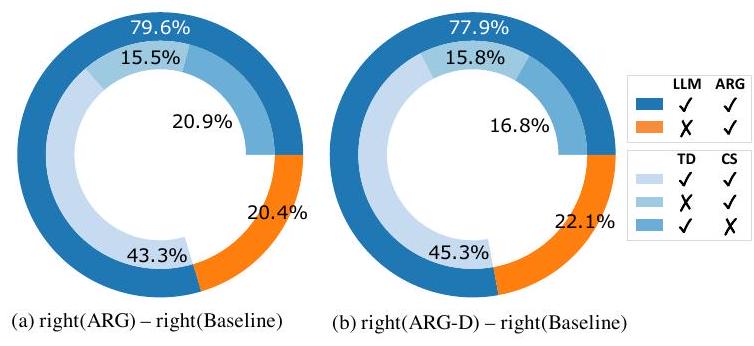

To answer these two questions, we first conduct a deep investigation of the effective role of LLMs in fake news detection and attempt to provide a practical LLM-involved solution. Unlike contemporary works (Pelrine et al., 2023; Caramancion, 2023) which simply prompt LLMs to provide predictions with the task instruction, we conduct a detailed empirical study to mine LLMs’ potential. Specifically, we use four typical prompting approaches (zero-shot/few-shot vanilla/chain-of-thought prompting) to ask the LLM to make veracity judgments of given news items (Figure 1(a)) and find that even the best-performing LLM-based method still underperforms task-specific fine-tuned SLMs. We then perform an analysis of the LLM-generated explanatory rationales and find that the LLM could provide reasonable and informative rationales from several perspectives. By subsequently inducing the LLM with perspective-specific prompts and performing rule-based ensembles of judgments, we find that rationales indeed benefit fake news detection, and attribute the unsatisfying performance to the LLM’s inability to select and integrate rationales properly

|

|

Chinese | English | ||||

| Train | Val | Test | Train | Val | Test | |

| Real | 2,331 | 1,172 | 1,137 | 2,878 | 1,030 | 1,024 |

| Fake | 2,873 | 779 | 814 | 1,006 | 244 | 234 |

| Total | 5,204 | 1,951 | 1,951 | 3,884 | 1,274 | 1,258 |

Based on these findings, we propose that the current LLM may not be a good substitute for the well-fine-tuned SLM but could serve as a good advisor by providing instructive rationales, as presented in Figure 1(b). To instantiate our proposal, we design the adaptive rationale guidance (ARG) network for fake news detection, which bridges the small and large LMs by selectively injecting new insight about news analysis from the large LM’s rationales to the small LM. The ARG further derives the rationale-free ARG-D via distillation for costsensitive scenarios with no need to query LLMs. Experiments on two real-world datasets show that ARG and ARG-D outperform existing SLM/LLMonly and combination methods. Our contributions are as follows:

- Detailed investigation: We investigate the effective role of LLMs in fake news detection and find the LLM is bad at veracity judgment but good at analyzing contents;

- Novel and practical solution: We design a novel ARG network and its distilled version ARG-D that complements small and large LMs by selectively acquiring insights from LLM-generated rationales for SLMs, which has shown superiority based on extensive experiments;

- Useful resource: We construct a rationale collection from GPT-3.5 for fake news detection in two languages (Chinese and English) and will make it publicly available to facilitate further research.

2 Is the LLM a Good Detector?

2.1 Experimental Settings

- Zero-Shot Prompting constructs prompt only containing the task description and the given news. To make the response more proficient and decrease the refusal ratio, we optionally adopt the role-playing technique when describing our task (Liu et al., 2023b; Ramlochan, 2023).

- Zero-Shot CoT Prompting (Kojima et al., 2022) is a simple and straightforward chain-of-thought ( CoT ) prompting approach to en-

| Model | Usage | Chinese | English |

| GPT-3.5- | Zero-Shot | 0.676 | 0.568 |

| Zero-Shot CoT | 0.677 | 0.666 | |

| Few-Shot |

|

0.697 | |

| Few-Shot CoT | 0.681 |

|

|

| BERT | Fine-tuning |

|

|

|

|

|

- Few-Shot Prompting (Brown et al., 2020) provides task-specific prompts and several news-label examples as demonstrations. After preliminary tests of

- Few-Shot CoT Prompting (Wei et al., 2022b) not only provides news-label examples but also demonstrates reasoning steps with previously written rationales. Here, we obtain the provided rationale demonstrations from the correct and reasonable outputs of zero-shot CoT prompting.

2.2 Comparison between Small and Large LMs

| Perspective | Chinese | English | |||||

| Prop. | macF1 | Prop. | macF1 | ||||

| Textual Description | 65% | 0.706 | 71% | 0.653 | |||

|

|||||||

| Commonsense | 71% | 0.698 | 60% | 0.680 | |||

|

|||||||

| Factuality | 17% | 0.629 | 24% | 0.626 | |||

|

|||||||

| Others | 4% | 0.649 | 8% | 0.704 | |||

2) Few-shot versions outperform zero-shot ones, suggesting the importance of task samples. However, introducing several samples only narrow the gap with the SLM but does not lead to surpassing.

3) CoT prompting brings additional performance gain in general, especially under the zero-shot setting on the English dataset (

2.3 Analysis on the Rationales from the LLM

| Model | Usage | Chinese | English |

| GPT-3.5-turbo | Zero-Shot CoT | 0.677 | 0.666 |

| from Perspective TD | 0.667 | 0.611 | |

| from Perspective CS | 0.678 | 0.698 | |

| BERT | Fine-tuning | 0.753 | 0.765 |

| Ensemble | Majority Voting | 0.735 | 0.724 |

| Oracle Voting | 0.908 | 0.878 |

3 ARG: Adaptive Rationale Guidance Network for Fake News Detection

3.1 Representation

resentations. For the given news item

3.2 News-Rationale Collaboration

3.2.1 News-Rationale Interaction

3.2.2 LLM Judgement Prediction

3.2.3 Rationale Usefulness Evaluation

3.3 Prediction

| Model | Chinese | English | |||||||

| macF1 | Acc. |

|

|

macF1 | Acc. |

|

|

||

| G1: LLM-Only GPT-3.5-turbo | 0.725 | 0.734 | 0.774 | 0.676 | 0.702 | 0.813 | 0.884 | 0.519 | |

| G2: SLM-Only | Baseline | 0.753 | 0.754 | 0.769 | 0.737 | 0.765 | 0.862 | 0.916 | 0.615 |

| EANN

|

0.754 | 0.756 | 0.773 | 0.736 | 0.763 | 0.864 | 0.918 | 0.608 | |

| Publisher-Emo | 0.761 | 0.763 | 0.784 | 0.738 | 0.766 | 0.868 | 0.920 | 0.611 | |

| ENDEF | 0.765 | 0.766 | 0.779 | 0.751 | 0.768 | 0.865 | 0.918 | 0.618 | |

| G3: LLM+SLM | Baseline + Rationale | 0.767 | 0.769 | 0.787 | 0.748 | 0.777 | 0.870 | 0.921 | 0.633 |

| SuperICL | 0.757 | 0.759 | 0.779 | 0.734 | 0.736 | 0.864 | 0.920 | 0.551 | |

| ARG | 0.784 | 0.786 | 0.804 | 0.764 | 0.790 |

|

0.926 | 0.653 | |

| (Relative Impr. over Baseline) |

|

||||||||

| w/o LLM Judgment Predictor | 0.773 | 0.774 | 0.789 | 0.756 |

|

0.880 | 0.928 | 0.645 | |

| w/o Rationale Usefulness Evaluator |

|

0.783 | 0.801 | 0.761 | 0.782 | 0.873 | 0.923 | 0.641 | |

| w/o Predictor & Evaluator | 0.769 | 0.770 | 0.782 | 0.756 | 0.780 | 0.874 | 0.923 | 0.637 | |

| ARG-D |

|

||||||||

3.4 Distillation for Rationale-Free Model

4 Evaluation

4.1 Experimental Settings

G2 (SLM-Only)

G3 (LLM+SLM): 1) Baseline+Rationale: It concatenates features from the news encoder and rationale encoder and feeds them into an MLP for prediction. 2) SuperICL (Xu et al., 2023): It exploits the SLM as a plug-in for the in-context learning of the LLM by injecting the prediction and the confidence for each testing sample into the prompt.

4.2 Performance Comparison and Ablation Study

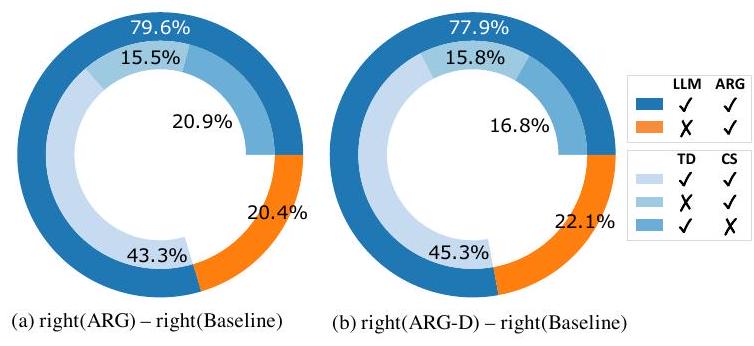

4.3 Result Analysis

4.4 Cost Analysis in Practice

5 Related Work

the given content, including text (Przybyla, 2020) and images (Qi et al., 2021) and may require extra assistance from knowledge bases (Popat et al., 2018) and news environments (Sheng et al., 2022). Both two groups of methods obtain textual representation from pre-trained models like BERT as a convention but rarely consider its potential for fake news detection. We conducted an exploration in this paper by combining large and small LMs and obtained good improvement only using textual content.

LLMs for Natural Language Understanding

6 Conclusion and Discussion

good to learn” from worse ones. We expect our solution to be extended to other tasks and foster more effective and cost-friendly use of LLMs in the future.

Acknowledgements

References

A Case Analysis

failed to provide accurate prediction, which surpasses our expectations. After conducting a comparative analysis, we found that within the training set, the use of phrases like “compact writing style” in textual description rationales often leads to incorrect judgments. We hypothesize that guided by the signals provided by the rationale usefulness evaluator, ARG recognized that pattern and was able to make judgments contrary to erroneous rationales and chose the correct prediction. While in Case 5, ARG was unable to invert the erroneous judgment as in Case 4. We speculate that this is due to the absence of a pattern as clear as that in Case 4. Constrained by the natural language understanding performance of the BERT-base model, ARG struggled to capture more complex logical relationships.

B Prompting Examples

News: Wow! A robot in Russia was captured heroically saving a playful little girl from being crushed by a shelf This act went viral online, showing the robot’s strength, amazing!

LLM Rationale (Textual Description): This message uses exaggerated, emotive language, while providing no credible sources or evidence.

LLM Rationale (Commonsense): Based on common knowledge and experience, robots have not yet reached a level where they can act autonomously and save human lives.

Baseline Pred.: Real LLM TD Pred.: Fake LLM CS Pred.: Fake ARG Pred.: Real

Case 2: The Baseline predicted incorrectly, the ARG did correctly, and the LLM using textual description perspective also did correctly.

News: #NingboRevelation# [Ningbo Xiangshan Fishermen Catch a Strange Fish, Dubbed the ‘Panda of the Water’]#NingboFreshNews# Around 7:00 PM on March 2nd, the ZXY02206 vessel, at the coordinates of

LLM Rationale (Textual Description): This message uses a more formal language and provides specific details about the time, location, and species of the fish caught, including its size. It also mentions that the information has been verified.

LLM Rationale (Commonsense): Based on common knowledge and experience, the Chinese sturgeon is a critically endangered and rare species, making it unlikely to be commonly caught by ordinary fishermen.

Baseline Pred. : Fake LLM TD Pred. : Real LLM CS Pred. : Fake ARG Pred. : Real

Case 3: The Baseline predicted incorrectly, the ARG did correctly, and the LLM using commonsense perspective also did correctly.

News: After recovery, the British Prime Minister commutes to work by bicycle every day, though he owns a second-hand Volkswagen. He is not allowed to use an official car for commuting, and since there’s no fixed parking spot at the Prime Minister’s Office, he opts for cycling. Two bodyguards follow him in a car but often fall behind due to traffic congestion.

LLM Rationale (Textual Description): The style of this message is straightforward and clear, without excessive embellishment or exaggeration. The content described also appears to be realistic and credible.

LLM Rationale (Commonsense): Considering the nature of the British Prime Minister’s job and security considerations, the claim that he commutes to work by bicycle every day is not very credible.

Baseline Pred. : Real LLM TD Pred. : Real LLM CS Pred. : Fake ARG Pred. : Fake

Table 6: Cases in the testing set where at least one in the Baseline and the LLM using perspective-specific prompting predicted correctly. TD/CS represents textual description/commonsense perspective, respectively. Patterns in rationales are underlined and correct predictions are in bold italics.

Case 4: Both the Baseline and the LLM using perspective-specific prompting made incorrect predictions, while the

ARG did it correctly.

News: According to Russian media reports, recently, Japan entrusted US military transport planes stationed in Japan to

transport 2,000 test kits donated by our country to Japan. However, during the transportation process, the US suddenly

informed Japan that these test kits had been transported to the US mainland. A US Air Force official later explained that

due to a mistake, these materials were wrongly transported to the US mainland. The Japanese side does not accept the

explanation of the US military official! Do you think the actions of the US military were really due to a mistake?

LLM Rationale (Textual Description): The style of the message is quite compact, with language that is concise and clear.

There are no apparent grammatical or spelling errors, making it consistent with the style of news reporting.

LLM Rationale (Commonsense): Based on common experience and knowledge, it's not uncommon for mistakes to occur

during the transportation of goods. Therefore, it's more likely that the actions of the U.S. military were due to an error

rather than intentional.

Ground Truth: Fake

Baseline Pred.: Real LLM TD Pred.: Real LLM CS Pred.: Real ARG Pred.: Fake

News: #ShenzhenEpidemic# Shenzhen’s Sungang area has started entry and exit controls. Everyone should pay attention to wearing masks properly! Protect yourselves! The epidemic is not over yet, everyone should be extra careful.

LLM Rationale (Textual Description): The message utilizes a hashtag “#ShenzhenEpidemic#”, which aligns with the common method of posting on social media. The tone is also quite formal, serving as a reminder for everyone to take protective measures and expressing concern and attention towards the epidemic situation.

LLM Rationale (Commonsense): Given the current global situation regarding the pandemic, various regions are implementing measures to control the spread of the virus. Therefore, Shenzhen may also adopt similar control measures. Additionally, the message mentions wearing masks and protecting oneself, which is in line with protective measures during the pandemic.

Ground Truth: Fake

Baseline Pred.: Real LLM TD Pred.: Real LLM CS Pred.: Real ARG Pred.: Real

(1) Zero-Shot Prompting

A: 1

(2) Zero-Shot CoT Prompting

A: Let’s think step by step. Firstly, this message mentions that Xiang Liu underwent tendon surgery, which can be verified through other channels. Secondly, the message refers to detailed photo exposure, which can also be verified by searching related reports. Lastly, the message urges people to show sympathy and offer blessings, which aligns with common practices. Therefore, it can be considered that this message is more likely to be true information, and the response is 1 . Therefore, the answer (arabic numerals) is 1

(3) Zero-Shot CoT with Perspective Specific Prompting (Textual Description)

A: Let’s think from the perspective of textual description. This message employs emotional language to convey sympathy and blessings for Xiang Liu, while also mentioning the detailed photo exposure of the surgery. Considering that such a message is likely to attract public attention and resonance, it is more likely to be true information. Return 1.

(4) Zero-Shot CoT with Perspective Specific Prompting (Commonsense)

A: Let’s think from the perspective of commonsense. Based on common knowledge and experience, usually, real surgery will not be exposed, as this involves patient privacy and medical institutions’ confidentiality obligations. Therefore, this message is more likely to be false. Return 0.

(5) Few-Shot Prompting

A: 1

Q: Given the following message, predict its veracity. If it is more likely to be a real message, return 1; otherwise, return 0. Please refrain from providing ambiguous assessments such as undetermined: Breaking News: Tianyi Li’s successful exoneration! Just received news that the owner of the “rivuai160” bar in Sanlitun has been taken into custody by the police. The authorities have initiated a prostitution investigation on the bar. Tianyi Li and five others are expected to shift from being defendants to witnesses, potentially being released as soon as this weekend!

A: 0

Q: Given the following message, predict its veracity. If it is more likely to be a real message, return 1 ; otherwise, return 0 . Please refrain from providing ambiguous assessments such as undetermined: Detailed photos of Xiang Liu’s tendon surgery exposed. Stop complaints and please show sympathy and blessings!

(6) Few-Shot CoT Prompting

A: Let’s think step by step. Firstly, the source of the message is a Weibo link, and we need to consider the credibility of this link. Secondly, the content of the message pertains to a Russian denial of transferring land to China, and we need to assess if this aligns with reality. Lastly, we should check if the message aligns with reports from other reliable media sources. Based on this analysis, the message is more likely to be true information. The Russian Ministry of Foreign Affairs is an official entity, lending some credibility to their denial. Additionally, the message is consistent with the denials from the government of Hunchun, China, and the Russian border defense department. Therefore, return 1. Therefore, the answer (arabic numeral) is: 1 .

Q: Given the following message, predict its veracity. If it is more likely to be a real message, return 1; otherwise, return 0. Please refrain from providing ambiguous assessments such as undetermined: Breaking News: Tianyi Li’s successful exoneration! Just received news that the owner of the “rivuai160” bar in Sanlitun has been taken into custody by the police. The authorities have initiated a prostitution investigation on the bar. Tianyi Li and five others are expected to shift from being defendants to witnesses, potentially being released as soon as this weekend!

A: Let’s think step by step. Firstly, this message claims that Tianyi Li’s exoneration was successful, but it doesn’t specify the case in question and lacks any supporting evidence. Therefore, this part is unreliable. Secondly, the message states that the owner of the “rivuai160” bar in Sanlitun has been taken into custody by the police, and the authorities have initiated a prostitution investigation on the bar. This part could be true, as police investigations into establishments suspected of involvement in prostitution are not uncommon. However, we cannot verify the source and authenticity of this message, so it’s not entirely trustworthy either. Lastly, the message suggests that Li Tianyi and five others are expected to shift from being defendants to witnesses and could be released as soon as this weekend. This part also lacks specific evidence, thus making it unreliable. In conclusion, the credibility of this message is low, and it’s more likely to be untrue. Therefore, it should return 0. Hence, the answer (Arabic numeral) is: 0.

Q: Given the following message, predict its veracity. If it is more likely to be a real message, return 1; otherwise, return 0 . Please refrain from providing ambiguous assessments such as undetermined: Detailed photos of Xiang Liu’s tendon surgery exposed. Stop complaints and please show sympathy and blessings!

A: Firstly, this message mentions that Xiang Liu underwent tendon surgery, which can be verified through other channels. Secondly, the message refers to detailed photo exposure, which can also be verified by searching related reports. Lastly, the message urges people to show sympathy and offer blessings, which aligns with common practices. Therefore, it can be considered that this message is more likely to be true information, and the response is 1 .

- *Corresponding author.

- is widely accepted that BERT (Devlin et al., 2019) and GPT-3 family (Brown et al., 2020) are respectively small and large ones (Zhao et al., 2023).