DOI: https://doi.org/10.1007/s40979-024-00149-4

تاريخ النشر: 2024-02-08

وجهات نظر الطلاب حول استخدام تقنيات الذكاء الاصطناعي التوليدي في التعليم العالي

bparsons@liverpool.ac.uk

الملخص

كان الهدف من هذا المشروع هو فهم وجهات نظر الطلاب حول تقنيات الذكاء الاصطناعي التوليدي (GAI) مثل Chat generative Pre-Trained Transformer (ChatGPT)، من أجل إبلاغ التغييرات على مدونة الممارسات الأكاديمية لجامعة ليفربول. تم إنشاء الاستبيان لهذه الدراسة بواسطة فريق من طلاب المكتبة وتمت مراجعته من خلال مجموعات التركيز. شارك ما مجموعه 2555 طالبًا في الاستبيان. أظهرت النتائج أن 7% فقط من الطلاب الذين استجابوا لم يسمعوا عن أي تقنيات GAI، بينما استخدم أكثر من نصفهم أو فكروا في استخدام هذه التقنيات لأغراض أكاديمية. كان معظم الطلاب (54.1%) داعمين أو داعمين إلى حد ما لاستخدام أدوات مثل Grammarly، لكن 70.4% كانوا غير داعمين أو غير داعمين إلى حد ما تجاه استخدام الطلاب لأدوات مثل ChatGPT لكتابة مقالاتهم بالكامل. كان الطلاب الذين لديهم مستويات أعلى من الثقة في كتابتهم الأكاديمية أقل احتمالًا لاستخدامها أو التفكير في استخدامها لأغراض أكاديمية، وكانوا أيضًا أقل احتمالًا لدعم استخدام الطلاب الآخرين لها. كما اعتقد معظم الطلاب (41.1%) أنه يجب أن تكون هناك سياسة شاملة على مستوى الجامعة بشأن متى تكون هذه التقنيات مناسبة أو غير مناسبة للاستخدام. تشير نتائج هذا البحث إلى أن الطلاب يحتاجون إلى سياسات واضحة بشأن استخدام GAI وأنه يجب عدم حظر هذه التقنيات من الجامعة، ولكن يجب مراعاة ضمان وصول مجموعات مختلفة من الطلاب إلى هذه التقنيات بشكل متساوٍ.

مقدمة

من أجل اتباع نهج يركز على الطالب في هذه السياسة، تم إطلاق مشروع لجمع آراء الطلاب حول هذه التقنيات. كان الهدف هو فهم كيف يستخدم الطلاب هذه التقنيات حاليًا، وما إذا كانت ثقتهم في الكتابة قد تأثرت.

تأثير ذلك على استخدامهم أو آرائهم حول التقنيات، وكيف يعتقدون أن الجامعة يجب أن تستجيب لها فيما يتعلق بالعمل الأكاديمي.

مراجعة الأدبيات

وجد الطلاب أن الواجبات مملة ومتعبة، وأصبحوا محبطين من الجهد المطلوب لإكمالها. تلا ذلك ما يسمى بـ “القدرة الأكاديمية”، حيث كان الطلاب يعانون من مستوى الصعوبة أو المهارات اللازمة لإكمال المهمة. شملت الأسباب الأخرى نقص الانضباط الذاتي والدافع، والمشاكل الشخصية/الطبية، والصعوبة في التوازن مع أولويات أخرى مثل العمل أو الأسرة. بشكل عام، استنتجوا أن الطلاب الذين استخدموا خدمات استئجار الواجبات عادة ما وصلوا إلى نقطة اعتبروا فيها أن “الفوائد المحتملة للغش تفوق التكاليف” (ص. 104). وجد بريمبل (2016، ص. 378) أسبابًا مشابهة، وأشار أيضًا إلى أن السلوك غير النزيه أصبح بشكل متزايد “القاعدة” ويُنظر إليه تقريبًا على أنه ضروري لمواكبة الأقران. وجد بريتاج وآخرون (2018) أن الغش عن طريق العقود كان الأكثر انتشارًا بين الطلاب الأصغر سنًا، والذين لم تكن الإنجليزية لغتهم الأم، والذين كانوا غير راضين عن التعليم والتعلم المقدم في دورتهم.

طرق البحث

النتائج

مجموعة التركيز

الاستبيان عبر الإنترنت

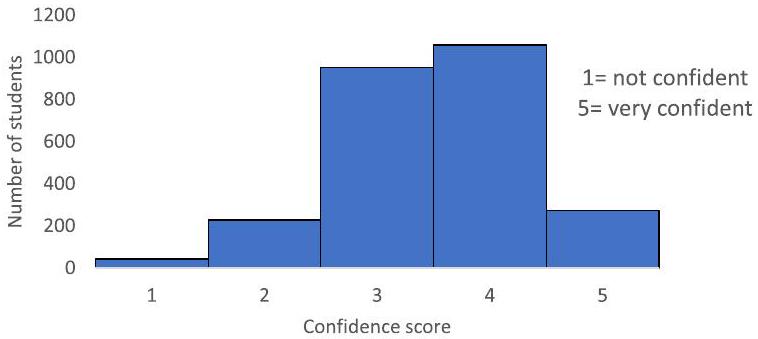

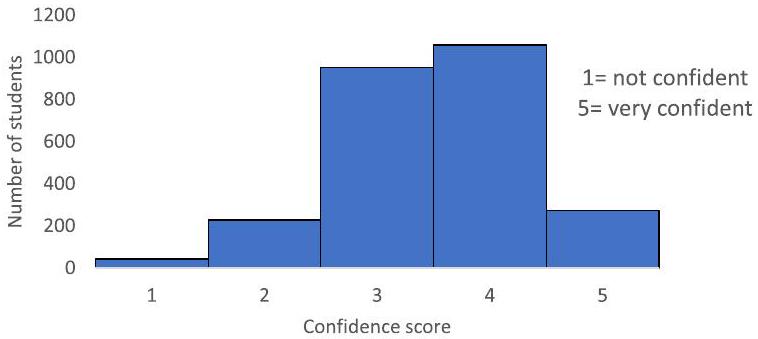

الثقة في الكتابة الأكاديمية

| مستوى الدراسة | % من المستجيبين | % من عدد سكان الجامعة |

| أساس | 0.7% | 1.2٪ |

| طالب جامعي | 69.7% | 76.4% |

| دراسات عليا مُعَلَّمة | 22.7% | 15.70% |

| دراسات عليا بحثية | 6.5% | 6.7% |

| العلوم الإنسانية والاجتماعية | الصحة وعلوم الحياة | العلوم والهندسة | |

| 1 | 1.6% | 2.0% | 1.6٪ |

| ٢ | 6.4% | 11.3% | 9.4% |

| ٣ | ٣٥.٨٪ | ٤٠٫٠٪ | ٣٥.٩٪ |

| ٤ | ٤٥.٣٪ | ٣٨٫٠٪ | ٤٠.٢٪ |

| ٥ | 10.9٪ | 8.7% | 12.8% |

| أساس | طالب جامعي | دراسات عليا موجهة | البحث الدراسي العالي | |

| 1 | ٥.٩٪ | 1.8٪ | 1.4% | 0.6% |

| ٢ | ٥.٩٪ | 10.3% | 5.5% | ٦٫٠٪ |

| ٣ | ٣٥.٣٪ | ٣٩.٨٪ | 33.4% | ٢٤٫٠٪ |

| ٤ | ٤٧.١٪ | ٤٠.١٪ | ٤٣.٣٪ | 51.5% |

| ٥ | ٥.٩٪ | ٧.٩٪ | 16.4% | 18.0% |

معرفة الطلاب بتقنيات الذكاء الاصطناعي العام

استخدام الطلاب أو الاستخدام المعتبر لتقنيات الذكاء الاصطناعي العام

لقد استخدمت ChatGPT لتبادل الأفكار وللمساعدة في هيكلة العمل. لن أستخدمه لكتابة أي شيء، لن أثق به في الحصول على معلومات صحيحة.

ومن المعروف أنه يقدم اقتباسات ومراجع غير موجودة. أنا مهتم بتجربته في تدقيق العمل، ويبدو أنه يمكن استخدامه لتلخيص المقالات، وما إلى ذلك. أعتقد أنه يمكن استخدامه بطرق مفيدة كثيرة، ولكن ليس للكتابة الأكاديمية… بعد!

الحصول على معرفة أساسية لمزيد من المعرفة حول ما يجب البحث عنه عند العثور على مراجع للأوراق. أشعر أحيانًا أن المنشورات يمكن أن تكون معقدة بعض الشيء، لذا فإن الحصول على إجابة بسيطة لسؤال ما يكون مفيدًا لفهمي.

لقد أعجبتني فكرة Grammarly خلال مرحلة A levels لأنها ساعدتني في مهارات الكتابة والمفردات. لكنني لم أستخدمها بشكل صحيح لأنها كانت اشتراكًا مدفوعًا.

الاستخدام اليومي، الإجابة على الأسئلة اليومية، وضع خطة التمارين، نصائح صحية، نصائح للصحة النفسية، إلخ…

جرامرلي يساعدني في اكتشاف نسبة الانتحال قبل تقديم عملي

كان هناك ميل لدى طلاب العلوم الصحية والحياتية لاستخدام هذه التقنيات أو التفكير في استخدامها أقل لأغراض شخصية ومهنية مقارنة بكليات أخرى، لكن الاستخدام الأكاديمي كان مشابهًا عبر الكليات الثلاث، ولم يبدو أن طريقة استخدام الطلاب أو تفكيرهم في استخدام التقنيات تأثرت بمستوى الدراسة. أظهر طلاب السنة التأسيسية، الذين يتكون العديد منهم من طلاب ناضجين يعودون إلى التعليم، استخدامًا/تفكيرًا أقل بشكل طفيف، ومع ذلك كان هناك 17 مستجيبًا فقط في هذه الفئة.

الثقة في الكتابة الأكاديمية واستخدام تقنيات الذكاء الاصطناعي العام

آراء الطلاب حول استخدام طلاب آخرين لتقنيات الذكاء الاصطناعي

| درجة الثقة

|

الاستخدام الشخصي | الاستخدام الأكاديمي | استخدام مهني | لم يُستخدم أبدًا | ||||

| % لا | % نعم | % لا | % نعم | % لا | % نعم | % المستخدم/المعتبر | % لم يُستخدم أبداً | |

| 1 | 65% | ٣٥٪ | 60٪ | 40٪ | 84% | 16% | 67% | ٣٣٪ |

| 2 | 69% | 31% | ٤٣٪ | 57% | ٤٣٪ | 57% | 69% | 31% |

| ٣ | 72% | ٢٨٪ | ٤٦٪ | 54% | ٤٦٪ | 54% | 67% | ٣٣٪ |

| ٤ | 69% | 31٪ | 51% | ٤٩٪ | 51% | ٤٩٪ | 62% | ٣٨٪ |

| ٥ | 70٪ | 30٪ | 54% | ٤٦٪ | 54% | ٤٦٪ | 63% | ٣٧٪ |

| بيان | % من المستجيبين الذين اختاروا هذا |

| داعم – أعتقد أنه في عام 2023 يجب علينا جميعًا استخدام تقنيات الذكاء الاصطناعي لجعل حياتنا أسهل | ٢٧.٢٪ |

| داعم إلى حد ما – أنا موافق على استخدام الطلاب الآخرين للبرامج إذا أشاروا إلى التكنولوجيا في أعمالهم | ٢٦.٣٪ |

| محايد – ليس لدي رأي حقيقي في هذا. أعتقد أن الأمر متروك للطالب الفردي ليقرر استخدامه أو عدم استخدامه. | ٢٦.٢٪ |

| غير داعم إلى حد ما – أعتقد أن هذه التقنيات لا تزال لديها الكثير من القيود وأشجع الطلاب الآخرين على التحقق من المعلومات التي يجدونها. | 11.6% |

| غير داعم – أعتقد أنه من غير العادل حقًا أن يستخدم الطلاب الآخرون هذه التقنيات. الأشخاص الذين يستخدمون هذه التقنيات يقومون فعليًا بنسخ أعمال الآخرين دون إعطاء الفضل الكامل. | ٧.٤٪ |

| آخر | 1.3% |

أعتقد أنه يجب اعتبار هذه التقنيات لما هي عليه حقًا، نماذج لغوية. كل ما تفعله هو تقديم بيانات محددة من معلمات مدخلة من المستخدم، يجب أن تكون جميع المعلومات المقدمة من النموذج قد وُجدت سابقًا، أو تم استنتاجها من بيانات موجودة مسبقًا. لذلك، يجب استخدام هذه التقنيات تمامًا كما هو مصمم لها، لتعمل كأداة بحث للمساعدة ولكن دون انتحال. تشير الإشعارات المقدمة داخل البرنامج إلى أنه يمكن تقديم معلومات خاطئة في بعض الأحيان، وأشعر أنه بينما يعد هذا جزئيًا قيدًا للتكنولوجيا، فإنه يعد إهمالًا بالكامل من قبل الطلاب إذا تم استخدام هذه المعلومات.

“إنه مفيد كوسيلة مساعدة لأولئك الذين قد يكون لديهم إعاقات أو احتياجات تعلم إضافية وسأكون داعمًا لذلك، ولكن بالنسبة للطلاب القادرين أشعر أن التطبيقات أو التقنيات المساعدة تعطي ميزة غير عادلة لأي شيء يتجاوز مجرد التحقق من القواعد النحوية، الإملاء، إلخ. “

“يعتمد الأمر، أعتقد أنه من الجيد استخدام التحقق من القواعد النحوية، خاصة للناطقين غير الأصليين. لديهم فكرتهم الخاصة، وهذه الأنواع من الذكاء الاصطناعي مثل بعض القواميس المتقدمة لمساعدتهم في التعبير عن أفكارهم بشكل أفضل. ولكن بالنسبة للتكنولوجيا المساعدة مثل ChatGPT، يجب أن تكون هناك سياسة لتجنب الاستخدام غير السليم. “

“أعتقد أن طلاب الجامعات يجب أن يتعلموا عن أحدث سلسلة من الذكاء الاصطناعي لأنها ستصبح جزءًا كبيرًا من حياتنا بغض النظر عن التخصص وفي غضون 10-15 عامًاأعتقد حتى تصبح جزءًا من جميع مستويات التعليم وإذا لم نتعلم كيفية استخدامها بفعالية فسوف نتخلف عن الأجيال القادمة. يمكن لطلاب الجامعات بالفعل استخدامها لكتابة مقال لهم في دقائق دون التعلم عنها لذلك أعتقد أن الجامعات يجب أن تغير أنواع التقييم وتحتضن التكنولوجيا حيث من المفترض أن تكون الجامعات تعدنا للمستقبل. “

“إنه يؤثر على الاقتصاد المستقبلي عندما ينتهي الأمر بأشخاص لا يستحقون شهادتهم

في مهنة لا يمكنهم فهمها بدون الذكاء الاصطناعي. علاوة على ذلك، يمكن أن يكون هناك شخص أكثر استحقاقًا لتلك الوظيفة، الذكاء الاصطناعي يخفي الذكاء الحقيقي. “

“لا أعتقد أنني سأقلق بشأن أي عمل دراسي لأي شخص سوى عملي! “

السؤال التالي سأل المستجيبين كيف سيشعرون إذا كان طالب آخر قد استخدم تقنية GAI مثل ChatGPT لكتابة مقالهم بالكامل. طُلب من المستجيبين اختيار البيان الذي يتوافق بشكل أقرب مع وجهة نظرهم. معظم الطلاب (

كمساعد، إنه مفيد، ولكن كتابة مقالهم بالكامل تأخذ من نزاهة وفخر عملهم

“سأدعم ذلك إذا استخدمه شخص ما للتحقق من القواعد النحوية أو الترجمة إذا لم تكن الإنجليزية لغتهم الأولى، ولكن ليس لكتابة مستند كامل. من المحتمل أن يتم إساءة استخدام ذلك من قبل الكثير من الطلاب، مما سيجعل التقييم غير عادل لأولئك الذين لا يفعلون ذلك. “

“أعتقد أن استخدامه للتحقق من المعلومات، والمساعدة في القواعد النحوية والبحث عن الأشياء أمر جيد. ولكن ليس مقالك إذا كتبه الذكاء الاصطناعي لك. أكره كتابة المقالات وأعاني منها، لكن لا يزال يتعين عليك القيام بها”

بشكل عام غير داعمين، حيث سيفقدون تجربة كتابة مقال والتعلم المكتسب منها. على الرغم من أنني أشعر أن تقييمات الجامعة تحتاج إلى التكيف لأخذ وجود المساعدة من الذكاء الاصطناعي في الاعتبار.

“غير داعم لذلك لأنني أعتقد أنه غير عادل عدم التوصل إلى أفكار بمفردك والاعتماد على الذكاء الاصطناعي لنقل أفكارك. من المهم أن تكون قادرًا على صياغة

| البيان | % من المستجيبين الذين اختاروا هذا |

| داعم – أعتقد أنه في عام 2023 يجب علينا جميعًا استخدام تقنيات الذكاء الاصطناعي لتسهيل حياتنا | 5.6% |

| داعم إلى حد ما – أنا بخير مع استخدام طلاب آخرين للبرامج إذا أعطوا الفضل للتكنولوجيا في عملهم | 8.2% |

| محايد – ليس لدي رأي حقيقي في هذا. أعتقد أنه يعود للطالب الفردي ليقرر استخدامه/عدم استخدامه | 14.2% |

| غير داعم إلى حد ما – أعتقد أن هذه التقنيات لا تزال لديها الكثير من القيود وسأشجع الطلاب الآخرين على التحقق من المعلومات التي يجدونها | 21.9% |

| غير داعم – أعتقد أنه من غير العادل حقًا للطلاب الآخرين استخدام هذه التقنيات. الأشخاص الذين يستخدمون هذه التقنيات يقومون فعليًا بنسخ عمل الآخرين دون إعطاء الفضل الكامل | 48.5% |

| أخرى | 1.6% |

“غير داعم – الذكاء الاصطناعي محدود بالبيانات التي تم تصميمه عليها. لا يمكن اعتبار أي إجابات يقدمها كمعرفة خبير، ولكن فقط كانعكاس للمعلومات التي تم تغذيتها إليه. “

“…أعتقد أن الأمر يعتمد على مدى أصالة المدخلات (يميل ChatGPT إلى العمل من مطالبات تعليمية قصيرة جدًا). سواء كان ‘غير عادل’ هو مناقشة مختلفة – تميل هذه المقالات التي تم إنشاؤها بواسطة الذكاء الاصطناعي إلى أن تكون متكررة للغاية وغير متماسكة. القليل منها قريب من أن يكون مقبولًا، وتلك التي تكون كذلك لا تتجاوز أبدًا 50%. إذا بدأنا نرى الكثير من هذه المقالات تُقدم، فإنها سترفع بشكل مصطنع النسبة المئوية التي تم تقييم الطلاب الذين قدموا ‘عملًا حقيقيًا’ فيها، إن كان هناك شيء. “

“أعتقد أنه سيكون من الواضح معرفة ما إذا كان مقال مكتوب بالكامل بواسطة الذكاء الاصطناعي، لذا ربما لن تحصل على علامة جيدة. “

“لا داعم ولا غير داعم. أعتقد أن استخدام مثل هذه التكنولوجيا مثل ChatGPT يختلف عن استخدام الآخرين مثل Grammerly. يقوم ChatGPT بالعمل نيابة عنك. هذا يأخذ من الفرد اكتساب المهارات اللازمة التي يجب عليهم بناؤها وتطويرها شخصيًا خلال دراستهم. أشعر أنه لا يرفع من مستوى الفرد، حيث توفر التقنيات الأخرى مثل هذه الفرص. “

“لا أمانع من استخدام الآخرين لها ولكنني أفضل توجيهًا واضحًا من الجامعة حول ما إذا كان يمكننا استخدامها أم لا حتى يشعر الجميع بالحرية في استخدامها أيضًا. “

“أنا داعم تمامًا، لأنه عندما نصل إلى التفرد في الحوسبة، هل يجب علينا منع استخدام التقنيات لأنها تجعل حياتنا أسهل؟ هل يجب علينا حظر الآلات الحاسبة عندما تكون آلة تقوم فعليًا بكل العمل الرياضي؟ لا أعتقد أنه يجب استخدام ChatGPT بدون تمييز، ولكن لا يوجد سبب يمنع شخصًا ما من طلبه لكتابة مقال طالما أن الطالب يراجع المقال بشكل نقدي لتعديلاته ومدخلاته. “

“أعتقد أنه إذا تم استخدامه بطريقة صادقة، يمكن أن يكون مفيدًا جدًا لفهمه وكوسيلة مساعدة في كتابة المقالات/الأوراق/إلخ. ما لا أوافق عليه هو استخدامه فقط لنسخ المعلومات مباشرة. المعلومات المضللة شائعة والتحقق من الحقائق مهم. لذا، من المهم الاستمرار في تشجيع ذلك عند استخدام هذه البرمجيات. الاعتماد على هذا النوع من البرمجيات سيضر فقط بالفرد وأعتقد أنه مصدر قلق حقيقي مع تحسين هذه الأنواع من البرمجيات. “

“يعتمد الأمر، بعض الطلاب بسبب الإعاقة يحتاجون إلى الذكاء الاصطناعي للمساعدة. إذا كان متاحًا لي ولم أستخدمه، فسيكون ذلك اختياري”

الثقة في الكتابة الأكاديمية وآراء حول استخدام الآخرين لتقنيات GAI

القواعد النحوية

آراء الطلاب حول سياسات الجامعة لتقنيات GAI

“تثقيف الناس حول كيفية استخدام أدوات الذكاء الاصطناعي بطرق أخرى غير الغش البسيط، على سبيل المثال لتحسين المراجعة، تسريع عملية الكتابة، أو المساعدة في

| درجة الثقة | داعم | داعم إلى حد ما | محايد | غير داعم إلى حد ما | غير داعم | آخر |

| 1.00 | 27.9% | 27.9% | 30.2% | 9.3% | 2.3% | ٢.٣٪ |

| 2.00 | 31.1% | 25.9٪ | ٢٦.٣٪ | 10.1٪ | 5.7% | 0.9% |

| ٣.٠٠ | 27.9% | 25.1% | ٢٨.٢٪ | 10.9٪ | 6.8% | 1.1% |

| ٤.٠٠ | ٢٥.٤٪ | ٢٩.١٪ | ٢٤.٨٪ | 11.7% | ٧.٥٪ | 1.5% |

| ٥.٠٠ | ٢٨.٢٪ | 19.4% | ٢٤.٢٪ | 15.0% | 11.7% | 1.5% |

| درجة الثقة | داعم | داعم إلى حد ما | محايد | غير داعم إلى حد ما | غير داعم | آخر |

| 1.00 | 14% | 18.6% | 27.9% | 9.3% | 30.2% | 0% |

| 2.00 | 8.3٪ | 9.2% | 13.2% | 25% | ٤١.٧٪ | 2.6% |

| ٣.٠٠ | ٥.٤٪ | ٨.٦٪ | 16.5% | ٢٣.٢٪ | 44.9% | 1.5% |

| ٤.٠٠ | ٤.٥٪ | ٧.٦٪ | 12.5% | 22% | 52.2% | 1.1% |

| ٥.٠٠ | ٧٪ | 6.2% | 11.7% | 16.5% | 55.7% | 2.9% |

| استجابة | % من المستجيبين الذين اختاروا هذا |

| حظرهم تمامًا | ٤.٥٪ |

| وجود سياسة شاملة على مستوى الجامعة حول متى يكون من المناسب استخدامها أو لا. | 41.1% |

| دع الأقسام / الكليات تقرر السياسة بشأن متى يكون من المناسب استخدامها أو لا. | ٢٦٫٠٪ |

| دع المحاضرين يحددون السياسات الفردية للمهام الفردية بشأن متى يكون من المناسب استخدامها أو عدم استخدامها. | 16.9% |

| اسمح لهم أن يُستخدموا كما يشاء الطلاب | 9.6% |

| آخر | 1.8% |

أعتقد أن هذه التقنيات تحتاج إلى أن تُحتضن في بيئة أكاديمية وأن تُعتمد في أقرب وقت ممكن. يجب أن تكون طريقة تعامل الجامعة مع هذه التقنيات مزيجًا من الخيارات المقدمة في هذا الاستطلاع… على سبيل المثال، قد يكون من المناسب لقسم واحد السماح للذكاء الاصطناعي بالمساعدة في البحث، طالما تم الإشارة إليه؛ بينما قد يُعتبر من غير المناسب استخدامه في أقسام أخرى وبالتالي يُحظر.

لقد وجدت أن التقنيات المساعدة يمكن أن تكون مفيدة حقًا دون أن تتعارض بالضرورة مع نزاهتي الأكاديمية، على سبيل المثال، أستخدمها لاسترجاع صيغة نادرة بسرعة قد يستغرق مني وقتًا للعثور عليها على الإنترنت أثناء حل المسائل. ولكن عندما يصبح واضحًا (باستخدام كاشفات الذكاء الاصطناعي) أن العمل المقدم هو في الغالب عمل الكمبيوتر وليس الطالب، يجب اتخاذ تدابير وعقوبات…

أعتقد أن الطلاب بحاجة إلى تعلم كيفية دمج هذه التكنولوجيا في حياتهم لأنها ستستخدم من قبل الجميع بغض النظر عما تفعله الجامعات، لذا نحتاج إلى تعلم كيفية استخدامها.

تعليم الناس كيفية استخدامها، ويعود لهم اتخاذ القرار.

لا أعتقد أنه من الممكن حظرها تمامًا، لسببين: (1) سيتم استخدام التكنولوجيا سواء أحببنا ذلك أم لا، وهي ستتحسن فقط؛ (2) ليس من الواضح دائمًا أي التقنيات المساعدة هي ذكاء اصطناعي وأعتقد أن هذا سيصبح بشكل متزايد منطقة رمادية مع تحسن التكنولوجيا وظهور المزيد من هذه المنصات. قد لا يدرك الطلاب حتى أنهم يستخدمون الذكاء الاصطناعي في بعض الحالات. لذا يجب تنظيم استخدام الذكاء الاصطناعي. يجب أن تكون هناك إرشادات واضحة حول ما هو الاستخدام المقبول وما هو غير المقبول ويجب أن يكون استخدام الذكاء الاصطناعي شفافًا… إذا كانت هناك إمكانية لاستخدام الذكاء الاصطناعي متاحة للجميع، فإنها سياسة عادلة للجميع. إذا تم استخدام الذكاء الاصطناعي للمساعدة في كتابة أجزاء من العمل، فيجب أن ينعكس ذلك في علامة الطالب (على سبيل المثال، خصم 5 من 10 علامات).

قم بتعديل التقييمات بطريقة تتطلب تفكيرًا أكثر إبداعًا بحيث يمكن استخدام أدوات الذكاء الاصطناعي بشكل داعم فقط – في رأيي، هذه هي الطريقة الفعالة الوحيدة لإدارة استخدامها من قبل الطلاب.

أوافق على أن يكون للمدرسين القرار النهائي، ومع ذلك

ابحث أكثر في تأثير الاستخدامات وإذا سمحت بالاستخدام، فاجعلها مجانية ومتاحة للجميع، وإلا ستخلق فجوة في الوصول – وهو ما أتخيل-

قد تكون موجودة بالفعل فيما يتعلق بهذه الأدوات

ربما يكون من الأفضل وجود سياسة عامة للجامعة ثم سياسة أكثر تحديدًا للقسم. من الصعب حظر تقنية الذكاء الاصطناعي لأنها تنتج قطعًا فريدة من العمل في كل مرة، لذا

استخدامات أخرى لتقنيات الذكاء الاصطناعي العام

يمكن استخدام هذه التقنيات كدعم، لكن لا ينبغي لأحد أن يعتبر هذه التقنيات تعمل نيابة عنه.

أعتقد أنه يمكن استخدامها كأداة تعليمية بدلاً من أن تكون أداة لإنجاز واجباتك بدلاً منك.

| استخدامات أخرى لتقنيات الذكاء الاصطناعي التوليدي | عدد التعليقات |

| القواعد/الإملاء/علامات الترقيم | 218 |

| آخر | ١٧٧ |

| لا تعليق | ١٢٦ |

| فهم المفهوم | ١١٠ |

| التخطيط | ١٠٣ |

| تلخيص النص | ١٠١ |

| أداة البحث | 94 |

| أداة بحث | 77 |

| خلق الأفكار | ٥٨ |

| الإشارة | 53 |

| الإعاقة/التنوع العصبي | 52 |

| فحص الأخطاء | ٤٧ |

| دولي/ترجمة | ٤٩ |

| البرمجة | ٣٩ |

| منظمة | ٣٦ |

| مراجعة | ٢٥ |

| المهنة/القابلية للتوظيف | ٢٢ |

| البريد الإلكتروني | 18 |

| الإجابة على الأسئلة | ١٣ |

| غير مفيد | ١٣ |

| بديل للمحاضر | 11 |

| تحليل البيانات | 11 |

| امتحان | 9 |

| المشاركة/التواصل | ٧ |

| تعليق | ٦ |

| جمع البيانات | ٥ |

| إنشاء المحتوى | ٤ |

أعتقد أنهم غير عادلين لأن بعض الناس لن يعرفوا كيفية استخدامها” “إذا كان مسموحًا باستخدامها في مناطق معينة، سيكون من المهم وجود دروس تعليمية توضح كيفية استخدام التكنولوجيا حتى يحصل جميع الطلاب على نفس الفرصة لتحقيق الدرجات.

مع تطور هذه التقنيات بسرعة

تعليقات عامة

أعتقد أن الذكاء الاصطناعي هو الواقع القاسي لعالم أكبر وأفضل وأكثر إشراقًا. لن أستخدمه لكتابة مقال. ولكن للعثور على مصادر، وإعطائي أفكار، وما إلى ذلك، فهو رائع. الأشخاص الذين يستخدمونه للقيام بكل عملهم هم فقط يخدعون أنفسهم ومن المحتمل أن يعانوا أكاديميًا.

المكان الحديث للعمل يتكيف والطلاب سيجدون دائمًا وسيلة للتكيف مع هذه التقنيات. بدلاً من حظرها، يجب دمجها وتعليم كيفية عدم دقتها في المعلومات وما إلى ذلك.

إذا تجاهلت الجامعة الذكاء الاصطناعي، فسوف تضر بكل طالب، حيث يحد ذلك من قدرتهم في بيئة عالمية تنافسية. إذا تجاهلت الجامعة الذكاء الاصطناعي، فسوف يؤدي ذلك إلى جعل جميع الشهادات بلا قيمة فعليًا.

أدوات الذكاء الاصطناعي قوية، لكنها مجرد أدوات. أعتقد أن استخدام الذكاء الاصطناعي للإلهام أكثر فعالية بكثير من استخدام جوجل، حيث يقدم إجابة أكثر ت polish. لكن الأداة جيدة فقط بقدر الشخص الذي يستخدمها.

هذه التقنيات مفيدة للغاية، فكوني من عائلة غير أكاديمية يعني أنني لا أستطيع أن أسأل والديّ أسئلة بسيطة مثل كيفية هيكلة مراجعة منهجية. المحاضرون لا يجيبون على السؤال الأساسي لأنهم يفترضون أننا نعرف بالفعل كيفية الاستشهاد، وكيفية الكتابة. حتى إذا كتبت في جوجل هيكل مراجعة منهجية، فإن جميع النتائج هي مقالات علمية ولا تجيب بطريقة يمكنني فهمها. أعتقد أن استخدام تقنية الذكاء الاصطناعي للمساعدة، على سبيل المثال، طلب المساعدة في الهيكل، وطرح أسئلة بسيطة إذا لم تفهم موضوع البحث وتحتاج إلى شرحه، هو أمر مقبول. ومع ذلك، فإن استخدامه لكتابة مقال كامل هو أمر خاطئ.

غير عادل ويصنف على أنه سرقة أدبية.

أبرز سبعة عشر من الردود المزايا للطلاب ذوي الإعاقة، واقترح عشرة أن هذه التقنيات مفيدة بشكل خاص للطلاب الدوليين.

تذكر: حظر الذكاء الاصطناعي بشكل عام يمكن أن يؤذي الطلاب ذوي الإعاقة. أستخدم الذكاء الاصطناعي للتنقل في CANVAS بسبب نقص ميزات الوصول.

…من المحتمل أن يتم استخدام الذكاء الاصطناعي بشكل متزايد، وبشكل أكثر تعاونًا في مكان العمل، مما سيوفر للطلاب إعدادًا أفضل لسوق العمل. يبدو أن إعادة تصور كيفية مشاركة الجامعات ونمو المعرفة أمر ضروري. الآن، أكثر من أي وقت مضى، تبدو المناقشات التعاونية الحقيقية وتحديات المعرفة مهمة. هذه فرصة لنمو وتعزيز نظام التعليم لدينا. العودة إلى الامتحانات المغلقة قد تتحقق مما يمكن للطلاب تذكره، لكنها غير متاحة للأشخاص ذوي الإعاقة ولا تتحدى الناس للتفكير. إنها جيدة فقط لأنها سهلة.

شكرًا على الدعوة وطرح هذه الأسئلة.

أنا معجب بأن الجامعة تطلب آراء الطلاب حول هذا وآمل أن يستمر الحوار في المستقبل حول كيفية استخدام هذه التقنيات الجديدة والمثيرة لتحسين كيفية تعلمنا وتطوير أنفسنا في الجامعة.

هذا موضوع رائع ولم أفكر فيه حقًا!

شكرًا لك على السماح لي بالمشاركة في هذا الاستطلاع.

استطلاع قصير لطيف!

نقاش

مثل ChatGPT متاحة بسهولة و

على سبيل المثال، إعادة استخدام المعلومات التي تم تحميلها عليها للإجابة على أسئلة الآخرين، على الرغم من عدم طرح سؤال استقصائي محدد حول هذا الموضوع (لوند ووانغ 2023). تم إثارة قضايا أمان أخرى تتعلق بالمعلومات الشخصية مع تقنيات مثل ChatGPT (لي وآخرون 2023). يمكن زيادة الوعي بالمزايا والقيود إذا استثمرت الجامعات في تدريب الموظفين والطلاب على كيفية استخدامها. قد يؤدي ذلك إلى تقليل عدد الطلاب الذين يستخدمون التقنيات بشكل غير مناسب، حيث إن سوء الفهم هو أحد الأسباب المحددة التي يمكن أن تؤدي إلى سوء السلوك الأكاديمي غير المقصود (بيري 2010).

الاستنتاجات

الاختصارات

ChatGPT المحول المدرب مسبقًا للدردشة

الشكر والتقدير

مساهمات المؤلفين

التمويل

توفر البيانات والمواد

الإعلانات

المصالح المتنافسة

تاريخ الاستلام: 4 أغسطس 2023 تاريخ القبول: 17 يناير 2024

تاريخ النشر عبر الإنترنت: 08 فبراير 2024

References

Amigud A (2019) 246 reasons to cheat: an analysis of students’ reasons for seeking to outsource academic work. Comput Educ 134:98-107. https://doi.org/10.1016/j.compedu.2019.01.017

Amigud A, Lancaster T (2019) I will pay someone to do my assignment: an analysis of market demand for contract cheating services on Twitter. Assess Evaluation High Educ 45(4):541-533. https://doi.org/10.1080/02602938.2019.1670780

Baidoo-Anu D, Owusu Ansah L (2023) Education in the era of generative artificial intelligence (AI): Understanding the potential benefits of ChatGPT in promoting teaching and learning. SSRN Electronic Journal. https://doi.org/10.2139/ ssrn.4337484. (Available at SSRN 4337484)

Bretag T, Harper R, Burton M, Ellis C, Newton P, Rozenberg P, Saddiqui S, van Haeringen K (2018) Contract cheating: a survey of Australian university students. Stud High Educ 44(11):1837-1856. https://doi.org/10.1080/03075079.2018. 1462788

Brimble

Clarke R, Lancaster T (2006) Eliminating the successor to plagiarism? Identifying the usage of contract cheating sites. In: Proceedings of 2nd International Plagiarism Conference. Northumbria Learning Press, Newcastle upon Tyne, p. 19-21

Cotton DRE, Cotton PA, Shipway JR (2023) Chatting and cheating: ensuring academic integrity in the era of ChatGPT. Innovations in Education and Teaching International 1-12. 13th March,https://doi.org/10.1080/14703297.2023. 2190148

East J, Donnelly L (2012) Taking responsibility for academic integrity: a collaborative teaching and learning design. J Univ Teach Learn Pract 9(3):6-17. https://doi.org/10.53761/1.9.3.2

Evering LC, Moorman G (2012) Rethinking plagiarism in the digital age. J Adolesc Adult Lit 56(1):35-44. https://doi.org/ 10.1002/JAAL. 00100

Flom J, Green K, Wallace S (2021) To cheat or not to cheat? An investigation into the ethical behaviours of generation Z. Act Learn High Educ 24(2):155-168. https://doi.org/10.1177/14697874211016147

Gravel J, D’Amours-Gravel M, Osmanlliu E (2023) Learning to fake it: limited responses and fabricated references provided by ChatGPT for medical questions. Mayo Clinic Proceedings: Digital Health 1(3):226-234

Harrison D, Patch A, McNally D, Harris L (2020) Student and faculty perceptions of study helper websites: a new practice in collaborative cheating. J Acad Ethics 19(4):483-500. https://doi.org/10.1007/s10805-020-09373-2

Howard RM, Davies LJ (2009) Plagiarism in the Internet age. Educational Leadership, 66(6), 64-67. http://www.ascd.org/ publications/educational-leadership/mar09/vol66/num06/Plagiarism-in-the-Internet-Age.aspx. Accessed 12 May 2023

Javaid M, Haleem A, Singh RP, Khan S, Kahn IH (2023) Unlocking the opportunities through ChatGPT Tool towards ameliorating the education system. BenchCouncil transactions on Benchmarks. Stand Evaluations 3(2):1-12. https://doi. org/10.1016/j.tbench.2023.100115

Lancaster T (2019) Profiling the international academic ghost writers who are providing low-cost essays and assignments for the contract cheating industry. J Inform Communication Ethics Soc 17(1):72-86. https://doi.org/10.1108/ JICES-04-2018-0040

Lancaster T (2021) Academic dishonesty or academic integrity? Using Natural Language Processing (NLP) techniques to investigate positive integrity in academic integrity research. J Acad Ethics 19(3):363-383. https://doi.org/10.1007/ s10805-021-09422-4

Lawson RA (2004) BUSINESS STUDENTS’WILLINGNESS TO ENGAGE IN ACADEMIC DISHONESTY AND WHISTLE-BLOWING. In Research on Professional Responsibility and Ethics in Accounting (Vol. 9, pp. 1-19). Emerald Group Publishing Limited. doi https://doi.org/10.1016/S1574-0765(04)09001-6.

Lazic D, Thompson A, Pritchard T, Tsuji S (2020) Student preferences: using Grammarly to help EFL writers with paraphrasing, summarizing, and synthesizing. In: Frederiksen KM, Larsen S, Bradley L, Thouësny S (Eds), CALL for widening participation: short papers from EUROCALL 2020, pp. 183-189. Research-publishing.net, https://doi.org/10.14705/ rpnet.2020.48.1186

Li H, Guo D, Fan W, Xu M, Song Y (2023) Multi-step jailbreaking privacy attacks on chatgpt. https://doi.org/10.48550/arxiv. 2304.05197

Lund BD, Wang T (2023) Chatting about ChatGPT: how may AI and GPT impact academia and libraries? Libr Hi Tech News 40(3):26-29. https://doi.org/10.1108/LHTN-01-2023-0009

McCabe DL, Trevino LK (1997) Individual and contextual influences on academic dishonesty: a multicampus investigation. Res High Educt 38:379-396

Newton P (2016) Academic integrity: a quantitative study of confidence and understanding in students at the start of their higher education. Assess Eval High Educ 41(3):482-497. https://doi.org/10.1080/02602938.2015.1024199

Perry B (2010) Exploring academic misconduct: some insights into student behaviour. Act Learn High Educ 11(2):97-108. https://doi.org/10.1177/1469787410365657

Pitt P, Dullaghan K, Sutherland-Smith W (2020) Mess, stress and trauma’: students’ experiences of formal contract cheating processes. Assess Evaluation High Educ 46(1):659-672. https://doi.org/10.1080/02602938.2020.1787332

Poláková P, Klímová B (2019) Mobile technology and generation Z in the english language classroom-A preliminary study. Educ Sci 9(3):203. https://doi.org/10.3390/educsci9030203

Prentice FM, Kinden CE (2018) Paraphrasing tools, language translation tools and plagiarism: an exploratory study. Int J Educational Integr 14(11):1-16. https://doi.org/10.1007/s40979-018-0036-7

Pupovac V, Popović S, Blažina V (2019) What prevents students from reporting academic misconduct? A survey of croatian students. J Acad Ethics 17(4):389-400. https://doi.org/10.1007/s10805-019-09341-5

Rogerson A, McCarthy G (2017) Using internet based paraphrasing tools: original work, patchwriting or facilitated plagiarism? Int J Educational Integr 13(2):1-5. https://doi.org/10.1007/s40979-016-0013-y

Simon CA, Carr JR, Mccullough SM, Morgan SJ, Oleson T, Ressel M (2004) Gender, student perceptions, institutional commitments and academic dishonesty: who reports in academic dishonesty cases? Assess Evaluation High Educ 29(1):75-90. https://doi.org/10.1080/0260293032000158171

Stokel-Walker C (2022) Al bot ChatGPT writes smart essays – should professors worry? Nature, 9th Dec. https://www. nature.com/articles/d41586-022-04397-7. Accessed 12 May 2023.

Szymkowiak A, Melovic B, Dabic M, Jeganathan K, Kundi GS (2021) Information technology and Gen Z: the role of teachers, the internet, and technology in the education of young people. Technol Soc 65:101565. https://doi.org/10. 1016/j.techsoc.2021.101565

Williams BT (2007) Trust, betrayal and authorship: plagiarism and how we perceive students. J Adolesc Adult Lit 51(4):350-354. https://doi.org/10.1598/JAAL.51.4.6

Yachison S, Okoshken J, Talwar V (2018) Students’ reactions to a peer’s cheating behavior. J Educ Psychol 110(6):747-763. https://doi.org/10.1037/edu0000227

Yu H (2023) Reflection on whether Chat GPT should be banned by academia from the perspective of education and teaching. Psychol 14:1181712. https://doi.org/10.3389/fpsyg.2023.1181712

ملاحظة الناشر

DOI: https://doi.org/10.1007/s40979-024-00149-4

Publication Date: 2024-02-08

Student perspectives on the use of generative artificial intelligence technologies in higher education

Check for updates

bparsons@liverpool.ac.uk

Abstract

The aim of this project was to understand student perspectives on generative artificial intelligence (GAI) technologies such as Chat generative Pre-Trained Transformer (ChatGPT), in order to inform changes to the University of Liverpool Academic Integrity code of practice. The survey for this study was created by a library student team and vetted through focus groups. A total of 2555 students participated in the survey. Results showed that only 7% of students who responded had not heard of any GAI technologies, whilst over half had used or considered using these for academic purposes. The majority of students (54.1%) were supportive or somewhat supportive of using tools such as Grammarly, but 70.4% were unsupportive or somewhat unsupportive towards students using tools such as ChatGPT to write their whole essay. Students who had higher levels of confidence in their academic writing were less likely to use or consider using them for academic purposes, and were also less likely to be supportive of other students using them. Most students (41.1%) also thought there should be a university wide policy on when these technologies are or are not appropriate to use. The results of this research suggest that students require clear policies on the use of GAI and that these technologies should not be banned from university, but consideration must be made to ensure different groups of students have equal access to the technologies.

Introduction

In order to have a student-centred approach to this policy, a project was launched to gather student perspectives on these technologies. The aim was to understand how students are using these technologies currently, whether their confidence in writing has an

impact on their usage or opinions of the technologies, and how they think the university should respond to them in relation to academic work.

Literature review

found assignments boring and tiring, and became frustrated with the effort required to complete them. This was followed by “academic aptitude”, where students were struggling with the level of difficulty or skills needed to complete the task. Other reasons included a lack of self-discipline and motivation, personal/medical issues, and struggling to balance with other priorities such as work or family. Overall, they concluded that students who used assignment outsourcing services typically reached a point where they considered the “potential benefits of cheating to outweigh the costs” (p.104). Brimble (2016, p.378) found similar reasons, and also stated that dishonest behaviour is increasingly becoming “the norm” and almost viewed as essential to be able to keep up with peers. Bretag et al (2018) found contract cheating to be most prevalent amongst younger students, those who did not speak English as their first language, and those who were dissatisfied with the teaching and learning provided on their course.

Methods

Results

Focus group

Online survey

Confidence in academic writing

| Level of study | % of respondents | % of university population |

| Foundation | 0.7% | 1.2% |

| Undergraduate | 69.7% | 76.4% |

| Taught Postgraduate | 22.7% | 15.70% |

| Research Postgraduate | 6.5% | 6.7% |

| Humanities and Social Sciences | Health and Life Sciences | Science and Engineering | |

| 1 | 1.6% | 2.0% | 1.6% |

| 2 | 6.4% | 11.3% | 9.4% |

| 3 | 35.8% | 40.0% | 35.9% |

| 4 | 45.3% | 38.0% | 40.2% |

| 5 | 10.9% | 8.7% | 12.8% |

| Foundation | Undergraduate | Postgraduate Taught | Postgraduate Research | |

| 1 | 5.9% | 1.8% | 1.4% | 0.6% |

| 2 | 5.9% | 10.3% | 5.5% | 6.0% |

| 3 | 35.3% | 39.8% | 33.4% | 24.0% |

| 4 | 47.1% | 40.1% | 43.3% | 51.5% |

| 5 | 5.9% | 7.9% | 16.4% | 18.0% |

Students knowledge of GAI technologies

Students usage or considered usage of GAI technologies

“I have used ChatGPT to throw around ideas and to help with structuring work. I wouldn’t use it to write anything, I wouldn’t trust it to source correct information,

and it’s known to provide citations and references that don’t exist. I am interested in trying to use it to proofread work though, and apparently it can be used to summarise articles, etc. I think it could be used in lots of useful ways, but not for academic writing… yet!”

“Getting a basis knowledge to further know what to search for when finding references for papers. I also sometimes feel publications can be a bit overly complicated so having a simple answer given to a question is helpful for my understanding.”

“I liked the idea of grammarly during A levels as it helped with my writing skills and vocabulary. But I never used it properly as it was a paid subscription.”

“Everyday use, answering every-day questions, making workout-plan, health tips, mental health tips, ect…”

“Grammarly helps me detect plagiarism percentage before submitting my work”

There was a tendency for students from Health and Life Sciences to use or consider using these technologies less for personal and professional use than other faculties, but academic use was similar across the three faculties and the way students used or considered using the technologies did not appear to be affected by level of study. Foundation students, many of whom consist of mature students returning to education, showed marginally lower overall use/considered usage, however only 17 respondents were in this category.

Confidence in academic writing and use of GAI technologies

Student views on other students use of GAI technologies

| Confidence score

|

Personal use | Academic use | Professional use | Never used | ||||

| % No | % Yes | % No | % Yes | % No | % Yes | % Used/ considered | % Never used | |

| 1 | 65% | 35% | 60% | 40% | 84% | 16% | 67% | 33% |

| 2 | 69% | 31% | 43% | 57% | 43% | 57% | 69% | 31% |

| 3 | 72% | 28% | 46% | 54% | 46% | 54% | 67% | 33% |

| 4 | 69% | 31% | 51% | 49% | 51% | 49% | 62% | 38% |

| 5 | 70% | 30% | 54% | 46% | 54% | 46% | 63% | 37% |

| Statement | % of respondents who selected this |

| Supportive – I think in 2023 we should all be using artificial intelligence technologies to make our life easier | 27.2% |

| Somewhat supportive – I am fine with other students using software if they give credit to the technology in their work | 26.3% |

| Neutral – I don’t really have an opinion on this. I think it’s up to the individual student to decide to use it/not the use it | 26.2% |

| Somewhat unsupportive – I think these technologies still have a lot of limitations and I would encourage other students to check the information they find | 11.6% |

| Unsupportive – I think it is really unfair for other students to use these technologies. People who use these technologies are effectively copying the work of others without giving full credit | 7.4% |

| Other | 1.3% |

“I believe these technologies should be taken for what they really are, language models. All they do is feedback data specified from user inputted parameters, all information given by the model has to have existed previously, or inferred from preexisting data. Therefore, these technologies should be used entirely as what they’re designed for, to act as a search engine to help but not plagiarise. Disclaimers given within the software state that wrongful information can be given at times, and I feel while this is partially a limitation of technology, it is entirely negligence by students if this information is used.”

“It is useful as an aid for those that may have disabilities or have additional learning needs and I would be supportive of this, but for able students I feel that assistive apps or technologies gives an unfair advantage for anything beyond simply checking grammar, spelling, etc.”

“It depends, I think it’s ok to use grammar check, especially for nonnative speakers. They have their own idea, and these kind of AI just like some advanced dictionary to help them express their ideas better. But for assistive technology like ChatGPT, there should be some policy to avoid improper use.”

“think the uni students should be taught about the newest series of AI as its going to bee a huge part of our lives no matter the course and in 10-15 years timethink till it become part of all levels of teaching and if we don’t learn how to used it effectively then we will be left behind the future generations. uni students can already get it to write them an essay in minutes without learning about it so think unis should change assessment types and embrace the technology as unis are supposed to be preparing us for the future.”

“It affects the future economoy when people undeserving of their degree have ended

in a profession that they cannot understand without AI. Furthermore, someone more deserving of that spot could be there, AI masks true intelligence.”

“I don’t think I would worry about anyone’s coursework but mine!”

The following question asked the respondents how they would feel if another student had used a GAI technology such as ChatGPT to write their entire essay for them. Respondents were asked to select the statement which closest matched their point of view. Most students (

“As an assistant it’s helpful, but to do their whole essay takes away the integrity and pride from their work”

“I would support it if someone used it to check grammar or translation if English was not their first language, but not to write a full document. This would likely be abused by a lot of students, which would make the assessment unfair for those who don’t.”

“I think using it to check information, help with grammar and research things is fine. But it’s not your essay if AI writes it for you. I hate writing essays and struggle with them, but you still have to do them”

“Generally unsupportive, as they would be loosing out on the experience of writing an essay and the learning gained from it. Although feel like university assessments need to adapt to take into account the existence of AI assistance.”

“Unsupportive of it because I think its unfair to not come up with ideas on your own and have to rely on AI to convey your thoughts. Its important to be able to phrase

| Statement | % of respondents who selected this |

| Supportive – I think in 2023 we should all be using artificial intelligence technologies to make our life easier | 5.6% |

| Somewhat supportive – I am fine with other students using software if they give credit to the technology in their work | 8.2% |

| Neutral – I don’t really have an opinion on this. I think it’s up to the individual student to decide to use it/not the use it | 14.2% |

| Somewhat unsupportive – I think these technologies still have a lot of limitations and I would encourage other students to check the information they find | 21.9% |

| Unsupportive – I think it is really unfair for other students to use these technologies. People who use these technologies are effectively copying the work of others without giving full credit | 48.5% |

| Other | 1.6% |

“Unsupportive – the AI is limited by the data on which it is modelled. Whatever answers it provides cannot be taken as expert knowledge, but only as a reflection of the information which fed into it.”

“…I suppose it depends how much of the input was original (ChatGPT tends to work from very short instructive prompts). Whether it is ‘unfair’ is probably a different discussion – these AI-generated essays tend to be extremely repetitive and incoherent. Few of them are close to pass-worthy, and those that are never really exceed a 50%. If we started seeing a lot of these essays being submitted, they would artificially raise the percentile in which students who had submitted ‘real work’ were graded, if anything.”

“I think it would be obvious to tell if an essay is written entirely by AI, and so you probably wouldn’t be given a good mark.”

“Neither supportive or unsupported. I think using such technology like ChatGPT is different from using others like Grammerly. ChatGPT does the work for you. This takes away an individual acquiring the necessary skills that they should be building and personally developing during their academics. I feel it doesn’t upskill an individual, where other technologies provide such opportunities.”

“I don’t mind others using it but I would prefer clear guidance from the university as to whether we can or cannot use it so then everyone can feel free to use it too.”

“I’m fully in support, because when we reach singularity for computing, should we prevent use of technologies because it makes our lives easier? Should we ban calculators when it’s a machine literally doing all the mathematical work? I don’t think ChatGPT should be used without discretion, but there’s no reason why someone can’t ask it to write an essay as long as the student critically goes over the essay for their own edits and input.”

“I think if used in an honest way it can be very helpful for understanding and as an aid in writing essays/papers/etc. What I don’t agree with is solely using it to directly copy the information. Misinformation is common and fact checking is important. So, it’s important to still encourage this when using these software. To become reliant on this type of software will only harm the individual and I think it’s a real concern with the improvement of these types of software.”

“it depends, some students due to disability need AI to help. If it was available to me and I didn’t use it, that would be my choice”

Confidence in academic writing and views on others using GAI

grammar

Student views on university policies for GAI technologies

“Educate people on how the AI tools can be used in ways other than to simply cheat, for example to improve revision, speed up the writing process, or help with

| Confidence score | Supportive | Somewhat supportive | Neutral | Somewhat unsupportive | Unsupportive | Other |

| 1.00 | 27.9% | 27.9% | 30.2% | 9.3% | 2.3% | 2.3% |

| 2.00 | 31.1% | 25.9% | 26.3% | 10.1% | 5.7% | 0.9% |

| 3.00 | 27.9% | 25.1% | 28.2% | 10.9% | 6.8% | 1.1% |

| 4.00 | 25.4% | 29.1% | 24.8% | 11.7% | 7.5% | 1.5% |

| 5.00 | 28.2% | 19.4% | 24.2% | 15.0% | 11.7% | 1.5% |

| Confidence score | Supportive | Somewhat supportive | Neutral | Somewhat unsupportive | Unsupportive | Other |

| 1.00 | 14% | 18.6% | 27.9% | 9.3% | 30.2% | 0% |

| 2.00 | 8.3% | 9.2% | 13.2% | 25% | 41.7% | 2.6% |

| 3.00 | 5.4% | 8.6% | 16.5% | 23.2% | 44.9% | 1.5% |

| 4.00 | 4.5% | 7.6% | 12.5% | 22% | 52.2% | 1.1% |

| 5.00 | 7% | 6.2% | 11.7% | 16.5% | 55.7% | 2.9% |

| Response | % of respondents who selected this |

| Ban them entirely | 4.5% |

| Have a university wide policy on when they are and or not appropriate to use | 41.1% |

| Let departments/ faculties decide the policy on when they are or are not appropriate to use | 26.0% |

| Let lecturers decide individual policies for individual assignments on when they are or are not appropriate to use | 16.9% |

| Allow them to be used however the students wish | 9.6% |

| Other | 1.8% |

“I believe these technologies need to be embraced in an academic setting and adopted asap. The way the university should handle these technologies should be a mixture of the options provided in this survey… For example it may be appropriate for one department to allow AI to help with research, as long as it’s referenced; for other departments it may be deemed inappropriate for it to be used and thus banned.”

“I have found that assistive technologies can be really helpful without necessarily encroaching upon my academic integrity, for example I use it to quickly recall an obscure formula that would take me a while to find on the internet while doing problems. But when it becomes evident (using AI detectors) that submitted work is predominantly the work of the computer and not the student, measures and sanctions should be taken…”

“i think students need to learn how to integrate this technology into their lives as its going to be used by everyone no matter what unis do so we need to learn how to use it.”

“educate people on how to use them and its up to them to make a choice.”

“I don’t think it is an option to ban them entirely, for two reasons: (1) the technolgy will be used whether we like it or not, and it’s only going to improve; (2) it’s not always clear which assistive technologies are AI and I think this will increasingly become a grey area as the technology improves and more of these platforms become available. Students might not even realise that they are using AI in some cases. So use of AI needs to be regulated. There needs to be clear guidelines on what is acceptable use and what is not and the use of AI should be transparent… If the option to use AI is available to all, then it’s a fair for all policy. If AI is used to help write pieces of work though, this should be reflected in the student’s mark (e.g., 5/10 marks deducted).”

“Modify assessments in a way that requires more creative thinking so that AI tools can only be used supportively – in my opinion, it is the only effective way to manage their use by students”

“I agree with lecturers having the final decision, however

“Research further into impact of uses and if allow the use then allow them to be free and accessible to all otherwise you create an accessibility gap – which I imag-

ine may already be present with respect to these tools”

“Maybe have a general uni policy and then a more specific departmental policy. It’s difficult to ban the ai technology as they create unique pieces of work each time, so

Other uses for GAI technologies

“These technologies may be used as a support but no one should consider these technologies to act on their behalf.”

“I believe they can be used a learning tool rather than a tool to do your assignments for you.”

| Other uses for Generative Artificial Intelligence Technologies | Number of comments |

| Grammar/spelling/punctuation | 218 |

| Other | 177 |

| No comment | 126 |

| Understand concept | 110 |

| Planning | 103 |

| Summarise text | 101 |

| Search tool | 94 |

| Research tool | 77 |

| Creating ideas | 58 |

| Referencing | 53 |

| Disability/Neurodiversity | 52 |

| Error checking | 47 |

| International/translation | 49 |

| Coding | 39 |

| Organisation | 36 |

| Revision | 25 |

| Career/employability | 22 |

| Emails | 18 |

| Answering questions | 13 |

| Not useful | 13 |

| Alternative to lecturer | 11 |

| Analysing data | 11 |

| Exam | 9 |

| Sharing/communication | 7 |

| Feedback | 6 |

| Collecting data | 5 |

| Content creation | 4 |

“I think they are unfair because some people won’t know how to use them” “If they are allowed to be used in certain areas, it would be important to have tutorials to show how to utilise the technology so all students are given the same opportunity to reach the grades.”

“As these technologies develop at a quick pace

General comments

“I believe AI is the harsh reality of a bigger, better and brighter world. I wouldn’t use it to write an essay. But to find sources, give me ideas etc it’s great. The people using it to do absolutely all their work for them are only cheating themselves and will more than likely suffer academically.”

“The modern workspace is adapting and students are always going to find a way to adapt with these technologies. Rather than banning them, integrate them and teach about how they can be inaccurate about information ect”

“If the university shuns AI then it will harm each student, as it limits their ability in a competitive world environment. If the university ignores AI then this will cause all degrees to become effectively worthless.”

“AI tools are powerful, but they are just tools. I think using AI for inspiration is much more effective than using Google, giving a more polished answer. But the tool is only as good as the person using it.”

“These technologies are super helpful, coming from a non-academic family means that I can’t ask my parents simple questions like how do I structure a systematic review. Lecturers never answer the basic question because they presume we already know how to reference, how to write. Even if you type into Google structure of a systematic review all of them our journal articles and don’t answer in a way I can understand. I believe using ai technology to assist, for example asking for help with structure, asking simple questions if you don’t understand the research topic and need it to be explained is fine. However, when using it write an entire essay is wrong,

unfair and classed as plagiarism.”

Seventeen of the responses highlighted the advantages for disabled students, and 10 suggested that these technologies are particularly useful for international students.

“Remember: banning AI blankly can hurt disabled students. I use AI to navigate CANVAS because of lack of accessibility features”

“…it’s likely that ai will be being used more and more, and more collaboratively in the workplace and so it would set students up better for the workplace. It seems that a re-imagining of how universities share and grow knowledge is necessary. Now, more than ever, genuine collaborative discussions and challenges of knowledge seems important. This is an opportunity to grow and enhance our education system. Returning to closed book exams may check what students can remember, but it’s inaccessible for disabled people and it doesn’t challenge people to think. They are only good because they’re easy.”

“Thank you for the invite and asking these questions.”

“I’m impressed that the university is asking for the students opinions on this and hope a dialogue can continue into the future on how we use these new and exciting technologies to ultimately improve how we all learn and develop ourselves at university.”

“This is a great a topic and one I haven’t really thought about!”

“Thank you to let me participate in this survey.”

“Nice short survey!”

Discussion

such as ChatGPT are easily accessible and

for example reusing information uploaded to them to answer the questions of others, although no specific survey question was asked on this topic (Lund and Wang 2023). Other safety issues relating to personal information have been raised with technologies such as ChatGPT (Li et al 2023). Awareness of advantages and limitations could be increased if universities invest in training staff and students on how to use them. This may result in fewer students using the technologies inappropriately since misunderstanding is one of the reasons identified that can lead to accidental academic misconduct (Perry 2010).

Conclusions

Abbreviations

ChatGPT Chat Generative Pre-Trained Transformer

Acknowledgements

Authors’ contributions

Funding

Availability of data and materials

Declarations

Competing interests

Received: 4 August 2023 Accepted: 17 January 2024

Published online: 08 February 2024

References

Amigud A (2019) 246 reasons to cheat: an analysis of students’ reasons for seeking to outsource academic work. Comput Educ 134:98-107. https://doi.org/10.1016/j.compedu.2019.01.017

Amigud A, Lancaster T (2019) I will pay someone to do my assignment: an analysis of market demand for contract cheating services on Twitter. Assess Evaluation High Educ 45(4):541-533. https://doi.org/10.1080/02602938.2019.1670780

Baidoo-Anu D, Owusu Ansah L (2023) Education in the era of generative artificial intelligence (AI): Understanding the potential benefits of ChatGPT in promoting teaching and learning. SSRN Electronic Journal. https://doi.org/10.2139/ ssrn.4337484. (Available at SSRN 4337484)

Bretag T, Harper R, Burton M, Ellis C, Newton P, Rozenberg P, Saddiqui S, van Haeringen K (2018) Contract cheating: a survey of Australian university students. Stud High Educ 44(11):1837-1856. https://doi.org/10.1080/03075079.2018. 1462788

Brimble

Clarke R, Lancaster T (2006) Eliminating the successor to plagiarism? Identifying the usage of contract cheating sites. In: Proceedings of 2nd International Plagiarism Conference. Northumbria Learning Press, Newcastle upon Tyne, p. 19-21

Cotton DRE, Cotton PA, Shipway JR (2023) Chatting and cheating: ensuring academic integrity in the era of ChatGPT. Innovations in Education and Teaching International 1-12. 13th March,https://doi.org/10.1080/14703297.2023. 2190148

East J, Donnelly L (2012) Taking responsibility for academic integrity: a collaborative teaching and learning design. J Univ Teach Learn Pract 9(3):6-17. https://doi.org/10.53761/1.9.3.2

Evering LC, Moorman G (2012) Rethinking plagiarism in the digital age. J Adolesc Adult Lit 56(1):35-44. https://doi.org/ 10.1002/JAAL. 00100

Flom J, Green K, Wallace S (2021) To cheat or not to cheat? An investigation into the ethical behaviours of generation Z. Act Learn High Educ 24(2):155-168. https://doi.org/10.1177/14697874211016147

Gravel J, D’Amours-Gravel M, Osmanlliu E (2023) Learning to fake it: limited responses and fabricated references provided by ChatGPT for medical questions. Mayo Clinic Proceedings: Digital Health 1(3):226-234

Harrison D, Patch A, McNally D, Harris L (2020) Student and faculty perceptions of study helper websites: a new practice in collaborative cheating. J Acad Ethics 19(4):483-500. https://doi.org/10.1007/s10805-020-09373-2

Howard RM, Davies LJ (2009) Plagiarism in the Internet age. Educational Leadership, 66(6), 64-67. http://www.ascd.org/ publications/educational-leadership/mar09/vol66/num06/Plagiarism-in-the-Internet-Age.aspx. Accessed 12 May 2023

Javaid M, Haleem A, Singh RP, Khan S, Kahn IH (2023) Unlocking the opportunities through ChatGPT Tool towards ameliorating the education system. BenchCouncil transactions on Benchmarks. Stand Evaluations 3(2):1-12. https://doi. org/10.1016/j.tbench.2023.100115

Lancaster T (2019) Profiling the international academic ghost writers who are providing low-cost essays and assignments for the contract cheating industry. J Inform Communication Ethics Soc 17(1):72-86. https://doi.org/10.1108/ JICES-04-2018-0040

Lancaster T (2021) Academic dishonesty or academic integrity? Using Natural Language Processing (NLP) techniques to investigate positive integrity in academic integrity research. J Acad Ethics 19(3):363-383. https://doi.org/10.1007/ s10805-021-09422-4

Lawson RA (2004) BUSINESS STUDENTS’WILLINGNESS TO ENGAGE IN ACADEMIC DISHONESTY AND WHISTLE-BLOWING. In Research on Professional Responsibility and Ethics in Accounting (Vol. 9, pp. 1-19). Emerald Group Publishing Limited. doi https://doi.org/10.1016/S1574-0765(04)09001-6.

Lazic D, Thompson A, Pritchard T, Tsuji S (2020) Student preferences: using Grammarly to help EFL writers with paraphrasing, summarizing, and synthesizing. In: Frederiksen KM, Larsen S, Bradley L, Thouësny S (Eds), CALL for widening participation: short papers from EUROCALL 2020, pp. 183-189. Research-publishing.net, https://doi.org/10.14705/ rpnet.2020.48.1186

Li H, Guo D, Fan W, Xu M, Song Y (2023) Multi-step jailbreaking privacy attacks on chatgpt. https://doi.org/10.48550/arxiv. 2304.05197

Lund BD, Wang T (2023) Chatting about ChatGPT: how may AI and GPT impact academia and libraries? Libr Hi Tech News 40(3):26-29. https://doi.org/10.1108/LHTN-01-2023-0009

McCabe DL, Trevino LK (1997) Individual and contextual influences on academic dishonesty: a multicampus investigation. Res High Educt 38:379-396

Newton P (2016) Academic integrity: a quantitative study of confidence and understanding in students at the start of their higher education. Assess Eval High Educ 41(3):482-497. https://doi.org/10.1080/02602938.2015.1024199

Perry B (2010) Exploring academic misconduct: some insights into student behaviour. Act Learn High Educ 11(2):97-108. https://doi.org/10.1177/1469787410365657

Pitt P, Dullaghan K, Sutherland-Smith W (2020) Mess, stress and trauma’: students’ experiences of formal contract cheating processes. Assess Evaluation High Educ 46(1):659-672. https://doi.org/10.1080/02602938.2020.1787332

Poláková P, Klímová B (2019) Mobile technology and generation Z in the english language classroom-A preliminary study. Educ Sci 9(3):203. https://doi.org/10.3390/educsci9030203

Prentice FM, Kinden CE (2018) Paraphrasing tools, language translation tools and plagiarism: an exploratory study. Int J Educational Integr 14(11):1-16. https://doi.org/10.1007/s40979-018-0036-7

Pupovac V, Popović S, Blažina V (2019) What prevents students from reporting academic misconduct? A survey of croatian students. J Acad Ethics 17(4):389-400. https://doi.org/10.1007/s10805-019-09341-5

Rogerson A, McCarthy G (2017) Using internet based paraphrasing tools: original work, patchwriting or facilitated plagiarism? Int J Educational Integr 13(2):1-5. https://doi.org/10.1007/s40979-016-0013-y

Simon CA, Carr JR, Mccullough SM, Morgan SJ, Oleson T, Ressel M (2004) Gender, student perceptions, institutional commitments and academic dishonesty: who reports in academic dishonesty cases? Assess Evaluation High Educ 29(1):75-90. https://doi.org/10.1080/0260293032000158171

Stokel-Walker C (2022) Al bot ChatGPT writes smart essays – should professors worry? Nature, 9th Dec. https://www. nature.com/articles/d41586-022-04397-7. Accessed 12 May 2023.

Szymkowiak A, Melovic B, Dabic M, Jeganathan K, Kundi GS (2021) Information technology and Gen Z: the role of teachers, the internet, and technology in the education of young people. Technol Soc 65:101565. https://doi.org/10. 1016/j.techsoc.2021.101565

Williams BT (2007) Trust, betrayal and authorship: plagiarism and how we perceive students. J Adolesc Adult Lit 51(4):350-354. https://doi.org/10.1598/JAAL.51.4.6

Yachison S, Okoshken J, Talwar V (2018) Students’ reactions to a peer’s cheating behavior. J Educ Psychol 110(6):747-763. https://doi.org/10.1037/edu0000227

Yu H (2023) Reflection on whether Chat GPT should be banned by academia from the perspective of education and teaching. Psychol 14:1181712. https://doi.org/10.3389/fpsyg.2023.1181712