DOI: https://doi.org/10.5539/cis.v17n1p49

تاريخ النشر: 2024-04-30

الآثار الأخلاقية لاعتماد الذكاء الاصطناعي في اتخاذ القرارات المالية

doi:10.5539/cis.v17n1p49

الرابط: https://doi.org/10.5539/cis.v17n1p49

الملخص

لقد أثار دمج الذكاء الاصطناعي (AI) في القطاع المالي مخاوف أخلاقية تحتاج إلى معالجة. تحلل هذه الورقة الآثار الأخلاقية لاستخدام الذكاء الاصطناعي في اتخاذ القرارات المالية وتؤكد على أهمية إطار أخلاقي لضمان نشره بشكل عادل وموثوق. تستكشف الدراسة اعتبارات أخلاقية متنوعة، بما في ذلك الحاجة إلى معالجة التحيز الخوارزمي، وتعزيز الشفافية وقابلية التفسير في أنظمة الذكاء الاصطناعي، والامتثال للوائح التي تحمي العدالة والمساءلة والثقة العامة. من خلال تجميع الأبحاث والأدلة التجريبية، تسلط الورقة الضوء على العلاقة المعقدة بين ابتكار الذكاء الاصطناعي والنزاهة الأخلاقية في المالية. لمواجهة هذه القضية، تقترح الورقة إطارًا أخلاقيًا شاملاً وقابلًا للتنفيذ يدعو إلى إرشادات واضحة، وهياكل حوكمة، وتدقيقات منتظمة، وتعاون بين أصحاب المصلحة. يهدف هذا الإطار إلى تعظيم إمكانيات الذكاء الاصطناعي مع تقليل الآثار السلبية والعواقب غير المقصودة. تعتبر الدراسة مصدرًا قيمًا لصانعي السياسات، والمهنيين في الصناعة، والباحثين، وغيرهم من أصحاب المصلحة، مما يسهل المناقشات المستنيرة، واتخاذ القرارات المستندة إلى الأدلة، وتطوير أفضل الممارسات لدمج الذكاء الاصطناعي بشكل مسؤول في القطاع المالي. الهدف النهائي هو ضمان العدالة والشفافية والمساءلة مع جني فوائد الذكاء الاصطناعي لكل من القطاع المالي والمجتمع.

1. المقدمة

2. الأطر الأخلاقية في اتخاذ القرارات المالية

3. الشفافية والمساءلة في خوارزميات الذكاء الاصطناعي

والمستخدمين للذكاء الاصطناعي المسؤولية عن نتائج قراراتهم، مما يعزز اتخاذ القرارات الأخلاقية والمستنيرة في القطاع المالي. بدون الشفافية والمساءلة، هناك خطر من استمرار التحيزات الموجودة، والتمييز ضد مجموعات معينة، وإحداث عدم الثقة في أنظمة الذكاء الاصطناعي التي تدعم اتخاذ القرارات المالية.

4. التحيز والعدالة في اتخاذ القرارات باستخدام الذكاء الاصطناعي

5. مخاوف الخصوصية وأمان البيانات

تدعي مبادئ وإرشادات منظمة التعاون والتنمية الاقتصادية (OECD) المتعلقة بالذكاء الاصطناعي أيضًا أن جودة وملاءمة معالجة البيانات وتمثيلها مرتبطة بمخاطر نتائج النماذج المضللة والنماذج غير الدقيقة أو غير الموثوقة. تعتبر تحديات خصوصية البيانات كبيرة في GenAI بسبب العدد الكبير من مجموعات البيانات التي يتم التدريب عليها، والتي يمكن أن تأتي أيضًا من أي مصدر عام. من المحتمل أن تحتوي هذه البيانات على معلومات محمية بحقوق الملكية الفكرية، ربما دون إذن مناسب أو حقوق نشر، مما يثير قضايا إضافية تتعلق بأصالة النتائج. يمكن اعتبار أفضل الممارسات لإدارة البيانات وممارسات الحوكمة لضمان جودة البيانات، وملاءمة البيانات بناءً على الاستخدام المقصود، وخصوصية البيانات عندما يتم إدخال بيانات العملاء المالية في النموذج، وأصالة البيانات عندما تكون الإسناد/حقوق النشر ذات صلة ومناسبة.

مطلوب إبلاغ الموضوع. في هذه الحالة، يمكن الحصول على موافقة مستنيرة لهذا الغرض (بافاش، كادام، زيرانج، وكاتكار، 2023). حماية البيانات النشطة أثناء النقل والاستخدام أمر حاسم للحفاظ على سرية وسلامة وتوافر المعلومات الحيوية (خيمينيز، 2023).

6. التأثير على التوظيف والقوى العاملة

ومع ذلك، من المهم ملاحظة أن الذكاء الاصطناعي سيخلق وظائف جديدة في مجالات مثل تحليل البيانات، والتعلم الآلي، وبرمجة الذكاء الاصطناعي. مع توسع العالم في الذكاء الاصطناعي والخدمات المالية، ستحتاج الشركات إلى إعادة تقييم قواها العاملة وتوفير التدريب للتكيف مع المشهد المتغير في صناعتها. سيعتمد تأثير الذكاء الاصطناعي على الوظائف والقوى العاملة على كيفية إدارة المنظمات للانتقال واستثمارها في تحديث قواها العاملة للمستقبل (OECD، 2023).

7. التحديات التنظيمية وقضايا الامتثال

تشمل تعقيدات تنظيم نماذج الذكاء الاصطناعي والامتثال الغموض وقابلية تفسير نماذج الذكاء الاصطناعي، التي يمكن أن تعمل كـ “صناديق سوداء” وتفتقر إلى الشفافية والمساءلة. كما أن التحيز والعدالة هما مصدر قلق، حيث يمكن أن ترث نماذج الذكاء الاصطناعي التحيزات الموجودة في بيانات التدريب. بالإضافة إلى ذلك، فإن الطبيعة الديناميكية للذكاء الاصطناعي تطرح تحديات للأطر التنظيمية التقليدية التي قد تكافح لمواكبة التقدم التكنولوجي.

تشمل استراتيجيات التعاون مع الهيئات التنظيمية الانخراط والحوار لتعزيز الفهم المتبادل، وصناديق الرمل التنظيمية للاختبار تحت الإشراف، والإرشادات والمعايير لاستخدام الذكاء الاصطناعي المسؤول، وبناء القدرات من خلال برامج التدريب وورش العمل.

يعد التعاون والشراكة بين المؤسسات المالية والهيئات التنظيمية أمرًا حيويًا للتنقل بفعالية في تعقيدات تنظيم نماذج الذكاء الاصطناعي والامتثال في المالية. من خلال العمل معًا، يمكن لأصحاب المصلحة معالجة التحديات التنظيمية، وتعزيز اعتماد الذكاء الاصطناعي المسؤول، وضمان الامتثال للمعايير الأخلاقية في اتخاذ القرار المالي (إفيجيموي، إيجيموفور، وأولوابي، 2023).

8. المخاطر المحتملة لاعتماد الذكاء الاصطناعي في اتخاذ القرار المالي

تنشأ مخاطر المساءلة من عدم اليقين بشأن المسؤولية عن القرارات المدفوعة بالذكاء الاصطناعي، مما يعقد تخصيص المساءلة عن الأخطاء، أو التحيزات، أو السلوك غير الأخلاقي والامتثال للمتطلبات القانونية والتنظيمية. تنشأ مخاطر التحيز من وراثة خوارزميات الذكاء الاصطناعي التحيزات من بيانات التدريب، مما قد يؤدي إلى نتائج متحيزة، وممارسات تمييزية، وأضرار سمعة، وعواقب غير مقصودة مثل تعزيز عدم المساواة أو إلحاق الضرر ببعض المجموعات (مانديتش، ستافيرسكا، وماليي، 2023).

9. الذكاء الاصطناعي والتداول الخوارزمي

1. تضخيم تقلبات السوق والمخاطر النظامية

2. نقص الإشراف البشري والتحكم

يمكن أن تجعل غموض نماذج الذكاء الاصطناعي، التي تُعرف غالبًا باسم “الصناديق السوداء”، من الصعب على البشر فهم العمليات الأساسية لاتخاذ القرار بالكامل. يمكن أن تعيق هذه الافتقار إلى الشفافية القدرة على تحديد وتصحيح التحيزات المحتملة، أو الأخطاء، أو العواقب غير المقصودة في الخوارزميات (كيريلينكو ولو، 2013). بالإضافة إلى ذلك، يمكن أن تجعل السرعة العالية التي تعمل بها هذه الخوارزميات من الصعب على المتداولين البشريين أو المنظمين التدخل واستعادة السيطرة في حالة حدوث خلل أو سلوك غير متوقع.

3. تحديات المساءلة

بالإضافة إلى ذلك، تثير الطبيعة العالمية للتداول الخوارزمي قضايا قضائية، حيث قد يتم تطوير أنظمة الذكاء الاصطناعي ونشرها عبر دول متعددة مع أطر تنظيمية متباينة. يمكن أن يؤدي هذا التجزؤ التنظيمي إلى خلق فجوات في الإشراف والمساءلة، مما قد يسمح للممارسات غير الأخلاقية بالمرور دون رادع. يتطلب معالجة هذه القضايا الأخلاقية نهجًا متعدد الأبعاد يتضمن التعاون بين المؤسسات المالية والهيئات التنظيمية ومطوري الذكاء الاصطناعي. تشمل الحلول المحتملة:

تنفيذ آليات إشراف بشري و”أزرار إيقاف” تسمح بالتدخل والسيطرة البشرية على خوارزميات التداول بالذكاء الاصطناعي في حالة حدوث أعطال أو سلوك غير متوقع.

تعزيز التعاون والتنظيم عبر الولايات القضائية لضمان وجود تدابير إشراف ومساءلة متسقة لأنظمة التداول الخوارزمية المدفوعة بالذكاء الاصطناعي.

تشجيع تدقيق الخوارزميات واختبارات الضغط لتحديد التحيزات المحتملة أو الأخطاء أو المخاطر النظامية المرتبطة بخوارزميات التداول بالذكاء الاصطناعي وتنفيذ تدابير للتخفيف من هذه المخاطر (برونديج وآخرون، 2018).

من خلال معالجة هذه القضايا الأخلاقية بشكل استباقي وتنفيذ تدابير الحماية المناسبة، يمكن لصناعة المالية استغلال قوة التداول الخوارزمي المدفوع بالذكاء الاصطناعي مع الحفاظ على نزاهة واستقرار ومعايير أخلاقية للنظام المالي العالمي.

10. اتخاذ القرارات الأخلاقية في تنفيذ الذكاء الاصطناعي

0.1 موازنة المسؤوليات بين البشر والذكاء الاصطناعي

- الإشراف البشري: من الضروري الحفاظ على الإشراف البشري لضمان المساءلة والشفافية والاعتبارات الأخلاقية. يتحمل البشر مسؤولية تحديد الأهداف، وتصميم خوارزميات الذكاء الاصطناعي، وتفسير النتائج، واتخاذ القرارات النهائية بناءً على المبادئ الأخلاقية.

- قدرات الذكاء الاصطناعي وقيوده: فهم قدرات وقيود أنظمة الذكاء الاصطناعي أمر حاسم لتحديد مدى الاستقلالية التي يمكن أن تتمتع بها في اتخاذ القرار. يجب على البشر التدخل عندما تصل أنظمة الذكاء الاصطناعي إلى حدودها أو تواجه معضلات أخلاقية تتطلب حكمًا بشريًا.

0.2 دمج الاعتبارات الأخلاقية

- الأطر الأخلاقية: يعد إنشاء أطر أخلاقية واضحة وإرشادات لنشر الذكاء الاصطناعي أمرًا ضروريًا لضمان عمل أنظمة الذكاء الاصطناعي بما يتماشى مع المبادئ الأخلاقية. يجب أن تتناول هذه الأطر قضايا مثل العدالة والشفافية والمساءلة والخصوصية والتخفيف من التحيز.

- تقييمات الأثر الأخلاقي: يمكن أن تساعد إجراء تقييمات الأثر الأخلاقي قبل نشر أنظمة الذكاء الاصطناعي في تحديد المخاطر الأخلاقية المحتملة والآثار المترتبة. تتضمن هذه العملية تقييم كيفية تأثير قرارات الذكاء الاصطناعي على مختلف أصحاب المصلحة وضمان دمج الاعتبارات الأخلاقية في مراحل التصميم والتنفيذ.

- لجان الأخلاقيات: يمكن أن تساعد إنشاء لجان الأخلاقيات أو المجالس الاستشارية داخل المنظمات في توجيه اتخاذ القرارات الأخلاقية في تنفيذ الذكاء الاصطناعي. يمكن أن تستعرض هذه اللجان مشاريع الذكاء الاصطناعي، وتقييم الآثار الأخلاقية، وتقديم توصيات لمعالجة القضايا الأخلاقية.

0.3 الشفافية وقابلية التفسير

- الشفافية: يعد ضمان الشفافية في عمليات اتخاذ القرار بالذكاء الاصطناعي أمرًا أساسيًا لبناء الثقة والمساءلة. يجب على المنظمات أن تكون شفافة بشأن كيفية اتخاذ أنظمة الذكاء الاصطناعي للقرارات، والبيانات التي تستخدمها، والاحتمالات أو القيود المحتملة في خوارزمياتها.

- قابلية التفسير: يجب تصميم أنظمة الذكاء الاصطناعي لتقديم تفسيرات لقراراتها بوضوح وسهولة الفهم. يساعد الذكاء الاصطناعي القابل للتفسير المستخدمين وأصحاب المصلحة والجهات التنظيمية على فهم الأسباب وراء قرارات الذكاء الاصطناعي واكتشاف أي تحيزات أو أخطاء.

0.4 المراقبة والتقييم المستمر

آليات التغذية الراجعة: يمكن أن تساعد تنفيذ آليات التغذية الراجعة التي تسمح للمستخدمين وأصحاب المصلحة بتقديم مدخلات حول قرارات الذكاء الاصطناعي المنظمات في تحسين الأداء الأخلاقي لأنظمة الذكاء الاصطناعي بمرور الوقت. تتيح حلقات التغذية الراجعة المراقبة والتقييم المستمر لسلوك الذكاء الاصطناعي من منظور أخلاقي.

11. حوكمة الذكاء الاصطناعي والإطار التنظيمي

أ. إنشاء لجان أو مجالس أخلاقيات الذكاء الاصطناعي

ب. تطوير إرشادات ومعايير خاصة بالصناعة

العدالة والشفافية والمساءلة والخصوصية، مع مراعاة أيضًا المشهد التنظيمي والواقع التشغيلي للقطاع (برونديج وآخرون، 2018). يمكن أن يسهل التعاون بين المؤسسات المالية والهيئات التنظيمية وأصحاب المصلحة المعنيين إنشاء إرشادات شاملة ومقبولة على نطاق واسع، مما يعزز التناسق ويعزز أفضل الممارسات عبر الصناعة.

ج. دور الهيئات التنظيمية في الإشراف على اعتماد الذكاء الاصطناعي

يمكن للهيئات التنظيمية التعاون مع أصحاب المصلحة في الصناعة وخبراء الذكاء الاصطناعي لتطوير إرشادات ومعايير للاستخدام المسؤول للذكاء الاصطناعي في المالية. يمكن أن تساعد هذه المقاربة التعاونية في تحقيق توازن بين تعزيز الابتكار والتخفيف من المخاطر المحتملة، مع ضمان تضمين الاعتبارات الأخلاقية في تطوير ونشر أنظمة الذكاء الاصطناعي.

من خلال تنفيذ آليات حوكمة قوية وأطر تنظيمية، يمكن للقطاع المالي استغلال الإمكانات التحويلية للذكاء الاصطناعي مع إعطاء الأولوية للمبادئ الأخلاقية وحماية مصالح جميع أصحاب المصلحة. هذه المقاربة الاستباقية ضرورية للحفاظ على ثقة الجمهور، وضمان ممارسات عادلة ومنصفة، وتعزيز نظام مالي مستدام ومسؤول.

12. دراسات حالة وأفضل الممارسات

أ. تسليط الضوء على أطر الذكاء الاصطناعي الأخلاقية الناجحة

مثال آخر هو البنك الإمبراطوري الكندي للتجارة (CIBC)، الذي طور مدونة أخلاقيات الذكاء الاصطناعي وأنشأ مجلس أخلاقيات الذكاء الاصطناعي للإشراف على تنفيذ ممارسات الذكاء الاصطناعي الأخلاقية (Robertson et al., 2021). يتضمن المجلس ممثلين من مختلف الأقسام، بما في ذلك إدارة المخاطر، والقانونية، والامتثال، مما يضمن نهجًا شاملاً لمعالجة القضايا الأخلاقية.

ب. الدروس المستفادة من الانتهاكات الأخلاقية والجدل

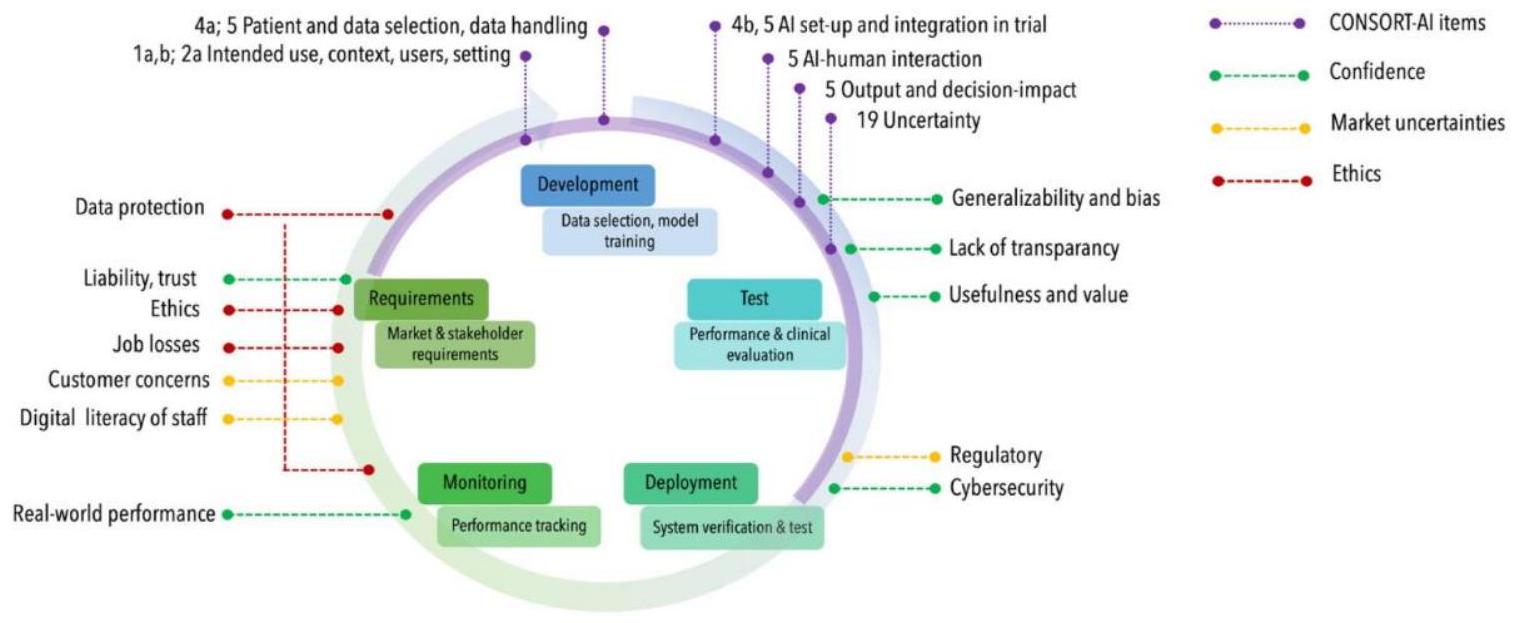

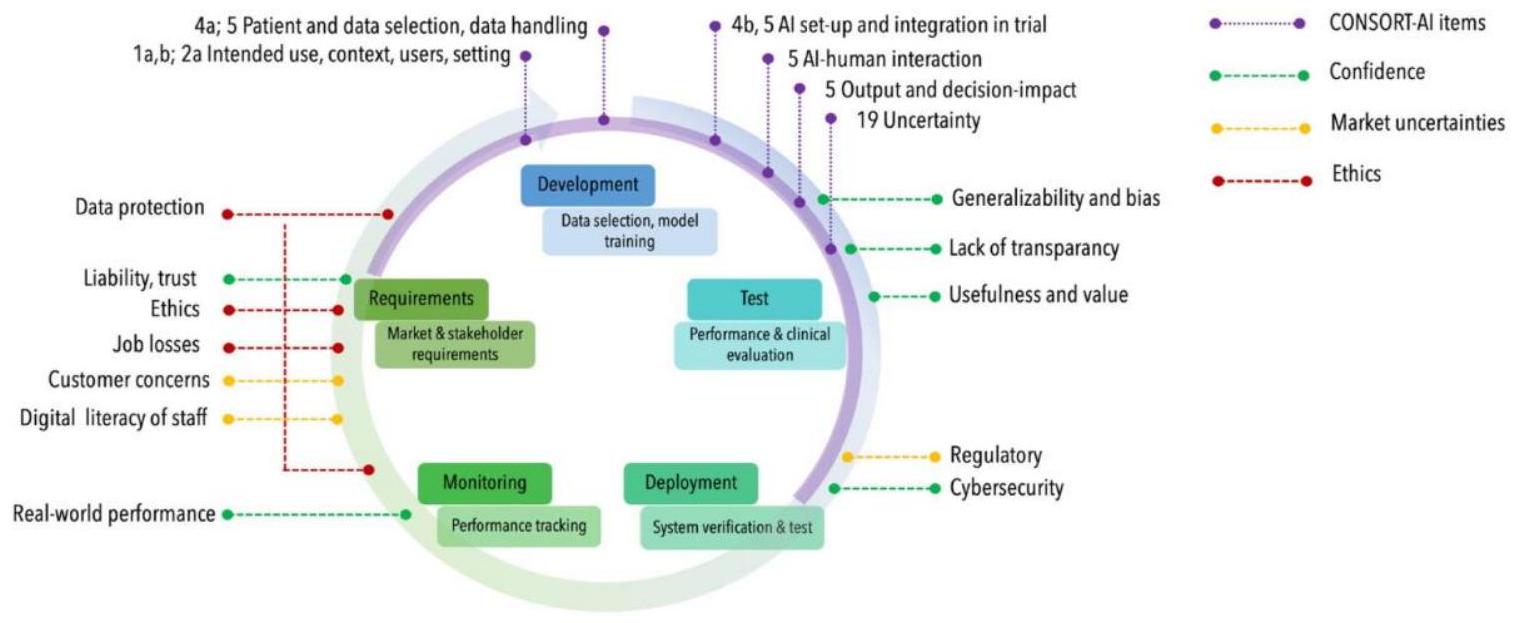

حالة بارزة أخرى تتعلق باستخدام تقنية التعرف على الوجه المدعومة بالذكاء الاصطناعي من قبل المؤسسات المالية لأغراض التحقق من الهوية. أثار هذا الممارسة مخاوف بشأن الخصوصية والتمييز المحتمل، حيث أظهرت خوارزميات التعرف على الوجه تحيزات بناءً على العرق والجنس (Brundage et al., 2018). تؤكد هذه الحوادث على الحاجة إلى أطر حوكمة قوية، ورصد مستمر، ودمج الاعتبارات الأخلاقية في جميع مراحل دورة حياة الذكاء الاصطناعي.

ج. أفضل الممارسات لتعزيز الشفافية والمساءلة والعدالة

- تنفيذ تقنيات الذكاء الاصطناعي القابل للتفسير (XAI) لتعزيز الشفافية وقابلية تفسير نماذج الذكاء الاصطناعي، مما يمكّن أصحاب المصلحة من فهم عمليات اتخاذ القرار وتحديد التحيزات المحتملة.

- إجراء تدقيقات خوارزمية منتظمة واختبارات تحيز لتحديد وتخفيف النتائج التمييزية المحتملة والمعاملة غير العادلة لمجموعات معينة.

- تأسيس فرق متنوعة وشاملة في تطوير ونشر أنظمة الذكاء الاصطناعي، مع دمج وجهات نظر وتجارب متنوعة لتقليل خطر استمرار التحيزات (Floridi & Cowls, 2019).

- تعزيز تعليم المستهلكين والوعي بشأن استخدام الذكاء الاصطناعي في اتخاذ القرارات المالية، مما يمكّن الأفراد من اتخاذ خيارات مستنيرة ومحاسبة المؤسسات.

من خلال الاستفادة من هذه الممارسات الجيدة والتعلم من كل من التنفيذات الناجحة والانتهاكات الأخلاقية، يمكن للقطاع المالي تعزيز ممارسات اعتماد الذكاء الاصطناعي الأخلاقي، مما يعزز الثقة والعدالة والمساءلة في عمليات اتخاذ القرار المدفوعة بالذكاء الاصطناعي.

13. الخاتمة

للتنقل عبر التحديات الأخلاقية وتعظيم إمكانات الذكاء الاصطناعي في الاقتصاد، هناك دعوة واضحة لتطوير إرشادات قوية تعزز اعتماد أدوار الذكاء الاصطناعي الأخلاقي. يتطلب نهج متوازن لاعتماد الذكاء الاصطناعي دمج الاعتبارات الأخلاقية في كل مرحلة من مراحل تنفيذ الذكاء الاصطناعي، من التصميم والتطوير إلى التنفيذ. من خلال إعطاء الأولوية للمعايير الأخلاقية، والشفافية، وضمان المشاركة البشرية في اتخاذ القرار بالذكاء الاصطناعي، يمكن للصناعة المالية استغلال الإمكانات الكاملة للذكاء الاصطناعي مع تقليل المخاطر الأخلاقية وحماية مصالح أصحاب المصلحة. تعتبر جهود التنظيم، وأصحاب المصلحة في الصناعة، والتعاون بين الذكاء الاصطناعي والمطورين أمرًا أساسيًا.

الشكر والتقدير

مساهمات المؤلفين

برينس سي. أوشي: قدم رؤى حاسمة حول الجوانب النظرية، وساهم في تطوير المفاهيم، وراجع المخطوطة من حيث الوضوح والتماسك.

ناثانييل تي. أدينيكن: ساهم في تطوير الإطار النظري، وجمع نتائج الأدبيات، وقدم مدخلات فكرية كبيرة للمخطوطة.

كريستوفر إهيجيركا: قدم خبرته في مراجعة وإعادة مراجعة المخطوطات، وقدم وجهات نظر نظرية قيمة، وراجع المخطوطة بشكل نقدي.

رياض بن إسلام: شارك في المناقشات المفاهيمية، وقدم رؤى نظرية، وساعد في تحسين المخطوطة.

بيشال جونغ ثابا تشيتري: قدم الدعم في الجدال النظري، وقام بتقييم مصادر الأدبيات بشكل نقدي، وراجع المخطوطة من حيث التناسق المفاهيمي.

التمويل

المصالح المتنافسة

الموافقة المستنيرة

موافقة الأخلاقيات

تلتزم سياسات المجلة بالممارسات الأساسية التي وضعتها لجنة أخلاقيات النشر (COPE).

الأصل والمراجعة من قبل الأقران

بيان توفر البيانات

بيان مشاركة البيانات

الوصول المفتوح

حقوق الطبع والنشر

References

Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … Amodei, D. (2018). The malicious use of artificial intelligence: Forecasting, prevention, and mitigation. ArXiv preprint arXiv:1802.07228. Retrieved from https://arxiv.org/abs/1802.07228

Castelnovo, A. (2024). Towards Responsible AI in Banking: Addressing Bias for Fair Decision-Making.

Efijemue, O., Ejimofor, I., & Owolabi, O. (2023). Insider Threat Prevention in the US Banking System. International Journal on Soft Computing. https://doi.org/10.5121/ijsc.2023.14302

Fabrègue, B. F. G., & Bogoni, A. (2023). Privacy and Security Concerns in the Smart City. Smart Cities, 6(1), 586-613. https://doi.org/10.3390/smartcities6010027

Financial Stability Board. (2020). Artificial intelligence and machine learning in financial services. Retrieved from https://www.fsb.org/wp-content/uploads/P011117.pdf

Floridi, L., & Cowls, J. (2019). A unified framework of five principles for AI in society. Harvard Data Science Review, 1(1). https://doi.org/10.1162/99608f92.8cd550d1

Jiménez, J. I. (2023). Wine NFT cryptoassets: EU regulatory issues and market challenges. BIO Web Conf., 68, 03026, 1-10. https://doi.org/10.1051/bioconf/20236803026

Kirilenko, A., & Lo, A. W. (2013). Moore’s law versus Murphy’s law: Algorithmic trading and its discontents. Journal of Economic Perspectives, 27(2), 51-72. https://doi.org/10.1257/jep.27.2.51

Kirilenko, A., Kyle, A. S., Samadi, M., & Tuzun, T. (2017). The flash crash: High-frequency trading in an electronic market. The Journal of Finance, 72(3), 967-998. https://doi.org/10.1111/jofi. 12498

Mandych, O., Staverska, T., & Maliy, O. (2023). Integration of Artificial Intelligence into the Blockchain and Cryptocurrency Market. https://doi.org/10.31891/mdes/2023-10-8

OECD. (2023). Generative artificial intelligence in finance. OECD Artificial Intelligence Papers, 9. https://doi.org/10.1787/ac7149cc-en

Olatoye, F. O., Awonuga, K. F., Mhlongo, N. Z., Ibeh, C. V., Elufioye, O. A., & Ndubuisi, N. L. (2024). AI and ethics in business: A comprehensive review of responsible AI practices and corporate responsibility.

Pavashe, A. S., Kadam, P. D., Zirange, V. B., & Katkar, R. D. (2023). The Impact of Artificial Intelligence on Employment and Workforce Trends in the Post-Pandemic Era. https://doi.org/10.22214/ijraset.2023.56418

Saikanth, D. R. K. (2024). The Impact of Emerging Technologies on Sustainable Agriculture and Rural Development. IJECC, 14(1), 253-263. https://doi.org/10.9734/ijecc/2024/v14i13830

Schwendicke, F., & Krois, J. (2021). Better Reporting of Studies on Artificial Intelligence: CONSORT-AI and Beyond. Journal of Dental Research, 100(7), 677-680. https://doi.org/10.1177/0022034521998337

DOI: https://doi.org/10.5539/cis.v17n1p49

Publication Date: 2024-04-30

Ethical Implication of Artificial Intelligence (AI) Adoption in Financial Decision Making

doi:10.5539/cis.v17n1p49

URL: https://doi.org/10.5539/cis.v17n1p49

Abstract

The integration of artificial intelligence (AI) into the financial sector has raised ethical concerns that need to be addressed. This paper analyzes the ethical implications of using AI in financial decision-making and emphasizes the importance of an ethical framework to ensure its fair and trustworthy deployment. The study explores various ethical considerations, including the need to address algorithmic bias, promote transparency and explainability in AI systems, and adhere to regulations that protect equity, accountability, and public trust. By synthesizing research and empirical evidence, the paper highlights the complex relationship between AI innovation and ethical integrity in finance. To tackle this issue, the paper proposes a comprehensive and actionable ethical framework that advocates for clear guidelines, governance structures, regular audits, and collaboration among stakeholders. This framework aims to maximize the potential of AI while minimizing negative impacts and unintended consequences. The study serves as a valuable resource for policymakers, industry professionals, researchers, and other stakeholders, facilitating informed discussions, evidence-based decision-making, and the development of best practices for responsible AI integration in the financial sector. The ultimate goal is to ensure fairness, transparency, and accountability while reaping the benefits of AI for both the financial sector and society.

1. Introduction

2. Ethical Frameworks in Financial Decision-Making

3. Transparency and Accountability in AI Algorithms

and users of AI accountable for the outcomes of their decisions, thereby promoting ethical and informed decision-making in the financial sector. Without transparency and accountability, there is a risk of perpetuating existing biases, discriminating against certain groups, and causing distrust in the AI systems that underpin financial decision-making.

4. Bias and Fairness in AI Decision-Making

5. Privacy and Data Security Concerns

The Organization for Economic Cooperation and Development (OECD) AI principles and guidelines also purported that the quality and adequacy of data processing and representation are associated with risks of misleading model output and inaccurate or unreliable models. Data privacy challenges are considerable in GenAI due to the large number of data sets, which they are trained on and can also come from any public source. These are likely to contain IP-protected information, possibly without appropriate permission or copyright, raising additional issues regarding the authenticity of outputs. Best practices for data management and governance practices can be considered to ensure data quality, data sufficiency based on intended use, data privacy when financial client data is fed into the model, and authenticity of the data when relevant and appropriate source attribution/copyright are

informed of the subject matter. In this case, informed consent can be obtained for that purpose (Pavashe, Kadam, Zirange, & Katkar, 2023). Protecting active data in transit and in use is crucial to maintaining the confidentiality, integrity, and availability of critical information (Jiménez, 2023).

6. Impact on Employment and Workforce

However, it is important to note that AI will create new jobs in areas such as data analysis, machine learning, and AI programming. As the world expands in AI and financial services, companies will need to re-evaluate their workforce and provide training to adapt to the changing landscape of their industry. The impact of AI on jobs and the workforce will depend on how organizations manage the transition and invest in modernizing their workforce for the future (OECD, 2023).

7. Regulatory Challenges and Compliance Issues

The complexities of AI model regulation and compliance include the opacity and explainability of AI models, which can operate as “black boxes” and lack transparency and accountability. Bias and fairness are also concerns, as AI models can inherit biases present in training data. Additionally, the dynamic nature of AI poses challenges for traditional regulatory frameworks that may struggle to keep pace with technological advancements.

Collaboration strategies with regulatory bodies involve engagement and dialogue to enhance mutual understanding, regulatory sandboxes for testing under supervision, guidance and standards for responsible AI use, and capacity building through training programs and workshops.

Collaboration and partnership between financial institutions and regulatory bodies are crucial for effectively navigating the complexities of AI model regulation and compliance in finance. By working together, stakeholders can address regulatory challenges, promote responsible AI adoption, and ensure compliance with ethical standards in financial decision-making (Efijemue, Ejimofor, & Owolabi, 2023).

8. Potential Risks of AI Adoption in Financial Decision-Making

Accountability risks arise from uncertainties regarding responsibility for AI-driven decisions, complicating assigning accountability for errors, biases, or unethical conduct and complying with legal and regulatory requirements. Bias risks stem from AI algorithms inheriting biases from training data, potentially resulting in biased outcomes, discriminatory practices, reputational damage, and unintentional consequences such as perpetuating inequalities or disadvantaging certain groups (Mandych, Staverska, & Maliy, 2023).

9. AI and Algorithmic Trading

1. Amplifying Market Volatility and Systemic Risks

2. Lack of Human Oversight and Control

The opacity of AI models, often referred to as “black boxes,” can make it challenging for humans to fully understand the underlying decision-making processes. This lack of transparency can hinder the ability to identify and correct potential biases, errors, or unintended consequences in the algorithms (Kirilenko & Lo, 2013). Additionally, the high speed at which these algorithms operate can make it difficult for human traders or regulators to intervene and regain control in the event of a malfunction or unexpected behavior.

3. Accountability Challenges

In addition, the global nature of algorithmic trading raises jurisdictional issues, as AI systems may be developed and deployed across multiple countries with varying regulatory frameworks. This regulatory fragmentation can create gaps in oversight and accountability, potentially allowing unethical practices to slip through the cracks. Addressing these ethical concerns requires a multi-faceted approach involving collaboration between financial institutions, regulatory bodies, and AI developers. Potential solutions include:

Implementing human oversight mechanisms and “kill switches” that allow human intervention and control over AI trading algorithms in case of malfunctions or unexpected behavior.

Enhancing regulatory cooperation and harmonization across jurisdictions to ensure consistent oversight and accountability measures for AI-driven algorithmic trading systems.

Promoting algorithmic audits and stress testing to identify potential biases, errors, or systemic risks associated with AI trading algorithms and implementing measures to mitigate these risks (Brundage et al., 2018).

Addressing these ethical concerns proactively and implementing appropriate safeguards, the financial industry can harness the power of AI-driven algorithmic trading while maintaining the integrity, stability, and ethical standards of the global financial system.

10. Ethical Decision-Making in AI Implementation

0.1 Balancing Human and AI Responsibilities

- Human Oversight: It is essential to maintain human oversight to ensure accountability, transparency, and ethical considerations. Humans are responsible for setting the objectives, designing the AI algorithms, interpreting the results, and making final decisions based on ethical principles.

- AI Capabilities and Limitations: Understanding the capabilities and limitations of AI systems is crucial for determining the extent of autonomy they can have in decision-making. Humans should intervene when AI systems reach their limits or encounter ethical dilemmas that require human judgment.

0.2 Integrating Ethical Considerations

- Ethical Frameworks: Establishing clear ethical frameworks and guidelines for AI deployment is essential to ensure that AI systems operate in alignment with ethical principles. These frameworks should address issues such as fairness, transparency, accountability, privacy, and bias mitigation.

- Ethical Impact Assessments: Conducting ethical impact assessments before deploying AI systems can help identify potential ethical risks and implications. This process involves evaluating how AI decisions may impact various stakeholders and ensuring that ethical considerations are integrated into the design and implementation phases.

- Ethics Committees: Establishing ethics committees or advisory boards within organizations can guide ethical decision-making in AI implementation. These committees can review AI projects, assess ethical implications, and provide recommendations for addressing ethical concerns.

0.3 Transparency and Explainability

- Transparency: Ensuring transparency in AI decision-making processes is essential for building trust and accountability. Organizations should be transparent about how AI systems make decisions, the data they use, and the potential biases or limitations in their algorithms.

- Explainability: AI systems should be designed to provide explanations for their decisions clearly and understandably. Explainable AI helps users, stakeholders, and regulators understand the reasoning behind AI decisions and detect any biases or errors.

0.4 Continuous Monitoring and Evaluation

Feedback Mechanisms: Implementing feedback mechanisms that allow users and stakeholders to provide input on AI decisions can help organizations improve the ethical performance of AI systems over time. Feedback loops enable continuous monitoring and evaluation of AI behavior from an ethical perspective.

11. AI Governance and Regulatory Framework

A. Establishing AI Ethics Boards or Committees

B. Developing Industry-Specific Guidelines and Standards

fairness, transparency, accountability, and privacy, while also considering the sector’s regulatory landscape and operational realities (Brundage et al., 2018). Collaboration among financial institutions, regulatory bodies, and relevant stakeholders can facilitate the creation of comprehensive and widely accepted guidelines, fostering consistency and promoting best practices across the industry.

C. Role of Regulatory Bodies in Overseeing AI Adoption

Regulatory bodies can collaborate with industry stakeholders and AI experts to develop guidelines and standards for the responsible use of AI in finance. This collaborative approach can help strike a balance between fostering innovation and mitigating potential risks, while also ensuring that ethical considerations are embedded in the development and deployment of AI systems.

By implementing robust governance mechanisms and regulatory frameworks, the financial sector can harness the transformative potential of AI while prioritizing ethical principles and safeguarding the interests of all stakeholders. This proactive approach is essential for maintaining public trust, ensuring fair and equitable practices, and fostering a sustainable and responsible financial ecosystem.

12. Case Studies and Best Practices

A. Highlighting Successful Ethical AI Frameworks

Another example is the Canadian Imperial Bank of Commerce (CIBC), which has developed an AI Ethics Code and established an AI Ethics Council to oversee the implementation of ethical AI practices (Robertson et al., 2021). The council includes representatives from various departments, including risk management, legal, and compliance, ensuring a comprehensive approach to addressing ethical concerns.

B. Lessons Learned from Ethical Breaches and Controversies

Another notable case involved the use of AI-powered facial recognition technology by financial institutions for identity verification purposes. This practice raised concerns about privacy and potential discrimination, as facial recognition algorithms have been shown to exhibit biases based on race and gender (Brundage et al., 2018). These incidents underscore the need for robust governance frameworks, continuous monitoring, and the integration of ethical considerations throughout the entire AI lifecycle.

C. Best Practices for Promoting Transparency, Accountability, and Fairness

- Implementing explainable AI (XAI) techniques to enhance transparency and interpretability of AI models, enabling stakeholders to understand the decision-making processes and identify potential biases.

- Conducting regular algorithmic audits and bias testing to identify and mitigate potential discriminatory outcomes and unfair treatment of specific groups.

- Establishing diverse and inclusive teams in the development and deployment of AI systems, incorporating diverse perspectives and experiences to reduce the risk of perpetuating biases (Floridi & Cowls, 2019).

- Promoting consumer education and awareness about the use of AI in financial decision-making, empowering individuals to make informed choices and hold institutions accountable.

By leveraging these best practices and learning from both successful implementations and ethical breaches, the financial sector can enhance its ethical AI adoption practices, fostering trust, fairness, and accountability in AI-driven decision-making processes.

13. Conclusion

To navigate ethical challenges and maximize the potential of AI in the economy, there is a clear call for the development of strong guidelines that promote the adoption and adoption of ethical AI roles. A balanced approach to AI adoption requires the integration of ethical considerations at every stage of AI implementation, from design and development to implementation. By prioritizing ethical standards, transparency, and ensuring human participation in AI decision-making, the financial industry can harness the full potential of AI while minimizing ethical risks and protecting the interests of stakeholders. Regulators, industry stakeholders, and collaborative efforts between AI and developers are essential.

Acknowledgments

Authors contributions

Prince C. Uche: Provided critical insights into the theoretical aspects, contributed to the development of concepts, and revised the manuscript for clarity and coherence.

Nathaniel T. Adeniken: Contributed to the theoretical framework development, synthesized literature findings, and provided substantial intellectual input to the manuscript.

Christopher Ihejirika: Offered expertise in reviewing and re-reviewing manuscripts, provided valuable theoretical perspectives, and critically reviewed and revised the manuscript.

Riyad Bin Islam: Participated in conceptual discussions, contributed theoretical insights, and assisted in manuscript refinement.

Bishal Jung Thapa Chhetri: Provided support in theoretical argumentation, critically evaluated literature sources, and revised the manuscript for conceptual consistency.

Funding

Competing interests

Informed consent

Ethics approval

The journal’s policies adhere to the Core Practices established by the Committee on Publication Ethics (COPE).

Provenance and peer review

Data availability statement

Data sharing statement

Open access

Copyrights

References

Brundage, M., Avin, S., Clark, J., Toner, H., Eckersley, P., Garfinkel, B., … Amodei, D. (2018). The malicious use of artificial intelligence: Forecasting, prevention, and mitigation. ArXiv preprint arXiv:1802.07228. Retrieved from https://arxiv.org/abs/1802.07228

Castelnovo, A. (2024). Towards Responsible AI in Banking: Addressing Bias for Fair Decision-Making.

Efijemue, O., Ejimofor, I., & Owolabi, O. (2023). Insider Threat Prevention in the US Banking System. International Journal on Soft Computing. https://doi.org/10.5121/ijsc.2023.14302

Fabrègue, B. F. G., & Bogoni, A. (2023). Privacy and Security Concerns in the Smart City. Smart Cities, 6(1), 586-613. https://doi.org/10.3390/smartcities6010027

Financial Stability Board. (2020). Artificial intelligence and machine learning in financial services. Retrieved from https://www.fsb.org/wp-content/uploads/P011117.pdf

Floridi, L., & Cowls, J. (2019). A unified framework of five principles for AI in society. Harvard Data Science Review, 1(1). https://doi.org/10.1162/99608f92.8cd550d1

Jiménez, J. I. (2023). Wine NFT cryptoassets: EU regulatory issues and market challenges. BIO Web Conf., 68, 03026, 1-10. https://doi.org/10.1051/bioconf/20236803026

Kirilenko, A., & Lo, A. W. (2013). Moore’s law versus Murphy’s law: Algorithmic trading and its discontents. Journal of Economic Perspectives, 27(2), 51-72. https://doi.org/10.1257/jep.27.2.51

Kirilenko, A., Kyle, A. S., Samadi, M., & Tuzun, T. (2017). The flash crash: High-frequency trading in an electronic market. The Journal of Finance, 72(3), 967-998. https://doi.org/10.1111/jofi. 12498

Mandych, O., Staverska, T., & Maliy, O. (2023). Integration of Artificial Intelligence into the Blockchain and Cryptocurrency Market. https://doi.org/10.31891/mdes/2023-10-8

OECD. (2023). Generative artificial intelligence in finance. OECD Artificial Intelligence Papers, 9. https://doi.org/10.1787/ac7149cc-en

Olatoye, F. O., Awonuga, K. F., Mhlongo, N. Z., Ibeh, C. V., Elufioye, O. A., & Ndubuisi, N. L. (2024). AI and ethics in business: A comprehensive review of responsible AI practices and corporate responsibility.

Pavashe, A. S., Kadam, P. D., Zirange, V. B., & Katkar, R. D. (2023). The Impact of Artificial Intelligence on Employment and Workforce Trends in the Post-Pandemic Era. https://doi.org/10.22214/ijraset.2023.56418

Saikanth, D. R. K. (2024). The Impact of Emerging Technologies on Sustainable Agriculture and Rural Development. IJECC, 14(1), 253-263. https://doi.org/10.9734/ijecc/2024/v14i13830

Schwendicke, F., & Krois, J. (2021). Better Reporting of Studies on Artificial Intelligence: CONSORT-AI and Beyond. Journal of Dental Research, 100(7), 677-680. https://doi.org/10.1177/0022034521998337