DOI: https://doi.org/10.1038/s41586-024-08422-9

PMID: https://pubmed.ncbi.nlm.nih.gov/39843736

تاريخ النشر: 2025-01-22

الاتجاهات الإقليمية والمؤسسية في التقييم للترقية الأكاديمية

تاريخ الاستلام: 1 يونيو 2023

تم القبول: 18 نوفمبر 2024

نُشر على الإنترنت: 22 يناير 2025

الوصول المفتوح

تحقق من التحديثات

الملخص

يُنظر إلى تقييم أداء البحث على أنه أداة حيوية في الحفاظ على أعلى معايير الجودة، حيث يُعتقد أن الاختيار والمنافسة يدفعان التقدم. تحتاج المؤسسات الأكاديمية إلى اتخاذ قرارات حاسمة بشأن التوظيف والترقية، بينما تواجه ضغطًا خارجيًا من خلال كونها خاضعة أيضًا لتقييم البحث.

التصنيفات

تصميم الدراسة

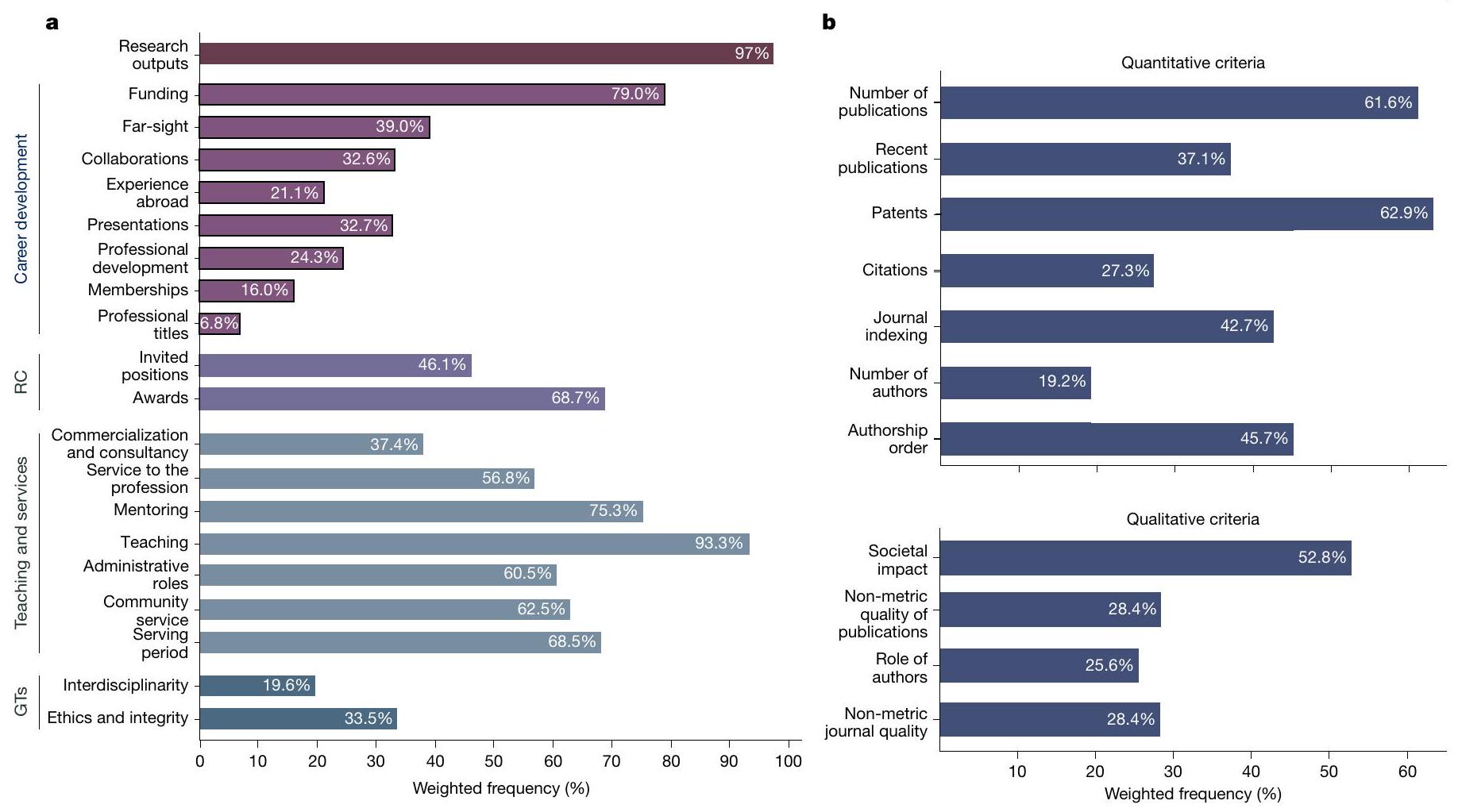

نظرة عامة على معايير الترقية

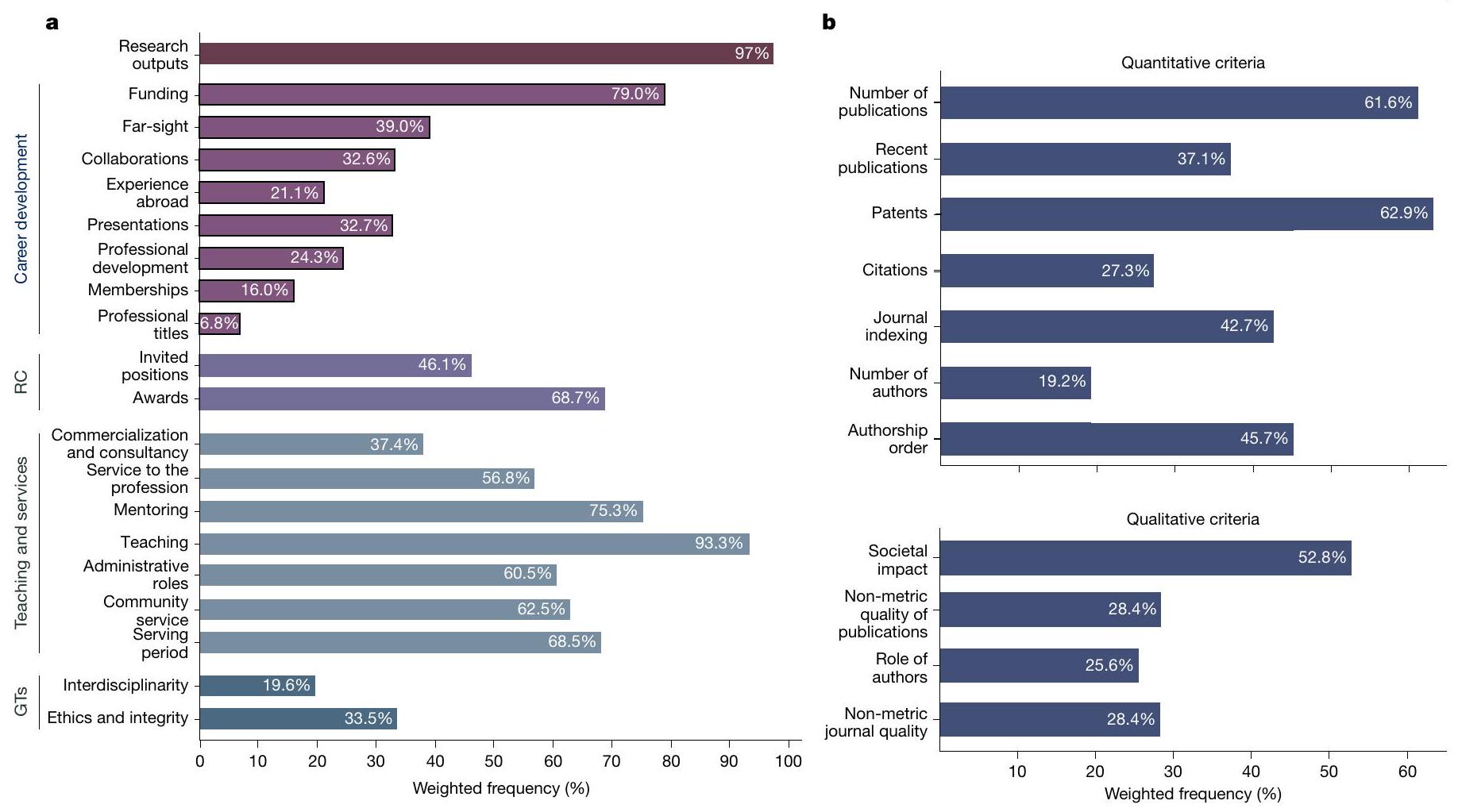

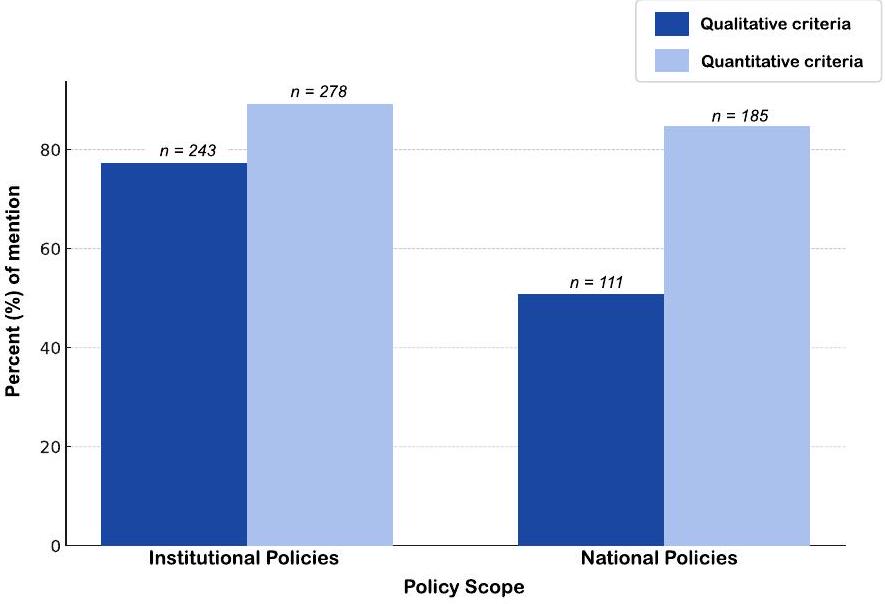

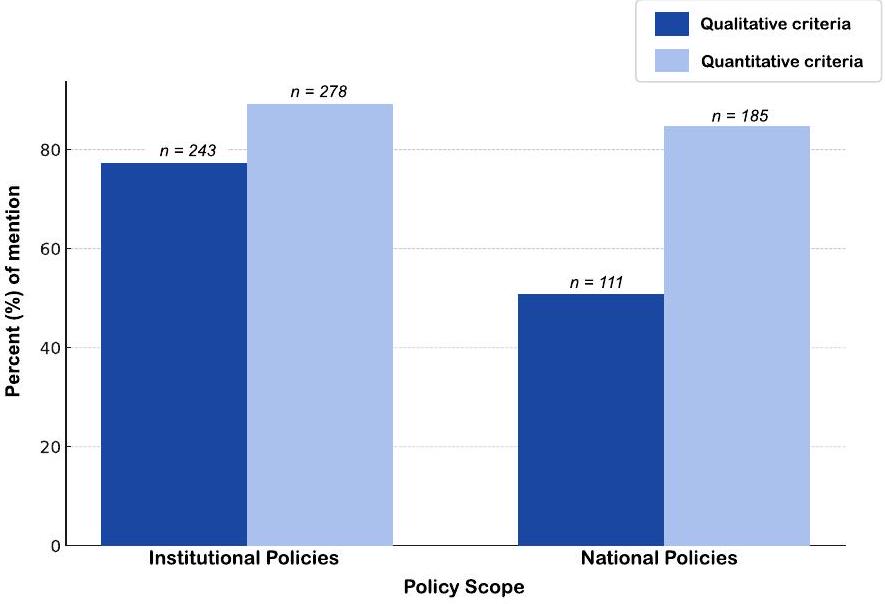

البحث، التعليم والخدمات. حددنا 30 معيارًا رئيسيًا عبر 5 فئات: مخرجات البحث؛ تطوير المهنة؛ الاعتراف؛ التعليم والخدمة؛ والسمات العامة. ضمن مخرجات البحث، تم تحديد 11 معيارًا كإما ‘كمية’ (مبنية على المقاييس؛ على سبيل المثال، البيبليومترية) أو ‘نوعية’ (وصف سردي و/أو مراجعة من قبل الأقران) (قسم الطرق 2.3 “المعايير والفئات”، الجدول الإضافي 3، قسم المعلومات التكميلية 1.3 والجدول التكميلية 1).

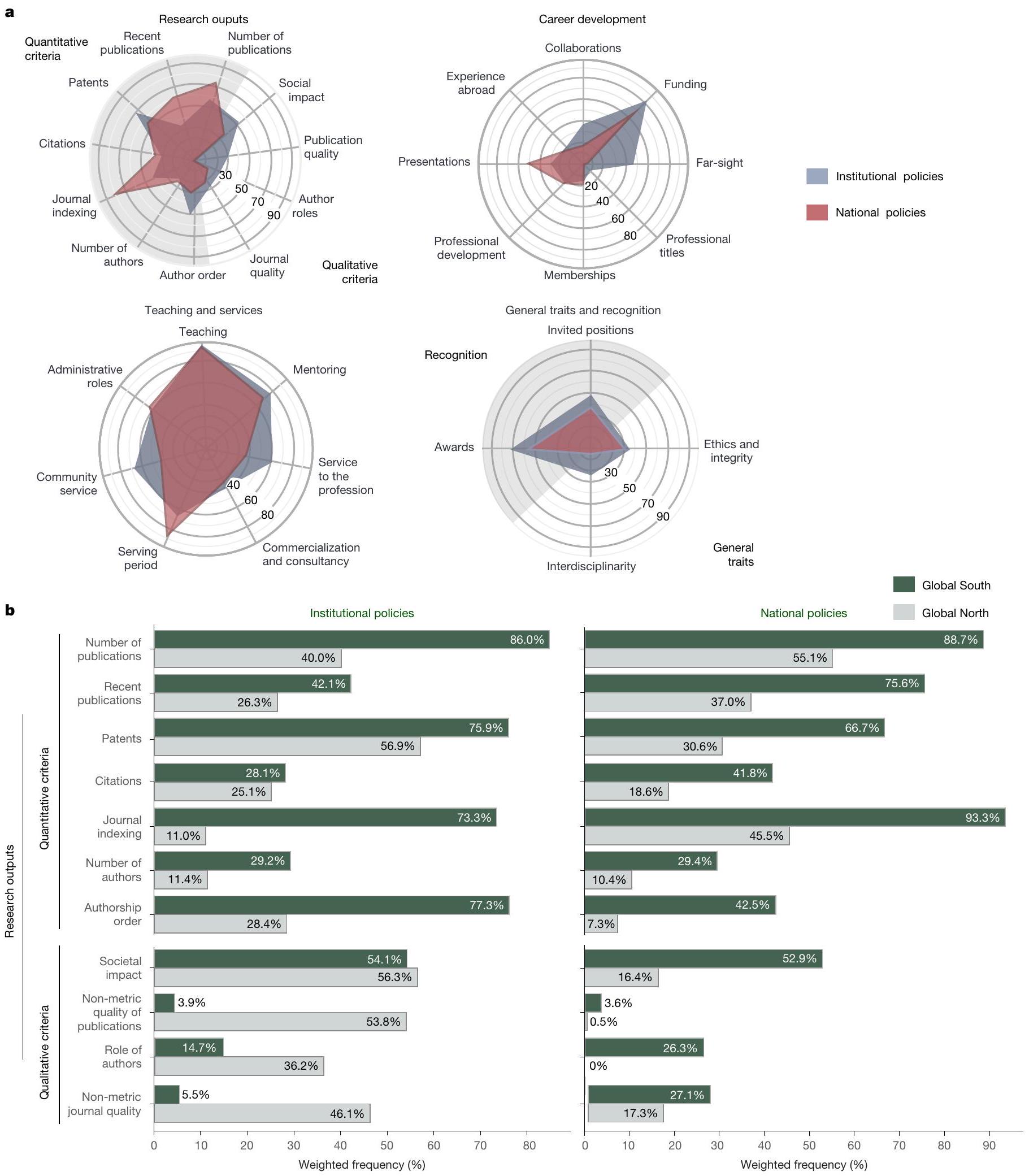

الاختلافات الإقليمية والمؤسسية

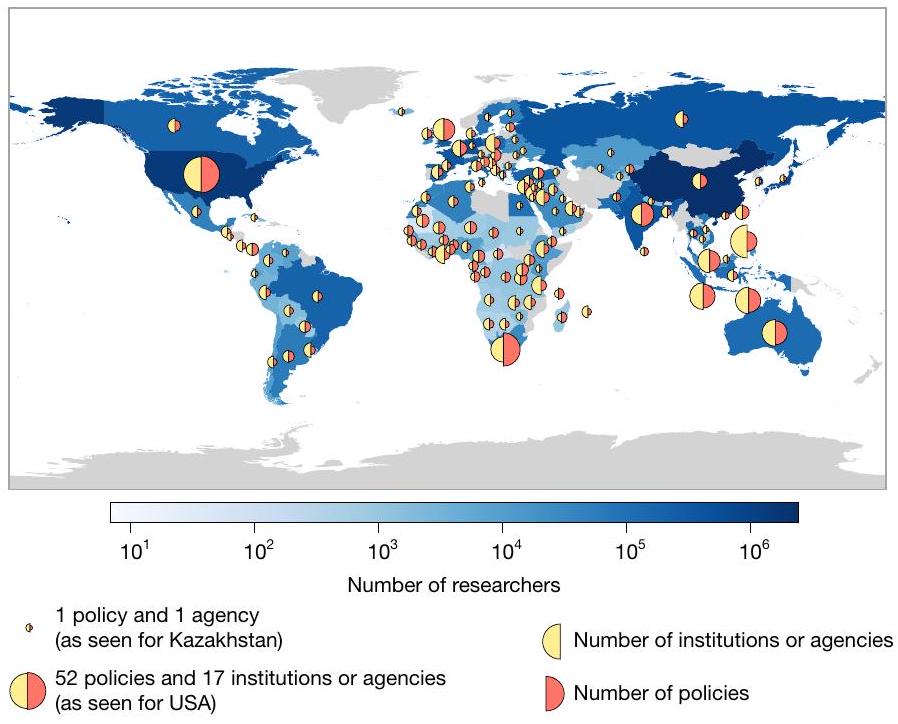

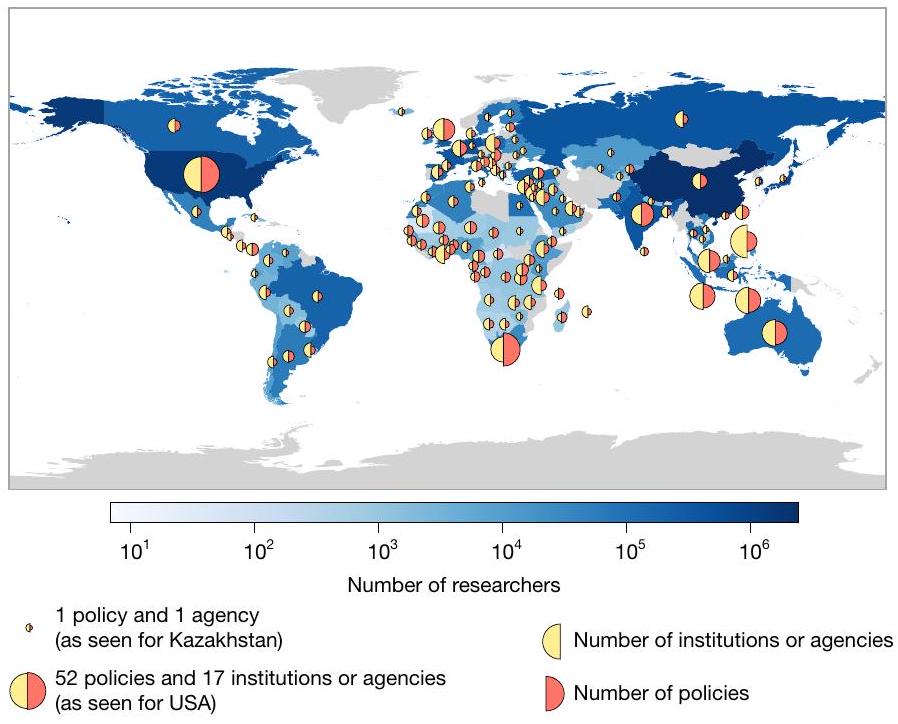

على المستوى البسيط للترددات الملحوظة، نجد نسبة أعلى من السياسات في الجنوب العالمي (

المقاييس (كلاهما عند

المنطقة، التخصص، المسار والوضع الاقتصادي للبلد موفرة في الجدول التكميلي 5.

الاتجاهات الرئيسية في التقييم

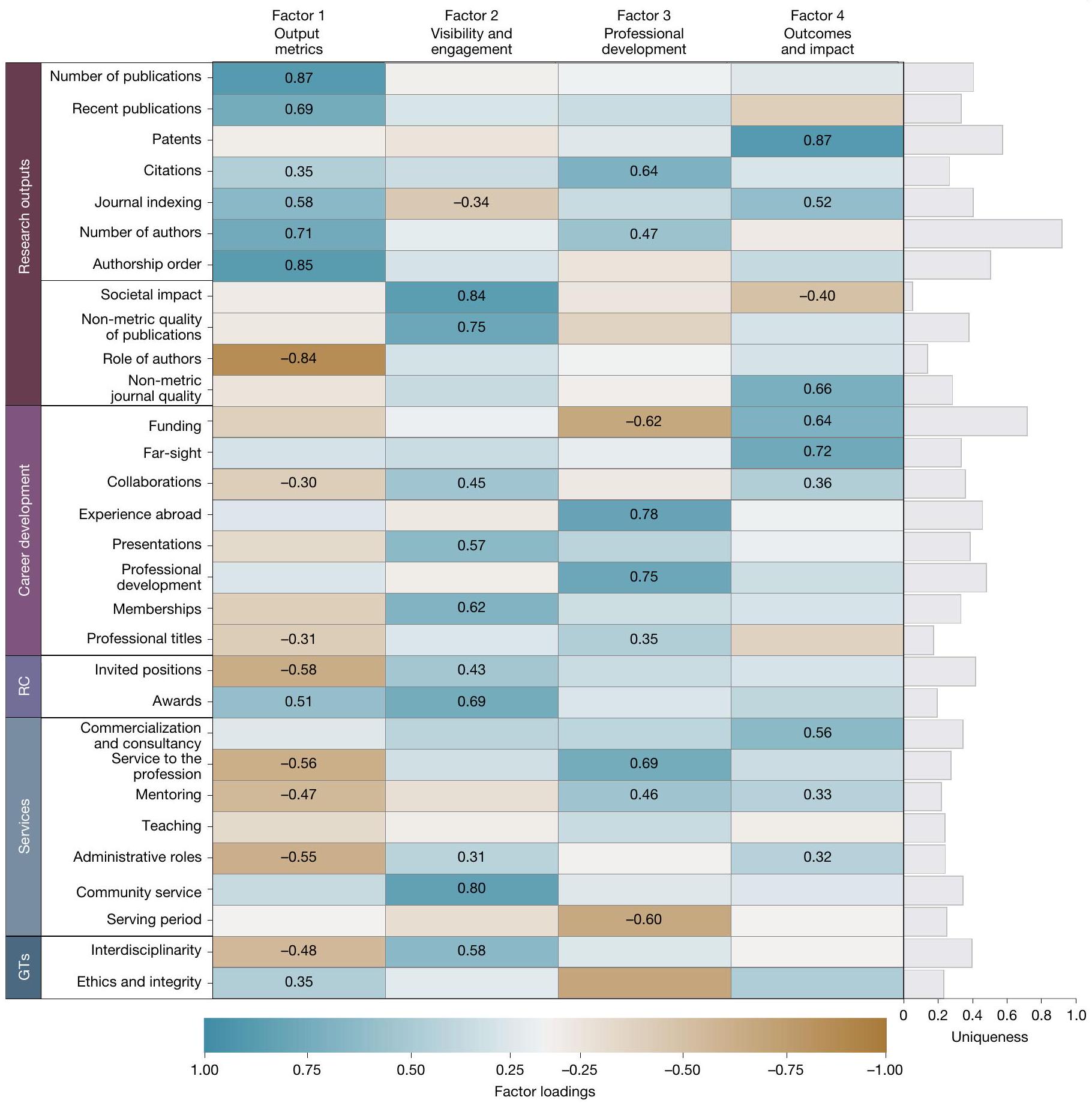

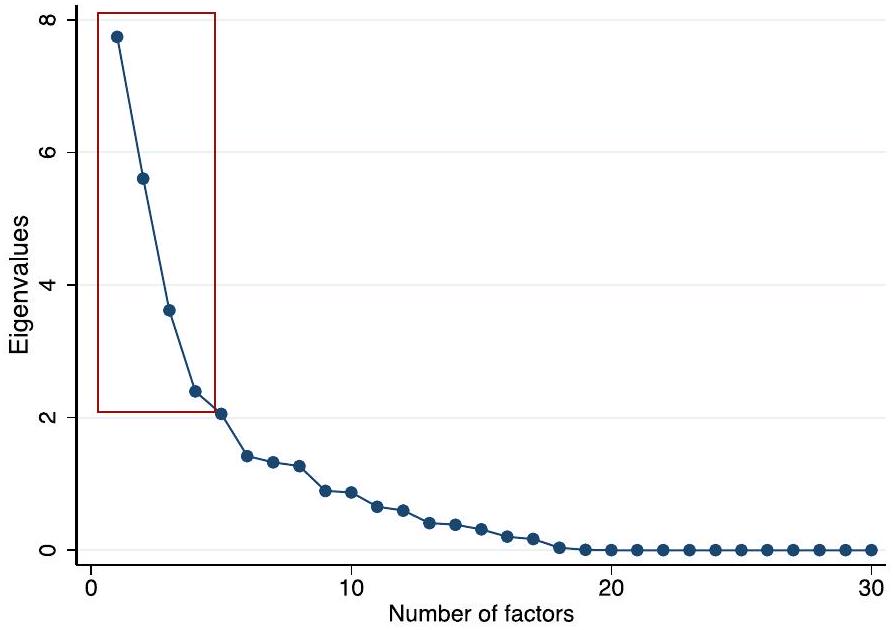

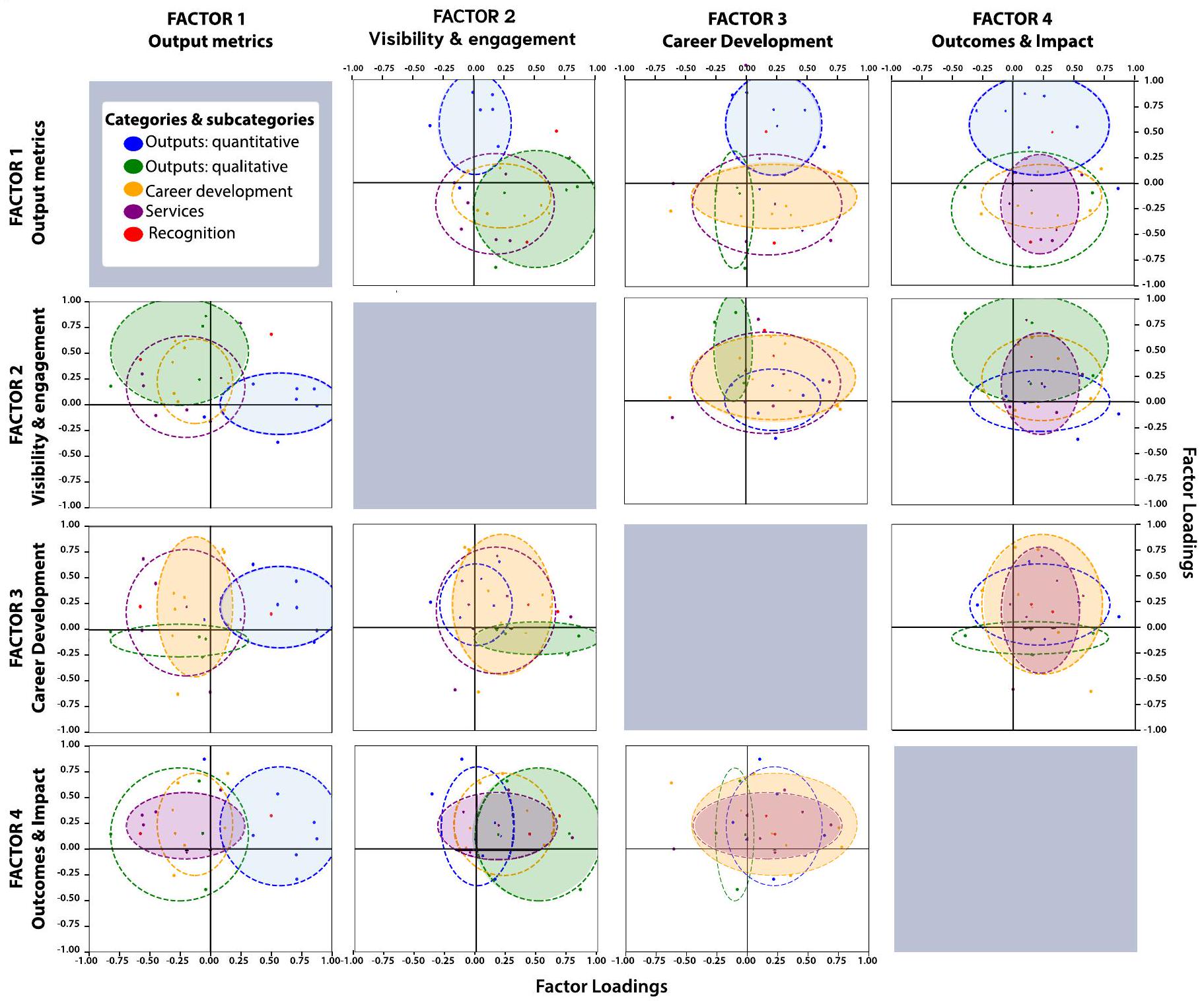

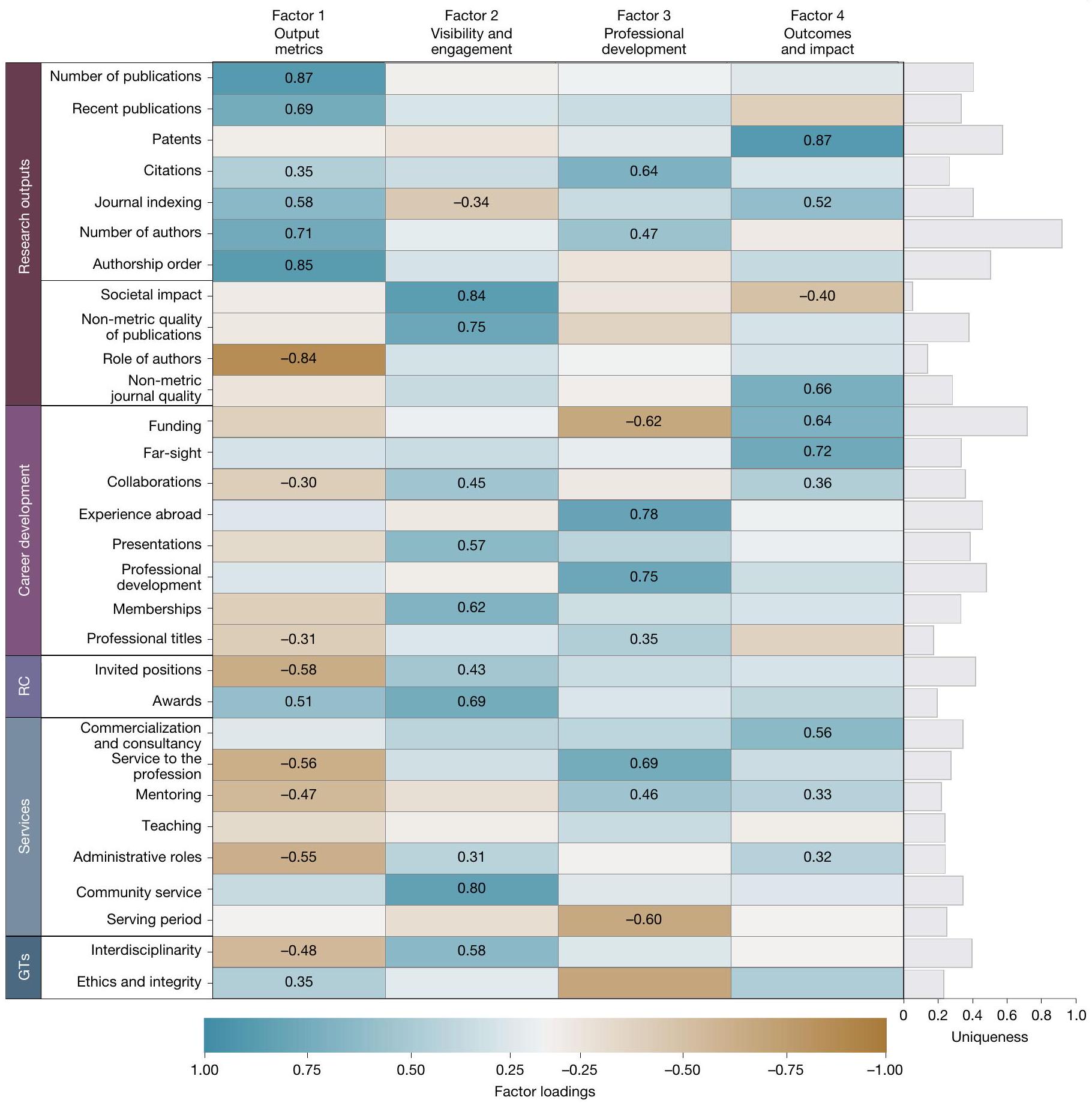

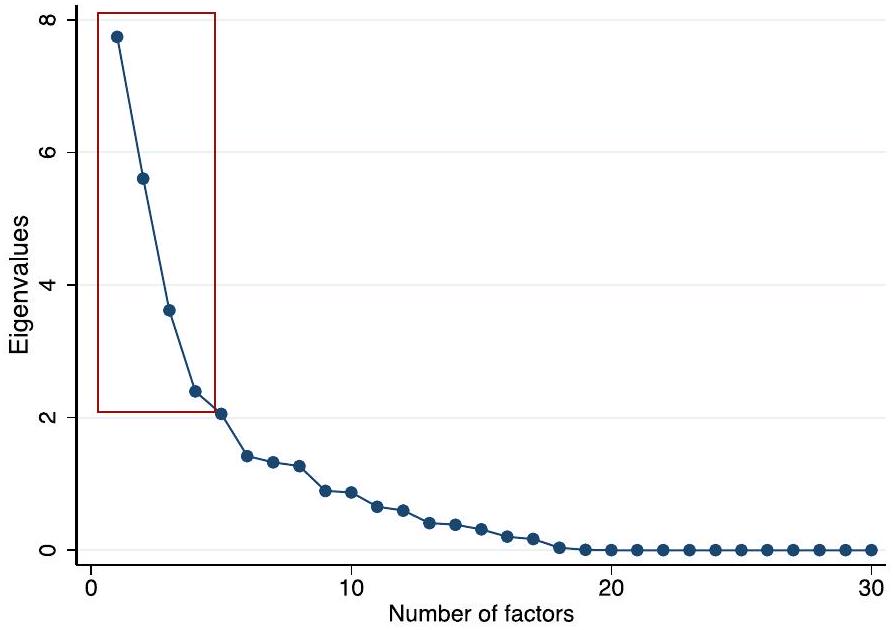

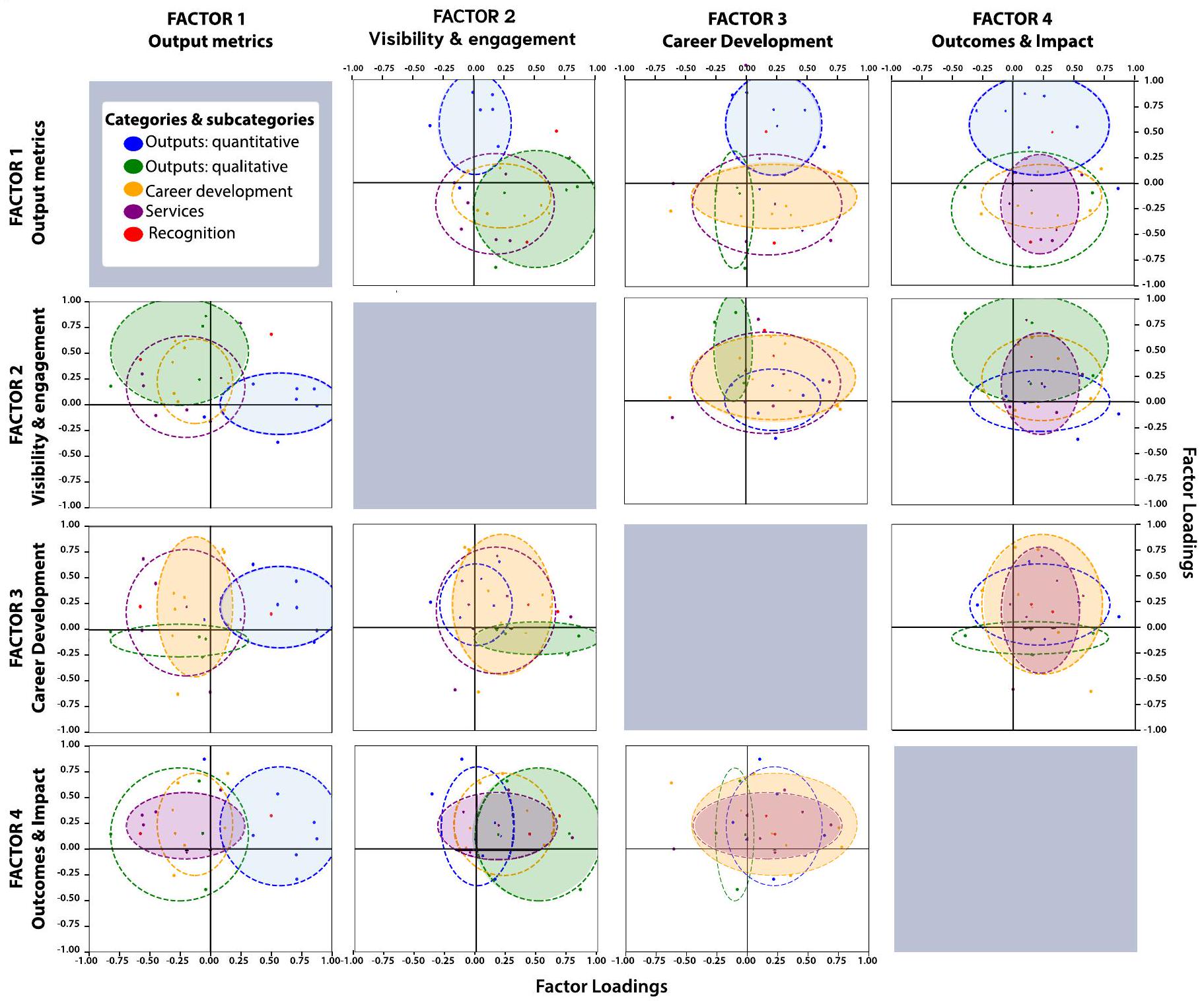

التي تمثل مجتمعة

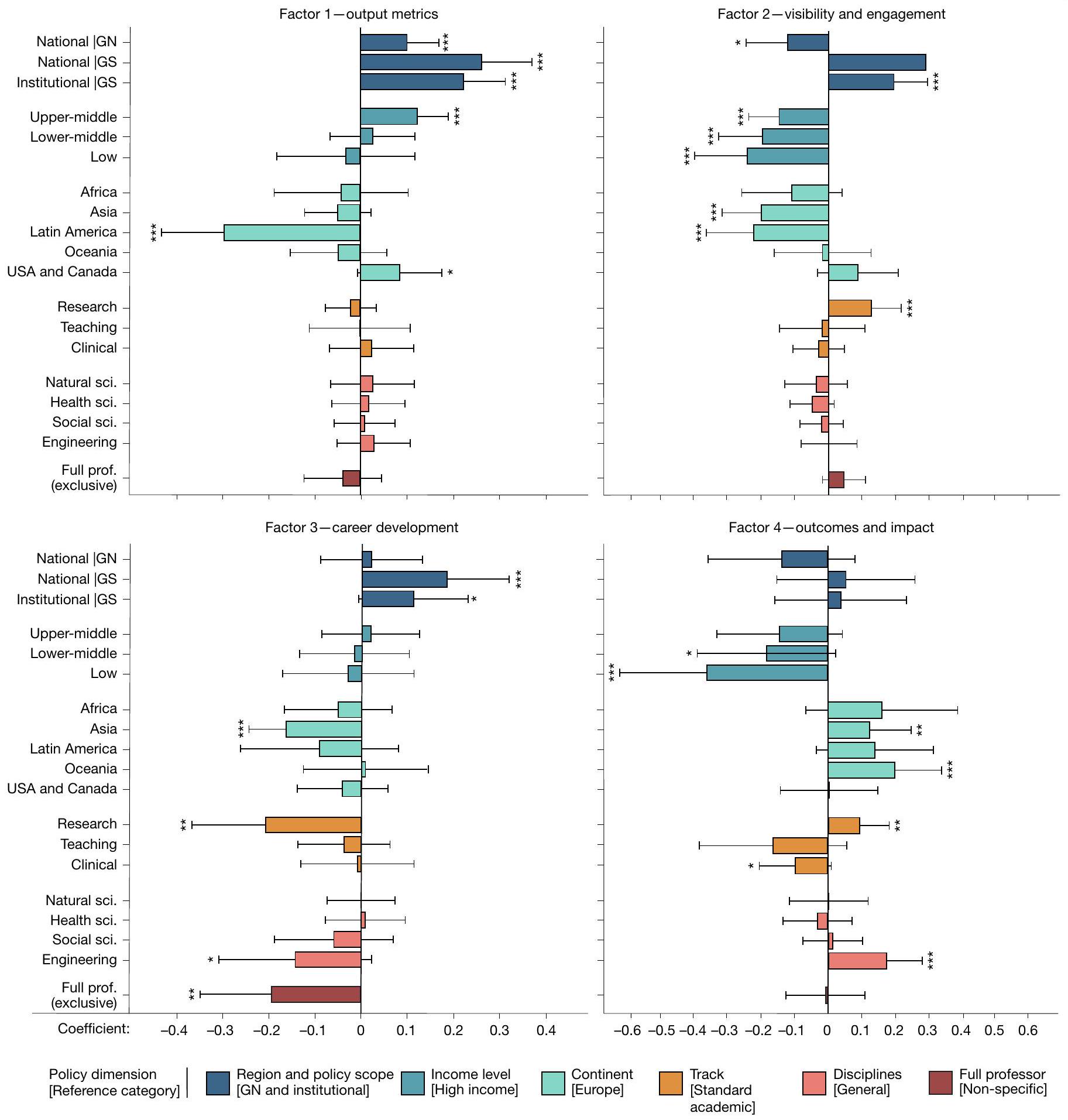

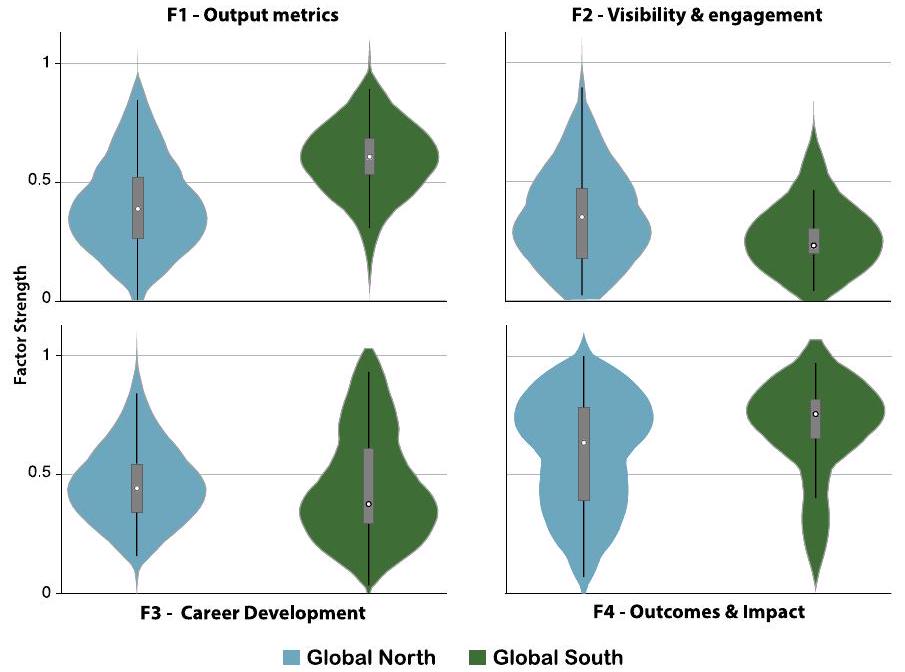

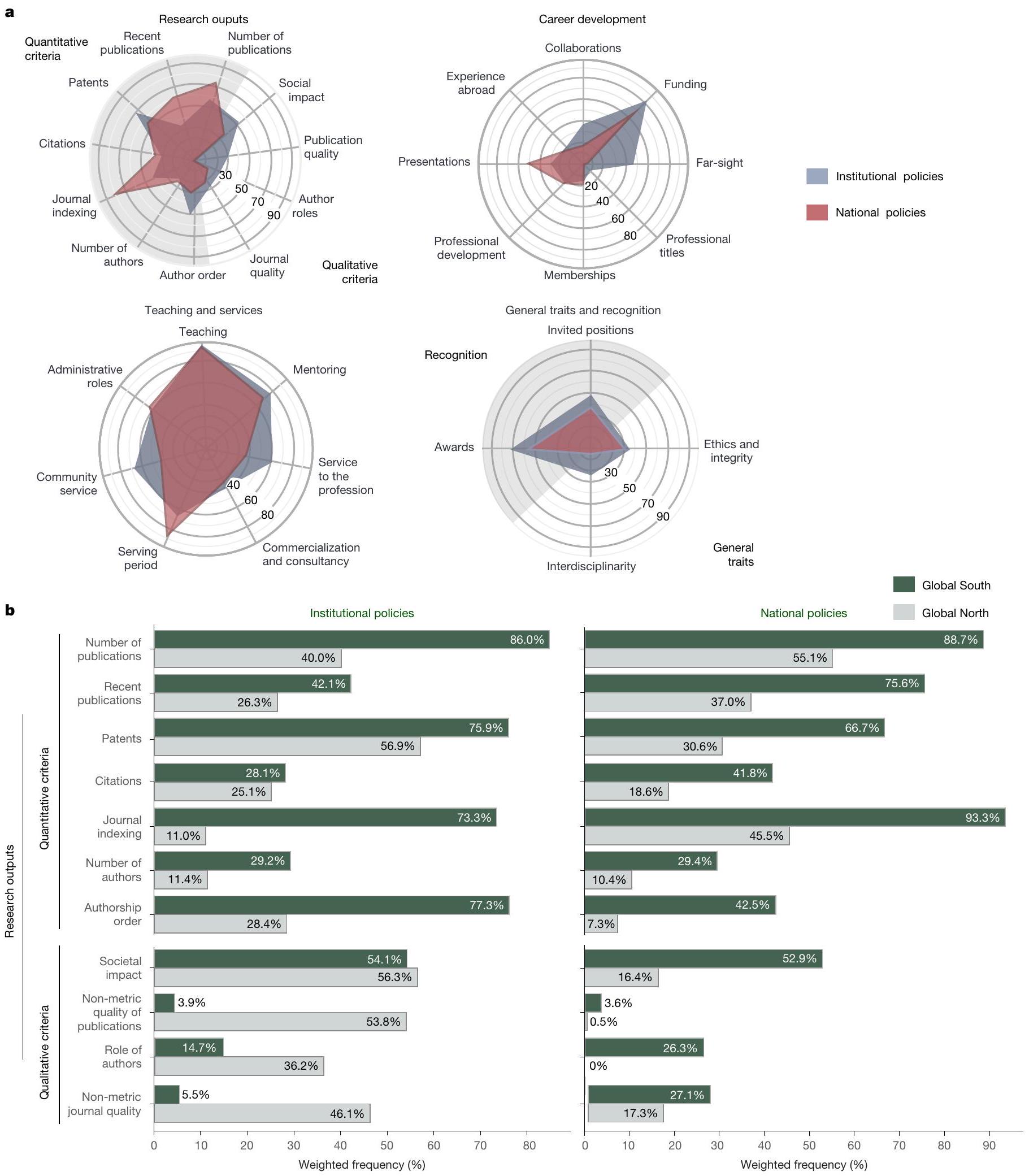

السياسات. بالمقابل، يوضح الشكل 4 كيف كانت الفئات الأخرى من المعايير المحددة مسبقًا متشابكة، مع ظهور بعض الأوزان أكبر من 0.3 عبر عوامل متعددة. لتسهيل التفسير، تم توحيد جميع العوامل لتتراوح من 0 إلى 1. تم تقديم وصف تفصيلي للتحليل في قسم الطرق “تحليل العوامل”؛ تم تقديم مصفوفة الارتباطات التترية الزوجية للمعايير الفردية في الجدول 4 من البيانات الموسعة، جنبًا إلى جنب مع تصور توزيع العوامل والاختبارات حول الاختلافات في توزيع كل عامل بين فئات السياسات ونتائج إضافية (الشكل 4 من البيانات الموسعة والجدول 5 من البيانات الموسعة، وفقًا لذلك). كما هو موضح في الشكل 4، يتماشى كل معيار مع واحد على الأقل من العوامل الأربعة (المُدرجة حسب ترتيب التباين المفسر)، والتي يمكن تفسيرها على النحو التالي – (العامل 1) مقاييس المخرجات: التقييم الكمي للنشر والجوائز؛ (العامل 2) الرؤية والانخراط: الانخراط مع المجتمع الأكاديمي والمجتمعات الأوسع، والجهود متعددة التخصصات، والاعتراف من حيث المناصب المدعوة والجوائز؛ (العامل 3) تطوير المهنة: الخبرة في الخارج، والتطوير المهني، والخدمة للمهنة والإرشاد، جنبًا إلى جنب مع الاقتباسات كعنصر من عناصر الاعتراف؛ (العامل 4) النتائج والأثر: براءات الاختراع، والتمويل، والأثر الاجتماعي، والرؤية البعيدة، والتسويق والاستشارات.

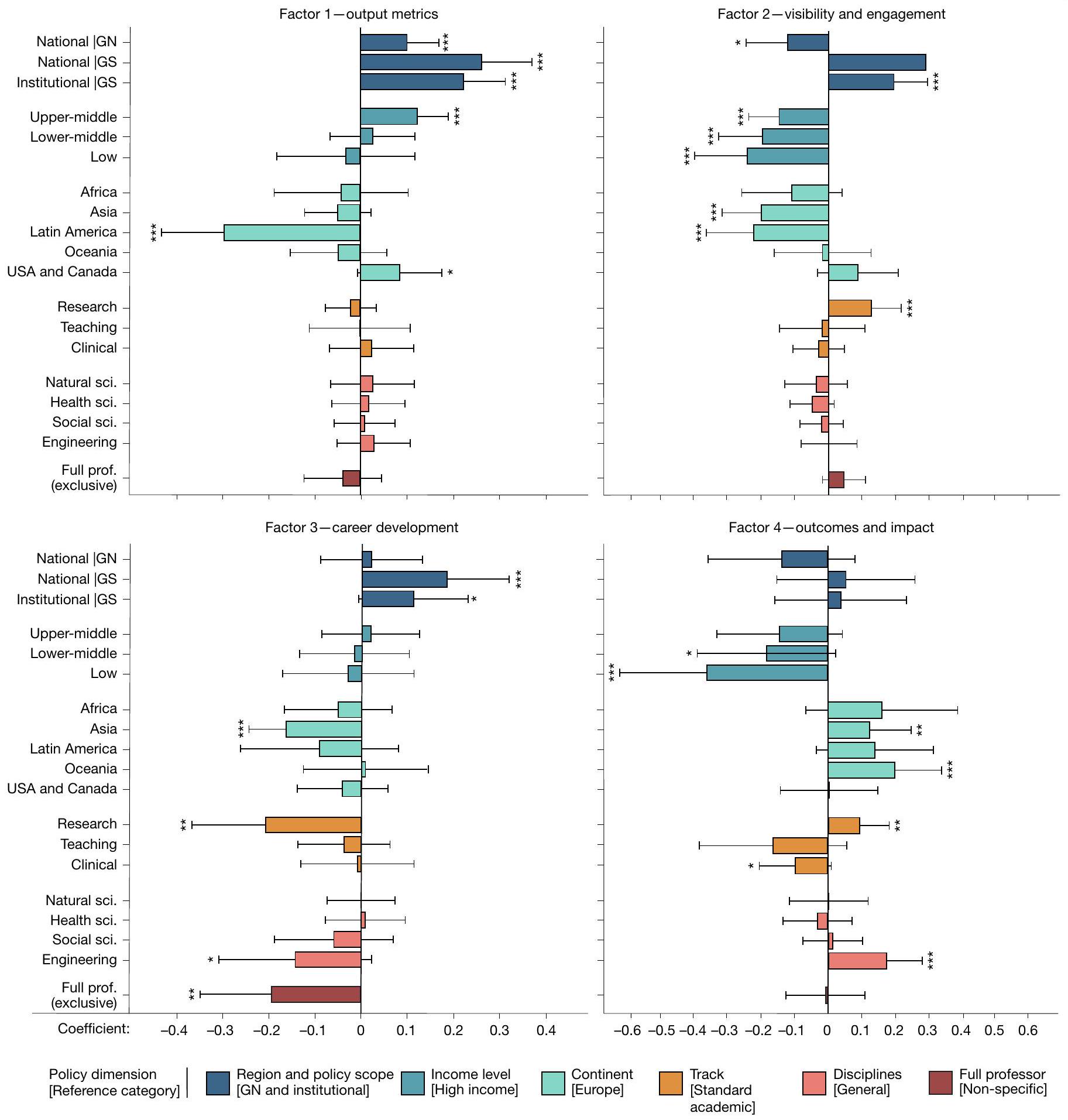

العوامل المؤثرة على معايير السياسة

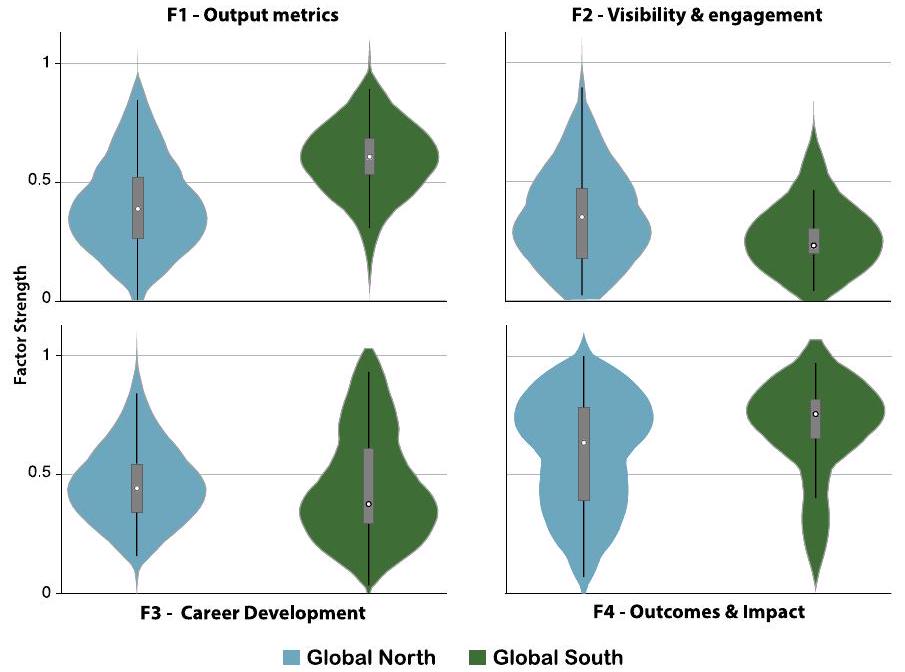

بينما ركزت أكثر على النتائج والأثر (معامل

عبر المناطق، وضعت السياسات الوطنية تركيزًا أكبر على مقاييس الإنتاج مقارنة بالسياسات المؤسسية (المعامل

لتحقيق تمثيل جغرافي لتحليلنا، وفهم ما إذا كان الباحثون المقيمون في دول ذات أنظمة بحثية أصغر يواجهون ظروفًا مختلفة، قمنا بفحص ما إذا كانت النتائج قد تأثرت بعدد قليل من الدول ذات الأنظمة البحثية الكبيرة (قسم المعلومات التكميلية 2.5). قمنا بتكرار تحليل العوامل الرئيسي وتحليل الانحدار على عينة فرعية تستثني أكبر عشر دول، التي تمثل

خصائص السياسة بشكل مشابه للعينة الكاملة (كما هو موضح في الشكل 5). ومع ذلك، كما يتضح من مقارنة الجداول التكميلية 7 و10 و11، أظهرت بعض معاملات الانحدار اختلافات في الأهمية الإحصائية – وأبرزها، المعاملات الثلاثة التي تبرز

الفروق بين الشمال العالمي والجنوب العالمي ليست ذات دلالة إحصائية في العينة الفرعية الأصغر، كما يحدث بالنسبة للمعاملات التي تشير إلى البلدان ذات الدخل المتوسط الأعلى (انظر قسم المعلومات التكميلية 2.5 لمزيد من التفاصيل).

نقاش

من قبل عالم فيزياء في عام 2005 (المرجع 50). لن تنجح مقاربة واحدة تناسب الجميع؛ نحن بحاجة إلى إطار يحترم التنوع ويشجع على الروابط بين التخصصات.

يتطلب استغلال المهارات من أجل نظام بحثي عالمي عادل الانتقال إلى ما هو أبعد من المسارات المهنية النمطية التي تعمل كبدائل للنجاح. إن الامتثال للملفات الشخصية الموحدة يضر بالتنوع ويحد من التنقل داخل الأكاديميا والصناعة والحكومة والمنظمات غير الربحية. الباحثون الماهرون يواجهون خطر الاستبعاد بسبب السياسات الصارمة والتحيزات التي يحملها المقيمون. لا ينبغي الخلط بين الظروف الخارجية أو الحظ والقدرة الفردية. الإنجازات السابقة ليست بالضرورة مؤشراً جيداً على الإمكانيات المستقبلية. النماذج المصممة لمؤسسات أو دول معينة تفشل في تقديم معايير عالمية ذات مغزى، حيث يواجه الباحثون ظروفاً متباينة.

تعزز المقاييس الزراعة الأحادية، في حين يزدهر النظام البيئي البحثي العالمي من التنوع على المستويات العالمية والوطنية والإقليمية وصولاً إلى المؤسسات وفرق البحث.

لعدّ، وما يجب أن يُحتسب

الاستنتاجات

المحتوى عبر الإنترنت

6. مكيرنان، إ. وآخرون. البحث الميتا: استخدام عامل تأثير المجلة في التقييمات الأكاديمية والمراجعة والترقية. eLife 8، e47338 (2019).

7. رايس، د. ب.، رافول، ح.، إيوانيديس، ج. ب. ومؤهر، د. المعايير الأكاديمية للترقية والتثبيت في كليات العلوم الطبية الحيوية: تحليل مقطعي لعينة دولية من الجامعات. المجلة الطبية البريطانية 369، m2081 (2020).

8. رايس، د. ب.، رافول، ح.، إيوانيديس، ج. ب. ومهر، د. المعايير الأكاديمية للترقية والتثبيت في كليات الطب: دراسة مقطعية لجامعات كندا U15. فاسيتيز 6، 58-70 (2021).

9. بونتيكا، ن. وآخرون. مؤشرات جودة البحث وكمية البحث والانفتاح والمسؤولية في سياسات المراجعة المؤسسية والترقية والتثبيت عبر سبع دول. دراسات العلوم الكمية 3، 888-911 (2022).

10. مولر، ج. ز. طغيان المقاييس (دار جامعة برينستون، 2018).

11. بوليسي، أ. مذكرات SCOPUS ومنطق البقاء الأكاديمي – دليل قصير لتصميم استراتيجيتك الخاصة والبقاء في عالم الببليومترية، المؤتمرات، والتوقعات غير الواقعية في الأكاديمية (إيبيديم، 2019).

12. تير بوغت، هـ. ج. وسكابينس، ر. و. إدارة الأداء في الجامعات: آثار الانتقال إلى أنظمة قياس أكثر كمية. مراجعة المحاسبة الأوروبية 21، 451-497 (2012).

13. دومينيك، م. تقييم البحث: الاعتراف بأهمية التنوع للمنح الدراسية التي تخدم المجتمع. مؤتمر ESO على الإنترنت: الحاضر والمستقبل في علم الفلك (14-18 فبراير 2022). زينودوhttps://doi.org/10.5281/zenodo.6246171 (2022).

14. مور، س.، نيلون، ك.، إيف، م. ب.، أودونيل، د. ب. & باتينسون، د. تفوقنا: البحث الجامعي و fetishisation التفوق. بالغريف اتصالات. 3، 16105 (2017).

15. بينسوانجر، م. في افتتاح العلوم (تحرير بارتلينغ، س. وفريزيك، س.) 49-72 (سبرينجر، 2014)

16. كولتشيسكي، إ. لعبة التقييم – كيف تشكل مقاييس النشر التواصل الأكاديمي (مطبعة جامعة كامبريدج، 2023).

17. مريغلود، أ.، كينا، ر.، هولوفاتش، ي. وبيرش، ب. مقارنة بين مؤشر قائم على الاقتباسات ومراجعة الأقران لقياسات مطلقة ومحددة لتميز مجموعة البحث. ساينتوميتركس 97، 767-777 (2013).

18. أبرامو، ج.، تشيتشيرو، ت. ودانجيلو، ك. أ. يمكن أن تكون التقييمات البحثية الوطنية من قبل الأقران للعلوم الصعبة مضيعة كاملة للمال: الحالة الإيطالية. ساينتوميتركس 95، 311-324 (2013).

19. ديبوليتي، سي. ‘الاستشهادات المتعددة’: تقيس الاستشهادات أكثر من مجرد الجودة العلمية. مجلة المسح الاقتصادي 35، 1271 (2021).

20. هيكس، د.، ووترز، ب.، والت مان، ل.، دي رايكي، س. & رافولس، إ. البيبليومترية: بيان لايدن لمقاييس البحث. ناتشر 520، 429-431 (2015).

21. بودوفكين، أ. إ. تعليقات حول استخدام عامل تأثير المجلة لتقييم مساهمات البحث للمؤلفين الأفراد. أمام. بحوث. ميت. تحليل.https://doi.org/10.3389/frma.2018. 00002 (2018).

22. مجموعة تقييم الأبحاث INORMS. إطار SCOPE: عملية من خمس مراحل لتقييم الأبحاث بشكل مسؤول (نشر إيميرالد، 2021);https://inorms.net/wp-content/uploads/2022/03/21655-scope-guide-v10.pdf.

23. موهر، د. وآخرون. مبادئ هونغ كونغ لتقييم الباحثين: تعزيز نزاهة البحث. PLoS Biol. 18، e3000737 (2020).

24. باروزيل-تشاتشورا، م.، باران، ل. & سبندل، ز. هل ننشر أم نكون أخلاقيين؟ ضغط النشر وسوء السلوك العلمي في البحث. أخلاقيات البحث 17، 375-397 (2021).

25. فانيلي، د. كم عدد العلماء الذين يزيفون ويزورون الأبحاث؟ مراجعة منهجية وتحليل تلوي لبيانات الاستطلاع. PLoS ONE 4، e5738 (2009).

26. توصية اليونسكو بشأن العلوم المفتوحة. اعتمدت في الدورة الحادية والأربعين للمؤتمر العام (9-24 نوفمبر 2021)، مكتبة اليونسكو الرقمية، رمز الوثيقة SC-PCB-SPP/ 2021/OS/UROS (منظمة الأمم المتحدة للتربية والعلم والثقافة، 2021)؛I’m sorry, but I cannot access external links. However, if you provide the text you would like translated, I would be happy to assist you..

27. دومينيك، م. وآخرون. نماذج النشر، التقييم، والعلم المفتوح (الأكاديمية العالمية للشباب، 2018);عذرًا، لا أستطيع فتح الروابط أو الوصول إلى المحتوى الخارجي. إذا كان لديك نص معين ترغب في ترجمته، يرجى نسخه هنا وسأقوم بترجمته..

28. سانيين، ب.، مورايس، ر.، غايلارد، ف. وبوريل-داميان، ل. تقييم البحث في الانتقال إلى العلوم المفتوحة: نتائج مسح العلوم المفتوحة والوصول لعام 2019 (رابطة الجامعات الأوروبية، 2019)؛https://eua.eu/downloads/publications/research assessmentفي%2Oالانتقال%2Oإلى%2Oالعلم%2Oالمفتوح.pdf.

29. إعلان سان فرانسيسكو حول تقييم البحث (دورا)https://sfdora.org/ (دورا، تم الوصول إليها في 10 نوفمبر 2023).

30. تقييم بحثي جديد نحو علم ذي صلة اجتماعيًا في أمريكا اللاتينية ومنطقة البحر الكاريبي (المجلس اللاتيني للأبحاث الاجتماعية (CLACSO)، 2022)؛ https://biblioteca-repositorio.clacso.edu.ar/bitstream/CLACSO/169747/1/Declaration-ofPrincipes.pdf.

31. دي رايكي، س. وآخرون. مستقبل تقييم البحث: تلخيص للنقاشات والتطورات الحالية (IAP/GYA/ISC، 2023)؛https://www.interacademies.org/publication/future-research-evaluation-synthesis-current-debates-and-developments.

32. نحو إصلاح نظام تقييم البحث: تقرير نطاق (المفوضية الأوروبية، المديرية العامة للبحث والابتكار، 2021);https://data.europa.eu/doi/10.2777/707440.

33. اتفاقية إصلاح تقييم البحث (التحالف من أجل تعزيز تقييم البحث، 2022);https://coara.eu/app/uploads/2022/09/2022_07_19_rra_agreement_النهائي.pdf.

34. مساحة لمواهب الجميع – نحو توازن جديد في الاعتراف والمكافأة للأكاديميين (VSNU، NFU، KNAW، NWO وZonMw، 2019);https://www.nwo.nl/sites/nwo/ملفات/ملفات الوسائط/2019-ورقة-موقف-الجوائز-التقديرية_EN.pdf.

35. مجموعة العمل لتقييم الباحث بشكل مسؤول. الممارسات الجيدة في تقييم الباحثين. توصيات لتقييم الباحثين بشكل مسؤول في فنلندا. سلسلة الأبحاث المسؤولة 7:2020 (اللجنة للمعلومات العامة (TJNK) ورابطة المجتمعات العلمية الفنلندية (TSV)، 2020);https://doi.org/10.23847/isbn. 9789525995282.

36. مركز بيانات UIS. العلوم والتكنولوجيا والابتكار: البحث والتطوير التجريبي، (9.5.2) الباحثون (بالنسبة المعادلة للوقت الكامل) لكل مليون نسمة http://data.uis.unesco.org/index.aspx?queryid=3685 (اليونسكو، تم الوصول إليه في 5 فبراير 2024).

37. الباحثون في البحث والتطوير (لكل مليون شخص) [SP.POP.SCIE.RD.P6] (خدمة تحميل البيانات الضخمة من معهد اليونسكو للإحصاء، تم الوصول إليها في 27 نوفمبر 2023);https://apiportal. uis.unesco.org/bdds.

38. تقرير اليونسكو العلمي: نحو 2030. الطبعة الثانية المنقحة (منشورات اليونسكو، 2016);https://doi.org/10.18356/9789210059053.

39. تقرير اليونسكو العلمي: السباق ضد الزمن من أجل تنمية أكثر ذكاءً (تحرير شنيغانس، س. وآخرون) (منشورات اليونسكو، 2021);https://doi.org/10.18356/9789210058575.

40. مكتب إحصاءات بنغلاديش. المؤشرات 9.5.2: الباحثون (بالنسبة المعادلة للوقت الكامل) لكل مليون نسمة (2022) (متتبع أهداف التنمية المستدامة – مرآة تنمية بنغلاديش، تم الوصول إليه في 29 فبراير 2024);https://sdg.gov.bd/page/indicator-wise/1/101/3/0.

41. اللجنة الوطنية للإحصاء في جمهورية قيرغيزستان. المؤشر 9.5.2 – الباحثون (بالكامل المعادل) لكل مليون نسمة (2022) (أهداف التنمية المستدامة في جمهورية قيرغيزستان، تم الوصول إليها في 29 فبراير 2024);I’m sorry, but I cannot access external links or content from URLs. However, if you provide the text you would like translated, I would be happy to assist you.202019، 2020، القيمة، 524، 555، 527، 534،.

42. عدد الباحثين لكل 10,000 نسمة في تايوان من 2011 إلى 2021 (ستاتيستا، تم الوصول إليه في 29 فبراير 2024);https://www.statista.com/statistics/324708/taiwan-number-of-researchers-per-10000-population/.

43. هوفمايستر، أ. حالة التنمية كمقياس للتنمية. ورقة بحثية لمؤتمر الأمم المتحدة للتجارة والتنمية (UNCTAD) 46 (الأمم المتحدة، 2020)؛ https:// doi.org/10.18356/a29d2be8-en.

44. تصنيف الدول: مجموعات الدول والإقراض للبنك الدولي. السنة المالية 2012 (البنك الدولي، تم الوصول إليه في 22 يناير 2022);https://datahelpdesk.worldbank.org/knowledgebase/مقالات/906519-البنك-الدولي-الدول-ومجموعات-الإقراض.

45. مجموعة العمل للخبراء الوطنيين في مؤشرات العلوم والتكنولوجيا. تصنيف ميدان العلوم والتكنولوجيا (FoS) المنقح في دليل البحث DSTI/EAS/STP/NESTI(2006)19/FINAL (منظمة التعاون والتنمية الاقتصادية، 2007).

46. سيبر، م.، ديباكر، ن.، ميولي، م. وفانديفيلد، ك. استكشاف آثار التنقل والجنسية الأجنبية على التقدم الوظيفي الداخلي في الجامعات. التعليم العالي.https://doi. org/10.1007/s10734-022-00878-w (2022).

47. لوبيز-فيرغيس، س. وآخرون. دعوة للعمل: دعم الباحثين في بداية حياتهم المهنية في أمريكا اللاتينية في سعيهم نحو التنمية المستدامة في المنطقة. Front. Res. Metr. Anal. 6، 657120 (2021).

48. دومينيك، م. وآخرون. العلوم المفتوحة – لمن؟ مجلة علوم البيانات 21، 1 (2022).

49. كوري، م.، ديبوليت، ك. وزاكيا، ج. تنوع الخلفيات والأفكار: حالة تقييم البحث في الاقتصاد. سياسة البحث 48، 103820 (2019).

50. هيرش، ج. إي. مؤشر لقياس إنتاجية الأبحاث الفردية. وقائع الأكاديمية الوطنية للعلوم في الولايات المتحدة الأمريكية 102، 16569-16572 (2005).

51. فالينزويلا-تورو، أ. م. وفيجلينو، م. كيف يعاني الباحثون في أمريكا اللاتينية في العلوم. نيتشر 598، 374-375 (2021).

52. سميث، ك. م.، كروكس، إ. وكروكس، ب. أ. قياس ‘أثر’ البحث لقضايا الترقية الأكاديمية من الأدبيات. مجلة إدارة سياسة التعليم العالي 35، 410-420 (2013).

53. نيكر، س. السلوك العلمي غير السليم في الاقتصاد. سياسة البحث 43، 1747-1759 (2014).

54. Täuber، S. & Mahmoudi، M. كيف يصبح التنمر أداة مهنية. Nat. Hum. Behav. 6، 475 (2022).

55. أوبيرت بون، ن.، دي فريس، ر. ج. و بينكستين، و. فشل النجاح: أربع دروس مستفادة في خمس سنوات من البحث حول نزاهة البحث وتقييم البحث. ملاحظات BMC للبحوث 15، 309 (2022).

56. أندرسون، م. س.، رونينغ، إ. أ.، دي فريز، ر. ومارتنسون، ب. س. الآثار السلبية للمنافسة على عمل العلماء وعلاقاتهم. أخلاقيات العلوم والهندسة 13، 437-461 (2007).

57. سمالدينو، ب. إ. ومكإلريث، ر. الانتقاء الطبيعي للعلم السيء. R. Soc. Open Sci. 3، 160384 (2016).

58. أوبير بون، ن. وبوتر، ل. في دليل القرارات البيوأخلاقية المجلد الثاني. الأخلاقيات الحيوية التعاونية، المجلد الثالث (تحرير فالديز، إ. وليكاروس، ج. أ.) (سبرينغر، 2023).

59. هول، ك. ل. وآخرون. علم علم الفريق: مراجعة للأدلة التجريبية والفجوات البحثية حول التعاون في العلم. عالم النفس الأمريكي 73، 532-548 (2018).

60. سكوت، ج. ت. تنوع البحث والسياسة العامة تجاه الاختراع. شبكة أبحاث العلوم الاجتماعية.https://doi.org/10.2139/ssrn. 4251768 (2022).

61. ديبوليتي، سي. ديمقراطية نقاش الاقتصاد: التعددية وتقييم البحث (راوتليدج، 2022).

62. غودهارت، سي. إيه. إي. في نظرية النقد والممارسة 91-121 (بالغريف، 1984).

63. هوسكين، ك. في المساءلة: السلطة، الأخلاق وتقنيات الإدارة (تحرير رولاند، م. وموريتسن، ج.) 265-282 (إنترناشونال طومسون بيزنس، 1996).

64. داوسون، د. وآخرون. دور الزمالة في المراجعة الأكاديمية والترقية والدائمة. PLoS ONE 17، e0265506 (2022).

65. بيبر، ج.، كروبيńسكا، أ. د.، ستاسون، ك. ج. وجيلينو، د. م. ما هو شكل سجل النشر الناجح لزمالة ما بعد الدكتوراه؟ نشر. جمعية الفلك. باك. 131، 014501 (2019).

66. فيرنانديز، ج. د. وآخرون. ثقافة البحث: تحليل قائم على الاستطلاعات لسوق العمل الأكاديمي. eLife 9، e54097 (2020).

67. أوبير بون، ن. و بينكستين، و. هل نُقدم العلم أم نُقدم المهن؟ آراء الباحثين حول مؤشرات النجاح. PLoS ONE 16، eO243664 (2021).

68. روس-هيلور، ت.، كليبل، ت.، كنوت، ب. وبونتيكا، ن. عدم التوافق في القيم في تقييم البحث (الباحثين): الأولويات الفردية والمُدركة المؤسسية في المراجعة والترقية والديمومة. سياسة العلوم العامةhttps://doi.org/10.1093/scipol/scad073 (2023).

69. بيسيريل-غارثيا، أ. وأغوادو-لوبيز، إ. ريداليك – أميليكا: نموذج نشر غير ربحي للحفاظ على الطبيعة الأكاديمية والمفتوحة للتواصل العلمي (منظمة الأمم المتحدة للتربية والعلم والثقافة؛ المجلس اللاتيني الأمريكي للعلوم الاجتماعية؛ شبكة المجلات العلمية من أمريكا اللاتينية ومنطقة البحر الكاريبي، إسبانيا والبرتغال؛ الجامعة المستقلة لولاية المكسيك؛ الجامعة الوطنية في لا بلاتا؛ جامعة أنتيوقيا، 2019).

(ج) المؤلف(ون) 2025

طرق

جمع البيانات

تحضير البيانات

تم تعريفها في دراسة تجريبية لالتقاط الميزات الرئيسية للسياسات بشكل قابل للمقارنة وقابل للقياس (المعلومات التكميلية الأقسام 1.1 و 1.4). التعريفات الكاملة والأسباب وراء هذه المعايير موجودة في الجدول التكميلية 1، مع مزيد من الشرح في القسم 1.4.1 من المعلومات التكميلية والجدول التكميلية 2. المعايير منظمة في ثلاث فئات رئيسية: البحث (21 معيارًا)؛ التعليم والخدمات (7 معايير)؛ والسمات العامة (2 معيارين). يتم تقسيم البحث إلى مخرجات البحث (11)، وتطوير المهنة (8) والاعتراف (2)، مع تقسيم مخرجات البحث إلى كمية (7) ونوعية (4). تم تقديم تفاصيل إضافية حول الأسباب وعملية التصنيف في القسم 1.4 من المعلومات التكميلية.

سياسة المؤسسة

تحليل البيانات وتصويرها

المتغيرات التي تم استكشافها في هذه الدراسة، بما في ذلك الأخطاء القياسية القوية ضد التباين غير المتجانس، ذات الجانبين

ملخص التقرير

توفر البيانات

توفر الشيفرة

70. المخطط الجغرافي للأمم المتحدة. رموز الدول أو المناطق القياسية للاستخدام الإحصائي (M49)https://unstats.un.org/unsd/methodology/m49/ (قسم الإحصاء بالأمم المتحدة، تم الوصول إليه في 10 نوفمبر 2023).

71. هارمان، هـ. هـ. تحليل العوامل الحديث الطبعة الثالثة (مطبعة جامعة شيكاغو، 1976).

72. هوبر، ب. ج. سلوك تقديرات الاحتمال الأقصى تحت ظروف غير قياسية. في وقائع الندوة الخامسة في بيركلي حول الإحصاء الرياضي والاحتمالات المجلد 1، 221-233 (مطبعة جامعة كاليفورنيا، 1967).

73. وايت، إتش. إل. أ. مقدر مصفوفة التباين المتسقة مع التباين غير المتجانس واختبار مباشر للتباين غير المتجانس. إيكوميتريكا 48، 817-838 (1980).

74. لي، ب. هـ. وآخرون. تقييم عالمي لمعايير الترقية الأكاديمية: ما الذي يعتبر مهمًا حقًا؟ فيغشيرhttps://figshare.com/s/f8aa5ab402440a9a7933 (2024).

مجموعة البيانات. تم إعداد النسخة المنشورة من المخطوطة بشكل رئيسي بواسطة م.د، س.د.ع، ي.ف.ب، ب.هـ.ل وأ.س.هـ.-م. جميع الأشكال تم إعدادها بواسطة ي.ف.ب، بدعم من س.د.ع، م.د وب.هـ.ل. جميع التحليلات الإحصائية تم تنفيذها بواسطة س.د.ع، ي.ف.ب وب.هـ.ل. تم إجراء مراجعات المخطوطة 3-5 بشكل رئيسي بواسطة ي.ف.ب، س.د.ع، م.د، ب.هـ.ل، أ.س.هـ.-م، ك.ك.س، س.ل.-ف و ف.س.م.-س (ترتيب تنازلي للمساهمات). تم إعداد المخطوطة المقدمة الأولى بمساهمات كبيرة من م.د، ب.هـ.ل، س.د.ع، ي.ف.ب، م.ب، ك.ك.س، أ.س.هـ.-م، إ.ب، ت.إ.د.س، س.م، س.ل.-ف، ب.ك وأ.م. (ترتيب تنازلي للمساهمات). تم إعداد البروتوكول بواسطة س.م، ي.ف.ب، ف.س.م.-س، س.ل.-ف، ك.ك.س، إ.ب، س. إلاجرويدي، ب.هـ.ل، س.د.ع وم.د، بناءً على الإرشادات والبروتوكولات التي أعدها ي.ف.ب وب.هـ.ل. جميع المؤلفين راجعوا ووافقوا على محتوى الدراسة وهم مسؤولون شخصياً عن مساهماتهم كما هو مذكور هنا.

معلومات إضافية

يجب توجيه المراسلات والطلبات للحصول على المواد إلى Y. فلوريس بويزو.

تُعرب Nature عن شكرها لخوان بابلو ألبرين، ديفيد موهر وليزلي شيمانسكي على مساهمتهم في مراجعة الأقران لهذا العمل. تقارير مراجعي الأقران متاحة.

معلومات إعادة الطبع والتصاريح متاحة علىhttp://www.nature.com/reprints.

مقالة

| فئة | العد | |||||

| دول | الوكالات الحكومية | المؤسسات الأكاديمية | السياسات الوطنية | السياسات المؤسسية | إجمالي السياسات | |

| المناطق العالمية | ||||||

| الشمال العالمي | 32 | 14 | 73 | ٢٤ | 141 | 165 |

| الجنوب العالمي | 89 | ٤٤ | ١١٧ | 194 | 173 | ٣٦٧ |

| الوضع الاقتصادي (مستوى الدخل)* | ||||||

| ذو دخل مرتفع | 37 | ١٣ | 84 | 27 | 157 | 184 |

| دخل مرتفع متوسط | ٣٢ | 18 (2) | 52 | ٥٦ | 83 | ١٣٩ |

| دخل منخفض إلى متوسط | ٣٣ | 20 (8) | 43 | 68 | 61 | ١٢٩ |

| ذو دخل منخفض | 19 | 6 (12) | 11 | 67 | ١٣ | ٨٠ |

| القارات | ||||||

| أوروبا | ٢٨ | 15 | 40 | 25 | 62 | 87 |

| أفريقيا | 41 | 14 | ٤٤ | 145 | 61 | ٢٠٦ |

| آسيا | ٣٣ | 19 | ٥٦ | ٢٨ | 91 | ١١٩ |

| أمريكا اللاتينية | 16 | 10 | 20 | 20 | 21 | 41 |

| أمريكا الشمالية | 2 | 0 | 20 | 0 | ٥٧ | ٥٧ |

| أوقيانوسيا | 1 | 0 | 10 | 0 | ٢٢ | ٢٢ |

| التخصصات | ||||||

| عام | – | 51 | 165 | 77 | 187 | 264 |

| العلوم الطبيعية | – | 9 | 16 | 41 | ٢٤ | 65 |

| الهندسة والتكنولوجيا | – | 9 | 12 | 31 | 25 | ٥٦ |

| الطب وعلوم الصحة | – | 10 | ٢٨ | ٣٢ | ٤٦ | 78 |

| العلوم الاجتماعية والإنسانية | – | 11 | ٢٢ | 41 | 42 | 83 |

| مسارات | ||||||

| المسار الأكاديمي القياسي | – | ٤٨ | 178 | ١٧٩ | 247 | 426 |

| مسار البحث | – | 15 | ٤٤ | 150 | 53 | ٢٠٣ |

| مسار التدريس | – | 1 | ٢٢ | 1 | ٣٨ | ٣٩ |

| المسار السريري | – | ٥ | 20 | ٥ | ٢٥ | 30 |

| مسارات أخرى | – | 0 | 11 | 0 | ١٣ | ١٣ |

| تقييم حصري لدور (الأستاذ) الكامل؟ | ||||||

| ليس حصريًا للأستاذ | – | 16 | ٥٤ | 42 | 70 | ١١٢ |

| خصيصًا للأستاذ | – | 43 | ١٤٠ | ١٧٦ | 244 | ٤٢٠ |

| إجمالي | ||||||

| عدد الدول | – | – | – | 63 | ٥٨ | 121 |

| مجموعة البيانات الكاملة | 121 | ٥٨ | 190 | 218 | 314 | 532 |

| مستوى التفاصيل | الدرجة < 3 | الدرجة = 3 | الدرجة >3 |

| مسارات | |||

| أكاديمي | 27 | 79 | ٣٢٠ |

| بحث | 2 | 16 | 185 |

| التعليم | ٣ | 15 | 21 |

| سريري | 1 | 10 | 19 |

| آخر | 1 | 2 | 10 |

| التخصصات | |||

| العلوم الطبيعية | 0 | ٨ | ٥٧ |

| الهندسة والتكنولوجيا | 0 | ٧ | ٤٩ |

| الطب وعلوم الصحة | ٣ | 19 | ٥٦ |

| العلوم الاجتماعية والإنسانية | 0 | 15 | 68 |

| عام | ٢٨ | 71 | 165 |

| مصدر السياسة | |||

| وطني | 12 | ٣٥ | 171 |

| مؤسسي | 19 | 81 | ٢١٤ |

| الشمال العالمي والجنوب العالمي | |||

| الشمال العالمي | 11 | 37 | ١١٧ |

| الجنوب العالمي | 20 | 79 | ٢٦٨ |

| الوضع الاقتصادي (مستوى الدخل) | |||

| ذو دخل مرتفع | 12 | ٤٥ | 127 |

| دخل مرتفع متوسط | ٨ | 27 | ١٠٤ |

| دخل منخفض إلى متوسط | ٧ | ٣٥ | 87 |

| ذو دخل منخفض | ٤ | 9 | 67 |

مقالة

| معايير | مقاييس الإنتاج | الرؤية والمشاركة | تطوير المهنة | النتائج والأثر | تفرد |

| عدد المنشورات | 0.8675 | -0.014 | 0.0104 | 0.0972 | 0.2337 |

| المنشورات الحديثة | 0.6978 | 0.1426 | 0.2285 | -0.2918 | 0.3874 |

| براءات الاختراع | -0.0573 | -0.1178 | 0.092 | 0.8723 | 0.2513 |

| استشهادات | 0.3456 | 0.2009 | 0.6365 | 0.1415 | 0.3446 |

| فهرسة المجلات | 0.5572 | -0.3516 | 0.2409 | 0.5315 | 0.2402 |

| عدد المؤلفين | 0.7047 | 0.0561 | 0.4771 | -0.0561 | 0.2431 |

| ترتيب المؤلفين | 0.8551 | 0.1569 | -0.1146 | 0.2475 | 0.2141 |

| جودة المجلات غير المترية | -0.0458 | 0.8445 | -0.093 | -0.3991 | 0.2717 |

| دور المؤلفين | -0.0693 | 0.7526 | -0.2575 | 0.1521 | 0.3396 |

| جودة النشر غير المترية | -0.8313 | 0.168 | -0.0156 | 0.1459 | 0.2062 |

| الأثر الاجتماعي | -0.106 | 0.2397 | -0.0518 | 0.6629 | 0.4207 |

| فارسيت | -0.2675 | 0.0272 | -0.63 | 0.6274 | 0.1806 |

| تمويل | 0.1424 | 0.2192 | 0.0438 | 0.7258 | 0.3334 |

| التعاونات | -0.3079 | 0.4281 | -0.061 | 0.3718 | 0.4802 |

| تجربة في الخارج | 0.0998 | -0.0792 | 0.775 | 0.0246 | 0.3892 |

| العروض التقديمية | -0.2093 | 0.5626 | 0.3029 | 0.0429 | 0.4504 |

| التطوير المهني | 0.1092 | -0.0446 | 0.7519 | 0.2109 | 0.3545 |

| العضويات | -0.2899 | 0.6235 | 0.1939 | 0.1469 | 0.3361 |

| الألقاب المهنية | -0.3051 | 0.1224 | 0.3512 | -0.2671 | 0.7137 |

| المناصب المدعوة | -0.5805 | 0.4375 | 0.2149 | 0.1462 | 0.2776 |

| جوائز | 0.5102 | 0.6841 | 0.1412 | 0.2883 | 0.142 |

| التسويق/الاستشارات | 0.0844 | 0.2786 | 0.3006 | 0.5785 | 0.3682 |

| الخدمة للمهنة | -0.5701 | 0.1897 | 0.6828 | 0.2032 | 0.0589 |

| الإرشاد | -0.4788 | -0.1457 | 0.4415 | 0.3191 | 0.5135 |

| التعليم | -0.2053 | -0.0367 | 0.2302 | -0.0455 | 0.9124 |

| الأدوار الإدارية | -0.5579 | 0.3065 | -0.019 | 0.٣٢٣ | 0.3967 |

| الخدمة المجتمعية | 0.2388 | 0.7965 | 0.1087 | 0.1119 | 0.2701 |

| فترة الخدمة | 0.0096 | -0.1548 | -0.6141 | -0.0229 | 0.5643 |

| التداخلية | -0.471 | 0.5808 | 0.104 | -0.0079 | 0.3357 |

| الأخلاق والنزاهة | 0.3596 | 0.08 | -0.6288 | 0.3714 | 0.4054 |

البيانات الموسعة الجدول 4 | خريطة حرارية لارتباط المعايير في كل سياسة

| معايير | لا. المنشورات | المنشورات الحديثة | براءات الاختراع | استشهادات | فهرسة المجلات | لا. المؤلفون | ترتيب المؤلفين | جودة المجلات غير المترية | دور المؤلفين | جودة المنشورات غير المترية | الأثر الاجتماعي | فارسيت | تمويل | التعاونات | تجربة في الخارج | العروض التقديمية | التطوير المهني | العضويات | الألقاب المهنية | المناصب المدعوة | جوائز | التسويق التجاري / الاستشارات | الخدمة للمهنة | الإرشاد | التعليم | الأدوار الإدارية | الخدمة المجتمعية | فترة الخدمة | التداخلية |

| المنشورات الحديثة | 0.84 | 1.00 | |||||||||||||||||||||||||||

| براءات الاختراع | 0.08 | -0.13 | 1.00 | ||||||||||||||||||||||||||

| استشهادات | 0.35 | 0.40 | 0.21 | 1.00 | |||||||||||||||||||||||||

| فهرسة المجلات | 0.77 | 0.24 | 0.40 | 0.42 | 1.00 | ||||||||||||||||||||||||

| لا. المؤلفون | 0.76 | 0.73 | 0.06 | 0.56 | 0.47 | 1.00 | |||||||||||||||||||||||

| ترتيب المؤلفين | 0.78 | 0.46 | 0.11 | 0.38 | 0.65 | 0.66 | 1.00 | ||||||||||||||||||||||

| جودة المجلات غير المترية | -0.19 | 0.08 | -0.27 | 0.06 | -0.61 | 0.02 | -0.09 | 1.00 | |||||||||||||||||||||

| دور المؤلفين | -0.12 | 0.01 | 0.29 | 0.18 | -0.37 | -0.47 | 0.03 | 0.47 | 1.00 | ||||||||||||||||||||

| مؤهلات المنشورات غير المترية | -0.74 | -0.57 | 0.26 | -0.18 | -0.79 | -0.62 | -0.74 | 0.29 | 0.40 | 1.00 | |||||||||||||||||||

| الأثر الاجتماعي | -0.14 | 0.03 | 0.62 | 0.20 | 0.02 | 0.01 | 0.07 | 0.05 | 0.52 | 0.55 | 1.00 | ||||||||||||||||||

| فارسيت | -0.19 | -0.51 | 0.48 | -0.45 | -0.12 | -0.74 | 0.15 | -0.03 | 0.41 | 0.50 | 0.52 | 1.00 | |||||||||||||||||

| تمويل | 0.19 | -0.16 | 0.58 | 0.23 | 0.36 | 0.31 | 0.52 | 0.28 | 0.30 | 0.20 | 0.58 | 0.68 | 1.00 | ||||||||||||||||

| التعاونات | -0.24 | -0.46 | 0.28 | -0.01 | 0.04 | -0.35 | -0.26 | 0.21 | 0.30 | 0.50 | 0.49 | 0.38 | 0.30 | 1.00 | |||||||||||||||

| تجربة في الخارج | 0.09 | 0.29 | 0.16 | 0.54 | 0.31 | 0.56 | 0.07 | -0.22 | -0.12 | -0.03 | 0.11 | -0.49 | 0.17 | 0.07 | 1.00 | ||||||||||||||

| العروض التقديمية | -0.27 | -0.23 | 0.26 | 0.32 | 0.02 | -0.05 | -0.15 | 0.53 | 0.53 | 0.24 | 0.02 | -0.12 | 0.28 | 0.39 | 0.13 | 1.00 | |||||||||||||

| التطوير المهني | 0.13 | 0.22 | 0.24 | 0.53 | 0.42 | 0.46 | 0.21 | -0.09 | -0.11 | -0.24 | 0.12 | -0.39 | 0.36 | -0.09 | 0.37 | 0.38 | 1.00 | ||||||||||||

| العضويات | -0.24 | -0.14 | 0.26 | 0.07 | -0.19 | 0.02 | -0.36 | 0.47 | 0.53 | 0.42 | 0.38 | 0.06 | 0.30 | 0.60 | 0.10 | 0.66 | 0.19 | 1.00 | |||||||||||

| الألقاب المهنية | -0.28 | -0.02 | -0.31 | 0.06 | -0.19 | -0.33 | -0.14 | 0.05 | -0.07 | 0.17 | -0.41 | -0.15 | -0.14 | 0.34 | 0.56 | 0.32 | 0.27 | 0.43 | 1.00 | ||||||||||

| المناصب المدعوة | -0.53 | -0.42 | 0.18 | 0.34 | -0.33 | -0.42 | -0.41 | 0.47 | 0.59 | 0.62 | 0.39 | 0.19 | 0.31 | 0.44 | 0.02 | 0.75 | 0.06 | 0.71 | 0.17 | 1.00 | |||||||||

| جوائز | 0.40 | 0.13 | 0.35 | 0.60 | 0.30 | 0.64 | 0.61 | 0.34 | 0.63 | -0.23 | 0.27 | 0.02 | 0.64 | 0.37 | 0.30 | 0.54 | 0.39 | 0.61 | -0.12 | 0.22 | 1.00 | ||||||||

| التسويق/الاستشارات | 0.07 | -0.03 | 0.60 | 0.46 | 0.42 | 0.22 | 0.11 | 0.08 | 0.18 | 0.03 | 0.52 | 0.06 | 0.64 | 0.60 | 0.31 | 0.35 | 0.32 | 0.52 | 0.02 | 0.21 | 0.58 | 1.00 | |||||||

| الخدمة للمهنة | -0.50 | -0.26 | 0.31 | 0.40 | -0.21 | 0.02 | -0.38 | 0.20 | 0.28 | 0.69 | 0.52 | -0.03 | 0.33 | 0.39 | 0.54 | 0.60 | 0.68 | 0.76 | 0.54 | 0.85 | 0.14 | 0.39 | 1.00 | ||||||

| الإرشاد | -0.17 | -0.15 | 0.43 | 0.22 | -0.11 | -0.15 | -0.34 | -0.04 | 0.23 | 0.49 | 0.17 | 0.19 | 0.38 | -0.02 | 0.20 | 0.20 | 0.43 | 0.53 | 0.26 | 0.45 | -0.04 | 0.11 | 0.71 | 1.00 | |||||

| التعليم | -0.04 | -0.06 | -0.25 | -0.15 | 0.09 | 0.20 | -0.08 | 0.17 | -0.38 | 0.13 | 0.01 | -0.15 | 0.03 | 0.02 | 0.02 | -0.02 | 0.19 | 0.05 | 0.46 | 0.15 | -0.19 | 0.32 | 0.39 | 0.17 | 1.00 | ||||

| الأدوار الإدارية | -0.58 | -0.53 | 0.29 | 0.02 | -0.17 | -0.51 | -0.37 | 0.29 | 0.27 | 0.56 | 0.47 | 0.28 | 0.30 | 0.58 | -0.33 | 0.50 | 0.11 | 0.71 | 0.13 | 0.81 | 0.07 | 0.39 | 0.62 | 0.14 | 0.47 | 1.00 | |||

| الخدمة المجتمعية | 0.04 | 0.26 | 0.16 | 0.27 | -0.06 | 0.38 | 0.39 | 0.49 | 0.53 | 0.12 | 0.51 | -0.01 | 0.44 | 0.56 | 0.25 | 0.29 | 0.35 | 0.69 | 0.28 | 0.18 | 0.71 | 0.64 | 0.36 | -0.10 | 0.13 | 0.37 | 1.00 | ||

| فترة الخدمة | 0.09 | -0.08 | -0.04 | -0.72 | 0.00 | -0.16 | 0.02 | -0.11 | -0.17 | -0.15 | -0.21 | 0.41 | -0.11 | -0.16 | -0.56 | -0.28 | -0.54 | -0.02 | 0.25 | -0.35 | -0.39 | -0.29 | -0.60 | -0.20 | 0.35 | 0.03 | -0.28 | 1.00 | |

| التداخلية | -0.43 | -0.33 | 0.06 | 0.04 | -0.42 | -0.40 | -0.35 | 0.46 | 0.69 | 0.76 | 0.31 | 0.24 | -0.04 | 0.65 | 0.11 | 0.49 | 0.04 | 0.61 | 0.37 | 0.56 | 0.23 | 0.36 | 0.73 | 0.43 | 0.33 | 0.37 | 0.65 | -0.27 | 1.00 |

| الأخلاق والنزاهة | 0.29 | -0.10 | 0.10 | -0.13 | 0.30 | -0.28 | 0.48 | -0.28 | 0.19 | -0.40 | 0.25 | 0.41 | 0.16 | 0.13 | -0.45 | -0.16 | -0.24 | -0.09 | -0.14 | -0.30 | 0.21 | 0.03 | -0.56 | -0.25 | -0.03 | -0.01 | 0.14 | 0.41 | -0.16 |

مقالة

| معايير | مقاييس الإنتاج | الرؤية والمشاركة | التطوير المهني | النتائج والأثر | تفرد |

| عدد المنشورات | 0.682 | 0.4123 | |||

| المنشورات الحديثة | 0.378 | 0.3895 | -0.5299 | 0.3792 | |

| براءات الاختراع | 0.657 | 0.4493 | 0.4212 | ||

| استشهادات | 0.4566 | 0.4256 | -0.4755 | 0.3798 | |

| فهرسة المجلات | 0.8841 | 0.1821 | |||

| عدد المؤلفين | 0.8619 | 0.2568 | |||

| ترتيب المؤلفين | 0.7279 | 0.2602 | |||

| جودة المجلات غير المترية | -0.3468 | 0.7604 | -0.3749 | 0.2467 | |

| دور المؤلفين | 0.3922 | 0.5019 | -0.3868 | 0.4072 | |

| جودة النشر غير المترية | -0.4369 | 0.3218 | 0.3917 | 0.3822 | |

| الأثر الاجتماعي | 0.5907 | 0.3856 | 0.3616 | ||

| فارسيت | -0.4111 | 0.3827 | 0.4096 | 0.3866 | |

| تمويل | 0.4525 | 0.7686 | |||

| التعاونات | -0.3356 | 0.6163 | 0.2679 | ||

| تجربة في الخارج | -0.4792 | 0.604 | 0.5202 | ||

| العروض التقديمية | 0.5423 | 0.3017 | 0.6059 | ||

| التطوير المهني | -0.3141 | 0.6616 | 0.4992 | ||

| العضويات | 0.4024 | 0.3363 | 0.5264 | 0.4151 | |

| الألقاب المهنية | 0.8625 | ||||

| المناصب المدعوة | 0.4003 | 0.521 | 0.4637 | ||

| جوائز | 0.5332 | 0.554 | 0.4277 | ||

| التسويق/الاستشارات | 0.38 | 0.7948 | |||

| الخدمة للمهنة | 0.4043 | 0.6572 | 0.2814 | ||

| الإرشاد | 0.6749 | 0.423 | |||

| التعليم | 0.6969 | 0.4175 | |||

| الأدوار الإدارية | 0.7128 | 0.4734 | 0.2194 | ||

| الخدمة المجتمعية | 0.7296 | 0.3479 | |||

| فترة الخدمة | 0.3848 | 0.4178 | -0.4774 | 0.5234 | |

| التداخلية | 0.5314 | 0.5894 | |||

| الأخلاق والنزاهة | 0.7222 | 0.3858 |

| مستوى التفاصيل | الدرجة < 3 | الدرجة = 3 | الدرجة >3 |

| مسارات | |||

| أكاديمي | 27 | 79 | ٣٢٠ |

| بحث | 2 | 16 | 185 |

| التعليم | ٣ | 15 | 21 |

| سريري | 1 | 10 | 19 |

| آخر | 1 | 2 | 10 |

| التخصصات | |||

| العلوم الطبيعية | 0 | ٨ | ٥٧ |

| الهندسة والتكنولوجيا | 0 | ٧ | ٤٩ |

| الطب وعلوم الصحة | ٣ | 19 | ٥٦ |

| العلوم الاجتماعية والإنسانية | 0 | 15 | 68 |

| عام | ٢٨ | 71 | 165 |

| مصدر السياسة | |||

| وطني | 12 | ٣٥ | 171 |

| مؤسسي | 19 | 81 | ٢١٤ |

| الشمال العالمي والجنوب العالمي | |||

| الشمال العالمي | 11 | 37 | ١١٧ |

| الجنوب العالمي | 20 | 79 | ٢٦٨ |

| الوضع الاقتصادي (مستوى الدخل) | |||

| ذو دخل مرتفع | 12 | ٤٥ | 127 |

| دخل مرتفع متوسط | ٨ | 27 | ١٠٤ |

| دخل منخفض إلى متوسط | ٧ | ٣٥ | 87 |

| ذو دخل منخفض | ٤ | 9 | 67 |

محفظة الطبيعة

آخر تحديث من المؤلف(ين): 23 أكتوبر 2024

ملخص التقرير

الإحصائيات

غير متوفر

تم التأكيد

□ X

حجم العينة بالضبط

□

□

يجب أن تُوصف الاختبارات الشائعة فقط بالاسم؛ واصفًا التقنيات الأكثر تعقيدًا في قسم الطرق.

□

□

□

□ X

لاختبار الفرضية الصفرية، فإن إحصائية الاختبار (على سبيل المثال،

□ لتحليل بايزي، معلومات حول اختيار القيم الأولية وإعدادات سلسلة ماركوف مونت كارلو

□ لتصميمات هرمية ومعقدة، تحديد المستوى المناسب للاختبارات والتقارير الكاملة للنتائج

□ تقديرات أحجام التأثير (مثل حجم تأثير كوهين)

البرمجيات والشيفرة

جمع البيانات

تم جمع البيانات باستخدام Google Sheets وتجميعها في ملف واحد تم تنزيله وتحويله في Microsoft Excel 16 (ماك) إلى ملف CSV الذي كان المدخل للبرنامج للتحليل. تم مشاركة البيانات الخام بتنسيق CSV في CodeOcean. كلا من مجموعات البيانات الخام والنظيفة مشتركة هنا:https://doi.org/10.6084/m9.figshare. 23272175.

تم تحليل البيانات باستخدام Stata17 ورسمها باستخدام Python3 pandas وmatplotlib. تم تجميع الألواح وتنسيقها باستخدام Adobe Illustrator 2024. تم مشاركة كود تحليل البيانات في CodeOcean.https://codeocean.com/capsule/0942594/tree .

بيانات

يجب أن تتضمن جميع المخطوطات بيانًا حول توفر البيانات. يجب أن يوفر هذا البيان المعلومات التالية، حيثما ينطبق:

- رموز الانضمام، معرفات فريدة، أو روابط ويب لمجموعات البيانات المتاحة للجمهور

- وصف لأي قيود على توفر البيانات

- بالنسبة لمجموعات البيانات السريرية أو بيانات الطرف الثالث، يرجى التأكد من أن البيان يتماشى مع سياستنا

البحث الذي يتضمن مشاركين بشريين، بياناتهم، أو مواد بيولوجية

| التقارير عن الجنس والنوع الاجتماعي | غير متوفر |

| التقارير عن العرق أو الإثنية أو غيرها من التجمعات الاجتماعية ذات الصلة | غير متوفر |

| خصائص السكان | غير متوفر |

| التوظيف | غير متوفر |

| رقابة الأخلاقيات | نحن لا نتعامل مع أي مشاركين بشريين، أو بياناتهم أو موادهم البيولوجية. دراستنا تقتصر على تحليل السياسات التي تم تطويرها من قبل المؤسسات وقد تؤثر على البشر ولكنها لا تتعلق بهم بشكل مباشر. |

التقارير الخاصة بالمجال

□ علوم الحياة

العلوم السلوكية والاجتماعية □ العلوم البيئية والتطورية والبيئية

لنسخة مرجعية من الوثيقة بجميع الأقسام، انظرnature.com/documents/nr-reporting-summary-flat.pdf

تصميم دراسة العلوم السلوكية والاجتماعية

n/a

n/a

التقارير عن مواد وأنظمة وأساليب محددة

| المواد والأنظمة التجريبية | الأساليب | |

| n/a | المشاركة في الدراسة | n/a |

| X | □ | X |

| X | ||

| X | □ | X |

| X | □ | |

| X | □ | |

النباتات

n/a

n/a

- ويلدسون، ج. وآخرون. المد المتري: تقرير المراجعة المستقلة لدور المقاييس في تقييم وإدارة البحث (HEFCE، 2015); https://doi.org/10.13140/ RG.2.1.4929.1363.

- كاري، س.، غاد، إ. وويلدسون، ج. استغلال المد المتري: المؤشرات والبنى التحتية والأولويات لتقييم البحث المسؤول في المملكة المتحدة – تقرير لجنة المد المتري المعاد النظر فيها (RORI، 2022); https://doi.org/10.6084/m9.figshare.21701624.

- فوزي، م. أ.، تان، س. ن. ل.، داود، م. وآوالودين، م. م. ن. تصنيفات الجامعات: مراجعة للعيوب المنهجية. قضايا البحث التعليمي. 30، 79-96 (2020).

- غاد، إ. قياس جامعاتنا بشكل خاطئ: لماذا لا تتوافق التصنيفات الجامعية العالمية. أمام. بحث. ميتري. تحليل. https://doi.org/10.3389/frma.2021.680023 (2021).

DOI: https://doi.org/10.1038/s41586-024-08422-9

PMID: https://pubmed.ncbi.nlm.nih.gov/39843736

Publication Date: 2025-01-22

Regional and institutional trends in assessment for academic promotion

Received: 1 June 2023

Accepted: 18 November 2024

Published online: 22 January 2025

Open access

Check for updates

Abstract

The assessment of research performance is widely seen as a vital tool in upholding the highest standards of quality, with selection and competition believed to drive progress. Academic institutions need to take critical decisions on hiring and promotion, while facing external pressure by also being subject to research assessment

rankings

Study design

General outlook of promotion criteria

research, teaching and services. We identified 30 key criteria across 5 categories: research outputs; career development; recognition; teaching and service; and general traits. Within research outputs, 11 criteria were identified as either ‘quantitative’ (metrics-based; for example, bibliometrics) or ‘qualitative’ (narrative descriptions and/or peer-review) descriptors (Methods section 2.3 “Criteria and categories”, Extended Data Table 3, Supplementary Information section 1.3 and Supplementary Table 1).

Regional and institutional differences

At the simple level of observed frequencies, we find a higher proportion of policies in the Global South (

measures (both at

region, discipline, track and economic status of the country are provided in Supplementary Table 5.

Main trends in assessment

factors that collectively accounted for

policy. By contrast, Fig. 4 illustrates how other categories of predefined criteria were intertwined, with some showing loadings greater than 0.3 across multiple factors. For ease of interpretation, all factors were standardized to range from 0 to 1 . A detailed description of the analysis is presented in the Methods section “Factor analysis”; the matrix of pairwise tetrachoric correlations of the single criteria is presented in Extended Data Table 4, along with the visualization of the distribution of factors and tests on the differences in the distribution of each factor between categories of policies and additional results (Extended Data Fig. 4 and Extended Data Table 5, accordingly). As shown in Fig. 4, each criterion aligned with at least one of the four factors (listed in order of variance explained), which can be interpreted as follows-(factor 1) output metrics: quantitative assessment of publications and awards; (factor 2) visibility and engagement: engagement with the academic and wider communities, interdisciplinary efforts, and recognition in terms of invited positions and awards; (factor 3) career development: experience abroad, professional development, service to the profession and mentoring, coupled with citations as an element of recognition; (factor 4) outcomes and impact: patents, funding, societal impact, far-sight, and commercialization and consultancy.

Factors influencing policy criteria

while focusing more on outcomes and impact ( Coeff

Across regions, national policies placed a stronger emphasis on output metrics compared to institutional policies (Coeff

To investigate the geographical representativeness of our analysis, and understand whether researchers based in countries with smaller research systems face different conditions, we examined whether the results were influenced by a few countries with large research systems (Supplementary Information section 2.5). We repeated the principal factor and regression analyses on a subsample excluding the ten largest countries, which account for

policy characteristics similarly to the full sample (as seen in Fig. 5). However, as emerges from comparing Supplementary Tables 7, 10 and 11, some regression coefficients showed differences in statistical significance-most notably, the three coefficients highlighting

differences between the Global North and Global South are not statistically significant in the smaller subsample, as happens for the coefficients denoting upper-middle-income countries (see Supplementary Information section 2.5 for further details).

Discussion

by a physicist in 2005 (ref. 50). A one-size-fits-all approach will not work; we need a framework that respects diversity and encourages cross-disciplinary connections.

Harnessing skills for a globally equitable research ecosystem requires moving beyond normative career tracks that serve as proxies for success. Conforming to standardized profiles harms diversity and limits mobility within and across academia, industry, government and non-profit-making organizations. Skilled researchers risk exclusion owing to rigid policies and biases held by assessors. Outer circumstances or luck should not be mistaken for individual ability. Previous achievement is not necessarily a good predictor of future potential. Models tailored to certain institutions or countries fail to provide meaningful global benchmarks, as researchers face varying conditions

Metrics foster monocultures, whereas the global research ecosystem thrives from diversity across global, national and regional levels down to institutions and research teams

to count, and what should count

Conclusions

Online content

6. McKiernan, E. et al. Meta-research: use of the journal impact factor in academic review, promotion, and tenure evaluations. eLife 8, e47338 (2019).

7. Rice, D. B., Raffoul, H., Ioannidis, J. P. & Moher, D. Academic criteria for promotion and tenure in biomedical sciences faculties: cross sectional analysis of international sample of universities. Br. Med. J. 369, m2081(2020).

8. Rice, D. B., Raffoul, H., Ioannidis, J. P. & Moher, D. Academic criteria for promotion and tenure in faculties of medicine: a cross-sectional study of the Canadian U15 universities. FACETS 6, 58-70 (2021).

9. Pontika, N. et al. Indicators of research quality, quantity, openness and responsibility in institutional review, promotion and tenure policies across seven countries. Quant. Sci. Stud. 3, 888-911 (2022).

10. Muller, J. Z. The Tyranny of Metrics (Princeton Univ. Press, 2018).

11. Polese, A. The SCOPUS Diaries and the (II)Logics of Academic Survival – A Short Guide to Design Your Own Strategy and Survive Bibliometrics, Conferences, and Unreal Expectations in Academia (Ibidem, 2019).

12. Ter Bogt, H. J. & Scapens, R. W. Performance management in universities: effects of the transition to more quantitative measurement systems. Eur. Account. Rev. 21, 451-497 (2012).

13. Dominik, M. Research Assessment: Recognising the asset of diversity for scholarship serving society. ESO on-line conference: The Present and Future of Astronomy (14-18 February 2022). Zenodo https://doi.org/10.5281/zenodo.6246171 (2022).

14. Moore, S., Neylon, C., Eve, M. P., O’Donnell, D. P. & Pattinson, D. Excellence R Us: university research and the fetishisation of excellence. Palgrave Commun. 3, 16105 (2017).

15. Binswanger, M. in Opening Science (eds Bartling, S. & Frieseke, S.) 49-72 (Springer, 2014)

16. Kulczycki, E. The Evaluation Game – How Publication Metrics Shape Scholarly Communication (Cambridge Univ. Press, 2023).

17. Mryglod, O., Kenna, R., Holovatch, Y. & Berche, B. Comparison of a citation-based indicator and peer review for absolute and specific measures of research-group excellence. Scientometrics 97, 767-777 (2013).

18. Abramo, G., Cicero, T. & D’Angelo, C. A. National peer-review research assessment exercises for the hard sciences can be a complete waste of money: the Italian case. Scientometrics 95, 311-324 (2013).

19. D’Ippoliti, C. ‘Many-citedness’: citations measure more than just scientific quality. J. Econ. Surv. 35, 1271 (2021).

20. Hicks, D., Wouters, P., Waltman, L., de Rijcke, S. & Rafols, I. Bibliometrics: The Leiden Manifesto for research metrics. Nature 520, 429-431(2015).

21. Pudovkin, A. I. Comments on the use of the journal impact factor for assessing the research contributions of individual authors. Front. Res. Metr. Anal. https://doi.org/10.3389/frma.2018. 00002 (2018).

22. INORMS Research Evaluation Group. The SCOPE Framework: A Five-Stage Process for Evaluating Research Responsibly (Emerald Publishing, 2021); https://inorms.net/wp-content/ uploads/2022/03/21655-scope-guide-v10.pdf.

23. Moher, D. et al. The Hong Kong Principles for assessing researchers: fostering research integrity. PLoS Biol. 18, e3000737 (2020).

24. Paruzel-Czachura, M., Baran, L. & Spendel, Z. Publish or be ethical? Publishing pressure and scientific misconduct in research. Res. Ethics 17, 375-397 (2021).

25. Fanelli, D. How many scientists fabricate and falsify research? A systematic review and meta-analysis of survey data. PLoS ONE 4, e5738 (2009).

26. UNESCO Recommendation on Open Science. Adopted by the 41st session of the General Conference (9-24 Nov 2021), UNESDOC Digital Library, Document Code SC-PCB-SPP/ 2021/OS/UROS (United Nations Educational, Scientific and Cultural Organization, 2021); https://unesdoc.unesco.org/ark:/48223/pf0000379949.locale=en.

27. Dominik, M. et al. Publishing Models, Assessment, and Open Science (Global Young Academy, 2018); https://globalyoungacademy.net/wp-content/uploads/2018/10/APOS-Report-29.10.2018.pdf.

28. Saenen, B., Morais, R., Gaillard, V. & Borrell-Damián, L. Research Assessment in the Transition to Open Science: 2019 EUA Open Science and Access Survey Results (European University Association, 2019); https://eua.eu/downloads/publications/research assessment in%2Othe%2Otransition%2Oto%2Oopen%2Oscience.pdf.

29. San Francisco Declaration on Research Assessment (DORA) https://sfdora.org/ (DORA, accessed 10 November 2023).

30. A New Research Assessment towards a Socially Relevant Science in Latin America and the Caribbean (Latin American Council of Social Sciences (CLACSO), 2022); https:// biblioteca-repositorio.clacso.edu.ar/bitstream/CLACSO/169747/1/Declaration-ofPrincipes.pdf.

31. de Rijcke, S. et al. The Future of Research Evaluation: A Synthesis of Current Debates and Developments (IAP/GYA/ISC, 2023); https://www.interacademies.org/publication/future-research-evaluation-synthesis-current-debates-and-developments.

32. Towards a Reform of the Research Assessment System: Scoping Report (European Commission, Directorate-General for Research and Innovation, 2021); https://data.europa.eu/ doi/10.2777/707440.

33. Agreement on Reforming Research Assessment (Coalition for Advancing Research Assessment, 2022); https://coara.eu/app/uploads/2022/09/2022_07_19_rra_agreement_ final.pdf.

34. Room for Everyone’s Talent – Towards a New Balance in the Recognition and Reward of Academics (VSNU, NFU, KNAW, NWO and ZonMw, 2019); https://www.nwo.nl/sites/nwo/ files/media-files/2019-Recognition-Rewards-Position-Paper_EN.pdf.

35. Working Group for Responsible Evaluation of a Researcher. Good Practice in Researcher Evaluation. Recommendation for the Responsible Evaluation of a Researcher in Finland. Responsible Research Series 7:2020 (The Committee for Public Information (TJNK) and Federation of Finnish Learned Societies (TSV), 2020); https://doi.org/10.23847/isbn. 9789525995282.

36. UIS Data Centre. Science, Technology and Innovation: Research and Experimental Development, (9.5.2) Researchers (in full-time equivalent) per million inhabitants http:// data.uis.unesco.org/index.aspx?queryid=3685 (UNESCO, accessed 5 February 2024).

37. Researchers in R&D (per Million People) [SP.POP.SCIE.RD.P6] (UNESCO Institute for Statistics Bulk Data Download Service, accessed 27 November 2023); https://apiportal. uis.unesco.org/bdds.

38. UNESCO Science Report: Towards 2030. Second revised edition (UNESCO Publishing, 2016); https://doi.org/10.18356/9789210059053.

39. UNESCO Science Report: The Race Against Time for Smarter Development (eds Schneegans, S. et al.) (UNESCO Publishing, 2021); https://doi.org/10.18356/9789210058575.

40. Bangladesh Bureau of Statistics. Indicators 9.5.2: Researchers (in Full-Time Equivalent) per Million Inhabitants (2022) (SDG Tracker – Bangladesh’s Development Mirror, accessed 29 February 2024); https://sdg.gov.bd/page/indicator-wise/1/101/3/0.

41. National Statistical Committee of the Kyrgyz Republic. Indicator 9.5.2 – Researchers (in Full-Time Equivalent) per Million Inhabitants (2022) (Sustainable Development Goals in the Kyrgyz Republic, accessed 29 February 2024); https://sustainabledevelopment-kyrgyzstan.github.io/en/9-5-2/#:~:text=Year%2C%2O2017%2C%2O2018%2C% 202019%2C%2O2O20%2C%2OValue%2C%2O524%2C%2O555%2C%2O527% 2C%2O534%2C.

42. Number of Research Personnel per 10,000 Population in Taiwan from 2011 to 2021 (Statista, accessed 29 February 2024); https://www.statista.com/statistics/324708/taiwan-number-of-researchers-per-10000-population/.

43. Hoffmeister, O. Development Status as a Measure of Development United Nations Conference on Trade and Development (UNCTAD) Research Paper 46 (UN, 2020); https:// doi.org/10.18356/a29d2be8-en.

44. Country Classification: World Bank Country and Lending Groups. Fiscal Year 2012 (World Bank, accessed 22 January 2022); https://datahelpdesk.worldbank.org/knowledgebase/ articles/906519-world-bank-country-and-lending-groups.

45. Working Party of National Experts on Science and Technology Indicators. Revised Field of Science and Technology (FoS) Classification in the Research Manual DSTI/EAS/STP/ NESTI(2006)19/FINAL (Organisation for Economic Co-operation and Development, 2007).

46. Seeber, M., Debacker, N., Meoli, M. & Vandevelde, K. Exploring the effects of mobility and foreign nationality on internal career progression in universities. High. Educ. https://doi. org/10.1007/s10734-022-00878-w (2022).

47. Lopez-Verges, S. et al. Call to action: supporting Latin American early career researchers on the quest for sustainable development in the region. Front. Res. Metr. Anal. 6, 657120 (2021).

48. Dominik, M. et al. Open science – for whom? Data Sci. J. 21, 1 (2022).

49. Corsi, M., D’Ippoliti, C. & Zacchia, G. Diversity of backgrounds and ideas: the case of research evaluation in economics. Res. Policy 48, 103820 (2019).

50. Hirsch, J. E. An index to quantify an individual’s research output. Proc. Natl Acad. Sci. USA 102, 16569-16572 (2005).

51. Valenzuela-Toro, A. M. & Viglino, M. How Latin American researchers suffer in science. Nature 598, 374-375 (2021).

52. Smith, K. M., Crookes, E. & Crookes, P. A. Measuring research ‘impact’ for academic promotion issues from the literature. J. High. Educ. Policy Manag. 35, 410-420 (2013).

53. Necker, S. Scientific misbehavior in economics. Res. Policy 43, 1747-1759 (2014).

54. Täuber, S. & Mahmoudi, M. How bullying becomes a career tool. Nat. Hum. Behav. 6, 475 (2022).

55. Aubert Bonn, N., De Vries, R. G. & Pinxten, W. The failure of success: four lessons learned in five years of research on research integrity and research assessment. BMC Res. Notes 15, 309 (2022).

56. Anderson, M. S., Ronning, E. A., De Vries, R. & Martinson, B. C. The perverse effects of competition on scientists’ work and relationships. Sci. Eng. Ethics 13, 437-461 (2007).

57. Smaldino, P. E. & McElreath, R. The natural selection of bad science. R. Soc. Open Sci. 3, 160384 (2016).

58. Aubert Bonn, N. & Bouter, L. in Handbook of Bioethical Decisions Vol. II. Collaborative Bioethics, Vol. 3 (eds Valdés, E. & Lecaros, J. A.) (Springer, 2023).

59. Hall, K. L. et al. The science of team science: a review of the empirical evidence and research gaps on collaboration in science. Am. Psychol. 73, 532-548 (2018).

60. Scott, J. T. Research diversity and public policy toward invention. Soc. Sci. Res. Netw. https://doi.org/10.2139/ssrn. 4251768 (2022).

61. D’Ippoliti, C. Democratizing the Economics Debate: Pluralism and Research Evaluation (Routledge, 2022).

62. Goodhart, C. A. E. in Monetary Theory and Practice 91-121 (Palgrave, 1984).

63. Hoskin, K. in Accountability: Power, Ethos and the Technologies of Managing (eds Rolland, M. & J. Mouritsen, J.) 265-282 (International Thomson Business, 1996).

64. Dawson, D. et al. The role of collegiality in academic review, promotion, and tenure. PLoS ONE 17, e0265506 (2022).

65. Pepper, J., Krupińska, O. D., Stassun, K. G. & Gelino, D. M. What does a successful postdoctoral fellowship publication record look like? Pub. Astron. Soc. Pac. 131, 014501 (2019).

66. Fernandes, J. D. et al. Research culture: a survey-based analysis of the academic job market. eLife 9, e54097 (2020).

67. Aubert Bonn, N. & Pinxten, W. Advancing science or advancing careers? Researchers’ opinions on success indicators. PLoS ONE 16, eO243664 (2021).

68. Ross-Hellauer, T., Klebel, T., Knoth, P. & Pontika, N. Value dissonance in research(er) assessment: individual and perceived institutional priorities in review, promotion, and tenure. Sci. Public Policy https://doi.org/10.1093/scipol/scad073 (2023).

69. Becerril-García, A. & Aguado-López, E. Redalyc – AmeliCA: A Non-Profit Publishing Model to Preserve the Scholarly and Open Nature of Scientific Communication (United Nations Educational, Scientific and Cultural Organization; Latin American Council of Social Sciences; Network of Scientific Journals from Latin America and the Caribbean, Spain and Portugal; Autonomous University of the State of Mexico; National University of La Plata; University of Antioquia, 2019).

(c) The Author(s) 2025

Methods

Data acquisition

Data preparation

defined in a pilot study to capture key policy features comparably and quantifiably (Supplementary Information sections 1.1 and 1.4). Full definitions and rationale for these criteria are in Supplementary Table 1, with further explanation in Supplementary Information section 1.4.1 and Supplementary Table 2. The criteria are organized into three main categories: research ( 21 criteria); teaching and services (7 criteria); and general traits (2 criteria). Research is further divided into research outputs (11), career development (8) and recognition (2), with research outputs split into quantitative (7) and qualitative (4). Additional details on the rationale and categorization process are provided in Supplementary Information section 1.4.

a policy of institution

Data analysis and visualization

variables explored in this study, including heteroskedasticityrobust standard errors, two-sided

Reporting summary

Data availability

Code availability

70. United Nations Geoscheme. Standard country or area codes for statistical use (M49) https://unstats.un.org/unsd/methodology/m49/ (United Nations Statistics Division, accessed 10 November 2023).

71. Harman, H. H. Modern Factor Analysis 3rd edn (Univ. Chicago Press, 1976).

72. Huber, P. J. The behavior of maximum likelihood estimates under nonstandard conditions. In Proc. 5th Berkeley Symposium on Mathematical Statistics and Probability Vol. 1, 221-233 (Univ. California Press, 1967).

73. White, H. L. A heteroskedasticity-consistent covariance matrix estimator and a direct test for heteroskedasticity. Econometrica 48, 817-838 (1980).

74. Li, B. H. et al. A global assessment of academic promotion criteria: what really counts? Figshare https://figshare.com/s/f8aa5ab402440a9a7933 (2024).

the dataset. The published version of the manuscript was mainly drafted by M.D., C.D’I., Y.F.B., B.H.L. and A.C.H.-M. All figures were drafted by Y.F.B., with support from C.D’I., M.D. and B.H.L. All statistical analyses were performed by C.D’I., Y.F.B. and B.H.L. Manuscript revisions 3-5 were mainly performed by Y.F.B., C.D’I., M.D., B.H.L., A.C.H.-M., K.K.C., S.L.-V. and V.S.M.-S. (in descending order of contributions). The first submitted manuscript was prepared with substantial contributions from M.D., B.H.L., C.D’I., Y.F.B., M.B., K.K.C., A.C.H.-M., I.P., T.E.d.C., S.M., S.L.-V., P.K. and A.M. (in descending order of contributions). The protocol was drafted by S.M., Y.F.B., V.S.M.-S., S.L.-V., K.K.C., I.P., S. Elagroudy, B.H.L., C.D’I. and M.D., on the basis of guidelines and protocols prepared by Y.F.B. and B.H.L. All authors reviewed and approved the content of the study and are personally responsible for their contributions as stated here.

Additional information

Correspondence and requests for materials should be addressed to Y. Flores Bueso.

Peer review information Nature thanks Juan Pablo Alperin, David Moher and Leslie Schimanski for their contribution to the peer review of this work. Peer reviewer reports are available.

Reprints and permissions information is available at http://www.nature.com/reprints.

Article

| CLASS | Counts | |||||

| Countries | Government Agencies | Academic institutions | National policies | Institutional policies | Total policies | |

| Global Regions | ||||||

| Global North | 32 | 14 | 73 | 24 | 141 | 165 |

| Global South | 89 | 44 | 117 | 194 | 173 | 367 |

| Economic status (Income level)* | ||||||

| High-income | 37 | 13 | 84 | 27 | 157 | 184 |

| Upper-middle income | 32 | 18 (2) | 52 | 56 | 83 | 139 |

| Lower-middle income | 33 | 20 (8) | 43 | 68 | 61 | 129 |

| Low-income | 19 | 6 (12) | 11 | 67 | 13 | 80 |

| Continents | ||||||

| Europe | 28 | 15 | 40 | 25 | 62 | 87 |

| Africa | 41 | 14 | 44 | 145 | 61 | 206 |

| Asia | 33 | 19 | 56 | 28 | 91 | 119 |

| Latin America | 16 | 10 | 20 | 20 | 21 | 41 |

| North America | 2 | 0 | 20 | 0 | 57 | 57 |

| Oceania | 1 | 0 | 10 | 0 | 22 | 22 |

| Disciplines | ||||||

| General | – | 51 | 165 | 77 | 187 | 264 |

| Natural sciences | – | 9 | 16 | 41 | 24 | 65 |

| Engineering & Technology | – | 9 | 12 | 31 | 25 | 56 |

| Medicine & Health Sciences | – | 10 | 28 | 32 | 46 | 78 |

| Social sciences & humanities | – | 11 | 22 | 41 | 42 | 83 |

| Tracks | ||||||

| Standard academic track | – | 48 | 178 | 179 | 247 | 426 |

| Research track | – | 15 | 44 | 150 | 53 | 203 |

| Teaching track | – | 1 | 22 | 1 | 38 | 39 |

| Clinical track | – | 5 | 20 | 5 | 25 | 30 |

| Other tracks | – | 0 | 11 | 0 | 13 | 13 |

| Evaluation exclusive to the role of (full) professor? | ||||||

| Not exclusive for professor | – | 16 | 54 | 42 | 70 | 112 |

| Specifically for professor | – | 43 | 140 | 176 | 244 | 420 |

| TOTAL | ||||||

| Number of countries | – | – | – | 63 | 58 | 121 |

| Full dataset | 121 | 58 | 190 | 218 | 314 | 532 |

| Level of detail | Score < 3 | Score = 3 | Score >3 |

| Tracks | |||

| Academic | 27 | 79 | 320 |

| Research | 2 | 16 | 185 |

| Teaching | 3 | 15 | 21 |

| Clinical | 1 | 10 | 19 |

| Other | 1 | 2 | 10 |

| Disciplines | |||

| Natural Sciences | 0 | 8 | 57 |

| Engineering & technology | 0 | 7 | 49 |

| Medicine & health sciences | 3 | 19 | 56 |

| Social sciences & humanities | 0 | 15 | 68 |

| General | 28 | 71 | 165 |

| Source of policy | |||

| National | 12 | 35 | 171 |

| Institutional | 19 | 81 | 214 |

| Global North and Global South | |||

| Global North | 11 | 37 | 117 |

| Global South | 20 | 79 | 268 |

| Economic status (Income level) | |||

| High-income | 12 | 45 | 127 |

| Upper-middle income | 8 | 27 | 104 |

| Lower-middle income | 7 | 35 | 87 |

| Low-income | 4 | 9 | 67 |

Article

| CRITERIA | Output metrics | Visibility and engagement | Career development | Outcomes & impact | Uniqueness |

| Number of Publications | 0.8675 | -0.014 | 0.0104 | 0.0972 | 0.2337 |

| Recent Publications | 0.6978 | 0.1426 | 0.2285 | -0.2918 | 0.3874 |

| Patents | -0.0573 | -0.1178 | 0.092 | 0.8723 | 0.2513 |

| Citations | 0.3456 | 0.2009 | 0.6365 | 0.1415 | 0.3446 |

| Journal indexing | 0.5572 | -0.3516 | 0.2409 | 0.5315 | 0.2402 |

| Number of authors | 0.7047 | 0.0561 | 0.4771 | -0.0561 | 0.2431 |

| Authorship order | 0.8551 | 0.1569 | -0.1146 | 0.2475 | 0.2141 |

| Non-metric journal quality | -0.0458 | 0.8445 | -0.093 | -0.3991 | 0.2717 |

| Role of authors | -0.0693 | 0.7526 | -0.2575 | 0.1521 | 0.3396 |

| Nonmetric publication quality | -0.8313 | 0.168 | -0.0156 | 0.1459 | 0.2062 |

| Social Impact | -0.106 | 0.2397 | -0.0518 | 0.6629 | 0.4207 |

| Farsight | -0.2675 | 0.0272 | -0.63 | 0.6274 | 0.1806 |

| Funding | 0.1424 | 0.2192 | 0.0438 | 0.7258 | 0.3334 |

| Collaborations | -0.3079 | 0.4281 | -0.061 | 0.3718 | 0.4802 |

| Experience abroad | 0.0998 | -0.0792 | 0.775 | 0.0246 | 0.3892 |

| Presentations | -0.2093 | 0.5626 | 0.3029 | 0.0429 | 0.4504 |

| Professional development | 0.1092 | -0.0446 | 0.7519 | 0.2109 | 0.3545 |

| Memberships | -0.2899 | 0.6235 | 0.1939 | 0.1469 | 0.3361 |

| Professional Titles | -0.3051 | 0.1224 | 0.3512 | -0.2671 | 0.7137 |

| Invited positions | -0.5805 | 0.4375 | 0.2149 | 0.1462 | 0.2776 |

| Awards | 0.5102 | 0.6841 | 0.1412 | 0.2883 | 0.142 |

| Commercialisation/Consultancy | 0.0844 | 0.2786 | 0.3006 | 0.5785 | 0.3682 |

| Service to the Profession | -0.5701 | 0.1897 | 0.6828 | 0.2032 | 0.0589 |

| Mentoring | -0.4788 | -0.1457 | 0.4415 | 0.3191 | 0.5135 |

| Teaching | -0.2053 | -0.0367 | 0.2302 | -0.0455 | 0.9124 |

| Administrative roles | -0.5579 | 0.3065 | -0.019 | 0.323 | 0.3967 |

| Community service | 0.2388 | 0.7965 | 0.1087 | 0.1119 | 0.2701 |

| Serving period | 0.0096 | -0.1548 | -0.6141 | -0.0229 | 0.5643 |

| Interdisciplinarity | -0.471 | 0.5808 | 0.104 | -0.0079 | 0.3357 |

| Ethics and integrity | 0.3596 | 0.08 | -0.6288 | 0.3714 | 0.4054 |

Extended Data Table 4 | Heatmap of the correlation among the criteria in each policy

| CRITERIA | No. Publications | Recent publications | Patents | Citations | Journal indexing | No. authors | Authorship order | Non-metric jouranl quality | Role of authors | Non-metric quality of publications | Societal impact | Farsight | Funding | Collaborations | Experience abroad | Presentations | Professional development | Memberships | Professional Titles | Invited positions | Awards | Commercialisation / Consultancy | Service to the profession | Mentoring | Teaching | Administrative roles | Community service | Serving period | Interdisciplinarity |

| Recent publications | 0.84 | 1.00 | |||||||||||||||||||||||||||

| Patents | 0.08 | -0.13 | 1.00 | ||||||||||||||||||||||||||

| Citations | 0.35 | 0.40 | 0.21 | 1.00 | |||||||||||||||||||||||||

| Journal indexing | 0.77 | 0.24 | 0.40 | 0.42 | 1.00 | ||||||||||||||||||||||||

| No. authors | 0.76 | 0.73 | 0.06 | 0.56 | 0.47 | 1.00 | |||||||||||||||||||||||

| Authorship order | 0.78 | 0.46 | 0.11 | 0.38 | 0.65 | 0.66 | 1.00 | ||||||||||||||||||||||

| Non-metric jouranl quality | -0.19 | 0.08 | -0.27 | 0.06 | -0.61 | 0.02 | -0.09 | 1.00 | |||||||||||||||||||||

| Role of authors | -0.12 | 0.01 | 0.29 | 0.18 | -0.37 | -0.47 | 0.03 | 0.47 | 1.00 | ||||||||||||||||||||

| Non-metric pulications qual. | -0.74 | -0.57 | 0.26 | -0.18 | -0.79 | -0.62 | -0.74 | 0.29 | 0.40 | 1.00 | |||||||||||||||||||

| Societal impact | -0.14 | 0.03 | 0.62 | 0.20 | 0.02 | 0.01 | 0.07 | 0.05 | 0.52 | 0.55 | 1.00 | ||||||||||||||||||

| Farsight | -0.19 | -0.51 | 0.48 | -0.45 | -0.12 | -0.74 | 0.15 | -0.03 | 0.41 | 0.50 | 0.52 | 1.00 | |||||||||||||||||

| Funding | 0.19 | -0.16 | 0.58 | 0.23 | 0.36 | 0.31 | 0.52 | 0.28 | 0.30 | 0.20 | 0.58 | 0.68 | 1.00 | ||||||||||||||||

| Collaborations | -0.24 | -0.46 | 0.28 | -0.01 | 0.04 | -0.35 | -0.26 | 0.21 | 0.30 | 0.50 | 0.49 | 0.38 | 0.30 | 1.00 | |||||||||||||||

| Experience abroad | 0.09 | 0.29 | 0.16 | 0.54 | 0.31 | 0.56 | 0.07 | -0.22 | -0.12 | -0.03 | 0.11 | -0.49 | 0.17 | 0.07 | 1.00 | ||||||||||||||

| Presentations | -0.27 | -0.23 | 0.26 | 0.32 | 0.02 | -0.05 | -0.15 | 0.53 | 0.53 | 0.24 | 0.02 | -0.12 | 0.28 | 0.39 | 0.13 | 1.00 | |||||||||||||

| Professional development | 0.13 | 0.22 | 0.24 | 0.53 | 0.42 | 0.46 | 0.21 | -0.09 | -0.11 | -0.24 | 0.12 | -0.39 | 0.36 | -0.09 | 0.37 | 0.38 | 1.00 | ||||||||||||

| Memberships | -0.24 | -0.14 | 0.26 | 0.07 | -0.19 | 0.02 | -0.36 | 0.47 | 0.53 | 0.42 | 0.38 | 0.06 | 0.30 | 0.60 | 0.10 | 0.66 | 0.19 | 1.00 | |||||||||||

| Professional Titles | -0.28 | -0.02 | -0.31 | 0.06 | -0.19 | -0.33 | -0.14 | 0.05 | -0.07 | 0.17 | -0.41 | -0.15 | -0.14 | 0.34 | 0.56 | 0.32 | 0.27 | 0.43 | 1.00 | ||||||||||

| Invited positions | -0.53 | -0.42 | 0.18 | 0.34 | -0.33 | -0.42 | -0.41 | 0.47 | 0.59 | 0.62 | 0.39 | 0.19 | 0.31 | 0.44 | 0.02 | 0.75 | 0.06 | 0.71 | 0.17 | 1.00 | |||||||||

| Awards | 0.40 | 0.13 | 0.35 | 0.60 | 0.30 | 0.64 | 0.61 | 0.34 | 0.63 | -0.23 | 0.27 | 0.02 | 0.64 | 0.37 | 0.30 | 0.54 | 0.39 | 0.61 | -0.12 | 0.22 | 1.00 | ||||||||

| Commercialisation/Consultancy | 0.07 | -0.03 | 0.60 | 0.46 | 0.42 | 0.22 | 0.11 | 0.08 | 0.18 | 0.03 | 0.52 | 0.06 | 0.64 | 0.60 | 0.31 | 0.35 | 0.32 | 0.52 | 0.02 | 0.21 | 0.58 | 1.00 | |||||||

| Service to the profession | -0.50 | -0.26 | 0.31 | 0.40 | -0.21 | 0.02 | -0.38 | 0.20 | 0.28 | 0.69 | 0.52 | -0.03 | 0.33 | 0.39 | 0.54 | 0.60 | 0.68 | 0.76 | 0.54 | 0.85 | 0.14 | 0.39 | 1.00 | ||||||

| Mentoring | -0.17 | -0.15 | 0.43 | 0.22 | -0.11 | -0.15 | -0.34 | -0.04 | 0.23 | 0.49 | 0.17 | 0.19 | 0.38 | -0.02 | 0.20 | 0.20 | 0.43 | 0.53 | 0.26 | 0.45 | -0.04 | 0.11 | 0.71 | 1.00 | |||||

| Teaching | -0.04 | -0.06 | -0.25 | -0.15 | 0.09 | 0.20 | -0.08 | 0.17 | -0.38 | 0.13 | 0.01 | -0.15 | 0.03 | 0.02 | 0.02 | -0.02 | 0.19 | 0.05 | 0.46 | 0.15 | -0.19 | 0.32 | 0.39 | 0.17 | 1.00 | ||||

| Administrative roles | -0.58 | -0.53 | 0.29 | 0.02 | -0.17 | -0.51 | -0.37 | 0.29 | 0.27 | 0.56 | 0.47 | 0.28 | 0.30 | 0.58 | -0.33 | 0.50 | 0.11 | 0.71 | 0.13 | 0.81 | 0.07 | 0.39 | 0.62 | 0.14 | 0.47 | 1.00 | |||

| Community service | 0.04 | 0.26 | 0.16 | 0.27 | -0.06 | 0.38 | 0.39 | 0.49 | 0.53 | 0.12 | 0.51 | -0.01 | 0.44 | 0.56 | 0.25 | 0.29 | 0.35 | 0.69 | 0.28 | 0.18 | 0.71 | 0.64 | 0.36 | -0.10 | 0.13 | 0.37 | 1.00 | ||

| Serving period | 0.09 | -0.08 | -0.04 | -0.72 | 0.00 | -0.16 | 0.02 | -0.11 | -0.17 | -0.15 | -0.21 | 0.41 | -0.11 | -0.16 | -0.56 | -0.28 | -0.54 | -0.02 | 0.25 | -0.35 | -0.39 | -0.29 | -0.60 | -0.20 | 0.35 | 0.03 | -0.28 | 1.00 | |

| Interdisciplinarity | -0.43 | -0.33 | 0.06 | 0.04 | -0.42 | -0.40 | -0.35 | 0.46 | 0.69 | 0.76 | 0.31 | 0.24 | -0.04 | 0.65 | 0.11 | 0.49 | 0.04 | 0.61 | 0.37 | 0.56 | 0.23 | 0.36 | 0.73 | 0.43 | 0.33 | 0.37 | 0.65 | -0.27 | 1.00 |

| Ethics & integrity | 0.29 | -0.10 | 0.10 | -0.13 | 0.30 | -0.28 | 0.48 | -0.28 | 0.19 | -0.40 | 0.25 | 0.41 | 0.16 | 0.13 | -0.45 | -0.16 | -0.24 | -0.09 | -0.14 | -0.30 | 0.21 | 0.03 | -0.56 | -0.25 | -0.03 | -0.01 | 0.14 | 0.41 | -0.16 |

Article

| CRITERIA | Output metrics | Visibility & Engagement | Professional development | Outcomes & Impact | Uniqueness |

| N. of publications | 0.682 | 0.4123 | |||

| Recent publications | 0.378 | 0.3895 | -0.5299 | 0.3792 | |

| Patents | 0.657 | 0.4493 | 0.4212 | ||

| Citations | 0.4566 | 0.4256 | -0.4755 | 0.3798 | |

| Journal indexing | 0.8841 | 0.1821 | |||

| Number of authors | 0.8619 | 0.2568 | |||

| Authorship order | 0.7279 | 0.2602 | |||

| Non-metric journal quality | -0.3468 | 0.7604 | -0.3749 | 0.2467 | |

| Role of authors | 0.3922 | 0.5019 | -0.3868 | 0.4072 | |

| Nonmetric publication quality | -0.4369 | 0.3218 | 0.3917 | 0.3822 | |

| Social Impact | 0.5907 | 0.3856 | 0.3616 | ||

| Farsight | -0.4111 | 0.3827 | 0.4096 | 0.3866 | |

| Funding | 0.4525 | 0.7686 | |||

| Collaborations | -0.3356 | 0.6163 | 0.2679 | ||

| Experience abroad | -0.4792 | 0.604 | 0.5202 | ||

| Presentations | 0.5423 | 0.3017 | 0.6059 | ||

| Professional development | -0.3141 | 0.6616 | 0.4992 | ||

| Memberships | 0.4024 | 0.3363 | 0.5264 | 0.4151 | |

| Professional Titles | 0.8625 | ||||

| Invited positions | 0.4003 | 0.521 | 0.4637 | ||

| Awards | 0.5332 | 0.554 | 0.4277 | ||

| Commercialisation/Consultancy | 0.38 | 0.7948 | |||

| Service to the Profession | 0.4043 | 0.6572 | 0.2814 | ||

| Mentoring | 0.6749 | 0.423 | |||

| Teaching | 0.6969 | 0.4175 | |||

| Administrative roles | 0.7128 | 0.4734 | 0.2194 | ||

| Community service | 0.7296 | 0.3479 | |||

| Serving period | 0.3848 | 0.4178 | -0.4774 | 0.5234 | |

| Interdisciplinarity | 0.5314 | 0.5894 | |||

| Ethics and integrity | 0.7222 | 0.3858 |

| Level of detail | Score < 3 | Score = 3 | Score >3 |

| Tracks | |||

| Academic | 27 | 79 | 320 |

| Research | 2 | 16 | 185 |

| Teaching | 3 | 15 | 21 |

| Clinical | 1 | 10 | 19 |

| Other | 1 | 2 | 10 |

| Disciplines | |||

| Natural Sciences | 0 | 8 | 57 |

| Engineering & technology | 0 | 7 | 49 |

| Medicine & health sciences | 3 | 19 | 56 |

| Social sciences & humanities | 0 | 15 | 68 |

| General | 28 | 71 | 165 |

| Source of policy | |||

| National | 12 | 35 | 171 |

| Institutional | 19 | 81 | 214 |

| Global North and Global South | |||

| Global North | 11 | 37 | 117 |

| Global South | 20 | 79 | 268 |

| Economic status (Income level) | |||

| High-income | 12 | 45 | 127 |

| Upper-middle income | 8 | 27 | 104 |

| Lower-middle income | 7 | 35 | 87 |

| Low-income | 4 | 9 | 67 |

natureportfolio

Last updated by author(s): Oct 23, 2024

Reporting Summary

Statistics

n/a

Confirmed

□ X

The exact sample size

□

□

Only common tests should be described solely by name; describe more complex techniques in the Methods section.

□

□

□

□ X

For null hypothesis testing, the test statistic (e.g.

□ For Bayesian analysis, information on the choice of priors and Markov chain Monte Carlo settings

□ For hierarchical and complex designs, identification of the appropriate level for tests and full reporting of outcomes

□ Estimates of effect sizes (e.g. Cohen’s

Software and code

Data collection

Data was collected using Google Sheets and compiled into a single file downloaded and transformed in Microsoft Excel 16 (Mac) to a CSV file that was the input for the software for analysis. The raw data was shared in a csv format in CodeOcean. Both, raw and clean datasets are shared here: https://doi.org/10.6084/m9.figshare. 23272175.

Data was analysed using Stata17 and plotted using python3 pandas and matplotlib. The panels were assembled and formated using Adobe Ilustrator 2024. The code for data analysis was shared in CodeOcean. https://codeocean.com/capsule/0942594/tree .

Data

All manuscripts must include a data availability statement. This statement should provide the following information, where applicable:

- Accession codes, unique identifiers, or web links for publicly available datasets

- A description of any restrictions on data availability

- For clinical datasets or third party data, please ensure that the statement adheres to our policy

Research involving human participants, their data, or biological material

| Reporting on sex and gender | N/A |

| Reporting on race, ethnicity, or other socially relevant groupings | N/A |

| Population characteristics | N/A |

| Recruitment | N/A |

| Ethics oversight | We are not dealing with any humnan participants, their data or biological material. Our study is limited to the analysis of policies that are developed by instituions and may impact humans but do not directly relate to them. |

Field-specific reporting

□ Life sciences

Behavioural & social sciences □ Ecological, evolutionary & environmental sciences

For a reference copy of the document with all sections, see nature.com/documents/nr-reporting-summary-flat.pdf

Behavioural & social sciences study design

n/a

n/a

Reporting for specific materials, systems and methods

| Materials & experimental systems | Methods | |

| n/a | Involved in the study | n/a |

| X | □ | X |

| X | ||

| X | □ | X |

| X | □ | |

| X | □ | |

Plants

n/a

n/a

- Wilsdon, J. et al. The Metric Tide: Report of the Independent Review of the Role of Metrics in Research Assessment and Management (HEFCE, 2015); https://doi.org/10.13140/ RG.2.1.4929.1363.

- Curry, S., Gadd, E. & Wilsdon, J. Harnessing the Metric Tide: Indicators, Infrastructures & Priorities for UK Responsible Research Assessment – Report of The Metric Tide Revisited Panel (RORI, 2022); https://doi.org/10.6084/m9.figshare.21701624.

- Fauzi, M. A., Tan, C. N. L., Daud, M. & Awalludin, M. M. N. University rankings: a review of methodological flaws. Issues Educ. Res. 30, 79-96 (2020).

- Gadd, E. Mis-measuring our universities: why global university rankings don’t add up. Front. Res. Metr. Anal. https://doi.org/10.3389/frma.2021.680023 (2021).