DOI: https://doi.org/10.2196/53008

PMID: https://pubmed.ncbi.nlm.nih.gov/38457208

تاريخ النشر: 2024-03-08

الذكاء الاصطناعي التوليدي في الممارسة الطبية: استكشاف متعمق لتحديات الخصوصية والأمان

الملخص

مع استمرار تقدم الذكاء الاصطناعي (AI) في تحويل وتغيير مجال الطب، يصبح فهم الاستخدامات المحتملة للذكاء الاصطناعي التوليدي في الرعاية الصحية أكثر أهمية. يُظهر الذكاء الاصطناعي التوليدي، بما في ذلك النماذج مثل الشبكات التنافسية التوليدية والنماذج اللغوية الكبيرة، وعدًا في تحويل التشخيصات الطبية، والبحث، وتخطيط العلاج، ورعاية المرضى. ومع ذلك، فإن هذه الأنظمة التي تتطلب بيانات كثيفة تطرح تهديدات جديدة للمعلومات الصحية المحمية. تهدف هذه الورقة إلى استكشاف فئات مختلفة من الذكاء الاصطناعي التوليدي في الرعاية الصحية، بما في ذلك التشخيصات الطبية، واكتشاف الأدوية، والمساعدين الصحيين الافتراضيين، والبحث الطبي، ودعم اتخاذ القرار السريري، مع تحديد التهديدات الأمنية والخصوصية في كل مرحلة من مراحل دورة حياة هذه الأنظمة (أي، جمع البيانات، وتطوير النموذج، ومرحلة التنفيذ). كانت أهداف هذه الدراسة تحليل الحالة الحالية للذكاء الاصطناعي التوليدي في الرعاية الصحية، وتحديد الفرص والتحديات المتعلقة بالخصوصية والأمان التي تطرحها دمج هذه التقنيات في البنية التحتية الحالية للرعاية الصحية، واقتراح استراتيجيات للتخفيف من مخاطر الأمان والخصوصية. تسلط هذه الدراسة الضوء على أهمية معالجة التهديدات الأمنية والخصوصية المرتبطة بالذكاء الاصطناعي التوليدي في الرعاية الصحية لضمان الاستخدام الآمن والفعال لهذه الأنظمة. يمكن أن تُفيد نتائج هذه الدراسة في تطوير أنظمة الذكاء الاصطناعي التوليدي المستقبلية في الرعاية الصحية وتساعد منظمات الرعاية الصحية على فهم الفوائد والمخاطر المحتملة المرتبطة بهذه الأنظمة بشكل أفضل. من خلال فحص حالات الاستخدام وفوائد الذكاء الاصطناعي التوليدي عبر مجالات متنوعة داخل الرعاية الصحية، تساهم هذه الورقة في المناقشات النظرية المحيطة بأخلاقيات الذكاء الاصطناعي، والثغرات الأمنية، وتنظيمات خصوصية البيانات. بالإضافة إلى ذلك، توفر هذه الدراسة رؤى عملية للمساهمين الذين يتطلعون إلى اعتماد حلول الذكاء الاصطناعي التوليدي داخل منظماتهم.

الكلمات الرئيسية

المقدمة

وهي خوارزميات يمكنها توليف بيانات جديدة، وصور، ونصوص، ومحتويات أخرى بإبداع ودقة شبيهة بالبشر بناءً على الأنماط المستفادة من البيانات الموجودة [2]. يمكن أن يدعم الذكاء الاصطناعي التوليدي الممارسات السريرية في الرعاية الصحية، من توليد بيانات مرضى اصطناعية إلى تعزيز أبحاث الأمراض النادرة إلى إنشاء أنظمة اكتشاف أدوية مدعومة بالذكاء الاصطناعي [3]. لدى الذكاء الاصطناعي التوليدي القدرة على اكتشاف العلامات، والأنماط، والأمراض، والشذوذات، والمخاطر ومساعدة في فحص المرضى لمختلف الأمراض المزمنة، مما يجعل التشخيصات أكثر دقة وقائمة على البيانات وتحسين اتخاذ القرار السريري [4]. كما أن للذكاء الاصطناعي التوليدي

القدرة على تحويل رعاية المرضى مع المساعدين الصحيين الافتراضيين المدعومين بالذكاء الاصطناعي [5].

ومطوري الذكاء الاصطناعي حول التحديات الأمنية والخصوصية المرتبطة بالذكاء الاصطناعي التوليدي في الرعاية الصحية. يمكن أن توجه نتائج هذه الدراسة تطوير أطر حوكمة بيانات قوية، وبنية تحتية آمنة، وإرشادات أخلاقية لضمان الاستخدام الآمن والمسؤول للذكاء الاصطناعي التوليدي في الرعاية الصحية. مع الحوكمة الدقيقة، يمكن تحقيق فوائد النماذج التوليدية مع حماية بيانات المرضى وثقة الجمهور. في النهاية، تساهم هذه الدراسة في تقدم المعرفة في مجال الذكاء الاصطناعي في الرعاية الصحية وتدعم تطوير أنظمة الذكاء الاصطناعي التوليدي الآمنة والمحافظة على الخصوصية لتحسين رعاية المرضى والنتائج.

تطبيقات الذكاء الاصطناعي التوليدي في الرعاية الصحية

نظرة عامة

| الفئة | مثال | الإعداد | المستخدم | بيانات الإدخال | بيانات الإخراج | مستوى التخصيص | تكامل سير العمل | التحقق المطلوب | الأثر | المخاطر | مشاركة الإنسان |

| التشخيص الطبي | AI-Rad Companion | الأشعة | أطباء الأشعة | الصور الطبية | نتائج النص | فردي | بعد التصوير | مرتفع | تشخيص محسن | الموثوقية والتحيز | مرتفع |

| اكتشاف الأدوية | Insilico Medicine | التكنولوجيا الحيوية | علماء البحث | بروتينات الهدف وبيانات الأمراض | هياكل جزيئية جديدة | نصف مخصص | بحث في مرحلة مبكرة | مرتفع | اكتشافات أسرع | متطلبات السلامة والاختبار | متوسطة |

| مساعدات صحية افتراضية | Sensely | عيادات الويب | المرضى | محادثة | محادثة | نصف مخصص | تفاعل المرضى | متوسطة | زيادة الوصول | الخصوصية والمعلومات المضللة | متوسطة |

| البحث الطبي | Anthropic | المختبرات والأكاديميا | الباحثون | مفاهيم البحث ومجموعات البيانات | الفرضيات والأسئلة | نصف مخصص | توليد الأفكار | منخفض | رؤى البحث | التحريف | متوسطة |

| دعم القرار السريري | Glass AI | نقطة الرعاية | الأطباء | بيانات المرضى | اقتراحات العلاج | فردي | التشخيص والعلاج | مرتفع | نتائج محسنة | الاعتماد المفرط والتحيز | مرتفع |

عوامل التمايز

الإعداد

المستخدمون

بيانات الإدخال

بيانات الإخراج

مستوى التخصيص

تكامل سير العمل

احتياجات التحقق

المخاطر

تعاون الإنسان والذكاء الاصطناعي

الملخص

الأهداف تهدف هذه الدراسة إلى الكشف عن الفروق الحاسمة، حالات الاستخدام، مستويات الاعتماد، المخاطر المختلفة، وممارسات التنفيذ من خلال تطوير فئات بناءً على هذه السمات الرئيسية لأنظمة الذكاء الاصطناعي التوليدي. يوضح الإطار المقترح المشهد غير المتجانس للذكاء الاصطناعي التوليدي في الرعاية الصحية ويمكّن من تحليل الاتجاهات عبر الفئات. توفر هذه العوامل منظورًا حول كيفية تجلي الذكاء الاصطناعي التوليدي بشكل مميز لمستخدمين مختلفين، أنواع البيانات، سير العمل، عوامل المخاطر، وشراكات الإنسان والذكاء الاصطناعي داخل الرعاية الصحية. من خلال تحليل منهجي لمجموعة متنوعة من أنظمة الذكاء الاصطناعي التوليدي عبر إعدادات الرعاية الصحية باستخدام العوامل الرئيسية التي تم مناقشتها سابقًا، يمكننا تصنيف المشهد غير المتجانس للذكاء الاصطناعي التوليدي في الرعاية الصحية إلى 5 فئات شاملة: التشخيص الطبي، اكتشاف الأدوية، المساعدات الصحية الافتراضية، البحث الطبي، ودعم القرار السريري.

التشخيص الطبي

اكتشاف الأدوية

المساعدات الصحية الافتراضية

البحث الطبي

الاتجاهات التي تستحق التحقيق [26]. هذه القدرة التوليدية الفريدة يمكن أن تسرع من التقدم العلمي. ومع ذلك، فإن التحقق من قبل الباحثين البشريين أمر حاسم لمنع القبول الأعمى للنتائج التي تنتجها الذكاء الاصطناعي [27].

دعم القرار السريري

مراجعة الأدبيات

الذكاء الاصطناعي التوليدي: موازنة الفوائد والمخاطر

نظرة عامة

سيناريو هجوم و(2) كمدافع يقاوم مهاجمًا قويًا (المميز) لمحاكاة سيناريو دفاع.

حماية خصوصية الصورة السابقة

الخصوصية في أنظمة التعلم الموزعة

الخصوصية التفاضلية في GANs

تم اقتراحها لمعالجة هذا التحدي [39]. تستند هذه الطريقة إلى إطار عمل قائم على GAN العميق يتكون من ثلاثة مكونات رئيسية: (1) شبكة تشفير عميقة، تعمل كمولد، تخفي بكفاءة علامات الهوية في الصور الطبية من خلال دمج ضوضاء إضافية؛ (2) مصنف ثنائي يعمل كالمميز، يضمن أن الصور المحولة تحتفظ بشبه مع نظيراتها الأصلية؛ و(3) شبكة قائمة على الشبكة العصبية التلافيفية مخصصة لتحليل الصور الطبية، تعمل كالمميز البديل المسؤول عن تحليل تفاصيل تقسيم الصور. يدمج هذا الإطار بين مشفر، ومصنف ثنائي، وشبكة تحليل تقسيم لتشكيل نهج قوي لحماية خصوصية البيانات الطبية مع الحفاظ على سلامة وفعالية تقسيم الصور الطبية.

سجل، هجوم العضوية، أقصى تشابه بين البيانات الحقيقية والاصطناعية، تكلفة الخصوصية التفاضلية، والشبكات التوليدية المعادية. على سبيل المثال، الخصوصية التفاضلية هي نهج يضيف ضوضاء إلى البيانات لمنع التعرف على الأفراد. يمكن للشبكات التوليدية المعادية إنشاء نقاط بيانات جديدة وغير حقيقية. تحاول تقنيات الإحصاء المتقدمة وتعلم الآلة الأخرى تحقيق التوازن بين فائدة البيانات والخصوصية. كل طريقة لها نقاط قوتها وقيودها، والاختيار يعتمد على المتطلبات المحددة لتطبيق الرعاية الصحية وحساسية البيانات المعنية.

تتناول دراسة إمكانيات التعلم الفيدرالي كنهج يحافظ على الخصوصية في تطبيقات الذكاء الاصطناعي في الرعاية الصحية. التعلم الفيدرالي هو نموذج ذكاء اصطناعي موزع يوفر الحفاظ على الخصوصية في أنظمة الرعاية الصحية الذكية من خلال السماح بتدريب النماذج دون الوصول إلى البيانات المحلية للمشاركين. يوفر الخصوصية للمستخدمين النهائيين من خلال مشاركة التدرجات فقط أثناء التدريب. الهدف من التعلم الفيدرالي في تطبيقات الذكاء الاصطناعي للرعاية الصحية هو الحفاظ على خصوصية المعلومات الحساسة للمرضى التي يتم تبادلها بين المستشفيات والمستخدمين النهائيين، وخاصة من خلال أجهزة إنترنت الأشياء الطبية. يتضمن هذا النهج تقنيات متقدمة مثل التعلم المعزز، التوأم الرقمي، والشبكات التنافسية التوليدية لاكتشاف ومنع تهديدات الخصوصية في شبكات إنترنت الأشياء الطبية. المستفيدون المحتملون من التعلم الفيدرالي في الرعاية الصحية يشملون المرضى، مقدمي الرعاية الصحية، والمنظمات المعنية بالبحث والتحليل التعاوني في الرعاية الصحية. ومع ذلك، فإن تنفيذ التعلم الفيدرالي في شبكات إنترنت الأشياء الطبية يواجه تحديات، مثل الحاجة إلى تعلم فيدرالي قوي لمجموعات البيانات الصحية الموزعة، ودمج التعلم الفيدرالي مع شبكات إنترنت الأشياء الطبية من الجيل التالي، واستخدام تقنية البلوكشين لتخزين البيانات بشكل لامركزي وآمن. علاوة على ذلك، يتم استكشاف آليات الحوافز لتشجيع مشاركة أجهزة إنترنت الأشياء الطبية في التعلم الفيدرالي، ويتم الاستفادة من تقنية التوأم الرقمي لإنشاء بيئات آمنة قائمة على الويب لمراقبة المرضى عن بُعد والبحث في الرعاية الصحية. بشكل عام، يهدف التعلم الفيدرالي في تطبيقات الذكاء الاصطناعي للرعاية الصحية إلى معالجة مخاوف الخصوصية والأمان مع تمكين أنظمة الرعاية الصحية التعاونية والفعالة.

الذكاء الاصطناعي، التحديات القانونية، والتنظيم

تهديدات الأمن والخصوصية في دورة حياة الذكاء الاصطناعي التوليدي في نظام الرعاية الصحية

نظرة عامة

الهجمات (على سبيل المثال، عكس النموذج، واستخراج النموذج، ومجموعة متنوعة من هجمات الخصوصية)، واستغلال ثغرات الشيفرة؛ يجب أن تكون استراتيجيات الدفاع في هذه المرحلة شاملة من خلال دمج حلول متنوعة مثل اختبار الفوضى وحماية الخصوصية المعتمدة على blockchain.

مرحلة جمع البيانات والمعالجة

والتحيزات. بشكل غير مقصود، يهدد زيادة حجم البيانات وتعقيد الذكاء الاصطناعي التوليدي نزاهة البيانات لأن الأخطاء والتحيزات عرضة للحدوث [63]. تعتمد الأخطاء والتحيزات أيضًا على مصادر البيانات لأنواع مختلفة من الذكاء الاصطناعي التوليدي في الرعاية الصحية. على سبيل المثال، تجميع قواعد بيانات الجينوم و

قواعد بيانات المركبات الكيميائية أو هياكل البروتين لاكتشاف الأدوية أمر بالغ الصعوبة وقد يكون مليئًا بالأخطاء لأن العديد من قواعد بيانات الجينوم والبروتين تفتقر إلى التعليقات الضرورية، وتكون غير متسقة في التنسيقات، وقد تكون رديئة في جودة البيانات [64].

علاوة على ذلك، تعتمد العديد من تطبيقات الذكاء الاصطناعي التوليدي في الرعاية الصحية على LLMs وتدربت على كميات كبيرة من بيانات الإنترنت دون أن يتم فحصها وتنقيحها بشكل صحيح [70]. يمكن للخصوم استخدام تقنيات الذكاء الاصطناعي لإنشاء كميات كبيرة من البيانات المزيفة تلقائيًا لتسميم البيانات التي سيتم إدخالها في LLMs، مما يؤدي إلى تدهور أداء النماذج (مثل الدقة والعدالة) وفي النهاية هلوسة الذكاء الاصطناعي، والمعلومات المضللة أو الخاطئة، والتزييف العميق. على الرغم من أن بعض هذه التهديدات ليست فريدة من نوعها للذكاء الاصطناعي التوليدي في الرعاية الصحية، إلا أنها قد تكون خطيرة بشكل خاص إذا تم استخدام معلومات خاطئة في اتخاذ القرارات الطبية. يحمل الذكاء الاصطناعي التوليدي أيضًا مخاطر فريدة تتعلق بالنزاهة. كما ذُكر سابقًا، فإن قدرته على إنشاء بيانات اصطناعية تؤدي إلى خطر فريد للنزاهة – هلوسة الذكاء الاصطناعي. في سياق الرعاية الصحية، يمكن استخدام الذكاء الاصطناعي التوليدي في الرعاية الصحية لإنشاء سجلات طبية مزيفة أو تعديل السجلات الموجودة. يمكن إدخال بيانات طبية مزيفة مرة أخرى في LLMs، مما يهدد نزاهة المعلومات الطبية. على سبيل المثال، يمكن أن يؤدي الاستخدام الخبيث للتزييف العميق الذي تم إنشاؤه بواسطة نماذج توليدية عميقة إلى تزوير تاريخ المريض الطبي للمطالبة بالتأمين بشكل خاطئ أو يؤدي إلى علاجات غير صحيحة. مثال آخر هو أن نموذج الذكاء الاصطناعي التوليدي قد ينشئ تقارير أشعة اصطناعية لت

تشخيص حالات طبية غير موجودة، مما يؤدي إلى تشخيص خاطئ أو علاج غير ضروري.

| فئات الذكاء الاصطناعي | مصدر البيانات | تهديدات الأمان والخصوصية | ||||||||||||||||||

| غير المقصودة (تهديدات النزاهة والخصوصية) | المتعمدة (هجمات التوافر والنزاهة) | |||||||||||||||||||

| التشخيصات الطبية |

|

|

1-3: التلاعب بالبرمجيات، وتزوير أجهزة الاستشعار الطبية، والتلاعب أو تسميم المعدات الطبية (مثل، التلاعب بمعدات التصوير المقطعي والتصوير بالرنين المغناطيسي)، والتلاعب بالصور الطبية (مثل تغيير حجم الصور، والتلاعب بنسخ وتحريك، والتوضيح، والتشويش، وإعادة العينة)، والبيانات والصور المزيفة التوليدية (مثل، صور التصوير المقطعي والتصوير بالرنين المغناطيسي المزيفة التي لا يمكن اكتشافها من قبل كل من الخبراء البشر والذكاء الاصطناعي التوليدي)، وتلاعب أو تسميم البيانات الطبية (مثل، حقن الضوضاء والبيانات التي تم إنشاؤها بشكل خبيث) | |||||||||||||||||

| اكتشاف الأدوية |

|

|

|

|||||||||||||||||

| مساعدو الصحة الافتراضيون |

|

|

|

|||||||||||||||||

| البحث الطبي |

|

1-7: يمكن أن تنطبق جميع الأخطاء والتحيزات المذكورة في الخلايا أعلاه | 1-7: جميع الهجمات المذكورة في الخلايا أعلاه قد تكون قابلة للتطبيق | |||||||||||||||||

| فئات الذكاء الاصطناعي | مصدر البيانات | تهديدات الأمن والخصوصية | ||||||||

| غير مقصود (تهديدات النزاهة والخصوصية) | الهجمات المتعمدة (هجمات التوافر والنزاهة) | |||||||||

| دعم القرار السريري |

|

1-7: يمكن أن تنطبق جميع الأخطاء والتحيزات المذكورة في الخلايا أعلاه | 1-7: جميع الهجمات المذكورة في الخلايا أعلاه قد تكون قابلة للتطبيق | |||||||

مرحلة تدريب النموذج وبنائه

في عملية تدريب النموذج. على النقيض من ذلك، تستكشف الأطراف الخبيثة أيضًا هذه الطريقة بشكل مكثف وتستخدم الأمثلة العدائية لمهاجمة نماذج التدريب لإنتاج نتائج غير صحيحة. تقنيًا، يمكن مهاجمة جميع أنواع الذكاء الاصطناعي التوليدي التي تستخدم GANs وLLMs، وخاصة تلك في الرعاية الصحية، باستخدام أمثلة عدائية تضر بنزاهة نموذج التدريب. على سبيل المثال، يمكن للخصوم استخدام هجمات تغيير حجم الصور لإدخال بيانات غير مرئية للبشر في نموذج الذكاء الاصطناعي لإجباره على ارتكاب خطأ.

مرحلة التنفيذ

الهلاوس الناتجة عن الشبكات التوليدية المعتمدة على الخصوم (GANs) ونماذج اللغة الكبيرة (LLMs) واستخدام البيانات الاصطناعية هي منطقة غير معروفة في البحث والممارسة، مما يؤدي إلى ثغرات غير معروفة مثل الهجمات العدائية.

تشخيص طبي توليدي واكتشاف أدوية باستخدام الذكاء الاصطناعي الذي يتضمن قواعد بيانات جينومية وهياكل مركبات كيميائية أو بروتينات

قواعد البيانات عرضة للغاية لهجمات الخصوصية. أشار فرنانديس وآخرون [87] إلى أن البيانات الجينومية مثل بيانات الحمض النووي عرضة لهجمات الاستنتاج، وهجمات إعادة التعرف، وهجمات العضوية، وهجمات الاسترداد. من المقلق للغاية عندما تستهدف مثل هذه الهجمات الأفراد البارزين. علاوة على ذلك، يعزز الذكاء الاصطناعي التوليدي القدرة على تصنيف المرضى، مما يزيد من خطر انتهاكات الخصوصية والهجمات، على الرغم من أن هذه القدرة ليست فريدة من نوعها للذكاء الاصطناعي.

| الفئة | مرحلة تدريب النموذج وبنائه | مرحلة التنفيذ | ||

| تهديدات النزاهة | تهديدات التوافر | تهديدات النزاهة | تهديدات السرية | |

| التشخيص الطبي | التدريب العدائي والتلاعب في التصنيف (مثل، التلاعب في تصنيف الصور) | تدهور أداء النموذج من خلال تغذية بيانات سامة | هلوسة الذكاء الاصطناعي (مثل، تشخيص مختلق)، معلومات مضللة أو مضللة، واستغلال الاستخدام العدائي | استخراج البيانات من توجيهات مصممة بعناية وهجمات الخصوصية |

| اكتشاف الأدوية | التدريب العدائي والتلاعب في التصنيف | تدهور أداء النموذج من خلال تغذية بيانات سامة | هلوسة الذكاء الاصطناعي (مثل، هياكل مركبات كيميائية أو بروتينات مختلقة)، معلومات مضللة أو مضللة، واستغلال الاستخدام العدائي | استخراج البيانات من توجيهات مصممة بعناية وهجمات الخصوصية |

| مساعدات صحية افتراضية | التدريب العدائي والتلاعب في التصنيف | تدهور أداء النموذج من خلال تغذية بيانات سامة | هلوسة الذكاء الاصطناعي (مثل، نصائح طبية مختلقة)، معلومات مضللة أو مضللة، واستغلال الاستخدام العدائي | استخراج البيانات من توجيهات مصممة بعناية وهجمات الخصوصية |

| البحث الطبي | التدريب العدائي والتلاعب في التصنيف | تدهور أداء النموذج من خلال تغذية بيانات سامة | هلوسة الذكاء الاصطناعي (مثل، نتائج مختلقة، فرضيات، واستشهادات)، معلومات مضللة أو مضللة، واستغلال الاستخدام العدائي | استخراج البيانات من توجيهات مصممة بعناية وهجمات الخصوصية |

| دعم اتخاذ القرار السريري | التدريب العدائي والتلاعب في التصنيف | تدهور أداء النموذج من خلال تغذية بيانات سامة | هلوسة الذكاء الاصطناعي (مثل، استنتاجات مختلقة، نتائج، وتوصيات)، معلومات مضللة أو مضللة، واستغلال الاستخدام العدائي | استخراج البيانات من توجيهات مصممة بعناية وهجمات الخصوصية |

التوصيات

نظرة عامة

لحمايتها أمر حاسم. تقدم هذه القسم بعض التوصيات حول وسائل الحماية. في القيام بذلك، نعتمد على إطار عمل الخصوصية من المعهد الوطني للمعايير والتكنولوجيا وإطار عمل إدارة مخاطر الذكاء الاصطناعي من المعهد الوطني للمعايير والتكنولوجيا بالإضافة إلى الإرشادات التنظيمية التي تم مناقشتها في قسم مراجعة الأدبيات. يجب أن نلاحظ أنه على الرغم من أن التهديدات الأمنية والخصوصية التي تم مناقشتها في هذه الدراسة مهمة وبعضها فريد في سياق الذكاء الاصطناعي التوليدي في الرعاية الصحية، إلا أن العديد منها شائعة أيضًا في أنواع أخرى من نماذج الذكاء الاصطناعي وتطبيقات الذكاء الاصطناعي

في سياقات أخرى. وبالتالي، يمكن تطبيق العديد من التوصيات التي نقترحها في القسم التالي على الذكاء الاصطناعي في سياقات غير الرعاية الصحية.

بروتوكولات تطوير تقييم المخاطر للذكاء الاصطناعي التوليدي في الرعاية الصحية

بروتوكولات تقييم مخاطر الذكاء الاصطناعي

في مرحلة تدريب وبناء النموذج، تعتبر عملية الكشف والتصفية مهمة أيضًا لتحديد وإزالة أمثلة التدريب المعادية. يمكن أن تساعد الاختبارات المتعلقة بالمتانة والعمومية واختبارات الضعف الأخرى (مثل اختبارات الصندوق الأسود والصندوق الأبيض) في منع هجمات النزاهة والتوافر وتسريبات البيانات. إعادة بناء المدخلات هي آلية أخرى لتحديد مصادر التدريب المعادي. قد يساعد تعديل عمليات التدريب والنماذج بالإضافة إلى طرق التدريب أيضًا في السيطرة على مخاطر الذكاء الاصطناعي في هذه المرحلة. نظرًا لتعقيد وتنوع نماذج الذكاء الاصطناعي في التفكير والتعلم، نقترح نهج التصنيف. على سبيل المثال، يمكن أن يحمل نموذج التعلم العميق

مخاطر مختلفة بشكل كبير عن نموذج التعلم الاحتمالي. من خلال بناء تصنيف لنماذج الذكاء الاصطناعي ومخاطرها، يمكن للباحثين تحديد والتحكم بشكل منهجي في مخاطر الأمان والخصوصية بناءً على نموذج الذكاء الاصطناعي.

مقاييس تقييم مخاطر الذكاء الاصطناعي

أهداف الأمن

مقاييس خاصة بالذكاء الاصطناعي التوليدي

عدم قابلية الفهم للذكاء الاصطناعي

الشفافية بسبب طبيعتها المغلقة أو قيود الملكية الفكرية. لذلك، يواجه العديد منها، حتى تلك التي لا تعتمد على تقنيات توليدية، تدقيقًا مشابهًا بشأن نقص الشفافية. ومن ثم، فإن الدعوة إلى مزيد من الانفتاح والقدرة على التفسير تنطبق بشكل واسع على تطبيقات الذكاء الاصطناعي في الرعاية الصحية، مما يعكس الطلب المتزايد على أنظمة الذكاء الاصطناعي القابلة للمساءلة والتفسير.

موثوقية الذكاء الاصطناعي

موثوقية تشخيص الذكاء الاصطناعي في الأشعة للأطباء. نظرًا لتعقيد قياس موثوقية الذكاء الاصطناعي، نوصي بتطوير مقاييس موثوقية الذكاء الاصطناعي المحددة حسب السياق. على غرار عدم قابلية الذكاء الاصطناعي للفهم، على الرغم من أن موثوقية الذكاء الاصطناعي ليست مقياسًا مباشرًا لمخاطر الأمان والخصوصية، إلا أنها تساعد في تقليل احتمال وحجم هذه المخاطر طوال دورة حياة الذكاء الاصطناعي التوليدي في الرعاية الصحية. على سبيل المثال، تساعد الدقة والموثوقية في تحسين نزاهة نظام الذكاء الاصطناعي.

مسؤولية الذكاء الاصطناعي

ضرر الذكاء الاصطناعي

من المساءلة البشرية. قد يكون من الصعب إنسانية أنظمة الذكاء الاصطناعي ونقل سمات مثل الموثوقية إلى الخوارزميات نفسها. قد تؤدي مؤشرات شفافية النموذج والموثوقية أو الدقة إلى تعزيز الثقة بين أصحاب المصلحة، لكن الثقة العامة تنبع أساسًا من الحوكمة الأخلاقية للبيانات، والتواصل بشأن المخاطر، وإجراءات الإشراف التي تنفذها المنظمات. بدون حوكمة قوية وعمليات مراجعة تشرف على التطوير وممارسات البيانات ورصد المخاطر، فإن ادعاءات موثوقية الذكاء الاصطناعي تفتقر إلى الت substantiation. وبالمثل، على الرغم من أن مخرجات الخوارزميات التي تسلط الضوء على القضايا المحتملة مثل التحيزات أو الأخطاء تزيد من الوعي، فإن هذا لا يعني بالضرورة مسؤولية الذكاء الاصطناعي. تتضمن المساءلة الحقيقية التحقيق الدقيق من قبل البشر في المشكلات التي تظهر، واتخاذ الإجراءات المناسبة، والإشراف المستمر من السلطات. قد تهدف المقاييس إلى جعل الذكاء الاصطناعي يبدو أكثر مسؤولية، لكن المسؤولية تتجلى بشكل أساسي في التزام المؤسسات باكتشاف المشكلات، والعمل مع الخبراء لتقييم أضرار الذكاء الاصطناعي بشكل صحيح، وإقامة عمليات تعويض قوية بمشاركة أصحاب المصلحة. وبالتالي، فإن الموثوقية والمسؤولية تعتمد على هياكل الدعم المؤسسي الواسعة بدلاً من القدرات الفطرية للنموذج. على الرغم من أن مؤشرات التقدم قد تعمل كإشارات لهذه السمات المرغوبة، فإن إنشاء ثقة عامة حقيقية ومساءلة في الرعاية الصحية يقع في النهاية على عاتق مديري الرعاية الصحية والمبتكرين والمجتمعات المشاركة، بدلاً من أن يكون ذلك مقتصرًا على الخوارزميات نفسها. يتيح توضيح هذا التمييز لنا تحديد التوقعات بشكل صحيح وتحديد المسؤوليات مع تزايد انتشار الذكاء الاصطناعي التوليدي في البيئات الطبية الحرجة.

الاستنتاجات

وتحديات الأمان التي يجب معالجتها بشكل استباقي لضمان الاستخدام الآمن والفعال لهذه الأنظمة. يساعد فحص التطبيقات المتنوعة للذكاء الاصطناعي التوليدي عبر المجالات الطبية (مثل، التشخيص الطبي، اكتشاف الأدوية، المساعدين الصحيين الافتراضيين، البحث الطبي، ودعم اتخاذ القرار السريري) هذه الدراسة في كشف الثغرات والتهديدات عبر دورة حياة هذه الأنظمة، من جمع البيانات إلى تطوير النماذج إلى التنفيذ السريري. على الرغم من أن الذكاء الاصطناعي التوليدي يمكّن من استخدام حالات مبتكرة، إلا أن هناك حاجة إلى تدابير كافية لمنع انتهاكات المعلومات الصحية المحمية والحفاظ على ثقة الجمهور. يمكن أن تساعد استراتيجيات مثل تطوير بروتوكولات تقييم مخاطر الذكاء الاصطناعي؛ وصياغة مقاييس محددة للذكاء الاصطناعي التوليدي مثل عدم القابلية للفهم، والموثوقية، والمسؤولية، والضرر؛ والمراقبة المستمرة للنماذج في التخفيف من المخاطر. ومع ذلك، فإن تطوير أطر حوكمة قوية وتحديثات لقوانين خصوصية البيانات مطلوبة أيضًا للإشراف على هذه التقنيات المتطورة بسرعة. من خلال تحليل حالات الاستخدام، والتأثيرات، والمخاطر للذكاء الاصطناعي التوليدي عبر مجالات متنوعة ضمن الرعاية الصحية، تساهم هذه الدراسة في المناقشات النظرية المحيطة بأخلاقيات الذكاء الاصطناعي، والثغرات الأمنية، وقوانين خصوصية البيانات. يجب أن تركز الأبحاث والتطوير المستقبلية في أنظمة الذكاء الاصطناعي التوليدي على الأمان والخصوصية لضمان الاستخدام المسؤول والموثوق لهذه النماذج في الرعاية الصحية. علاوة على ذلك، يجب أن تكون المخاوف المتعلقة بالأمان والخصوصية التي تم تسليط الضوء عليها في هذا التحليل بمثابة دعوة للعمل لكل من مجتمع الذكاء الاصطناعي ومنظمات الرعاية الصحية التي تسعى إلى دمج الذكاء الاصطناعي التوليدي. ستكون الجهود التعاونية بين مطوري الذكاء الاصطناعي، ومقدمي الرعاية الصحية، وصانعي السياسات، وخبراء المجال حاسمة في فتح فوائد الذكاء الاصطناعي التوليدي مع إعطاء الأولوية أيضًا للأخلاقيات، والمساءلة، والسلامة. من خلال وضع الأساس لجعل الأمان والخصوصية الركائز الأساسية للذكاء الاصطناعي التوليدي في الطب، يمكن للمعنيين العمل لضمان استخدام هذه التقنيات التحويلية بشكل مسؤول لصالح المرضى في جميع أنحاء العالم.

تعارض المصالح

References

- Noorbakhsh-Sabet N, Zand R, Zhang Y, Abedi V. Artificial intelligence transforms the future of health care. Am J Med. Jul 2019;132(7):795-801. [FREE Full text] [doi: 10.1016/j.amjmed.2019.01.017] [Medline: 30710543]

- Eysenbach G. The role of ChatGPT, generative language models, and artificial intelligence in medical education: a conversation with ChatGPT and a call for papers. JMIR Med Educ. Mar 06, 2023;9:e46885. [FREE Full text] [doi: 10.2196/46885] [Medline: 36863937]

- Kung TH, Cheatham M, Medenilla A, Sillos C, De Leon L, Elepaño C, et al. Performance of ChatGPT on USMLE: potential for AI-assisted medical education using large language models. PLOS Digit Health. Feb 9, 2023;2(2):e0000198. [FREE Full text] [doi: 10.1371/journal.pdig.0000198] [Medline: 36812645]

- Li X, Jiang Y, Rodriguez-Andina JJ, Luo H, Yin S, Kaynak O. When medical images meet generative adversarial network: recent development and research opportunities. Discov Artif Intell. Sep 22, 2021;1(1):1-20. [FREE Full text] [doi: 10.1007/s44163-021-00006-0]

- Topol EJ. As artificial intelligence goes multimodal, medical applications multiply. Science. Sep 15, 2023;381(6663):adk6139. [doi: 10.1126/science.adk6139] [Medline: 37708283]

- Dwivedi YK, Kshetri N, Hughes L, Slade EL, Jeyaraj A, Kar AK, et al. Opinion paper: “so what if ChatGPT wrote it?” Multidisciplinary perspectives on opportunities, challenges and implications of generative conversational AI for research, practice and policy. Int J Inf Manage. Aug 2023;71:102642. [doi: 10.1016/j.jjinfomgt.2023.102642]

- Thirunavukarasu AJ, Ting DS, Elangovan K, Gutierrez L, Tan TF, Ting DS. Large language models in medicine. Nat Med. Aug 17, 2023;29(8):1930-1940. [doi: 10.1038/s41591-023-02448-8] [Medline: 37460753]

- Alqahtani H, Kavakli-Thorne M, Kumar G. Applications of generative adversarial networks (GANs): an updated review. Arch Computat Methods Eng. Dec 19, 2019;28(2):525-552. [doi: 10.1007/s11831-019-09388-y]

- Jain S, Seth G, Paruthi A, Soni U, Kumar G. Synthetic data augmentation for surface defect detection and classification using deep learning. J Intell Manuf. Nov 18, 2020;33(4):1007-1020. [doi: 10.1007/s10845-020-01710-x]

- Arora A, Arora A. The promise of large language models in health care. Lancet. Feb 2023;401(10377):641. [doi: 10.1016/s0140-6736(23)00216-7]

- Zeng X, Wang F, Luo Y, Kang S, Tang J, Lightstone FC, et al. Deep generative molecular design reshapes drug discovery. Cell Rep Med. Dec 20, 2022;3(12):100794. [FREE Full text] [doi: 10.1016/j.xcrm.2022.100794] [Medline: 36306797]

- Jiang S, Hu J, Wood KL, Luo J. Data-driven design-by-analogy: state-of-the-art and future directions. J Mech Des. 2022;144(2):020801. [doi: 10.1115/1.4051681]

- Javaid M, Haleem A, Singh RP. ChatGPT for healthcare services: an emerging stage for an innovative perspective. TBench. Feb 2023;3(1):100105. [doi: 10.1016/j.tbench.2023.100105]

- Nova K. Generative AI in healthcare: advancements in electronic health records, facilitating medical languages, and personalized patient care. J Adv Anal Healthc Manag. 2023;7(1):115-131. [FREE Full text]

- Zhang P, Kamel Boulos MN. Generative AI in medicine and healthcare: promises, opportunities and challenges. Future Internet. Aug 24, 2023;15(9):286. [doi: 10.3390/fi15090286]

- Byrne DW. Artificial Intelligence for Improved Patient Outcomes: Principles for Moving Forward with Rigorous Science. Philadelphia, PA. Lippincott Williams & Wilkins; 2022.

- Bohr A, Memarzadeh K. The rise of artificial intelligence in healthcare applications. In: Bohr A, Memarzadeh K, editors. Artificial Intelligence in Healthcare. Amsterdam, The Netherlands. Elsevier Academic Press; 2020.

- Paul D, Sanap G, Shenoy S, Kalyane D, Kalia K, Tekade RK. Artificial intelligence in drug discovery and development. Drug Discov Today. Jan 2021;26(1):80-93. [FREE Full text] [doi: 10.1016/j.drudis.2020.10.010] [Medline: 33099022]

- Mosqueira-Rey E, Hernández-Pereira E, Alonso-Ríos D, Bobes-Bascarán J, Fernández-Leal Á. Human-in-the-loop machine learning: a state of the art. Artif Intell Rev. Aug 17, 2022;56(4):3005-3054. [doi: 10.1007/s10462-022-10246-w]

- Martín-Noguerol T, Oñate Miranda MO, Amrhein TJ, Paulano-Godino F, Xiberta P, Vilanova JC, et al. The role of Artificial intelligence in the assessment of the spine and spinal cord. Eur J Radiol. Apr 2023;161:110726. [doi: 10.1016/j.ejrad.2023.110726] [Medline: 36758280]

- Ellis RJ, Sander RM, Limon A. Twelve key challenges in medical machine learning and solutions. Intell Based Med. 2022;6:100068. [doi: 10.1016/j.ibmed.2022.100068]

- Martinelli DD. Generative machine learning for de novo drug discovery: a systematic review. Comput Biol Med. Jun 2022;145:105403. [doi: 10.1016/j.compbiomed.2022.105403] [Medline: 35339849]

- Kasirzadeh A, Gabriel I. In conversation with artificial intelligence: aligning language models with human values. Philos Technol. Apr 19, 2023;36(2):1-24. [doi: 10.1007/s13347-023-00606-x]

- van Bussel MJ, Odekerken-Schröder GJ, Ou C, Swart RR, Jacobs MJ. Analyzing the determinants to accept a virtual assistant and use cases among cancer patients: a mixed methods study. BMC Health Serv Res. Jul 09, 2022;22(1):890. [FREE Full text] [doi: 10.1186/s12913-022-08189-7] [Medline: 35804356]

- Xu L, Sanders L, Li K, Chow JC. Chatbot for health care and oncology applications using artificial intelligence and machine learning: systematic review. JMIR Cancer. Nov 29, 2021;7(4):e27850. [FREE Full text] [doi: 10.2196/27850] [Medline: 34847056]

- Summerfield C. Natural General Intelligence: How Understanding the Brain Can Help Us Build AI. Oxford, UK. Oxford University Press; 2022.

- Gesk TS, Leyer M. Artificial intelligence in public services: when and why citizens accept its usage. Gov Inf Q. Jul 2022;39(3):101704. [doi: 10.1016/j.giq.2022.101704]

- Wang Z, Qinami K, Karakozis IC, Genova K, Nair P, Hata K. Towards fairness in visual recognition: effective strategies for bias mitigation. In: Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020 Presented at: CVPR ’20; June 13-19, 2020, 2020;8916-8925; Seattle, WA. URL: https://ieeexplore.ieee.org/document/ 9156668 [doi: 10.1109/cvpr42600.2020.00894]

- Cai Z, Xiong Z, Xu H, Wang P, Li W, Pan Y. Generative adversarial networks: a survey toward private and secure applications. ACM Comput Surv. Jul 13, 2021;54(6):1-38. [doi: 10.1145/3459992]

- Huang C, Kairouz P, Chen X, Sankar L, Rajagopal R. Context-aware generative adversarial privacy. Entropy. Dec 01, 2017;19(12):656. [doi: 10.3390/e19120656]

- Tripathy A, Wang Y, Ishwar P. Privacy-preserving adversarial networks. In: Proceedings of the 57th Annual Allerton Conference on Communication, Control, and Computing. 2019 Presented at: ALLERTON ’19; September 24-27, 2019, 2019;495-505; Monticello, IL. URL: https://ieeexplore.ieee.org/document/8919758 [doi: 10.1109/allerton.2019.8919758]

- Chen CS, Chang SF, Liu CH. Understanding knowledge-sharing motivation, incentive mechanisms, and satisfaction in virtual communities. Soc Behav Pers. May 01, 2012;40(4):639-647. [doi: 10.2224/sbp.2012.40.4.639]

- Liu S, Shrivastava A, Du J, Zhong L. Better accuracy with quantified privacy: representations learned via reconstructive adversarial network. arXiv Preprint posted online January 25, 2019. 2019. [FREE Full text] [doi: 10.1090/mbk/121/79]

- Tseng BW, Wu PY. Compressive privacy generative adversarial network. IEEE Trans Inf Forensics Secur. 2020;15:2499-2513. [doi: 10.1109/tifs.2020.2968188]

- Shokri R, Shmatikov V. Privacy-preserving deep learning. In: Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015 Presented at: CCS ’15; October 12-16, 2015, 2015;1310-1321; Denver, CO. URL: https://dl.acm.org/doi/10.1145/2810103.2813687 [doi: 10.1145/2810103.2813687]

- McMahan B, Moore E, Ramage D, Hampson S. Communication-efficient learning of deep networks from decentralized data. In: Proceedings of the 20th International Conference on Artificial Intelligence and Statistics. 2017. Presented at: AISTATS ’17; April 20-22, 2017, 2017; Fort Lauderdale, FL. URL: https://proceedings.mlr.press/v54/mcmahan17a?ref=https:/ /githubhelp.com

- Nasr M, Shokri R, Houmansadr A. Machine learning with membership privacy using adversarial regularization. In: Proceedings of the 2018 ACM SIGSAC Conference on Computer and Communications Security. 2018 Presented at: CCS ’18; October 15-19, 2018, 2018;634-646; Toronto, ON. URL: https://dl.acm.org/doi/10.1145/3243734.3243855 [doi: 10.1145/3243734.3243855]

- Abadir PM, Chellappa R, Choudhry N, Demiris G, Ganesan D, Karlawish J, et al. The promise of AI and technology to improve quality of life and care for older adults. Nat Aging. Jun 25, 2023;3(6):629-631. [FREE Full text] [doi: 10.1038/s43587-023-00430-0] [Medline: 37231197]

- Kim BN, Dolz J, Jodoin PM, Desrosiers C. Privacy-net: an adversarial approach for identity-obfuscated segmentation of medical images. IEEE Trans Med Imaging. Jul 27, 2021;40(7):1737-1749. [FREE Full text] [doi: 10.1109/TMI.2021.3065727] [Medline: 33710953]

- Choi E, Biswal S, Malin B, Duke J, Stewart WF, Sun J. Generating multi-label discrete patient records using generative adversarial networks. In: Proceedings of the 2017 Machine Learning for Health Care Conference. 2017 Presented at: MLHC ’17; August 18-19, 2017, 2017;1-20; Boston, MA. URL: https://proceedings.mlr.press/v68/choi17a/choi17a.pdf

- Yale A, Dash S, Dutta R, Guyon I, Pavao A, Bennett KP. Generation and evaluation of privacy preserving synthetic health data. Neurocomput. Nov 2020;416:244-255. [doi: 10.1016/j.neucom.2019.12.136]

- Torfi A, Fox EA. CorGAN: correlation-capturing convolutional generative adversarial networks for generating synthetic healthcare records. arXiv Preprint posted online January 25, 2020. 2020. [FREE Full text]

- Lee D, Yu H, Jiang X, Rogith D, Gudala M, Tejani M, et al. Generating sequential electronic health records using dual adversarial autoencoder. J Am Med Inform Assoc. Jul 01, 2020;27(9):1411-1419. [FREE Full text] [doi: 10.1093/jamia/ocaa119] [Medline: 32989459]

- Rane N. ChatGPT and similar generative artificial intelligence (AI) for smart industry: role, challenges and opportunities for industry 4.0, industry 5.0 and society 5.0. SSRN J. 2023. [FREE Full text] [doi: 10.2139/ssrn.4603234]

- Bale AS, Dhumale R, Beri N, Lourens M, Varma RA, Kumar V, et al. The impact of generative content on individuals privacy and ethical concerns. Int J Intell Syst Appl Eng. 2023;12(1):697-703. [FREE Full text]

- Ghosheh GO, Li J, Zhu T. A survey of generative adversarial networks for synthesizing structured electronic health records. ACM Comput Surv. Jan 22, 2024;56(6):1-34. [doi: 10.1145/3636424]

- Hernandez M, Epelde G, Alberdi A, Cilla R, Rankin D. Synthetic data generation for tabular health records: a systematic review. Neurocomput. Jul 2022;493:28-45. [doi: 10.1016/j.neucom.2022.04.053]

- Fui-Hoon Nah F, Zheng R, Cai J, Siau K, Chen L. Generative AI and ChatGPT: applications, challenges, and AI-human collaboration. J Inf Technol Case Appl Res. Jul 21, 2023;25(3):277-304. [doi: 10.1080/15228053.2023.2233814]

- Ali M, Naeem F, Tariq M, Kaddoum G. Federated learning for privacy preservation in smart healthcare systems: a comprehensive survey. IEEE J Biomed Health Inform. Feb 2023;27(2):778-789. [doi: 10.1109/jbhi.2022.3181823]

- Khan S, Saravanan V, Lakshmi TJ, Deb N, Othman NA. Privacy protection of healthcare data over social networks using machine learning algorithms. Comput Intell Neurosci. Mar 24, 2022;2022:9985933-9985938. [FREE Full text] [doi: 10.1155/2022/9985933] [Medline: 35371203]

- Sun H, Zhu T, Zhang Z, Jin D, Xiong P, Zhou W. Adversarial attacks against deep generative models on data: a survey. IEEE Trans Knowl Data Eng. Apr 1, 2023;35(4):3367-3388. [doi: 10.1109/tkde.2021.3130903]

- The legal issues presented by generative AI. MIT Sloan School of Management. URL: https://mitsloan.mit.edu/ ideas-made-to-matter/legal-issues-presented-generative-ai [accessed 2024-01-29]

- EU AI Act: first regulation on artificial intelligence. European Parliament. 2023. URL: https://www.europarl.europa.eu/ topics/en/article/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence [accessed 2024-02-16]

- Blueprint for an AI bill of rights: making automated systems work for the American people. The White House. URL: https:/ /www.whitehouse.gov/ostp/ai-bill-of-rights/ [accessed 2024-02-19]

- Ahmad K, Maabreh M, Ghaly M, Khan K, Qadir J, Al-Fuqaha A. Developing future human-centered smart cities: critical analysis of smart city security, Data management, and Ethical challenges. Comput Sci Rev. Feb 2022;43:100452. [doi: 10.1016/j.cosrev.2021.100452]

- Liu Q, Li P, Zhao W, Cai W, Yu S, Leung VC. A survey on security threats and defensive techniques of machine learning: a data driven view. IEEE Access. 2018;6:12103-12117. [doi: 10.1109/access.2018.2805680]

- Hu Y, Kuang W, Qin Z, Li K, Zhang J, Gao Y, et al. Artificial intelligence security: threats and countermeasures. ACM Comput Surv. Nov 23, 2021;55(1):1-36. [doi: 10.1145/3487890]

- Tang

, Yin , Zhou , Huang . Adversarial perturbation elimination with GAN based defense in continuous-variable quantum key distribution systems. Electronics. May 27, 2023;12(11):2437. [doi: 10.3390/electronics12112437] - Gu S, Rigazio L. Towards deep neural network architectures robust to adversarial examples. arXiv Preprint posted online December 11, 2014. 2014. [FREE Full text]

- Brown H, Lee K, Mireshghallah F, Shokri R, Tramèr F. What does it mean for a language model to preserve privacy? In: Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency. 2022. Presented at: FAccT ’22; June 21-24, 2022, 2022; Seoul, Republic of Korea. URL: https://dl.acm.org/doi/fullHtml/10.1145/3531146.3534642 [doi: 10.1145/3531146.3534642]

- Albahri A, Duhaim AM, Fadhel MA, Alnoor A, Baqer NS, Alzubaidi L, et al. A systematic review of trustworthy and explainable artificial intelligence in healthcare: assessment of quality, bias risk, and data fusion. Inf Fusion. Aug 2023;96:156-191. [doi: 10.1016/j.inffus.2023.03.008]

- Hacker P, Engel A, Mauer M. Regulating ChatGPT and other large generative AI models. In: Proceedings of the 2023 ACM Conference on Fairness, Accountability, and Transparency. 2023 Presented at: FAccT ’23; June 12-15, 2023, 2023;1112-1113; Chicago, IL. URL: https://dl.acm.org/doi/abs/10.1145/3593013.3594067 [doi: 10.1145/3593013.3594067]

- Artificial Intelligence Risk Management Framework (AIRMF1.0). National Institute of Standards and Technology. 2023. URL: https://doi.org/10.6028/NIST.AI.100-1 [accessed 2023-09-20]

- Learned K, Durbin A, Currie R, Kephart ET, Beale HC, Sanders LM, et al. Barriers to accessing public cancer genomic data. Sci Data. Jun 20, 2019;6(1):98. [FREE Full text] [doi: 10.1038/s41597-019-0096-4] [Medline: 31222016]

- Park Y, Son Y, Shin H, Kim D. This ain’t your dose: sensor spoofing attack on medical infusion pump. In: Proceedings of the 10th USENIX Workshop on Offensive Technologies. 2016. Presented at: WOOT ’16; August 8-9, 2016, 2016; Austin, TX. URL: https://www.usenix.org/system/files/conference/woot16/woot16-paper-park 0.pdf

- Shoukry Y, Martin P, Tabuada P, Srivastava M. Non-invasive spoofing attacks for anti-lock braking systems. In: Proceedings of the 15th International Workshop on Cryptographic Hardware and Embedded Systems. 2013 Presented at: CHES ’13; August 20-23, 2013, 2013;55-72; Santa Barbara, CA. URL: https://link.springer.com/chapter/10.1007/978-3-642-40349-1 4 [doi: 10.1007/978-3-642-40349-1_4]

- Quiring E, Klein D, Arp D, Johns M, Rieck K. Adversarial preprocessing: understanding and preventing image-scaling attacks in machine learning. In: Proceedings of the 29th USENIX Security Symposium. 2020 Presented at: USS ’20; August 12-14, 2020, 2020;1363-1380; Boston, MA. URL: https://www.usenix.org/conference/usenixsecurity20/presentation/quiring

- Xiao Q, Chen Y, Shen C, Chen Y, Li K. Seeing is not believing: camouflage attacks on image scaling algorithms. In: Proceedings of the 28th USENIX Security Symposium. 2019. Presented at: USENIXS ’19; August 14-16, 2019, 2019; Santa Clara, CA. URL: https://www.usenix.org/conference/usenixsecurity19/presentation/xiao

- Reichman B, Jing L, Akin O, Tian Y. Medical image tampering detection: a new dataset and baseline. In: Proceedings of the 2021 Workshops and Challenges on Pattern Recognition. 2021 Presented at: ICPR ’21; January 10-15, 2021, 2021;266-277; Virtual Event. URL: https://link.springer.com/chapter/10.1007/978-3-030-68763-2_20 [doi: 10.1007/978-3-030-68763-2_20]

- Harrer S. Attention is not all you need: the complicated case of ethically using large language models in healthcare and medicine. EBioMedicine. Apr 2023;90:104512. [FREE Full text] [doi: 10.1016/j.ebiom.2023.104512] [Medline: 36924620]

- Chen RJ, Lu MY, Chen TY, Williamson DF, Mahmood F. Synthetic data in machine learning for medicine and healthcare. Nat Biomed Eng. Jun 15, 2021;5(6):493-497. [FREE Full text] [doi: 10.1038/s41551-021-00751-8] [Medline: 34131324]

- Han C, Rundo L, Araki R, Nagano Y, Furukawa Y, Mauri G, et al. Combining noise-to-image and image-to-image GANs: brain MR image augmentation for tumor detection. IEEE Access. 2019;7:156966-156977. [doi: 10.1109/access.2019.2947606]

- Lu TK, Khalil AS, Collins JJ. Next-generation synthetic gene networks. Nat Biotechnol. Dec 9, 2009;27(12):1139-1150. [FREE Full text] [doi: 10.1038/nbt.1591] [Medline: 20010597 ]

- Synthetic data is enabling better healthcare tools – here’s how. Particle Health. URL: https://www.particlehealth.com/blog/ synthetic-data-healthcare-tools [accessed 2024-01-29]

- Chen D, Yu N, Zhang Y, Fritz M. GAN-Leaks: a taxonomy of membership inference attacks against generative models. In: Proceedings of the 2020 ACM SIGSAC Conference on Computer and Communications Security. 2020 Presented at: CCS ’20; November 9-13, 2020, 2020;343-362; Virtual Event. URL: https://dl.acm.org/doi/10.1145/3372297.3417238 [doi: 10.1145/3372297.3417238]

- Wang Z, Song M, Zhang Z, Song Y, Wang Q, Qi H. Beyond inferring class representatives: user-level privacy leakage from federated learning. In: Proceedings of the 2019 IEEE Conference on Computer Communications. 2019 Presented at: IEEE INFOCOM ’19; April 29-May 2, 2019, 2019;2512-2520; Virtual Event. URL: https://dl.acm.org/doi/abs/10.1109/ infocom. 2019.8737416 [doi: 10.1109/infocom.2019.8737416]

- Xie Q, Schenck EJ, Yang HS, Chen Y, Peng Y, Wang F. Faithful AI in medicine: a systematic review with large language models and beyond. Res Sq. Dec 04, 2023.:2023. [FREE Full text] [doi: 10.21203/rs.3.rs-3661764/v1] [Medline: 38106170]

- McCoy LG, Brenna CT, Chen SS, Vold K, Das S. Believing in black boxes: machine learning for healthcare does not need explainability to be evidence-based. J Clin Epidemiol. Feb 2022;142:252-257. [doi: 10.1016/j.jclinepi.2021.11.001] [Medline: 34748907]

- Mahmood F, Chen R, Durr NJ. Unsupervised reverse domain adaptation for synthetic medical images via adversarial training. IEEE Trans Med Imaging. Dec 2018;37(12):2572-2581. [doi: 10.1109/tmi.2018.2842767]

- Shafahi A, Huang W, Najibi M, Suciu O, Studer C, Dumitras TA, et al. Poison frogs! targeted clean-label poisoning attacks on neural networks. In: Proceedings of the 32nd International Conference on Neural Information Processing Systems. 2018 Presented at: NIPS’18; December 3-8, 2018, 2018;6106-6116; Montréal, QC. URL: https://dl.acm.org/doi/10.5555/3327345. 3327509

- Walker HL, Ghani S, Kuemmerli C, Nebiker CA, Müller BP, Raptis DA, et al. Reliability of medical information provided by ChatGPT: assessment against clinical guidelines and patient information quality instrument. J Med Internet Res. Jun 30, 2023;25:e47479. [FREE Full text] [doi: 10.2196/47479] [Medline: 37389908]

- Athaluri S, Manthena SV, Kesapragada VK, Yarlagadda V, Dave T, Duddumpudi RT. Exploring the boundaries of reality: investigating the phenomenon of artificial intelligence hallucination in scientific writing through ChatGPT references. Cureus. Apr 2023;15(4):e37432. [FREE Full text] [doi: 10.7759/cureus.37432] [Medline: 37182055]

- Lee P, Bubeck S, Petro J. Benefits, limits, and risks of GPT-4 as an AI Chatbot for medicine. N Engl J Med. Mar 30, 2023;388(13):1233-1239. [doi: 10.1056/nejmsr2214184]

- Fredrikson M, Jha S, Ristenpart T. Model inversion attacks that exploit confidence information and basic countermeasures. In: Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015 Presented at: CCS ’15; October 12-16, 2015, 2015;1322-1323; Denver, CO. [doi: 10.1145/2810103.2813677]

- Shokri R, Stronati M, Song C, Shmatikov V. Membership inference attacks against machine learning models. In: Proceedings of the 38th IEEE Symposium on Security and Privacy. 2017 Presented at: SSP ’17; May 22-24, 2017, 2017;3-18; San Jose, CA. URL: https://www.computer.org/csdl/proceedings-article/sp/2017/07958568/12OmNBUAvVc [doi: 10.1109/sp.2017.41]

- Matwin S, Nin J, Sehatkar M, Szapiro T. A review of attribute disclosure control. In: Advanced Research in Data Privacy. Thousand Oaks, CA. Springer; 2015.

- Fernandes M, Decouchant J, Couto FM. Security, privacy, and trust management in DNA computing. Adv Comput. 2023.:129. [doi: 10.1016/bs.adcom.2022.08.009]

- Mopuri KR, Uppala PK, Babu VR. Ask, acquire, and attack: data-free UAP generation using class impressions. In: proceedings of the 15th European Conference on Computer Vision. 2018 Presented at: ECCV ’18; September 8-14, 2018, 2018;20-35; Munich, Germany. URL: https://link.springer.com/chapter/10.1007/978-3-030-01240-3_2 [doi: 10.1007/978-3-030-01240-3 2]

- Song Y, Kim T, Nowozin S, Ermon S, Kushman N. Pixeldefend: Leveraging generative models to understand and defend against adversarial examples. arXiv Preprint posted online October 30, 2017. 2017. [FREE Full text] [doi: 10.48550/arXiv.1710.10766]

- Mattioli J, Sohier H, Delaborde A, Amokrane-Ferka K, Awadid A, Chihani Z, et al. Towards a holistic approach for AI trustworthiness assessment based upon aids for multi-criteria aggregation. In: Proceedings of the Safe AI 2023-The AAAI’s Workshop on Artificial Intelligence Safety. 2023. Presented at: SafeAI ’23; February 13-14, 2023, 2023; Washington, DC. URL: https://hal.science/hal-04086455

- Chen Y, Zahedi FM, Abbasi A, Dobolyi D. Trust calibration of automated security IT artifacts: a multi-domain study of phishing-website detection tools. Inf Manag. Jan 2021;58(1):103394. [doi: 10.1016/j.im.2020.103394]

- Lankton N, McKnight DH, Tripp J. Technology, humanness, and trust: rethinking trust in technology. J Assoc Inf Syst. Oct 2015;16(10):880-918. [FREE Full text] [doi: 10.17705/1jais.00411]

- Mcknight DH, Carter M, Thatcher JB, Clay PF. Trust in a specific technology: an investigation of its components and measures. ACM Trans Manag Inf Syst. Jul 2011;2(2):1-25. [doi: 10.1145/1985347.1985353]

Chen Y, Esmaeilzadeh P

Generative AI in Medical Practice: In-Depth Exploration of Privacy and Security Challenges

J Med Internet Res 2024;26:e53008

URL: https://www.jmir.org/2024/1/e53008

doi: 10.2196/53008

PMID: 38457208

©Yan Chen, Pouyan Esmaeilzadeh. Originally published in the Journal of Medical Internet Research (https://www.jmir.org), 08.03.2024. This is an open-access article distributed under the terms of the Creative Commons Attribution License (https://creativecommons.org/licenses/by/4.0/), which permits unrestricted use, distribution, and reproduction in any medium, provided the original work, first published in the Journal of Medical Internet Research, is properly cited. The complete bibliographic information, a link to the original publication on https://www.jmir.org/, as well as this copyright and license information must be included.

الاختصارات

الذكاء الاصطناعي: الذكاء الاصطناعي

CorGAN: الشبكات التنافسية التوليدية لالتقاط الارتباطات

EHR: السجل الصحي الإلكتروني

EU: الاتحاد الأوروبي

FL: التعلم الفيدرالي

GAN: الشبكة التنافسية التوليدية

IoMT: إنترنت الأشياء الطبية

LLM: نموذج اللغة الكبير

medGAN: الشبكة التنافسية التوليدية الطبية

PHI: المعلومات الصحية المحمية

DOI: https://doi.org/10.2196/53008

PMID: https://pubmed.ncbi.nlm.nih.gov/38457208

Publication Date: 2024-03-08

Generative AI in Medical Practice: In-Depth Exploration of Privacy and Security Challenges

Abstract

As advances in artificial intelligence (AI) continue to transform and revolutionize the field of medicine, understanding the potential uses of generative AI in health care becomes increasingly important. Generative AI, including models such as generative adversarial networks and large language models, shows promise in transforming medical diagnostics, research, treatment planning, and patient care. However, these data-intensive systems pose new threats to protected health information. This Viewpoint paper aims to explore various categories of generative AI in health care, including medical diagnostics, drug discovery, virtual health assistants, medical research, and clinical decision support, while identifying security and privacy threats within each phase of the life cycle of such systems (ie, data collection, model development, and implementation phases). The objectives of this study were to analyze the current state of generative AI in health care, identify opportunities and privacy and security challenges posed by integrating these technologies into existing health care infrastructure, and propose strategies for mitigating security and privacy risks. This study highlights the importance of addressing the security and privacy threats associated with generative AI in health care to ensure the safe and effective use of these systems. The findings of this study can inform the development of future generative AI systems in health care and help health care organizations better understand the potential benefits and risks associated with these systems. By examining the use cases and benefits of generative AI across diverse domains within health care, this paper contributes to theoretical discussions surrounding AI ethics, security vulnerabilities, and data privacy regulations. In addition, this study provides practical insights for stakeholders looking to adopt generative AI solutions within their organizations.

KEYWORDS

Introduction

which are algorithms that can synthesize new data, imagery, text, and other content with humanlike creativity and nuance based on patterns learned from existing data [2]. Generative AI could power clinical practices in health care, from generating synthetic patient data to augmenting rare disease research to creating AI-assisted drug discovery systems [3]. Generative AI has the potential to detect signs, patterns, diseases, anomalies, and risks and assist in screening patients for various chronic diseases, making more accurate and data-driven diagnoses and improving clinical decision-making [4]. Generative AI also has

the potential to transform patient care with generative AI virtual health assistants [5].

and AI developers about the security and privacy challenges associated with generative AI in health care. The findings of this study can guide the development of robust data governance frameworks, secure infrastructure, and ethical guidelines to ensure the safe and responsible use of generative AI in health care. With careful governance, the benefits of generative models can be realized while safeguarding patient data and public trust. Ultimately, this study contributes to the advancement of knowledge in the field of AI in health care and supports the development of secure and privacy-preserving generative AI systems for improved patient care and outcomes.

Generative AI Applications in Health Care

Overview

| Category | Example | Setting | User | Input data | Output data | Personalization level | Workflow integration | Validation needed | Impact | Risks | Human involvement |

| Medical diagnostics | AI-Rad Companion | Radiology | Radiologists | Medical images | Text findings | Individual | Postimaging | High | Improved diagnosis | Reliability and bias | High |

| Drug discovery | Insilico Medicine | Biotechnology | Research scientists | Target proteins and disease data | Novel molecular structures | Semipersonalized | Early-stage research | High | Faster discoveries | Safety and testing requirements | Moderate |

| Virtual health assistants | Sensely | Web clinics | Patients | Conversation | Conversation | Semipersonalized | Patient engagement | Moderate | Increased access | Privacy and misinformation | Moderate |

| Medical research | Anthropic | Laboratories and academia | Researchers | Research concepts and data sets | Hypotheses and questions | Semipersonalized | Idea generation | Low | Research insights | Misdirection | Moderate |

| Clinical decision support | Glass AI | Point of care | Physicians | Patient data | Treatment suggestions | Individual | Diagnosis and treatment | High | Improved outcomes | Overreliance and bias | High |

Differentiating Factors

Setting

Users

Input Data

Output Data

Personalization Level

Workflow Integration

Validation Needs

Risks

Human-AI Collaboration

Abstract

Aims This study aims to reveal crucial differences, use cases, adoption levels, various risks, and implementation practices by developing categories based on these key attributes of generative AI systems. The proposed framework clarifies the heterogeneous landscape of generative AI in health care and enables a trend analysis across categories. These factors provide a perspective on how generative AI manifests distinctly for various users, data types, workflows, risk factors, and human-AI partnerships within health care. By systematically analyzing the diverse range of generative AI systems across health care settings using the key factors discussed previously, we can classify the heterogeneous landscape of generative AI in health care into 5 overarching categories: medical diagnostics, drug discovery, virtual health assistants, medical research, and clinical decision support.

Medical Diagnostics

Drug Discovery

Virtual Health Assistants

Medical Research

directions worth investigating [26]. This unique generative capacity could accelerate scientific advancement. However, corroboration by human researchers is crucial to prevent the blind acceptance of AI-generated findings [27].

Clinical Decision Support

Literature Review

Generative AI: Balancing Benefits and Risks

Overview

an attack scenario and (2) as a defender resisting a powerful attacker (the discriminator) to simulate a defense scenario.

Protection of Preimage Privacy

Privacy in Distributed Learning Systems

Differential Privacy in GANs

segmentation has been proposed to address this challenge [39]. This method is underpinned by a deep convolutional GAN-based framework comprising three key components: (1) a deep encoder network, functioning as the generator, efficiently obscuring identity markers in medical images by incorporating additional noise; (2) a binary classifier serves as the discriminator, ensuring that the transformed images retain a resemblance to their original counterparts; and (3) a convolutional neural network-based network dedicated to medical image analysis, acting as an alternate discriminator responsible for analyzing the segmentation details of the images. This framework integrates an encoder, a binary classifier, and a segmentation analysis network to form a robust approach to safeguard medical data privacy while preserving the integrity and efficacy of medical image segmentation.

record, membership attack, maximum real-to-synthetic similarity, differential privacy cost, and GANs. For instance, differential privacy is an approach that adds noise to the data to prevent the identification of individuals. GANs can create new and nonreal data points. Other advanced statistical and machine learning techniques attempt to balance data utility and privacy. Each method has its strengths and limitations, and the choice depends on the specific requirements of the health care application and the sensitivity of the data involved.

A study discusses the potential of FL as a privacy-preserving approach in health care AI applications [49]. FL is a distributed AI paradigm that offers privacy preservation in smart health care systems by allowing models to be trained without accessing the local data of participants. It provides privacy to end users by only sharing gradients during training. The target of FL in health care AI applications is to preserve the privacy of sensitive patient information communicated between hospitals and end users, particularly through Internet of Medical Things (IoMT) devices. The approach incorporates advanced techniques such as reinforcement learning, digital twin, and GANs to detect and prevent privacy threats in IoMT networks. The potential beneficiaries of FL in health care include patients, health care providers, and organizations involved in collaborative health care research and analysis. However, implementing FL in IoMT networks presents challenges, such as the need for robust FL for diffused health data sets, the integration of FL with next-generation IoMT networks, and the use of blockchain for decentralized and secure data storage. Furthermore, incentive mechanisms are being explored to encourage the participation of IoMT devices in FL, and digital twin technology is being leveraged to create secure web-based environments for remote patient monitoring and health care research. Overall, FL in health care AI applications aims to address privacy and security concerns while enabling collaborative and efficient health care systems.

AI, Legal Challenges, and Regulation

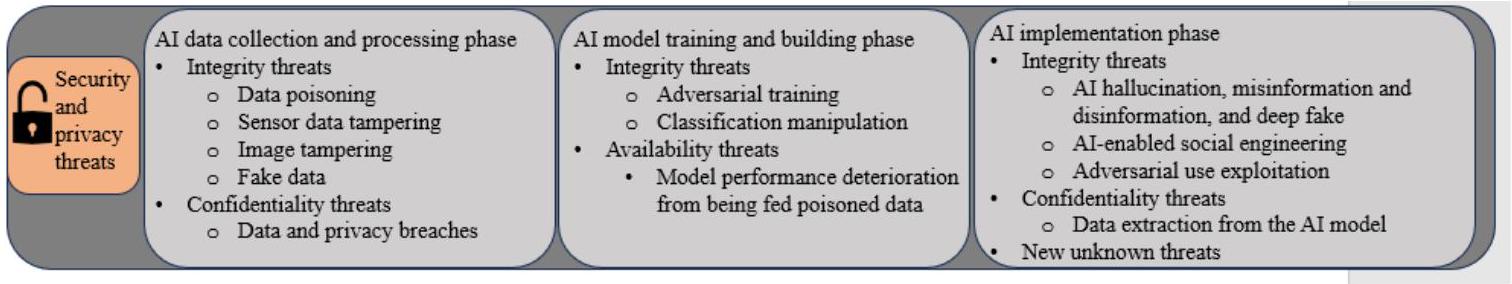

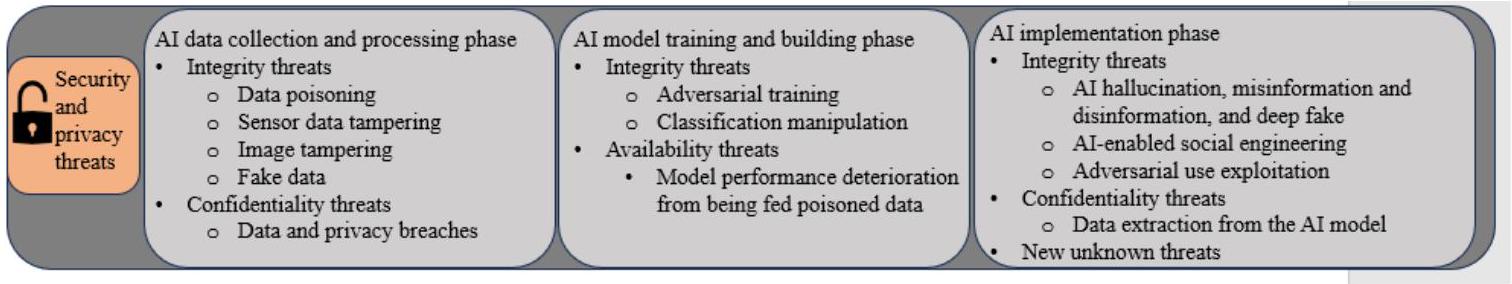

Security and Privacy Threats in the Life Cycle of a Generative AI in Health Care System

Overview

attacks (eg, model inversion, model extraction, and various privacy attacks), and code vulnerability exploitation; defense strategies in this phase should be comprehensive via integrating various solutions such as fuzz testing and blockchain-based privacy protection.

Data Collection and Processing Phase

and biases. Unintentionally, the increased data volume and complexity of generative AI threatens data integrity because errors and biases are prone to occur [63]. Errors and biases also depend on the data sources for different types of generative AI in health care. For example, assembling genomic databases and

chemical compound or protein structure databases for drug discovery is extremely challenging and could be error ridden because many genomic and protein databases lack necessary annotations, are inconsistent in formats, and may be poor in data quality [64].

Moreover, many generative AI applications in health care rely on LLMs and are trained on large amounts of internet data without being properly screened and filtered [70]. Adversaries can use AI technologies to automatically generate large quantities of fake data to poison data to be fed into LLMs, resulting in deteriorated performance of the models (eg, accuracy and fairness) and eventually AI hallucination, misinformation or disinformation, and deepfakes. Although some of these threats are not unique to generative AI in health care, they can be particularly risky if false information is used for medical decision-making. Generative AI also carries unique integrity risks. As mentioned before, its capability to create synthetic data leads to a unique integrity risk-AI hallucination. In the health care context, generative AI in health care could be used to create fake medical records or alter existing ones. Fabricated medical data can be fed again into LLMs, further threatening the integrity of medical information. For instance, the malicious use of deepfakes generated by deep generative models could fabricate a patient’s medical history to falsely claim insurance or lead to incorrect treatments. Another example is that a generative AI model may create synthetic radiology reports to

diagnose nonexistent medical conditions, leading to misdiagnosis or unnecessary treatment.

| AI categories | Data source | Security and privacy threats | ||||||||||||||||||

| Unintentional (integrity and privacy threats) | Intentional (availability and integrity attacks) | |||||||||||||||||||

| Medical diagnostics |

|

|

1-3: Software tampering, medical sensor spoofing, medical equipment tampering or poisoning (eg, CT and MRI scanning equipment tampering), medical image tampering (eg, image scaling, copy-move tampering, sharpening, blurring, and resampling), generative fake data and images (eg, generative fake CT and MRI images undetectable by both human experts and generative AI), and medial data tampering or poisoning (eg, noise injection and maliciously synthesized data) | |||||||||||||||||

| Drug discovery |

|

|

|

|||||||||||||||||

| Virtual health assistants |

|

|

|

|||||||||||||||||

| Medical research |

|

1-7: All the errors and biases mentioned in the above cells could be applicable | 1-7: All the attacks mentioned in the above cells could be applicable | |||||||||||||||||

| AI categories | Data source | Security and privacy threats | ||||||||

| Unintentional (integrity and privacy threats) | Intentional (availability and integrity attacks) | |||||||||

| Clinical decision support |

|

1-7: All the errors and biases mentioned in the above cells could be applicable | 1-7: All the attacks mentioned in the above cells could be applicable | |||||||

Model Training and Building Phase

in the model training process. By contrast, malicious parties also intensively explore this method and use adversarial examples to attack training models to generate incorrect outcomes [57]. Technically, all types of generative AI using GANs and LLMs, particularly those in health care, can be attacked with adversarial examples that compromise the integrity of the training model. For example, adversaries can use image-scaling attacks to feed human-invisible data into an AI model to force it to make a mistake [67,68].

Implementation Phase

hallucination by GANs and LLMs and synthetic data use is an unknown territory in research and practice, leading to unknown vulnerabilities such as adversarial attacks.

Generative medical diagnosis and drug discovery AI involving genomic databases and chemical compound or protein structure

databases are extremely susceptible to privacy attacks. Fernandes et al [87] pointed out that genomic data such as DNA data are susceptible to inference attacks, reidentification attacks, membership attacks, and recovery attacks. It is extremely concerning when such attacks target high-profile individuals. Moreover, generative AI enhances the ability to profile patients, thereby increasing the risk of privacy violations and attacks, although this capability is not unique to AI.

| Category | Model training and building phase | Implementation phase | ||

| Integrity threats | Availability threats | Integrity threats | Confidentiality threats | |

| Medical diagnostics | Adversarial training and classification manipulation (eg, image classification manipulation) | Model performance deteriorating by feeding poisonous data | AI hallucination (eg, made-up diagnosis), misinformation or disinformation, and adversarial use exploitation | Data extraction from carefully crafted prompts and privacy attacks |

| Drug discovery | Adversarial training and classification manipulation | Model performance deteriorating by feeding poisonous data | AI hallucination (eg, made-up chemical compound or protein structures), misinformation or disinformation, and adversarial use exploitation | Data extraction from carefully crafted prompts and privacy attacks |

| Virtual health assistants | Adversarial training and classification manipulation | Model performance deteriorating by feeding poisonous data | AI hallucination (eg, made-up medical advice), misinformation or disinformation, and adversarial use exploitation | Data extraction from carefully crafted prompts and privacy attacks |

| Medical research | Adversarial training and classification manipulation | Model performance deteriorating by feeding poisonous data | AI hallucination (eg, made-up findings, hypothesis, and citations), misinformation or disinformation, and adversarial use exploitation | Data extraction from carefully crafted prompts and privacy attacks |

| Clinical decision support | Adversarial training and classification manipulation | Model performance deteriorating by feeding poisonous data | AI hallucination (eg, made-up conclusions, findings, and recommendations), misinformation or disinformation, and adversarial use exploitation | Data extraction from carefully crafted prompts and privacy attacks |

Recommendations

Overview

approach to safeguard them is critical. This section provides some recommendations on safeguards. In doing so, we rely on the National Institute of Standards and Technology Privacy Framework and the National Institute of Standards and Technology AI Risk Management Framework as well as the regulatory guidance discussed in the Literature Review section. It should be noted that although the security and privacy threats discussed in this study are significant and some are unique in the context of generative AI in health care, many are also common in other types of AI models and other AI application

contexts. Hence, many of the recommendations we propose in the subsequent section can be applied to AI in non-health care contexts.

Development Protocols of Risk Assessment for Generative AI in Health Care

AI Risk Assessment Protocols

In the model training and building phase, detecting and filtering are also important for identifying and removing adversary training examples. Robustness, generalizability, and other vulnerability tests (eg, black-box and white-box tests) can further prevent integrity and availability attacks and data breaches [88]. Input reconstruction is another mechanism to pinpoint sources of adversary training [89]. Modifying training processes and models as well as training methods may also help to control AI risks in this phase [57]. Given the complexity and variety of AI models in reasoning and learning, we suggest a taxonomy approach. For example, a deep learning model can carry

significantly different risks than a probabilistic learning model. By building a taxonomy of AI models and their risks, researchers can systematically identify and control security and privacy risks based on the AI model.

AI Risk Assessment Metrics

Security Objectives

Generative AI-Specific Metrics

AI Inscrutability

transparency because of their closed nature or intellectual property constraints. Therefore, many of them, even those that are not based on generative techniques, face similar scrutiny regarding their lack of transparency. Hence, the call for greater openness and explainability applies broadly across AI applications in health care, reflecting a growing demand for accountable and interpretable AI systems.

AI Trustworthiness

trustworthiness of a radiology diagnosis AI for radiologists. Given the complexity of measuring AI trustworthiness, we recommend developing context-specific AI trustworthiness metrics. Similar to AI inscrutability, although AI trustworthiness is not a direct measure of security and privacy risks, it helps reduce the probability and magnitude of such risks throughout the life cycle of generative AI in health care. For instance, accuracy and reliability help to improve the integrity of an AI system.

AI Responsibility

AI Harm

from human accountability. It may be challenging to humanize AI systems and transfer attributes such as trustworthiness to the algorithms themselves. Indicators of model transparency, reliability, or accuracy may engender confidence among stakeholders, but public trust fundamentally arises from the ethical data governance, risk communication, and oversight procedures instantiated by organizations. Without robust governance and review processes overseeing development, data practices, and risk monitoring, claims of AI trustworthiness lack substantiation. Similarly, although algorithmic outputs highlighting potential issues such as biases or errors increase awareness, this does not intrinsically amount to AI responsibility. True accountability involves diligent human investigation of problems that surface, enacting appropriate recourse, and continuous authority oversight. Metrics may aim for AI to appear more responsible, but responsibility mainly manifests in organizational commitment to discovering issues, working with experts to properly assess AI harms, and instituting robust redress processes with stakeholder input. Thus, trustworthiness and responsibility are contingent on extensive institutional support structures rather than innate model capabilities. Although progress indicators may serve as signals for these desired attributes, establishing genuine public trust and accountability in health care ultimately falls on the shoulders of health care administrators, innovators, and engaged communities, rather than solely on the algorithms themselves. Clarifying this distinction enables us to properly set expectations and delineate responsibilities as generative AI becomes increasingly prevalent in critical medical settings.

Conclusions

and security challenges that must be proactively addressed to ensure the safe and effective use of these systems. Examining diverse applications of generative AI across medical domains (ie, medical diagnostics, drug discovery, virtual health assistants, medical research, and clinical decision support) helps this study uncover vulnerabilities and threats across the life cycle of these systems, from data collection to model development to clinical implementation. Although generative AI enables innovative use cases, adequate safeguards are needed to prevent breaches of PHI and to maintain public trust. Strategies such as developing AI risk assessment protocols; formulating specific metrics for generative AI such as inscrutability, trustworthiness, responsibility, and harm; and ongoing model monitoring can help mitigate risks. However, developing robust governance frameworks and updates to data privacy regulations are also required to oversee these rapidly evolving technologies. By analyzing the use cases, impacts, and risks of generative AI across diverse domains within health care, this study contributes to theoretical discussions surrounding AI ethics, security vulnerabilities, and data privacy regulations. Future research and development in generative AI systems should emphasize security and privacy to ensure the responsible and trustworthy use of these AI models in health care. Moreover, the security and privacy concerns highlighted in this analysis should serve as a call to action for both the AI community and health care organizations looking to integrate generative AI. Collaborative efforts between AI developers, health care providers, policy makers, and domain experts will be critical to unlocking the benefits of generative AI while also prioritizing ethics, accountability, and safety. By laying the groundwork to make security and privacy the central pillars of generative AI in medicine, stakeholders can work to ensure that these transformative technologies are harnessed responsibly for patients worldwide.

Conflicts of Interest

References

- Noorbakhsh-Sabet N, Zand R, Zhang Y, Abedi V. Artificial intelligence transforms the future of health care. Am J Med. Jul 2019;132(7):795-801. [FREE Full text] [doi: 10.1016/j.amjmed.2019.01.017] [Medline: 30710543]

- Eysenbach G. The role of ChatGPT, generative language models, and artificial intelligence in medical education: a conversation with ChatGPT and a call for papers. JMIR Med Educ. Mar 06, 2023;9:e46885. [FREE Full text] [doi: 10.2196/46885] [Medline: 36863937]

- Kung TH, Cheatham M, Medenilla A, Sillos C, De Leon L, Elepaño C, et al. Performance of ChatGPT on USMLE: potential for AI-assisted medical education using large language models. PLOS Digit Health. Feb 9, 2023;2(2):e0000198. [FREE Full text] [doi: 10.1371/journal.pdig.0000198] [Medline: 36812645]

- Li X, Jiang Y, Rodriguez-Andina JJ, Luo H, Yin S, Kaynak O. When medical images meet generative adversarial network: recent development and research opportunities. Discov Artif Intell. Sep 22, 2021;1(1):1-20. [FREE Full text] [doi: 10.1007/s44163-021-00006-0]

- Topol EJ. As artificial intelligence goes multimodal, medical applications multiply. Science. Sep 15, 2023;381(6663):adk6139. [doi: 10.1126/science.adk6139] [Medline: 37708283]

- Dwivedi YK, Kshetri N, Hughes L, Slade EL, Jeyaraj A, Kar AK, et al. Opinion paper: “so what if ChatGPT wrote it?” Multidisciplinary perspectives on opportunities, challenges and implications of generative conversational AI for research, practice and policy. Int J Inf Manage. Aug 2023;71:102642. [doi: 10.1016/j.jjinfomgt.2023.102642]

- Thirunavukarasu AJ, Ting DS, Elangovan K, Gutierrez L, Tan TF, Ting DS. Large language models in medicine. Nat Med. Aug 17, 2023;29(8):1930-1940. [doi: 10.1038/s41591-023-02448-8] [Medline: 37460753]

- Alqahtani H, Kavakli-Thorne M, Kumar G. Applications of generative adversarial networks (GANs): an updated review. Arch Computat Methods Eng. Dec 19, 2019;28(2):525-552. [doi: 10.1007/s11831-019-09388-y]

- Jain S, Seth G, Paruthi A, Soni U, Kumar G. Synthetic data augmentation for surface defect detection and classification using deep learning. J Intell Manuf. Nov 18, 2020;33(4):1007-1020. [doi: 10.1007/s10845-020-01710-x]

- Arora A, Arora A. The promise of large language models in health care. Lancet. Feb 2023;401(10377):641. [doi: 10.1016/s0140-6736(23)00216-7]

- Zeng X, Wang F, Luo Y, Kang S, Tang J, Lightstone FC, et al. Deep generative molecular design reshapes drug discovery. Cell Rep Med. Dec 20, 2022;3(12):100794. [FREE Full text] [doi: 10.1016/j.xcrm.2022.100794] [Medline: 36306797]

- Jiang S, Hu J, Wood KL, Luo J. Data-driven design-by-analogy: state-of-the-art and future directions. J Mech Des. 2022;144(2):020801. [doi: 10.1115/1.4051681]

- Javaid M, Haleem A, Singh RP. ChatGPT for healthcare services: an emerging stage for an innovative perspective. TBench. Feb 2023;3(1):100105. [doi: 10.1016/j.tbench.2023.100105]

- Nova K. Generative AI in healthcare: advancements in electronic health records, facilitating medical languages, and personalized patient care. J Adv Anal Healthc Manag. 2023;7(1):115-131. [FREE Full text]

- Zhang P, Kamel Boulos MN. Generative AI in medicine and healthcare: promises, opportunities and challenges. Future Internet. Aug 24, 2023;15(9):286. [doi: 10.3390/fi15090286]

- Byrne DW. Artificial Intelligence for Improved Patient Outcomes: Principles for Moving Forward with Rigorous Science. Philadelphia, PA. Lippincott Williams & Wilkins; 2022.

- Bohr A, Memarzadeh K. The rise of artificial intelligence in healthcare applications. In: Bohr A, Memarzadeh K, editors. Artificial Intelligence in Healthcare. Amsterdam, The Netherlands. Elsevier Academic Press; 2020.

- Paul D, Sanap G, Shenoy S, Kalyane D, Kalia K, Tekade RK. Artificial intelligence in drug discovery and development. Drug Discov Today. Jan 2021;26(1):80-93. [FREE Full text] [doi: 10.1016/j.drudis.2020.10.010] [Medline: 33099022]

- Mosqueira-Rey E, Hernández-Pereira E, Alonso-Ríos D, Bobes-Bascarán J, Fernández-Leal Á. Human-in-the-loop machine learning: a state of the art. Artif Intell Rev. Aug 17, 2022;56(4):3005-3054. [doi: 10.1007/s10462-022-10246-w]

- Martín-Noguerol T, Oñate Miranda MO, Amrhein TJ, Paulano-Godino F, Xiberta P, Vilanova JC, et al. The role of Artificial intelligence in the assessment of the spine and spinal cord. Eur J Radiol. Apr 2023;161:110726. [doi: 10.1016/j.ejrad.2023.110726] [Medline: 36758280]

- Ellis RJ, Sander RM, Limon A. Twelve key challenges in medical machine learning and solutions. Intell Based Med. 2022;6:100068. [doi: 10.1016/j.ibmed.2022.100068]

- Martinelli DD. Generative machine learning for de novo drug discovery: a systematic review. Comput Biol Med. Jun 2022;145:105403. [doi: 10.1016/j.compbiomed.2022.105403] [Medline: 35339849]

- Kasirzadeh A, Gabriel I. In conversation with artificial intelligence: aligning language models with human values. Philos Technol. Apr 19, 2023;36(2):1-24. [doi: 10.1007/s13347-023-00606-x]

- van Bussel MJ, Odekerken-Schröder GJ, Ou C, Swart RR, Jacobs MJ. Analyzing the determinants to accept a virtual assistant and use cases among cancer patients: a mixed methods study. BMC Health Serv Res. Jul 09, 2022;22(1):890. [FREE Full text] [doi: 10.1186/s12913-022-08189-7] [Medline: 35804356]

- Xu L, Sanders L, Li K, Chow JC. Chatbot for health care and oncology applications using artificial intelligence and machine learning: systematic review. JMIR Cancer. Nov 29, 2021;7(4):e27850. [FREE Full text] [doi: 10.2196/27850] [Medline: 34847056]

- Summerfield C. Natural General Intelligence: How Understanding the Brain Can Help Us Build AI. Oxford, UK. Oxford University Press; 2022.

- Gesk TS, Leyer M. Artificial intelligence in public services: when and why citizens accept its usage. Gov Inf Q. Jul 2022;39(3):101704. [doi: 10.1016/j.giq.2022.101704]

- Wang Z, Qinami K, Karakozis IC, Genova K, Nair P, Hata K. Towards fairness in visual recognition: effective strategies for bias mitigation. In: Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020 Presented at: CVPR ’20; June 13-19, 2020, 2020;8916-8925; Seattle, WA. URL: https://ieeexplore.ieee.org/document/ 9156668 [doi: 10.1109/cvpr42600.2020.00894]

- Cai Z, Xiong Z, Xu H, Wang P, Li W, Pan Y. Generative adversarial networks: a survey toward private and secure applications. ACM Comput Surv. Jul 13, 2021;54(6):1-38. [doi: 10.1145/3459992]

- Huang C, Kairouz P, Chen X, Sankar L, Rajagopal R. Context-aware generative adversarial privacy. Entropy. Dec 01, 2017;19(12):656. [doi: 10.3390/e19120656]

- Tripathy A, Wang Y, Ishwar P. Privacy-preserving adversarial networks. In: Proceedings of the 57th Annual Allerton Conference on Communication, Control, and Computing. 2019 Presented at: ALLERTON ’19; September 24-27, 2019, 2019;495-505; Monticello, IL. URL: https://ieeexplore.ieee.org/document/8919758 [doi: 10.1109/allerton.2019.8919758]

- Chen CS, Chang SF, Liu CH. Understanding knowledge-sharing motivation, incentive mechanisms, and satisfaction in virtual communities. Soc Behav Pers. May 01, 2012;40(4):639-647. [doi: 10.2224/sbp.2012.40.4.639]

- Liu S, Shrivastava A, Du J, Zhong L. Better accuracy with quantified privacy: representations learned via reconstructive adversarial network. arXiv Preprint posted online January 25, 2019. 2019. [FREE Full text] [doi: 10.1090/mbk/121/79]

- Tseng BW, Wu PY. Compressive privacy generative adversarial network. IEEE Trans Inf Forensics Secur. 2020;15:2499-2513. [doi: 10.1109/tifs.2020.2968188]

- Shokri R, Shmatikov V. Privacy-preserving deep learning. In: Proceedings of the 22nd ACM SIGSAC Conference on Computer and Communications Security. 2015 Presented at: CCS ’15; October 12-16, 2015, 2015;1310-1321; Denver, CO. URL: https://dl.acm.org/doi/10.1145/2810103.2813687 [doi: 10.1145/2810103.2813687]

- McMahan B, Moore E, Ramage D, Hampson S. Communication-efficient learning of deep networks from decentralized data. In: Proceedings of the 20th International Conference on Artificial Intelligence and Statistics. 2017. Presented at: AISTATS ’17; April 20-22, 2017, 2017; Fort Lauderdale, FL. URL: https://proceedings.mlr.press/v54/mcmahan17a?ref=https:/ /githubhelp.com

- Nasr M, Shokri R, Houmansadr A. Machine learning with membership privacy using adversarial regularization. In: Proceedings of the 2018 ACM SIGSAC Conference on Computer and Communications Security. 2018 Presented at: CCS ’18; October 15-19, 2018, 2018;634-646; Toronto, ON. URL: https://dl.acm.org/doi/10.1145/3243734.3243855 [doi: 10.1145/3243734.3243855]

- Abadir PM, Chellappa R, Choudhry N, Demiris G, Ganesan D, Karlawish J, et al. The promise of AI and technology to improve quality of life and care for older adults. Nat Aging. Jun 25, 2023;3(6):629-631. [FREE Full text] [doi: 10.1038/s43587-023-00430-0] [Medline: 37231197]

- Kim BN, Dolz J, Jodoin PM, Desrosiers C. Privacy-net: an adversarial approach for identity-obfuscated segmentation of medical images. IEEE Trans Med Imaging. Jul 27, 2021;40(7):1737-1749. [FREE Full text] [doi: 10.1109/TMI.2021.3065727] [Medline: 33710953]