المجلة: Scientific Reports، المجلد: 15، العدد: 1

DOI: https://doi.org/10.1038/s41598-025-98731-4

PMID: https://pubmed.ncbi.nlm.nih.gov/40325128

تاريخ النشر: 2025-05-05

DOI: https://doi.org/10.1038/s41598-025-98731-4

PMID: https://pubmed.ncbi.nlm.nih.gov/40325128

تاريخ النشر: 2025-05-05

افتح

تحسين اكتشاف سرطان الرئة غير صغير الخلايا باستخدام الشبكات العصبية التلافيفية والتعزيز التفاضلي

يظل سرطان الرئة واحدًا من الأسباب الرئيسية للوفيات المرتبطة بالسرطان في جميع أنحاء العالم، حيث إن الكشف المبكر يعد أمرًا حاسمًا لتحسين نتائج المرضى. أظهرت التقدمات الأخيرة في التعلم العميق وعدًا في تعزيز دقة التشخيص، لا سيما من خلال استخدام الشبكات العصبية التلافيفية (CNNs). تقترح هذه الدراسة دمج التعزيز التفاضلي (DA) مع الشبكات العصبية التلافيفية لمعالجة التحدي الحاسم المتمثل في الإفراط في التكيف مع الذاكرة، وهو قيد يعيق تعميم النماذج على البيانات غير المرئية. من خلال تقديم استراتيجيات تعزيز مستهدفة، مثل التعديلات في اللون، والسطوع، والتشبع، والتباين، يقوم نموذج CNN + DA بتنويع بيانات التدريب وتعزيز قوته. استخدمت الدراسة مجموعات بيانات متعددة، بما في ذلك مجموعة بيانات IQ-OTH/NCCD، لتقييم النموذج المقترح مقابل الأساليب المتقدمة الحالية. تم إجراء ضبط المعلمات باستخدام البحث العشوائي لتحسين المعلمات، مما أدى إلى تحسين الأداء بشكل أكبر. كشفت النتائج أن نموذج CNN + DA حقق دقة تبلغ 98.78%، متفوقًا على نماذج متقدمة مثل DenseNet وResNet وEfficientNetB0، بالإضافة إلى الأساليب الهجينة بما في ذلك النماذج التجميعية. بالإضافة إلى ذلك، أكدت التحليلات الإحصائية، بما في ذلك اختبارات Tukey’s HSD بعد الاختبار، على أهمية الأداء المتفوق للنموذج. تشير هذه النتائج إلى أن نموذج CNN + DA يعالج بفعالية قيود الأعمال السابقة من خلال تقليل الإفراط في التكيف وضمان تعميم موثوق عبر مجموعات بيانات متنوعة. تختتم الدراسة بأن بنية CNN + DA الجديدة توفر إطارًا قويًا ودقيقًا وفعالًا حسابيًا لكشف سرطان الرئة، مما يضعها كأداة قيمة للتطبيقات السريرية ويمهد الطريق للبحوث المستقبلية في تشخيص الصور الطبية.

الكلمات الرئيسية: توقع سرطان الرئة، الشبكات العصبية التلافيفية، زيادة الاختلاف (DA)، الإفراط في التذكر، التصوير الطبي، متانة التشخيص، EfficientNetB0

يعتمد التنبؤ المبتكر بسرطان الرئة على خوارزميات التعلم الآلي المتطورة المطبقة على ثروة من بيانات المرضى. من خلال دمج عناصر متنوعة مثل التصوير، والوراثة، والسجلات الطبية، يظهر هذا النموذج دقة ملحوظة في توقع الحوادث المحتملة. من خلال تحسين التدخل المبكر وتخصيص العلاجات، يحمل هذا النموذج القدرة على رفع نتائج المرضى في المجال الصعب لسرطان الرئة. الكشف المبكر أمر حيوي لعلاج ناجح.

تطوير نموذج CNN أحادي الأبعاد متقدم لتصنيف ودرجات سرطان الرئة غير صغير الخلايا، مستفيدًا من الرؤى المستخلصة من مجموعة TCIA لعلم الجينوم الإشعاعي لسرطان الرئة غير صغير الخلايا. نموذج MSER-SURF الهجين يدمج ميزات الورم مع البيانات السريرية لتحليل شامل.

من خلال الاستفادة من اكتشاف الأمراض بواسطة الشبكات العصبية التلافيفية، تستكشف هذه الدراسة دمج تقنية البلوكشين لتأمين البيانات في تعزيز سلامة الغذاء وتوقع سرطان الرئة.

تقديم نهج مبتكر، يستخدم شبكة عصبية تلافيفية ثنائية الأبعاد مع تحسين تاجوتشي للتعرف التلقائي على سرطان الرئة من صور الأشعة المقطعية، كما هو موضح في المرجع

يتكشف هيكل البحث مع القسم الأول الذي يتناول المقدمة. يقوم قسم “مراجعة الأدبيات” بالتنقل في المشهد الأكاديمي في مراجعة الأدبيات. يكشف قسم “المنهجية المقترحة” عن تعقيدات المنهجية المقترحة، مقدماً خريطة طريق مفصلة. يكشف قسم “النتائج والمناقشة” عن النتائج، مما يشعل مناقشات ثاقبة حول تداعياتها. يلخص قسم “الخاتمة” رؤى عميقة، مما يؤدي إلى إغلاق شامل يجمع بين نتائج الدراسة ويبرز أهميتها في السياق الأوسع لمجال البحث.

مراجعة الأدبيات

في عام 2024، إسلام وآخرون.

في عام 2024، سها وآخرون

في عام 2024، ريكو كلين وآخرون

في عام 2024، S. Kukreja وM. Sabharwa وآخرون.

في عام 2024، Zhang وآخرون.

قدم طريقة تحسين جديدة للتفكيك النادر (PSD) لاكتساب ميزات نادرة من الصور الطبية، مما عزز أيضًا تحسين النموذج.

قدم طريقة تحسين جديدة للتفكيك النادر (PSD) لاكتساب ميزات نادرة من الصور الطبية، مما عزز أيضًا تحسين النموذج.

في عام 2023، Lulu Gai وآخرون.

في عام 2023، Syeda Reeha وآخرون.

نظرًا للبيانات والموارد المتاحة، تقدم هذه الدراسة استجابة معقولة من خلال إظهار إمكانيات الطرق الجماعية كأداة قوية لتعزيز دقة وكفاءة تشخيص سرطان الرئة.

في عام 2023، R. Raza وآخرون.

في عام 2023، Nandita Gautam وآخرون.

في عام 2022، Dritsas وTrigka وآخرون.

في عام 2021، Tsou وآخرون.

بينما تركز الدراسات السابقة على التعزيز وتحسين النموذج، تتناول هذه البحث بشكل فريد مشكلة الإفراط في الذاكرة باستخدام التعزيز التفاضلي، مما يظهر أداءً متفوقًا في اكتشاف سرطان الرئة.

بيان المشكلة

تتركز مشكلة البحث على تعزيز دقة وكفاءة اكتشاف سرطان الرئة باستخدام تقنيات التعلم العميق. على الرغم من التحسينات، تكافح النماذج الحالية مع التعميم، وتنوع البيانات، وقابلية التفسير عبر طرق التصوير. من الصعب تحسين أداء النموذج، خاصة في الكشف المبكر، مع معالجة تنوع مجموعة البيانات وحدود التعزيز.

تحديات التعميم

على الرغم من أن نموذج CNN + DA يؤدي بشكل جيد على مجموعة البيانات المسيطر عليها، إلا أن قابليته للتعميم على السيناريوهات الواقعية لا تزال بحاجة إلى التحقق. تشمل التحديات التباينات غير المرئية في بروتوكولات التصوير، وخصائص المرضى، والعيوب في مجموعات البيانات السريرية. ستستكشف الدراسات المستقبلية استراتيجيات مثل التعلم بالنقل والتعديل الدقيق على مجموعات البيانات متعددة المراكز للتخفيف من هذه التحديات وضمان القابلية للتطبيق في بيئات سريرية متنوعة. لزيادة مرونة نماذج تحليل الصور الطبية، وقابليتها للتوسع، وفائدتها السريرية، يجب استكشاف دمج البيانات، والحوسبة على حافة الهاتف المحمول، وطرق التجميع. تلخص الجدول 1 الأهداف والقيود للأبحاث السابقة، مع تسليط الضوء على أهدافها ونقاط ضعفها.

فجوة البحث

بينما أحدث التعلم العميق ثورة في العديد من المجالات، بما في ذلك التصوير الطبي لاكتشاف سرطان الرئة، لا تزال هناك فجوة بحثية مستمرة تتعلق بالتحيز في الذاكرة. على الرغم من الجهود المختلفة لمعالجة التحيز العام، إلا أن التحدي الدقيق المتمثل في نماذج حفظ بيانات التدريب بدلاً من التعلم للتعميم لم يتم معالجته بشكل شامل. تركز العديد من الحلول الحالية على قضايا التحيز الأوسع، وغالبًا ما تتجاهل الجانب الدقيق ولكنه حاسم من التحيز في الذاكرة. تؤكد هذه الفجوة على الحاجة إلى بحث مخصص في استراتيجيات ومنهجيات مكافحة التحيز في الذاكرة، لضمان بقاء النماذج قوية وموثوقة، خاصة في التطبيقات الحرجة مثل التشخيص الطبي.

| المؤلف | الطريقة | الهدف | العيب | ||

| إسلام وآخرون.

|

مناقشة حول تطبيق خوارزميات التعلم العميق المختلفة في توليد وتطبيق تعزيز البيانات. قد تشمل هذه الطرق مثل الشبكات التنافسية التوليدية (GANs) أو هياكل الشبكات العصبية الأخرى التي تخلق تباينات واقعية في الصور الطبية. | تحديد الصعوبات الميدانية يشمل القيود في التقنيات الحالية أو مشاكل جودة البيانات والمسارات البحثية المستقبلية المقترحة للتعامل مع هذه الصعوبات. | يمكن أن ترفع تقنيات تعزيز البيانات المتقدمة من تعقيد النموذج وعملية التدريب، مما قد يجعل من الصعب التحقق من توقعات النموذج. يمكن أن تتسبب التعزيزات الأوسع والأكثر تعقيدًا في إطالة عملية التدريب وزيادة استهلاك الموارد، مما يؤثر بالتالي على الكفاءة العامة لتطوير النموذج. | ||

| ساها وآخرون.

|

تقدم الورقة نموذج تعلم نقل جديد يسمى VER-Net، الذي يجمع بين ثلاثة نماذج مختلفة من التعلم بالنقل لتحسين تشخيص سرطان الرئة من صور الأشعة المقطعية. | استخدام فوائد التعلم بالنقل ودمج عدة نماذج يساعد على زيادة دقة تصنيف سرطان الرئة. كما يسعى العمل إلى إظهار أن VER-Net يمكن أن يكون مفيدًا لمهام التصوير الطبي الأخرى بالإضافة إلى تجاوز النماذج الحالية في الأداء. | يمكن أن يؤدي تجميع عدة نماذج تعلم نقل تحت نموذج VER-Net إلى تعقيد النظام. قد يجعل هذا التعقيد من صعوبة تفسير النموذج ويزيد من الاحتياجات الحاسوبية. | ||

| ريكو كلين وآخرون.

|

تم تدريب شبكة عصبية تلافيفية (CNN) لتصنيف الصور الطبية إلى فئتين: حالات متأثرة وغير متأثرة وطرق التعزيز. | تقييم تأثير طرق تعزيز الصور المختلفة على دقة شبكة عصبية تلافيفية (CNN) تم تدريبها لتصنيف الصور الطبية إلى فئتين. تحديد أكثر طرق التعزيز فعالية لمختلف أنماط التصوير الطبي (الأشعة السينية، الموجات فوق الصوتية، التصوير المقطعي بالإصدار البوزيتروني، التصوير بالرنين المغناطيسي) لتعزيز دقة التصنيف. | يمكن أن تختلف فعالية طرق التعزيز بشكل كبير اعتمادًا على طبيعة بيانات التصوير الطبي. قد لا تكون نتائج الدراسة قابلة للتطبيق عالميًا عبر جميع أنماط التصوير الطبي أو عبر حالات سريرية مختلفة. | ||

| س. كوكريجا و م. ساباروا وآخرون.

|

يستخدم العمل بنية CNN لتصنيف صور سرطان الرئة النسيجية إلى حميدة، أدينوكارسينوما، وسرطان الخلايا الحرشفية. | لتقسيم الصور النسيجية لسرطان الرئة إلى ثلاثة أنواع: حميدة، أدينوكارسينوما، وسرطان الخلايا الحرشفية بدقة. نموذج CNN. | يركز هذا العمل على CNN ولا يقارن أدائها مع طيف أوسع من أساليب التعلم الآلي أو التعلم العميق خارج تلك التي تم النظر فيها بالفعل. | ||

| تشانغ وآخرون.

|

شبكة عصبية تلافيفية (CNN) مع DenseNet لتحسين القدرة على استخراج الميزات والتعلم لغرض تصنيف سرطان الرئة. | تطوير وتقييم نظام متقدم يعد الهدف الرئيسي للكشف وتصنيف سرطان الرئة. الإطار المقترح يدمج الشبكات العصبية التلافيفية (CNN) مع DenseNet من خلال دمج البيانات والحوسبة على حافة الهاتف المحمول لتحقيق أهدافه. الهدف الأساسي هو الحصول على مستوى عالٍ من الدقة في التمييز بين الأنسجة الرئوية الطبيعية، الحميدة، وأشكال مختلفة من الأنسجة الخبيثة. تهدف التكنولوجيا التشخيصية إلى تحسين تخطيط العلاج والكشف المبكر، وهو ما يسعى هذا المشروع إلى تحقيقه من خلال تحسين الأساليب التشخيصية. | بينما يؤدي النموذج بشكل جيد في الاختبارات المسيطر عليها، قد تكون هناك تحديات عند التعميم على بيانات العالم الحقيقي المختلفة، خاصة إذا كانت بيانات التدريب لا تلتقط جميع الاختلافات في حالات سرطان الرئة بشكل كافٍ. | ||

| لولو جاي وآخرون.

|

شبكة عصبية تلافيفية (CNN) مع DenseNet لتحسين القدرة على استخراج الميزات والتعلم لغرض تصنيف سرطان الرئة. |

|

بينما يؤدي النموذج بشكل جيد في الاختبارات المسيطر عليها، قد تكون هناك تحديات عند التعميم على بيانات العالم الحقيقي المختلفة، خاصة إذا كانت بيانات التدريب لا تلتقط جميع الاختلافات في حالات سرطان الرئة بشكل كافٍ. | ||

| سيدة ريهة وآخرون.

|

نماذج التجميع: تجمع هذه الدراسة بين نماذج مختلفة لتحديد وتصنيف سرطان الرئة. BEiT: نموذج محول بصري يستخدم لقدرته القوية على استخراج الميزات. DenseNet هو نوع من الشبكات العصبية التلافيفية العميقة المعروفة بتدفق التدرج الفعال والدقة الاستثنائية. CNN التسلسلي: نموذج شبكة عصبية تلافيفية مصمم بهيكل تسلسلي. | الهدف من المشروع هو تحسين دقة تحديد وتصنيف سرطان الرئة من خلال دمج العديد من نماذج التعلم الآلي المتقدمة باستخدام طرق تجميع متنوعة. يهدف المشروع إلى تعزيز الأداء العام لتشخيص سرطان الرئة من خلال استخدام قدرات نماذج مثل BEiT وDenseNet وCNN التسلسلي. | قد تطرح طرق التجميع تحديات في فك شفرة المساهمات المحددة لكل نموذج فردي. يمكن أن تعيق غياب الشفافية الفهم بشأن المنطق وراء توقعات معينة. | ||

| ر. رضا وآخرون.

|

Lung-EffNet، نموذج جديد قائم على التعلم بالنقل تم تقديمه في الورقة، يستخدم بنية EfficientNet. | الهدف من العمل هو بناء وتقييم نموذج تصنيف سرطان الرئة بدقة وفعالية عالية بالاعتماد على بنية EfficientNet والتعلم بالنقل بناءً عليها. الهدف هو تقديم طريقة قوية وآلية لتشخيص سرطان الرئة يمكن أن تحقق دقة وكفاءة عالية، وبالتالي معالجة حدود تحليل الأشعة المقطعية اليدوي وتكون مناسبة للنشر السريري الكبير. | قد يؤدي الاعتماد على طرق تعزيز البيانات لمعالجة عدم توازن الفئات إلى تشوهات أو عيوب يمكن أن تضر بقدرة النموذج على التعميم. | ||

| نانديتا غوتام وآخرون.

|

تستخدم تقنية التجميع نماذج CNN. ResNet-152 هو شبكة عميقة متبقية معروفة للتعامل مع الهياكل العميقة جدًا. DenseNet-169: مصممة لتعزيز انتشار الميزات عبر الاتصالات الكثيفة، هذه شبكة تلافيفية كثيفة. EfficientNet-B7: تعظيم حجم النموذج والدقة، هذه شبكة CNN سريعة للغاية. | قم بالتحقيق واستخدام نموذج التجميع، أي، تركيبات من عدة نماذج متميزة، لتوليد التوقعات، وبالتالي الاستفادة من نقاط قوتها المشتركة لرفع الأداء. | يتطلب تدريب وتقييم مجموعة من نماذج التعلم العميق موارد حسابية كبيرة، بما في ذلك الذاكرة وقدرة المعالجة، والتي قد لا تكون متاحة بسهولة في كل بيئة سريرية. | ||

| دريستاس وترغكا وآخرون

|

تمت معالجة مجموعة البيانات لتحقيق توازن الفئات وتصنيف الميزات. تم تقييم أداء نماذج التعلم الآلي المختلفة وقياساتها، مما يضمن تحليلًا قويًا. | تم توسيع الدراسة باستخدام طرق التعلم العميق مثل LSTM و CNN. تم تضمين تقييم قوي لنماذج التصنيف من خلال عملية إعادة التقدير للتحقق. | قد تتأثر دقة توقعات النموذج بعوامل غير مدرجة في مجموعة البيانات، مما يؤثر على التقييم الشامل للمخاطر. | ||

| تسوا وآخرون

|

لتحسين التحليل، تم استخدام طريقة تعزيز التدرج القوي (XGBoost) بالتزامن مع مطيافية الكتلة بتدفق الأيونات المختارة. | تحقيق في المركبات العضوية المتطايرة في التنفس لتوقع سرطان الرئة، وتطوير نموذج تصنيف دقيق من خلال التعلم الآلي لزيادة القدرات التنبؤية القوية. | أجريت دراسة حالة وشاهد في مركز واحد، مع الاعتراف بفروق العمر ومعالجة التحيزات المتأصلة في تصاميم دراسات الحالة والشاهد من أجل تحليل شامل. |

الجدول 1. هدف وعيوب البحث السابق.

المنهجية المقترحة

EfficientNetB0

EfficientNetB0

عملية الالتفاف في كتلة MBConv

عملية الالتفاف هي جوهر EfficientNetB0، خاصة داخل كتل MBConv كما هو موضح في المعادلة (1)

أين:

الت convolutions العمودية في كتلة MBConv

في كتلة MBConv، يتم تطبيق الالتفاف العمقي على كل قناة إدخال بشكل منفصل، مما يقلل من تكلفة الحساب كما هو موضح في المعادلة (2)

أين:

كتلة الضغط والتحفيز (SE)

تقوم نماذج كتلة SE بنمذجة الاعتمادات حسب القناة باستخدام عمليتين رئيسيتين: الضغط والإثارة كما هو موضح في المعادلتين (3) و (4).

عملية الضغط:

أين:

H و W هما ارتفاع وعرض خريطة المميزات.

عملية الإثارة:

H و W هما ارتفاع وعرض خريطة المميزات.

عملية الإثارة:

أين:

إعادة المعايرة:

إعادة المعايرة:

أين

التجميع العالمي المتوسط

يتم تقليل الأبعاد المكانية لخريطة المميزات إلى قيمة واحدة لكل قناة من خلال استخدام التجميع المتوسط العالمي كما هو موضح في المعادلة (6).

أين:

H و W هما الارتفاع والعرض لخريطة المميزات.

H و W هما الارتفاع والعرض لخريطة المميزات.

طريقة التحجيم المركب

تستخدم EfficientNet طريقة التحجيم المركب لتغيير عمق الشبكة d ، وعرضها w ، ودقة الإدخال r كما هو موضح في المعادلة (7).

أين:

توفر هذه المعادلات إطارًا رياضيًا لفهم كيفية معالجة وتحويل بنية EfficientNetB0 للبيانات المدخلة، مع التركيز على استخراج الميزات والكفاءة من خلال تصميمها المبتكر.

توفر هذه المعادلات إطارًا رياضيًا لفهم كيفية معالجة وتحويل بنية EfficientNetB0 للبيانات المدخلة، مع التركيز على استخراج الميزات والكفاءة من خلال تصميمها المبتكر.

تجنب الحفظ الزائد باستخدام الشبكات العصبية التلافيفية مع خوارزمية DA

لقد أظهر التعلم العميق، بشكل رئيسي من خلال الشبكات العصبية التلافيفية، إمكانيات تحويلية في تطبيقات متنوعة، تتراوح من معالجة اللغة الطبيعية إلى التصوير الطبي. ومع ذلك، كما هو الحال مع أي أداة قوية، لا تزال التحديات قائمة. إحدى القضايا الرئيسية التي ظهرت في تطبيقات التعلم العميق هي الإفراط في التكيف، حيث يظهر الإفراط في التكيف في مجال التعلم الآلي عندما تتفوق النماذج على بيانات التدريب لكنها تتعثر عند مواجهة حالات غير مألوفة. “الإفراط في التكيف الذاكري”، وهو تجلٍ خاص، يحدث عندما يقوم النموذج بت memorizing حالات التدريب بدلاً من تمييز الأنماط الأساسية للبيانات. هذه الظاهرة، التي تشكل خطرًا خاصًا في مجالات مثل التشخيص الطبي، تطرح مخاطر كبيرة بسبب الهامش الضئيل للخطأ.

معالجة هذه الفجوة البحثية لا تقتصر على تحسين النماذج الحالية فحسب، بل تتطلب استراتيجيات مبتكرة تغير ديناميات التدريب بشكل جذري. إحدى الطرق الواعدة هي دمج الشبكات العصبية التلافيفية مع التعزيز التفاضلي. التعزيز التفاضلي (DA) يطبق تحويلات مثل تعديلات اللون العشوائية.

تستكشف هذه البحث التآزر الناتج عن دمج الشبكات العصبية التلافيفية مع التحليل التمييزي، بهدف التخفيف من فرط التكيف في الذاكرة. من خلال هذا النهج التكاملي، فإن الطموح هو تطوير نماذج ليست دقيقة فحسب، بل أيضًا قوية وقابلة للتعميم، مما يضمن موثوقيتها في سيناريوهات التشخيص في العالم الحقيقي.

استنادًا إلى الفهم الأساسي لزيادة الذاكرة وآثارها، فإن الخطوة المنطقية التالية هي تطوير وتنقيح خوارزمية جديدة تدمج بسلاسة الشبكات العصبية التلافيفية مع التعزيز التفاضلي. إن التعرف على نقاط القوة الفردية لكل من الشبكات العصبية التلافيفية والتعزيز التفاضلي يوفر وجهة نظر فريدة.

يتطلب تطوير شبكة عصبية تلافيفية جديدة مع خوارزمية DA نهجًا متعدد الجوانب. في البداية، يجب أن تكون بنية الشبكة العصبية التلافيفية مصممة لتكون قادرة على استيعاب التعديلات الديناميكية. وهذا يعني أنه يجب تحسين الطبقات والعقد ليس فقط لاستخراج الميزات، ولكن أيضًا لتحمل التباين. يجب أن تكون الخوارزمية مصممة لتكون قابلة للتكيف، تتعلم ليس فقط من ميزات بيانات التدريب ولكن أيضًا من التغيرات التي تقدمها DA.

علاوة على ذلك، مكون DA

تطوير شبكة CNN جديدة مع خوارزمية DA يمثل حدودًا مثيرة في أبحاث التعلم العميق. من خلال معالجة التحدي المستمر المتمثل في الإفراط في التكيف مع الذاكرة بشكل مباشر، يعد هذا الجهد بوضع معايير جديدة في الدقة والموثوقية والعمومية في نماذج التعلم العميق.

لتطوير شبكة CNN جديدة مع خوارزمية تعزيز تفاضلي (DA) للتخفيف من الإفراط في التكيف مع الذاكرة، من المهم فهم الأساس الرياضي وراء كل من CNN و DA.

عمليات الطبقة التلافيفية

تستند الشبكة العصبية التلافيفية (CNN) بشكل أساسي إلى عملية التلافيف، التي تستخرج الميزات من بيانات الإدخال كما هو موضح في المعادلة (8)

عملية التلافيف:

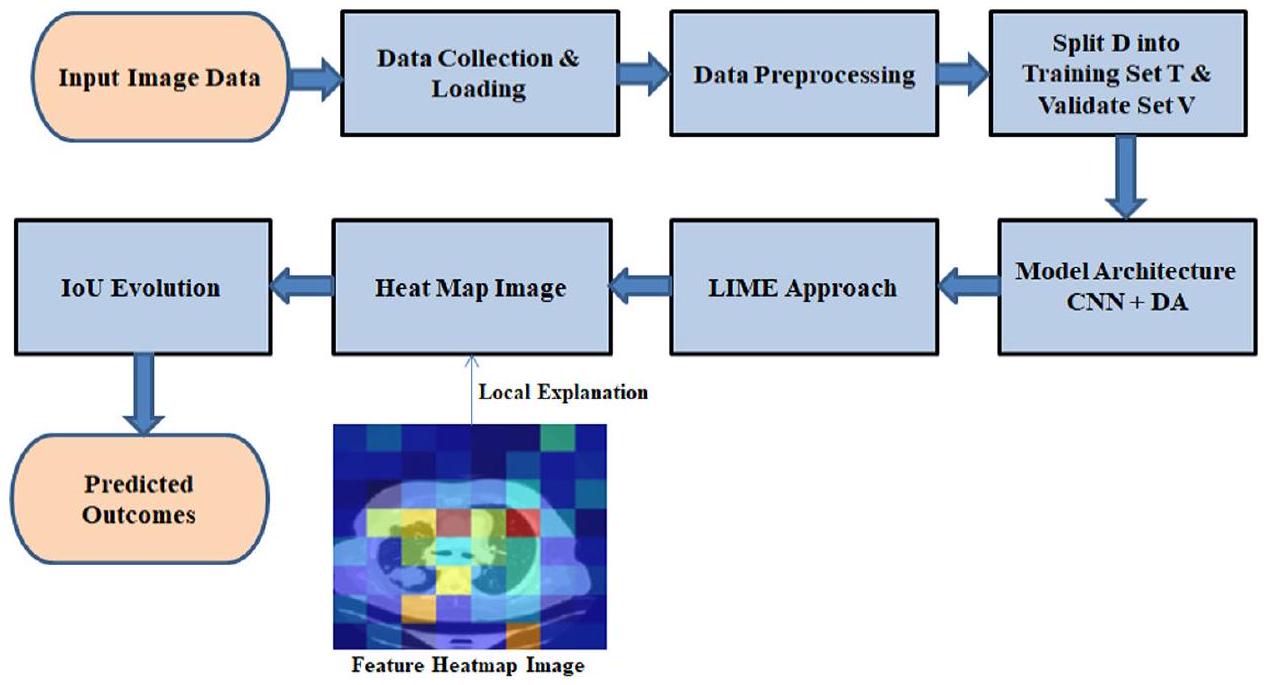

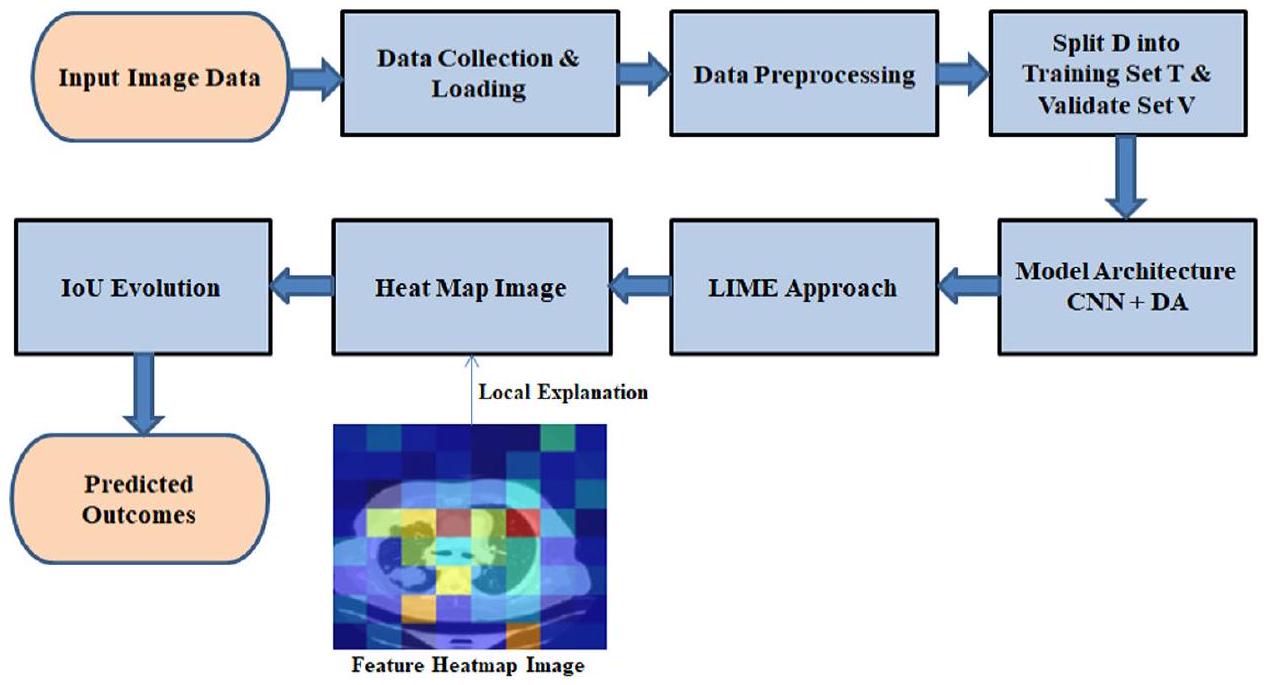

الشكل 1. مخطط تدفق لـ CNN مع DA.

حيث:

X هو خريطة الميزات المدخلة.

W هو نواة التلافيف (المرشح) بحجم MXN.

X هو خريطة الميزات المدخلة.

W هو نواة التلافيف (المرشح) بحجم MXN.

دالة التنشيط

تستخدم دالة التنشيط لإضافة عدم الخطية بعد التلافيف. الدوال المستخدمة بشكل شائع هي ReLU كما هو موضح في المعادلة (9).

دالة تنشيط ReLU:

عملية التجميع

تقلل طبقات التجميع من أبعاد خرائط الميزات، عادة باستخدام التجميع الأقصى كما هو موضح في المعادلة (10).

التجميع الأقصى:

التجميع الأقصى:

حيث:

s هو حجم مرشح التجميع.

s هو حجم مرشح التجميع.

الطبقة المتصلة بالكامل

تستقبل طبقة أو أكثر من الطبقات المتصلة بالكامل المخرجات المسطحة من الطبقات التلافيفية وطبقات التجميع كما هو موضح في المعادلة (11).

عملية الطبقة المتصلة بالكامل:

حيث:

W هي مصفوفة الأوزان.

x هو متجه الإدخال.

b هو الانحياز.

W هي مصفوفة الأوزان.

x هو متجه الإدخال.

b هو الانحياز.

دالة Softmax

للمهام التصنيفية، غالبًا ما تستخدم الطبقة الناتجة دالة softmax لتحويل اللوغيتات إلى احتمالات كما هو موضح في المعادلة (12).

دالة Softmax:

حيث:

K هو عدد الفئات.

K هو عدد الفئات.

دالة الخسارة

للمهام التصنيفية، تُستخدم عادةً دالة خسارة الانتروبيا المتقاطعة كما هو موضح في المعادلة (13).

خسارة الانتروبيا المتقاطعة:

خسارة الانتروبيا المتقاطعة:

حيث:

التعزيز التفاضلي (DA)

تم تصميم تقنية التعزيز التفاضلي (DA) لتحسين قدرة النموذج على التعميم من خلال تقديم تحويلات متنوعة، مثل تعديلات اللون، والسطوع، والتشبع، والتباين. هذا يحاكي التغيرات الواقعية في ظروف التصوير، والتي تكون شائعة في البيئات السريرية.

يمكن استخدام دالة التعزيز كما هو موضح في المعادلة (14)

حيث:

X هي بيانات الإدخال الأصلية.

X هي بيانات الإدخال الأصلية.

مصطلحات التنظيم

لمكافحة الإفراط في التكيف، يمكن استخدام تقنيات التنظيم مثل تنظيم L2 كما هو موضح في المعادلة (15).

تنظيم L2:

تنظيم L2:

حيث:

آلية التغذية الراجعة لدمج DA-CNN

لضمان حلقة تغذية راجعة بين أداء CNN واستراتيجيات DA:

يمكن عرض تعديل تغذية الأداء في المعادلة (16):

يمكن عرض تعديل تغذية الأداء في المعادلة (16):

حيث:

من خلال دمج هذه المكونات الرياضية، يمكن تطوير خوارزمية CNN-DA تتكيف ديناميكيًا مع تغيرات البيانات، مما يقلل من الإفراط في التكيف مع الذاكرة ويعزز متانة النموذج.

من خلال دمج هذه المكونات الرياضية، يمكن تطوير خوارزمية CNN-DA تتكيف ديناميكيًا مع تغيرات البيانات، مما يقلل من الإفراط في التكيف مع الذاكرة ويعزز متانة النموذج.

جمع البيانات وتحميلها

يعد جمع البيانات وتحميلها بكفاءة مكونات حاسمة في أي جهد للتعلم الآلي. يتضمن ذلك جمع مجموعات البيانات ذات الصلة من مصادر متنوعة، وضمان سلامة البيانات، واستخدام آليات تحميل فعالة. تشمل الطرق المتقدمة دمج البث المباشر في الوقت الحقيقي والمعالجة التلقائية للحفاظ على جودة البيانات وتسهيل الدمج السلس في خطوط أنابيب التعلم الآلي، مما يحسن أداء النموذج.

معالجة البيانات

تشمل معالجة البيانات خطوات حيوية مثل التطبيع وترميز التسمية. تم تغيير حجم الصور إلى

| الخطوة | الوصف |

| تغيير الحجم | تم تغيير حجم جميع الصور إلى

|

| التطبيع | تمت مقاييس قيم البكسل إلى النطاق

|

| ترميز التسمية | تم تحويل التسميات الفئوية إلى متجهات بنمط واحد |

الجدول 2. يلخص خطوات المعالجة المطبقة في هذه الدراسة من أجل تعزيز القابلية للتكرار.

التطبيع

التطبيع هو تقنية معالجة بيانات محورية تعمل على توحيد الميزات العددية، مما يضمن مقياسًا متسقًا عبر المتغيرات. من خلال إعادة قياس البيانات إلى نطاق مشترك، غالبًا ما يكون بين 0 و 1، يقلل التطبيع من تأثير الأحجام المختلفة، مما يعزز المقارنات العادلة وتقارب النموذج الأمثل في تطبيقات التعلم الآلي.

ترميز التسمية

يعد ترميز التسمية خطوة حاسمة في معالجة البيانات، خاصة للمتغيرات الفئوية في التعلم الآلي. يتضمن ذلك تعيين قيم عددية للتسميات الفئوية، مما يمكّن الخوارزميات من تفسيرها ومعالجتها بفعالية. تعزز هذه التحويلات أداء النموذج من خلال تحويل المعلومات غير العددية إلى تنسيق مناسب للحسابات الرياضية والتحليل.

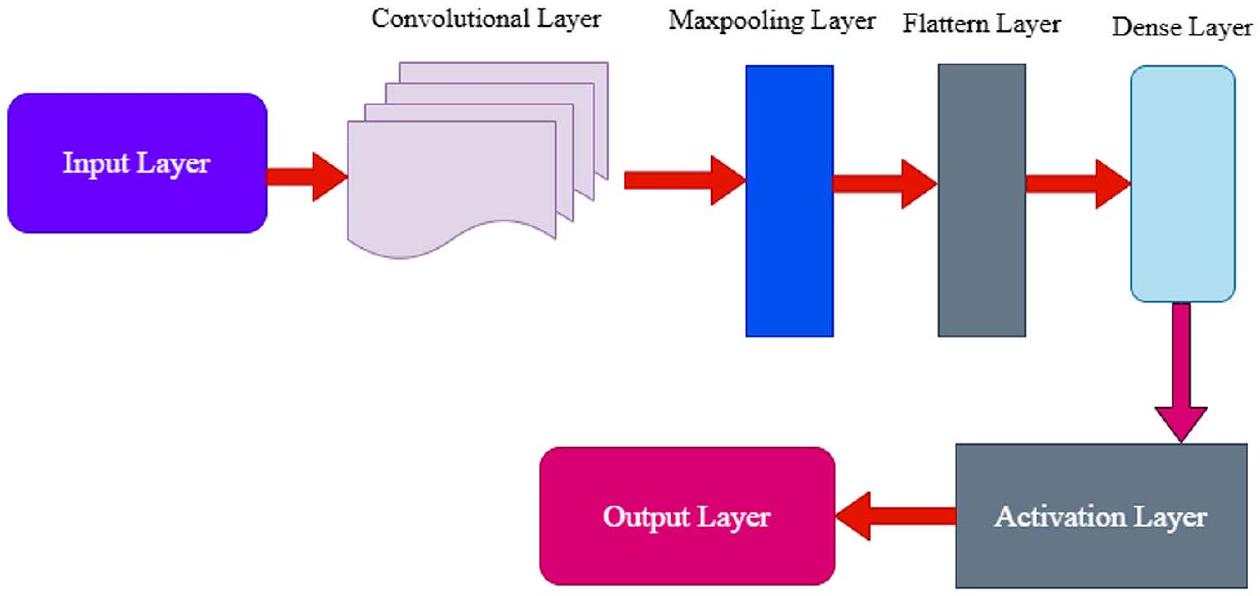

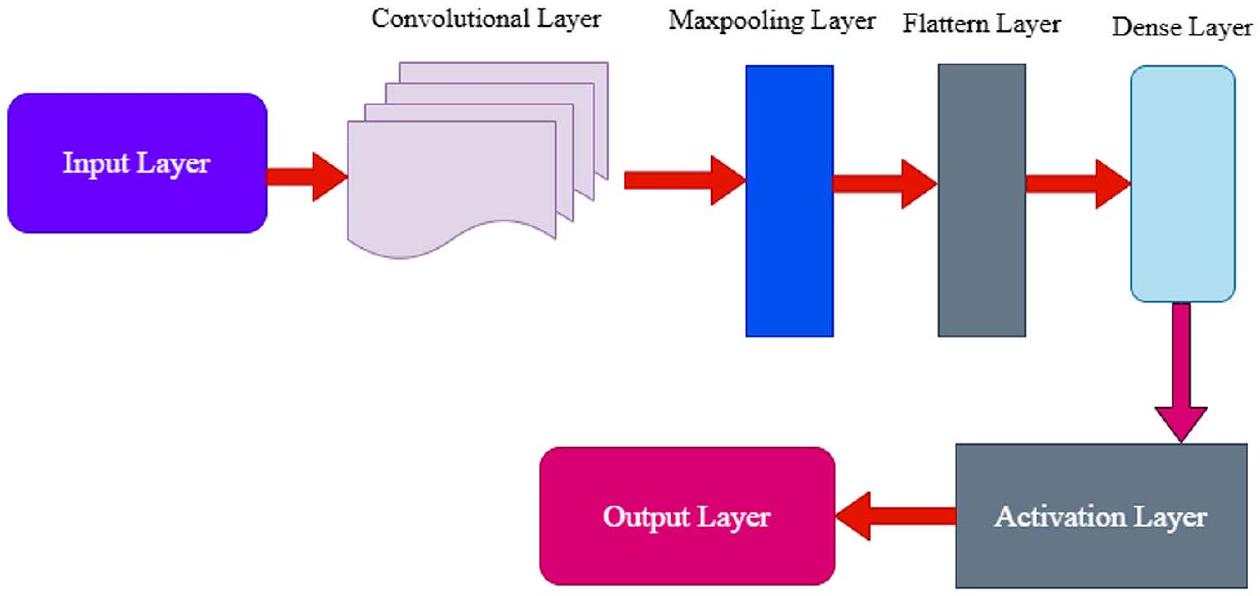

معمارية نموذج CNN

الطبقة التلافيفية

في التعلم العميق، وخاصة في الشبكات العصبية التلافيفية، تعتبر الطبقة التلافيفية هي الطبقة الأساسية. تستخدم هذه الطبقة مرشحات أو نوى، للانزلاق فوق بيانات الإدخال واستخراج الميزات المحلية المتكررة، مع الحفاظ في الوقت نفسه على الاتصال المكاني. يحلل كل مرشح هياكل معينة داخل الصورة، مما يحسن الاحتمالية العامة لاكتشاف أنماط أكثر تعقيدًا في الشبكة. من خلال التقاط الميزات الهرمية، تكون الطبقات التلافيفية فعالة في معالجة الصور، مما يمكّن النموذج من التعرف على الحواف، والملمس، والتمثيلات ذات المستوى الأعلى. تتحكم الخطوات والحشو في الأبعاد المكانية، مما يؤثر على مجال الاستقبال للطبقة. تساهم الطبقات التلافيفية بشكل كبير في نجاح المهام مثل التعرف على الصور، واكتشاف الكائنات، والتجزئة الدلالية في تطبيقات التعلم الآلي المختلفة.

طبقة التجميع الأقصى

أساسية في CNNs، تقوم طبقة التجميع الأقصى بتقليل العينات واستخراج الميزات من خلال تقسيم الإدخال إلى مناطق غير متداخلة، واختيار القيمة القصوى من كل خريطة ميزات. يحتفظ هذا الإجراء بالمعلومات الأساسية مع تقليل الأبعاد المكانية، مما يساعد على الكفاءة الحاسوبية ويخفف من الإفراط في التكيف. من خلال تحسين عدم التباين في الترجمة، يعزز التجميع الأقصى مقاومة الشبكة للتغيرات في الاتجاه المكاني. أثناء تقليل العينات، يحتفظ بالميزات السائدة، مما يساهم في تعلم الميزات الهرمية. تعتبر طبقات التجميع الأقصى أداة مهمة في إنشاء الهياكل المكانية، مما يحسن قدرة الشبكة على التعرف على الأنماط المعقدة وتعميمها في بيانات متنوعة، خاصة في المهام المتعلقة بالصور.

طبقة التسطيح

طبقة التسطح هي جزء أساسي من العديد من الشبكات العصبية وتأتي بعد طبقات الالتفاف وطبقات التجميع. دورها الرئيسي هو تغيير بيانات الإدخال إلى مصفوفة واحدة أو دمج المعلومات كوسيلة للطبقات المتصلة بالكامل. تعتبر عملية التسطح هذه محورية في الانتقال من التسلسلات الهرمية المكانية إلى تنسيق مناسب لهياكل الشبكات العصبية التقليدية. من خلال تحويل البيانات متعددة الأبعاد إلى هيكل خطي، تسهل طبقة التسطح تعلم الميزات الشامل والتجريد. تلعب دورًا حاسمًا في مهام مثل تصنيف الصور، مما يمكّن الشبكة العصبية من استخراج ومعالجة الأنماط المعقدة لتحقيق توقعات دقيقة واتخاذ قرارات.

طبقة كثيفة

تعتبر الطبقة الكثيفة، التي تُعرف غالبًا بالطبقة المتصلة بالكامل، جزءًا أساسيًا من الشبكات العصبية، حيث تشكل حجر الزاوية في هيكلها. تتصل الخلايا العصبية في هذه الطبقة ببعضها البعض، مما يشكل مصفوفة كثيفة تسمح لكل خلية عصبية بالاتصال بكل خلية عصبية في الطبقات السابقة واللاحقة. تتيح هذه الاتصالات الواسعة تعلم الميزات بشكل شامل وتجريدها. تكون هذه الأمور مهمة جدًا عندما تكون هناك أنماط معقدة تحتاج إلى التعلم ضمن البيانات التي يتم إدخالها إلى النموذج. تعتبر الطبقات الكثيفة مهمة جدًا خاصة في المهام مثل تصنيف الصور وكذلك توليد الصور ومعالجة اللغة الطبيعية. في الطبقات الكثيفة، يتم تدريب الأوزان والانحياز لتحسين كفاءة إجراء التنبؤات الدقيقة بناءً على أكثر الأنماط تطورًا.

طبقة التفعيل

طبقة التفعيل هي عنصر حيوي في الشبكات العصبية لإدخال عدم الخطية، مما يعزز تعقيد النموذج وقوة التعبير. تتبع كل مخرجات الخلايا العصبية في طبقة الشبكة العصبية، حيث تطبق دالة تفعيل مثل ReLU أو Sigmoid أو Tanh. هذه التحويلات غير الخطية تقدم سلوكًا ديناميكيًا كما هو موضح في الشكل 2، مما يمكّن الشبكة من فهم الأنماط والعلاقات المعقدة الكامنة في البيانات، مما يسهل عمليات التعلم الأكثر دقة وتفصيلاً. تتيح طبقات التفعيل للنموذج التقاط ميزات معقدة وأداء مهام متقدمة مثل التعرف على الصور أو فهم اللغة الطبيعية، مما يضمن قدرة الشبكة على تقديم تمثيلات أكثر دقة وقوة.

الشكل 2. هيكل نموذج الشبكة العصبية التلافيفية.

زيادة التمايز

تشمل زيادة التمايز (DA) اللون، التشبع، السطوع، والتباين، والتي عند دمجها في البيانات تساعد في تعزيز أداء النموذج من خلال إنشاء تنوعات واقعية ومتنوعة في بيانات التدريب. تغيير اللون يعني تحريك الألوان لأعلى أو لأسفل في الطيف، وتغيير ظروف الإضاءة بالإضافة إلى تدريب النموذج تحت نغمة لونية مختلفة، على الرغم من أن التحولات المفرطة قد تشوه الميزات المهمة المعتمدة على اللون. تعديل التشبع يأخذ اللون إلى مستوى آخر من خلال زيادة أو تقليل قدرة النموذج على التمييز بين الألوان في الظروف الساطعة أو الأقل سطوعًا، ولكن الإفراط في ذلك قد ينتج عنه نتائج غير واقعية. تغييرات التباين تحاكي مستويات مختلفة من التعرض، مما يفيد تدريب النموذج في الميزات مع ضمان التكيف مع البيئات ذات التباين العالي أو المنخفض؛ ومع ذلك، فإن التصحيحات المتطرفة مثل السطوع الشديد أو الظلام الشديد تقلل من فعالية التدريب. تساعد هذه التأثيرات بشكل كبير في تحسين التعرف على الميزات في ظروف الإضاءة المنخفضة وت stabilizing أداء الجهاز في كل من إعدادات التباين العالي والمنخفض، ولكن يمكن أن تتسبب في إخفاء التفاصيل الدقيقة المهمة بسبب التغيير في التباين. بشكل عام، تُثري هذه الطرق بيانات التدريب، وتوفر رؤية أكثر عمومية لتوزيعات البيانات، وتقلل من الإفراط في التكيف، وبالتالي تحسن جميع المهام القابلة للتعلم في حالة التطبيق الحذر للتعزيزات للحفاظ على واقعية البيانات.

تعديل اللون

في معالجة الصور

ضبط التشبع

تعديل التشبع هو عملية رئيسية في معالجة الصور تتضمن تغيير شدة الألوان. من خلال التلاعب بمستويات التشبع، يمكن تعزيز أو تقليل تشبع الألوان في الصورة. هذا التعديل ذو قيمة لتعديل التأثير البصري للصور، مما يساهم في التعديلات الفنية وعمليات تصحيح الألوان.

ضبط السطوع

تتطلب عمليات معالجة الصور ضبط السطوع لتغيير مستوى الإضاءة بالكامل في الصورة. يمكن تحسين الرؤية أثناء معالجة مشاكل التعرض أو إنشاء تأثيرات فنية من خلال تعديل مستويات سطوع الصورة. تعمل هذه العملية بشكل أساسي على تحسين الجودة البصرية إلى جانب وضوح الصورة عبر منصات تطبيقات مختلفة.

ضبط التباين

تعديل التباين هو عملية معالجة صور حيوية تتضمن تعديل الفرق في السطوع بين المناطق الفاتحة والداكنة في الصورة. من خلال تعزيز أو تقليل التباين، يمكن إبراز التفاصيل، وتحسين الرؤية، أو تحقيق تأثيرات فنية. يساهم هذا التعديل في تحسين جودة الصورة والأثر البصري.

الخوارزمية: شبكة عصبية تلافيفية مع تعزيز تفاضلي (DA) لجمع بيانات الكشف عن سرطان الرئة وتحميلها.

اختر مجلد مجموعة البيانات D الذي يحتوي على الصور المعلّمة.

معالجة البيانات المسبقة.

لكل صورة Ii في D:

معالجة البيانات المسبقة.

لكل صورة Ii في D:

- تطبيع: Ii norm

. - ترميز التسمية:

حيث li هو التسمية لـ Ii.

قم بتقسيم D إلى مجموعة تدريب T ومجموعة تحقق V بنسبة (مثل 80:20).

هيكل النموذج.

قم بإنشاء نموذج CNN M مع الطبقات:

- التفاف (

حيث f هو عدد الفلاتر و k هو حجم النواة. - تجميع الحد الأقصى:

حيث k هو حجم التجميع. - تسطيح: F() .

- كثيف:

حيث n هو عدد الخلايا العصبية. - التفعيل: استخدم ReLU للطبقات المخفية وSoftmax للإخراج.

دالة الخسارة

تعزيز قابل للاشتقاق.

بالنسبة للصورة أنا:

- ضبط اللون:

لون (I, h) حيث هو عامل لون عشوائي. - ضبط التشبع:

التشبع (I، smin، smax) حيث smin و smax هما عوامل تشبع عشوائية. - ضبط السطوع:

حيث b هو عامل سطوع عشوائي. - ضبط التباين:

التباين (I، cmin، cmax) حيث cmin و cmax هما عوامل تباين عشوائية.

التدريب.

- قم بتدريب M باستخدام T مع تطبيق DA. لكل عصر:

- لكل دفعة B في T.

- طبق DA على B للحصول على B’.

- تحديث M باستخدام

لتقليل L.

تقييم.

قم بتقييم M باستخدام V لحساب الدقة والخسارة.

التعاريف

- د: مجموعة البيانات الكاملة.

- Ii: الصورة عند الفهرس i.

- li: علامة الصورة Ii.

- ت: مجموعة بيانات التدريب.

- V: مجموعة بيانات التحقق.

- نموذج CNN.

- ل: دالة الخسارة.

-

: التسمية المتوقعة بواسطة النموذج. - y: التسمية الحقيقية.

التدريب

الزيادة التفاضلية هي تقنية تطبق تحولات متنوعة على حالات فردية ضمن دفعات الصور أثناء التدريب. الأسباب الرئيسية لاعتمادها هي:

تنوع في بيانات التدريب: يقدم DA تنوعات في عينات التدريب، مما يثري مجموعة البيانات. هذا يضمن أن النماذج تتعرض لوجهات نظر بيانات متنوعة، مما يحسن التعميم.

أين

تم تطبيق تعزيز تفاضلي التحولات التالية: تعديلات اللون ضمن

تم تطبيق تعزيز تفاضلي التحولات التالية: تعديلات اللون ضمن

تخفيف الإفراط في التكيف: من خلال إدخال العشوائية والتنوع في عملية التدريب، يقلل DA من خطر نماذج حفظ بيانات التدريب بدقة، وهو ظاهرة تعرف بالإفراط في التكيف بالذاكرة.

الاستخدام الفعال للبيانات المحدودة: خاصة في مجالات مثل التصوير الطبي، حيث يمكن أن تكون البيانات نادرة، يقوم DA بتوسيع مجموعة البيانات بشكل مصطنع، مما يوفر المزيد من عينات التدريب دون الحاجة لجمع بيانات جديدة.

أثر DA على وقت الحساب

بينما يقدم DA تنوعًا في بيانات التدريب، فإنه يضيف أيضًا عبئًا حسابيًا بسبب عملية التعزيز. ومع ذلك، غالبًا ما يتم تعويض هذا العبء من خلال تقليل عدد دورات التدريب المطلوبة لتحقيق التقارب، بفضل مجموعة البيانات الأكثر ثراءً وتنوعًا.

دعونا نعتبر الوقت الحسابي بدون DA ومع DA:

- بدون DA: لا-DA

دورة Tno – DA Tepoch. - مع DA: DATDA

Tepoch + Taug .

حيث E هو عدد الدورات، دورة Tepoch هو الوقت المستغرق لكل دورة،

في العديد من السيناريوهات، DA<no-DATDA< Tno – DA، مما يجعل DA فعالًا من الناحية الحسابية على المدى الطويل.

عمل الشبكة العصبية مع DA

عندما يتم تدريب الشبكات العصبية، وخاصة CNNs، باستخدام DA، فإنها تتعلم التعرف على الميزات غير المتغيرة بالنسبة للتعزيزات المطبقة. وهذا يعني أنها تصبح بارعة في تحديد الميزات ذات الصلة بغض النظر عن التغيرات في اللون، السطوع، التباين، أو أي تحسينات أخرى تم إدخالها بواسطة DA.

رياضيًا، إذا تم الإشارة إلى مستخرج الميزات في الشبكة العصبية بـ F، فإن:

تشير هذه المعادلة إلى أن الميزات الأساسية المستخرجة من الصور الأصلية والمعززة يجب أن تكون قابلة للمقارنة.

تقييم الشبكات العصبية مع DA

عادةً ما يتضمن تقييم أداء الشبكات العصبية المدربة باستخدام DA اختبار النموذج على بيانات غير معززة (أو أحيانًا بيانات معززة بشكل طفيف) لضمان قابلية التطبيق في العالم الحقيقي. تقدم مقاييس الأداء مثل الدقة، الدقة، الاسترجاع، وF1-score تقييمًا شاملًا لفعالية النموذج وقدراته.

الدقة

في جوهرها، يعمل DA كتنظيم، مما يعزز من قوة الشبكات العصبية وقدراتها على التعميم، مما يجعلها أكثر ملاءمة لتطبيقات العالم الحقيقي المتنوعة.

في جوهرها، يعمل DA كتنظيم، مما يعزز من قوة الشبكات العصبية وقدراتها على التعميم، مما يجعلها أكثر ملاءمة لتطبيقات العالم الحقيقي المتنوعة.

نظام الكشف عن سرطان الرئة، المصمم لإحداث ثورة في عملية التشخيص، يتميز بشكل بارز بشبكة عصبية تلافيفية (CNN) متكاملة مع تعزيز تفاضلي. عندما تدخل مجموعة جديدة من مسحات الرئة إلى النظام، تخضع لسلسلة من خطوات المعالجة المسبقة. تضمن هذه الخطوات تطبيع الصورة لقيم شدة متسقة، وإعادة الحجم إلى أبعاد موحدة تناسب CNN، وترميز التسميات إلى قيم عددية للتدريب المراقب. بمجرد المعالجة المسبقة، يتم توجيه البيانات إلى قلب النظام: نموذج CNN مع DA. يتكون هيكل هذا النموذج المتطور من طبقات تلافيفية مصممة لاستخراج الميزات الهرمية، وطبقات تجميع لتقليل الأبعاد مع الاحتفاظ بالمعلومات الأساسية، وطبقات كثيفة تم ضبطها بدقة للتصنيف.

دور DA، الذي يعد حاسمًا في مرحلة التدريب، هو تطبيق تحويلات عشوائية ولكن ذات مغزى على الصور في كل دورة تدريبية. يضمن هذا التعزيز الديناميكي أن يواجه CNN باستمرار تمثيلات متنوعة من البيانات، مما يمنع الاعتماد المفرط على عينات تدريب معينة ويعزز التعرف الحقيقي على الميزات. بعد التدريب المكثف، يخضع النموذج لتقييم دقيق باستخدام مجموعة بيانات اختبار مستقلة. تقيم المقاييس الرئيسية، بما في ذلك الحساسية، الخصوصية، الدقة وF1-score، فعاليته التشخيصية.

بمجرد التأكد من كفاءته وموثوقيته، يتم دمج النموذج في بيئة التشغيل الخاصة بالنظام. هنا، يتفاعل المتخصصون في الرعاية الصحية مع واجهة تركز على المستخدم، حيث يقومون بتحميل مسحات الرئة، وبدء التقييمات التشخيصية، واستلام التنبؤات المدعومة بنقاط الثقة. تم تصميم النظام للتعلم المستمر للحفاظ على ملاءمة النموذج وقابليته للتكيف. مع ظهور اكتشافات طبية جديدة وتوفر بيانات إضافية، يخضع النموذج لإعادة تدريب دورية، مما يضمن توافقه مع أحدث تشخيصات سرطان الرئة. من خلال دمج قوى CNN وDA، يقف هذا النظام كمنارة أمل للكشف عن سرطان الرئة في الوقت المناسب، بدقة وكفاءة، بهدف تحسين نتائج المرضى وتبسيط عمليات الرعاية الصحية.

XAI باستخدام نهج LIME

تقدم هذه الدراسة طريقة جديدة تهدف إلى تعزيز موثوقية تصنيف صور سرطان الرئة من خلال تطبيق تقنيات الذكاء الاصطناعي القابل للتفسير (XAI). يستخدم التحليل LIME للصورة

LIME (تفسيرات نموذجية محلية قابلة للتفسير)

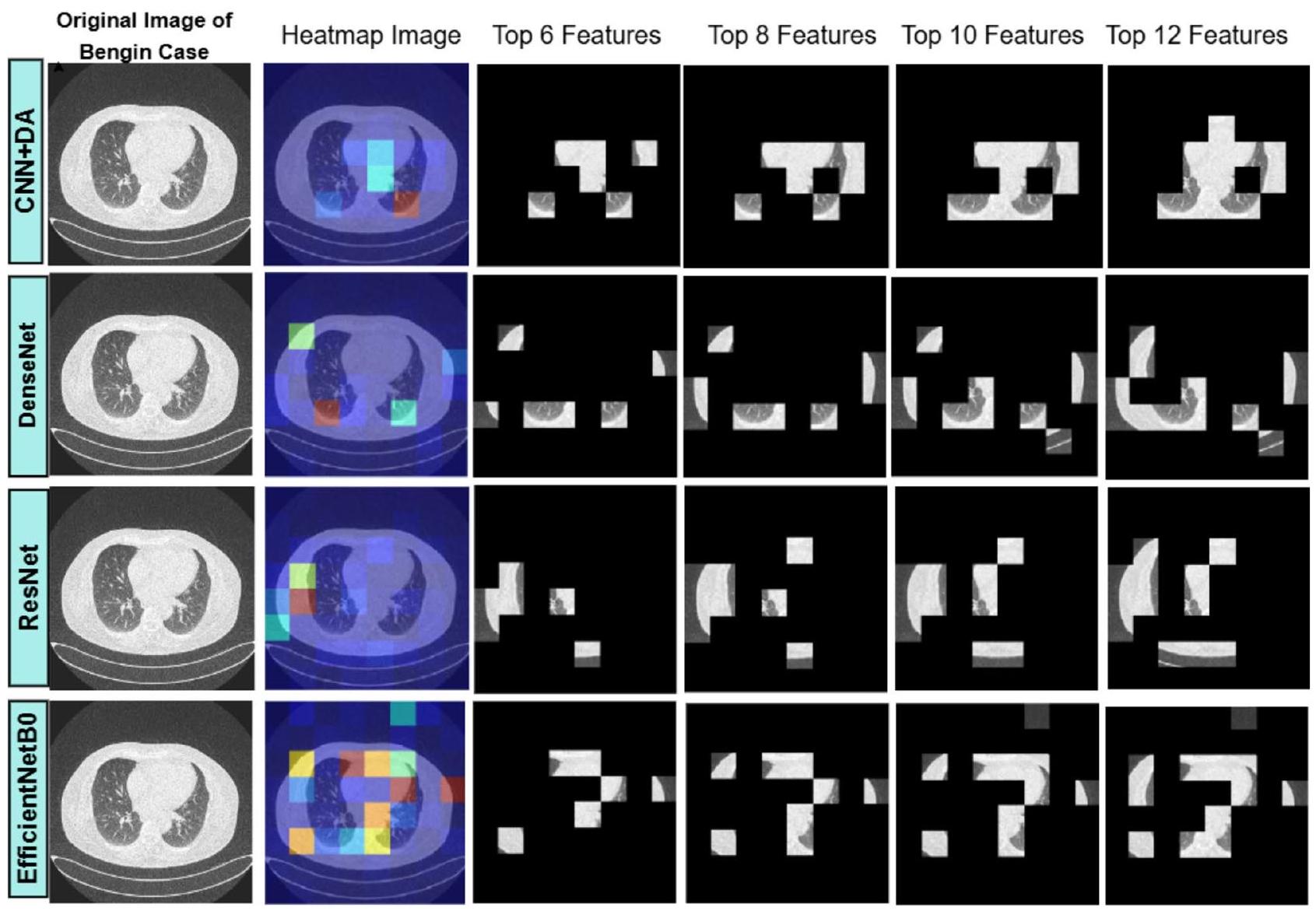

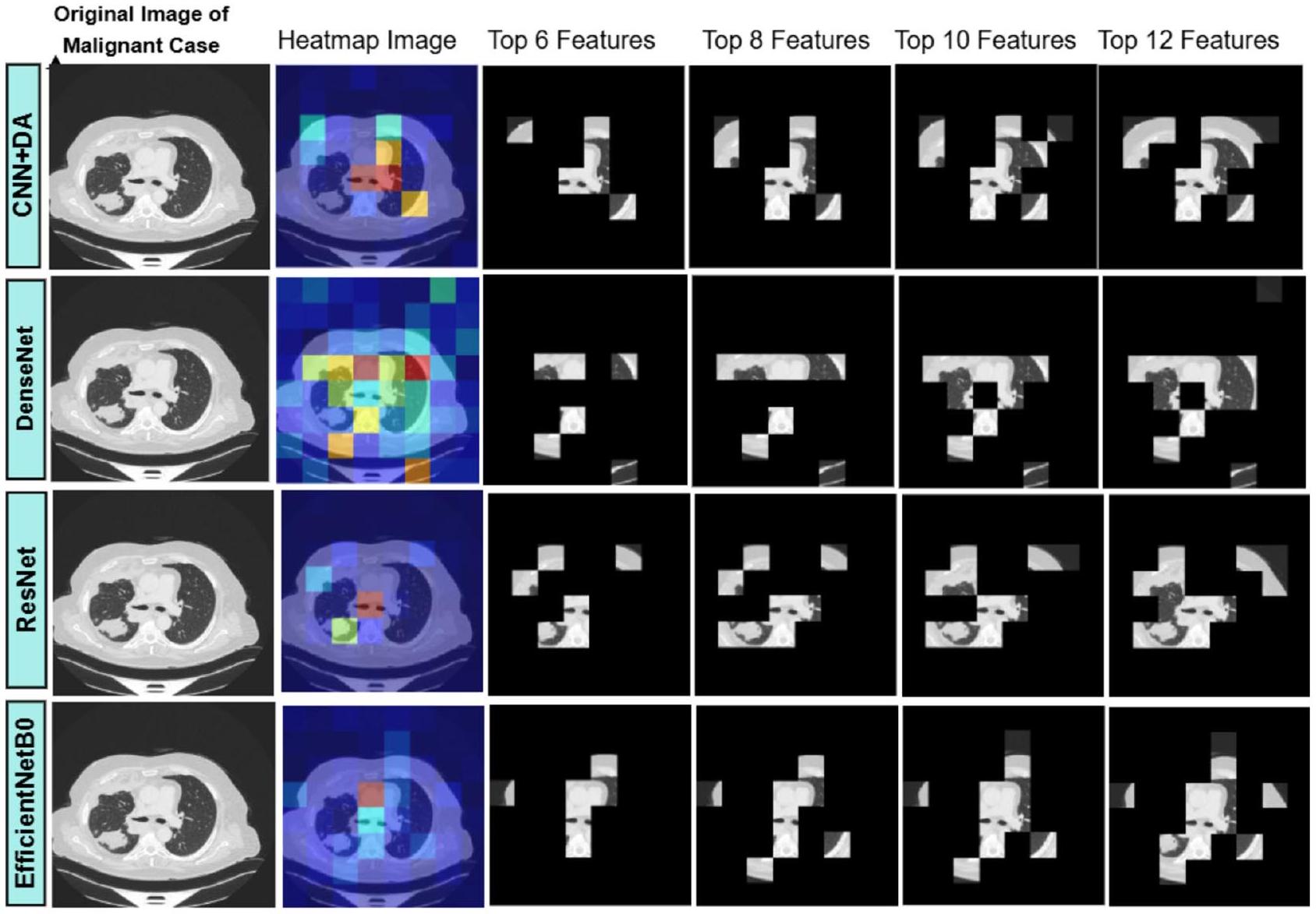

في المرحلة الثانية من منهجيتنا، يتم استخدام LIME لتصور وتفسير عملية اتخاذ القرار للنموذج على مستوى محلي. يتم ذلك من خلال تسليط الضوء على المناطق أو الميزات الرئيسية داخل الصورة التي تساهم بشكل كبير في تنبؤات النموذج. طبقنا تقنية LIME لتحليل الميزات ذات الأولوية التي كشف عنها النموذج في تفسير صورة اختبار محددة. بعد ذلك، استخدمنا خرائط حرارة الميزات التي تم إنشاؤها بواسطة LIME لتغطية الصور، كاشفين فقط عن الأكثر أهمية

تحدث مقارنة شاملة للنماذج في المرحلة النهائية من الدراسة التي تتضمن كل من التنبؤات الناجحة من المرحلة الأولية والاستخراج الفعال للميزات المعتمد على LIME من المرحلة الثانية. تستخدم منهجية التقييم لملاءمة ميزات النموذج في صور سرطان الرئة مقياس التشابه Intersection over Union (IoU). يمكن للمستخدمين الوصول إلى تصورات LIME لكشف الميزات المميزة التي يعتمد عليها كل نموذج عند اتخاذ نتائج التنبؤ. يراقب تحليل الكفاءة الاستخراجية مدى توافق الميزات التي حددها النموذج مع الميزات الحقيقية الموجودة في البيانات. يتم استخدام درجة IoU كمقياس كمي لمقارنة الصورة الممسوحة ثنائيًا التي أنشأها النموذج مع الصورة الحقيقية، مما يتيح تقييم درجة التداخل بين الميزات المختارة. تقيس هذه الطريقة التقييمية مدى جودة اختيار النموذج للميزات المناسبة التي تؤدي إلى الكشف الصحيح عن سرطان الرئة.

يقيم مقياس IoU تشابه مجموعتين من خلال قسمة منطقة تقاطع الصورة الحقيقية (GT) على منطقة الصورة الثنائية الممسوحة (MB) مقارنة بمناطقها المجمعة. يتراوح المقياس الكمي لقياس تداخل الميزات من 0 إلى 1 من خلال هذا المقياس. يتواجد مقياس قياس مقياس IoU بين 0 لعدم وجود تشابه و1 للتداخل المثالي. يمكن عرض صيغة حساب قيمة IoU من خلال هذه المصطلحات في المعادلة (17):

كلاهما

النتيجة والمناقشة

تتناول هذه الورقة تصميم وتنفيذ نظام متقدم لتوقع سرطان الرئة باستخدام بايثون وأطر التعلم العميق القوية مثل TensorFlow وKeras. تُعرف TensorFlow، وهي مكتبة مفتوحة المصدر للتعلم الآلي، بمرونتها وقابليتها للتوسع، مما يجعلها مناسبة للتعامل مع المهام المعقدة مثل تحليل الصور الطبية. توفر Keras، وهي واجهة برمجة تطبيقات الشبكات العصبية عالية المستوى، واجهة بديهية لبناء وتدريب نماذج التعلم العميق، مما يسهل العملية دون المساس بالقدرة. تهدف هذه الدراسة إلى إنشاء نظام قوي لتوقع سرطان الرئة من خلال دمج هذه التقنيات. الهدف من الجمع بين الشبكات العصبية التلافيفية وتقنيات تعزيز البيانات المبتكرة هو تحقيق دقة لا مثيل لها في اكتشاف وتصنيف سرطان الرئة من الصور الطبية. ستسلط هذه الورقة الضوء على رحلة التطوير، بدءًا من معالجة البيانات وتصميم هيكل النموذج إلى التدريب والتقييم والنشر. بالإضافة إلى ذلك، ستؤكد على أهمية دمج الذكاء الاصطناعي في الرعاية الصحية، موضحة كيف أن بايثون وTensorFlow وKeras تمثل الأعمدة التي تدعم هذا الجهد التحويلي.

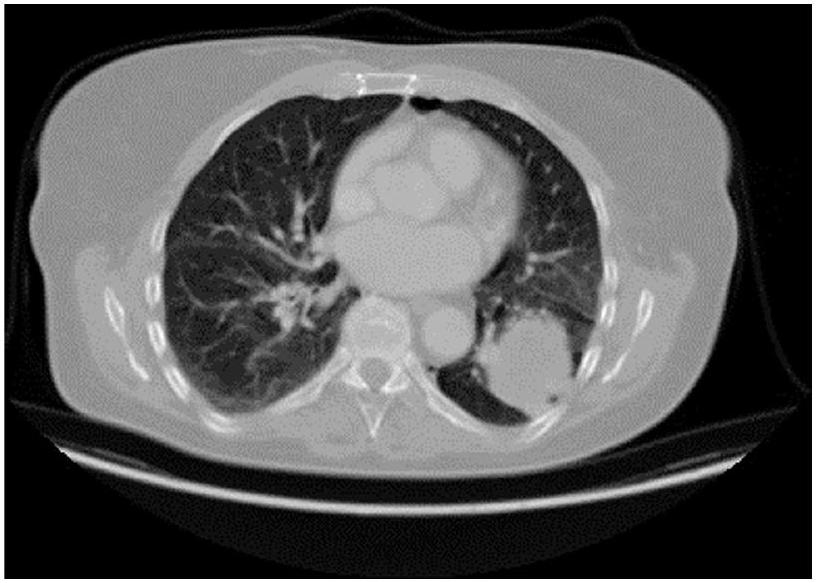

مجموعة البيانات

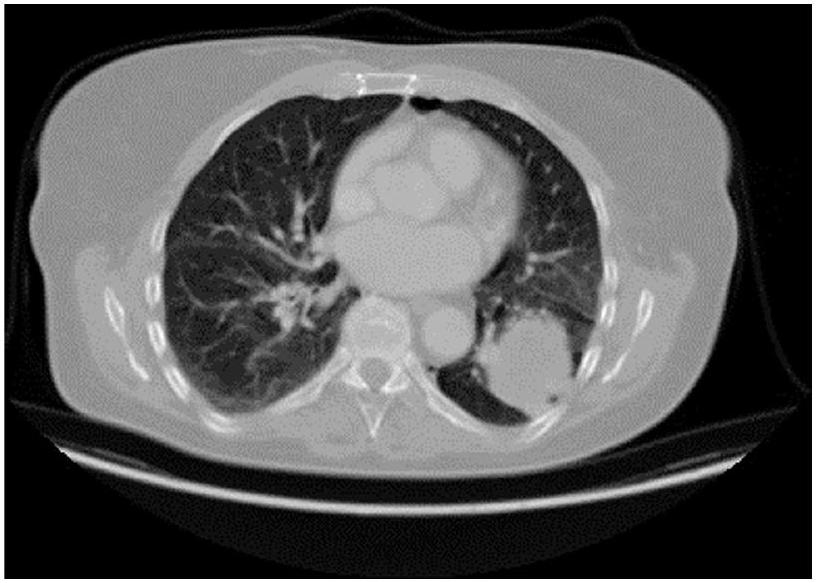

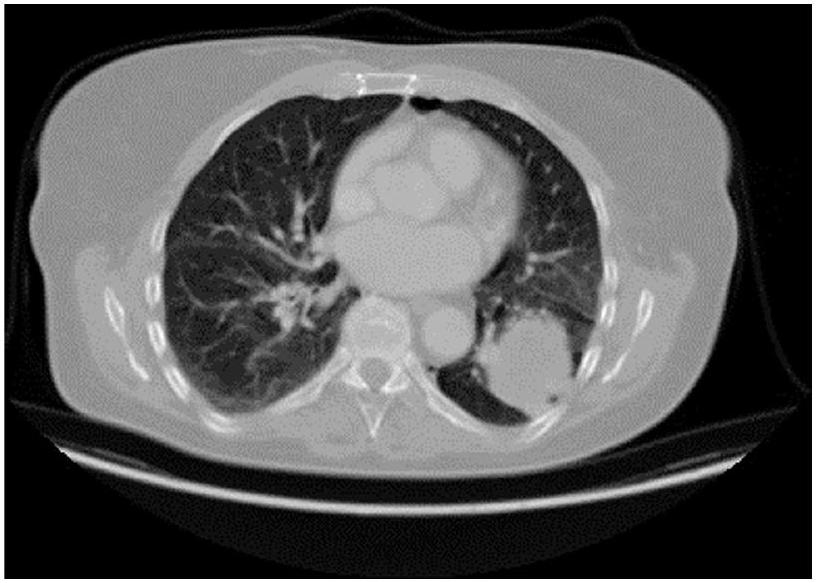

لهذه الدراسة، تم استخدام مجموعة بيانات سرطان الرئة من مستشفى العراق التعليمي للأورام/المركز الوطني لأمراض السرطان (IQ-OTH/NCCD)، المتاحة للجمهور على كاجل.

تتكون مجموعة البيانات من 1,097 صورة مقطعية تم تنظيمها في ثلاث مجموعات متميزة وهي مجموعة الأورام الحميدة، والأورام الخبيثة، والمجموعة الطبيعية لأمراض سرطان الرئة. تحتوي فئة الأورام الحميدة على 120 صورة، بينما تمتلك فئة الأورام الخبيثة 561 صورة بالإضافة إلى 416 صورة في الفئة الطبيعية. يتم تقسيم أورام الرئة إلى أنواع حميدة غير سرطانية وأنواع خبيثة سرطانية مع تمييز إضافي بين الأورام والأورام الكتلية. مرت مجموعة البيانات بعمليات تدريب لـ

النقاش حول قيود مجموعة البيانات، وخاصة الحجم النسبي الصغير لمجموعة بيانات IQ-OTH/NCCD والانحيازات المحتملة في توزيع الفئات، هو أمر حاسم لفهم تداعيات النتائج التي تم الحصول عليها من نموذج CNN + DA. تتكون مجموعة بيانات IQ-OTH/NCCD، على الرغم من توفيرها لصور مقطعية عالية الجودة من مجموعة متنوعة من مرضى سرطان الرئة، من 1,097 صورة فقط. قد يحد هذا الحجم المحدود من العينة من قدرة النموذج على التقاط الطيف الكامل لتنوعات الأورام وتعقيداتها الموجودة في مجموعة سكانية أوسع. وبالتالي، قد تتأثر أداء النموذج بالخصائص المحددة لبيانات التدريب، مما قد يؤدي إلى الإفراط في التكيف مع الأمثلة المحدودة التي واجهها.

علاوة على ذلك، فإن توزيع الفئات داخل مجموعة البيانات يقدم طبقة أخرى من التعقيد. تتضمن مجموعة البيانات 561 صورة للأورام الخبيثة، و120 صورة للأورام الحميدة، و416 صورة للرئتين السليمتين، مما يؤدي إلى تمثيل غير متوازن للفئات. يمكن أن تؤدي مثل هذه الاختلالات إلى انحراف عملية تعلم النموذج، حيث قد يصبح متحيزًا نحو الفئة الأكثر انتشارًا (الأورام الخبيثة) بينما يتم تمثيل الفئات الأقل تكرارًا (الأورام الحميدة والرئتين السليمتين) بشكل غير كافٍ. يمكن أن يؤدي هذا التحيز إلى معدل أعلى من النتائج السلبية الكاذبة للحالات الحميدة، وهو أمر مقلق بشكل خاص في البيئات السريرية حيث يكون التمييز الدقيق بين الحالات الحميدة والخبيثة أمرًا حاسمًا لإدارة المرضى.

لتخفيف هذه التحديات، يجب أن تأخذ الدراسات المستقبلية في الاعتبار زيادة مجموعة البيانات من خلال إضافة صور إضافية من مصادر متنوعة لتعزيز حجمها وتوازنها. ستساهم طرق توليد البيانات الاصطناعية مع التعلم الانتقالي من مصادر أكبر وأكثر تنوعًا في تحسين كل من قوة النموذج وأداء التعميم. علاوة على ذلك، ستوفر التحليلات الدقيقة لمقاييس الأداء الخاصة بالفئات رؤى أعمق حول مدى أداء النموذج عبر فئات مختلفة، مما يسمح للعلماء بفهم أفضل لقدرات التشخيص. يجب على الباحثين تنفيذ طرق لمعالجة قيود مجموعة البيانات، مما سيجعل نتائجهم قابلة للتطبيق في السيناريوهات السريرية ويعزز موثوقية نموذج CNN+DA لتشخيص سرطان الرئة.

استخدم هذا العمل مجموعة بيانات LC25000

سرطان الرئة الغدي هو نوع من سرطان الرئة الذي يشمل الخلايا الغدية ويحدث في الرئتين والحويصلات الهوائية، مما يشكل أكثر من

عملت مع مجموعة البيانات التي تشترك في العديد من الميزات مع “مجموعة بيانات التصوير المقطعي المحوسب والتصوير المقطعي بالإصدار البوزيتروني الكبيرة لتشخيص سرطان الرئة (Lung-PET-CT-Dx)” من أرشيف تصوير السرطان (TCIA). TCIA هو مشروع مفتوح الوصول تم تطويره لتسهيل أبحاث السرطان من خلال مشاركة بيانات تصوير السرطان المفتوحة الوصول للباحثين.

NLST

تم فحص 26,732 مشاركًا في مجموعة التصوير المقطعي المحوسب بجرعة منخفضة، وتم التحقق من سرطان الرئة في 1,083 مريضًا.

يوفر الجدول 3 مقارنة بين مجموعات البيانات، موضحًا نقاط قوتها وقيودها. يبرز الميزات الرئيسية ومدى ملاءمتها لتطبيقات محددة، مما يوفر رؤى حول استخدامها الأمثل في سيناريوهات مختلفة.

توضح الشكل 3 صورة عينة جنبًا إلى جنب مع نسختها المعززة باستخدام تقنيات DA. تبرز هذه المقارنة التحولات المطبقة لتعزيز تنوع البيانات وقوة النموذج.

يظهر الشكل 4 منحنيات خسارة التدريب والتحقق بعد تدريب النموذج باستخدام صور سرطان الرئة. يبرز انخفاض الخسارة على مر العصور، مما يشير إلى تحسين الأداء والتعميم.

تدريب وتقييم نموذج CNN مع DA.

تقييم CNN باستخدام خوارزمية التعزيز التفاضلي (DA)

الرسم البياني المقدم يقيم بشكل شامل نموذج CNN المعزز بالتعزيز التفاضلي (DA) عبر عدة عصور تدريب. يقارن الرسم البياني أداء التدريب والتحقق، مما يعطي رؤى حول ديناميات تعلم النموذج وقدرته على التعميم.

منحنيات التدريب مقابل التحقق: يعرض الرسم البياني مجموعتين من المنحنيات، واحدة تمثل أداء النموذج على بيانات التدريب والأخرى على بيانات التحقق. يسمح هذا التمييز لنا بتقييم تقدم النموذج من حيث التعلم وقدرته على الأداء على البيانات غير المرئية.

اتجاهات الدقة: ملاحظة ملحوظة هي مسار منحنيات الدقة لكل من مجموعات بيانات التدريب والتحقق. مع تقدم العصور، تميل الدقة إلى الزيادة، مما يشير إلى تحسين النموذج

| مجموعة البيانات | نقاط القوة | القيود | |||||||

| IQ-OTH/NCCD (مجموعة البيانات المختارة) |

|

|

|||||||

| LC25000 (مجموعة البيانات النسيجية) |

|

|

|||||||

| Lung-PET-CT-Dx (CT/PET على نطاق واسع) |

|

|

|||||||

| NLST (التجربة الوطنية لفحص الرئة) |

|

|

الجدول 3. مقارنة مجموعات البيانات: نقاط القوة والقيود.

الشكل 3. صورة عينة والصورة مع DA.

الشكل 4. بعد تدريب النموذج باستخدام صور سرطان الرئة، يظهر الرسم البياني خسارة التدريب وخسارة التحقق.

القدرة على تصنيف صور سرطان الرئة بشكل صحيح. أي انحراف كبير بين هذه المنحنيات قد يشير إلى الإفراط في التكيف أو نقص التكيف، وهي جوانب حاسمة يجب مراقبتها في تقييم النموذج.

اتجاهات الخسارة: تكمل منحنيات الخسارة الدقة، حيث توضح كيف تنحرف توقعات النموذج عن التسميات الفعلية عبر العصور. تشير الاتجاهات المتناقصة في الخسارة إلى أن النموذج يقوم بتحسين توقعاته، مما يجعلها تتماشى عن كثب مع العلامات الحقيقية. قرب منحنيات خسارة التدريب والتحقق هو مؤشر على أداء النموذج المتسق عبر كلا مجموعتي البيانات.

دور DA: من المحتمل أن يساهم دمج التعزيز التفاضلي (DA) في الاتجاهات الملحوظة. من خلال تقديم تمثيلات متنوعة من صور التدريب بشكل مستمر، يضمن DA أن النموذج لا يعتمد بشكل مفرط على أنماط معينة، مما يؤدي إلى تحسين التعميم. يتضح ذلك من التقدم المتزامن لمنحنيات التدريب والتحقق، مما يشير إلى تقليل الميل للإفراط في التكيف.

ملاحظات ختامية: الرسم البياني هو شهادة على فعالية دمج DA مع CNN لتصنيف صور سرطان الرئة. تشير الاتجاهات المتسقة عبر العصور والتوافق الوثيق لمقاييس التدريب والتحقق إلى نموذج مدرب جيدًا وقوي جاهز للتطبيقات في العالم الحقيقي.

تشير دقة نموذج CNN + DA العالية وحساسيته وخصوصيته إلى إمكانات قوية للتطبيقات السريرية. ومع ذلك، فإن فائدته في الإعدادات الواقعية تتطلب مزيدًا من التحقق باستخدام مجموعات بيانات متنوعة واختبار في سير العمل السريري. بالإضافة إلى ذلك، يجب ضمان القوة ضد عيوب التصوير وأنواع الماسحات المختلفة.

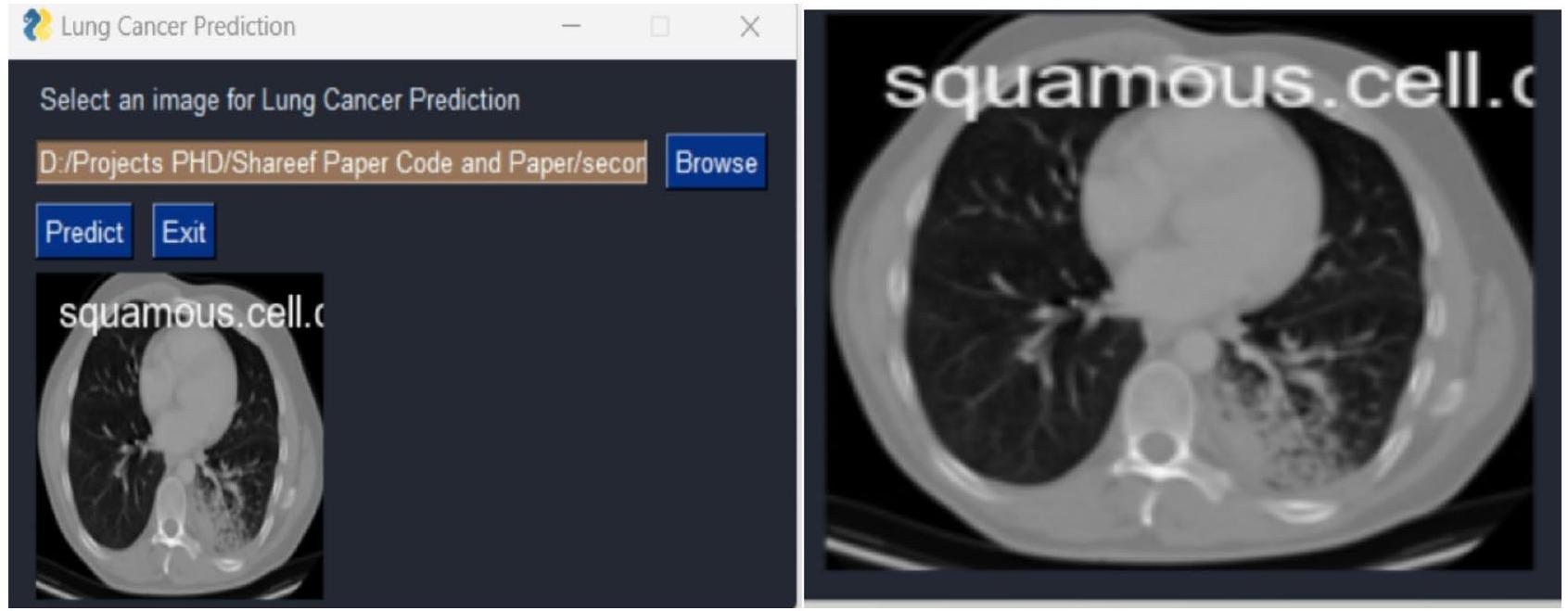

لتوقع الأمراض بدقة بناءً على المدخلات المعروضة في الشكل 5، من المحتمل أن يقوم النموذج بتحليل الأنماط في البيانات باستخدام تقنيات التعلم الآلي. يعالج ميزات متنوعة لتحديد النتائج المحتملة للأمراض، مما يعزز دقة التشخيص.

توقع سرطان الرئة باستخدام نموذج CNN مع DA

تمرير النموذج للأمام: يتم تمرير الصورة المعالجة مسبقًا عبر CNN. بينما تنتقل عبر الطبقات التلافيفية، يتم استخراج الميزات الأساسية التي تشير إلى حالات الرئة. تتم معالجة هذه الميزات الهرمية، التي تتراوح من الحواف الأساسية إلى الأنماط المعقدة، بواسطة الطبقات التالية.

الشكل 5. بمجرد إدخال البيانات، يتوقع النموذج الأمراض بدقة.

| اسم الوظيفة | القيمة |

| معدل التعلم | 0.001 |

| حجم الدفعة | 32 |

| معدل التسرب | 0.3 |

الجدول 4. معلمات التدريب.

توليد التوقعات: تأخذ الطبقات النهائية من CNN، عادةً الطبقات الكثيفة أو المتصلة بالكامل، الميزات المستخرجة وتولد توقعًا. قد يكون هذا في شكل احتمالات الفئات، خاصة إذا كانت المهمة هي تصنيف حالة الرئة. تصبح الفئة ذات أعلى فرصة هي توقع النموذج للصورة المدخلة.

المعالجة اللاحقة: قد يتم تطبيق المعالجة اللاحقة بمجرد الحصول على التوقع الخام. قد يتضمن ذلك تحويل التسميات العددية إلى نظيراتها الفئوية (مثل ‘سرطان الغدد الصماء’، ‘طبيعي’) أو تطبيق عتبة لتحديد التشخيص النهائي.

عرض المخرجات: يتم تقديم التوقع وأي درجات ثقة أو احتمالات مرتبطة للمستخدم. في بيئة الرعاية الصحية، تساعد هذه المعلومات المتخصصين الطبيين في اتخاذ قرارات مستنيرة بشأن حالة المريض والعلاج اللاحق.

تعديل المعلمات باستخدام البحث العشوائي

تعديل المعلمات باستخدام البحث العشوائي

تم تعيين معلمات التدريب الأولية للنماذج كما يلي: معدل تعلم قدره 0.001، حجم دفعة قدره 32، ومعدل تسرب قدره 0.3. بعد تطبيق البحث العشوائي لضبط المعلمات، تم تحسين هذه القيم لتحسين أداء كل نموذج. تم ضبط معدل التعلم إلى قيم تتراوح بين 0.0001 و 0.0005، حيث أثبتت المعدلات المنخفضة للتعلم فعاليتها أكثر بالنسبة لـ ResNet و EfficientNetB0. تم تعديل حجم الدفعة إلى 32 لـ CNN مع DA و ResNet، بينما حققت DenseNet و EfficientNetB0 نتائج مثالية مع حجم الدفعة الأصلي البالغ 32. وبالمثل، تم تحسين معدل التسرب إلى 0.2 لنموذج Hybrid CNN، بينما تطلبت ResNet معدلًا أعلى قليلاً قدره 0.4 لمنع الإفراط في التكيف، واحتفظت DenseNet و EfficientNetB0 بمعدل تسرب متوازن قدره 0.3. هذه المعلمات المضبوطة حسنت بشكل كبير من الدقة ودرجة F1 لكل نموذج.

يوضح الجدول 4 معلمات التدريب المستخدمة للنموذج. يوفر تفاصيل مثل معدل التعلم، حجم الدفعة، ومعدل التسرب، وهي ضرورية لإعادة إنتاج عملية التدريب.

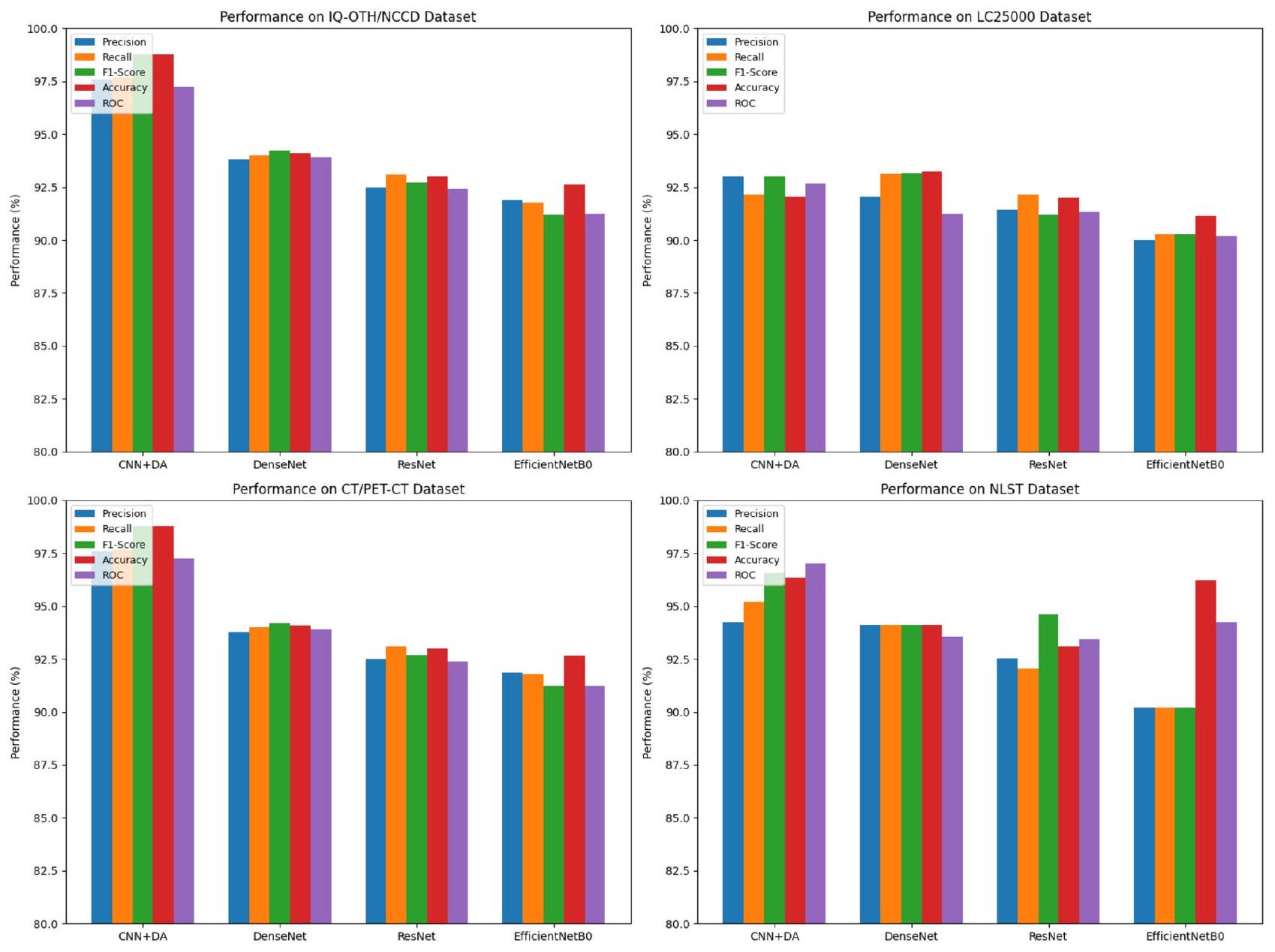

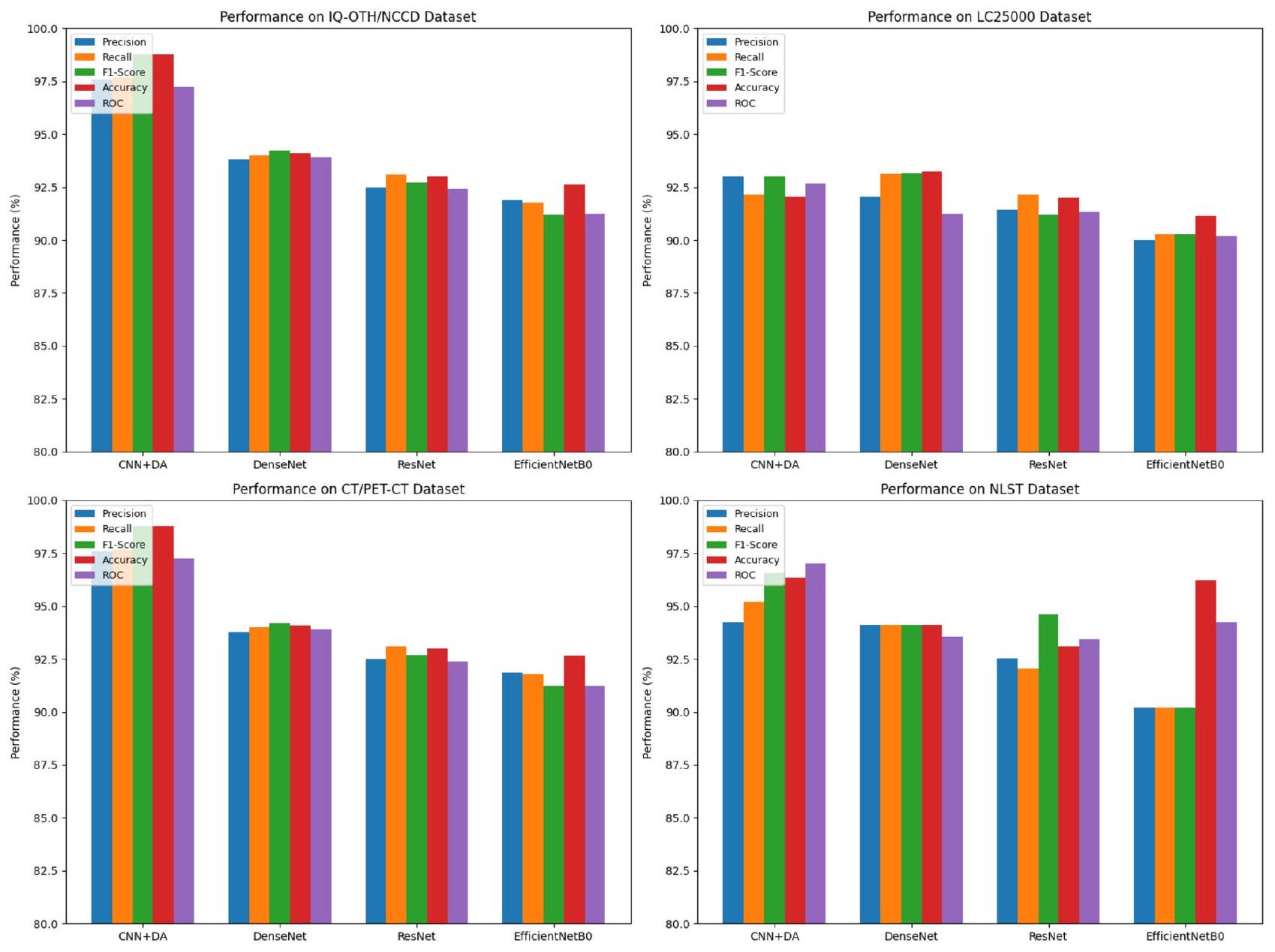

قارن بين مقاييس أداء CNN مع DA (نموذج هجين جديد)، DenseNet، ResNet و EfficientNetB0.

تظهر النتائج عبر مجموعات البيانات المختلفة أن نموذج CNN + DA (الجديد) يتفوق باستمرار على النماذج الأخرى، خاصة عند تقييمه على مجموعة البيانات الرئيسية IQ-OTH/NCCD (الجدول 5). تبرز هذه المجموعة قوة CNN + DA، حيث تحقق أعلى المقاييس في الدقة (

| مقاييس الأداء | سي إن إن + دي إيه (رواية) | دينس نت | ريزنت | EfficientNetB0 |

| دقة | ٩٧.٥٧ | 93.80 | 92.50 | 91.87 |

| استدعاء | ٩٧.٦٧ | 94.00 | 93.10 | 91.78 |

| درجة f1 | ٩٨.٧٨ | 94.20 | 92.70 | 91.21 |

| دقة | ٩٨.٧٨ | 94.10 | 93.00 | 92.64 |

| رُخ | ٩٧.٢٣ | 93.90 | 92.40 | 91.24 |

| نسبة الخطأ (%) | 1.22 | ٥.٩٠ | ٧.٠٠ | 7.36 |

الجدول 5. نماذج المقارنة مع مقاييس الأداء مع تدابير إحصائية داعمة باستخدام مجموعة بيانات IQ-OTH/ NCCD.

| المجموعة 1 | المجموعة 2 | فرق المتوسط |

|

أخفض | علوي | رفض |

| سي إن إن + دا | دينس نت | -4.61 | 0.0000 | -5.24 | -3.98 | صحيح |

| سي إن إن + دا | EfficientNetB0 | -5.97 | 0.0000 | -6.60 | -5.34 | صحيح |

| سي إن إن + دا | ريزنت | -5.58 | 0.0000 | -6.21 | -4.95 | صحيح |

| دينس نت | EfficientNetB0 | -1.36 | 0.0000 | -1.99 | -0.73 | صحيح |

| دينس نت | ريزنت | -0.97 | 0.0006 | -1.59 | -0.34 | صحيح |

| EfficientNetB0 | ريزنت | 0.39 | 0.3655 | -0.23 | 1.02 | كاذب |

الجدول 6. اختبار توكي HSD بعد التحليل لمقارنات دقة النموذج باستخدام مجموعة بيانات IQ-OTH/NCCD.

| مجموعة بيانات | سي إن إن + دا | دينس نت | ريزنت | EfficientNetB0 |

| دقة | 93.02 | 92.03 | 91.42 | 90.01 |

| استدعاء | 94.16 | 93.12 | 92.15 | 90.26 |

| درجة F1 | ٩٤.٠١ | 93.16 | 91.22 | 90.26 |

| دقة | 95.02 | 93.22 | 91.99 | 91.14 |

| رُخ | 93.69 | 91.26 | 91.32 | 90.20 |

| نسبة الخطأ (%) | ٤.٩٨ | 6.78 | 8.01 | 8.86 |

الجدول 7. نماذج المقارنة مع مقاييس الأداء مع تدابير إحصائية داعمة باستخدام LC25000.

نماذج أخرى مثل DenseNet وResNet وEfficientNetB0، تظهر CNN + DA هيمنة واضحة، خاصة في هذه المجموعة الأساسية من البيانات.

لتقييم دقة أربعة نماذج هي CNN + DA (جديد)، DenseNet، ResNet، و EfficientNetB0، تم إجراء تحليل لاحق باستخدام اختبار توكي HSD كما هو موضح في الجدول 6. أظهر التحليل وجود اختلافات كبيرة في الدقة بين معظم النماذج. أظهر نموذج CNN + DA تفوقًا ذا دلالة إحصائية على جميع النماذج الأخرى، مع اختلافات متوسطة في الدقة قدرها

عند الاختبار على مجموعة بيانات LC25000 (الجدول 7)، يقدم CNN + DA أيضًا نتائج جديرة بالثناء، محققًا أعلى دقة (

| المجموعة 1 | المجموعة 2 | فرق المتوسط (meandiff) |

|

حد الثقة الأدنى | الحد الأعلى لفترة الثقة | رفض الفرضية الصفرية |

| سي إن إن + دا | دينس نت | 1.80 | 0.02 | 0.56 | ٣.٠٤ | نعم |

| سي إن إن + دا | EfficientNetB0 | 3.03 | 0.005 | 1.44 | ٤.٦١ | نعم |

| سي إن إن + دا | ريزنت | 3.88 | 0.001 | 2.07 | ٥.٦٩ | نعم |

| دينس نت | EfficientNetB0 | 1.22 | 0.14 | -0.19 | 2.63 | لا |

| دينس نت | ريزنت | 2.08 | 0.03 | 0.15 | ٤.٠٠ | نعم |

| EfficientNetB0 | ريزنت | 0.87 | 0.22 | – 0.46 | 2.20 | لا |

الجدول 8. اختبار توكي HSD بعد التحليل لمقارنات دقة النموذج باستخدام مجموعة بيانات LC25000.

| مجموعة بيانات | سي إن إن + دا | دينس نت | ريزنت | EfficientNetB0 |

| دقة | ٩٧.٥٧ | 93.80 | 92.50 | 91.87 |

| استدعاء | ٩٧.٦٧ | 94.00 | 93.10 | 91.78 |

| درجة F1 | ٩٨.٧٨ | 94.20 | 92.70 | 91.21 |

| دقة | ٩٨.٧٨ | 94.10 | 93.00 | 92.64 |

| رُخ | ٩٧.٢٣ | 93.90 | 92.40 | 91.24 |

| معدل الخطأ (%) | 1.22 | ٥.٩٠ | ٧.٠٠ | 7.36 |

الجدول 9. نماذج المقارنة مع مقاييس الأداء مع تدابير إحصائية داعمة باستخدام التصوير المقطعي المحوسب واسع النطاق والتصوير المقطعي بالإصدار البوزيتروني/التصوير المقطعي المحوسب.

| المجموعة 1 | المجموعة 2 | فرق المتوسط (meandiff) |

|

حد الثقة الأدنى | حد الثقة العلوي | رفض الفرضية الصفرية |

| سي إن إن + دا | دينس نت | ٤.٦٨ | 0.001 | 3.90 | 5.47 | نعم |

| سي إن إن + دا | ريزنت | ٥.٧٨ | 0.0005 | ٤.٩٨ | 6.58 | نعم |

| سي إن إن + دا | EfficientNetB0 | 6.14 | 0.0002 | 5.33 | 6.95 | نعم |

| دينس نت | ريزنت | 1.10 | 0.14 | -0.12 | 2.32 | لا |

| دينس نت | EfficientNetB0 | 1.46 | 0.09 | -0.01 | 2.93 | لا |

| ريزنت | EfficientNetB0 | 0.36 | 0.42 | -1.12 | 1.84 | لا |

الجدول 10. اختبار توكي HSD بعد التجربة لمقارنات دقة النموذج باستخدام مجموعة بيانات كبيرة النطاق من التصوير المقطعي المحوسب (CT) والتصوير المقطعي بالإصدار البوزيتروني (PET/CT).

أكثر تشابهًا. تسلط هذه النتائج الضوء على القدرة الفائقة لنموذج CNN + DA على التعميم عبر مجموعة البيانات، على الأرجح بسبب الجمع بين بنية CNN القوية وزيادة البيانات، مما يعزز التعلم والصلابة.

وبالمثل، يتفوق نموذج CNN + DA على مجموعة بيانات التصوير المقطعي المحوسب (CT) والتصوير المقطعي بالإصدار البوزيتروني (PET/CT) الكبيرة (الجدول 9)، محققًا أعلى الدرجات عبر جميع المقاييس، بما في ذلك درجة F1.

اختبار توكي HSD بعد الاختبار لمقارنات دقة النموذج على مجموعة بيانات التصوير المقطعي المحوسب واسع النطاق و PET/CT (الجدول 10) يكشف أن CNN + DA يتفوق بشكل كبير على DenseNet و ResNet و EfficientNetB0، مع اختلافات في متوسط الدقة تبلغ

في مجموعة بيانات تجربة الفحص الوطني للرئة (NLST) (الجدول 11)، تظل أداء CNN + DA قويًا، مع أعلى دقة (

تظهر النتائج من اختبار Tukey’s HSD بعد الاختبار ومقاييس الأداء على مجموعة بيانات التجربة الوطنية لفحص الرئة (NLST) أن CNN + DA يتفوق بشكل كبير على DenseNet و ResNet، مع اختلافات في الدقة المتوسطة تبلغ 2.24 و 3.27 على التوالي، وكلاهما بقيم p أقل من 0.05، مما يؤكد رفض الفرضية الصفرية كما هو موضح في الجدول 12. ومع ذلك، لم يتم العثور على فرق كبير في الدقة بين CNN + DA و EfficientNetB0 (فرق متوسط من

| مجموعة البيانات | CNN + DA | DenseNet | ResNet | EfficientNetB0 |

| الدقة | 94.23 | 94.12 | 92.56 | 90.20 |

| استرجاع | 95.22 | 94.12 | 92.06 | 90.22 |

| f1score | 96.56 | 94.12 | 94.63 | 90.22 |

| الدقة | 96.36 | 94.12 | 93.09 | 96.23 |

| Roc | 97.02 | 93.56 | 93.45 | 94.23 |

| معدل الخطأ (%) | 3.64 | 5.88 | 6.91 | 3.77 |

الجدول 11. مقارنة النماذج مع مقاييس الأداء مع تدابير إحصائية داعمة باستخدام مجموعة بيانات التجربة الوطنية لفحص الرئة (NLST).

| المجموعة 1 | المجموعة 2 | فرق المتوسط (meandiff) |

|

حد CI السفلي | حد CI العلوي | رفض الفرضية الصفرية |

| CNN + DA | DenseNet | 2.24 | 0.001 | 1.56 | 2.92 | نعم |

| CNN + DA | ResNet | 3.27 | 0.0002 | 2.49 | 4.05 | نعم |

|

|

EfficientNetB0 | 0.13 | 0.85 | -1.08 | 1.34 | لا |

| DenseNet | ResNet | 1.02 | 0.18 | -0.16 | 2.19 | لا |

| DenseNet | EfficientNetB0 | -2.11 | 0.01 | -3.25 | -0.97 | نعم |

| ResNet | EfficientNetB0 | -3.13 | 0.0003 | -4.34 | -1.91 | نعم |

الجدول 12. اختبار Tukey’s HSD لمقارنة دقة النماذج باستخدام مجموعة بيانات التجربة الوطنية لفحص الرئة (NLST).

تم اختيار مجموعة بيانات IQ-OTH/NCCD لهذا البحث بسبب قوتها الفريدة في توفير صور CT عالية الجودة لمرضى سرطان الرئة عبر الفئات الحميدة، الخبيثة، والعادية. وهذا يجعلها مناسبة تمامًا لتطوير نماذج تعمم بشكل فعال عبر مجموعات سكانية متنوعة من المرضى. على عكس مجموعات البيانات الأخرى مثل LC25000، التي تركز على الصور النسيجية، أو Lung-PET-CT-Dx، التي تركز على أنواع سرطان الرئة، توفر مجموعة بيانات IQ-OTH/NCCD تمثيلًا واقعيًا لحالات الرئة. تعزز التعليقات الواضحة وتوزيع الفئات المتوازن من ملاءمتها لتشخيص سرطان الرئة.

على الرغم من حجمها النسبي الصغير المكون من 1,097 صورة، تعوض مجموعة البيانات عن ذلك بتصوير عالي الجودة (سماكة شريحة CT تبلغ 1 مم) وتمثيل ديموغرافي متنوع، مما يسمح بالكشف التفصيلي عن الأورام وتحسين القابلية للتعميم. بالإضافة إلى ذلك، فإن الأداء المتفوق لنموذج CNN + DA على هذه المجموعة من البيانات يبرز ملاءمته لتقييم نماذج توقع سرطان الرئة. هذه العوامل مجتمعة تؤسس IQ-OTH/NCCD كأفضل خيار لهذا البحث.

الجدول 5 يقارن أداء نماذج مختلفة، بما في ذلك CNN + DA (جديد)، DenseNet، ResNet، و EfficientNetB0، باستخدام مجموعة بيانات IQ-OTH/NCCD. يبرز الجدول مقاييس الأداء الرئيسية مع تدابير إحصائية داعمة، مما يظهر فعالية كل نموذج.

الشكل 6 يوضح مقاييس الأداء المقارنة لـ CNN + DA و DenseNet و ResNet و EfficientNetB0. تسلط النتائج الضوء على تفوق النموذج المقترح عبر مقاييس التقييم الرئيسية.

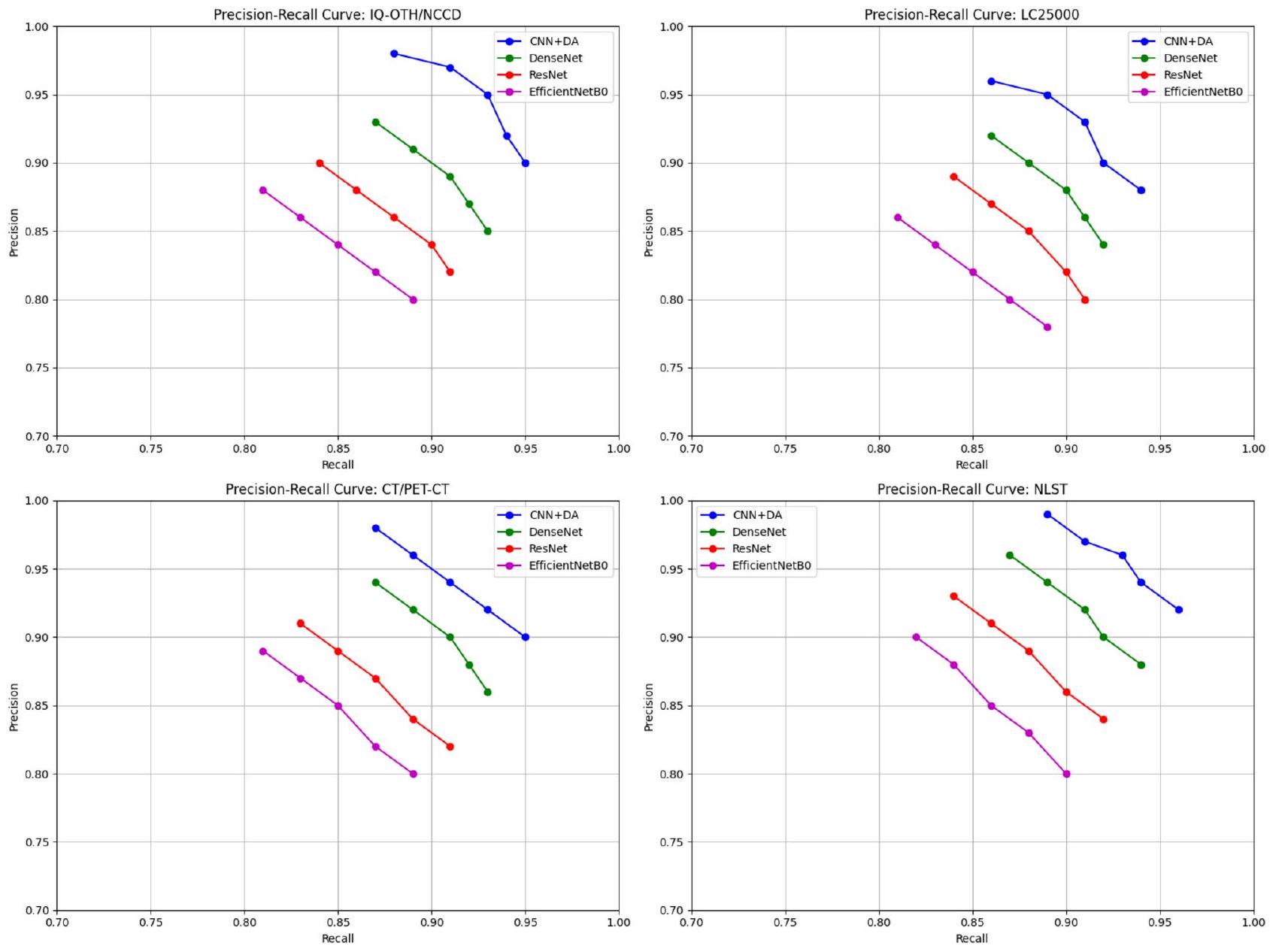

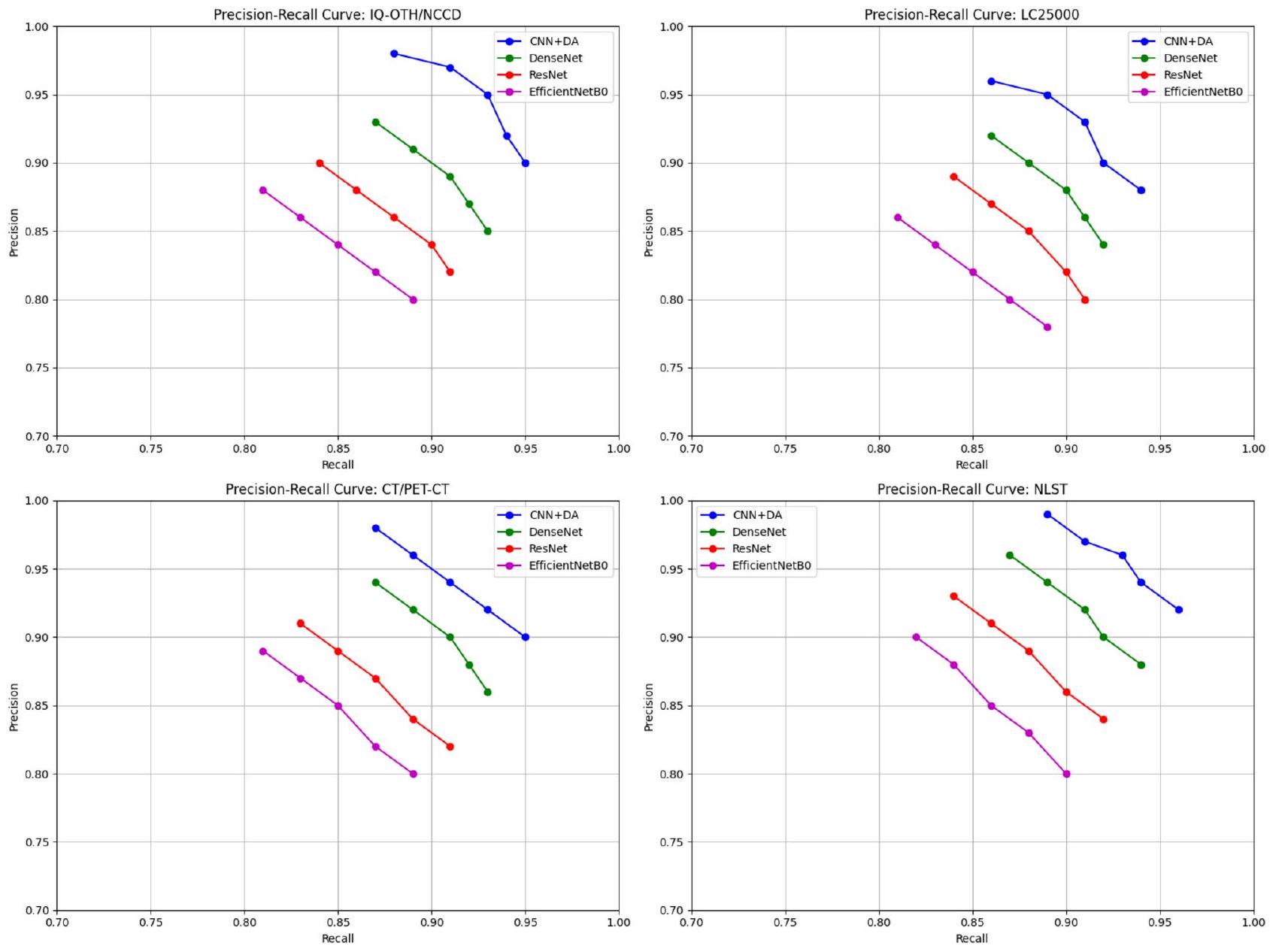

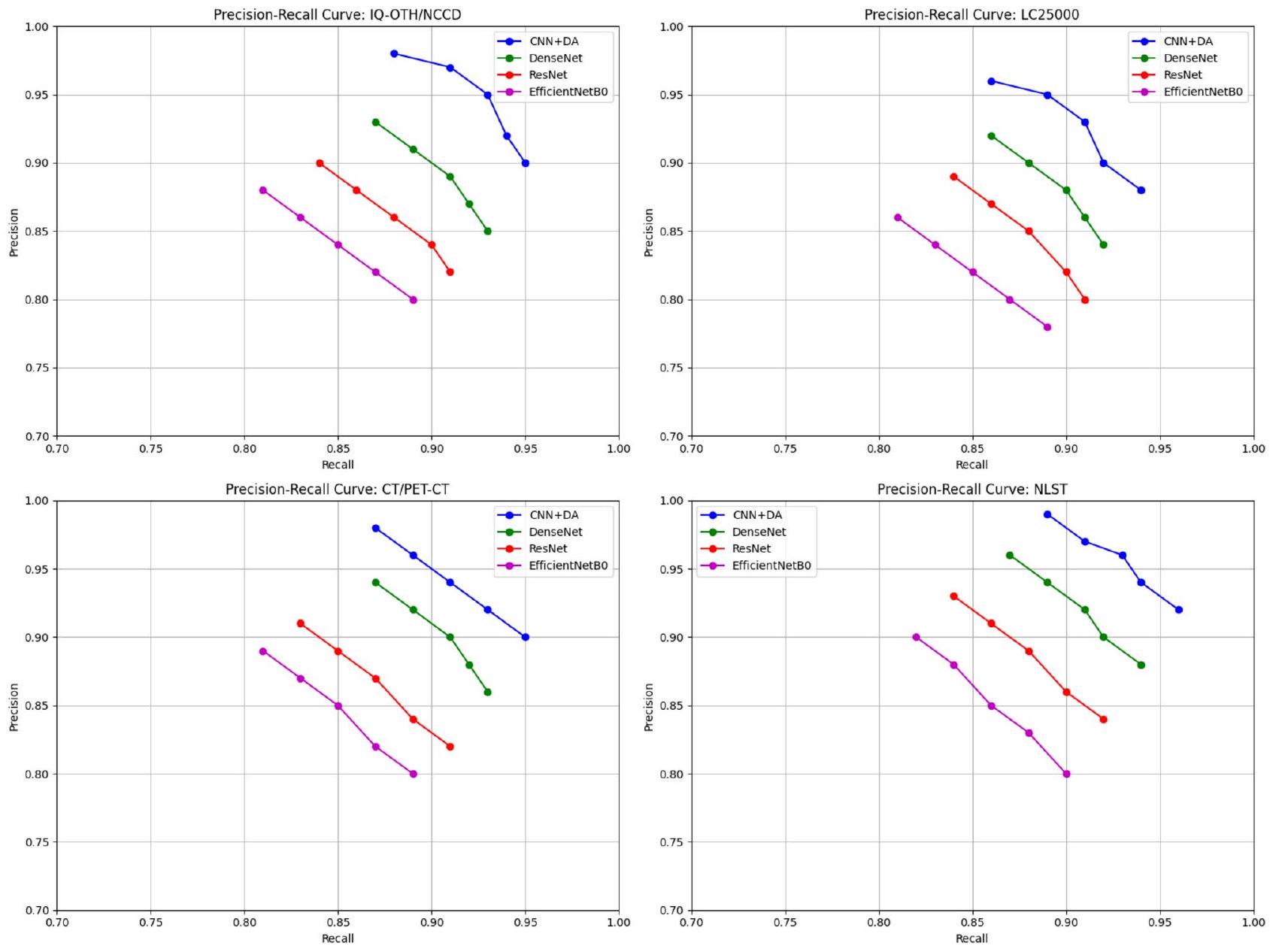

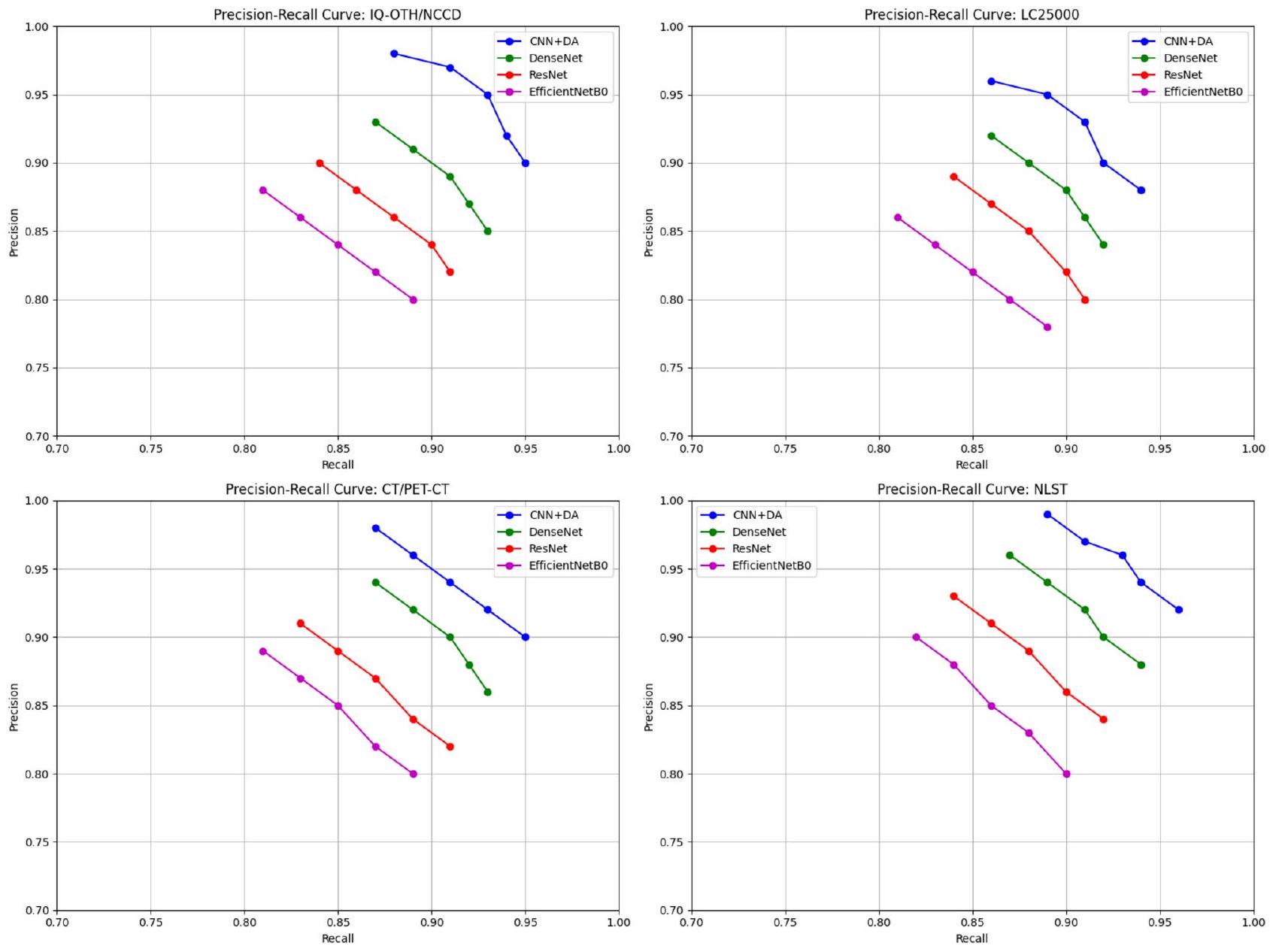

تظهر منحنيات الدقة والاسترجاع (PR) الموضحة في الشكل 7 أداء النماذج المختلفة (CNN + DA و DenseNet و ResNet و EfficientNetB0) عبر مجموعات بيانات متنوعة (IQ-OTH/NCCD و LC25000 و CT/PET-CT و NLST). يظهر نموذج CNN + DA باستمرار دقة واسترجاع متفوقين، مما ينعكس في منحنياته التي تكون أقرب إلى الزاوية العليا اليمنى لجميع مجموعات البيانات. تظهر DenseNet و ResNet و EfficientNetB0 أداءً أقل تدريجيًا، حيث ينتج EfficientNetB0 عادةً أدنى قيم للدقة والاسترجاع. تعزز هذه الاتجاهات من قوة وعمومية نموذج CNN+DA عبر مجموعات بيانات متنوعة.

تم تقييم نموذج CNN المقترح مع زيادة البيانات (CNN+DA) من خلال تقنيات تحليلية متعددة، بما في ذلك خرائط الحرارة للتوافق، وتحليل المتبقيات، وتقييم التماثل، ومخططات Q-Q. توفر هذه التقييمات رؤى عميقة حول أداء النموذج التنبؤي، وتوزيعات الأخطاء، وقدرة التعميم.

تم تقييم أداء النموذج باستخدام مقاييس مختلفة، بما في ذلك الدقة، والاسترجاع، وF1-score، والدقة، وROC. تكشف خريطة الحرارة للتوافق عن درجة عالية من التوافق (قريبة من 1) بين جميع مقاييس الأداء، مما يشير إلى أداء متسق عبر جوانب التقييم المختلفة كما هو موضح في الشكل 8. تشير هذه العلاقة الإيجابية القوية إلى أن النموذج يلتقط بفعالية الأنماط الأساسية في البيانات ويظهر أداءً متوازنًا.

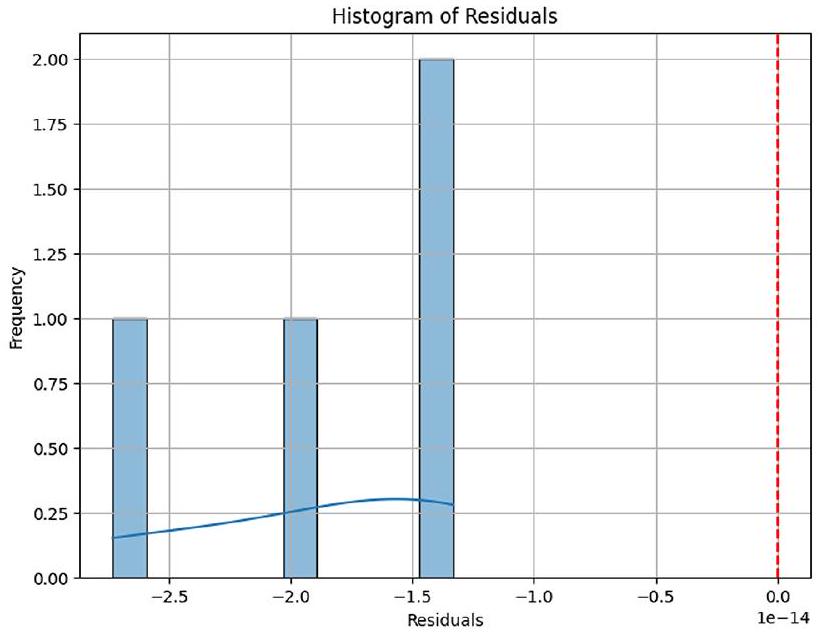

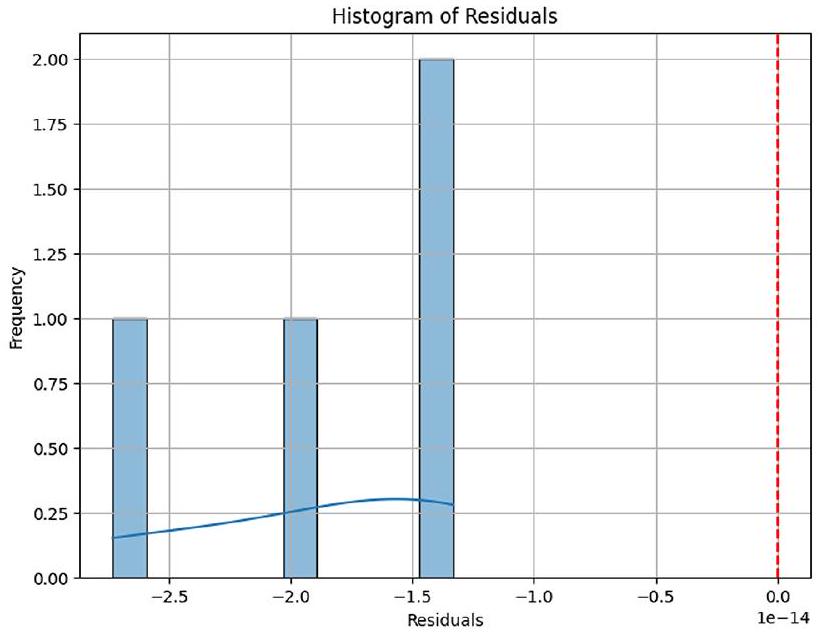

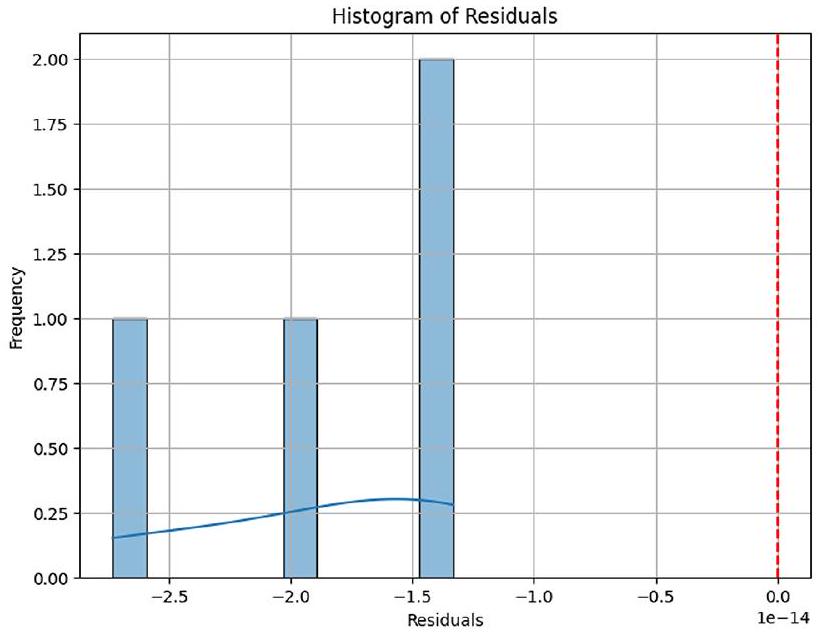

يعرض المدرج التكراري للمتبقيات توزيعًا قريبًا من الطبيعي، مما يشير إلى أن متبقيات النموذج موزعة عشوائيًا ولا تظهر أي أنماط منهجية. يتماشى هذا الملاحظة مع فرضية الطبيعية لتحليل المتبقيات، مما يوفر مزيدًا من الأدلة على كفاية النموذج كما هو موضح في الشكل 9.

يظهر مخطط المتبقيات مقابل القيم الملائمة، والذي يستخدم عادةً للتحقق من التماثل، توزيعًا متفرقًا للنقاط دون أي اتجاه أو نمط واضح. يشير هذا إلى أن تباين المتبقيات متسق عبر قيم ملائمة مختلفة، مما يدعم فرضية التماثل كما هو موضح في الشكل 10.

علاوة على ذلك، يعرض مخطط Q-Q للدقة علاقة خطية بين القيم المرتبة والكمية النظرية، مما يشير إلى أن توزيع قيم الدقة قريب من توزيع طبيعي.

مقارنة أداء النموذج عبر مجموعات البيانات

الشكل 6. مقاييس الأداء المقارنة لـ

كما هو موضح في الشكل 11. تشير هذه النتيجة إلى أن أداء النموذج متسق ولا يظهر انحرافات كبيرة عن الطبيعية.

كما هو موضح في الشكل 11. تشير هذه النتيجة إلى أن أداء النموذج متسق ولا يظهر انحرافات كبيرة عن الطبيعية.

بشكل عام، تشير تحليل هذه المخططات والمقاييس إلى أن النموذج يعمل بشكل جيد، ويظهر درجات أداء عالية، ومتبيعات موزعة بشكل طبيعي، وأداء متسق عبر جوانب التقييم المختلفة. تشير هذه النتائج إلى أن النموذج يمكن أن يكشف بنجاح عن الأنماط الأساسية في البيانات ويولد توقعات دقيقة.

يظهر نموذج CNN المقترح مع زيادة البيانات التفاضلية (CNN + DA) أداءً متفوقًا مقارنةً بالهياكل المعروفة مثل DenseNet و EfficientNetB0، ويرجع ذلك أساسًا إلى نهجه المبتكر في التخفيف من الإفراط في حفظ الذاكرة وتعزيز القوة ضد تباين البيانات. يحدث الإفراط في حفظ الذاكرة، وهو تحدٍ شائع في التعلم العميق، عندما تتذكر النماذج بيانات التدريب بدلاً من التعميم منها. يعالج نموذج CNN + DA هذه المشكلة بفعالية من خلال دمج زيادة البيانات التفاضلية (DA)، التي تطبق تحولات متنوعة مثل تعديل اللون، والسطوع، والتشبع، وتعديلات التباين أثناء التدريب. هذا التعرض لطيف أوسع من تباينات البيانات يثبط الحفظ ويعزز التعلم الحقيقي، مما يؤدي إلى تحسين قدرات التعميم. علاوة على ذلك، فإن الطبيعة الديناميكية لـ DA تسمح لنموذج CNN + DA بالتكيف مع التباينات الواقعية في ظروف التصوير، مما يعزز قوته وأدائه عبر مجموعات سكانية متنوعة من المرضى وبروتوكولات التصوير. تم تصميم هيكل نموذج CNN+DA للاستفادة من استخراج الميزات الهرمية، مما يمكّنه من تحديد الميزات الحرجة التي تشير إلى سرطان الرئة، بغض النظر عن التباينات التي قدمتها DA. تؤكد التحقق عبر مجموعات بيانات متعددة، بما في ذلك مجموعة بيانات IQ-OTH/NCCD و LC25000 و مجموعة بيانات CT و PET/CT الكبيرة، قدرة النموذج على التعميم بفعالية، محققًا دقة قدرها

منحنيات الدقة والاسترجاع لجميع النماذج ومجموعات البيانات

الشكل 7. منحنيات الدقة والاسترجاع مقارنة بين CNN + DA و DenseNet و ResNet و EfficientNetB0، تظهر توازنًا أفضل بين الدقة والاسترجاع في النموذج المقترح.

الشكل 8. خريطة حرارة ارتباط الميزات لتحليل اعتماد السمات.

الشكل 9. هيستوجرام المتبقي لتقييم كفاية النموذج.

الشكل 10. رسم المتبقيات مقابل القيم الملائمة لفحص التماثل.

الشكل 11. رسم Q-Q للدقة لتقييم الطبيعية.

| نماذج CNN | درجة التقاطع على الاتحاد (IoU) | ||||

| 6 ميزات | 8 ميزات | 10 ميزات | 12 ميزة | متوسط درجة IoU | |

| DenseNet | 0.33 | 0.36 | 0.39 | 0.43 | 0.37 |

| ResNet | 0.29 | 0.31 | 0.35 | 0.39 | 0.33 |

| EfficientNetB0 | 0.31 | 0.37 | 0.41 | 0.43 | 0.38 |

| CNN + DA | 0.35 | 0.40 | 0.43 | 0.47 | 0.41 |

الجدول 13. درجة IoU للنماذج المدربة مسبقًا المختارة لحالة البنجين.

| نماذج CNN | درجة التقاطع على الاتحاد (IoU) | ||||

| 6 ميزات | 8 ميزات | 10 ميزات | 12 ميزة | متوسط درجة IoU | |

| DenseNet | 0.28 | 0.32 | 0.35 | 0.38 | 0.33 |

| ResNet | 0.25 | 0.28 | 0.31 | 0.34 | 0.29 |

| EfficientNetB0 | 0.27 | 0.30 | 0.33 | 0.36 | 0.31 |

| CNN + DA | 0.33 | 0.37 | 0.40 | 0.44 | 0.38 |

الجدول 14. درجة IoU للنماذج المدربة مسبقًا المختارة لحالة الخبيث.

تحليل الأخطاء على أربع مجموعات بيانات

يمكن أيضًا تصنيف الأخطاء المحتملة من خلال التصنيفات الخاطئة من حيث معدل الخطأ، مما يعطي فهمًا واضحًا لنقاط الضعف في النموذج. الآخرون الذين لديهم معدلات خطأ أعلى نسبيًا في تجاربنا (على سبيل المثال،

الآثار الأخلاقية والعملية

يأتي استخدام نموذج CNN مع التعزيز التفاضلي (DA) للكشف عن سرطان الرئة مع بعض القضايا الأخلاقية والعملية. تعتبر خصوصية البيانات وأمانها عاملًا مهمًا يجب مراعاته حيث يجب مشاركة هذه البيانات، وتشفيرها، وما إلى ذلك. لتقليل التحيز وعدم العدالة تجاه المرضى، يتم منع التحيز من مجموعات بيانات متعددة؛ يعزز التخفيف من التحيز من خلال مجموعات بيانات متنوعة العدالة، بينما تعزز الذكاء الاصطناعي القابل للتفسير الشفافية للأطباء. تعتبر الاعتبارات الفنية هي التحقق من الأداء الفعلي للنموذج المقترح في مجموعات بيانات العالم الحقيقي المختلفة والتعامل مع الاختلافات في التصوير للحصول على تطبيقات عامة. يعد الدمج السلس في سير العمل السريري مع واجهات سهلة الاستخدام أمرًا حاسمًا للتبني. تعمل هذه الخطوات كأمور حاسمة حتى يمكن تحويل نموذج CNN + DA المدمج إلى أداة تشخيص موثوقة ودقيقة ستساعد في التشخيص المبكر وعلاج أفضل، مع محاولة منع القضايا الأخلاقية والعملية في تنفيذه.

النتائج لـ XAI باستخدام LIME

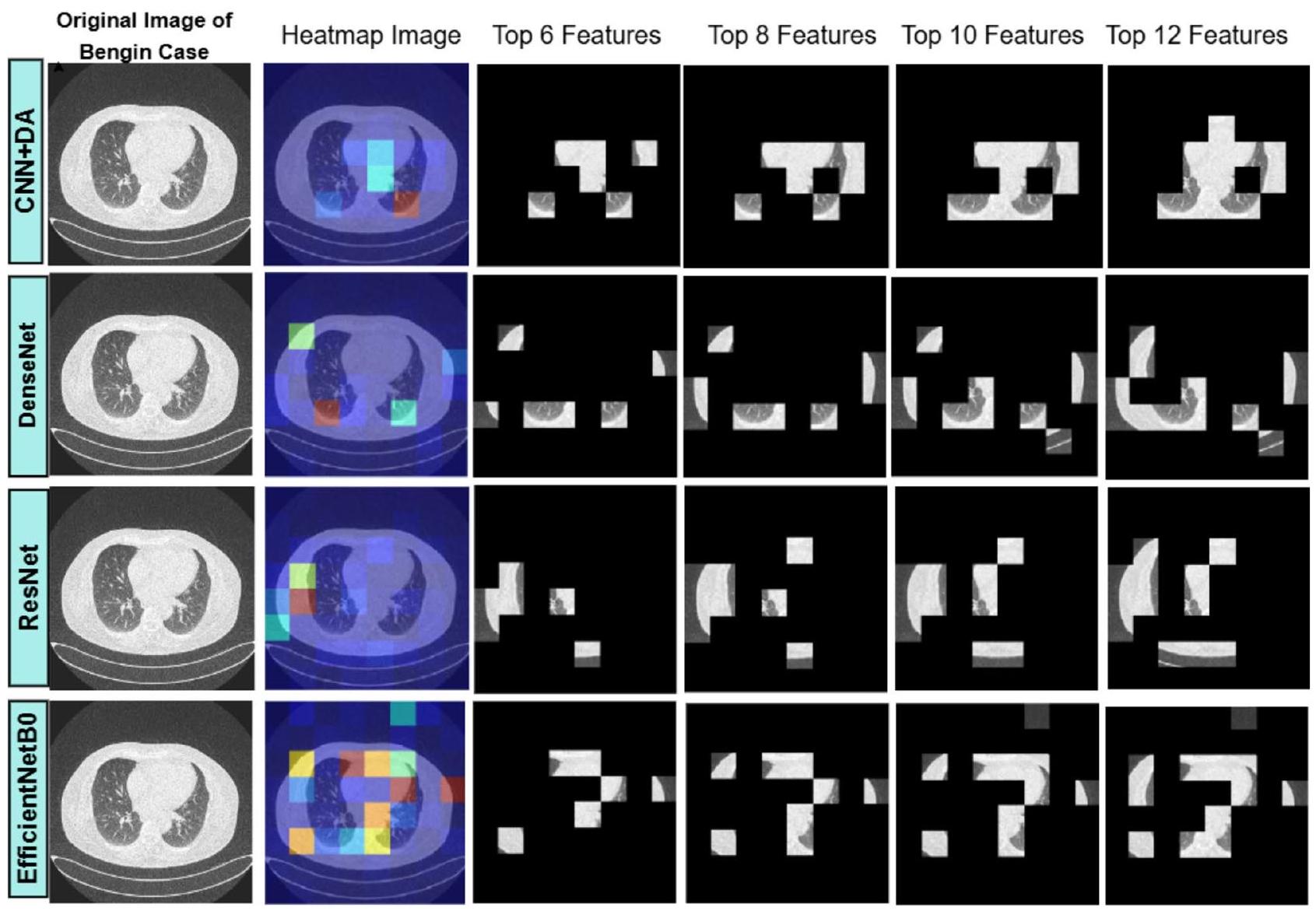

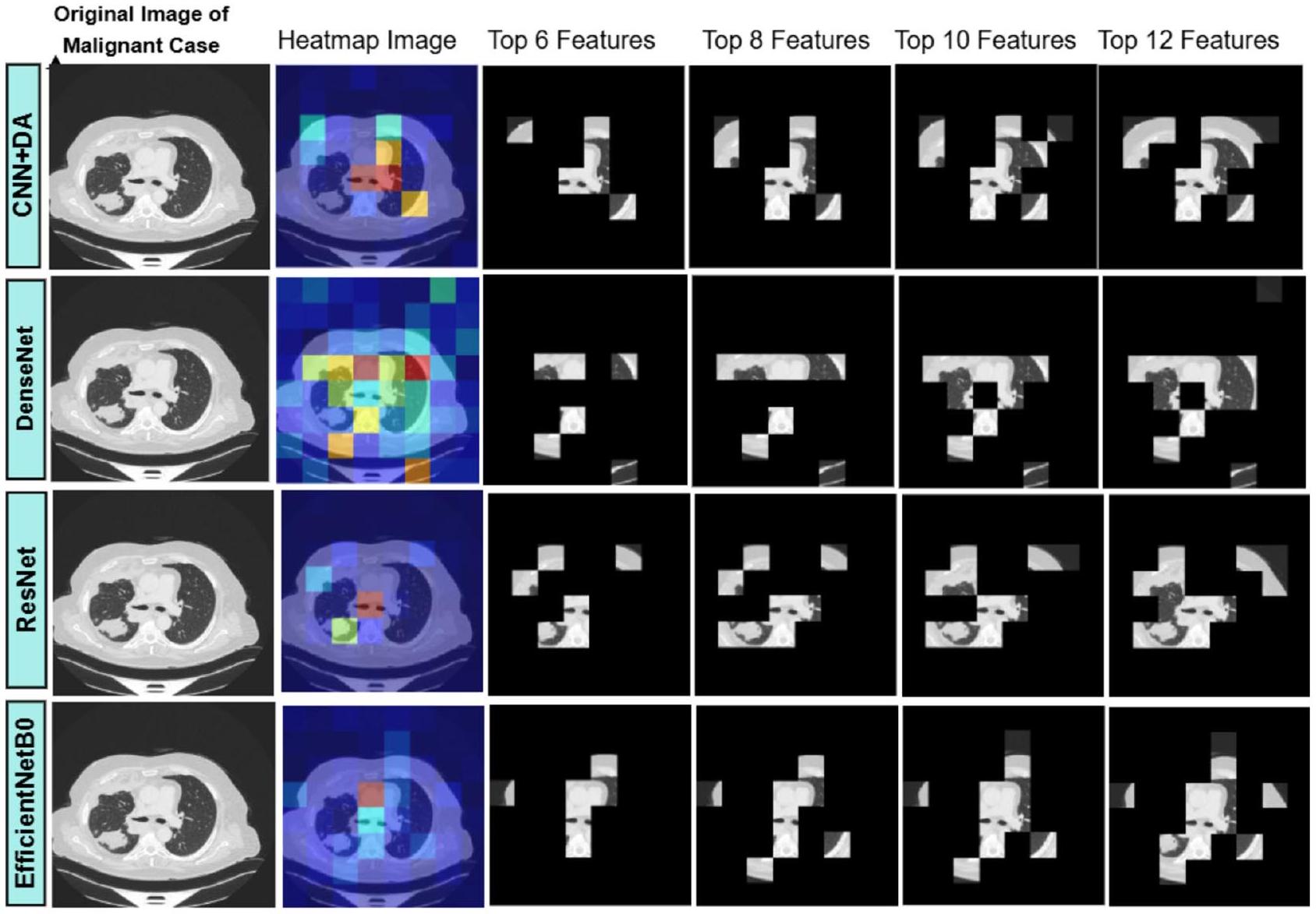

يتم تقديم تقييم نماذج الشبكة العصبية التلافيفية (CNN) باستخدام مقياس التقاطع على الاتحاد (IoU) في سياقين: حالات البنجين والخبيث. يقارن الجدول 13 (لحالة البنجين) والجدول 14 (لحالة الخبيث) أداء أربعة نماذج: DenseNet و ResNet و EfficientNetB0 و CNN + DA (CNN مع تعزيز البيانات). في الجدول 13، يحقق CNN + DA أعلى متوسط درجة IoU قدرها 0.41، مما يشير إلى أداء متفوق في تحديد الميزات ذات الصلة عبر مجموعات ميزات مختلفة (

الشكل 12. تصور تحليل صورة الرئة: الصورة الأصلية لحالة البنجين، خرائط حرارة LIME، والتغطية المعتمدة على الميزات لـ 6 و 8 و 10 و 12 ميزة مهمة.

مقارنة أداء الأعمال الحالية مع العمل المقترح

يحقق نموذج CNN مع التعزيز التفاضلي (CNN + DA) دقة رائدة تبلغ 98.78%، متفوقًا على الأساليب الحالية الرائدة في تشخيص سرطان الرئة. استكشفت الأعمال السابقة نماذج التعلم العميق وتقنيات التعزيز المختلفة، ومع ذلك لا تزال هناك فجوات في معالجة الإفراط في الذاكرة وتحقيق تعميم قوي. بشكل حاسم، أظهرت دراسة أجراها إسلام وآخرون (2024)

أظهرت الشبكات العصبية التلافيفية التقليدية (CNNs) من راينيو وكلين (2024)

أظهرت النماذج المتقدمة المجمعة والهجينة وعدًا، حيث حقق كوازار وآخرون (2023)

على النقيض من ذلك، يدمج نموذج CNN + DA التعزيز التفاضلي لتقديم تحولات متنوعة، مثل تعديل اللون والسطوع والتباين، مما يعالج مباشرة الإفراط في التكيف ويعزز التعميم. مقارنة بالأعمال الأخرى، يظهر نموذج CNN + DA دقة متفوقة، مما يثبت موثوقيته وقوته للتطبيقات السريرية في الكشف عن سرطان الرئة. يربط نهجه المبتكر الفجوات التي تركتها النماذج السابقة، مما يعزز مساهمته كأداة تشخيص جديدة وفعالة للغاية. يقارن الجدول 15 أداء الأساليب الحالية مع النهج المقترح، مسلطًا الضوء على التحسينات في الدقة أو الكفاءة أو غيرها من المقاييس الرئيسية.

القيود

مجموعة البيانات الأساسية المستخدمة (IQ-OTH/NCCD)، التي تتكون من 1,097 صورة فقط، صغيرة نسبيًا لتدريب نماذج التعلم العميق، مما يحد من قدرة النموذج على التعميم عبر طيف أوسع من تنوعات سرطان الرئة وخصائص المرضى. توزيع الفئات في هذه المجموعة غير متوازن أيضًا، مع وجود حالات خبيثة أكثر من الحالات الحميدة أو العادية، مما قد يؤدي إلى تحيز النموذج نحو الفئة الغالبة. بينما نموذج CNN + DA

الشكل 13. تصور تحليل صورة الرئة: الصورة الأصلية لحالة خبيثة، خرائط حرارة LIME، وقناع قائم على الميزات لـ 6 و 8 و 10 و 12 ميزة مهمة.

| المؤلف(ون) | النموذج المقترح | الدقة |

| إسلام وآخرون (2024)

|

الشبكات التنافسية التوليدية (GANs) والترميز التلقائي التبايني (VAEs) | 94% |

| سها وآخرون (2024)

|

VER-Net | 91% |

| راينيو وكلين (2024)

|

شبكة الأعصاب التلافيفية (CNN) | 92.6% |

| كوكريجا وساباروال (2024)

|

شبكة الأعصاب التلافيفية (CNN) | 96.11% |

| تشانغ وآخرون (2024)

|

دمج DenseNet-CNN | 96% |

| غاي وآخرون (2023)

|

شبكات الأعصاب التلافيفية (CNNs) ومحولات الرؤية (ViTs) | 93.4% |

| كوازار وآخرون (2023)

|

نموذج تجميعي (BEiT، DenseNet، CNN تسلسلي مع طرق تجميع) | 96.34% |

| رازآ وآخرون (2023)

|

Lung-EffNet (EfficientNet مع طبقات علوية معدلة) | 96.10% |

| غوتام وآخرون (2023)

|

تجميع (ResNet-152، DenseNet-169، EfficientNet-B7 مع تحسين الوزن) | 97.23% |

| دريستاس وترغكا (2022)

|

غابة الدوران | 97.1% |

| تسوا وآخرون (2021)

|

تعزيز التدرج المتطرف (XGBoost) | 92% |

| عملنا | CNN مع DA | 98.78% |

الجدول 15. مقارنة أداء الأعمال الحالية مع العمل المقترح.

يؤدي بشكل جيد على مجموعة البيانات المسيطر عليها، لكن أداؤه في البيئات السريرية الواقعية، التي تتضمن بروتوكولات تصوير متنوعة، وخصائص المرضى، والآثار المحتملة، لم يتم التحقق منه بعد. قد يواجه النموذج صعوبة في التعامل مع التغيرات غير المرئية في ظروف التصوير الشائعة في الإعدادات السريرية. بالإضافة إلى ذلك، فإن دمج التعزيز التفاضلي (DA) أثناء التدريب يقدم عبئًا حسابيًا إضافيًا، مما يزيد من وقت التدريب ومتطلبات الموارد، مما قد يكون تحديًا في البيئات ذات الموارد المحدودة. أخيرًا، يعتمد أداء النموذج بشكل كبير على جودة بيانات الإدخال؛ الصور المزعجة أو ذات الجودة المنخفضة قد تؤدي إلى تصنيفات خاطئة، خاصة عند التمييز بين الأورام الحميدة والخبيثة.

الخاتمة

يظل سرطان الرئة تحديًا صحيًا عالميًا كبيرًا، يتطلب حلولًا مبتكرة لتحسين دقة التشخيص. تتناول هذه الدراسة المشكلة المستمرة للإفراط في التكيف في نماذج التعلم العميق، مما يعيق قدرتها على التعميم عبر مجموعات بيانات متنوعة. كجهد لتحسين جودة نماذج اكتشاف سرطان الرئة، تسعى هذه البحث إلى تصميم طريقة جديدة تتضمن دمج تقنية التعزيز التفاضلي مع شبكة الأعصاب التلافيفية.

تم إثبات فعالية نموذج CNN + DA المقترح، حيث حقق دقة توقع

كما هو موضح في هذا البحث، فإن دمج التعزيز التفاضلي مع الشبكات العصبية التلافيفية هو حل جيد للمشكلات الموجودة في النماذج التقليدية. وبالتالي، تشير الاستنتاجات إلى الحاجة إلى تطوير نماذج لا تحل المشكلات بدقة فحسب، بل تكون أيضًا محصنة ضد الاضطرابات المعادية ويمكن توسيعها بسهولة لمعالجة مجموعة أوسع من المشكلات. يمكن أن تستكشف الأعمال المستقبلية المزيد من قابلية تكيف هذا النهج مع مجالات ومجموعات بيانات أخرى، مما يوسع من فائدته في تعزيز أبحاث التعلم العميق للمهام التشخيصية المعقدة.

توفر البيانات

البيانات المستخدمة لدعم نتائج مجموعة البيانات الجديدة التي تم إنشاؤها، هذه الدراسة متاحة من المؤلف المراسل عند الطلب.

تاريخ الاستلام: 24 سبتمبر 2024؛ تاريخ القبول: 14 أبريل 2025

تم النشر عبر الإنترنت: 05 مايو 2025

تم النشر عبر الإنترنت: 05 مايو 2025

References

- Jaksik, R., Szumała, K., Dinh, K. N. & Śmieja, J. Multiomics-Based feature extraction and selection for the prediction of lung Cancer survival. Int. J. Mol. Sci. 25 (7 (March 25), 3661. https://doi.org/10.3390/ijms25073661 (2024).

- Lasrado, S. A. & Babu, G. N. K. S. Fused feature reduction and selection system for early lung Cancer detection (April 4). https:// doi.org/10.1109/iconstem60960.2024.10568801 (2024).

- Aggarwal, P., Marwah, N., Kaur, R. & Mittal, A. Lung Cancer Survival Prognosis Using a Two-Stage Modeling Approach. Multimedia Tools and Applications (January 31). https://doi.org/10.1007/s11042-024-18280-2 (2024).

- Hussain, L., Almaraashi, M. S., Aziz, W., Habib, N. & Abbasi, S. U. R. S. Machine learning-based lungs cancer detection using reconstruction independent component analysis and sparse filter features. Waves Random Complex. Media 34, 226-251. https://d oi.org/10.1080/17455030.2021.1905912 (2021).

- Mamun, M., Mahmud, M. I. & Meherin, M. & Abdelgawad, A. LCDctCNN: lung Cancer diagnosis of CT scan images using CNN based model. ArXiv (Cornell University). (2023). https://doi.org/10.48550/arxiv.2304.04814

- Moitra, D. & Mandal, R. K. Classification of non-small cell lung cancer using one-dimensional convolutional neural network. Expert Syst. Appl. 159, 113564 (2020).

- Perez, G. & Arbelaez, P. Automated Lung cancer Diagnosis Using three-dimensional Convolutional Neural Networks, 1803-1815 (Medical & Biological Engineering & Computing, 2020).

- Moitra, D. & Mandal, R. K. Automated AJCC staging of non-small cell lung cancer (NSCLC) using deep convolutional neural network (CNN) and recurrent neural network (RNN). Health Inform. Sci. Syst. 7, 1-12 (2019).

- Doppalapudi, S., Qiu, R. G. & Badr, Y. Lung cancer survival period prediction and understanding: deep learning approaches. Int. J. Med. Informatics. 148, 104371 (2021).

- Faruqui, N. et al. LungNet: A hybrid deep-CNN model for lung cancer diagnosis using CT and wearable sensor-based medical IoT data. Comput. Biol. Med. 139, 104961. (2021).

- Aboamer, M. A. et al. An investigation in analyzing the food quality well-being for lung cancer using blockchain through cnn. J. Food Qual. (2022).

- Kirienko, M. et al. Convolutional neural networks promising in lung cancer T-parameter assessment on baseline FDG-PET/CT. Contrast Media Mol. Imaging (2018).

- Lin, C. J., Jeng, S. Y. & Chen, M. K. Using 2D CNN with Taguchi parametric optimization for lung cancer recognition from CT images. Appl. Sci. 10 (7), 2591 (2020).

- Moitra, D. & Mandal, R. K. Prediction of non-small cell lung cancer histology by a deep ensemble of convolutional and bidirectional recurrent neural network. J. Digit. Imaging. 33, 895-902 (2020).

- Zhan, X. et al. A convolutional neural network-based intelligent medical system with sensors for assistive diagnosis and decisionmaking in non-small cell lung cancer. Sensors, 21(23), p.7996. (2021).

- Islam, Tauhidul, M. S., Hafiz, J. R., Jim & Mridha, M. F. Md. Mohsin Kabir, and A systematic review of deep learning data augmentation in medical imaging: Recent advances and future research directions. Healthcare Analytics 5June 1, : 100340. (2024). https://doi.org/10.1016/j.health.2024.100340

- Saha, A. et al. VER-Net: A hybrid transfer learning model for lung cancer detection using CT scan images. BMC Med. Imaging 24. https://doi.org/10.1186/s12880-024-01238-z (2024).

- Rainio, O. & Klén, R. Comparison of simple augmentation transformations for a convolutional neural network classifying medical images. Signal Image Video Process. https://doi.org/10.1007/s11760-024-02998-5 (2024).

- Kukreja, S. & Sabharwal, M. An effective lung Cancer diagnosis model using the CNN algorithm. EAI Endorsed Trans. Pervasive Health Technol. 10 https://doi.org/10.4108/eetpht.10.6805 (2024).

- Zhang, C. et al. Enhancing lung cancer diagnosis with data fusion and mobile edge computing using DenseNet and CNN. J. Cloud Comput. Adv. Syst. Appl. 13. https://doi.org/10.1186/s13677-024-00597-w (2024).

- Gai, L., Xing, M., Chen, W., Zhang, Y. & Qiao, X. Comparing CNN-based and transformer-based models for identifying lung cancer: which is more effective? Multim. Tools Appl. 83, 59253-59269. https://doi.org/10.1007/s11042-023-17644-4 (2023).

- Quasar, S. et al. Ensemble methods for computed tomography scan images to improve lung cancer detection and classification. Multimedia Tools Appl. 83 (17), 52867-52897. https://doi.org/10.1007/s11042-023-17616-8 (2023).

- Raza, R. et al. Lung-EffNet: lung cancer classification using EfficientNet from CT-scan images. Eng. Appl. Artif. Intell. 126 (1), 106902. https://doi.org/10.1016/j.engappai.2023.106902 (2023).

- Gautam, N., Basu, A. & Sarkar, R. Lung cancer detection from thoracic CT scans using an ensemble of deep learning models. Neural Comput. Appl. 36, 2459-2477. https://doi.org/10.1007/s00521-023-09130-7 (2023).

- Dritsas, E. & Trigka, M. Lung cancer risk prediction with machine learning models. Big Data Cogn. Comput. 6 (4), 139. (2022).

- Tsou, P. H. et al. Exploring volatile organic compounds in breath for high-accuracy prediction of lung cancer. Cancers 13 (6), 1431 (2021).

- Muniasamy, A., Alquhtani, S. A. S., Bilfaqih, S. M., Balaji, P. & Karunakaran, G. Lung cancer histopathology image classification using transfer learning with Convolution neural network model. Technol. Health Care November. 9, 1-12. https://doi.org/10.3233 /thc-231029 (2023).

- Jothi, J., Sathiya & Chinnadurai, M. A combined deep CNN with a chimp optimization approach for lung cancer diagnosis. J. Intell. Fuzzy Syst. 46 (2), 4681-4696. https://doi.org/10.3233/jifs-237339 (2024).

- Garcea, F., Serra, A., Lamberti, F. & Morra, L. Data augmentation for medical imaging: A systematic literature review. Comput. Biol. Med. 152 (January 1), 106391. https://doi.org/10.1016/j.compbiomed.2022.106391 (2023).

- Mathworks Understand Network Predictions Using LIME – MATLAB & Simulink – MathWorks India-in.mathworks.com. (2024). https://in.mathworks.com/help/deeplearning/ug/understand-network-predictions-using-lime.html. Accessed 28 May 2024.

- Kumar, S. V. & Kondaveeti, H. K. Towards transparency in AI: explainable bird species image classification for ecological research. Ecol. Ind. 169, 112886. https://doi.org/10.1016/j.ecolind.2024.112886 (2024).

- Ribeiro, M. T., Singh, S. & Guestrin, C. Why should i trust you? Explaining the predictions of any classifier. In Proceedings of the 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining, 1135-1144. (2016).

- Zafar, M. R. & Khan, N. Deterministic local interpretable model-agnostic explanations for stable explainability. Mach. Learn. Knowl. Extr. 3 (3), 525-541 (2021).

- Hamdalla, F. The & IQ-OTH/NCCD Lung Cancer Dataset. Kaggle. (2020). https://www.kaggle.com/datasets/hamdallak/the-iqoth nccd-lung-cancer-dataset. Accessed 3 Jan 2023.

- Lung and Colon Cancer Histopathological Images. https://www.kaggle.com/datasets/andrewmvd/lung-and-colon-cancer-histopa thological-images. Accessed 7 Dec 2024.

- Clark, K. et al. The Cancer imaging archive (TCIA): maintaining and operating a public information repository. J. Digit. Imaging. 26, 1045-1057. https://doi.org/10.1007/s10278-013-9622-7 (2013).

- Team, N. L. S. T. R. The National lung screening trial: overview and study design. Radiology 258 (1), 243-253. https://doi.org/10.1 148/radiol. 10091808 (2011).

- Tirumanadham, N. Improving predictive performance in e-learning through hybrid 2-tier feature selection and hyper parameteroptimized 3-tier ensemble modeling. Int. J. Inf. Tecnol. 16, 5429-5456. https://doi.org/10.1007/s41870-024-02038-y (2024).

الشكر والتقدير

يقول المؤلفون شكرًا لدعمهم في إكمال هذا العمل البحثي.

مساهمات المؤلفين

راجع جميع المؤلفين المخطوطة.

التمويل

أعلن المؤلف أنه لم يتم تلقي أي تمويل لهذا البحث والنشر.

الإعلانات

المصالح المتنافسة

يعلن المؤلفون عدم وجود مصالح متنافسة.

الموافقة الأخلاقية

لا يحتوي هذا المقال على أي دراسات مع مشاركين بشريين أو حيوانات أجراها المؤلف.

معلومات إضافية

يجب توجيه المراسلات والطلبات للحصول على المواد إلى V.S.

معلومات إعادة الطبع والأذونات متاحة علىwww.nature.com/reprints.

ملاحظة الناشر تظل Springer Nature محايدة فيما يتعلق بالمطالبات القضائية في الخرائط المنشورة والانتماءات المؤسسية.

معلومات إعادة الطبع والأذونات متاحة علىwww.nature.com/reprints.

ملاحظة الناشر تظل Springer Nature محايدة فيما يتعلق بالمطالبات القضائية في الخرائط المنشورة والانتماءات المؤسسية.

الوصول المفتوح هذا المقال مرخص بموجب ترخيص المشاع الإبداعي النسب-غير التجاري-بدون اشتقاقات 4.0 دولي، الذي يسمح بأي استخدام غير تجاري، ومشاركة، وتوزيع وإعادة إنتاج في أي وسيلة أو صيغة، طالما أنك تعطي الائتمان المناسب للمؤلف(ين) الأصليين والمصدر، وتوفر رابطًا إلى ترخيص المشاع الإبداعي، وتوضح إذا قمت بتعديل المادة المرخصة. ليس لديك إذن بموجب هذا الترخيص لمشاركة المواد المعدلة المشتقة من هذا المقال أو أجزاء منه. الصور أو المواد الأخرى من طرف ثالث في هذا المقال مشمولة في ترخيص المشاع الإبداعي للمقال، ما لم يُذكر خلاف ذلك في سطر ائتمان للمادة. إذا لم تكن المادة مشمولة في ترخيص المشاع الإبداعي للمقال واستخدامك المقصود غير مسموح به بموجب اللوائح القانونية أو يتجاوز الاستخدام المسموح به، ستحتاج إلى الحصول على إذن مباشرة من صاحب حقوق الطبع والنشر. لعرض نسخة من هذا الترخيص، قم بزيارةhttp://creativecommo ns.org/licenses/by-nc-nd/4.0/.

© المؤلف(ون) 2025

© المؤلف(ون) 2025

قسم علوم الحاسوب والهندسة، UCEK، جامعة جواهر لال نهرو التكنولوجية كاكينادا، كاكينادا، أندرا براديش-533003، الهند. قسم علوم الحاسوب والهندسة، معهد أمارا ساي للعلوم والتكنولوجيا، باتينابادو، باريتالا، أندرا براديش-521180، الهند. البريد الإلكتروني:shariff.v@gmail.com

Journal: Scientific Reports, Volume: 15, Issue: 1

DOI: https://doi.org/10.1038/s41598-025-98731-4

PMID: https://pubmed.ncbi.nlm.nih.gov/40325128

Publication Date: 2025-05-05

DOI: https://doi.org/10.1038/s41598-025-98731-4

PMID: https://pubmed.ncbi.nlm.nih.gov/40325128

Publication Date: 2025-05-05

OPEN

Optimizing non small cell lung cancer detection with convolutional neural networks and differential augmentation

Lung cancer remains one of the leading causes of cancer-related deaths worldwide, with early detection being critical to improving patient outcomes. Recent advancements in deep learning have shown promise in enhancing diagnostic accuracy, particularly through the use of Convolutional Neural Networks (CNNs). This study proposes the integration of Differential Augmentation (DA) with CNNs to address the critical challenge of memory overfitting, a limitation that hampers the generalization of models to unseen data. By introducing targeted augmentation strategies, such as adjustments in hue, brightness, saturation, and contrast, the CNN + DA model diversifies training data and enhances its robustness. The research utilized multiple datasets, including the IQ-OTH/NCCD dataset, to evaluate the proposed model against existing state-of-the-art methods. Hyperparameter tuning was performed using Random Search to optimize parameters, further improving performance. The results revealed that the CNN + DA model achieved an accuracy of 98.78%, outperforming advanced models like DenseNet, ResNet, and EfficientNetB0, as well as hybrid approaches including ensemble models. Additionally, statistical analyses, including Tukey’s HSD post-hoc tests, confirmed the significance of the model’s superior performance. These findings suggest that the CNN + DA model effectively addresses the limitations of prior works by reducing overfitting and ensuring reliable generalization across diverse datasets. The study concludes that the novel CNN + DA architecture provides a robust, accurate, and computationally efficient framework for lung cancer detection, positioning it as a valuable tool for clinical applications and paving the way for future research in medical image diagnostics.

Keywords Lung Cancer prediction, Convolutional neural networks, Differential augmentation (DA), Memorization overfitting, Medical imaging, Diagnostic robustness, EfficientNetB0

Innovative lung cancer prognosis relies on cutting-edge machine learning algorithms applied to a wealth of patient data. By incorporating various elements like imaging, genetics, and medical records, this model demonstrates remarkable precision in anticipating potential occurrences. Optimizing early intervention and customizing treatments, it holds the potential to elevate patient outcomes in the challenging realm of lung cancer. Early detection is vital for successful treatment

Developing a cutting-edge 1D CNN model for NSCLC staging and grading, leveraging insights from the latest TCIA NSCLC Radio genomics Collection. Hybrid MSER-SURF model integrates tumor features with clinical data for comprehensive analysis

Leveraging CNN’s disease detection, this research explores the fusion of blockchain for secure data in enhancing food safety and lung cancer prediction

Introducing an innovative approach, employs a 2D CNN with Taguchi optimization for automated lung cancer recognition from CT images, as outlined in reference

The research structure unfolds with Section 1delvering into the introduction. Section “Literature review” navigates the scholarly landscape in the literature review. Section “Proposed methodology” intricately unfolds the intricacies of the proposed methodology, offering a detailed roadmap. Section “Result and discussion” unveils the results, igniting insightful discussions around their implications. The “conclusion” section encapsulates profound insights, culminating in a comprehensive closure that synthesizes the study’s findings and underscores their significance in the broader context of the research domain.

Literature review

In 2024, Islam et al.

In 2024, Saha et al.

In 2024, Riku Klén et al.

In 2024, S. Kukreja and M. Sabharwa et al.

In 2024, Zhang et al.

introduced an enhanced predictive sparse decomposition (PSD) method to acquire sparse feature from medical images, which also promoted the improvement of the model.

introduced an enhanced predictive sparse decomposition (PSD) method to acquire sparse feature from medical images, which also promoted the improvement of the model.

In 2023, Lulu Gai et al.

In 2023, Syeda Reeha et al.

In view of the available data and resources, this study provides a reasonable response by demonstrating the potential of ensemble methods as a potent tool for enhancing the precision and efficiency of lung cancer diagnosis.

In 2023, R. Raza et al.

In 2023, Nandita Gautam et al.

In 2022, Dritsas and Trigka et al.

In 2021, Tsou et al.

While prior studies focus on augmentation and model optimization, this research uniquely addresses memory overfitting using Differential Augmentation, demonstrating superior performance in lung cancer detection.

Problem statement

The research problem focuses on enhancing the accuracy and efficiency of lung cancer detection using deep learning techniques. Although improved, current models struggle with generalisation, data variability, and interpretability across imaging modalities. Optimising model performance, especially early detection, while addressing dataset variety and augmentation limits is difficult.

Generalizability challenges

Although the CNN + DA model performs well on the controlled dataset, its generalizability to real-world scenarios remains to be validated. Challenges include unseen variations in imaging protocols, patient demographics, and artifacts in clinical datasets. Future studies will explore strategies such as transfer learning and fine-tuning on multi-center datasets to mitigate these challenges and ensure applicability in diverse clinical settings. To increase medical image analysis models’ resilience, scalability, and clinical utility, data fusion, mobile edge computing, and ensemble methods must be explored. Table 1 summarizes the objectives and limitations of previous research, highlighting both their goals and shortcomings.

Research gap

While deep learning has revolutionized numerous domains, including medical imaging for lung cancer detection, a persistent research gap remains concerning memory overfitting. Despite various efforts to address general overfitting, the nuanced challenge of models memorizing training data rather than learning to generalize has not been comprehensively addressed. Many existing solutions focus on broader overfitting issues, often overlooking the subtle yet critical aspect of memory overfitting. This gap underscores the need for dedicated research into strategies and methodologies to combat memory overfitting, ensuring that models remain robust and reliable, especially in critical applications like medical diagnostics.

| Author | Method | Aim | Drawback | ||

| Islam et al.

|