DOI: https://doi.org/10.1186/s12880-024-01292-7

PMID: https://pubmed.ncbi.nlm.nih.gov/38734629

تاريخ النشر: 2024-05-11

تعزيز اكتشاف أورام الدماغ في صور الرنين المغناطيسي من خلال الذكاء الاصطناعي القابل للتفسير باستخدام Grad-CAM مع Resnet 50

الملخص

تتناول هذه الدراسة التحدي الحاسم في الكشف عن أورام الدماغ باستخدام صور الرنين المغناطيسي، وهي مهمة محورية في التشخيص الطبي تتطلب دقة عالية وقابلية للتفسير. بينما أظهر التعلم العميق نجاحًا ملحوظًا في تحليل الصور الطبية، لا يزال هناك حاجة كبيرة لنماذج ليست دقيقة فحسب، بل قابلة للتفسير أيضًا لمهنيي الرعاية الصحية. غالبًا ما تعمل المنهجيات الحالية، التي تعتمد بشكل أساسي على التعلم العميق، كصناديق سوداء، مما يوفر القليل من الرؤية في عملية اتخاذ القرار الخاصة بها. تقدم هذه البحث نهجًا متكاملًا باستخدام ResNet50، وهو نموذج تعلم عميق، مقترنًا بتخطيط تنشيط الفئة المعتمد على التدرج (Grad-CAM) لتقديم إطار عمل شفاف وقابل للتفسير للكشف عن أورام الدماغ. استخدمنا مجموعة بيانات من صور الرنين المغناطيسي، تم تحسينها من خلال زيادة البيانات، لتدريب نموذجنا والتحقق من صحته. تظهر النتائج تحسنًا كبيرًا في أداء النموذج، مع دقة اختبار تبلغ

المقدمة

، مما يسهل التمييز بين الأنسجة السليمة والمرضية. إنه أداة حيوية في تقييم موقع الورم وحجمه وتأثيره المحتمل على الهياكل الدماغية المجاورة، وهو أمر حاسم في تخطيط العلاج. ومع ذلك، فإن تفسير صور الرنين المغناطيسي يعتمد بشكل كبير على خبرة أطباء الأشعة وقد يكون مستهلكًا للوقت، مما يبرز الحاجة إلى تقنيات مساعدة لتحسين دقة وكفاءة التشخيص.

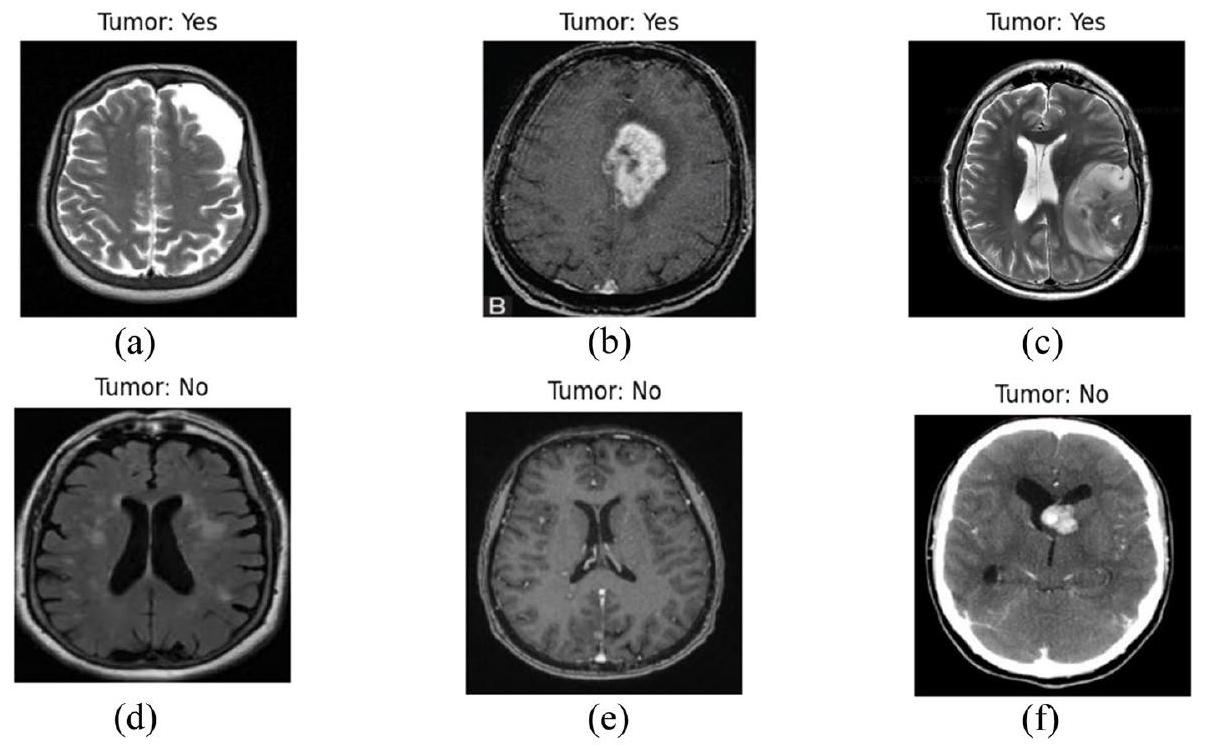

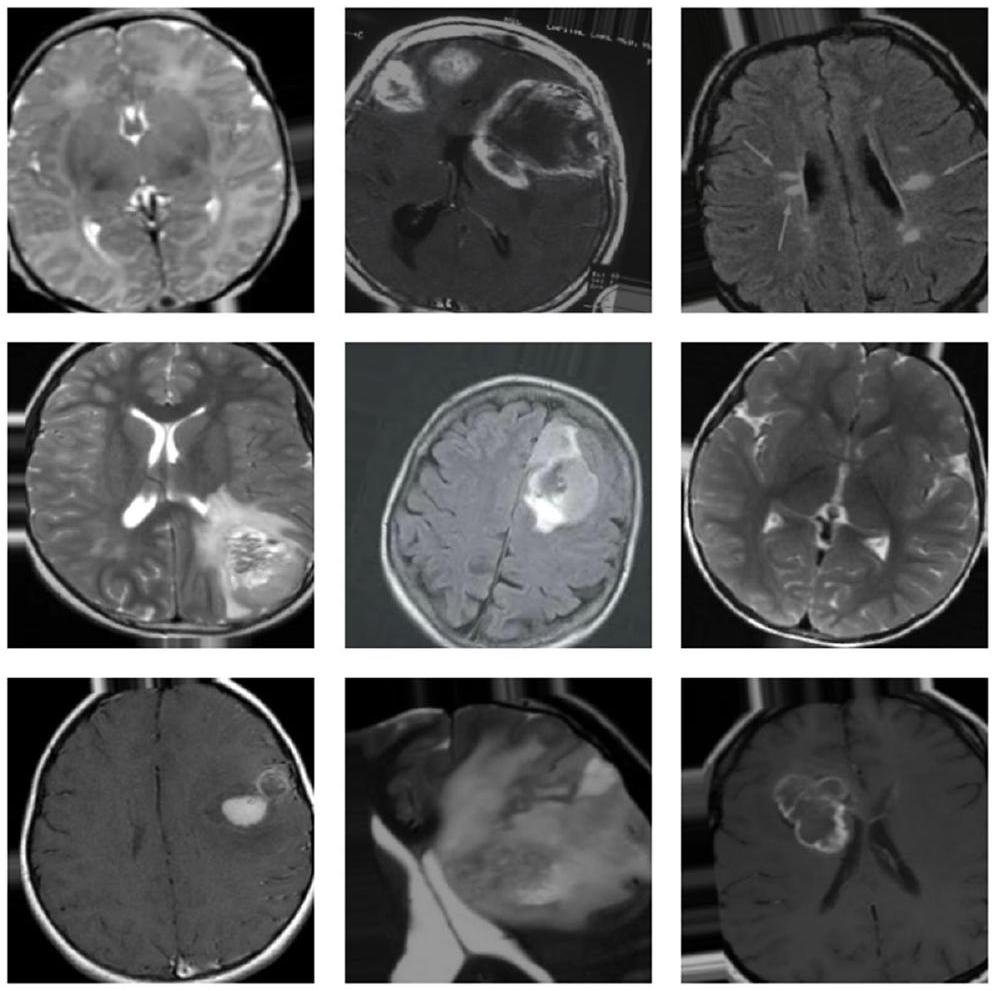

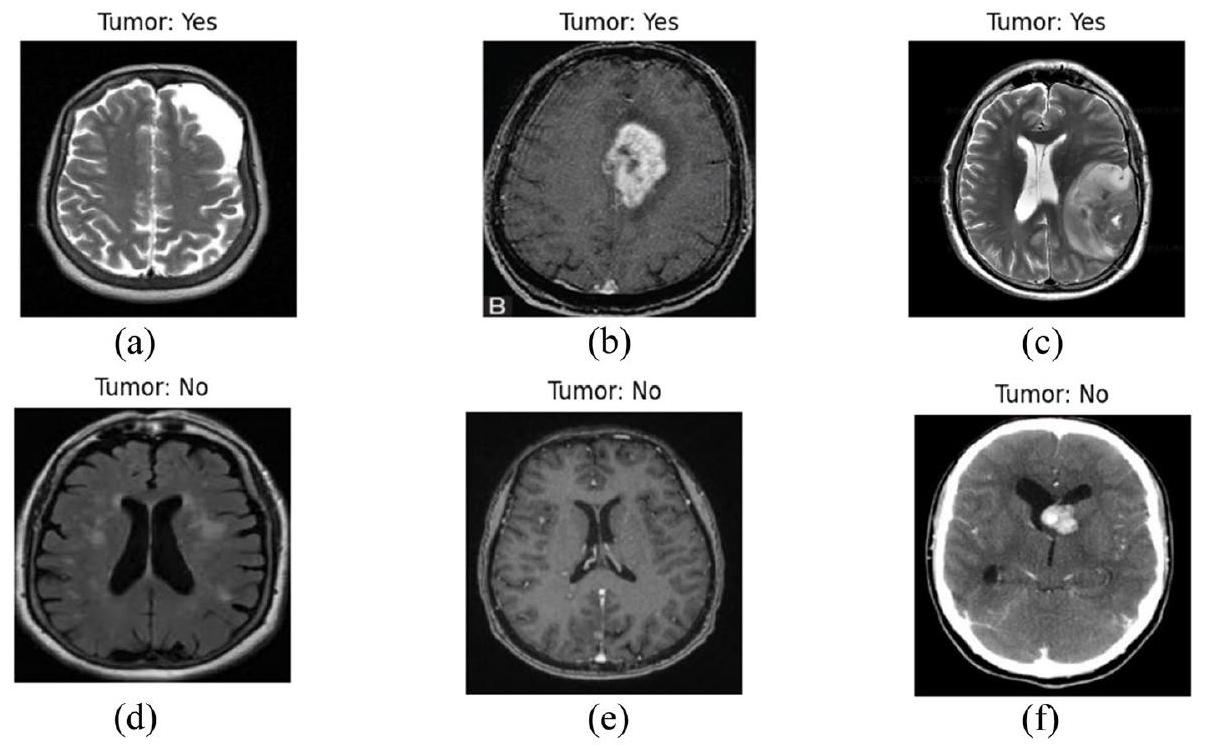

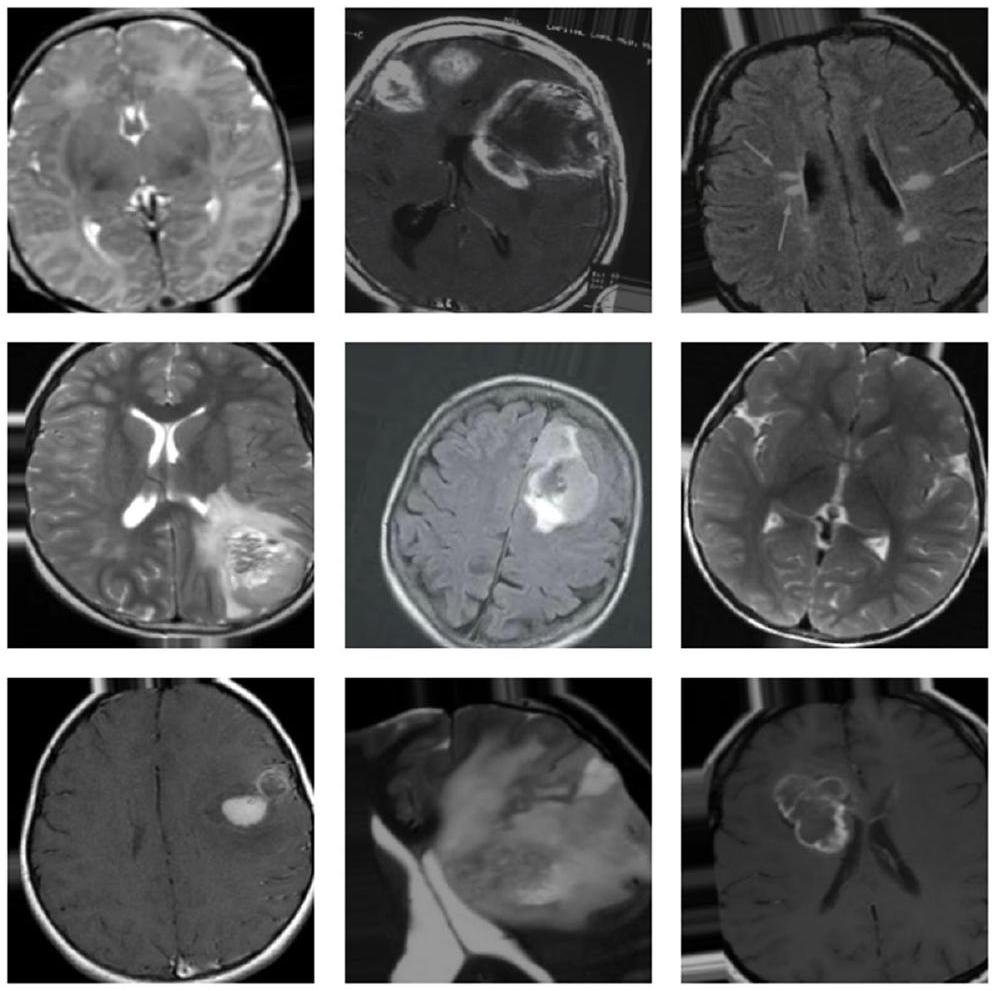

لقد أحدث التعلم العميق، وهو فرع من فروع التعلم الآلي، ثورة في مجال تحليل الصور الطبية، حيث قدم تحسينات كبيرة في الكشف وتصنيف الأمراض المختلفة [3]. في كشف أورام الدماغ، يمكن لخوارزميات التعلم العميق تحليل بيانات الرنين المغناطيسي المعقدة، وتحديد الأنماط التي لا يمكن رؤيتها بالعين المجردة، والتعلم من هذه الأنماط لإجراء تنبؤات دقيقة. لقد أظهرت هذه الخوارزميات، وخاصة الشبكات العصبية التلافيفية (CNNs)، براعتها في تعزيز دقة وسرعة تشخيص أورام الدماغ، مما يقلل من الاعتماد على التفسير البشري ويقلل من الأخطاء التشخيصية. في الشكل 1، تظهر بعض الحالات البصرية لأورام الدماغ من مجموعة البيانات.

الهدف الرئيسي من هذه البحث هو استغلال قدرات التعلم العميق، وبشكل خاص بنية ResNet50، بالتزامن مع تخطيط تنشيط الفئة المعتمد على التدرج (Grad-CAM)، لتعزيز الكشف وقابلية تفسير تشخيصات أورام الدماغ من صور الرنين المغناطيسي. تهدف هذه الدراسة إلى:

- تنفيذ نموذج تعلم عميق يوفر دقة متقدمة في الكشف عن أورام الدماغ من صور الرنين المغناطيسي.

- دمج Grad-CAM مع نموذج التعلم العميق لتقديم تفسيرات بصرية لتنبؤات النموذج، مما يعزز قابلية التفسير وموثوقية نظام الذكاء الاصطناعي.

- تقييم أداء النموذج باستخدام مجموعة شاملة من المقاييس، لضمان موثوقيته وقابليته للتطبيق في بيئة سريرية.

- المساهمة في مجموعة المعرفة من خلال تقديم رؤى حول كيفية جعل الذكاء الاصطناعي أكثر شفافية ومساعدة في التشخيص الطبي، خاصة في سياق كشف أورام الدماغ.

الأعمال ذات الصلة

لقد أحدث التعلم العميق، وخاصة الشبكات العصبية التلافيفية (CNNs)، ثورة في مجال التصوير الطبي. على عكس التعلم الآلي التقليدي، يلغي التعلم العميق الحاجة إلى استخراج الميزات يدويًا، مما يسمح للنموذج بتعلم الميزات مباشرة من البيانات. كانت هذه القدرة تحولية بشكل خاص في كشف أورام الدماغ [5]، حيث تتطلب الطبيعة المعقدة والمتنوعة للأورام تحليلًا دقيقًا.

أظهرت الدراسات التي تستخدم التعلم العميق لكشف أورام الدماغ نجاحًا ملحوظًا. على سبيل المثال، تم استخدام الشبكات العصبية التلافيفية بشكل واسع لتصنيف وتقسيم أورام الدماغ في صور الرنين المغناطيسي [6، 7]، محققة تحسينات كبيرة في الدقة مقارنة بالمنهجيات السابقة. كما استكشفت بعض الأبحاث استخدام التعلم الانتقالي، حيث يتم ضبط النماذج المدربة مسبقًا على مجموعات بيانات كبيرة لمهام التصوير الطبي المحددة، مما يحقق نتائج مثيرة للإعجاب حتى مع مجموعات بيانات صغيرة نسبيًا [8].

على الرغم من هذه التقدمات، فإن أحد القيود الرئيسية لنماذج التعلم العميق في التصوير الطبي، وخاصة في كشف أورام الدماغ، هو طبيعتها “الصندوق الأسود”. تجعل الهياكل المعقدة لهذه النماذج من الصعب فهم الأسباب وراء تنبؤاتها، وهو ما يمثل حاجزًا كبيرًا لقبولها وتنفيذها في البيئات السريرية [9]. في الجدول 1، تم تقديم ملخص لدراسات مختلفة.

علاوة على ذلك، تركز العديد من الدراسات الحالية بشكل أساسي على دقة النموذج، وغالبًا ما تتجاهل جانب القابلية للتعميم. من الضروري أن لا تؤدي النماذج أداءً جيدًا فقط على البيانات التي تم تدريبها عليها، بل يجب أن تحافظ أيضًا على أدائها عبر مجموعات بيانات متنوعة وغير مرئية.

تؤثر على قرار النموذج، مما يوفر نافذة على “عملية تفكير” النموذج. لا يهدف هذا النهج فقط إلى تعزيز قابلية تفسير النموذج، بل يسعى أيضًا لبناء الثقة بين الأطباء من خلال توفير أداة ذكاء اصطناعي شفافة يمكن أن تساعد في اتخاذ القرارات التشخيصية [20].

المنهجية

وصف مجموعة البيانات

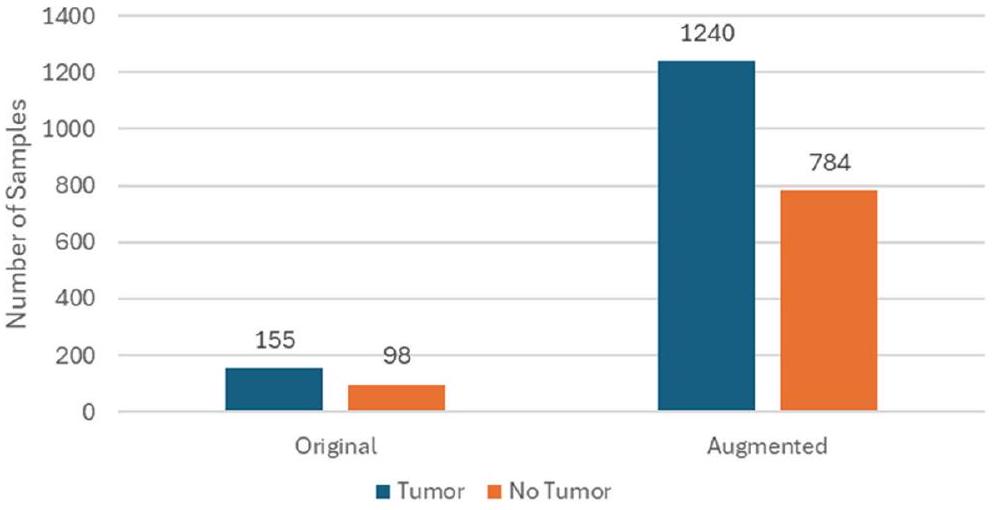

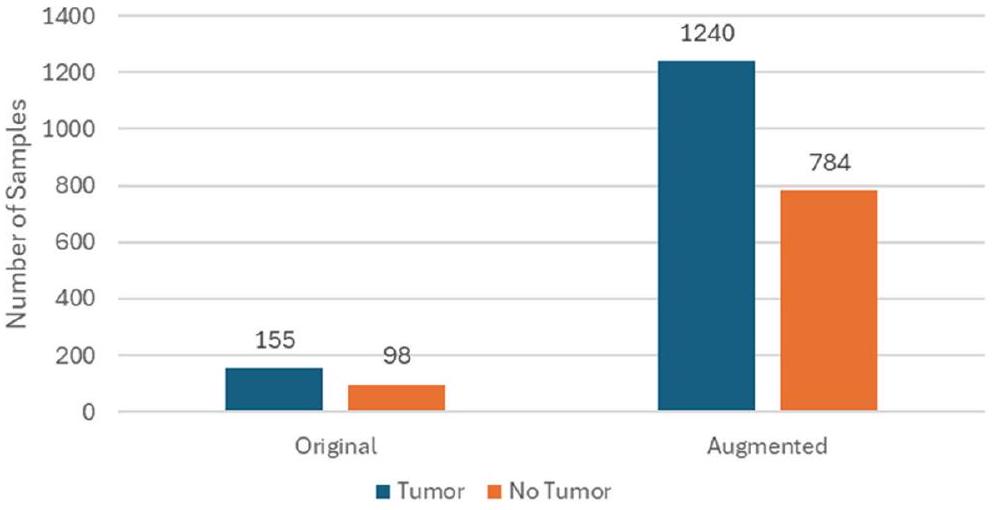

تقدم الشكل 4 توزيع البيانات.

تتضمن مجموعة البيانات مجموعة متنوعة من الصور لتشمل أنواع وأحجام ومواقع الأورام المختلفة، بهدف تعزيز قدرة النموذج على التعميم. تحتوي على آلاف الصور، مقسمة إلى مجموعات التدريب والتحقق والاختبار. تُستخدم مجموعة التدريب لتدريب النموذج، ومجموعة التحقق لضبط المعلمات الفائقة ومنع الإفراط في التكيف، ومجموعة الاختبار لتقييم أداء النموذج على البيانات غير المرئية.

خطوات معالجة البيانات

| دراسة | هدف | ملخص |

| باتيل وكيرانج، (2023) [10] | تصميم نموذج تجميعي عميق لتحسين دقة التصنيف متعدد الفئات لأورام الدماغ باستخدام صور الرنين المغناطيسي، مع معالجة تحديات تحديد موقع الورم وتصنيفه. | يقدم نموذجًا عميقًا يجمع بين شبكات SCNN و VGG16 لتصنيف أورام الدماغ من صور الرنين المغناطيسي، محققًا دقة تصل إلى 97.77% ومعالجًا قضايا الإفراط في التكيف وعدم توازن مجموعة البيانات. |

| ووزنياك وآخرون، (2023) [11] | تقديم نموذج CLM لتعزيز كفاءة هياكل الشبكات العصبية العميقة، لا سيما في تقييم أشعة مقطعية للدماغ. | يقدم نموذج CLM الذي يدمج الشبكة العصبية الداعمة مع CNN لتسريع التعلم وزيادة الكفاءة، محققًا دقة تقارب 96% في تقييم أشعة الدماغ المقطعية. |

| عبد السلاموف وآخرون، (2023) [12] | تعزيز اكتشاف أورام الدماغ باستخدام نموذج YOLOv7 المحسن مع تحسين الصور، وزيادة البيانات، وتقنيات دمج الميزات. | يقدم نموذج YOLOv7 المحسن للكشف الدقيق عن أورام الدماغ في صور الرنين المغناطيسي، محققًا أداءً تنافسيًا ويظهر فائدة محتملة في التطبيقات الطبية. |

| محمود وآخرون، (2023) [13] | تطوير بنية شبكة عصبية تلافيفية (CNN) للكشف الفعال عن أورام الدماغ من صور الرنين المغناطيسي، مع مقارنة أدائها مع النماذج المعتمدة. | يقترح بنية شبكة عصبية تلافيفية (CNN) لاكتشاف أورام الدماغ من صور الرنين المغناطيسي، محققة أداءً متفوقًا مقارنةً بالنماذج المعتمدة.

|

| أسد وآخرون، (2023) [14] | تطوير نظام تلقائي للكشف المبكر عن أورام الدماغ باستخدام شبكة عصبية عميقة مع خوارزمية تحسين SGD. | يستخدم شبكة عصبية تلافيفية عميقة مع تحسين SGD لاكتشاف أورام الدماغ، متفوقًا على الطرق الأساسية ويقترح إمكانية استخدامها في أمراض أخرى. |

| كانشنامالا وآخرون، (2023) [15] | تطوير نظام دقيق لاكتشاف وتصنيف أورام الدماغ باستخدام ShCNN المعتمد على ExpDHO وDeep CNN، مما يعزز الدقة والحساسية والخصوصية. | يقترح نهجًا يجمع بين ShCNN المعتمد على ExpDHO وDeep CNN لاكتشاف وتصنيف أورام الدماغ، محققًا قيم دقة وحساسية ونوعية تتجاوز 0.9. |

| أغاروال وآخرون، (2023) [16] | تطوير نهج محسّن قائم على ResNet لتقسيم أورام الدماغ في صور الرنين المغناطيسي. | يقدم نهجًا محسّنًا قائمًا على ResNet لتجزئة أورام الدماغ، محققًا دقة أعلى وتسريع عملية التعلم. |

| أرتشانا وكوماراسامي، (2023) [17] | تقييم دقة طريقة جديدة تعتمد على BKNN لتقسيم أورام الدماغ في صور الرنين المغناطيسي. | يقدم طريقة تعتمد على BKNN لتقسيم أورام الدماغ، تهدف إلى تحسين الدقة وتبسيط عملية التقسيم. |

| غياتري وآخرون، (2023) [18] | تقييم فعالية بنية VGG-16 في الكشف بدقة عن أورام الدماغ من خلال التعلم العميق. | يقيم أداء VGG-16 في اكتشاف أورام الدماغ، محققًا دقة تصل إلى 94% بعد تحسين المعلمات الفائقة. |

| حق وآخرون، (2023) [19] | تطوير تقنيات فعالة تعتمد على الشبكات العصبية التلافيفية لتحديد وتصنيف أورام الدماغ من بيانات الرنين المغناطيسي. | يقدم تقنيات قائمة على الشبكات العصبية التلافيفية لتحديد وتصنيف أورام الدماغ باستخدام بيانات التصوير بالرنين المغناطيسي، محققًا دقة عالية ويستفيد من الحقول العشوائية الشرطية للتقسيم الدقيق. |

| أصلي | معزز | |

| ورم | 155 | 1240 |

| لا ورم | 98 | 784 |

قيم شدة صور الرنين المغناطيسي على مقياس موحد.

تُحافظ موثوقية مجموعة البيانات، مما يضمن أن المراحل اللاحقة من تطوير النموذج تستند إلى عينة بيانات قوية وتمثيلية.

علاوة على ذلك، قد تشمل منهجيات المعالجة المسبقة المتقدمة استخدام خوارزميات متطورة لتسجيل الصور، والتقسيم، وتصحيح العيوب. يسهل تسجيل الصور المحاذاة المكانية لصور الرنين المغناطيسي من مواضيع أو نقاط زمنية مختلفة على قالب تشريحي مشترك، مما يمكّن من إجراء مقارنات ذات مغزى بين الأفراد وتحليلات طولية. تحدد خوارزميات التقسيم مناطق الاهتمام داخل الدماغ، مما يسهل التحديد الدقيق لحدود الورم ويمكّن من التوصيف الكمي لشكل الورم وحجمه. بالإضافة إلى ذلك، تستفيد استراتيجيات تصحيح العيوب من تقنيات معالجة الإشارات المتقدمة للتخفيف من آثار الضوضاء، والتشويه، أو غيرها من عيوب التصوير، مما يحافظ على دقة البيانات.

تعتبر معالجة صور الرنين المغناطيسي خطوة حيوية لضمان أن تكون بيانات الإدخال ملائمة لعملية التعلم لنماذج التعلم العميق. يتم اختيار كل خطوة من خطوات المعالجة بعناية وتطبيقها لتحسين قدرة النموذج على اكتشاف أورام الدماغ بدقة وموثوقية عالية.

يتم تغيير حجم جميع صور الرنين المغناطيسي إلى أبعاد قياسية لضمان التوحيد في حجم الإدخال للنموذج. هذا أمر ضروري لأن الشبكات العصبية التلافيفية (CNNs) تتطلب حجم إدخال ثابت. يساعد إعادة قياس قيم البكسل إلى نطاق من 0 إلى 1 في استقرار عملية التدريب حيث أنه يقوم بتطبيع تحديثات التدرج أثناء عملية الانتشار العكسي، مما يؤدي إلى تقارب أسرع. يمكن أن تختلف صور الرنين المغناطيسي في التباين والسطوع بسبب بروتوكولات المسح المختلفة. يجلب تطبيع الشدة جميع الصور إلى مقياس شدة مشترك، مما يساعد النموذج على التركيز على المعلومات الهيكلية بدلاً من التغيرات الناتجة عن عملية التصوير. هذه الخطوة حاسمة لتحسين حساسية النموذج للميزات المرضية الفعلية.

أورام الدماغ. من الضروري إزالة الصور التي تحتوي على عيوب، مثل ضبابية الحركة أو الضوضاء الناتجة عن الماسح الضوئي، لمنع النموذج من تعلم ميزات غير ذات صلة أو مضللة. تعزز مجموعات البيانات النظيفة قدرة النموذج على التعميم من خلال التعلم من صور عالية الجودة خالية من العيوب. توسيع البيانات، بما في ذلك التدوير، والانعكاس، والتغيير في الحجم، والتشوهات المرنة، يوسع مجموعة البيانات بشكل مصطنع ويقدم مجموعة متنوعة من التحولات التي قد يواجهها النموذج في سيناريوهات العالم الحقيقي. هذا مهم بشكل خاص لمهام التصوير الطبي، حيث يحاكي التباين في مظهر الورم وموقعه، مما يعزز قوة النموذج وقدرته على التعميم.

تقنيات زيادة البيانات

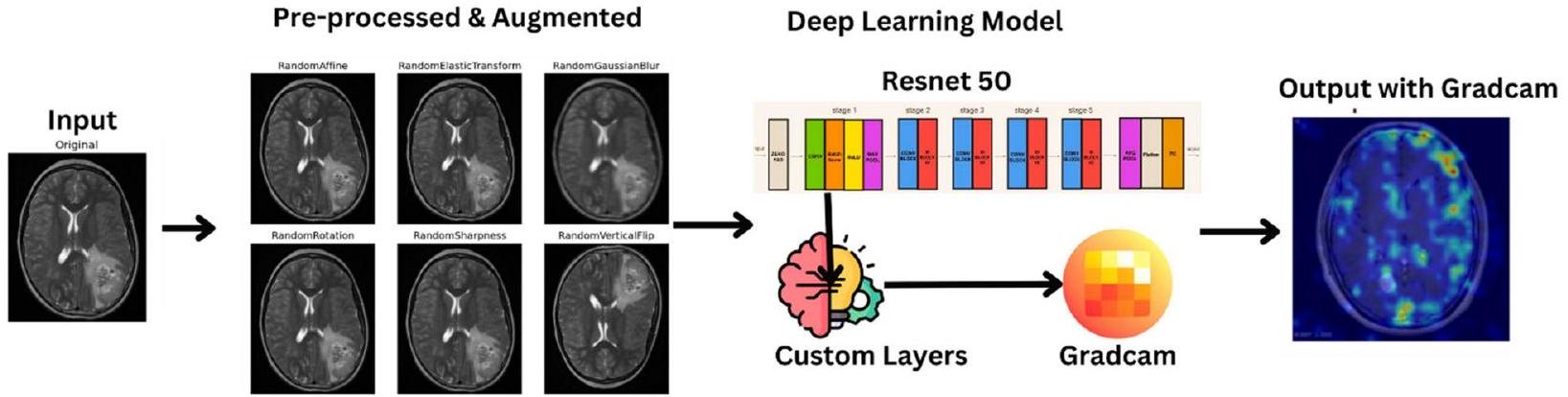

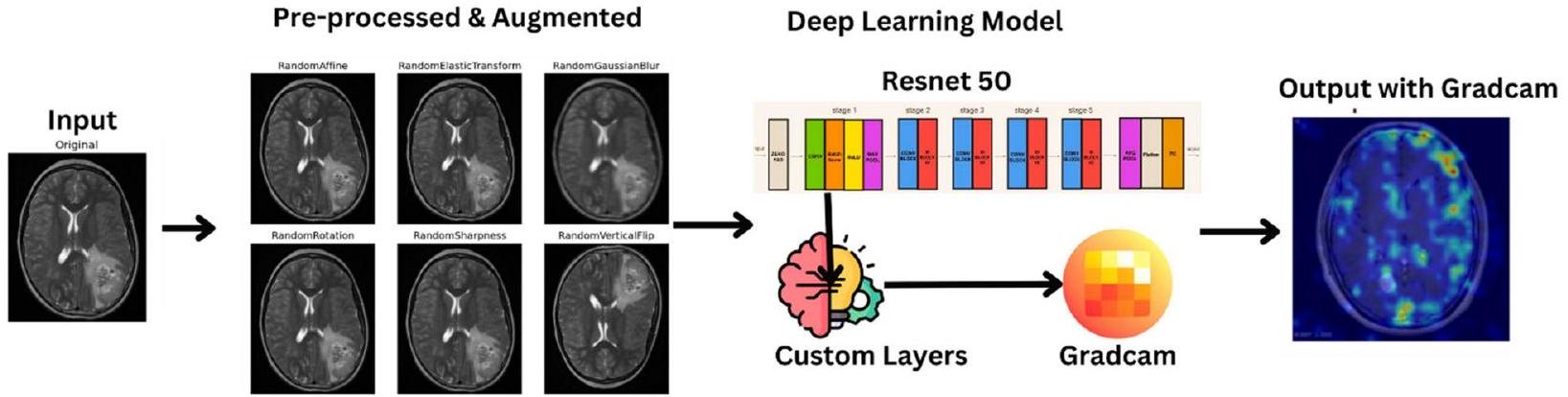

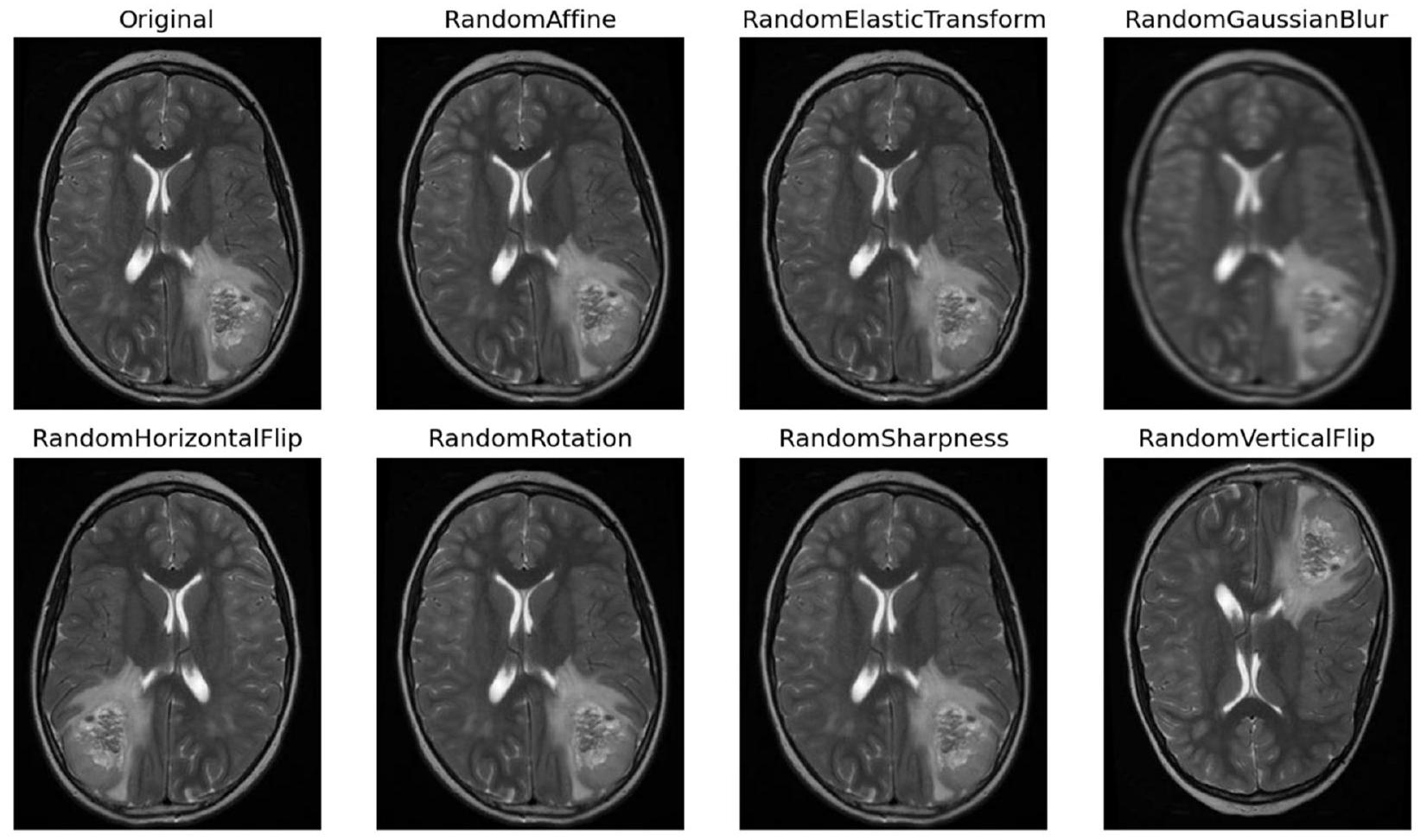

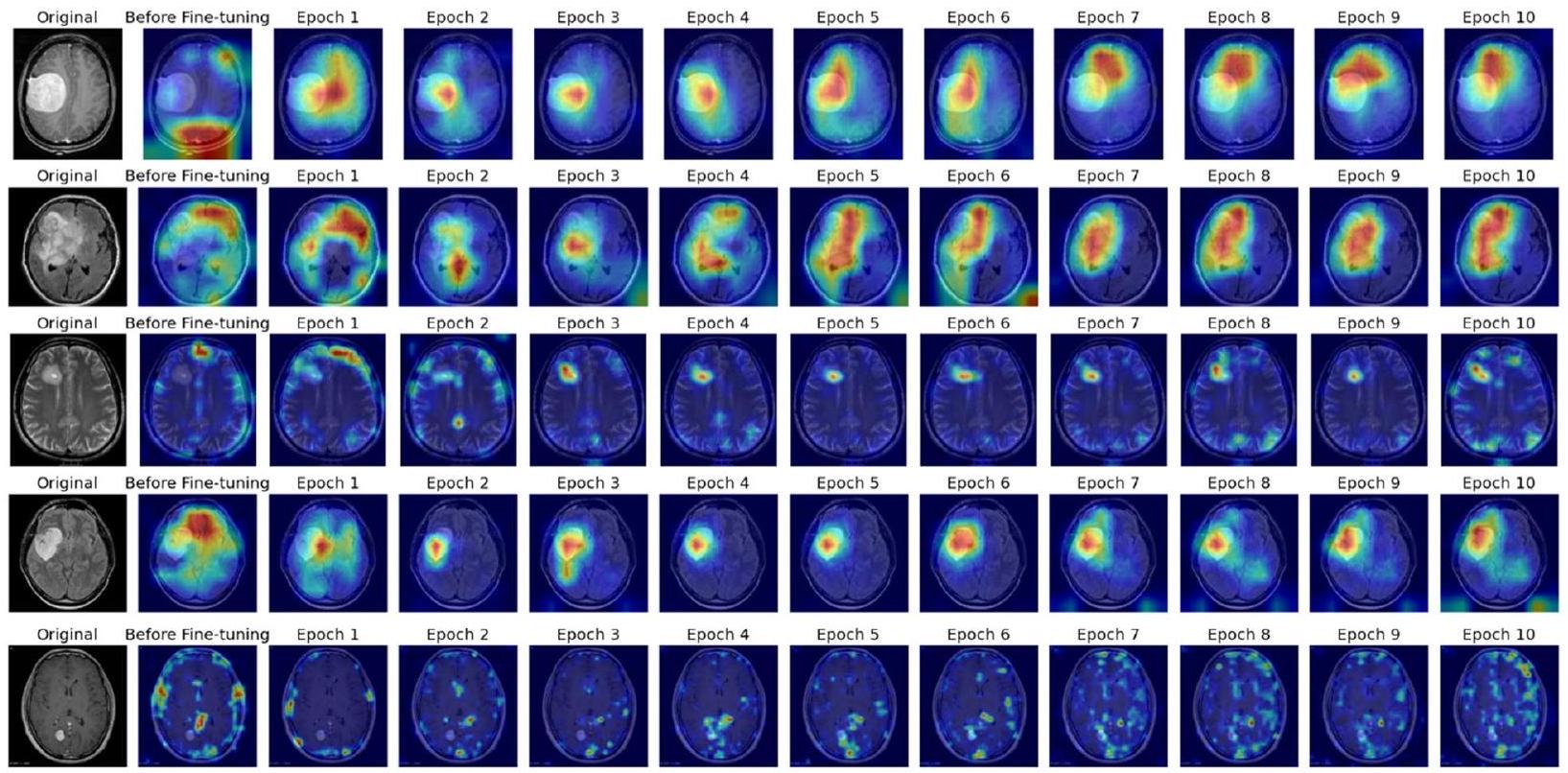

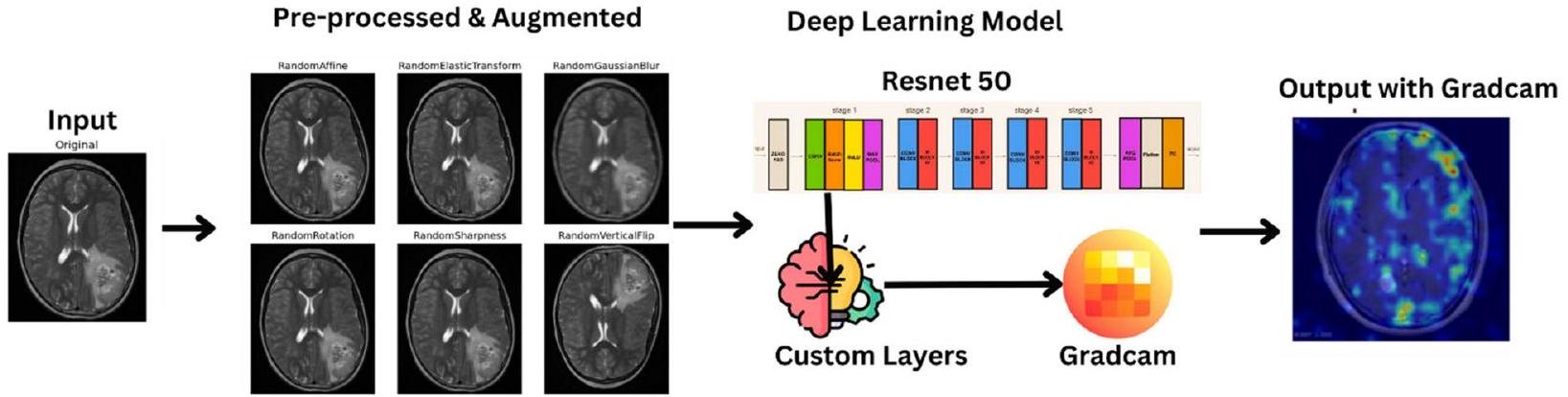

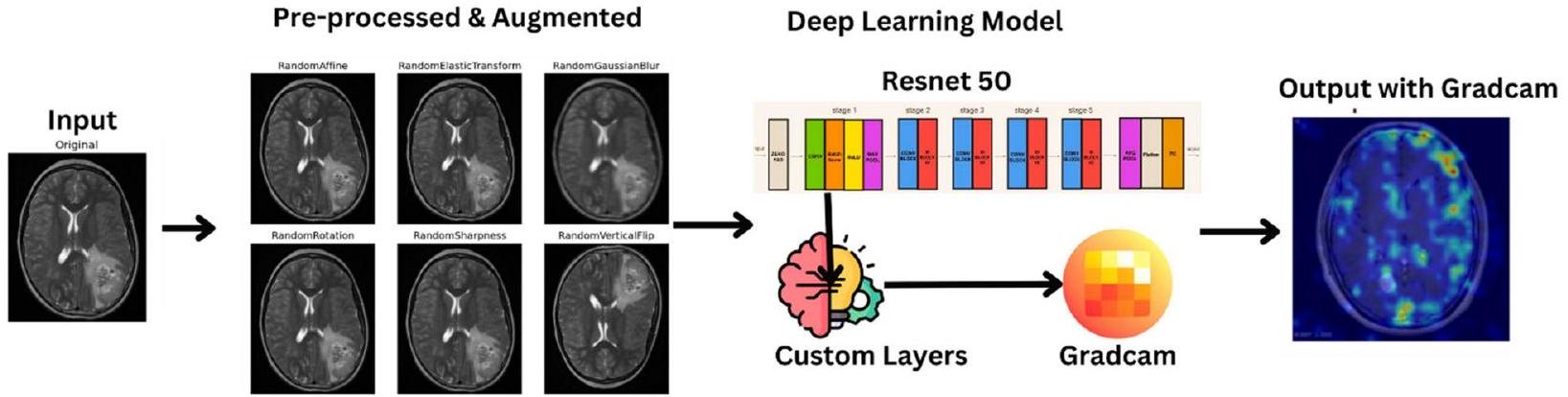

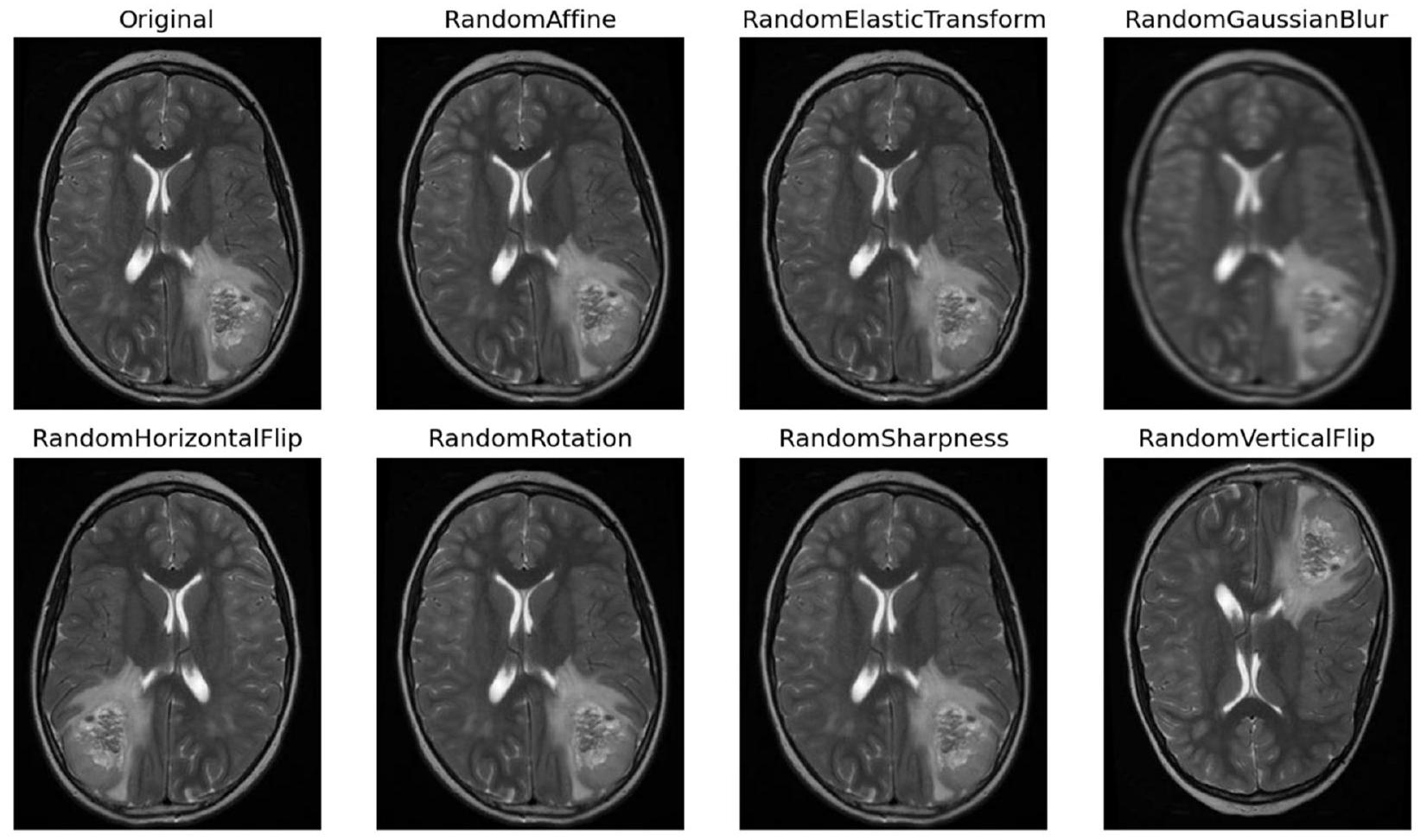

تُصبح التقنيات ضرورية لتعزيز ثراء مجموعة البيانات، مما يزيد من قوة النموذج وقدراته على التعميم. تشمل منهجيات التAugmentation مجموعة من العمليات التحويلية، كل منها مصمم لإدخال تنوعات مختلفة تعكس سيناريوهات الأورام في العالم الحقيقي. تُعتبر التدوير تقنية أساسية، حيث تسهل إنشاء صور من زوايا متعددة لمحاكاة المنظورات المتنوعة التي يتم مواجهتها في التصوير السريري [20]. في الشكل 5، تُظهر بعض الصور المعززة.

بالإضافة إلى ذلك، فإن عمليات التدوير أفقيًا ورأسيًا تنوع اتجاهات الصور، مما يحاكي بشكل فعال الترتيبات المكانية المتنوعة للأورام داخل الدماغ. تساهم عمليات تغيير الحجم أيضًا من خلال تغيير حجم الصور لمحاكاة طيف أحجام الأورام التي يتم مواجهتها في الممارسة السريرية، مما يعزز قدرة النموذج على تمييز الأورام ذات الأبعاد المختلفة. تعمل عمليات الترجمة، سواء عموديًا أو أفقيًا، على إزاحة الصور مكانيًا لتدريب النموذج على تحديد موقع الأورام، بغض النظر عن موقعها داخل الدماغ. توضح الشكل 6 صورة واحدة بعد خطوات مختلفة.

نطاق ظروف التصوير التي يتم مواجهتها في البيئات السريرية، مما يضمن قدرة النموذج على التكيف مع بيئات المسح المتنوعة. بشكل جماعي، تتجاوز هذه استراتيجيات التعزيز مجرد توسيع مجموعة البيانات، مما يمنح مجموعة البيانات تمثيلاً شاملاً لتنوع الأورام، وهو أمر حاسم لتدريب نموذج قوي.

نظرة عامة على نموذج التعلم العميق (ResNet50) وأهميته

ResNet50، وهو هيكل شبكة عصبية تلافيفية بارز، يتميز بعمقه وعناصر تصميمه المعقدة المصممة لتسهيل استخراج الميزات الغنية وانتشار التدرجات. يتكون ResNet50 من 50 طبقة، ويجمع بين الطبقات التلافيفية، وطبقات تفعيل الوحدة الخطية المصححة (ReLU) (المعادلة 2)، وطبقات تطبيع الدفعات، وطبقات متصلة بالكامل. تتكون المعادلات 3 و10 من المعادلات المختلفة المستخدمة في عملية بناء النموذج.

يظهر ResNet50 كأداة محورية بفضل هيكله العميق وقدرته على استخراج الميزات المعقدة من بيانات التصوير الطبي. من خلال الاستفادة من قدراته في تعلم الميزات الهرمية، يتفوق ResNet50 في تمييز الأنماط الدقيقة والمعقدة داخل صور الرنين المغناطيسي التي تشير إلى وجود أورام. علاوة على ذلك، تعزز تطبيقات التعلم الانتقالي من فائدته في مهام التصوير الطبي، حيث تمثل أحجام مجموعات البيانات المحدودة تحديات لتدريب الشبكات العميقة من الصفر. من خلال التدريب المسبق على مجموعات بيانات واسعة مثل ImageNet ومن ثم تحسينه على صور الرنين المغناطيسي، يستفيد ResNet50 من المعرفة بالميزات العامة المكتسبة من مجموعات البيانات الأكبر للتكيف مع تفاصيل اكتشاف الأورام، مما يعزز أدائه وقدرته على التعميم.

علاوة على ذلك، يساهم دمج تقنيات التفسير مثل رسم خرائط تنشيط الفئة المعتمدة على التدرج (Grad-CAM) مع ResNet50 في فائدته في الإعدادات السريرية. تتيح هذه المنهجية تصور المناطق البارزة داخل الصور المدخلة التي تؤثر على عملية اتخاذ القرار للنموذج، مما يعزز من قابلية التفسير. يحصل الأطباء على رؤى حول الأسباب وراء توقعات النموذج، حيث يوضح Grad-CAM المناطق التي تعتبر دالة على وجود الأورام. لا يعزز هذا الثقة في تشخيصات النموذج فحسب، بل يسهل أيضًا عمليات اتخاذ القرار التعاونية بين الأطباء وأنظمة الذكاء الاصطناعي، مما يعزز في النهاية رعاية المرضى وتخطيط العلاج.

تم تعديل ResNet50 لمهمة التصنيف الثنائي لاكتشاف أورام الدماغ. يتم استبدال الطبقة النهائية المتصلة بالكامل في نموذج ResNet50 القياسي، الذي يستخدم عادةً لتصنيف 1000 فئة، بطبقة جديدة مصممة لتمييز بين فئتين: ‘ورم’ و ‘لا ورم’. هذه التعديلات ضرورية لتكييف النموذج المدرب مسبقًا مع المهمة المحددة.

التفاصيل المعقدة اللازمة لاكتشاف الأورام بدقة. ثم يتم تطبيق Grad-CAM على النموذج المدرب، مما يوفر تفسيرات بصرية تبرز المناطق في صور الرنين المغناطيسي الأكثر تأثيرًا على توقعات النموذج، مما يوفر رؤية شفافة في آليات تشغيل النموذج.

- مجموعة من صور الرنين المغناطيسي للدماغ لتقييم وجود أورام الدماغ.

- أوزان نموذج ResNet50 المدرب مسبقًا.

- تصنيف كل صورة رنين مغناطيسي إلى ‘ورم’ أو ‘لا ورم’.

- تفسيرات Grad-CAM التي تبرز المناطق المؤثرة على توقعات النموذج.

- تحضير البيانات:

- تحميل مجموعة بيانات صور الرنين المغناطيسي للدماغ.

- تطبيع كثافات الصور وإعادة تحجيم الصور لتتناسب مع حجم الإدخال لنموذج ResNet50.

- تقسيم مجموعة البيانات إلى مجموعات تدريب، تحقق، واختبار.

- زيادة البيانات (لمجموعة التدريب):

- تطبيق التدوير، والانعكاس، والتكبير، والترجمة، والتشويه المرن، وتعديلات السطوع/التباين على الصور في مجموعة التدريب لتعزيز تعميم النموذج.

- تكوين النموذج:

- تهيئة نموذج ResNet50. إذا كنت تستخدم التعلم الانتقالي، قم بتحميل الأوزان المدربة مسبقًا؛ وإلا، قم بالتهيئة بأوزان عشوائية.

- استبدال الطبقة النهائية المتصلة بالكامل بطبقة جديدة مصممة للتصنيف الثنائي (ورم، لا ورم).

- التدريب:

- لكل عصر، قم بالتكرار على مجموعة التدريب في دفعات:

- قم بإجراء تمرير أمامي للنموذج لحساب التوقعات.

- احسب الخسارة باستخدام الانتروبيا المتقاطعة الثنائية.

- قم بإجراء الانتشار العكسي لحساب التدرجات.

- قم بتحديث أوزان النموذج باستخدام مُحسِّن (مثل SGD أو Adam).

- بعد كل عصر، قم بتقييم النموذج على مجموعة التحقق لمراقبة الأداء وتطبيق التوقف المبكر أو حفظ النموذج حسب الحاجة.

- الاختبار والتقييم:

- قم بتقييم النموذج النهائي على مجموعة الاختبار لتحديد أدائه باستخدام مقاييس مثل الدقة، والدقة، والاسترجاع، وF1-Score، والخصوصية.

- قم بإنشاء مصفوفة الارتباك ومنحنى ROC لتقييم أداء النموذج بالتفصيل.

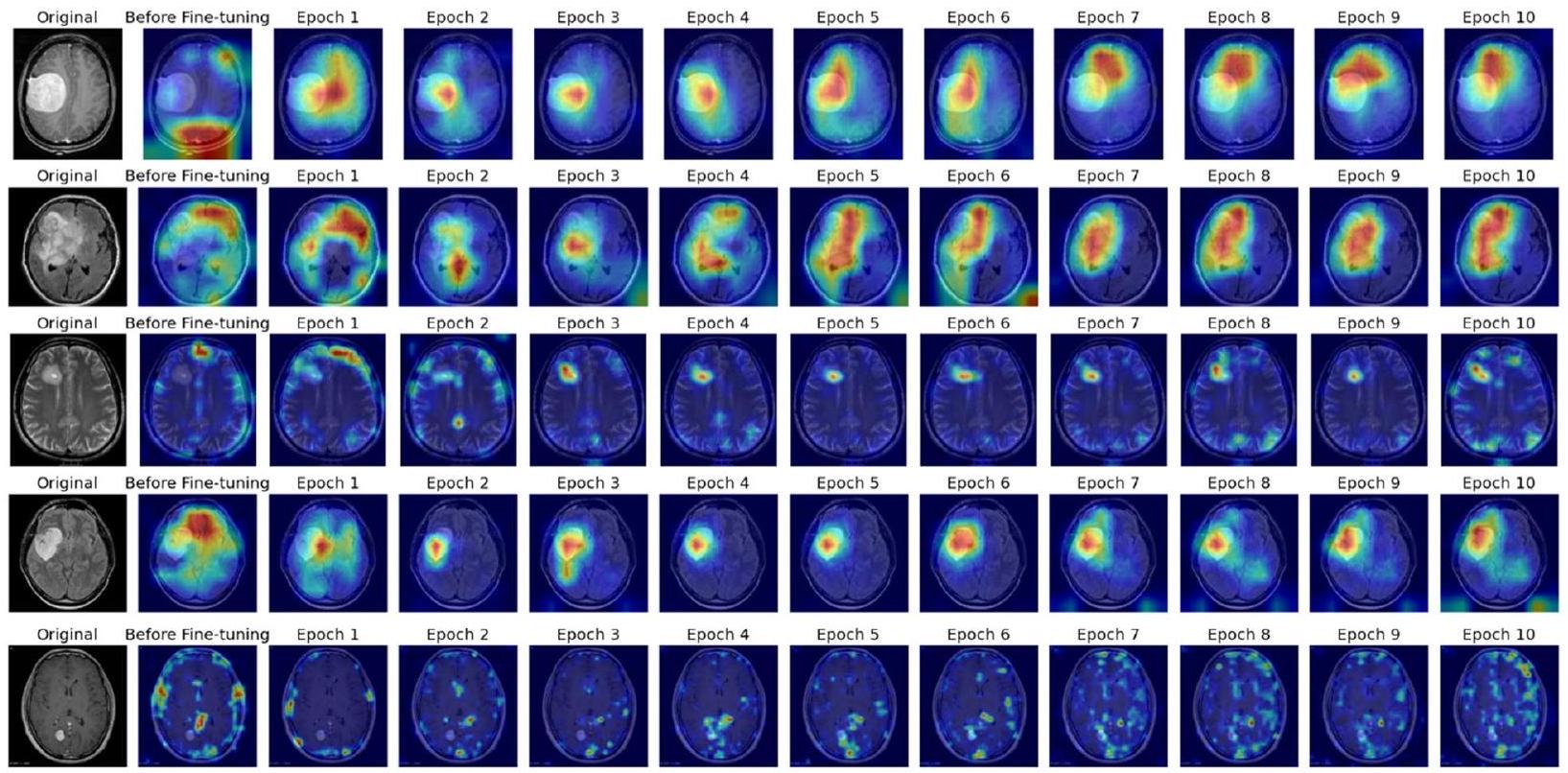

- تصوير Grad-CAM:

- بالنسبة لصور الاختبار المختارة، قم بتطبيق Grad-CAM لإنشاء خرائط حرارية تبرز المناطق الأكثر تأثيرًا على توقعات النموذج.

- قم بتراكب هذه الخرائط الحرارية على الصور الأصلية لتصور مناطق التركيز للنموذج.

- توليد المخرجات:

- قم بتصنيف كل صورة في مجموعة الاختبار كـ ‘ورم’ أو ‘لا ورم’ بناءً على توقعات النموذج.

- قدم تفسيرات Grad-CAM جنبًا إلى جنب مع التوقعات من أجل قابلية التفسير والتحليل الإضافي.

عملية التدريب والتحقق والاختبار

يتم استخدام معالجة الدفعات لتقسيم مجموعة بيانات التدريب إلى مجموعات فرعية قابلة للإدارة، مما يمكّن من تحديث الأوزان بشكل تدريجي ويعزز الكفاءة الحسابية. خلال كل تكرار تدريبي، يتم تمرير البيانات عبر الشبكة، مما يولد توقعات. بعد ذلك، يتم حساب تدرج الخسارة بالنسبة لأوزان الشبكة، مما يسهل تحديث الأوزان بواسطة المُحسِّن لتقليل الخسارة.

تت unfold عملية التدريب على مدى عدة عصور، حيث يمثل كل عصر تمريرة كاملة عبر مجموعة بيانات التدريب بأكملها. قد يتم استخدام تقنيات مثل الإسقاط أو تنظيم L2 لتخفيف الإفراط في التكيف، مما يضمن أن النموذج يتعمم بشكل جيد على البيانات غير المرئية.

في الوقت نفسه، تحدث عملية التحقق في نهاية كل عصر، حيث يتم تقييم أداء النموذج على مجموعة تحقق منفصلة. توفر هذه التقييمات رؤى حول قدرات تعميم النموذج وتوجه قرارات ضبط المعلمات. يتم تعديل المعلمات مثل معدل التعلم وحجم الدفعة بناءً على مقاييس الأداء مثل الدقة والدقة والاسترجاع. علاوة على ذلك، قد يتم تنفيذ معايير التوقف المبكر لوقف التدريب إذا تدهور أداء النموذج على مجموعة التحقق، مما يقلل من الإفراط في التكيف عن طريق منع النموذج من تعلم الضوضاء من مجموعة بيانات التدريب. من خلال هذا النظام التدريبي والتحققي التكراري، يتم صقل نموذج ResNet50 لتحقيق أداء وموثوقية مثلى في مهمة اكتشاف أورام الدماغ.

تشمل عملية اختبار نموذج التعلم العميق المطور في الكشف عن أورام الدماغ عدة خطوات صارمة للتأكد من موثوقيته وفعاليته وقابليته للتفسير. بعد الانتهاء من مراحل التدريب والتحقق، يخضع النموذج للتقييم النهائي باستخدام مجموعة اختبار محددة تتكون من بيانات لم يتم رؤيتها خلال المراحل السابقة. تعتبر هذه الخطوة الحاسمة ضرورية لتقييم قابلية تطبيق النموذج في العالم الحقيقي وأدائه تحت ظروف جديدة.

مقاييس الأداء المستخدمة للتقييم

التجارب والنتائج

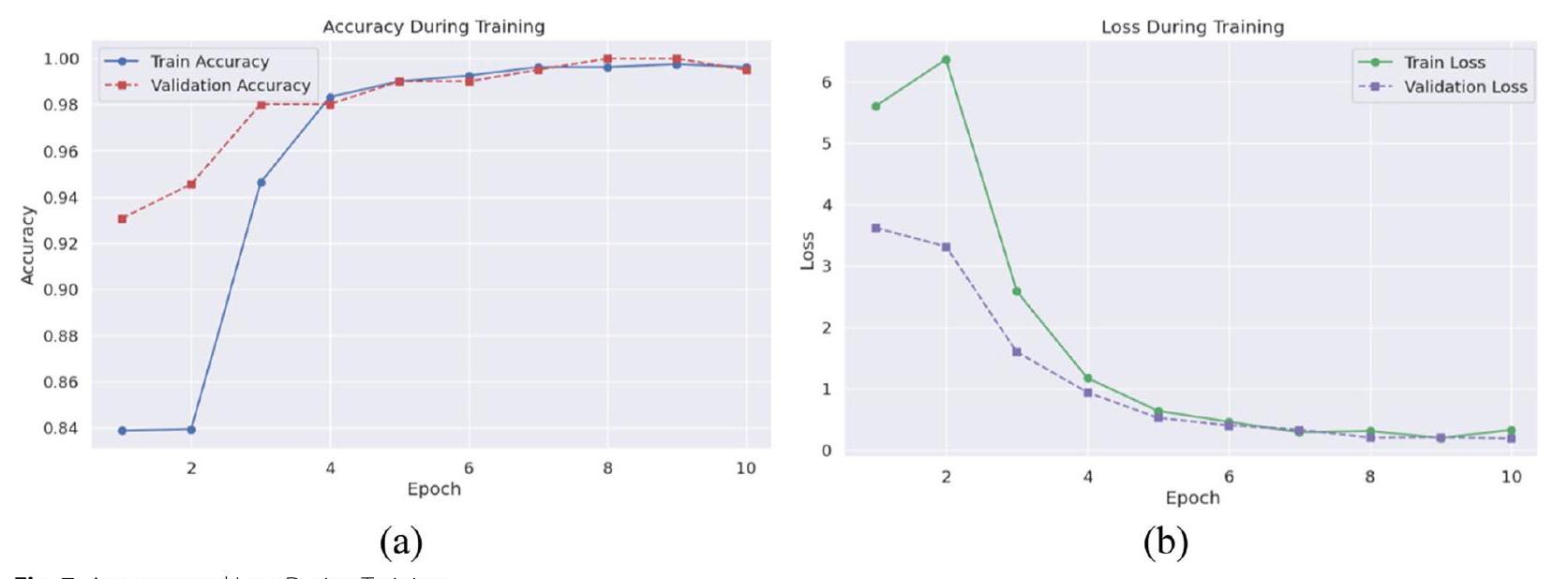

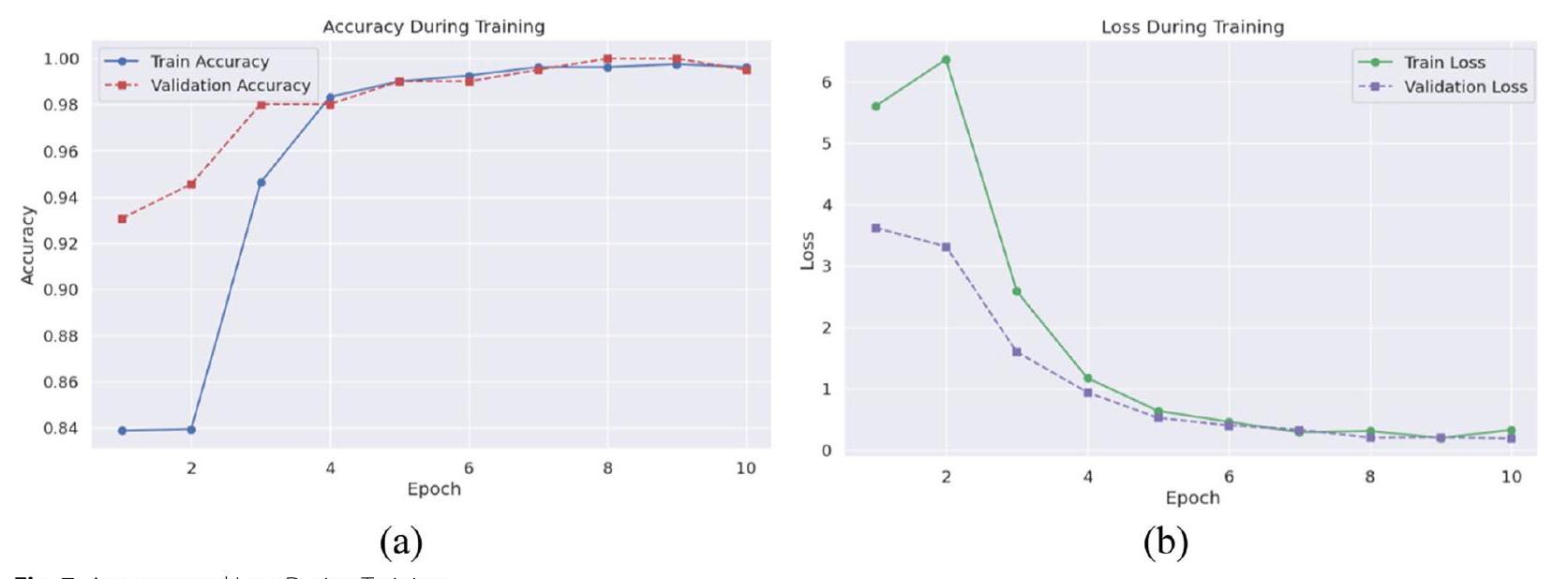

بدقة. عززت مقاييس الدقة والاسترجاع ودرجة F1 موثوقية النموذج، حيث اقتربت القيم من 100% بحلول العصر الثامن، مما يدل على أداء قوي في تحديد الحالات الإيجابية الحقيقية مع تقليل الإيجابيات والسلبية الكاذبة. على مجموعة الاختبار، أظهر النموذج دقة مثيرة للإعجاب قدرها

خلال مراحل التحقق والاختبار، تم فحص أداء النموذج وقدرته على التعميم بدقة، مما أسفر عن رؤى شاملة حول فعاليته في اكتشاف أورام الدماغ. ظهرت دقة التحقق كمقياس محوري، حيث حقق النموذج دقة قصوى ملحوظة تبلغ

في مرحلة الاختبار اللاحقة، أظهر النموذج دقة جديرة بالثناء تبلغ

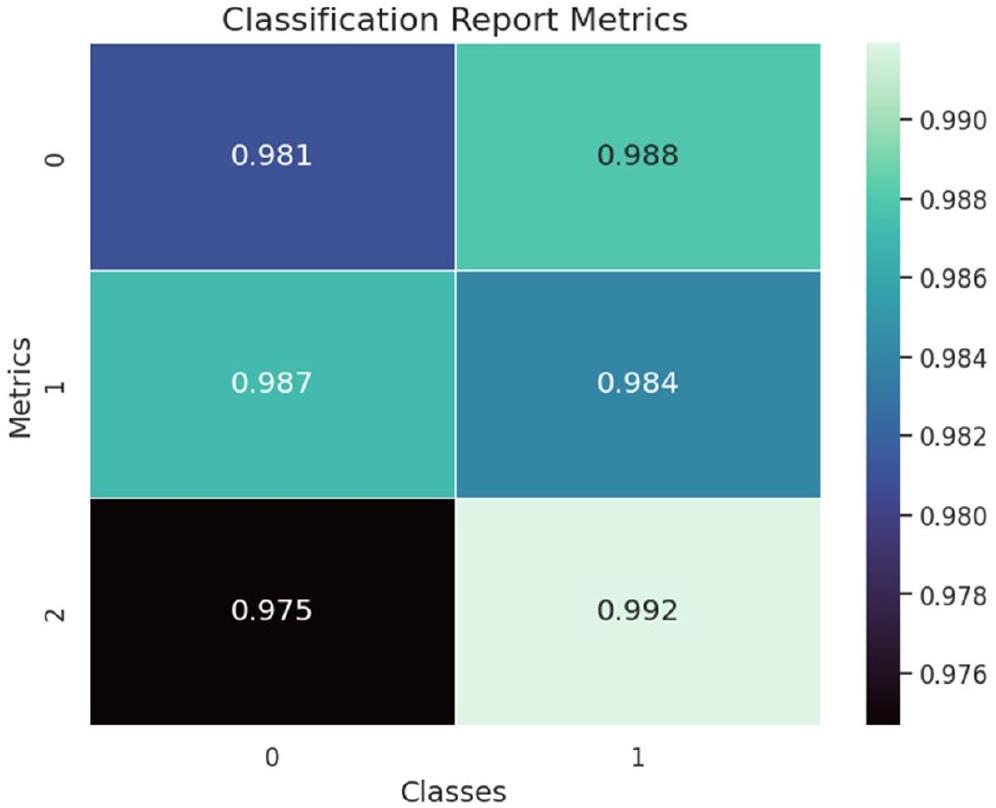

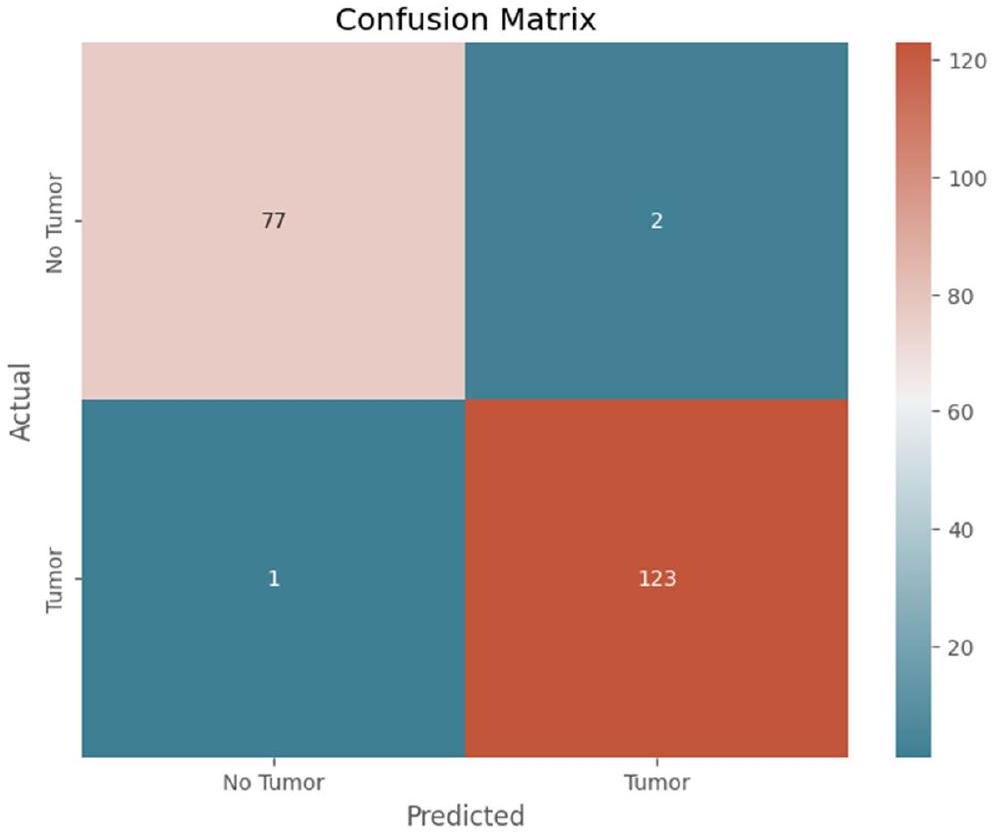

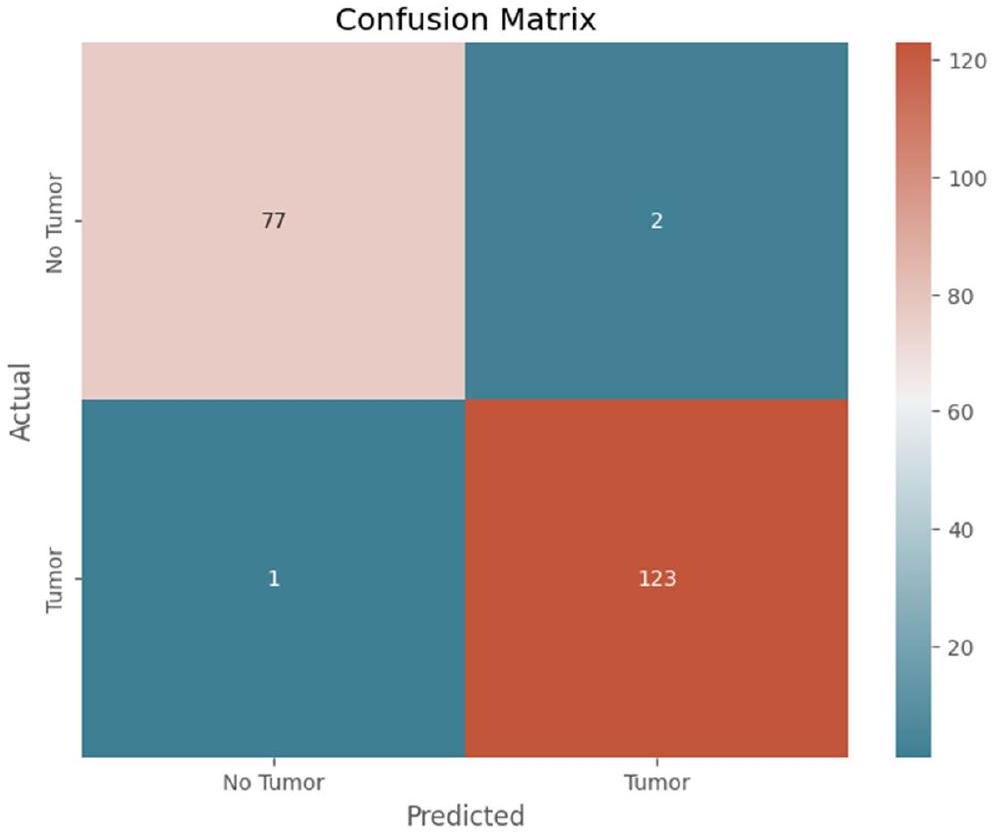

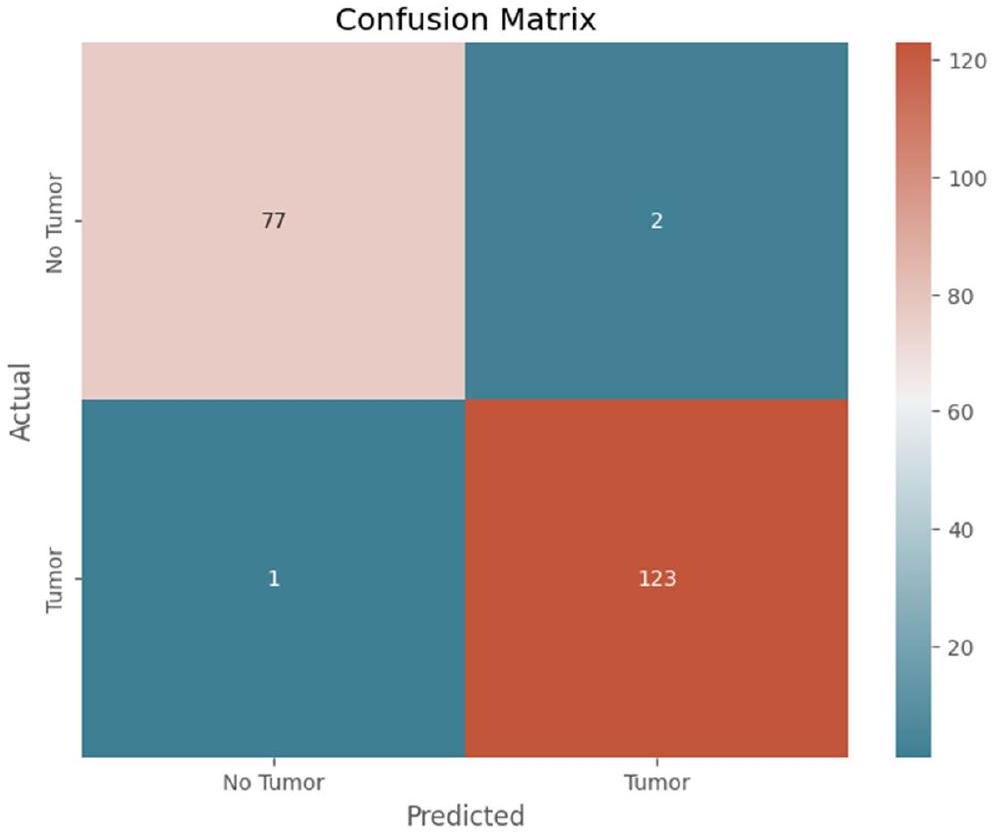

يوضح الشكل 9 مصفوفة الارتباك للنموذج المقترح.

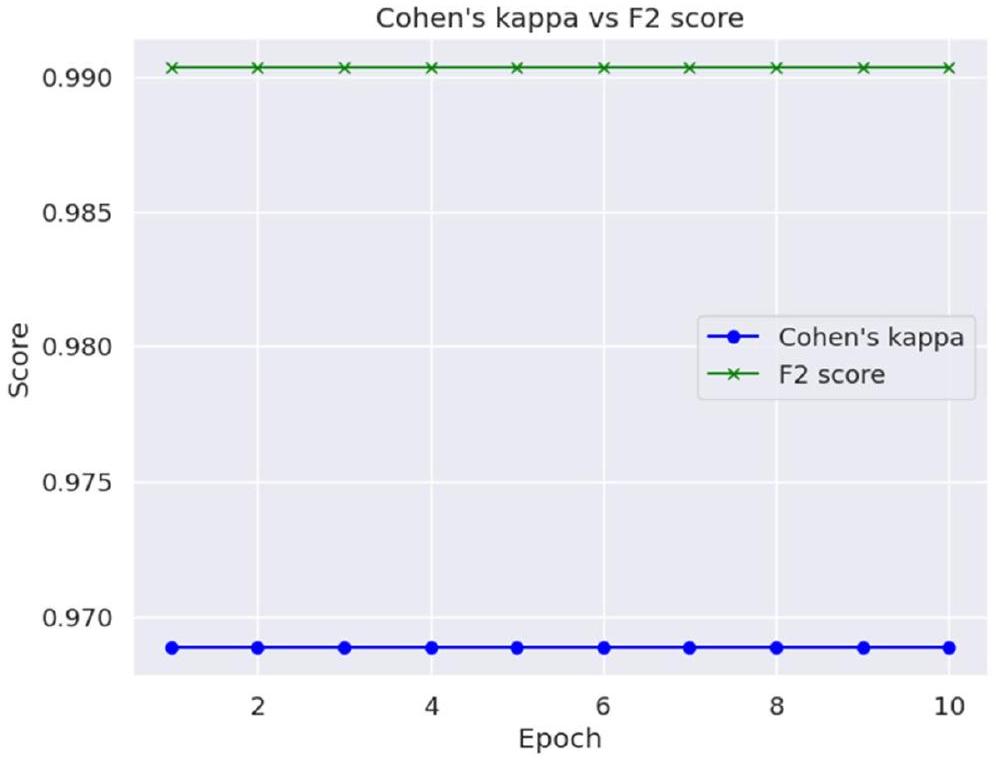

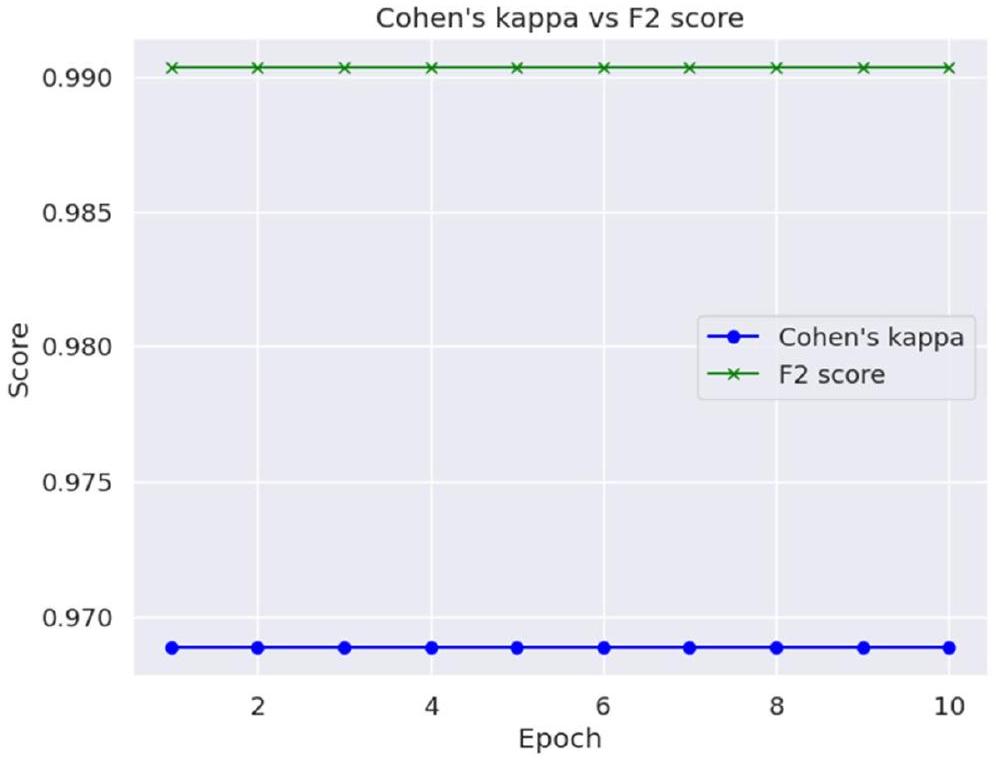

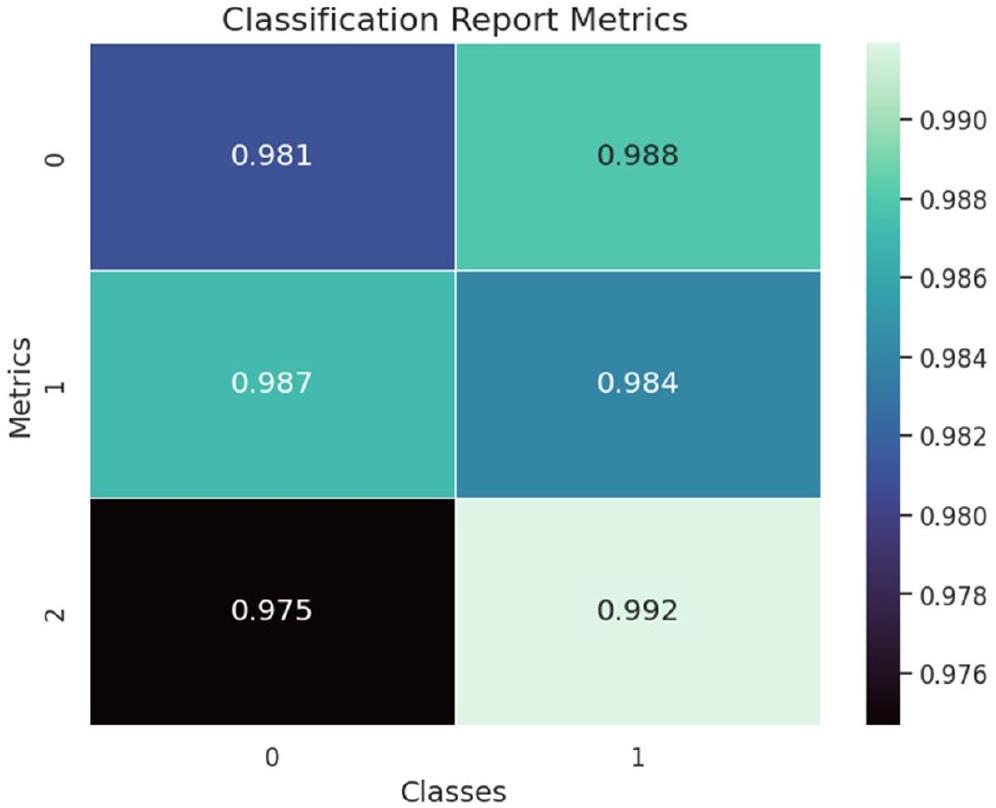

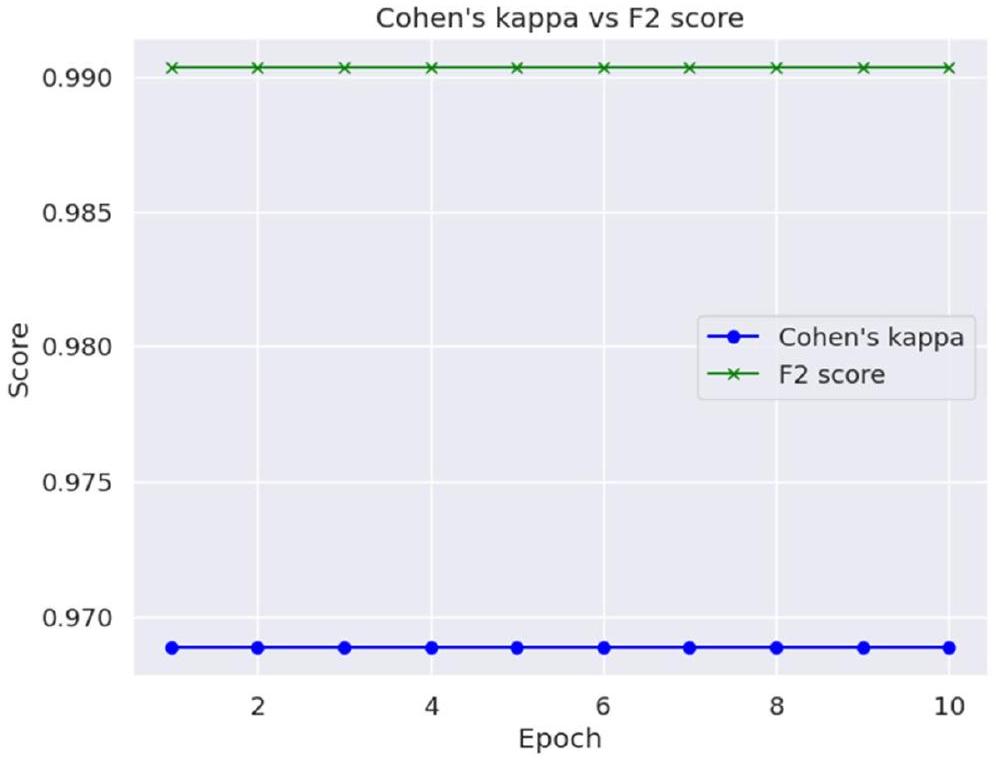

تظهر قيمة كابا لكوهين ودرجة F2 في الجدول 5.

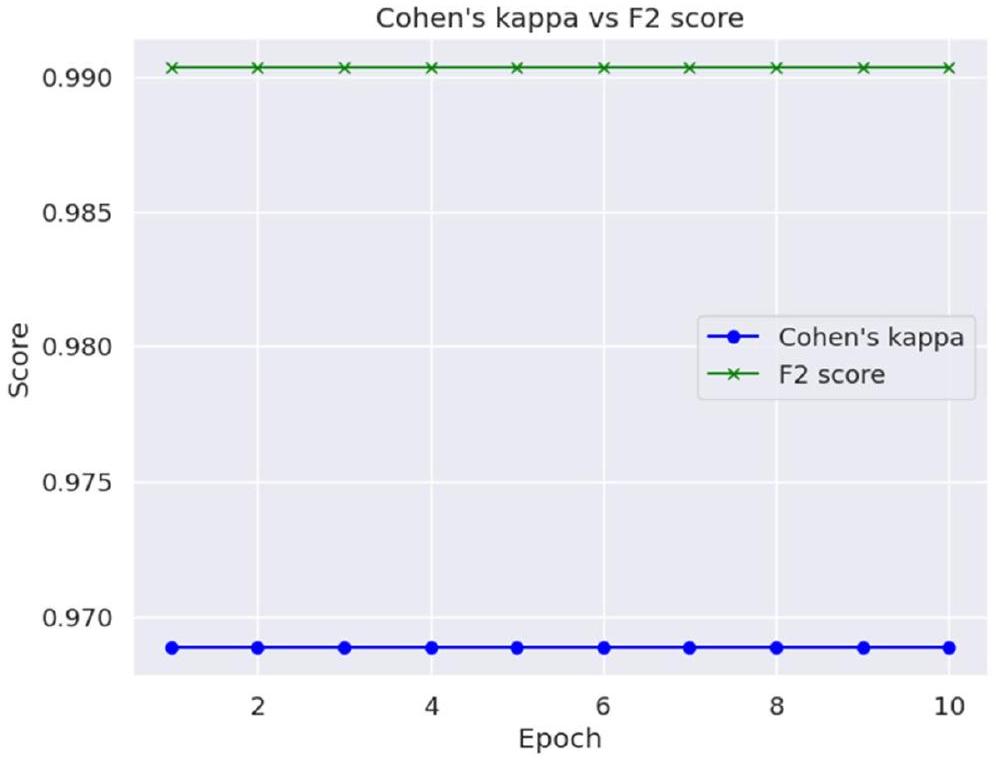

تم تصوير كابا لكوهين ودرجة F2 حسب العصر في الشكل 11.

إن دمج المقاييس الكمية والتصورات النوعية لـ Grad-CAM قدم إطار تقييم شامل، موضحًا فعالية النموذج في اكتشاف أورام الدماغ مع تقديم رؤى حول منطق اتخاذ القرار الخاص به. لم يثبت هذا التقييم متعدد الأوجه دقة النموذج التشخيصية فحسب، بل زاد أيضًا من شفافيتها وموثوقيتها، وهو أمر بالغ الأهمية للحصول على القبول والتبني في البيئات السريرية.

المناقشة

| الدقة | الاسترجاع | درجة F1 | |

| لا ورم | 0.99 | 0.97 | 0.98 |

| ورم | 0.98 | 0.99 | 0.99 |

| المقاييس | القيمة |

| MSE | 0.015 |

| RMSE | 0.122 |

| MAE | 0.015 |

تفسيرات بصرية لتنبؤات النموذج. تشير الأبحاث السابقة التي أجريت في هذا المجال جنبًا إلى جنب مع الاستطلاعات التي أجريت إلى أن grad cam أفضل لتصورات النموذج التفسيرية تتماشى مع التقييمات الإشعاعية الخبيرة.

| المقاييس | القيمة |

| درجة F2 | 0.99 |

| كابا لكوهين | 0.97 |

| الدراسة | التقنية | الدقة |

| خان وآخرون. (2023) [27] | اكتشاف أورام الدماغ باستخدام التعلم العميق | 95.94% |

| كومار وآخرون. (2023) [28] | تصنيف أورام الدماغ باستخدام نماذج CNN | 96.2% |

| حسين وآخرون. (2023) [5] | تصنيف أورام الدماغ متعددة الفئات باستخدام هياكل DL | 96.94% |

| أنيا-إيزازا وآخرون. (2023) [29] | تصنيف واكتشاف أورام الدماغ باستخدام هياكل DL وCross-Transformer | 97% |

| بيلاي وآخرون. (2023) [30] | اكتشاف أورام الدماغ باستخدام نماذج التعلم العميق للنقل | 91.58% |

| شارما وآخرون. (2023) [31] | اكتشاف أورام الدماغ باستخدام ResNet50 المعدل مع ميزات HOG | 88% |

| بيدادا وآخرون. (2023) [32] | تقسيم أورام الدماغ باستخدام U-Net المعدل مع الشبكات المتبقية | 93.40% |

| رحمن وإسلام (2023) [33] | تصنيف أورام الدماغ باستخدام شبكة عصبية تلافيفية عميقة متوازية (PDCNN) | 97.33% |

| النموذج المقترح | Resnet50 المحسن مع Gradcam | 98.52% |

يتميز النموذج، بأسلوبه الفريد في العمليات التلافيفية، بأداء أفضل من الهياكل الأخرى المستخدمة على نطاق واسع لهذه المهمة المحددة. من الضروري ملاحظة أن هيكل النموذج ليس العامل الوحيد المحدد للأداء؛ حيث تلعب عوامل مثل تعقيد مجموعة البيانات، ومعالجة البيانات المسبقة، واستراتيجيات التAugmentation أيضًا أدوارًا حاسمة في تحقيق دقة عالية وخسارة منخفضة في خوارزميات اكتشاف أورام الدماغ.

قيود مجموعة البيانات وآثارها على القابلية للتعميم

| سي إن إن | خسارة | 0.5071 |

| دقة | 80.16% | |

| EfficientNetB0 | خسارة | 0.4281 |

| دقة | 86.51% | |

| دينسنت 201 | خسارة | 0.3953 |

| دقة | 80.16% | |

| البداية | خسارة | 0.3982 |

| دقة | 81.75% | |

| إكسبشن | خسارة | 0.412 |

| دقة | 85.71% | |

| موبيل نت | خسارة | 0.3439 |

| دقة | 84.13% | |

| النموذج المقترح | خسارة | 0.0702 |

| دقة | 98.30% |

بينما توفر الدراسة الحالية رؤى قيمة حول قدرات التعلم العميق في اكتشاف أورام الدماغ، فإنها تبرز أيضًا الحاجة إلى تحسين مستمر في جمع البيانات وتدريب النماذج.

من خلال معالجة هذه القيود، يمكن أن تؤدي الأعمال المستقبلية إلى أدوات تشخيصية أكثر قوة وقابلية للتطبيق على نطاق واسع، مما يسهم في تحسين رعاية المرضى والنتائج في مجال التصوير الطبي.

الاعتبارات الأخلاقية في استخدام الذكاء الاصطناعي للتشخيصات السريرية

اتجاهات البحث المستقبلية والتكامل السريري

الخاتمة

مساهمات المؤلفين

التمويل

توفر البيانات والمواد

الإعلانات

موافقة الأخلاقيات والموافقة على المشاركة

الموافقة على النشر

المصالح المتنافسة

تاريخ النشر عبر الإنترنت: 11 مايو 2024

References

- Solanki S, et al. “Brain Tumor Detection and Classification Using Intelligence Techniques: An Overview.” IEEE Access. 2023;11:12870-86. https:// doi.org/10.1109/access.2023.3242666.

- Thenuwara G, Curtin J, Tian F. Advances in diagnostic tools and therapeutic approaches for gliomas: a comprehensive review. Sensors. 2023;23:9842.

- Thakur A, et al. Transformative breast Cancer diagnosis using CNNs with optimized ReduceLROnPlateau and Early stopping Enhancements. Int J Comput Intell Syst. 2024;17(1):14.

- Song J, et al. “Magnetic Resonance Imaging (MRI) Brain Tumor Image Classification Based on Five Machine Learning Algorithms.” Cloud Comput Data Sci. 2023, pp. 122-33. https://doi.org/10.37256/ccds. 42202 32740.

- Hossain S, et al. “Vision Transformers, Ensemble Model, and Transfer Learning Leveraging Explainable AI for Brain Tumor Detection and Classification.” IEEE J Biomed Health Informatics. 2024;28(3):1261-72. https://doi. org/10.1109/jbhi.2023.3266614.

- Saeedi S, et al. MRI-based brain tumor detection using convolutional deep learning methods and chosen machine learning techniques. BMC Med Inf Decis Mak. 2023;23(1):16.

- Anwar RW, et al. “Transfer Learning in Brain Tumor Classification: Challenges, Opportunities, and Future Prospects.” 2023 14th International Conference on Information and Communication Technology Convergence (ICTC). 2023. https://doi.org/10.1109/ictc58733.2023.10392830.

- Ullah F, et al. “Evolutionary Model for Brain Cancer-Grading and Classification.” IEEE Access. 2023;11:126182-94. https://doi.org/10.1109/access. 2023.3330919.

- Ullah F, et al. Enhancing brain tumor segmentation accuracy through scalable federated learning with advanced data privacy and security measures. Mathematics. 2023;11(19):4189.

- Patil S. Ensemble of deep learning models for brain tumor detection. Procedia Comput Sci. 2023;218:2468-79.

- Woźniak M. Jakub Siłka, and Michał Wieczorek. Deep neural network correlation learning mechanism for CT brain tumor detection. Neural Comput Appl. 2023;35(20):14611-26.

- Abdusalomov A, Bobomirzaevich M, Mukhiddinov, Taeg Keun Whangbo. Brain Tumor Detect Based deep Learn Approaches Magn Reson Imaging Cancers. 2023;15(16):4172.

- Mahmud

- Asad R , et al. Computer-aided early melanoma brain-tumor detection using deep-learning approach. Biomedicines. 2023;11(1):184.

- Kanchanamala, Pendela KG, Revathi. Belsam Jeba Ananth. Optimizationenabled hybrid deep learning for brain tumor detection and classification from MRI. Biomed Signal Process Control. 2023;84:104955.

- Aggarwal

- Archana KV, Komarasamy G. A novel deep learning-based brain tumor detection using the bagging ensemble with K-nearest neighbor. J Intell Syst. 2023;32(1):20220206.

- Gayathri P, et al. Exploring the potential of vgg-16 architecture for accurate brain tumor detection using deep learning. J Computers Mech Manage. 2023;2(2):23056-23056.

- Haq Ejaz UI, et al. “An MRI-Based Deep Learning Approach for Efficient Classification of Brain Tumors.” J Ambient Intell Humaniz Comput. 2021;14(6):6697-718. https://doi.org/10.1007/s12652-021-03535-9.

- Ullah F, et al. Brain Tumor Segmentation from MRI Images Using Handcrafted Convolutional Neural Network. Diagnostics. 2023;13(16):2650.

- Ullah F, Nadeem M. and Mohammad Abrar. Revolutionizing Brain Tumor Segmentation in MRI with Dynamic Fusion of Handcrafted Features and Global Pathway-Based Deep Learning.” KSII Trans Internet Inform Syst. 2024;18(1)- https://doi.org/10.3837/tiis.2024.01.007.

- Koonce B. “ResNet 50.” Convolutional neural networks with swift for tensorflow, 2021, pp. 63-72. https://doi.org/10.1007/978-1-4842-6168-2_6.

- Navoneel, Brain MRI Images for Brain Tumor Detection., Kaggle. https:// www.kaggle.com/datasets/navoneel/brain-mri-images-for-brain-tumordetection.

- Albalawi E, et al. Oral squamous cell carcinoma detection using EfficientNet on histopathological images. Front Med. 2024;10:1349336.

- Moteri A, Moteeb, et al. Enhancing accessibility for improved diagnosis with modified EfficientNetV2-S and cyclic learning rate strategy in women with disabilities and breast cancer. Front Med. 2024;11:1373244.

- Sannasi Chakravarthy SR, Bharanidharan N, Kumar V. Deep transfer learning with fuzzy ensemble approach for the early detection of breast cancer. BMC Med Imaging. 2024;24:82. https://doi.org/10.1186/ s12880-024-01267-8.

- Khan M , Attique, et al. Multimodal brain tumor detection and classification using deep saliency map and improved dragonfly optimization algorithm. Int J Imaging Syst Technol. 2023;33(2):572-87.

- Kavin Kumar K, et al.”Brain Tumor Identification Using Data Augmentation and Transfer Learning Approach.” Comput Syst Sci Eng. 2023;46(2):1845-61. https://doi.org/10.32604/csse.2023.033927.

- Anaya-Isaza Andrés, et al. Optimizing MRI-based brain tumor classification and detection using AI: a comparative analysis of neural networks, transfer learning, data augmentation, and the cross-transformer network. Eur J Radiol Open. 2023;10:100484.

- Pillai R, Sharma A, Sharma N, Gupta R. “Brain Tumor Classification using VGG 16, ResNet50, and Inception V3 Transfer Learning Models,” 2023 2nd International Conference for Innovation in Technology (INOCON), Bangalore, India. 2023, pp. 1-5. https://doi.org/10.1109/INOCON57975. 2023.10101252.

- Sharma A, Kumar, et al. HOG transformation based feature extraction framework in modified Resnet50 model for brain tumor detection. Biomed Signal Process Control. 2023;84:104737.

- Pedada K, Rao, et al. A novel approach for brain tumour detection using deep learning based technique. Biomed Signal Process Control. 2023;82:104549.

- Rahman T, Md Saiful Islam. MRI brain tumor detection and classification using parallel deep convolutional neural networks. Measurement: Sens. 2023;26:100694.

ملاحظة الناشر

- *المراسلة:

سورش غولوادي

suresh.guluwadi@astu.edu.et

DOI: https://doi.org/10.1186/s12880-024-01292-7

PMID: https://pubmed.ncbi.nlm.nih.gov/38734629

Publication Date: 2024-05-11

Enhancing brain tumor detection in MRI

Check for updates images through explainable AI using Grad-CAM with Resnet 50

Abstract

This study addresses the critical challenge of detecting brain tumors using MRI images, a pivotal task in medical diagnostics that demands high accuracy and interpretability. While deep learning has shown remarkable success in medical image analysis, there remains a substantial need for models that are not only accurate but also interpretable to healthcare professionals. The existing methodologies, predominantly deep learning-based, often act as black boxes, providing little insight into their decision-making process. This research introduces an integrated approach using ResNet50, a deep learning model, combined with Gradient-weighted Class Activation Mapping (Grad-CAM) to offer a transparent and explainable framework for brain tumor detection. We employed a dataset of MRI images, enhanced through data augmentation, to train and validate our model. The results demonstrate a significant improvement in model performance, with a testing accuracy of

Introduction

contrast, facilitating the distinction between healthy and pathological tissues. It is instrumental in assessing the tumor’s location, size, and potential impact on adjacent brain structures, critical for treatment planning. However, the interpretation of MRI scans is highly reliant on the expertise of radiologists and can be time-consuming, highlighting the need for assistive technologies to improve diagnostic accuracy and efficiency.

Deep learning, a subset of machine learning, has revolutionized the field of medical image analysis, offering substantial improvements in detecting and classifying various diseases [3]. In brain tumor detection, deep learning algorithms can analyze complex MRI data, identify patterns imperceptible to the human eye, and learn from these patterns to make accurate predictions. These algorithms, particularly convolutional neural networks (CNNs), have demonstrated their prowess in enhancing the accuracy and speed of brain tumor diagnostics, reducing the reliance on human interpretation and potentially minimizing diagnostic errors. In Fig. 1, some of visual instances of the brain tumor are shown from the dataset.

The primary objective of this research is to harness the capabilities of deep learning, specifically the ResNet50 architecture, in conjunction with Gradient-weighted Class Activation Mapping (Grad-CAM), to enhance the detection and interpretability of brain tumor diagnoses from MRI scans. This study aims to:

- Implement a deep learning model that provides state-of-the-art accuracy in detecting brain tumors from MRI images.

- Integrate Grad-CAM with the deep learning model to offer visual explanations for the model’s predictions, enhancing the interpretability and trustworthiness of the AI system.

- Evaluate the model’s performance using a comprehensive set of metrics, ensuring its reliability and applicability in a clinical setting.

- Contribute to the body of knowledge by providing insights into how AI can be made more transparent and assistive in medical diagnostics, particularly in the context of brain tumor detection.

Related work

Deep learning, particularly convolutional neural networks (CNNs), has revolutionized the field of medical imaging. Unlike traditional machine learning, deep learning eliminates the need for manual feature extraction, allowing the model to learn features directly from the data. This capability has been particularly transformative in brain tumor detection [5], where the intricate and varied nature of tumors necessitates a nuanced analysis.

Studies utilizing deep learning for brain tumor detection have shown remarkable success. CNNs, for instance, have been extensively used to classify and segment brain tumors in MRI scans [6, 7], achieving substantial improvements in accuracy compared to previous methodologies. Some research has also explored the use of transfer learning, where pre-trained models on large datasets are fine-tuned for specific medical imaging tasks, yielding impressive results even with relatively small datasets [8].

Despite these advancements, a critical limitation of deep learning models in medical imaging, particularly in brain tumor detection, is their “black box” nature. The complex architectures of these models make it challenging to understand the reasoning behind their predictions, which is a significant barrier to their acceptance and implementation in clinical settings [9]. In Table 1 a summary of different studies has been given.

Furthermore, many existing studies focus predominantly on model accuracy, often overlooking the aspect of generalizability. It is crucial for models to not only perform well on the data they were trained on but also maintain their performance across diverse and unseen datasets.

influence the model’s decision, thereby offering a window into the model’s “thought process.” This approach not only aims to enhance the model’s interpretability but also strives to build trust among clinicians by providing a transparent AI tool that can assist in diagnostic decisions [20].

Methodology

Description of the dataset

Figure 4 presents the data distribution.

The dataset includes a diverse range of images to encompass various tumor types, sizes, and locations, aiming to enhance the model’s generalizability. It contains thousands of images, split into training, validation, and test sets. The training set is used to train the model, the validation set to tune the hyperparameters and prevent overfitting, and the test set to evaluate the model’s performance on unseen data.

Data preprocessing steps

| Study | Objective | Summary |

| Patil & Kirange, (2023) [10] | Design a deep ensemble model to improve the accuracy of multiclass classification for brain tumors using MRI scans, addressing the challenges of tumor localization and classification. | Presents a deep ensemble model combining SCNN and VGG16 networks for brain tumor classification from MRI scans, achieving 97.77% accuracy and addressing issues of overfitting and dataset imbalance. |

| Woźniak et al., (2023) [11] | Introduce a CLM to enhance the efficiency of deep neural network architectures, particularly for evaluating CT brain scans. | Presents a CLM model integrating support neural network with CNN for faster learning and higher efficiency, achieving approximately 96% accuracy in CT brain scan evaluation. |

| Abdusalomov et al., (2023) [12] | Enhance brain tumor detection using an improved YOLOv7 model with image enhancement, data augmentation, and feature fusion techniques. | Introduces a refined YOLOv7 model for accurate detection of brain tumors in MRI scans, achieving competitive performance and demonstrating potential usefulness in medical applications. |

| Mahmud et al., (2023) [13] | Develop a CNN architecture for efficient brain tumor detection from MR images, comparing its performance with established models. | Proposes a CNN architecture for brain tumor detection from MR images, achieving superior performance compared to established models with

|

| Asad et al., (2023) [14] | Develop an automatic system for early detection of brain tumors using a deep CNN with SGD optimization algorithm. | Employs a deep CNN with SGD optimization for brain tumor detection, outperforming baseline methods and suggesting potential for other diseases. |

| Kanchanamala et al., (2023) [15] | Develop an accurate brain tumor detection and classification system using ExpDHO-based ShCNN and Deep CNN, enhancing accuracy, sensitivity, and specificity. | Proposes an approach combining ExpDHO-based ShCNN and Deep CNN for brain tumor detection and classification, achieving accuracy, sensitivity, and specificity values exceeding 0.9. |

| Aggarwal et al., (2023) [16] | Develop an improved ResNet-based approach for brain tumor segmentation in MRI images. | Presents an improved ResNet-based approach for brain tumor segmentation, achieving higher precision and accelerating the learning process. |

| Archana & Komarasamy, (2023) [17] | Evaluate the accuracy of a novel BKNN-based method for brain tumor segmentation in MRI images. | Introduces a BKNN-based method for brain tumor segmentation, aiming to improve accuracy and simplify the segmentation process. |

| Gayathri et al., (2023) [18] | Assess the effectiveness of the VGG-16 architecture in accurately detecting brain tumors through deep learning. | Evaluates the performance of VGG-16 in brain tumor detection, achieving 94% accuracy after hyperparameter optimization. |

| Haq et al., (2023) [19] | Develop efficient CNN-based techniques for brain tumor identification and classification from MRI data. | Presents CNN-based techniques for brain tumor identification and classification using MRI data, achieving high accuracy and leveraging conditional random fields for fine segmentation. |

| Original | Augmented | |

| Tumor | 155 | 1240 |

| No Tumor | 98 | 784 |

the intensity values of MRI images onto a uniform scale.

reliability of the dataset are upheld, ensuring that subsequent stages of model development are founded upon a robust and representative data sample.

Furthermore, advanced preprocessing methodologies may encompass the utilization of sophisticated algorithms for image registration, segmentation, and artifact correction. Image registration facilitates the spatial alignment of MRI scans from different subjects or time points onto a common anatomical template, enabling meaningful inter-subject comparisons and longitudinal analyses. Segmentation algorithms delineate regions of interest within the brain, facilitating precise delineation of tumor boundaries and enabling quantitative characterization of tumor morphology and volume. Additionally, artifact correction strategies leverage advanced signal processing techniques to mitigate the effects of noise, distortion, or other imaging artifacts, thereby preserving data fidelity.

The preprocessing of MRI images is a pivotal step in ensuring that the input data is conducive to the learning process of deep learning models. Each preprocessing step is deliberately chosen and applied to optimize the model’s ability to detect brain tumors with high accuracy and reliability.

All MRI images are resized to a standard dimension to ensure uniformity in input size for the model. This is essential because convolutional neural networks (CNNs) require a fixed input size. Rescaling the pixel values to a range of 0 to 1 assists in stabilizing the training process as it normalizes the gradient updates during backpropagation, leading to faster convergence. MRI images can vary in contrast and brightness due to different scanning protocols. Intensity normalization brings all images to a common intensity scale, which helps the model focus on structural information rather than variations caused by the imaging process. This step is crucial for improving the model’s sensitivity to the actual pathological features of

brain tumors. The removal of images with artifacts, such as motion blur or scanner-induced noise, is necessary to prevent the model from learning irrelevant or misleading features. Clean datasets enhance the model’s ability to generalize by learning from high-quality, artifact-free images. Data augmentation, including rotation, flipping, scaling, and elastic deformations, artificially expands the dataset and introduces a variety of transformations that the model might encounter in real-world scenarios. This is particularly important for medical imaging tasks, as it simulates variability in tumor appearance and location, thereby enhancing the model’s robustness and ability to generalize.

Data Augmentation Techniques

techniques becomes imperative to bolster the dataset’s richness, thereby augmenting the model’s robustness and generalization capabilities. These augmentation methodologies encompass a range of transformative processes, each designed to introduce diverse variations reflective of real-world tumor scenarios. Rotation serves as a foundational technique, facilitating the generation of images from multiple angles to emulate the diverse perspectives encountered in clinical imaging [20]. In Fig. 5 some augmented images are shown.

In conjunction, flipping operations horizontally and vertically diversify image orientations, effectively mimicking the varying spatial arrangements of tumors within the brain. Scaling manipulations further contribute by resizing images to simulate the spectrum of tumor sizes encountered in clinical practice, thereby enhancing the model’s ability to discern tumors of varying dimensions. Translation operations, both vertically and horizontally, spatially displace images to train the model in tumor localization, regardless of their position within the brain. Figure 6 shows one image after different steps.

the range of imaging conditions encountered in clinical settings, ensuring the model’s adaptability to diverse scanning environments. Collectively, these augmentation strategies transcend mere dataset expansion, imbuing the dataset with a comprehensive representation of tumor diversity crucial for robust model training.

Overview of the Deep Learning Model (ResNet50) and its relevance

ResNet50, a prominent convolutional neural network architecture, is characterized by its depth and intricate design elements tailored to facilitate rich feature extraction and gradient propagation. Comprising 50 layers, ResNet50 integrates convolutional layers, rectified linear unit (ReLU) (Eq. 2) activation layers, batch normalization layers, and fully connected layers. Equations 3,10 consists of the various equations used in the model building process.

ResNet50 emerges as a pivotal tool owing to its deep architecture and adeptness in extracting intricate features from medical imaging data. Leveraging its hierarchical feature learning capabilities, ResNet50 excels in discerning subtle and complex patterns within MRI images that signify the presence of tumors. Moreover, the application of transfer learning augments its utility in medical imaging tasks, where limited dataset sizes pose challenges for training deep networks from scratch. By pre-training on extensive datasets like ImageNet and subsequently finetuning on MRI images, ResNet50 harnesses the knowledge of generic features acquired from larger datasets to adapt to the nuances of tumor detection, thereby enhancing its performance and generalization capacity.

Furthermore, the integration of interpretability techniques such as Gradient-weighted Class Activation Mapping (Grad-CAM) with ResNet50 contributes to its utility in clinical settings. This methodology enables the visualization of salient regions within input images that influence the model’s decision-making process, thereby enhancing interpretability. Clinicians gain insights into the rationale behind the model’s predictions, as Grad-CAM elucidates the areas deemed indicative of tumor presence. This not only bolsters confidence in the model’s diagnoses but also facilitates collaborative decision-making processes between clinicians and AI systems, ultimately enhancing patient care and treatment planning.

ResNet50 is adapted for the binary classification task of detecting brain tumors. The final fully connected layer of the standard ResNet50 model, typically used for 1000-class classification, is replaced with a new layer tailored to distinguish between two classes: ‘tumor’ and ‘no tumor’. This adaptation is crucial for tailoring the pre-trained model to the specific task at hand.

intricate details necessary for accurate tumor detection. Grad-CAM is then applied to the trained model, providing visual explanations that highlight the regions in the MRI images most influential to the model’s predictions, thus offering a transparent view into the model’s operational mechanics.

- A set of MRI brain images to be evaluated for the presence of brain tumors.

- Pre-trained ResNet50 model weights.

- Classification of each MRI image into ‘tumor’ or ‘no tumor’.

- Grad-CAM visualizations highlighting the regions influencing the model’s predictions.

- Data Preparation:

- Load the MRI brain image dataset.

- Normalize the image intensities and resize images to match the input size of the ResNet50 model.

- Split the dataset into training, validation, and testing sets.

- Data Augmentation (for the training set):

- Apply rotation, flipping, scaling, translation, elastic deformation, and brightness/contrast adjustments to the images in the training set to enhance model generalization.

- Model Configuration:

- Initialize the ResNet50 model. If using transfer learning, load pre-trained weights; otherwise, initialize with random weights.

- Replace the final fully connected layer with a new layer tailored for binary classification (tumor, no tumor).

- Training:

- For each epoch, iterate over the training set in batches:

- Perform a forward pass of the model to compute predictions.

- Calculate the loss using binary cross-entropy.

- Perform backpropagation to compute gradients.

- Update model weights using an optimizer (e.g., SGD or Adam).

- After each epoch, evaluate the model on the validation set to monitor performance and apply early stopping or model checkpointing as needed.

- Testing and Evaluation:

- Evaluate the final model on the test set to determine its performance using metrics such as accuracy, precision, recall, F 1 -score, and specificity.

- Generate confusion matrix and ROC curve to assess model performance in detail.

- Grad-CAM Visualization:

- For selected test images, apply Grad-CAM to generate heatmaps highlighting the regions of the image most influential to the model’s predictions.

- Overlay these heatmaps on the original images to visualize the focus areas of the model.

- Output Generation:

- Classify each image in the test set as ‘tumor’ or ‘no tumor’ based on the model’s predictions.

- Provide Grad-CAM visualizations alongside the predictions for interpretability and further analysis.

Training, validation and testing process

Batch processing is employed to partition the training dataset into manageable subsets, enabling incremental weight updates and enhancing computational efficiency. During each training iteration, a forward pass propagates data through the network, generating predictions. Following this, a backward pass, known as backpropagation, computes the gradient of the loss with respect to the network weights, facilitating weight updates by the optimizer to minimize the loss.

The training process unfolds over multiple epochs, with each epoch representing a complete pass through the entire training dataset. Techniques like dropout or L2 regularization may be employed to mitigate overfitting, ensuring the model generalizes well to unseen data.

Concurrently, the validation process occurs at the end of each epoch, where the model’s performance is evaluated on a separate validation set. This assessment offers insights into the model’s generalization capabilities and informs hyperparameter tuning decisions. Hyperparameters such as learning rate and batch size are adjusted based on performance metrics such as accuracy, precision, and recall. Furthermore, early stopping criteria may be implemented to halt training if the model’s performance on the validation set deteriorates, mitigating overfitting by preventing the model from learning noise from the training dataset. Through this iterative training and validation regimen, the ResNet50 model is honed to achieve optimal performance and reliability in the task of brain tumor detection.

The testing process for the developed deep learning model in brain tumor detection involves several rigorous steps to ascertain its reliability, effectiveness, and interpretability. Following the completion of training and validation phases, the model undergoes final evaluation using a designated test set comprising data that remains unseen during prior phases. This critical step serves to assess the model’s real-world applicability and performance under novel conditions.

Performance metrics used for evaluation

Experimentation and results

categories accurately. Precision, recall, and F1-score metrics further underscored the model’s reliability, with values nearing 100% by the eighth epoch, indicative of robust performance in identifying true positive cases while minimizing false positives and negatives. On the test set, the model exhibited an impressive accuracy of

During the validation and testing phases, the model’s performance and generalization ability were meticulously scrutinized, yielding comprehensive insights into its efficacy in brain tumor detection. Validation accuracy emerged as a pivotal metric, with the model achieving a remarkable peak accuracy of

medical diagnostics. In the subsequent testing phase, the model exhibited a commendable accuracy of

Figure 9 depicts the confusion matrix of the proposed model.

Cohen’s Kappa and F2 Score value is shown in Table 5.

Cohen’s Kappa and F2 Score has been depicted epoch wise in Fig. 11.

The amalgamation of quantitative metrics and qualitative Grad-CAM visualizations furnished a comprehensive evaluation framework, elucidating the model’s efficacy in brain tumor detection while offering insights into its decision-making rationale. This multifaceted evaluation not only substantiated the model’s diagnostic accuracy but also augmented its transparency and trustworthiness, paramount for garnering acceptance and adoption in clinical settings.

Discussion

| Precision | Recall | F1 Score | |

| No Tumor | 0.99 | 0.97 | 0.98 |

| Tumor | 0.98 | 0.99 | 0.99 |

| Metrics | Value |

| MSE | 0.015 |

| RMSE | 0.122 |

| MAE | 0.015 |

explanations for the model’s predictions. The previous research works carried out in this field along with the survey’s carried out signifies that grad cam is better for the model’s interpretative visualizations align with expert radiological assessments.

| Metrics | Value |

| F2 Score | 0.99 |

| Cohen’s Kappa | 0.97 |

| Study | Technique | Accuracy |

| Khan et al. (2023) [27] | Brain tumor detection using deep learning | 95.94% |

| Kumar et al. (2023) [28] | Brain tumor classification using CNN models | 96.2% |

| Hossain et al. (2023) [5] | Multiclass brain tumor classification using DL architectures | 96.94% |

| Anaya-Isaza et al. (2023) [29] | Brain tumor classification and detection using DL architectures and Cross-Transformer | 97% |

| Pillai et al. (2023) [30] | Brain tumor detection using deep transfer learning models | 91.58% |

| Sharma et al. (2023) [31] | Brain tumor detection using Modified ResNet50 with HOG features | 88% |

| Pedada et al. (2023) [32] | Brain tumor segmentation using modified U-Net with residual networks | 93.40% |

| Rahman and Islam (2023) [33] | Brain tumor classification using parallel deep convolutional neural network (PDCNN) | 97.33% |

| Proposed Model | Optimized Resnet50 with Gradcam | 98.52% |

model, with its distinctive approach to convolutional operations, outperforms other widely used architectures for this specific task. It is essential to note that the model’s architecture is not the sole determinant of performance; factors such as dataset complexity, data preprocessing, and augmentation strategies also play critical roles in achieving high accuracy and low loss in brain tumor detection algorithms.

Limitations of the dataset and implications for Generalizability

| CNN | Loss | 0.5071 |

| Accuracy | 80.16% | |

| EfficientNetB0 | Loss | 0.4281 |

| Accuracy | 86.51% | |

| Densenet201 | Loss | 0.3953 |

| Accuracy | 80.16% | |

| Inception | Loss | 0.3982 |

| Accuracy | 81.75% | |

| Xception | Loss | 0.412 |

| Accuracy | 85.71% | |

| Mobilenet | Loss | 0.3439 |

| Accuracy | 84.13% | |

| Proposed Model | Loss | 0.0702 |

| Accuracy | 98.30% |

While the present study provides valuable insights into the capabilities of deep learning for brain tumor detection, it also highlights the need for continual improvement in dataset collection and model training

methodologies. By addressing these limitations, future work can lead to more robust and widely applicable diagnostic tools, ultimately contributing to improved patient care and outcomes in the domain of medical imaging.

Ethical considerations in the deployment of AI for clinical diagnostics

Future research directions and clinical integration

Conclusion

Authors’ contributions

Funding

Availability of data and materials

Declarations

Ethics approval and consent to participate

Consent for publication

Competing interests

Published online: 11 May 2024

References

- Solanki S, et al. “Brain Tumor Detection and Classification Using Intelligence Techniques: An Overview.” IEEE Access. 2023;11:12870-86. https:// doi.org/10.1109/access.2023.3242666.

- Thenuwara G, Curtin J, Tian F. Advances in diagnostic tools and therapeutic approaches for gliomas: a comprehensive review. Sensors. 2023;23:9842.

- Thakur A, et al. Transformative breast Cancer diagnosis using CNNs with optimized ReduceLROnPlateau and Early stopping Enhancements. Int J Comput Intell Syst. 2024;17(1):14.

- Song J, et al. “Magnetic Resonance Imaging (MRI) Brain Tumor Image Classification Based on Five Machine Learning Algorithms.” Cloud Comput Data Sci. 2023, pp. 122-33. https://doi.org/10.37256/ccds. 42202 32740.

- Hossain S, et al. “Vision Transformers, Ensemble Model, and Transfer Learning Leveraging Explainable AI for Brain Tumor Detection and Classification.” IEEE J Biomed Health Informatics. 2024;28(3):1261-72. https://doi. org/10.1109/jbhi.2023.3266614.

- Saeedi S, et al. MRI-based brain tumor detection using convolutional deep learning methods and chosen machine learning techniques. BMC Med Inf Decis Mak. 2023;23(1):16.

- Anwar RW, et al. “Transfer Learning in Brain Tumor Classification: Challenges, Opportunities, and Future Prospects.” 2023 14th International Conference on Information and Communication Technology Convergence (ICTC). 2023. https://doi.org/10.1109/ictc58733.2023.10392830.

- Ullah F, et al. “Evolutionary Model for Brain Cancer-Grading and Classification.” IEEE Access. 2023;11:126182-94. https://doi.org/10.1109/access. 2023.3330919.

- Ullah F, et al. Enhancing brain tumor segmentation accuracy through scalable federated learning with advanced data privacy and security measures. Mathematics. 2023;11(19):4189.

- Patil S. Ensemble of deep learning models for brain tumor detection. Procedia Comput Sci. 2023;218:2468-79.

- Woźniak M. Jakub Siłka, and Michał Wieczorek. Deep neural network correlation learning mechanism for CT brain tumor detection. Neural Comput Appl. 2023;35(20):14611-26.

- Abdusalomov A, Bobomirzaevich M, Mukhiddinov, Taeg Keun Whangbo. Brain Tumor Detect Based deep Learn Approaches Magn Reson Imaging Cancers. 2023;15(16):4172.

- Mahmud

- Asad R , et al. Computer-aided early melanoma brain-tumor detection using deep-learning approach. Biomedicines. 2023;11(1):184.

- Kanchanamala, Pendela KG, Revathi. Belsam Jeba Ananth. Optimizationenabled hybrid deep learning for brain tumor detection and classification from MRI. Biomed Signal Process Control. 2023;84:104955.

- Aggarwal

- Archana KV, Komarasamy G. A novel deep learning-based brain tumor detection using the bagging ensemble with K-nearest neighbor. J Intell Syst. 2023;32(1):20220206.

- Gayathri P, et al. Exploring the potential of vgg-16 architecture for accurate brain tumor detection using deep learning. J Computers Mech Manage. 2023;2(2):23056-23056.

- Haq Ejaz UI, et al. “An MRI-Based Deep Learning Approach for Efficient Classification of Brain Tumors.” J Ambient Intell Humaniz Comput. 2021;14(6):6697-718. https://doi.org/10.1007/s12652-021-03535-9.

- Ullah F, et al. Brain Tumor Segmentation from MRI Images Using Handcrafted Convolutional Neural Network. Diagnostics. 2023;13(16):2650.

- Ullah F, Nadeem M. and Mohammad Abrar. Revolutionizing Brain Tumor Segmentation in MRI with Dynamic Fusion of Handcrafted Features and Global Pathway-Based Deep Learning.” KSII Trans Internet Inform Syst. 2024;18(1)- https://doi.org/10.3837/tiis.2024.01.007.

- Koonce B. “ResNet 50.” Convolutional neural networks with swift for tensorflow, 2021, pp. 63-72. https://doi.org/10.1007/978-1-4842-6168-2_6.

- Navoneel, Brain MRI Images for Brain Tumor Detection., Kaggle. https:// www.kaggle.com/datasets/navoneel/brain-mri-images-for-brain-tumordetection.

- Albalawi E, et al. Oral squamous cell carcinoma detection using EfficientNet on histopathological images. Front Med. 2024;10:1349336.

- Moteri A, Moteeb, et al. Enhancing accessibility for improved diagnosis with modified EfficientNetV2-S and cyclic learning rate strategy in women with disabilities and breast cancer. Front Med. 2024;11:1373244.

- Sannasi Chakravarthy SR, Bharanidharan N, Kumar V. Deep transfer learning with fuzzy ensemble approach for the early detection of breast cancer. BMC Med Imaging. 2024;24:82. https://doi.org/10.1186/ s12880-024-01267-8.

- Khan M , Attique, et al. Multimodal brain tumor detection and classification using deep saliency map and improved dragonfly optimization algorithm. Int J Imaging Syst Technol. 2023;33(2):572-87.

- Kavin Kumar K, et al.”Brain Tumor Identification Using Data Augmentation and Transfer Learning Approach.” Comput Syst Sci Eng. 2023;46(2):1845-61. https://doi.org/10.32604/csse.2023.033927.

- Anaya-Isaza Andrés, et al. Optimizing MRI-based brain tumor classification and detection using AI: a comparative analysis of neural networks, transfer learning, data augmentation, and the cross-transformer network. Eur J Radiol Open. 2023;10:100484.

- Pillai R, Sharma A, Sharma N, Gupta R. “Brain Tumor Classification using VGG 16, ResNet50, and Inception V3 Transfer Learning Models,” 2023 2nd International Conference for Innovation in Technology (INOCON), Bangalore, India. 2023, pp. 1-5. https://doi.org/10.1109/INOCON57975. 2023.10101252.

- Sharma A, Kumar, et al. HOG transformation based feature extraction framework in modified Resnet50 model for brain tumor detection. Biomed Signal Process Control. 2023;84:104737.

- Pedada K, Rao, et al. A novel approach for brain tumour detection using deep learning based technique. Biomed Signal Process Control. 2023;82:104549.

- Rahman T, Md Saiful Islam. MRI brain tumor detection and classification using parallel deep convolutional neural networks. Measurement: Sens. 2023;26:100694.

Publisher’s Note

- *Correspondence:

Suresh Guluwadi

suresh.guluwadi@astu.edu.et