DOI: https://doi.org/10.1186/s12903-025-05424-5

PMID: https://pubmed.ncbi.nlm.nih.gov/39799304

تاريخ النشر: 2025-01-11

تقييم تطبيقات الذكاء الاصطناعي المختلفة في الاستجابة لإجراءات علاج الجذور التجديدي

الملخص

المقدمة إن دمج تقنيات الذكاء الاصطناعي (AI) في الرعاية الصحية يحدث ثورة في سير العمل لمهنيي الرعاية الصحية، مما يمكّن من علاج المرضى بشكل أسرع وأكثر دقة. تهدف هذه الدراسة إلى تقييم دقة الردود المقدمة من قبل روبوتات الدردشة المختلفة للذكاء الاصطناعي على الأسئلة التي قد يطرحها أطباء الأسنان بشأن علاج الجذور التجديدية (RET)، وهو إجراء يظهر إمكانات شفاء بيولوجية واعدة. الطرق تم تطوير ما مجموعه 23 سؤالًا يتعلق بإجراءات RET بناءً على إرشادات الجمعية الأمريكية لأطباء الأسنان (AAE) لعام 2022. تم تقديم هذه الأسئلة لثلاث منصات: Google Bard (Gemini)، ChatGPT-4o، وChatGPT-4 مع مكون PDF. تم طرح الأسئلة ثلاث مرات في اليوم على مدار 10 أيام من قبل باحثين مختلفين. تم تصنيف الردود التي تم الحصول عليها على أنها صحيحة أو غير صحيحة أو غير كافية وفقًا للإرشادات، وتم تحليل النتائج إحصائيًا. النتائج تم جمع ما مجموعه 1,380 ردًا من المنصات الثلاث. كشفت التحليلات الإحصائية عن علاقات مهمة بين الردود المقدمة من المنصات خلال جلسات الصباح والظهر والمساء (

المقدمة

الصور، والصوت، وهي من بين نماذج LLM متعددة الوسائط التي تهدف إلى توفير تفاعل ووظائف أوسع للمستخدمين [4، 5]. تم إصدار أحدث نموذج LLM متعدد الوسائط من OpenAI، GPT-4o، في مايو 2024 [6]. بالإضافة إلى معالجة وفهم أنواع البيانات المختلفة، يمكن لـ GPT-4o أيضًا تفسير المشاعر من مقاطع الفيديو، مشابهًا لـ Gemini، مما يساهم في معدل نجاحه العالي [7،8]. تشمل النسخ المدفوعة مثل ChatGPT Plus، التي تقدم وصولاً غير محدود وميزات إضافية، مكون PDF الذي يمكّن المستخدمين من تفسير وتحليل واستخراج معلومات حيوية من ملفات PDF بشكل أكثر فعالية [9].

لقد تطور استخدام الذكاء الاصطناعي في الرعاية الصحية منذ الخمسينيات، عندما تم استخدام أجهزة الكمبيوتر لأول مرة لتحليل البيانات الطبية والمساعدة في التشخيص، إلى أنظمة طبية متقدمة اليوم مزودة بخوارزميات التعلم العميق ومعدلات دقة عالية [10]. تعزز تطبيقات الذكاء الاصطناعي في الرعاية الصحية الآن فعالية وكفاءة الخدمات الطبية من خلال تطبيقات مثل التحليل التشخيصي وتحليل الصور، وتخطيط العلاج الشخصي، ومراقبة المرضى، وتقييم مخاطر الأمراض [11]. في علاج الجذور، يتم استخدام الذكاء الاصطناعي لأغراض مثل الكشف الشعاعي عن الآفات المحيطية، وتحديد كسور التاج و/أو الجذر، وتقييم شكل وعدد قنوات الجذر، وتحديد نقاط إنهاء الجذر في الأشعة السينية، وتوقع نتائج العلاج [12، 13]. ومع ذلك، لا تزال بعض المخاوف قائمة بشأن استخدام الذكاء الاصطناعي في علاج الجذور. قد يؤدي الاعتماد المفرط على الذكاء الاصطناعي من قبل الأطباء إلى مشاكل إذا ارتكب نظام الذكاء الاصطناعي أخطاء [14]. نظرًا لتنوع علاجات الجذور (ET)، من المهم البحث في موثوقية ودقة تطبيقات الذكاء الاصطناعي التي تساعد الأطباء أثناء العلاج [15].

يتم تعريف RET على أنه “إجراءات قائمة على البيولوجيا تهدف إلى استبدال الهياكل التالفة، بما في ذلك العاج، وهياكل الجذر، وخلايا مركب اللب والعاج” [16]. حاليًا، يتم استخدام RET بشكل متزايد لعلاج الأسنان غير الناضجة التي تعاني من نخر اللب والتهاب اللثة القمي، بهدف استعادة حيوية نسيج اللب الضام، والقضاء على العلامات والأعراض لإغلاق القمة، وتحسين الشفافية الشعاعية المحيطية، وتثخين جدران قنوات الجذر، واستمرار تطوير الجذر [17، 18]. يوفر RET شفاءً بيولوجيًا أكثر مقارنة بعلاجات ET التقليدية بسبب قدرته على تعزيز إصلاح الأنسجة وتجديدها، مما يجعله خيار علاج قيم [19]. كشفت تحليل البيانات الذي أجراه كونتاكيوتيس وآخرون في عام 2015 حول البروتوكولات السريرية عن اختلافات كبيرة في بروتوكولات RET عبر جميع الدراسات التي تم فحصها. يمكن أن تؤدي الاختلافات في بروتوكولات العلاج إلى نتائج علاجية مختلفة [19]. أوصت AAE بدليل بعنوان “الاعتبارات السريرية لإجراء تجديدي” لمساعدة الأطباء في إجراء علاج الجذور التجديدي للأسنان الدائمة غير الناضجة ذات اللب النخر أو التهاب اللثة القمي. من الضروري

أن يتبع الأطباء الإرشادات الموصى بها من AAE عند إجراء RET. على الرغم من الاستخدام المتزايد للذكاء الاصطناعي في الرعاية الصحية، هناك دراسات محدودة في الأدبيات تبحث فيما إذا كانت روبوتات الدردشة للذكاء الاصطناعي يمكن أن تقدم ردودًا دقيقة على الأسئلة في مجال علاج الجذور [15، 21، 22]. علاوة على ذلك، لم يتم حتى الآن دراسة دقة ردود روبوتات الدردشة للذكاء الاصطناعي المتعلقة بشكل خاص بعلاج الجذور التجديدية. تهدف هذه الدراسة إلى تقييم دقة الردود التي تولدها روبوتات الدردشة المختلفة للذكاء الاصطناعي على الأسئلة التي قد يطرحها أطباء الأسنان بشأن إجراءات RET. الفرضية H1 لهذه الدراسة هي “من حيث الحصول على إجابات دقيقة على الأسئلة المتعلقة بإجراءات RET، فإن ChatGPT-4 مع مكون PDF يتفوق على نماذج اللغة ChatGPT-4o وGemini.”

الطرق

- تصميم السؤال: تم تطوير جميع الأسئلة بناءً على إرشادات الجمعية الأمريكية لأطباء الأسنان (AAE) لعام 2022، لضمان الدقة العلمية والملاءمة السريرية.

- الملاءمة السريرية: ركزت الأسئلة على الجوانب العملية لعلاج الجذور التجديدية (RET)، مثل جدوى الإجراءات، والأساس البيولوجي، والمضاعفات، واختيار المرضى.

- مراجعة الخبراء: قام اثنان من المتخصصين في علاج الجذور بتقييم الأسئلة وتنقيحها لضمان دقتها وقابليتها للتطبيق.

- نهج مركز: أكدت الدراسة على نقاط القرار الرئيسية، مثل اختيار المواد وتسلسل الإجراءات، بدلاً من معالجة النطاق الكامل لـ RET.

2- هل يمكن إجراء علاج جذور الأسنان التجديدي في الأسنان ذات اللب النخرى وقمة غير ناضجة مع دلالة لبية؟ نعم أم لا؟

3- هل يمكن اعتبار الألم بعد علاج جذور الأسنان التجديدي تأثيرًا جانبيًا؟ نعم أم لا؟

4- هل يتطلب علاج جذور الأسنان التجديدي موعدين أو أكثر؟ نعم أم لا؟

5- هل علاج جذور الأسنان التجديدي هو الخيار العلاجي الوحيد للأسنان غير الناضجة ذات اللب النخرى؟ نعم أم لا؟

6- ما هو محلول التخدير الذي يجب استخدامه في علاج جذور الأسنان التجديدي؟

7- ما هي محاليل الري المستخدمة في علاج جذور الأسنان التجديدي؟

8- ما يجب أن تكون تركيز محلول NaOCl في علاج جذور الأسنان التجديدي؟

9- هل يتم استخدام هيبوكلوريت الصوديوم (NaOCl) في الجلسة الثانية من علاج جذور الأسنان التجديدي؟ نعم أم لا؟

10- كم يجب أن تكون مدة ري قناة الجذر لكل محلول في علاج جذور الأسنان التجديدي؟

11- ما هي الأدوية التي يجب استخدامها في قنوات الجذر بين المواعيد في علاج جذور الأسنان التجديدي؟

12- كم يجب أن تكون الفترة بين المواعيد في علاج جذور الأسنان التجديدي؟

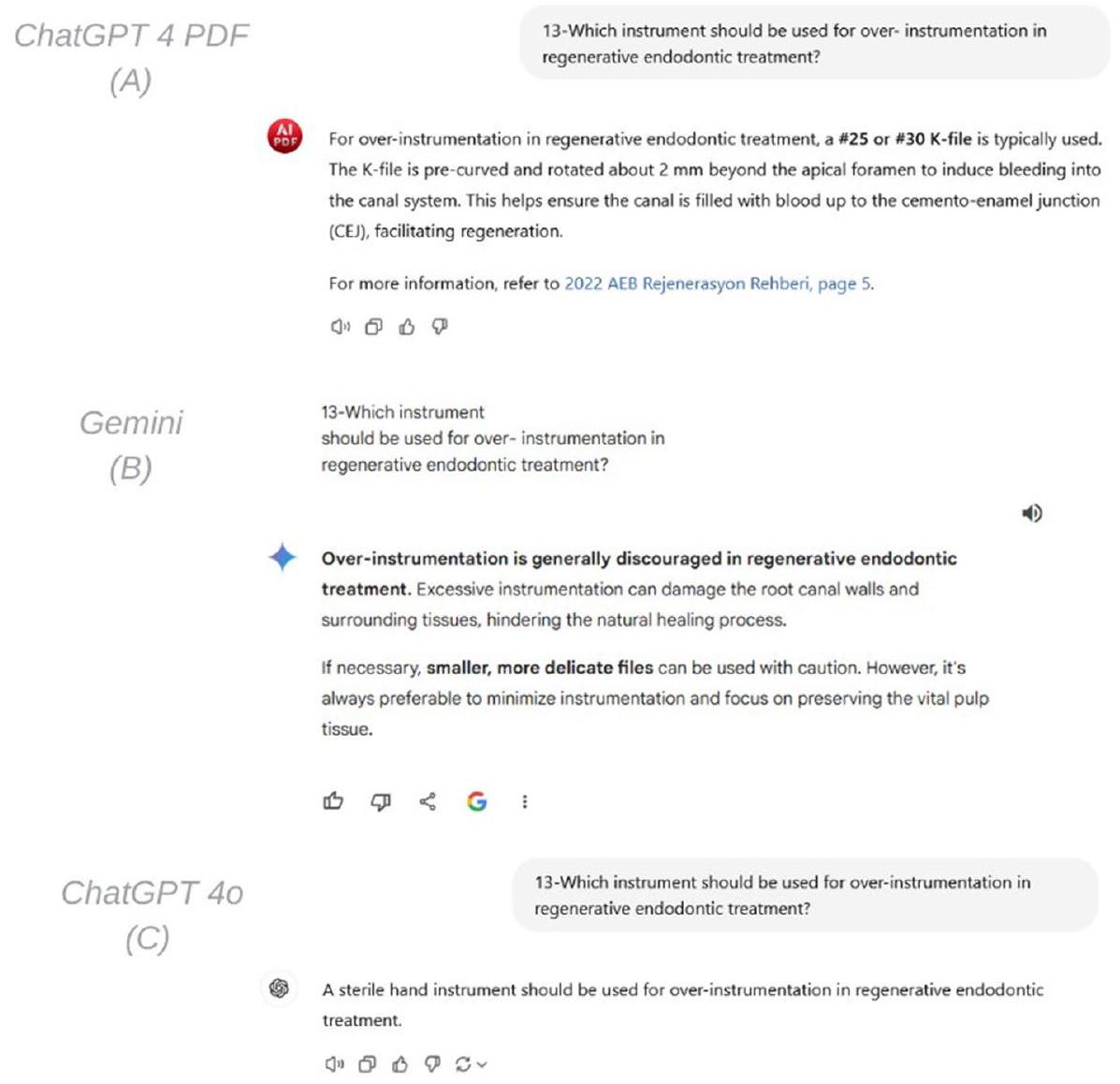

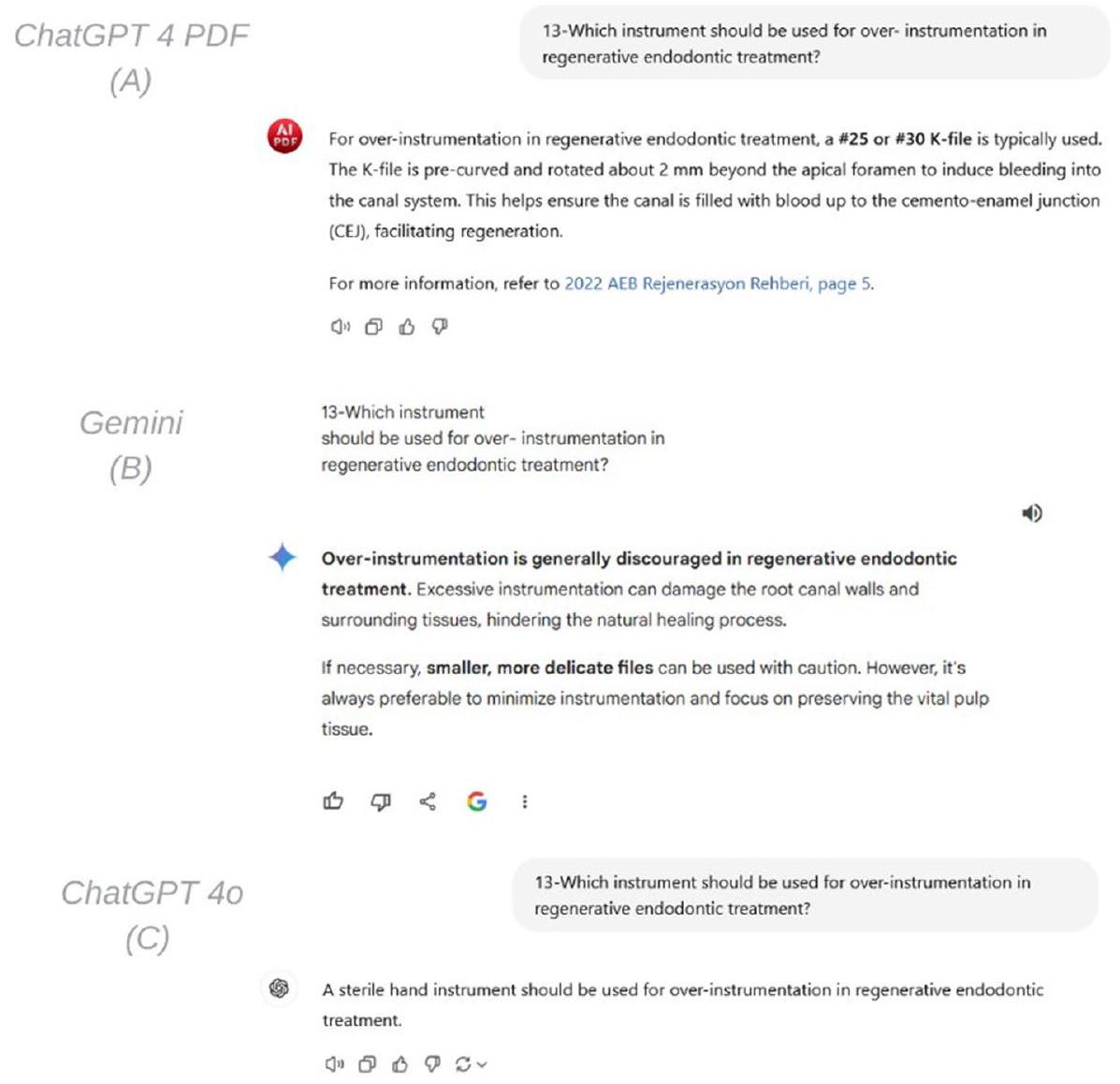

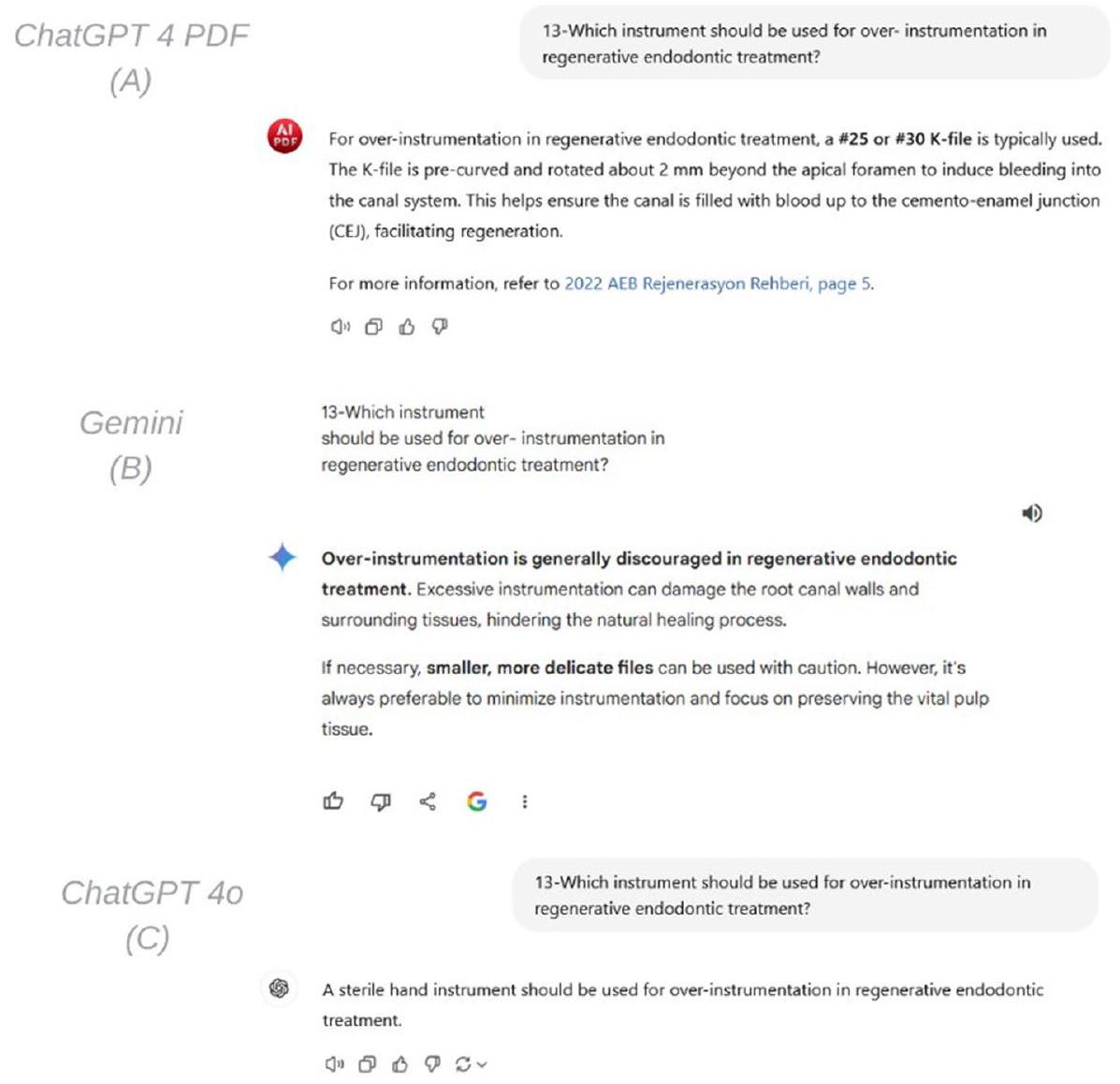

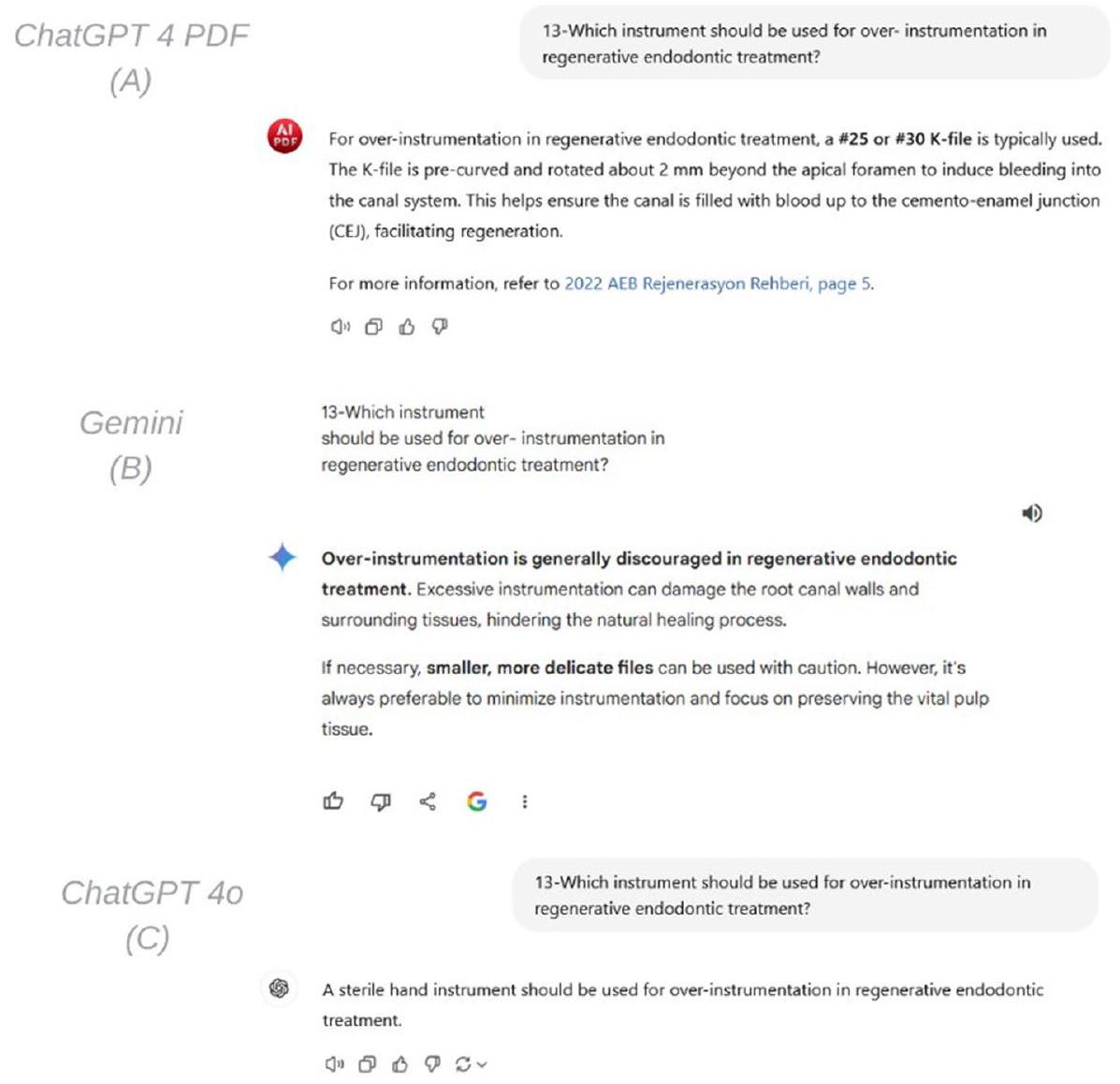

14- ماذا يمكن استخدامه كبديل في علاج جذور الأسنان التجديدي إذا لم يكن بالإمكان تحفيز النزيف بواسطة التجاوز؟

15- ماذا يمكن استخدامه كمواد تغطية لبية في علاج جذور الأسنان التجديدي؟

16- كم يجب أن تكون سماكة مادة تغطية اللب على الجلطة الدموية في علاج جذور الأسنان التجديدي؟

17- هل يجب إجراء موعد علاج إضافي إذا كانت هناك أعراض في الموعد الثاني من علاج جذور الأسنان التجديدي؟ نعم أم لا؟

18- إذا كان يجب استخدام مادة بين الجلطة الدموية في نظام القناة وMTA في علاج جذور الأسنان التجديدي، فما المادة التي يمكن استخدامها؟

19- هل CBCT ضروري تمامًا في موعد المتابعة لعلاج جذور الأسنان التجديدي؟ نعم أم لا؟

20- ما هي مدة موعد المتابعة بعد علاج جذور الأسنان التجديدي؟

21- ما هو الهدف الأساسي في علاج جذور الأسنان التجديدي؟

22- هل الاستجابة الإيجابية لاختبار حيوية اللب هي هدفنا الأساسي في علاج جذور الأسنان التجديدي؟ نعم أم لا؟

23- ما هي معايير النجاح لسن التي خضعت لعلاج جذور الأسنان التجديدي؟

bناءً على معايير الإرشادات. في نهاية فترة العشرة أيام، تمت مقارنة كل استجابة مع الإجابات الصحيحة الموضحة في الإرشادات. تم تطبيق اختبارات Pearson ChiSquare لتحليل توزيع الإجابات وتقييم العلاقات بين المنصات.

النتائج

أظهر التحليل أن ChatGPT-4o قدمت

من خلال تقديم

المناقشة

| الوقت | البرنامج |

|

% |

|

% |

|

% |

|

| صباحًا | جمنائي | 217 | 47.2 | 83 | 18.0 | 160 | 34.8 | <0.001* |

| ChatGpt 4 PDF | 453 | 98.5 | 0 | 0.0 | 7 | 1.5 | ||

| ChatGpt 4o | 393 | 85.2 | 17 | 3.7 | 51 | 11.1 | ||

| ظهرًا | جمنائي | 211 | 47.1 | 75 | 16.7 | 162 | 36.2 | <0.001* |

| ChatGpt 4 PDF | 448 | 97.4 | 0 | 0.0 | 12 | 2.6 | ||

| ChatGpt 4o | 398 | 86.3 | 13 | 2.8 | 50 | 10.8 | ||

| مساءً | جمنائي | 231 | 49.8 | 82 | 17.7 | 151 | 32.5 | <0.001* |

| ChatGpt 4 PDF | 453 | 98.5 | 0 | 0.0 | 7 | 1.5 | ||

| ChatGpt 4o | 397 | 87.1 | 10 | 2.2 | 49 | 10.7 | ||

| الإجمالي | جمنائي | 659 | 48.0 | 240 | 17.5 | 473 | 34.5 | <0.001* |

| ChatGpt 4 PDF | 1354 | 98.1 | 0 | 0.0 | 26 | 1.9 | ||

| ChatGpt 4o | 1188 | 86.2 | 40 | 2.9 | 150 | 10.9 |

الحد الأدنى من دقة تطبيقات الذكاء الاصطناعي في عمليات اتخاذ القرار السريري مقبول عمومًا أن يكون على الأقل

استنادًا إلى هذه النتائج، تم قبول فرضية H1 للدراسة. وفقًا لنتائج دراستنا، بغض النظر عن النسخة، أظهر ChatGPT الذي طورته OpenAI مستوى أعلى من الدقة مقارنة بـ Gemini. تتماشى هذه النتيجة مع نتائج دراسة أجراها دوسي وآخرون [30]، التي قارنت بين نسخ Gemini وChatGPT لتبسيط تقارير الأشعة.

في دراسة أجراها دياث-فلوريس غارسيا وآخرون [22]، تم فحص دقة استجابات Gemini لأسئلة التشخيص والعلاج في مجال علاج الجذور، ووجد أن فقط

تم تفضيل تنسيقات أسئلة متنوعة مثل الاختيار من متعدد [31، 32]، والأسئلة المفتوحة [33]، والثنائية (نعم/لا) [15، 21] في الدراسات التي أجريت مع الدردشة الآلية الذكية. قام أوزدن وآخرون [15] بتقييم استجابات الدردشة الآلية لـ 25 سؤالًا متعلقًا بإصابات الأسنان بناءً على إرشادات الجمعية الدولية لعلاج إصابات الأسنان ووجدوا معدل استجابة صحيحة قدره

وآخرون [15]، تم طرح أسئلة ثنائية على الدردشة الآلية، بينما في دراستنا، تم استخدام كل من الأسئلة الثنائية والمفتوحة حسب الحالة السريرية. السبب في عدم اختيار الأسئلة بتنسيق ثنائي فقط هو أن هذا التنسيق لا يعكس الطبيعة متعددة الأوجه للممارسة السريرية وضرورة النظر في مجموعة من الاحتمالات والعوامل عند اتخاذ القرارات في العيادة [34]. يُعتقد أن الأداء المحسن لـ ChatGPT في دراستنا ناتج عن حقيقة أن النسخة المستخدمة في دراستنا (Chat-GPT-4o) تحتوي على قاعدة بيانات أكثر تقدمًا وهي نموذج أكثر تطورًا كنموذج لغوي متعدد الوسائط مقارنةً بالنسخة المستخدمة في الدراسات الأخرى (ChatGPT-3.5).

وبالمثل، في بعض الدراسات [21، 22]، تم استخدام إرشادات علمية دولية نشرتها جمعيات علمية دولية في كل من إعداد الأسئلة وتقييم الاستجابات التي تم الحصول عليها، مما يضمن الدقة العلمية. بينما تم إعداد الأسئلة في الدراسة في ضوء الإرشادات، تم أخذ الجوانب التي من المحتمل أن يواجهها الأطباء أثناء RET بعين الاعتبار. ومع ذلك، قد لا يكون من الممكن للأطباء صياغة هذه الأسئلة دون أي معرفة مسبقة حول RET. هذا الجانب هو قيد مهم في دراستنا. كونه مجالًا متخصصًا للغاية، يمكن أن يتم RET بدقة فقط من قبل الأطباء الذين لديهم خبرة متقدمة. علاوة على ذلك، من الواضح أنه بدون معرفة كافية وخبرة، لا يمكن تنفيذ هذا العلاج بشكل فعال. بالإضافة إلى ذلك، من المهم ملاحظة أن الدردشة الآلية الذكية المستخدمة في هذه الدراسة هي نماذج لغوية مصممة للجمهور العام ولم يتم تدريبها بشكل خاص في مجال علاج الجذور. قد يكون هذا قد أدى إلى بعض التحيزات في الاستجابات المقدمة، وهو قيد آخر في دراستنا. للتغلب على هذا القيد، يمكن اقتراح تطوير نماذج بيانات ذكاء اصطناعي متخصصة أعدها أطباء علاج الجذور.

الاستنتاجات

الاختصارات

| الذكاء الاصطناعي | الذكاء الاصطناعي |

| RET | علاج الجذور التجديدي |

| AAE | الرابطة الأمريكية لأطباء علاج الجذور |

| LLMs | نماذج اللغة الكبيرة |

| ChatGPT | الدردشة التوليدية المدربة مسبقًا |

| NLP | معالجة اللغة الطبيعية |

| ET | علاجات الجذور |

الشكر والتقدير

مساهمات المؤلفين

التمويل

توفر البيانات

الإعلانات

موافقة الأخلاقيات والموافقة على المشاركة

الموافقة على النشر

المصالح المتنافسة

تم النشر عبر الإنترنت: 11 يناير 2025

References

- Deng L. Artificial intelligence in the rising wave of deep learning: the historical path and future outlook [perspectives]. IEEE Signal Process Mag. 2018;35(1):180-177. https://doi.org/10.1109/MSP.2017.2762725.

- Xu Y, Hu L, Zhao J, Qiu Z, Ye Y, Gu H. A survey on multilingual large language models: corpora, alignment, and bias. arXiv Preprint arXiv:2404 00929. 2024. https://doi.org/10.48550/arXiv.2404.00929.

- Ghanem YK, Rouhi AD, Al-Houssan A, Saleh Z, Moccia MC, Joshi H, et al. Dr. Google to Dr. ChatGPT: assessing the content and quality of artificial intelligence-generated medical information on appendicitis. Surgical Endoscopy. 2024;38(5):2887-93. https://doi.org/10.1007/ s00464-024-10739-5.

- Team G, Anil R, Borgeaud S, Wu Y, Alayrac JB, Yu J, et al. Gemini: a family of highly capable multimodal models. arXiv preprint arXiv:2312.11805. 2023. https://doi.org/10.48550/arXiv.2312.11805.

- Saab, K., Tu, T., Weng, W. H., Tanno, R., Stutz, D., Wulczyn, E., et al. Capabilities of gemini models in medicine. 2024. arXiv preprint arXiv:2404.18416. https://doi.org/10.48550/arXiv.2404.18416.

- Kerner SM. GPT-4o explained: everything you need to know. 2024. https://www.techtarget.com/whatis/feature/GPT-4o-explained-Every thing-you-need-to-know. Accessed 26 May 2024.

- OpenAI, Hello GPT-4o. https://openai.com/index/hellogpt-4o/. Accessed 10-06-2024.

- Doyle K. ‘The o is for omni’ and other things you should know about GPT4o. https://www.jasper.ai/blog/what-is-gpt-4o. Accessed 26 May 2024.

- TechJunkie, ChatGPT: How to Upload and Analyze PDFs. 2024. https:// www.techjunkie.com/chatgpt-how-to-upload-analyze-pdfs/?utm_ source=chatgpt.com. Accessed 8 Jan 2025.

- King MR. The future of AI in medicine: a perspective from a Chatbot. Ann Biomed Eng. 2023;51(2):291-5. https://doi.org/10.1007/ s10439-022-03121-w.

- Rodrigues JA, Krois J, Schwendicke F. Demystifying artificial intelligence and deep learning in dentistry. Braz Oral Res. 2021;35: e094. https://doi. org/10.1590/1807-3107bor-2021.vol35.0094.

- Lai G, Dunlap C, Gluskin A, Nehme WB, Azim AA. Artificial intelligence in endodontics. J Calif Dent Assoc. 2023;51(1): 2199933. https://doi.org/10. 1080/19424396.2023.2199933.

- Ahmed ZH, Almuharib AM, Abdulkarim AA, Alhassoon AH, Alanazi AF, Alhaqbani MA, et al. Artificial intelligence and its application in endodontics: a review. J Contemp Dent Pract. 2024;24(11):912-7. https://doi.org/ 10.5005/jp-journals-10024-3593.

- Umer F, Khan M. A call to action: concerns related to artificial intelligence. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;132(2):255. https://doi. org/10.1016/j.oooo.2021.04.056.

- Ozden I, Gokyar M, Ozden ME, Ovecoglu S. Assessment of artificial intelligence applications in responding to dental trauma. Dent Traumatol. 2024. https://doi.org/10.1111/edt.12965.

- Murray PE, Garcia-Godoy F, Hargreaves KM. Regenerative endodontics: a review of current status and a call for action. J Endod. 2007;33(4):377-90. https://doi.org/10.1016/j.joen.2006.09.013.

- Diogenes A, Henry MA, Teixeira FB, Hargreaves KM. An update on clinical regenerative endodontics. Endodontic Top. 2013;28(1):2-23. https://doi. org/10.1111/etp.12040.

- Kontakiotis EG, Filippatos CG, Tzanetakis GN, Agrafioti A. Regenerative endodontic therapy: a data analysis of clinical protocols. J Endod. 2015;41(2):146-54. https://doi.org/10.1016/j.joen.2014.08.003.

- EzEldeen M, De Piero MNSP, Xu L, Driesen RB, Wyatt J, Van Gorp G, et al. Multimodal imaging of dental pulp healing patterns following tooth autotransplantation and regenerative endodontic treatment. J Endod. 2023;49(8):1058-72. https://doi.org/10.1016/j.joen.2023.06.003.

- Kim SG, Malek M, Sigurdsson A, Lin LM, Kahler B. Regenerative endodontics: a comprehensive review. Int Endod J. 2018;51(12):1367-88. https:// doi.org/10.1111/iej.12954.

- Suárez A, Díaz-Flores García V, Algar J, Gómez Sánchez M, Llorente de Pedro M, Freire Y. Unveiling the ChatGPT phenomenon: evaluating the consistency and accuracy of endodontic question answers. Int Endod J. 2024;57(1):108-13. https://doi.org/10.1111/iej.13985.

- Díaz-Flores García V, Freire Y, Tortosa M, Tejedor B, Estevez R, Suárez A. Google gemini’s performance in endodontics: a study on answer precision and reliability. Appl Sci. 2024;14(15):6390. https://doi.org/10.3390/ app14156390.

- AAE clinical considerations for a regenerative procedure revised, https:// www.aae.org/specialty/wp-content/uploads/sites/2/2023/04/Considerat ionsForRegEndo_AsOfNov2022-4.pdf. Accessed 11-2022.

- Antaki F, Touma S, Milad D, El-Khoury J, Duval R. Evaluating the performance of ChatGPT in ophthalmology: an analysis of its successes and shortcomings. Ophthalmol Sci. 2023;3(4):100324. https://doi.org/10. 1016/j.xops.2023.100324.

- Wu S, Fei H, Qu L, Ji W, Chua TS. Next-gpt: any-to-any multimodal IIm. arXiv Preprint arXiv:2309 05519. 2023. https://doi.org/10.48550/arXiv. 2309.05519.

- Huang H, Zheng O, Wang D, Yin J, Wang Z, Ding S, et al. ChatGPT for shaping the future of dentistry: the potential of multi-modal large language model. Int J Oral Sci. 2023;15(1):29. https://doi.org/10.1038/ s41368-023-00239-y.

- Hackett C. OpenAl’s ChatGPT plus: an electronic resources librarian’s review. J Electron Resour Librariansh. 2023;35(4):299-304. https://doi.org/ 10.1080/1941126X.2023.2271373.

- Labkoff S, Oladimeji B, Kannry J, Solomonides A, Leftwich R, Koski E, et al. Toward a responsible future: recommendations for AI-enabled clinical decision support. J Am Med Inform Assoc. 2024:ocae209. https://doi.org/ 10.1093/jamia/ocae209.

- Vollmer S, Mateen BA, Bohner G, Király FJ, Ghani R, Jonsson P, et al. Machine learning and artificial intelligence research for patient benefit:20 critical questions on transparency, replicability, ethics, and effectiveness. BMJ. 2020;368. https://doi.org/10.1136/bmj.l6927.

- Doshi R, Amin K, Khosla P, Bajaj S, Chheang S, Forman HP. Utilizing large language models to simplify radiology reports: a comparative analysis of ChatGPT3. 5, ChatGPT4. 0, Google Bard, and Microsoft Bing. medRxiv. 2023;2023-06. https://doi.org/10.1101/2023.06.04.23290786.

- Asker ÖF, Özgür EG, Eriç A, Bekiroğlu N. Comparing the performance of medical students, ChatGPT-3.5 and ChatGPT-4 in biostatistics exam: pros and cons as an education assistant. Uluslararası Yönetim Bilişim Sistemleri ve Bilgisayar Bilimleri Dergisi. 2023;7(2):85-94. https://doi.org/10.33461/ uybisbbd. 1329650.

- Ali K, Barhom N, Marino FT, Duggal M. The thrills and chills of ChatGPT: implications for assessments in undergraduate dental education. 2023. https://doi.org/10.20944/preprints202302.0513.v1.

- Azadi A, Gorjinejad F, Mohammad-Rahimi H, Tabrizi R, Alam M, Golkar M. Evaluation of AI-generated responses by different artificial intelligence chatbots to the clinical decision-making case-based questions in oral and maxillofacial surgery. Oral Surg Oral Med Oral Pathol Oral Radiol. 2024;137(6):587-93. https://doi.org/10.1016/j.oooo.2024.02.018.

- Giordano C, Brennan M, Mohamed B, Rashidi P, Modave F, Tighe P. Accessing artificial intelligence for clinical decision-making. Front Digit Health. 2021;3: 645232. https://doi.org/10.3389/fdgth.2021.645232.

ملاحظة الناشر

- *المراسلة:

بارلا ميفا دورماز بينار

parlamewa@hotmail.com

قسم علاج الجذور، كلية طب الأسنان، جامعة مرمرة، باصيبويك، طريق باصيبويك جامعة مرمرة باصيبويك الصحية 9/3، باصيبويك – مالتيب، صندوق بريد: 34854، إسطنبول، تركيا

DOI: https://doi.org/10.1186/s12903-025-05424-5

PMID: https://pubmed.ncbi.nlm.nih.gov/39799304

Publication Date: 2025-01-11

Evaluation of different artificial intelligence applications in responding to regenerative endodontic procedures

Abstract

Introduction The integration of artificial intelligence (AI) technologies in healthcare is revolutionizing the workflows of healthcare professionals, enabling faster and more accurate patient treatment. This study aims to evaluate the accuracy of responses provided by different AI chatbots to questions that dentists might ask regarding regenerative endodontic treatment (RET), a procedure that shows promising biological healing potential. Methods A total of 23 questions related to RET procedures were developed based on the American Association of Endodontists (AAE) 2022 guidelines. These questions were presented to three platforms: Google Bard (Gemini), ChatGPT-4o, and ChatGPT-4 with a PDF plugin. The questions were asked three times a day over the course of 10 days by two different researchers. The responses obtained were categorized as correct, incorrect, or insufficient according to the guidelines, and the results were statistically analyzed. Results A total of 1,380 responses were collected from the three platforms. Statistical analysis revealed significant relationships between the responses given by the platforms during morning, noon, and evening sessions (

Introduction

images, and audio, is among the multimodal LLMs aimed at providing users with broader interaction and functionality [4, 5]. OpenAI’s latest multimodal LLM, GPT-4o, was released in May 2024 [6]. In addition to processing and understanding various data types, GPT-4o can also interpret emotions from videos, similar to Gemini, contributing to its high success rate [7,8]. Paid versions like ChatGPT Plus, which offer unlimited access and additional features, include a PDF plugin that enables users to interpret, analyze, and extract critical information from PDFs more effectively [9].

The use of AI in healthcare has evolved from the 1950s, when computers were first used to analyze medical data and aid in diagnosis, to today’s advanced medical systems equipped with deep learning algorithms and high accuracy rates [10]. AI applications in healthcare now enhance the effectiveness and efficiency of medical services through applications such as diagnostic and image analysis, personalized treatment planning, patient monitoring, and disease risk assessment [11]. In endodontics, AI is employed for purposes like the radiographic detection of periapical lesions, the identification of crown and/or root fractures, the evaluation of root canal morphology and numbers, the determination of apical termination points in radiographs, and the prediction of treatment outcomes [12, 13]. However, some concerns persist regarding AI usage in endodontics. Overreliance on AI by clinicians may lead to problems if the AI system makes errors [14]. Given the diversity of endodontic treatments (ET), it is important to research the reliability and accuracy of AI applications that assist clinicians during treatment [15].

RET is defined as “biologically based procedures designed to replace damaged structures, including dentin, root structures, and cells of the pulp-dentin complex” [16]. Currently, RET is increasingly used for the treatment of immature teeth with pulp necrosis and apical periodontitis, with the aim of restoring pulp connective tissue vitality, eliminating signs and symptoms for apical closure, improving periapical radiolucency, thickening root canal walls, and continuing root development [17, 18]. RET offers more biological healing compared to traditional ET due to its ability to promote tissue repair and regeneration, making it a valuable treatment option [19]. A data analysis conducted by Kontakiotis et al. in 2015 on clinical protocols revealed significant differences in RET protocols across all the examined studies. Variations in treatment protocols can result in different treatment outcomes [19]. The AAE has recommended a guide titled “Clinical Considerations for a Regenerative Procedure” to aid clinicians in performing regenerative endodontic treatment for immature permanent teeth with necrotic pulp or apical periodontitis. It is essential

for clinicians to follow the AAE’s recommended guidelines when performing RET. Despite the growing use of AI in healthcare, there are limited studies in the literature investigating whether AI chatbots can provide accurate responses to questions in the field of endodontics [15, 21, 22]. Moreover, no studies to date have examined the accuracy of AI chatbots’ responses specifically related to regenerative endodontics. This study aims to evaluate the accuracy of responses generated by different AI chatbots to questions that dentists might ask regarding RET procedures. The H1 hypothesis for this study is “In terms of obtaining accurate answers to questions related to RET procedures, ChatGPT-4 with the PDF plugin is superior to ChatGPT-4o and Gemini language models.”

Methods

- Question Design: All questions were developed based on the 2022 guidelines of the American Association of Endodontists (AAE), ensuring scientific accuracy and clinical relevance.

- Clinical Relevance: Questions focused on practical aspects of regenerative endodontic treatment (RET), such as procedural feasibility, biological basis, complications, and patient selection.

- Expert Review: Two endodontic specialists evaluated and refined the questions to ensure their accuracy and applicability.

- Focused Approach: The study emphasized key decision points, like material selection and procedural sequencing, rather than addressing the full scope of RET.

2- Can regenerative endodontic treatment be performed in teeth with necrotic pulp and immature apex with post core indication? Yes or no?

3- Can pain after regenerative endodontic treatment be considered a side effect? Yes or no?

4- Are two or more appointments required for regenerative endodontic treatment? Yes or no?

5 – Is regenerative endodontic treatment the only treatment option for immature teeth with necrotic pulp? Yes or no?

6- Which anesthetic solution should be used in regenerative endodontic treatment?

7- Which irrigation solutions are used in regenerative endodontic treatment?

8- What should be the concentration of NaOCl solution in regenerative endodontic treatment?

9- Is sodium hypochlorite (NaOCl) used in the second session of regenerative endodontic treatment? Yes or no?

10 – How long the root canal irrigation time should be for each solution in regenerative endodontic treatment?

11- Which medicaments should be used in root canals between appointments in regenerative endodontic treatment?

12 – How long should the interval between appointments be in regenerative endodontic treatment?

14- What can be used as an alternative in regenerative endodontic treatment if bleeding cannot be induced by over-instrumentation?

15 – What can be used as pulpal capping material in regenerative endodontic treatment?

16 – How many millimeter thick pulp capping material should be placed on the blood clot in regenerative endodontic treatment?

17- Should an additional treatment appointment be performed if there are symptoms in the 2nd appointment of regenerative endodontic treatment? Yes or no?

18- If a material needs to be used between the blood clot in the canal system and MTA in regenerative endodontic treatment, which material can be used?

19- Is CBCT absolutely necessary in follow-up appointment of regenerative endodontic therapy? Yes or no?

20 – What is the duration of follow-up appointment after regenerative endodontic treatment?

21- What is the primary goal in regenerative endodontic treatment?

22 – Is a positive response to pulp vitality testing our primary goal in regenerative endodontic treatment? Yes or no?

23- What are the success criteria for a tooth that has undergone regenerative endodontic treatment?

based on the guideline’s criteria. At the end of the 10-day period, each response was compared against the correct answers outlined in the guideline. Pearson ChiSquare tests were applied to analyze the distribution of the answers and to assess the relationships between the platforms.

Results

The analysis showed that ChatGPT-4o provided

by delivering

Discussion

| Zaman | Program |

|

% |

|

% |

|

% |

|

| Morning | Gemini | 217 | 47,2 | 83 | 18,0 | 160 | 34,8 | <0,001* |

| ChatGpt 4 PDF | 453 | 98,5 | 0 | 0,0 | 7 | 1,5 | ||

| ChatGpt 4o | 393 | 85,2 | 17 | 3,7 | 51 | 11,1 | ||

| Noon | Gemini | 211 | 47,1 | 75 | 16,7 | 162 | 36,2 | <0,001* |

| ChatGpt 4 PDF | 448 | 97,4 | 0 | 0,0 | 12 | 2,6 | ||

| ChatGpt 4o | 398 | 86,3 | 13 | 2,8 | 50 | 10,8 | ||

| Evening | Gemini | 231 | 49,8 | 82 | 17,7 | 151 | 32,5 | <0,001* |

| ChatGpt 4 PDF | 453 | 98,5 | 0 | 0,0 | 7 | 1,5 | ||

| ChatGpt 4o | 397 | 87,1 | 10 | 2,2 | 49 | 10,7 | ||

| Total | Gemini | 659 | 48,0 | 240 | 17,5 | 473 | 34,5 | <0,001* |

| ChatGpt 4 PDF | 1354 | 98,1 | 0 | 0,0 | 26 | 1,9 | ||

| ChatGpt 4o | 1188 | 86,2 | 40 | 2,9 | 150 | 10,9 |

The accuracy threshold for AI applications in clinical decision-making processes is generally accepted to be at least

on these findings, the H1 hypothesis of the study was accepted. According to our study results, regardless of the version, ChatGPT developed by OpenAI demonstrated a higher level of accuracy compared to Gemini. This finding aligns with the results of a study by Doshi et al. [30], which compared Gemini and ChatGPT versions for simplifying radiology reports.

In a study conducted by Díaz-Flores García et al. [22], the accuracy of Gemini’s responses to diagnostic and treatment questions in the field of endodontics was examined, and it was found that only

Various question formats such as multiple-choice [31, 32], open-ended [33], and dichotomous (yes/no) [15, 21] have been preferred in studies conducted with AI chatbots. Özden et al. [15] evaluated the responses of chatbots to 25 questions related to dental trauma based on the guidelines of the The International Association of Dental Traumatology and found a correct response rate of

et al.’s study [15], the chatbots were asked dichotomous questions, while in our study, both dichotomous and open-ended questions were used depending on the clinical situation. The reason for not exclusively opting for dichotomous format questions is that this format does not reflect the multifaceted nature of clinical practice and the necessity to consider a range of possibilities and factors when making decisions in the clinic [34]. ChatGPT’s improved performance in our study is thought to stem from the fact that the version used in our study (Chat-GPT-4o) has a more advanced database and is a more advanced model as a multimodal LLM compared to the version used in the other studies (ChatGPT-3.5).

Similarly, in some studies [21, 22], international scientific guidelines published by international scientific associations have been utilized in both the preparation of questions and the evaluation of the obtained responses, thus ensuring scientific accuracy. While the questions in the study were prepared in light of the guidelines, the aspects that physicians are most likely to encounter during RET were keenly considered. However, it may not be feasible for physicians to formulate these questions without any prior knowledge about RET. This aspect is an important limitation of our study. As a highly specialized field, RET can only be accurately performed by clinicians with advanced expertise. Moreover, it is evident that without sufficient knowledge and experience, this treatment cannot be carried out effectively. Additionally, it is important to note that the AI chatbots used in this study are language models designed for the general audience and have not been specifically trained in the field of endodontics. This may have led to certain biases in the responses provided, which is another limitation of our study. To overcome this limitation, the development of specialized AI data models prepared by endodontists could be proposed.

Conclusions

Abbreviations

| Al | Artificial intelligence |

| RET | Regenerative endodontic treatment |

| AAE | American Association of Endodontists |

| LLMs | Large Language Models |

| ChatGPT | Chat Generative Pre-Trained Transformer |

| NLP | Natural language processing |

| ET | Endodontic treatments |

Acknowledgements

Authors’ contributions

Funding

Data availability

Declarations

Ethics approval and consent to partcipate

Consent for publication

Competing interests

Published online: 11 January 2025

References

- Deng L. Artificial intelligence in the rising wave of deep learning: the historical path and future outlook [perspectives]. IEEE Signal Process Mag. 2018;35(1):180-177. https://doi.org/10.1109/MSP.2017.2762725.

- Xu Y, Hu L, Zhao J, Qiu Z, Ye Y, Gu H. A survey on multilingual large language models: corpora, alignment, and bias. arXiv Preprint arXiv:2404 00929. 2024. https://doi.org/10.48550/arXiv.2404.00929.

- Ghanem YK, Rouhi AD, Al-Houssan A, Saleh Z, Moccia MC, Joshi H, et al. Dr. Google to Dr. ChatGPT: assessing the content and quality of artificial intelligence-generated medical information on appendicitis. Surgical Endoscopy. 2024;38(5):2887-93. https://doi.org/10.1007/ s00464-024-10739-5.

- Team G, Anil R, Borgeaud S, Wu Y, Alayrac JB, Yu J, et al. Gemini: a family of highly capable multimodal models. arXiv preprint arXiv:2312.11805. 2023. https://doi.org/10.48550/arXiv.2312.11805.

- Saab, K., Tu, T., Weng, W. H., Tanno, R., Stutz, D., Wulczyn, E., et al. Capabilities of gemini models in medicine. 2024. arXiv preprint arXiv:2404.18416. https://doi.org/10.48550/arXiv.2404.18416.

- Kerner SM. GPT-4o explained: everything you need to know. 2024. https://www.techtarget.com/whatis/feature/GPT-4o-explained-Every thing-you-need-to-know. Accessed 26 May 2024.

- OpenAI, Hello GPT-4o. https://openai.com/index/hellogpt-4o/. Accessed 10-06-2024.

- Doyle K. ‘The o is for omni’ and other things you should know about GPT4o. https://www.jasper.ai/blog/what-is-gpt-4o. Accessed 26 May 2024.

- TechJunkie, ChatGPT: How to Upload and Analyze PDFs. 2024. https:// www.techjunkie.com/chatgpt-how-to-upload-analyze-pdfs/?utm_ source=chatgpt.com. Accessed 8 Jan 2025.

- King MR. The future of AI in medicine: a perspective from a Chatbot. Ann Biomed Eng. 2023;51(2):291-5. https://doi.org/10.1007/ s10439-022-03121-w.

- Rodrigues JA, Krois J, Schwendicke F. Demystifying artificial intelligence and deep learning in dentistry. Braz Oral Res. 2021;35: e094. https://doi. org/10.1590/1807-3107bor-2021.vol35.0094.

- Lai G, Dunlap C, Gluskin A, Nehme WB, Azim AA. Artificial intelligence in endodontics. J Calif Dent Assoc. 2023;51(1): 2199933. https://doi.org/10. 1080/19424396.2023.2199933.

- Ahmed ZH, Almuharib AM, Abdulkarim AA, Alhassoon AH, Alanazi AF, Alhaqbani MA, et al. Artificial intelligence and its application in endodontics: a review. J Contemp Dent Pract. 2024;24(11):912-7. https://doi.org/ 10.5005/jp-journals-10024-3593.

- Umer F, Khan M. A call to action: concerns related to artificial intelligence. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;132(2):255. https://doi. org/10.1016/j.oooo.2021.04.056.

- Ozden I, Gokyar M, Ozden ME, Ovecoglu S. Assessment of artificial intelligence applications in responding to dental trauma. Dent Traumatol. 2024. https://doi.org/10.1111/edt.12965.

- Murray PE, Garcia-Godoy F, Hargreaves KM. Regenerative endodontics: a review of current status and a call for action. J Endod. 2007;33(4):377-90. https://doi.org/10.1016/j.joen.2006.09.013.

- Diogenes A, Henry MA, Teixeira FB, Hargreaves KM. An update on clinical regenerative endodontics. Endodontic Top. 2013;28(1):2-23. https://doi. org/10.1111/etp.12040.

- Kontakiotis EG, Filippatos CG, Tzanetakis GN, Agrafioti A. Regenerative endodontic therapy: a data analysis of clinical protocols. J Endod. 2015;41(2):146-54. https://doi.org/10.1016/j.joen.2014.08.003.

- EzEldeen M, De Piero MNSP, Xu L, Driesen RB, Wyatt J, Van Gorp G, et al. Multimodal imaging of dental pulp healing patterns following tooth autotransplantation and regenerative endodontic treatment. J Endod. 2023;49(8):1058-72. https://doi.org/10.1016/j.joen.2023.06.003.

- Kim SG, Malek M, Sigurdsson A, Lin LM, Kahler B. Regenerative endodontics: a comprehensive review. Int Endod J. 2018;51(12):1367-88. https:// doi.org/10.1111/iej.12954.

- Suárez A, Díaz-Flores García V, Algar J, Gómez Sánchez M, Llorente de Pedro M, Freire Y. Unveiling the ChatGPT phenomenon: evaluating the consistency and accuracy of endodontic question answers. Int Endod J. 2024;57(1):108-13. https://doi.org/10.1111/iej.13985.

- Díaz-Flores García V, Freire Y, Tortosa M, Tejedor B, Estevez R, Suárez A. Google gemini’s performance in endodontics: a study on answer precision and reliability. Appl Sci. 2024;14(15):6390. https://doi.org/10.3390/ app14156390.

- AAE clinical considerations for a regenerative procedure revised, https:// www.aae.org/specialty/wp-content/uploads/sites/2/2023/04/Considerat ionsForRegEndo_AsOfNov2022-4.pdf. Accessed 11-2022.

- Antaki F, Touma S, Milad D, El-Khoury J, Duval R. Evaluating the performance of ChatGPT in ophthalmology: an analysis of its successes and shortcomings. Ophthalmol Sci. 2023;3(4):100324. https://doi.org/10. 1016/j.xops.2023.100324.

- Wu S, Fei H, Qu L, Ji W, Chua TS. Next-gpt: any-to-any multimodal IIm. arXiv Preprint arXiv:2309 05519. 2023. https://doi.org/10.48550/arXiv. 2309.05519.

- Huang H, Zheng O, Wang D, Yin J, Wang Z, Ding S, et al. ChatGPT for shaping the future of dentistry: the potential of multi-modal large language model. Int J Oral Sci. 2023;15(1):29. https://doi.org/10.1038/ s41368-023-00239-y.

- Hackett C. OpenAl’s ChatGPT plus: an electronic resources librarian’s review. J Electron Resour Librariansh. 2023;35(4):299-304. https://doi.org/ 10.1080/1941126X.2023.2271373.

- Labkoff S, Oladimeji B, Kannry J, Solomonides A, Leftwich R, Koski E, et al. Toward a responsible future: recommendations for AI-enabled clinical decision support. J Am Med Inform Assoc. 2024:ocae209. https://doi.org/ 10.1093/jamia/ocae209.

- Vollmer S, Mateen BA, Bohner G, Király FJ, Ghani R, Jonsson P, et al. Machine learning and artificial intelligence research for patient benefit:20 critical questions on transparency, replicability, ethics, and effectiveness. BMJ. 2020;368. https://doi.org/10.1136/bmj.l6927.

- Doshi R, Amin K, Khosla P, Bajaj S, Chheang S, Forman HP. Utilizing large language models to simplify radiology reports: a comparative analysis of ChatGPT3. 5, ChatGPT4. 0, Google Bard, and Microsoft Bing. medRxiv. 2023;2023-06. https://doi.org/10.1101/2023.06.04.23290786.

- Asker ÖF, Özgür EG, Eriç A, Bekiroğlu N. Comparing the performance of medical students, ChatGPT-3.5 and ChatGPT-4 in biostatistics exam: pros and cons as an education assistant. Uluslararası Yönetim Bilişim Sistemleri ve Bilgisayar Bilimleri Dergisi. 2023;7(2):85-94. https://doi.org/10.33461/ uybisbbd. 1329650.

- Ali K, Barhom N, Marino FT, Duggal M. The thrills and chills of ChatGPT: implications for assessments in undergraduate dental education. 2023. https://doi.org/10.20944/preprints202302.0513.v1.

- Azadi A, Gorjinejad F, Mohammad-Rahimi H, Tabrizi R, Alam M, Golkar M. Evaluation of AI-generated responses by different artificial intelligence chatbots to the clinical decision-making case-based questions in oral and maxillofacial surgery. Oral Surg Oral Med Oral Pathol Oral Radiol. 2024;137(6):587-93. https://doi.org/10.1016/j.oooo.2024.02.018.

- Giordano C, Brennan M, Mohamed B, Rashidi P, Modave F, Tighe P. Accessing artificial intelligence for clinical decision-making. Front Digit Health. 2021;3: 645232. https://doi.org/10.3389/fdgth.2021.645232.

Publisher’s Note

- *Correspondence:

Parla Meva Durmazpinar

parlamewa@hotmail.com

Department of Endodontics, Faculty of Dentistry, Marmara University, Başıbüyük, Başıbüyük Yolu Marmara Üniversitesi Başıbüyük Sağlık Yerleşkesi 9/3, Başıbüyük – Maltepe, PO Box: 34854, İstanbul, Turkey