DOI: https://doi.org/10.1186/s12903-024-03896-5

PMID: https://pubmed.ncbi.nlm.nih.gov/38297288

تاريخ النشر: 2024-01-31

كشف أنماط فقدان العظام اللثوي وعيوب الفركشن من الأشعة السينية البانورامية باستخدام خوارزمية التعلم العميق: دراسة استعادية

الملخص

الخلفية: تهدف هذه الدراسة الاستعادية إلى تطوير خوارزمية تعلم عميق لتفسير الأشعة السينية البانورامية وفحص أداء هذه الخوارزمية في الكشف عن فقدان العظام حول الأسنان وأنماط فقدان العظام. الطرق: تم استخدام 1121 صورة أشعة سينية بانورامية في هذه الدراسة. تم تصنيف فقدان العظام في الفك العلوي والسفلي (إجمالي فقدان العظام السنخية) (

الخلفية

الطرق

تصميم الدراسة

اختيار البيانات

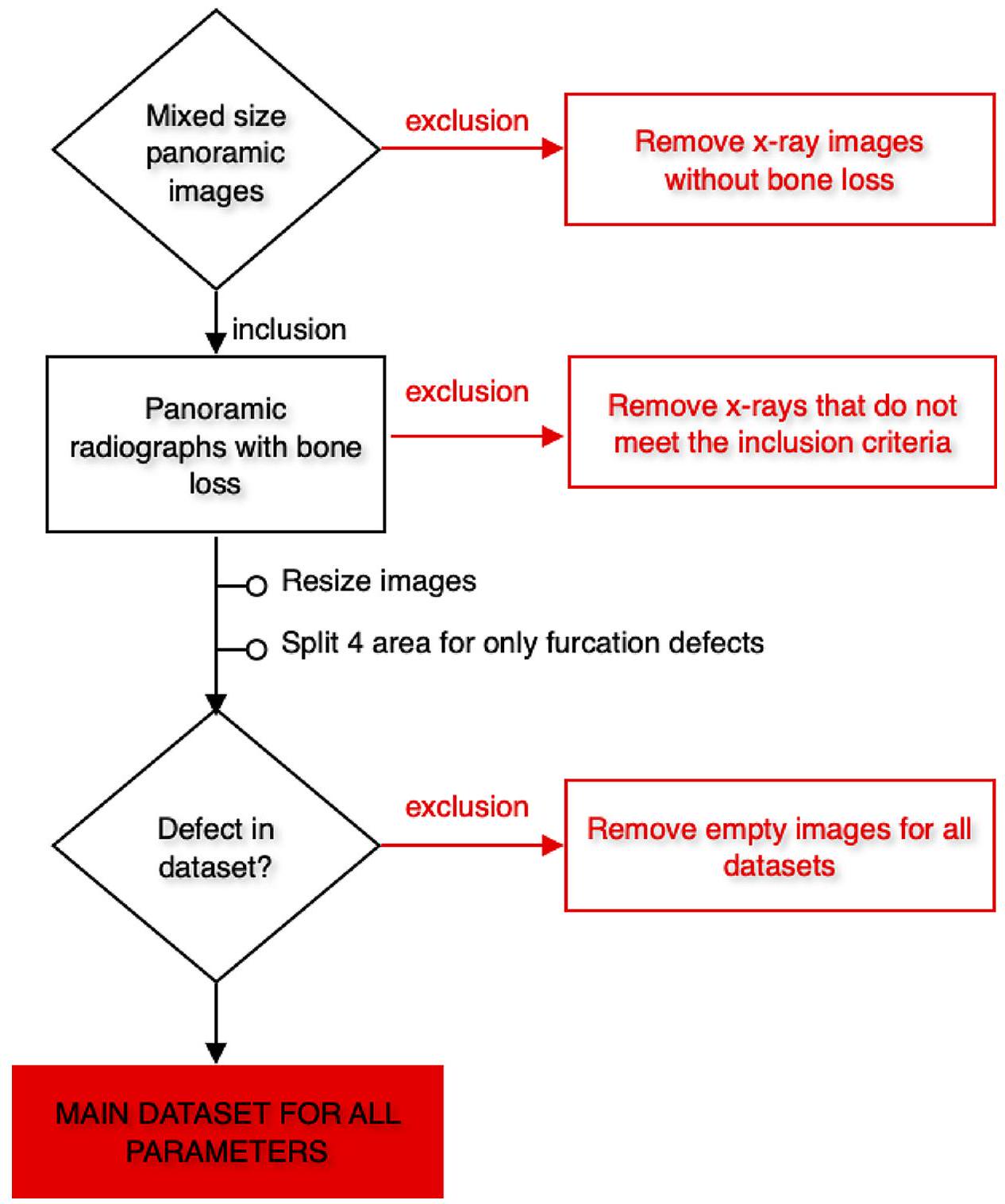

تم قبول منطقة التقاء المينا بالأسمنت في الأسنان كمستوى صحي للأنسجة الداعمة [31-33]. تم اعتبار الحالات التي كانت قمة العظم السنخي لديها فوق هذه الخط الوهمي كمصابة بأنسجة داعمة صحية وتم استبعادها من الدراسة. تم إعادة تقييم صور حالات التهاب اللثة من أعمار وجنسيات مختلفة وفقًا للمعايير المذكورة أدناه: ‘1. الصور التي تحتوي على تشويش كثيف، 2. الصور ذات الجودة المنخفضة بسبب خطأ في وضعية المريض أو حركة المريض أثناء التصوير، 3. صور المرضى الذين تلقوا علاجًا جراحيًا للفكين، 4. صور المرضى الذين يعانون من اضطرابات في عملية الأيض العظمي، 5. صور المرضى الذين لديهم شكل غير عادي للعظم السنخي (أمراض عظمية بسبب حالات مثل الكيسات والأورام)، 6. صور المرضى الذين يعانون من شق الشفة والحنك، 7. الصور ذات الجودة الرديئة والصور الضبابية في منطقة العظم السنخي بسبب حالات مثل ازدحام الأسنان، 8. صور المرضى الذين لديهم ترميمات معدنية تسبب تشويشًا تعقيدًا في تشخيص التهاب اللثة’. تم استبعاد الصور التي تلبي هذه المعايير، والتي قد تجعل التشخيص صعبًا وتؤثر على توحيد الدراسة.

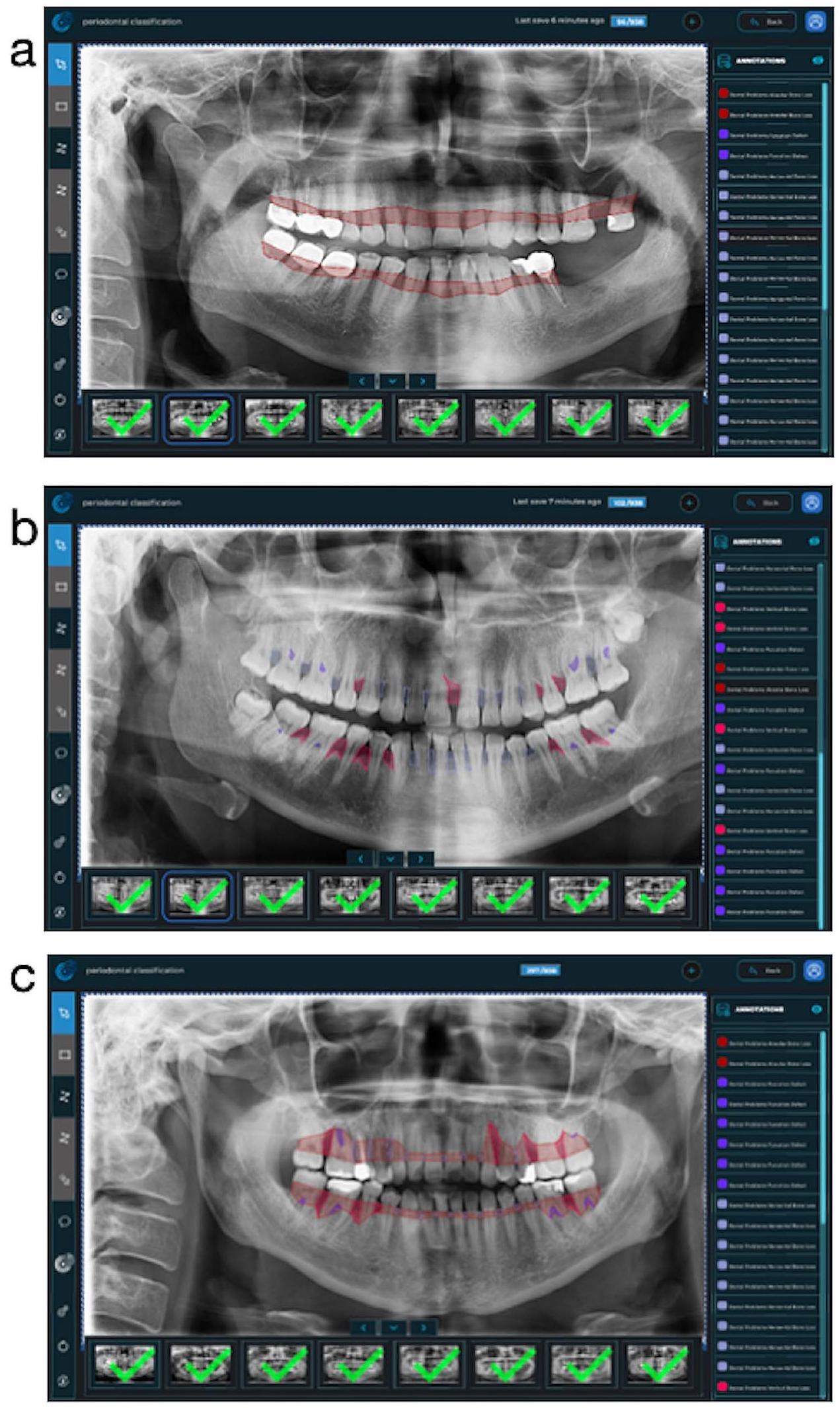

الحقيقة الأرضية

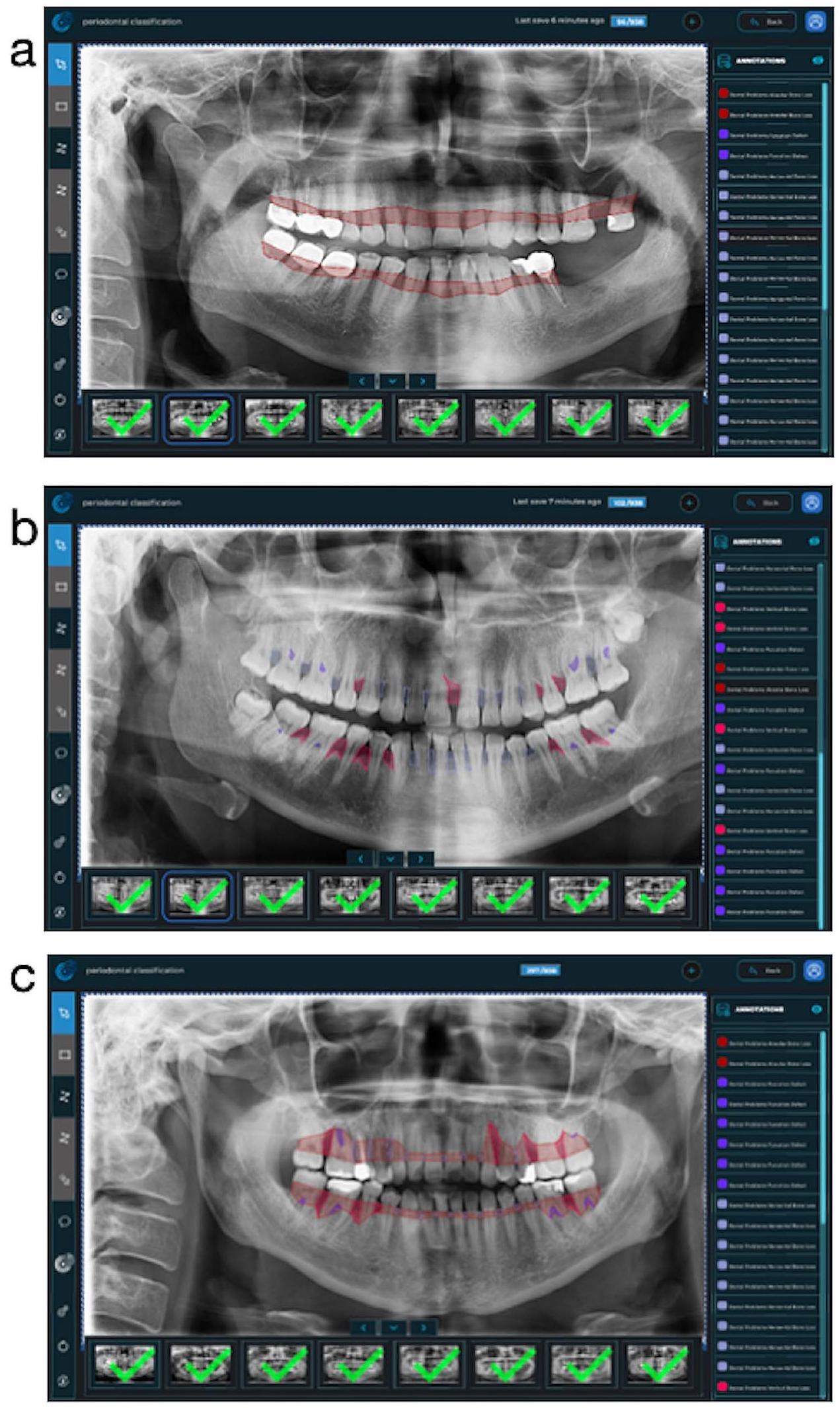

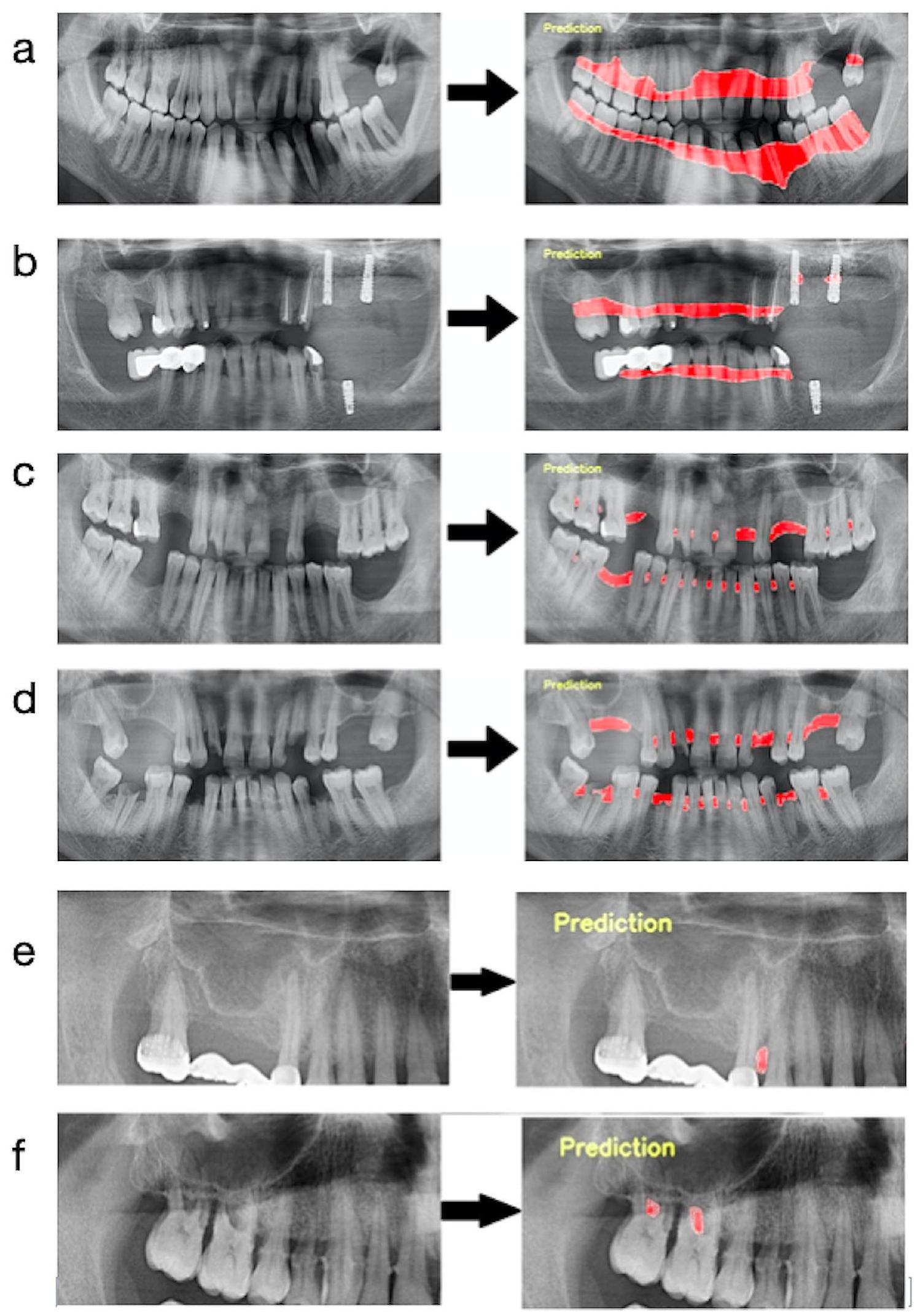

تقاطع جميع الأسنان. بعد ذلك، تم دمج خط التقسيم ليتبع الخط على الأسطح البعيدة لأبعد الأسنان وحدود قمة العظام في الفك المعني. في الشكل 1-أ، تم تقديم صورة مثال لفهم أفضل للطريق المتبع عند وضع علامة على هذه المعلمة. (الشكل 1-أ)

تدريب النموذج

- خطوات المعالجة المسبقة: تم تغيير حجم جميع الصور إلى

بكسلات. تم قص الأشعة السينية البانورامية التي ستستخدم في مجموعات البيانات التي تم إنشاؤها لتطوير نموذج عيب الفركشن إلى 4 (الفك السفلي الأيسر، الفك السفلي الأيمن، الفك العلوي الأيسر، والفك العلوي الأيمن). نظرًا لأن عيوب الفركشن كانت مرئية فقط في الأضراس متعددة الجذور، كان الهدف هو التركيز أكثر على المناطق ذات الصلة بهذه الطريقة. لم يتم استخدام الأشعة السينية في نماذج المعلمات الأخرى.

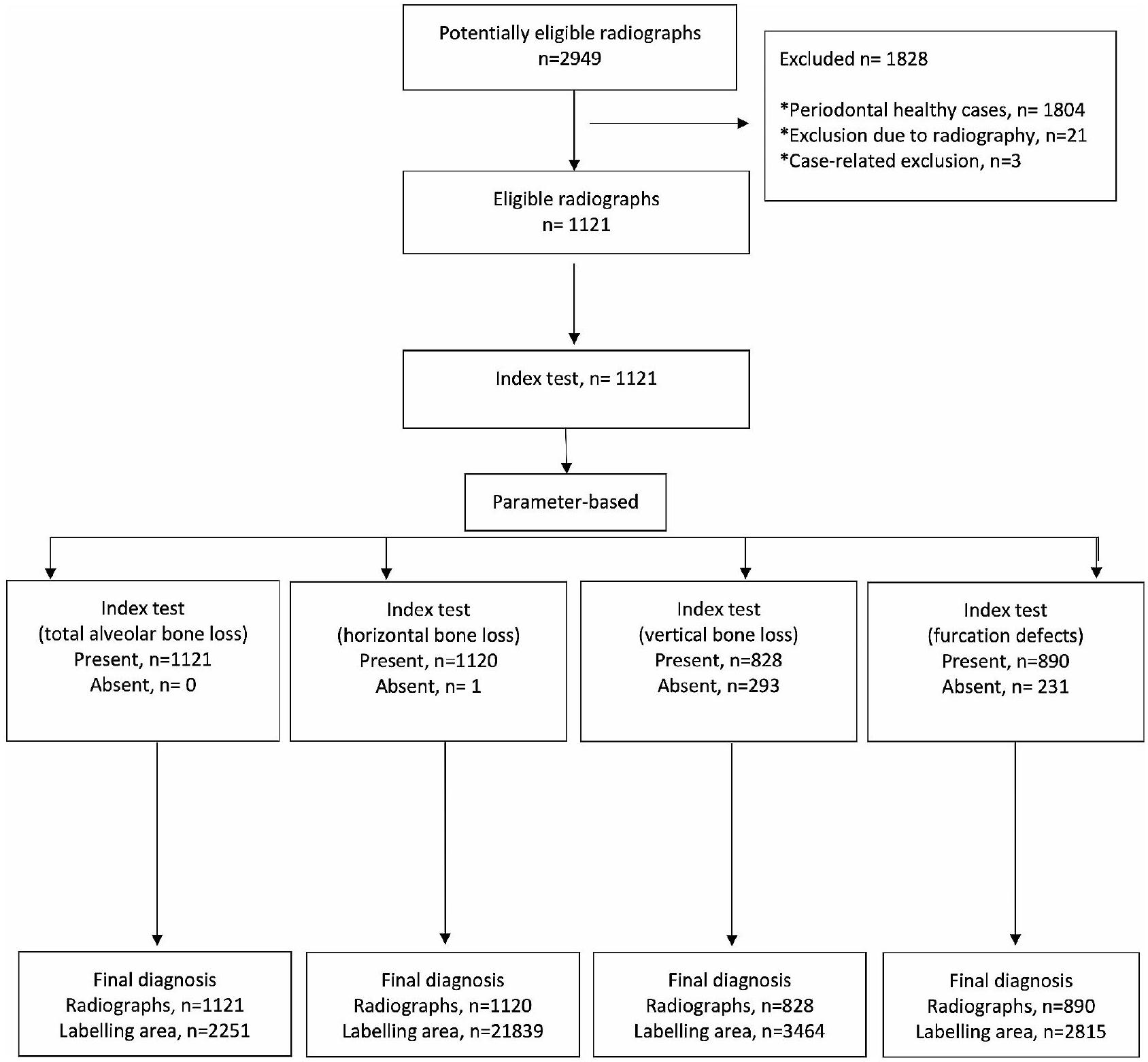

تم اقتصاصها ولكن استخدامها ككل. تم استبعاد الصور التي لا تحتوي على تسمية المعامل ذات الصلة من مجموعات البيانات الرئيسية لذلك المعامل (الأشكال 2 و 3). وفقًا لهذه المعايير، تم تضمين 1121 صورة شعاعية بانورامية لفقدان العظام السنخية الكلي، و1120 صورة شعاعية بانورامية لفقدان العظام الأفقي، و828 صورة شعاعية بانورامية لفقدان العظام العمودي، و1941 صورة شعاعية بانورامية مقصوصة (890 صورة شعاعية بانورامية) لعيوب الفركشن في مجموعات البيانات الرئيسية (الجدول 1؛ الشكل 3). - بيانات التدريب والتحقق والاختبار: تم إنشاء المجموعات الرئيسية من خلال دمج جميع الأشعة السينية البانورامية التي تحتوي على تسميات المعلمات ذات الصلة لكل معلمة. ثم تم تقسيم هذه المجموعات الرئيسية إلى مجموعة تدريب (

)، مجموعة التحقق ( ) ومجموعة الاختبار ( عشوائيًا لتطوير أنظمة الذكاء الاصطناعي (الجدول 1).

| اسم الطراز | عدد صور التدريب | عدد تسميات التدريب | عدد صور التحقق | عدد تسميات التحقق | عدد صور الاختبار | عدد تسميات الاختبار | عصر | معدل التعلم | نموذج |

| فقدان العظم السنخي الكلي | 935 | 1878 | 93 | 186 | 93 | 187 | ٨٠٠ | 0.0001 | يو-نت |

| فقدان العظام الأفقي | 934 | 18,232 | 93 | 1786 | 93 | 1821 | ٨٠٠ | 0.0001 | يو-نت |

| فقدان العظام العمودي | ٦٩٠ | 2869 | 69 | 287 | 69 | 308 | 800 | 0.00001 | U-Net |

| عيب الفركيشن | 1619 | 2358 | 161 | 227 | 161 | 230 | 800 | 0.00001 | U-Net |

صورة مقصوصة (230 تسمية) لعيب الفركيشن تم استخدامها كبيانات اختبار.

تم استخدام التسميات في مجموعة التدريب لإنشاء خوارزمية نموذج الذكاء الاصطناعي. تم اختبار هذا النموذج مع البيانات في مجموعة التحقق لضبط الخوارزمية والتساؤل حول الحاجة إلى مزيد من التدريب. النسخة النهائية من الخوارزمية، التي تم تطويرها باستخدام مجموعة التدريب وتم إجراء تجارب ناجحة مع التسميات في مجموعة التحقق، تم استخدامها في اكتشاف تدمير العظم اللثوي والنمط على الأشعة السينية في مجموعة الاختبار. تم مقارنة النتائج التشخيصية للنظام في مجموعة الاختبار مع تسميات المراقب في هذه المجموعة بواسطة أمر كمبيوتر،

وتم تقديم مقاييس النجاح للنظام. باختصار، أثناء تحديد النجاح النهائي للنموذج، تم قبول تشخيصات المراقب في مجموعة اختبار البيانات كمعيار ذهبي وتم استخدام هذه التسميات كبيانات الحقيقة الأساسية. (الشكل 3). تم تنفيذ هذه الخطوات بشكل منفصل لكل معلمة.

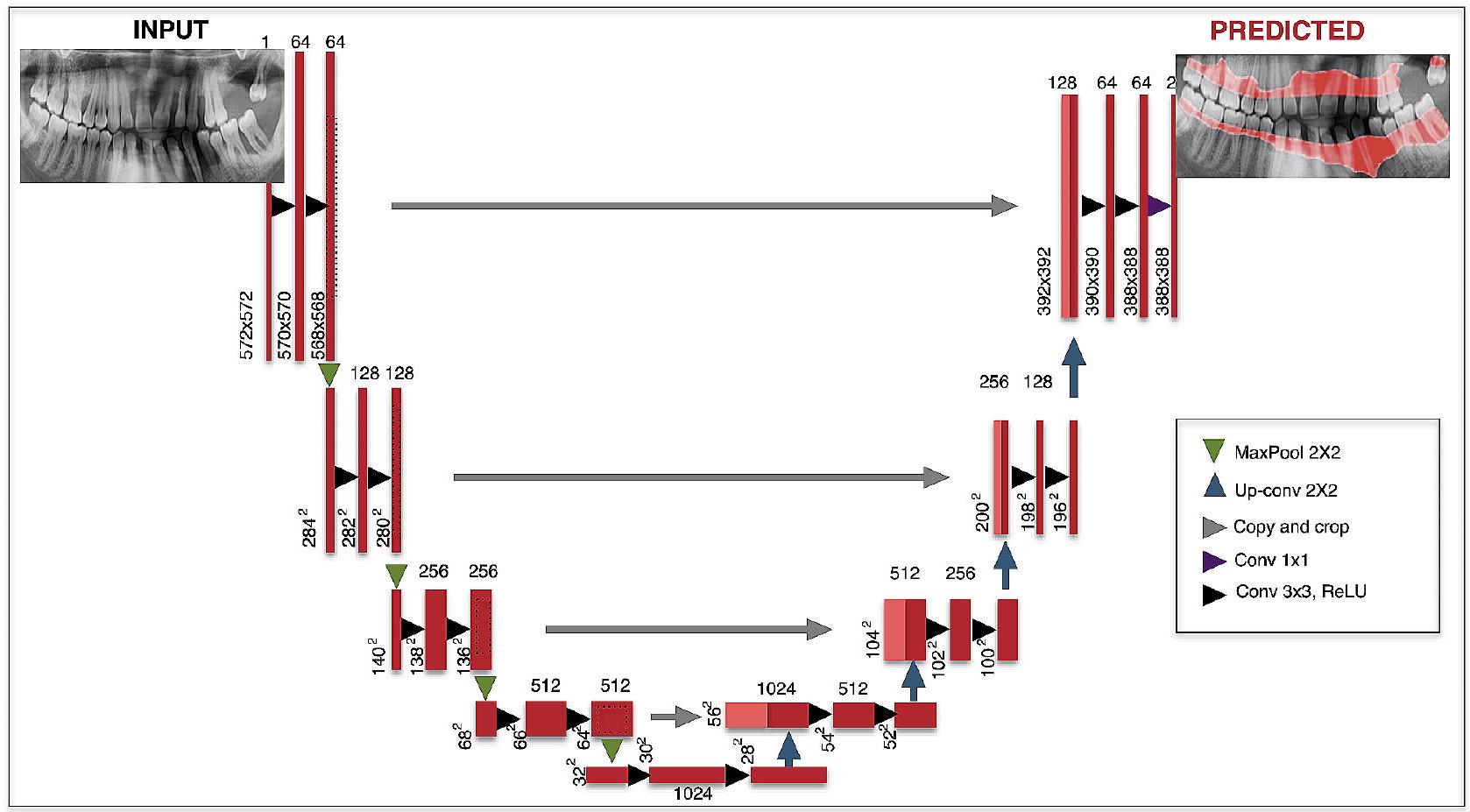

3. وصف بنية CNN: تم استخدام بنية U-Net لأداء التعلم العميق (الجدول 1) [24، 34]. U-Net هو نوع من CNN يمكنه أداء مهام تقسيم دلالي على صور مختلفة مثل صور الأشعة السينية. تحتوي U-Net على أربعة مستويات كتلة مع

4. طريقة التدريب: تم استخدام مكتبة PyTorch (الإصدار 3.6.1؛ مؤسسة برمجيات بايثون، ويلمنجتون، ديلاوير، الولايات المتحدة الأمريكية) ومُحسِّن تقدير الزخم التكيفي (ADAM) (لتحديث معدل التعلم لكل معلمة) في مراحل تطوير النموذج. تم إجراء جميع التدريب باستخدام كمبيوتر مزود بذاكرة وصول عشوائي سعة 16 جيجابايت وبطاقة رسومات NVIDIA GeForce GTX 1660 TI. تم استخدام بنية U-Net

في تدريب جميع المعلمات وتم تدريبها جميعًا على 800 دورة. تم إجراء تدريب فقدان العظم السنخي الكلي وفقدان العظم الأفقي بمعدل تعلم قدره 0.0001، وتم إجراء تدريب فقدان العظم العمودي ومعلمات عيب الفركيشن بمعدل تعلم قدره 0.00001.

مقاييس التقييم

تم حساب الحساسية والدقة ودرجات F1 باستخدام طريقة مصفوفة الارتباك [24]. في البداية، كانت هناك ثلاث حسابات مختلفة لطريقة مصفوفة الارتباك: عدد الإيجابيات الحقيقية (TP، كان هناك مشكلة لثوية وتم تقسيمها بشكل صحيح)، عدد الإيجابيات الكاذبة (FP، لم تكن هناك مشكلة لثوية ولكن تم اكتشافها بشكل خاطئ)، وعدد

الدقة: TP/ (TP+FP).

درجة F1: 2TP/ (2TP + FP + FN).

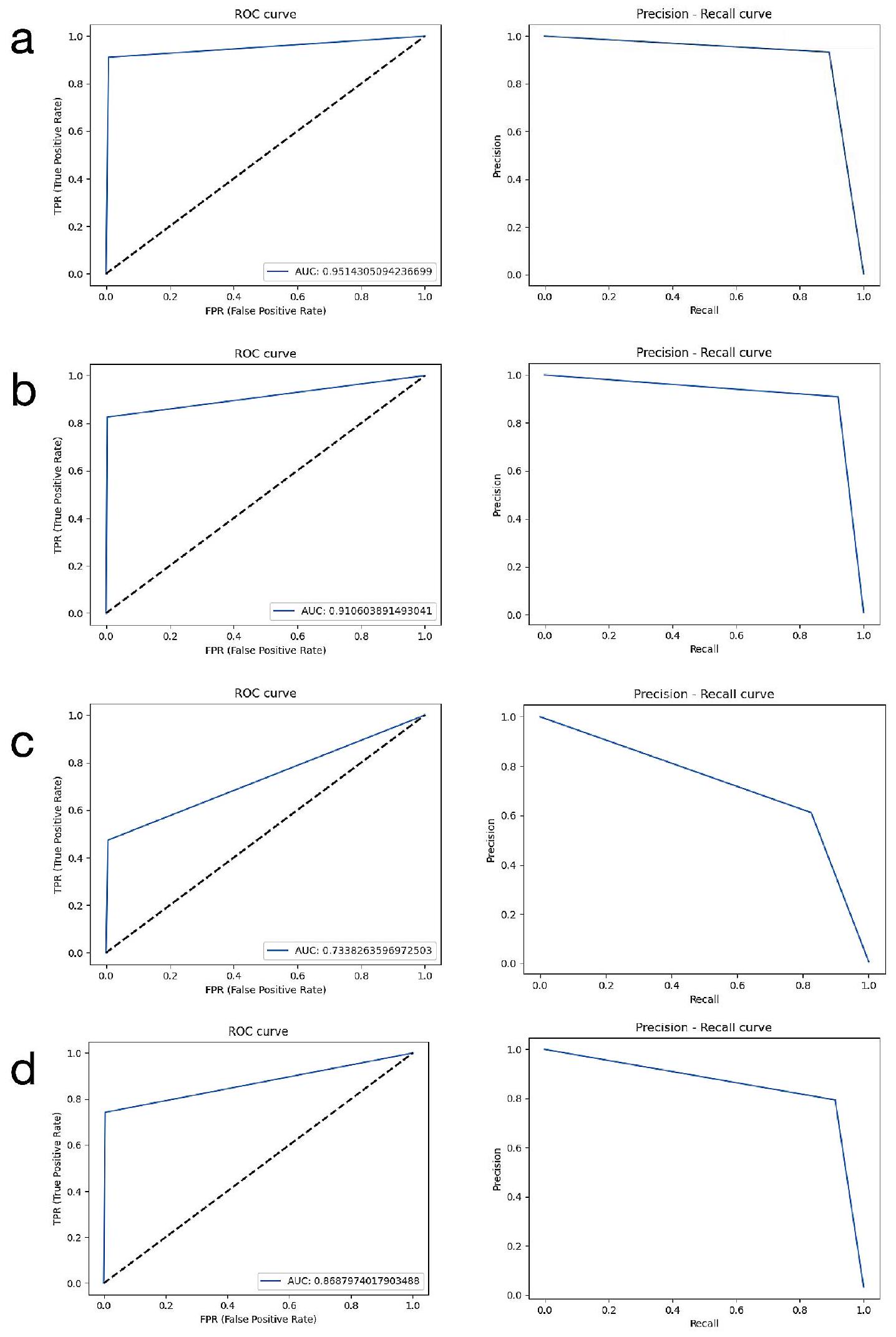

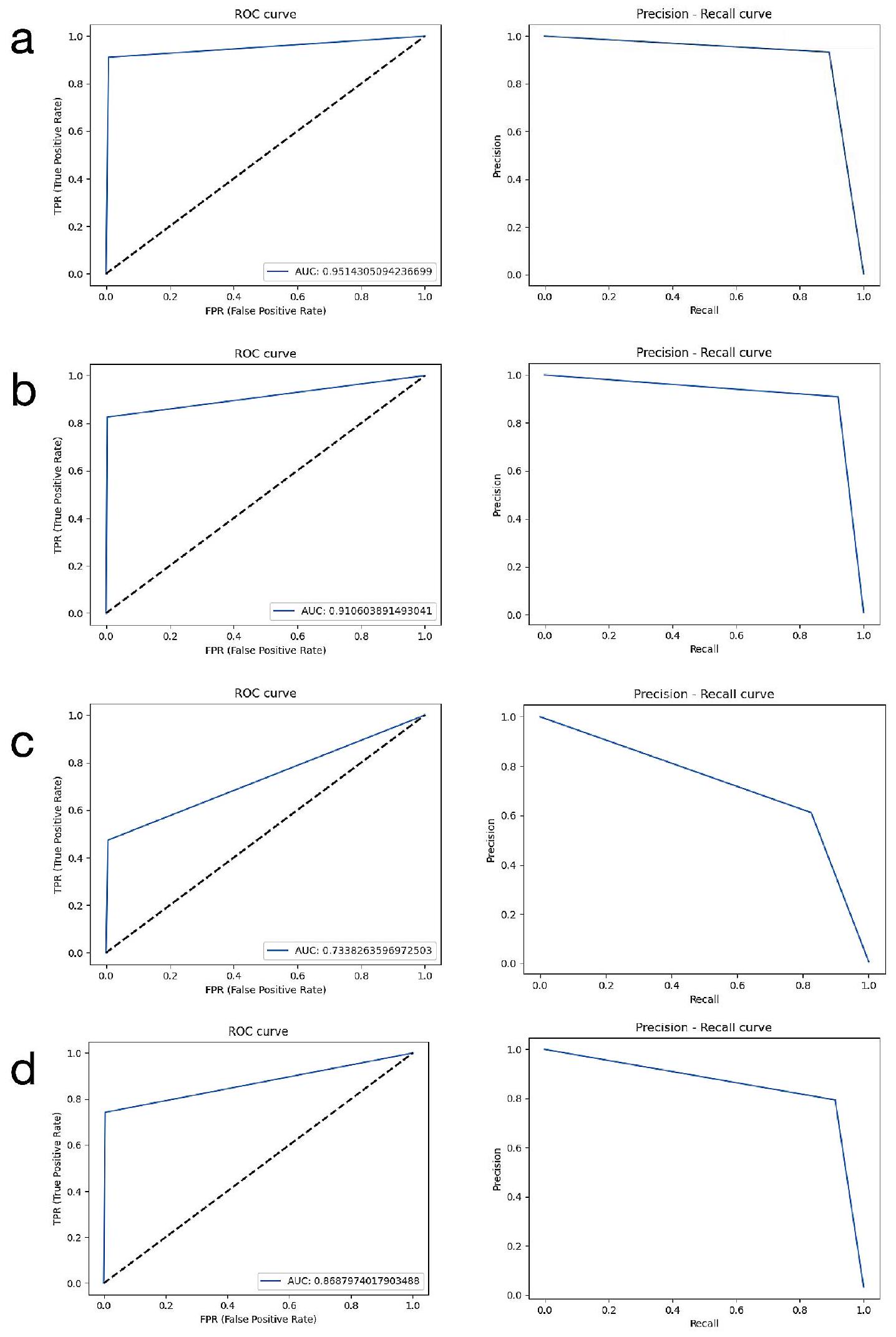

بالإضافة إلى طريقة مصفوفة الارتباك، تم أيضًا إجراء تحليل منحنى خصائص التشغيل المستقبلية (ROC) وتقييم الدقة-الاسترجاع لتوفير بيانات أكثر تفصيلًا. يتم حساب قيم المساحة تحت منحنى ROC (AUC) من خلال هذا التحليل. ROC هو منحنى احتمالي وتمثل المساحة تحته، AUC، درجة أو مقياس للفصل. مع زيادة المساحة تحت المنحنى، تزداد أداء التمييز بين الفئات. من المعروف أنه مع زيادة نجاح النظام، ينمو AUC ويقترب من القيمة 1. بناءً على هذه المعلومات، تم إجراء تفسيرات وتم تقديم النتائج. بالإضافة إلى ذلك، تمت مراجعة التسميات ونتائج النظام للأشعة السينية في مجموعة بيانات الاختبار التي تم إجراء التقييمات عليها من قبل أطباء الأسنان ذوي الخبرة لكل معلمة.

النتائج

بيانات الدراسة

اتفاقيات بين المراقبين

النتائج 0.85 وما فوق لفقدان العظام الأفقي، وفقدان العظام السنخي الكلي، وعيب الفركيشن، كانت أقل لفقدان العظام العمودي (>0.81).

النتائج

الملاحظات

| اسم النموذج | تم العثور على صحيح لعتبة loU: 50% | تم العثور على خطأ لعتبة loU: 50% | لم يتم العثور عليه لعتبة loU: 50% | الحساسية | الدقة | درجة F1 | الدقة | AUC |

| فقدان العظم السنخي الكلي | 185 | 1 | 0 | 1 | 0.995 | 0.997 | 0.994 | 0.951 |

| فقدان العظم الأفقي | 108 | 7 | 6 | 0.947 | 0.939 | 0.943 | 0.892 | 0.910 |

| فقدان العظم العمودي | 115 | 21 | 91 | 0.558 | 0.846 | 0.673 | 0.506 | 0.733 |

| عيب الفركشن | 181 | 13 | 22 | 0.892 | 0.933 | 0.912 | 0.837 | 0.868 |

المناقشة

إلى تقييم الأشعة السينية البانورامية تلقائيًا بواسطة نظام ذكاء اصطناعي وتحديد نجاح النظام المعني في اكتشاف نتائج أمراض اللثة على الأشعة السينية. أظهرت نتائج هذه الدراسة أن أنظمة الذكاء الاصطناعي يمكن أن تكون آلية دعم قرار لأطباء الأسنان

(2276 أشعة سينية بانورامية). قاموا بتقييم نجاح أنظمة الذكاء الاصطناعي التي طوروها في تحديد الأشعة السينية لحالات التهاب اللثة [6]. في هذه الدراسة، تم استخدام 1137 أشعة سينية لمرضى يعانون من فقدان العظم وأشعة سينية بانورامية لـ 1139 فردًا صحيًا لأسنان اللثة لتطوير نموذج الذكاء الاصطناعي. تم العثور على درجة F1 والدقة مرتفعة كما كانت

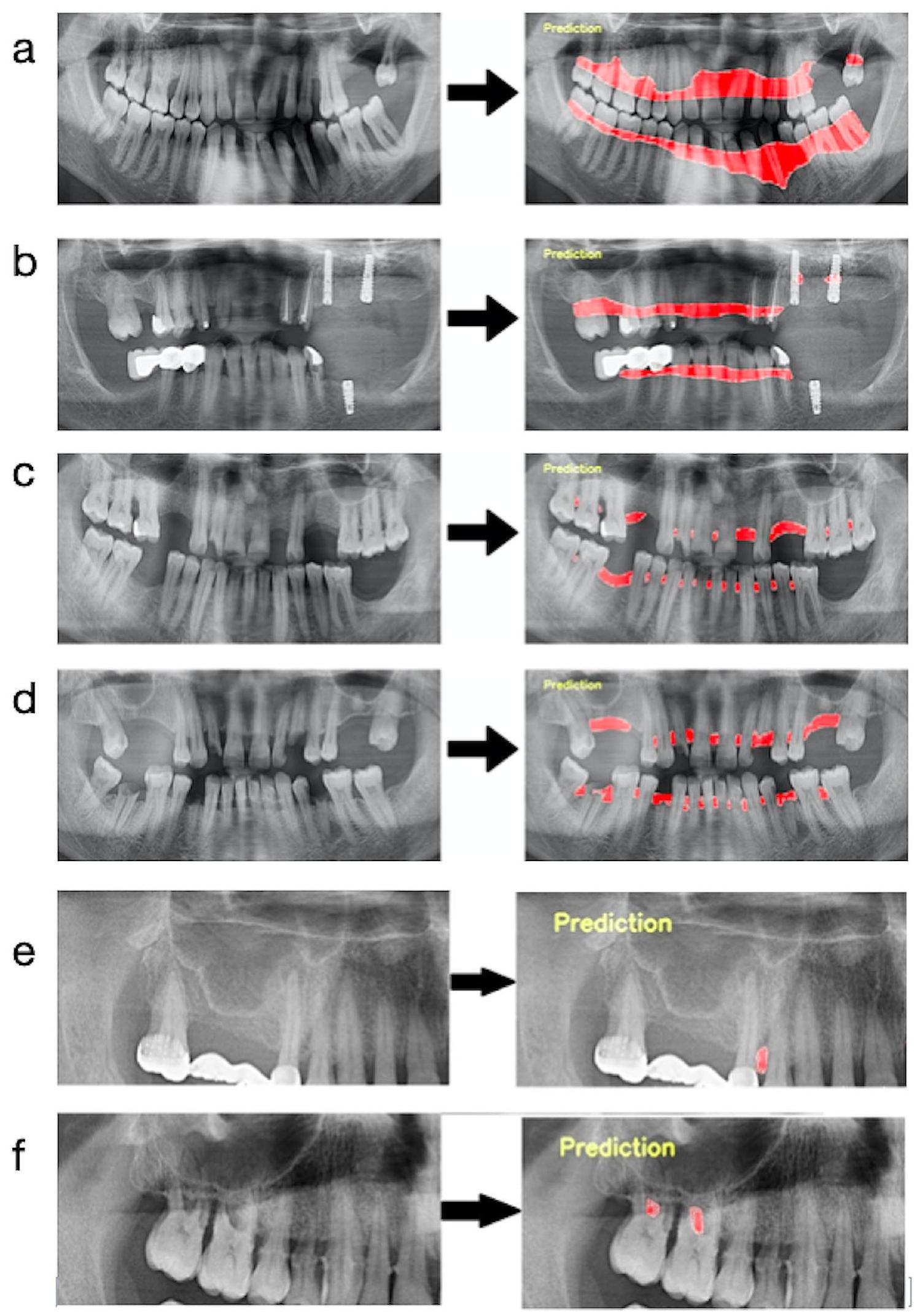

تم استخدامه في هذه الدراسة للتصنيف. طريقة التقسيم التي نستخدمها هي طريقة أكثر فائدة بكثير لأنها تحدد المنطقة المعيبة مع حدودها. لأنها توفر معلومات أكثر تفصيلاً لطبيب الأسنان لتحديد شدة المرض ولتخطيط العلاج في العملية التالية. بالإضافة إلى ذلك، في هذه الطريقة، تتم معالجة منطقة العيب مثل خريطة مفصلة وتوفر دعمًا تشخيصيًا أكثر تقدمًا بصريًا. من ناحية أخرى، عند مقارنة دراستين بالتفصيل، لوحظ أنهما استخدمتا عدة مراقبين، واثنين من الهياكل المعمارية المختلفة للذكاء الاصطناعي (U-Net و Yolo-v4)، وشملتا شدة المرض في تقييمهما.

مخطط قمة العظم السنخي في العيوب ذات الجدران 1 و2 و3. نعتقد أن اتفاقيات المراقبين كانت أيضًا أقل بالنسبة لهذا المعامل بسبب هذه القيود، والتي قد تكون ناتجة عن الرؤية المحدودة للأشعة السينية البانورامية. يمكن القضاء على هذه الصعوبة التشخيصية من خلال استخدام بعض تقنيات الأشعة السينية التي توفر صورًا أكثر تفصيلًا في الدراسات المستقبلية.

الاستنتاجات

الاختصارات

الذكاء الاصطناعي

2D ثنائي الأبعاد

تقاطع الاتحاد

تقدير اللحظة التكيفية ADAM

TP أعداد الإيجابيات الحقيقية

أرقام الإيجابيات الكاذبة

أرقام FN للنتائج السلبية الكاذبة

ROC منحنى خصائص التشغيل المستقبلية

مساحة تحت منحنى ROC

ثلاثي الأبعاد

أنظمة التصوير المقطعي المحوسب باستخدام شعاع مخروط

معايير ستارد للإبلاغ عن التشخيص

شكر وتقدير

مساهمات المؤلفين

تمويل

توفر البيانات

الإعلانات

موافقة الأخلاقيات والموافقة على المشاركة

موافقة على النشر

المصالح المتنافسة

تفاصيل المؤلف

تم الاستلام: 9 نوفمبر 2023 / تم القبول: 15 يناير 2024

References

- Dentino A, Lee S, Mailhot J, Hefti AF. Principles of periodontology. Periodontol 2000. 2013;61:16-53.

- Bourgeois D, Inquimbert C, Ottolenghi L, Carrouel F. Periodontal pathogens as Risk factors of Cardiovascular diseases, Diabetes, Rheumatoid Arthritis, Cancer, and Chronic Obstructive Pulmonary Disease-Is there cause for Consideration? Microorganisms 2019;7.

- Chang H-J, Lee S-J, Yong T-H, Shin N-Y, Jang B-G, Kim J-E, et al. Deep learning hybrid method to automatically diagnose periodontal bone loss and stage periodontitis. Sci Rep. 2020;10:1-8.

- Mol A. Imaging methods in periodontology. Periodontol 2000. 2004;34:34-48.

- Scarfe WC, Azevedo B, Pinheiro LR, Priaminiarti M, Sales MAO. The emerging role of maxillofacial radiology in the diagnosis and management of patients with complex periodontitis. Periodontol 2000. 2017;74:116-39.

- Kurt Bayrakdar S, Özer Ç, Bayrakdar IS, Orhan K, Bilgir E, Odabaş A, et al. Success of artificial intelligence system in determining alveolar bone loss from dental panoramic radiography images. Cumhuriyet Dent J. 2020;23:318-24.

- Rushton VE, Horner K. The use of panoramic radiology in dental practice. J Dent. 1996;24:185-201.

- Clerehugh V, Tugnait A. Diagnosis and management of periodontal diseases in children and adolescents. Periodontol 2000. 2001;26:146-68.

- Ivanauskaite D, Lindh C, Rangne K, Rohlin M. Comparison between Scanora panoramic radiography and bitewing radiography in the assessment of marginal bone tissue. Stomatologija. 2006;8(1):9-15. PMID: 16687909.

- de Faria Vasconcelos K, Evangelista KM, Rodrigues CD, Estrela C, de Sousa TO, Silva MA. Detection of periodontal bone loss using cone beam CT and intraoral radiography. Dentomaxillofac Radiol. 2012;41:64-9.

- Haas LF, Zimmermann GS, De Luca Canto G, Flores-Mir C, Corrêa M. Precision of cone beam CT to assess periodontal bone defects: a systematic review and meta-analysis. Dentomaxillofac Radiol. 2018;47:20170084.

- Persson RE, Hollender LG, Laurell L, Persson GR. Horizontal alveolar bone loss and vertical bone defects in an adult patient population. J Periodontol. 1998;69:348-56.

- Gomes-Filho IS, Sarmento VA, de Castro MS, da Costa NP, da Cruz SS, Trindade SC, et al. Radiographic features of periodontal bone defects: evaluation of digitized images. Dentomaxillofac Radiol. 2007;36:256-62.

- Jayakumar A, Rohini S, Naveen A, Haritha A, Reddy K. Horizontal alveolar bone loss: a periodontal orphan. J Indian Soc Periodontol. 2010;14:181-5.

- Braun

, Ritter , Jervøe-Storm PM, Frentzen M. Diagnostic accuracy of CBCT for periodontal lesions. Clin Oral Investig. 2014;18:1229-36. - Papapanou PN, Sanz M, Buduneli N, Dietrich T, Feres M, Fine DH, et al. Periodontitis: Consensus report of workgroup 2 of the 2017 World workshop on the classification of Periodontal and Peri-implant diseases and conditions. J Periodontol. 2018;89(Suppl 1):173-s82.

- Ertaş K, Pence I, Cesmeli MS, Ay ZY. Determination of the stage and grade of periodontitis according to the current classification of periodontal and peri-implant diseases and conditions (2018) using machine learning algorithms. J Periodontal Implant Sci. 2023;53(1):38-53. https://doi.org/10.5051/ jpis. 2201060053.

- Lee CT, Kabir T, Nelson J, Sheng S, Meng HW, Van Dyke TE, et al. Use of the deep learning approach to measure alveolar bone level. J Clin Periodontol. 2022;49:260-9.

- Sen D, Chakrabarti R, Chatterjee S, Grewal DS, Manrai K. Artificial intelligence and the radiologist: the future in the Armed Forces Medical Services. BMJ Mil Health. 2020;166:254-6.

- Kurt Bayrakdar S, Orhan K, Bayrakdar IS, Bilgir E, Ezhov M, Gusarev M, et al. A deep learning approach for dental implant planning in cone-beam computed tomography images. BMC Med Imaging. 2021;21:86.

- Lee JH, Kim DH, Jeong SN, Choi SH. Detection and diagnosis of dental caries using a deep learning-based convolutional neural network algorithm. J Dent. 2018;77:106-11.

- Fukuda M, Inamoto K, Shibata N, Ariji Y, Yanashita Y, Kutsuna S, et al. Evaluation of an artificial intelligence system for detecting vertical root fracture on panoramic radiography. Oral Radiol. 2020;36:337-43.

- Bilgir E, Bayrakdar İ, Çelik Ö, Orhan K, Akkoca F, Sağlam H, et al. An artifıcial intelligence approach to automatic tooth detection and numbering in panoramic radiographs. BMC Med Imaging. 2021;21:124.

- Bayrakdar IS, Orhan K, Çelik Ö, Bilgir E, Sağlam H, Kaplan FA, et al. A U-Net Approach to apical lesion segmentation on panoramic radiographs. Biomed Res Int. 2022;2022:7035367.

- Krois J, Ekert T, Meinhold L, Golla T, Kharbot B, Wittemeier A, et al. Deep learning for the Radiographic detection of Periodontal Bone loss. Sci Rep. 2019;9:8495.

- Thanathornwong B, Suebnukarn S. Automatic detection of periodontal compromised teeth in digital panoramic radiographs using faster regional convolutional neural networks. Imaging Sci Dent. 2020;50:169-74.

- Lee JH, Kim DH, Jeong SN, Choi SH. Diagnosis and prediction of periodontally compromised teeth using a deep learning-based convolutional neural network algorithm. J Periodontal Implant Sci. 2018;48:114-23.

- Khan HA, Haider MA, Ansari HA, Ishaq H, Kiyani A, Sohail K, et al. Automated feature detection in dental periapical radiographs by using deep learning. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;131:711-20.

- Kim J, Lee HS, Song IS, Jung KH. DeNTNet: deep neural transfer network for the detection of periodontal bone loss using panoramic dental radiographs. Sci Rep. 2019;9:17615.

- Jiang L, Chen D, Cao Z, Wu F, Zhu H, Zhu F. A two-stage deep learning architecture for radiographic staging of periodontal bone loss. BMC Oral Health. 2022;22:106.

- Helmi MF, Huang H, Goodson JM, Hasturk H, Tavares M, Natto ZS. Prevalence of periodontitis and alveolar bone loss in a patient population at Harvard School of Dental Medicine. BMC Oral Health. 2019;19:254. https://doi. org/10.1186/s12903-019-0925-z.

- Wylleman A, Van Der Veken D, Teughels W, Quirynen M, Laleman I. Alveolar bone level at deciduous molars in flemish children: a retrospective, radiographic study. J Clin Periodontol. 2020;47:660-7. https://doi.org/10.1111/ jcpe. 13280.

- Castro LO, Castro IO, de Alencar AHG, Valladares-Neto J, Estrela C. Cone beam computed tomography evaluation of distance from cementoenamel

junction to alveolar crest before and after nonextraction orthodontic treatment. Angle Orthod. 2015;86:543-9. https://doi.org/10.2319/040815-235.1. - Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation. International Conference on Medical image computing and computer-assisted intervention: Springer; 2015. p. 234-41.

- Zhou Z, Siddiquee MMR, Tajbakhsh N, Liang J. UNet++: A nested U-Net Architecture for Medical Image Segmentation. Deep Learn Med Image Anal Multimodal Learn Clin Decis Support (2018). 2018;11045:3-11.

- Du G, Cao X, Liang J, Chen X, Zhan Y. Medical image segmentation based on u-net: a review. J Imaging Sci Technol. 2020;64:1-12.

- Lee S, Kim D, Jeong HG. Detecting 17 fine-grained dental anomalies from panoramic dental radiography using artificial intelligence. Sci Rep. 2022;12:5172.

- Kılıc MC, Bayrakdar IS, Çelik Ö, Bilgir E, Orhan K, Aydın OB, et al. Artificial intelligence system for automatic deciduous tooth detection and numbering in panoramic radiographs. Dentomaxillofac Radiol. 2021;50:20200172.

- Pauwels R, Brasil DM, Yamasaki MC, Jacobs R, Bosmans H, Freitas DQ, et al. Artificial intelligence for detection of periapical lesions on intraoral radiographs: comparison between convolutional neural networks and human observers. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;131:610-6.

- Zhang X, Liang Y, Li W, Liu C, Gu D, Sun W, et al. Development and evaluation of deep learning for screening dental caries from oral photographs. Oral Dis. 2022;28:173-81.

- Takahashi T, Nozaki K, Gonda T, Mameno T, Ikebe K. Deep learning-based detection of dental prostheses and restorations. Sci Rep. 2021;11:1960

- Fu Q, Chen Y, Li Z, Jing Q, Hu C, Liu H, et al. A deep learning algorithm for detection of oral cavity squamous cell carcinoma from photographic images: a retrospective study. EClinicalMedicine. 2020;27:100558.

- Li W, Liang Y, Zhang X, Liu C, He L, Miao L, et al. A deep learning approach to automatic gingivitis screening based on classification and localization in RGB photos. Sci Rep. 2021;11:16831.

- Zehra T, Shaikh A, Shams M. Dawn of artificial intelligence – enable digital Pathology in Pakistan: a paradigm shift. J Pak Med Assoc. 2021;71:2683-4.

- Alhazmi A, Alhazmi Y, Makrami A, Masmali A, Salawi N, Masmali K, et al. Application of artificial intelligence and machine learning for prediction of oral cancer risk. J Oral Pathol Med. 2021;50:444-50.

- Alotaibi G, Awawdeh M, Farook FF, Aljohani M, Aldhafiri RM, Aldhoayan M. Artificial intelligence (AI) diagnostic tools: utilizing a convolutional neural network (CNN) to assess periodontal bone level radiographically-a retrospective study. BMC Oral Health. 2022;22:399.

- Surya L. An exploratory study of AI and Big Data, and it’s future in the United States. Int J Creative Res Thoughts (IJCRT), ISSN 2015;2320-882.

- Acar B, Kamburoğlu K. Use of cone beam computed tomography in periodontology. World J Radiol. 2014;28(5):6.

ملاحظة الناشر

- *المراسلة:

سيفدا كورت-بايرقدار

dt.sevdakurt@hotmail.com

القائمة الكاملة لمعلومات المؤلف متاحة في نهاية المقال

DOI: https://doi.org/10.1186/s12903-024-03896-5

PMID: https://pubmed.ncbi.nlm.nih.gov/38297288

Publication Date: 2024-01-31

Detection of periodontal bone loss patterns and furcation defects from panoramic radiographs using deep learning algorithm: a retrospective study

Abstract

Background This retrospective study aimed to develop a deep learning algorithm for the interpretation of panoramic radiographs and to examine the performance of this algorithm in the detection of periodontal bone losses and bone loss patterns. Methods A total of 1121 panoramic radiographs were used in this study. Bone losses in the maxilla and mandibula (total alveolar bone loss) (

Background

Methods

Study design

Data selection

cemento-enamel junction of the teeth was accepted as the healthy periodontium level [31-33]. Cases whose alveolar bone crest was coronal to this imaginary line were considered to have healthy periodontium and were excluded from the study. Images of periodontitis cases of different ages and genders were re-evaluated in terms of the criteria stated below: ‘1. The images with dense artifacts, 2 . The images with low quality due to patient positioning error or patient movement during acquisition, 3. The images of patients who received orthognathic treatment, 4 . The images of patients with bone metabolism disorders, 5 . The images of patients with unusual alveolar bone morphology (bone pathologies due to conditions such as cysts and tumors), 6. The images of patients with cleft lip and palate, 7. The images of poor quality and blurred images in the alveolar bone region due to conditions such as dental crowding, 8. The images of patients with metal restorations that cause artifacts to complicate periodontal diagnosis’. Images that meet these criteria, which would make diagnosis difficult and disrupt the standardization of the study, were also excluded from the study.

Ground truth

junction of all teeth. After that, the segmentation line was combined to follow the line on the distal surfaces of the most distal teeth and the border of the bone crests in the relevant jaw. In Fig. 1-a, an example image was presented to better understand the path followed when labeling this parameter. (Fig. 1-a)

Model training

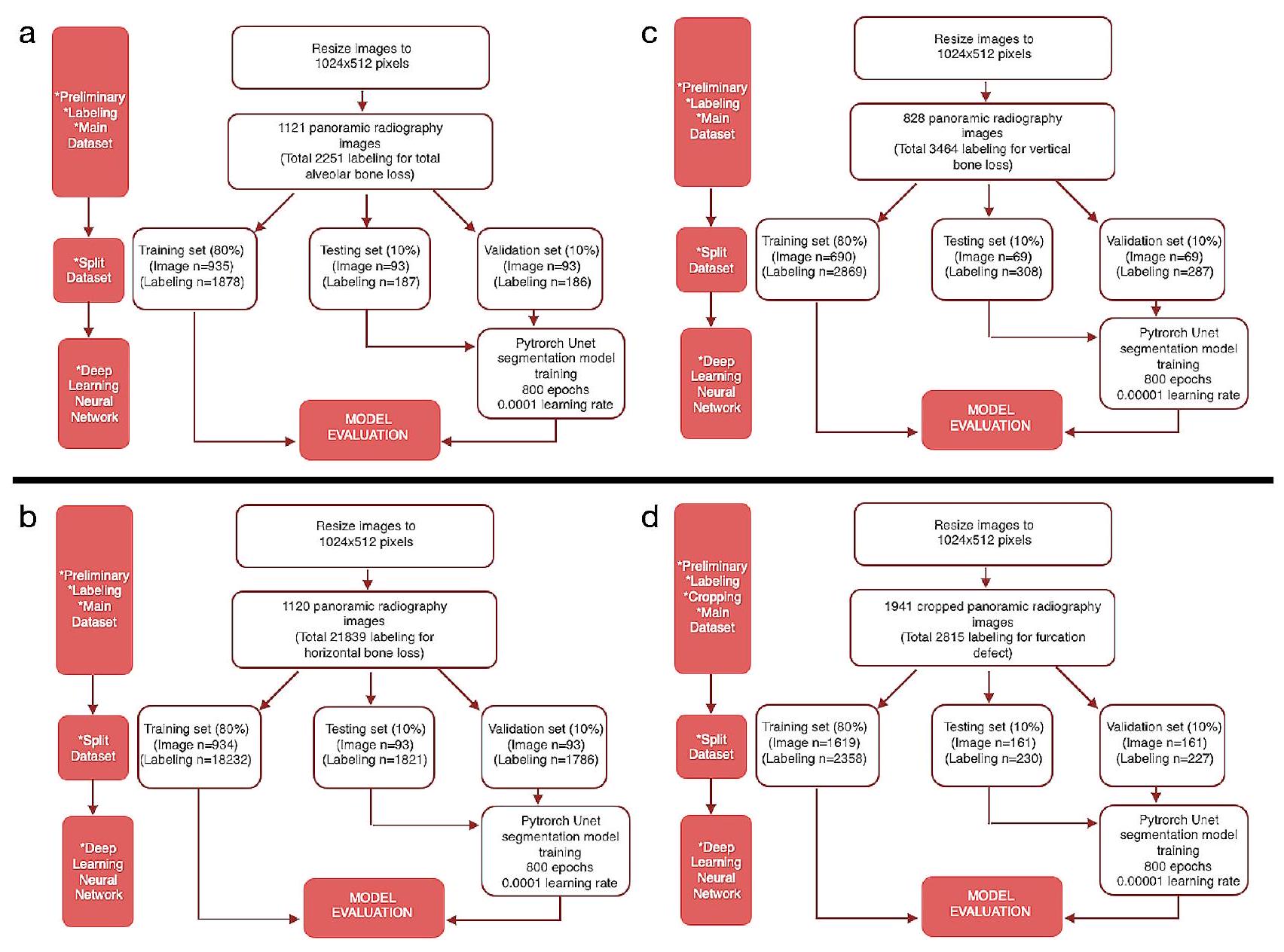

- Pre-processing steps: All images were resized as

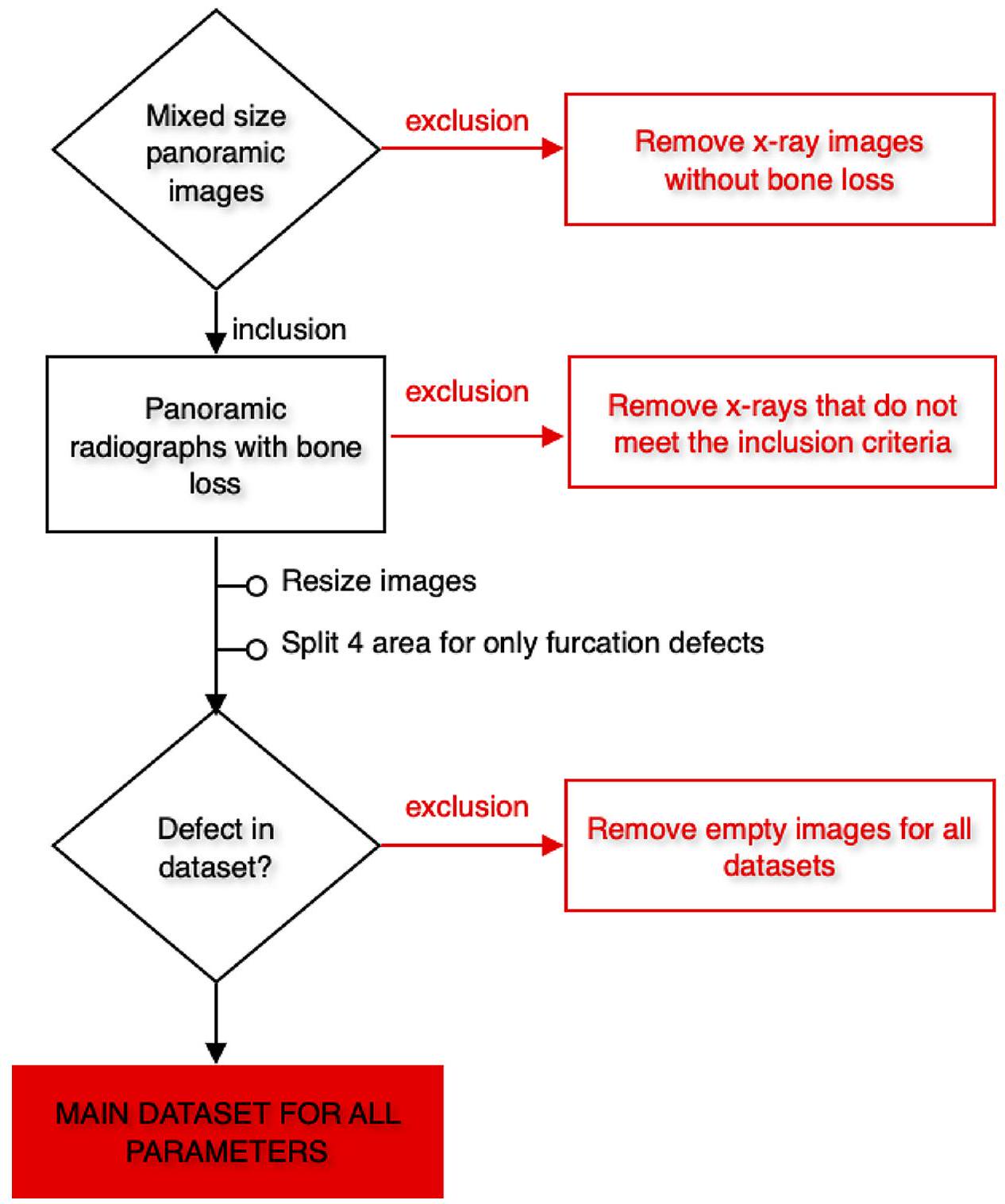

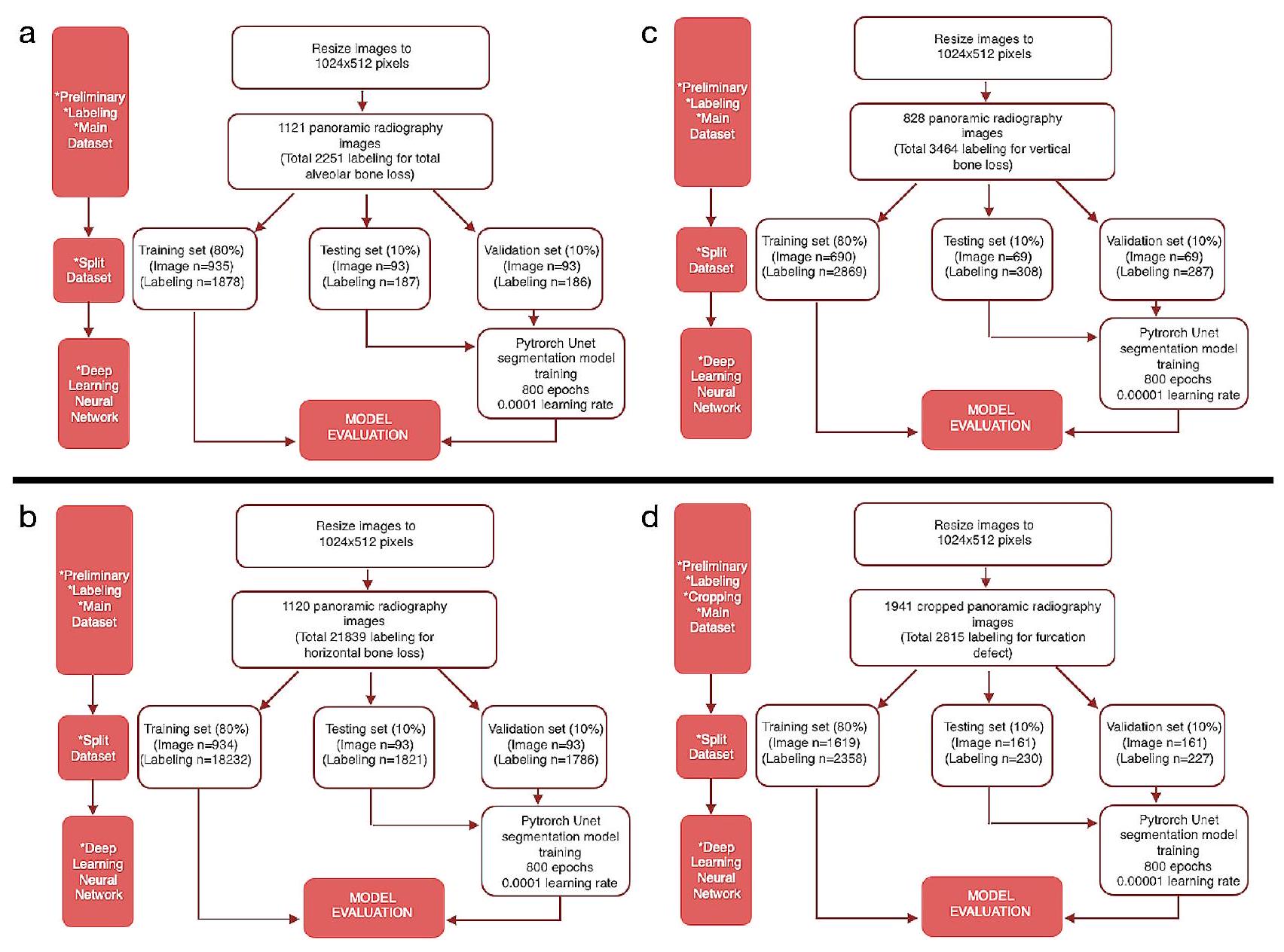

pixels. Panoramic radiographs to be used in the data sets created for developing the furcation defect model were cropped to 4 (left mandible, right mandible, left maxilla, and right maxilla). Since furcation defects were only seen in multi-rooted molars, it was aimed to focus more on the relevant areas in this way. The radiographs to be used in other parameter models were not

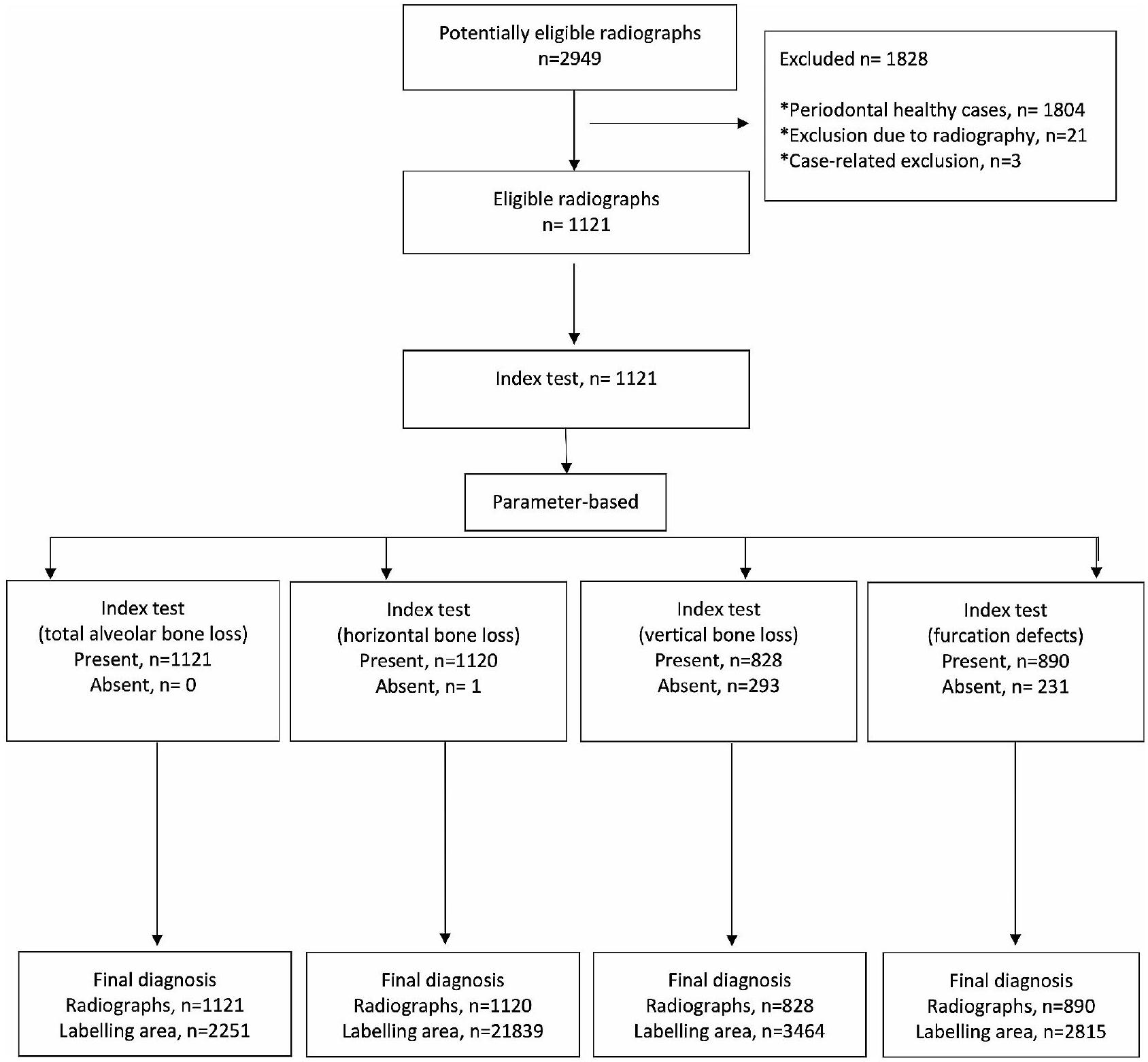

cropped but used as a whole. Images that do not have the related parameter label were excluded from the main data sets of that parameter (Figs. 2 and 3). In line with these criteria, 1121 panoramic radiographs for total alveolar bone losses, 1120 panoramic radiographs for horizontal bone losses, 828 panoramic radiographs for vertical bone losses, and 1941 cropped panoramic radiographs ( 890 panoramic radiographs) for furcation defects were included in the main datasets (Table 1; Fig. 3). - Training, Validation, and Testing Data: The main datasets were created by combining all panoramic radiographs containing the relevant parameter labels for each parameter. Then these main datasets were split as a training set (

), validation set ( ), and testing set ( ) randomly for the development of AI systems (Table 1).

| Model Name | Number of Training Images | Number of Training Labels | Number of Validation Images | Number of Validation Labels | Number of Test Images | Number of Test Labels | Epoch | Learning Rate | Model |

| Total Alveolar Bone Loss | 935 | 1878 | 93 | 186 | 93 | 187 | 800 | 0.0001 | U-Net |

| Horizontal Bone Loss | 934 | 18,232 | 93 | 1786 | 93 | 1821 | 800 | 0.0001 | U-Net |

| Vertical Bone Loss | 690 | 2869 | 69 | 287 | 69 | 308 | 800 | 0.00001 | U-Net |

| Furcation Defect | 1619 | 2358 | 161 | 227 | 161 | 230 | 800 | 0.00001 | U-Net |

cropped images (230 labels) for furcation defect were used as testing data-set.

The labels in the training set were used to create the algorithm of the AI model. This model was tested with the data in the validation set for adjusting the algorithm and questioning the need for further training. The final version of the algorithm, which was developed using the training set and successful trials were carried out with the labels in the validation set, was used in the detection of periodontal bone destruction and pattern on the radiographs in the testing set. The diagnostic results of the system in the testing set were compared with the observer labels in this dataset by a computer command,

and the success metrics of the system were presented. In short, while determining the final success of the model, the observer diagnoses in the test dataset were accepted as the gold standard and these labels were used as the ground truth dataset. (Fig. 3). These steps were performed separately for each parameter.

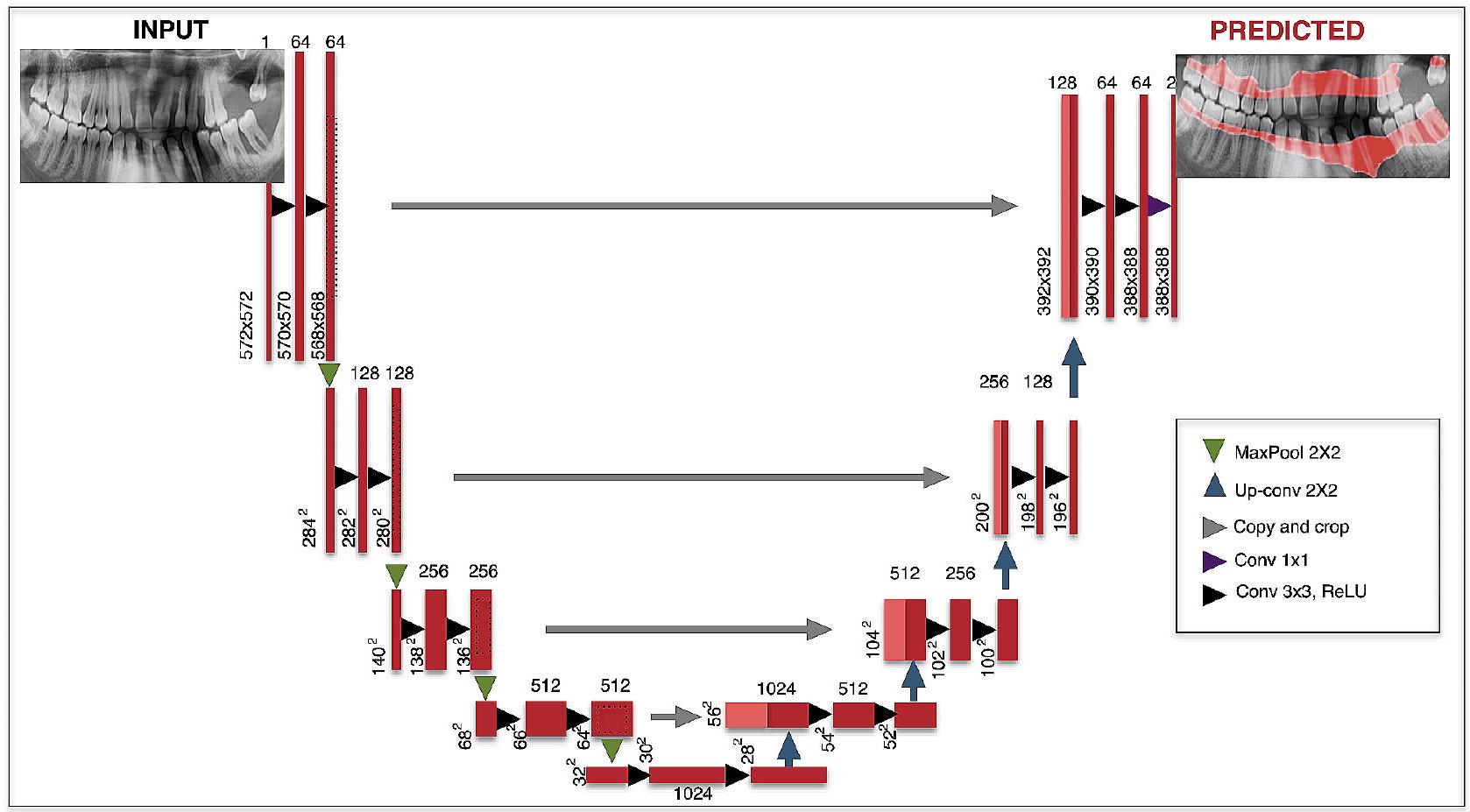

3. Description of CNN architecture: The U-Net architecture was used to perform deep learning (Table 1) [24, 34]. U-Net is a type of CNN that can perform semantic segmentation assignments on various images such as radiography images. U-Net contains four block levels with

4. Method for training: PyTorch library (v. 3.6.1; Python Software Foundation, Wilmington, DE, USA) and Adaptive Moment Estimation (ADAM) optimizer (for updating the learning rate for each parameter) were used in the model development stages. All training was made with a computer equipped with 16 GB RAM and NVIDIA GeForce GTX 1660 TI graphics card. U-Net architecture

was used in the training of all parameters and all of them were trained with 800 epochs. Training of total alveolar bone loss and horizontal bone loss parameters was carried out with a learning rate of 0.0001 , and training of vertical bone loss and furcation defect parameters was carried out with a learning rate of 0.00001 .

Assessment metrics

Sensitivity, precision, and F1 scores were calculated using the confusion matrix method [24]. Initially, three different calculations were for the confusion matrix method: numbers of true positives (TP, there was a periodontal problem and it was segmented correctly), numbers of false positives (FP, there wasn’t a periodontal problem but it was detected wrongly), and numbers of

Precision: TP/ (TP+FP).

F1 score: 2TP/ (2TP + FP + FN).

In addition to the confusion matrix method, receiver operating characteristic (ROC) curve analysis and pre-cision-recall evaluation were also performed to provide more detailed data. The area under the ROC curve (AUC) values are calculated by this analysis. ROC is a probability curve and the area under it, AUC, represents the degree or measure of separability. As the area under the curve increases, the discrimination performance between classes increases. It is known that as the success of the system increases, the AUC grows and approaches the value of 1 . In line with this information, interpretations were made and the results were presented. In addition, the labels and system results of the radiographs in the test data set in which the evaluations were carried out were reviewed by experienced dentists for each parameter.

Results

Study data

Intra-observer and inter-observer agreements

results were 0.85 and above for horizontal bone loss, total alveolar bone loss, and furcation defect, they were lower for vertical bone loss (>0.81).

Outcomes

Observations

| Model Name | Found Correct for loU Threshold: 50% | Found Wrong for loU Threshold: 50% | Not Found for loU Threshold: 50% | Sensitivity | Precision | F1 Score | Accuracy | AUC |

| Total Alveolar Bone Loss | 185 | 1 | 0 | 1 | 0.995 | 0.997 | 0.994 | 0.951 |

| Horizontal Bone Loss | 108 | 7 | 6 | 0.947 | 0.939 | 0.943 | 0.892 | 0.910 |

| Vertical Bone Loss | 115 | 21 | 91 | 0.558 | 0.846 | 0.673 | 0.506 | 0.733 |

| Furcation Defect | 181 | 13 | 22 | 0.892 | 0.933 | 0.912 | 0.837 | 0.868 |

Discussion

aims to automatically evaluate panoramic radiographs by an AI system and to determine the success of the related system in detecting periodontal disease findings on radiographs. The results of this study showed that AI systems can be a decision-support mechanism for dentists

(2276 panoramic radiographs). They evaluated the success of the AI systems they developed in the determination of radiographs of periodontitis cases [6]. In this study, 1137 radiographs of patients with bone loss and panoramic radiographs of 1139 periodontal healthy individuals were used for the development of the AI model. F1 score and accuracy were found as high as

was used in this study for labeling. The segmentation method we use is a much more advantageous method since it determines the defective area with its borders. Because it provides more detailed information to the dentist to determine the severity of the disease and to plan the treatment in the next process. In addition, in this method, the defect area is processed like a detailed map and provides more advanced diagnostic support visually. On the other hand, when two studies were compared in detail, it was seen that they used multiple observers, and two different AI architectures (U-Net and Yolo-v4), and included the severity of the disease in their assessment.

the outline of the alveolar bone crest in 1,2 , and 3 -walled defects. We think that interobserver agreements were also lower for this parameter due to this limitation, which may be due to the limited view of panoramic radiography. This diagnostic difficulty can be eliminated by using some radiography techniques that provide more detailed images in future studies.

Conclusions

Abbreviations

AI Artificial intelligence

2D Two-dimensional

loU Intersection over Union

ADAM Adaptive Moment Estimation

TP Numbers of true positives

FP Numbers of false positives

FN Numbers of false negatives

ROC Receiver operating characteristic

AUC Area under the ROC curve

3D Three-dimensional

CBCT Cone-beam computed tomography systems

STARD Standards for Reporting Diagnostic

Acknowledgements

Author contributions

Funding

Data availability

Declarations

Ethics approval and consent to participate

Consent for publication

Competing interests

Author details

Received: 9 November 2023 / Accepted: 15 January 2024

References

- Dentino A, Lee S, Mailhot J, Hefti AF. Principles of periodontology. Periodontol 2000. 2013;61:16-53.

- Bourgeois D, Inquimbert C, Ottolenghi L, Carrouel F. Periodontal pathogens as Risk factors of Cardiovascular diseases, Diabetes, Rheumatoid Arthritis, Cancer, and Chronic Obstructive Pulmonary Disease-Is there cause for Consideration? Microorganisms 2019;7.

- Chang H-J, Lee S-J, Yong T-H, Shin N-Y, Jang B-G, Kim J-E, et al. Deep learning hybrid method to automatically diagnose periodontal bone loss and stage periodontitis. Sci Rep. 2020;10:1-8.

- Mol A. Imaging methods in periodontology. Periodontol 2000. 2004;34:34-48.

- Scarfe WC, Azevedo B, Pinheiro LR, Priaminiarti M, Sales MAO. The emerging role of maxillofacial radiology in the diagnosis and management of patients with complex periodontitis. Periodontol 2000. 2017;74:116-39.

- Kurt Bayrakdar S, Özer Ç, Bayrakdar IS, Orhan K, Bilgir E, Odabaş A, et al. Success of artificial intelligence system in determining alveolar bone loss from dental panoramic radiography images. Cumhuriyet Dent J. 2020;23:318-24.

- Rushton VE, Horner K. The use of panoramic radiology in dental practice. J Dent. 1996;24:185-201.

- Clerehugh V, Tugnait A. Diagnosis and management of periodontal diseases in children and adolescents. Periodontol 2000. 2001;26:146-68.

- Ivanauskaite D, Lindh C, Rangne K, Rohlin M. Comparison between Scanora panoramic radiography and bitewing radiography in the assessment of marginal bone tissue. Stomatologija. 2006;8(1):9-15. PMID: 16687909.

- de Faria Vasconcelos K, Evangelista KM, Rodrigues CD, Estrela C, de Sousa TO, Silva MA. Detection of periodontal bone loss using cone beam CT and intraoral radiography. Dentomaxillofac Radiol. 2012;41:64-9.

- Haas LF, Zimmermann GS, De Luca Canto G, Flores-Mir C, Corrêa M. Precision of cone beam CT to assess periodontal bone defects: a systematic review and meta-analysis. Dentomaxillofac Radiol. 2018;47:20170084.

- Persson RE, Hollender LG, Laurell L, Persson GR. Horizontal alveolar bone loss and vertical bone defects in an adult patient population. J Periodontol. 1998;69:348-56.

- Gomes-Filho IS, Sarmento VA, de Castro MS, da Costa NP, da Cruz SS, Trindade SC, et al. Radiographic features of periodontal bone defects: evaluation of digitized images. Dentomaxillofac Radiol. 2007;36:256-62.

- Jayakumar A, Rohini S, Naveen A, Haritha A, Reddy K. Horizontal alveolar bone loss: a periodontal orphan. J Indian Soc Periodontol. 2010;14:181-5.

- Braun

, Ritter , Jervøe-Storm PM, Frentzen M. Diagnostic accuracy of CBCT for periodontal lesions. Clin Oral Investig. 2014;18:1229-36. - Papapanou PN, Sanz M, Buduneli N, Dietrich T, Feres M, Fine DH, et al. Periodontitis: Consensus report of workgroup 2 of the 2017 World workshop on the classification of Periodontal and Peri-implant diseases and conditions. J Periodontol. 2018;89(Suppl 1):173-s82.

- Ertaş K, Pence I, Cesmeli MS, Ay ZY. Determination of the stage and grade of periodontitis according to the current classification of periodontal and peri-implant diseases and conditions (2018) using machine learning algorithms. J Periodontal Implant Sci. 2023;53(1):38-53. https://doi.org/10.5051/ jpis. 2201060053.

- Lee CT, Kabir T, Nelson J, Sheng S, Meng HW, Van Dyke TE, et al. Use of the deep learning approach to measure alveolar bone level. J Clin Periodontol. 2022;49:260-9.

- Sen D, Chakrabarti R, Chatterjee S, Grewal DS, Manrai K. Artificial intelligence and the radiologist: the future in the Armed Forces Medical Services. BMJ Mil Health. 2020;166:254-6.

- Kurt Bayrakdar S, Orhan K, Bayrakdar IS, Bilgir E, Ezhov M, Gusarev M, et al. A deep learning approach for dental implant planning in cone-beam computed tomography images. BMC Med Imaging. 2021;21:86.

- Lee JH, Kim DH, Jeong SN, Choi SH. Detection and diagnosis of dental caries using a deep learning-based convolutional neural network algorithm. J Dent. 2018;77:106-11.

- Fukuda M, Inamoto K, Shibata N, Ariji Y, Yanashita Y, Kutsuna S, et al. Evaluation of an artificial intelligence system for detecting vertical root fracture on panoramic radiography. Oral Radiol. 2020;36:337-43.

- Bilgir E, Bayrakdar İ, Çelik Ö, Orhan K, Akkoca F, Sağlam H, et al. An artifıcial intelligence approach to automatic tooth detection and numbering in panoramic radiographs. BMC Med Imaging. 2021;21:124.

- Bayrakdar IS, Orhan K, Çelik Ö, Bilgir E, Sağlam H, Kaplan FA, et al. A U-Net Approach to apical lesion segmentation on panoramic radiographs. Biomed Res Int. 2022;2022:7035367.

- Krois J, Ekert T, Meinhold L, Golla T, Kharbot B, Wittemeier A, et al. Deep learning for the Radiographic detection of Periodontal Bone loss. Sci Rep. 2019;9:8495.

- Thanathornwong B, Suebnukarn S. Automatic detection of periodontal compromised teeth in digital panoramic radiographs using faster regional convolutional neural networks. Imaging Sci Dent. 2020;50:169-74.

- Lee JH, Kim DH, Jeong SN, Choi SH. Diagnosis and prediction of periodontally compromised teeth using a deep learning-based convolutional neural network algorithm. J Periodontal Implant Sci. 2018;48:114-23.

- Khan HA, Haider MA, Ansari HA, Ishaq H, Kiyani A, Sohail K, et al. Automated feature detection in dental periapical radiographs by using deep learning. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;131:711-20.

- Kim J, Lee HS, Song IS, Jung KH. DeNTNet: deep neural transfer network for the detection of periodontal bone loss using panoramic dental radiographs. Sci Rep. 2019;9:17615.

- Jiang L, Chen D, Cao Z, Wu F, Zhu H, Zhu F. A two-stage deep learning architecture for radiographic staging of periodontal bone loss. BMC Oral Health. 2022;22:106.

- Helmi MF, Huang H, Goodson JM, Hasturk H, Tavares M, Natto ZS. Prevalence of periodontitis and alveolar bone loss in a patient population at Harvard School of Dental Medicine. BMC Oral Health. 2019;19:254. https://doi. org/10.1186/s12903-019-0925-z.

- Wylleman A, Van Der Veken D, Teughels W, Quirynen M, Laleman I. Alveolar bone level at deciduous molars in flemish children: a retrospective, radiographic study. J Clin Periodontol. 2020;47:660-7. https://doi.org/10.1111/ jcpe. 13280.

- Castro LO, Castro IO, de Alencar AHG, Valladares-Neto J, Estrela C. Cone beam computed tomography evaluation of distance from cementoenamel

junction to alveolar crest before and after nonextraction orthodontic treatment. Angle Orthod. 2015;86:543-9. https://doi.org/10.2319/040815-235.1. - Ronneberger O, Fischer P, Brox T. U-net: Convolutional networks for biomedical image segmentation. International Conference on Medical image computing and computer-assisted intervention: Springer; 2015. p. 234-41.

- Zhou Z, Siddiquee MMR, Tajbakhsh N, Liang J. UNet++: A nested U-Net Architecture for Medical Image Segmentation. Deep Learn Med Image Anal Multimodal Learn Clin Decis Support (2018). 2018;11045:3-11.

- Du G, Cao X, Liang J, Chen X, Zhan Y. Medical image segmentation based on u-net: a review. J Imaging Sci Technol. 2020;64:1-12.

- Lee S, Kim D, Jeong HG. Detecting 17 fine-grained dental anomalies from panoramic dental radiography using artificial intelligence. Sci Rep. 2022;12:5172.

- Kılıc MC, Bayrakdar IS, Çelik Ö, Bilgir E, Orhan K, Aydın OB, et al. Artificial intelligence system for automatic deciduous tooth detection and numbering in panoramic radiographs. Dentomaxillofac Radiol. 2021;50:20200172.

- Pauwels R, Brasil DM, Yamasaki MC, Jacobs R, Bosmans H, Freitas DQ, et al. Artificial intelligence for detection of periapical lesions on intraoral radiographs: comparison between convolutional neural networks and human observers. Oral Surg Oral Med Oral Pathol Oral Radiol. 2021;131:610-6.

- Zhang X, Liang Y, Li W, Liu C, Gu D, Sun W, et al. Development and evaluation of deep learning for screening dental caries from oral photographs. Oral Dis. 2022;28:173-81.

- Takahashi T, Nozaki K, Gonda T, Mameno T, Ikebe K. Deep learning-based detection of dental prostheses and restorations. Sci Rep. 2021;11:1960

- Fu Q, Chen Y, Li Z, Jing Q, Hu C, Liu H, et al. A deep learning algorithm for detection of oral cavity squamous cell carcinoma from photographic images: a retrospective study. EClinicalMedicine. 2020;27:100558.

- Li W, Liang Y, Zhang X, Liu C, He L, Miao L, et al. A deep learning approach to automatic gingivitis screening based on classification and localization in RGB photos. Sci Rep. 2021;11:16831.

- Zehra T, Shaikh A, Shams M. Dawn of artificial intelligence – enable digital Pathology in Pakistan: a paradigm shift. J Pak Med Assoc. 2021;71:2683-4.

- Alhazmi A, Alhazmi Y, Makrami A, Masmali A, Salawi N, Masmali K, et al. Application of artificial intelligence and machine learning for prediction of oral cancer risk. J Oral Pathol Med. 2021;50:444-50.

- Alotaibi G, Awawdeh M, Farook FF, Aljohani M, Aldhafiri RM, Aldhoayan M. Artificial intelligence (AI) diagnostic tools: utilizing a convolutional neural network (CNN) to assess periodontal bone level radiographically-a retrospective study. BMC Oral Health. 2022;22:399.

- Surya L. An exploratory study of AI and Big Data, and it’s future in the United States. Int J Creative Res Thoughts (IJCRT), ISSN 2015;2320-882.

- Acar B, Kamburoğlu K. Use of cone beam computed tomography in periodontology. World J Radiol. 2014;28(5):6.

Publisher’s Note

- *Correspondence:

Sevda Kurt-Bayrakdar

dt.sevdakurt@hotmail.com

Full list of author information is available at the end of the article